7 أفضل أدوات تجريف الويب عبر الإنترنت في عام 2023

نشرت: 2023-11-17ملخص: تعمل أدوات تجريف الويب على تبسيط إجراءات استخراج البيانات من مواقع الويب لاتخاذ قرارات تعتمد على البيانات. دعنا نستكشف بعضًا من أفضل أدوات الكشط التي يمكنك استخدامها لهذا الغرض.

تعتبر أدوات تجريف مواقع الويب مفيدة في استخراج البيانات من مواقع الويب. إنها تمكن المستخدمين من جمع المعلومات وتحليلها وتنظيمها لأغراض مختلفة، بما في ذلك البحث والتحليلات والرؤى التنافسية. يمكنهم أتمتة عملية استخراج البيانات بأكملها والمساهمة بشكل كبير في اتخاذ القرارات المستندة إلى البيانات في مجالات متنوعة.

في هذه المقالة، سنتعرف على أفضل أدوات استخراج الويب التي يمكن أن تكون مفيدة أثناء تصدير البيانات. لكن أولاً، دعونا نتعرف على ما هو تجريف الويب بالضبط.

جدول المحتويات

ما هو تجريف الويب؟

يعد تجريف الويب طريقة آلية لجمع البيانات المجمعة من مواقع الويب المختلفة. البيانات المستخرجة هي بيانات غير منظمة بتنسيق HTML يتم تحويلها إلى بيانات منظمة مثل جداول البيانات وقاعدة البيانات.

هناك طرق متعددة لاستخراج البيانات من مواقع الويب مثل استخدام واجهات برمجة التطبيقات والبرامج وإنشاء رمز فريد خاص بك لنفس الشيء. تقدم العديد من أمثلة البرامج روبوتات كشط مدمجة أو تسمح لك بإنشاء روبوتات كشط خاصة بك لتقطيع الويب.

قائمة بـ 7 أدوات لتقطيع الويب لعام 2023 في الهند للمبتدئين

- أوكتوبرس

- ParseHub

- كشط بوت

- نحلة القشط

- Apify

- زينسكريب

- مكشطة الويب

فيما يلي التعداد التفصيلي لأفضل أدوات تجريف الويب بناءً على ميزاتها وأسعارها وإيجابياتها وسلبياتها وما إلى ذلك، لمساعدتك في اختيار أفضل البرامج.

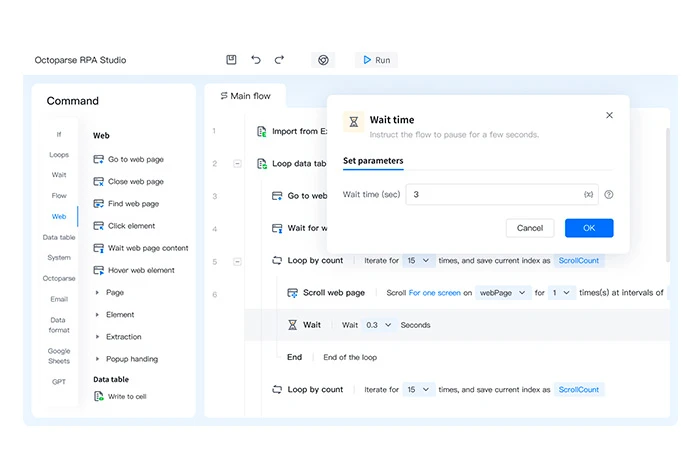

أوكتوبرس

Octoparse هي أداة لتقطيع الويب تتيح لك تحويل صفحات الويب الخاصة بك إلى بيانات منظمة في بضع ثوانٍ. إنه برنامج بدون تعليمات برمجية يمكنه استخراج المعلومات ذات الصلة من أنواع مختلفة من مواقع الويب أو صفحات الويب.

يتم حفظ البيانات غير المنظمة التي تستخرجها من أي موقع ويب بتنسيقات ملفات منظمة مثل HTML والنص العادي وExcel وما إلى ذلك.

ميزات الأخطبوط

- تصدير البيانات إلى تنسيقات متعددة مثل Excel وCSV وJSON

- جدولة تصدير البيانات إلى قواعد البيانات

- يوفر قوالب متعددة لكشط البيانات

- لا ينشئ أي كاشطات ويب للأكواد

- إنشاء 750 مهمة لكشط الويب

إيجابيات وسلبيات Octoparse

- وهو يدعم تدوير IP التلقائي عند استخراج البيانات من موقع ويب لتقليل فرص تتبعها.

- يمكنك أيضًا استخراج البيانات من السحب المتعددة عبر الخوادم السحابية.

- خيارات محدودة متاحة لتخصيص البرنامج.

تسعير Octoparse: خطة مجانية متاحة | تبدأ الخطة المدفوعة من 6,241.54 روبية هندية شهريًا

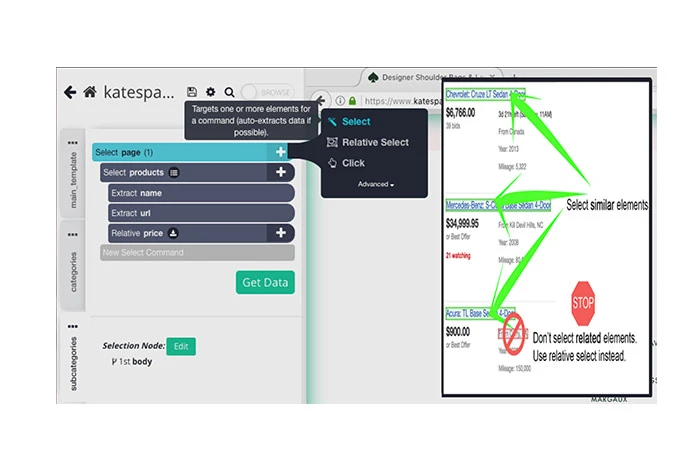

ParseHub

يمكن استخدام أداة ParseHub المجانية لإلغاء البيانات من مواقع الويب المختلفة. كل ما عليك فعله هو تحديد موقع الويب المراد حذفه، واختيار البيانات المراد حذفها، وتصدير البيانات المسروقة إلى تنسيقات مختلفة.

يمكن استخدامه لتخزين البيانات من خوادم مختلفة، وعرض JavaScript، وحل اختبارات CAPTCHA، وما إلى ذلك. ومن خلال ميزة الجدولة الخاصة به، يمكنك أيضًا جدولة استخراج البيانات من مواقع الويب المختلفة.

ميزات بارس هاب

- يقوم تلقائيًا بتدوير عناوين IP للزحف إلى مواقع الويب

- استيراد البيانات المسروقة إلى تنسيقات متعددة مثل JSON وExcel

- قصاصات المبيعات المتوقعة من الدلائل والمجتمعات ووسائل التواصل الاجتماعي وما إلى ذلك.

- يقدم واجهات برمجة التطبيقات المتعددة لتجميع البيانات من مصادر مختلفة

- استخراج البيانات من الجداول والخرائط والرسوم البيانية

إيجابيات وسلبيات ParseHub

- يوفر التكامل مع Dropbox لحفظ البيانات المستخرجة.

- يمكنك استخدامه لاستخراج الصور والنصوص والسمات وما إلى ذلك من مواقع الويب.

- قد يجد المستخدمون الذين لديهم القليل من المعرفة التقنية صعوبة في استخدام البرنامج.

تسعير ParseHub: خطة مجانية متاحة | تبدأ الخطة المدفوعة من 15,736.69 روبية هندية شهريًا

كشط بوت

يوفر Scraping Bot واجهة برمجة تطبيقات لتجريد الويب لاستخراج بيانات HTML من مصادر مختلفة دون حظرها. وهو يقدم واجهات برمجة التطبيقات المتعددة التي تلبي احتياجات قطاع معين لاستخراج البيانات الأكثر صلة. بمجرد تحليل البيانات، يتم استيرادها تلقائيًا بتنسيق JSON للتكامل مع سير العمل الحالي.

مميزات بوت القشط

- يدعم طلبات الخادم المتزامنة

- أتمتة إجراءات جمع البيانات

- يستخرج تفاصيل العملاء للعثور على عملاء محتملين للمبيعات

- يقدم التحليل العاطفي

- ينظم المحتوى من مصادر مختلفة لتحسين استراتيجية المحتوى

إيجابيات وسلبيات كشط بوت

- كما أنه يدعم عرض جافا سكريبت.

- يوفر الاستهداف الجغرافي لتصفية مواقع الويب بناءً على موقعك الجغرافي

- يستغرق الكثير من ذاكرة النظام وذاكرة الوصول العشوائي.

تسعير روبوت الكشط: تتوفر خطة مجانية | تبدأ الخطة المدفوعة من 3,476.21 روبية هندية شهريًا

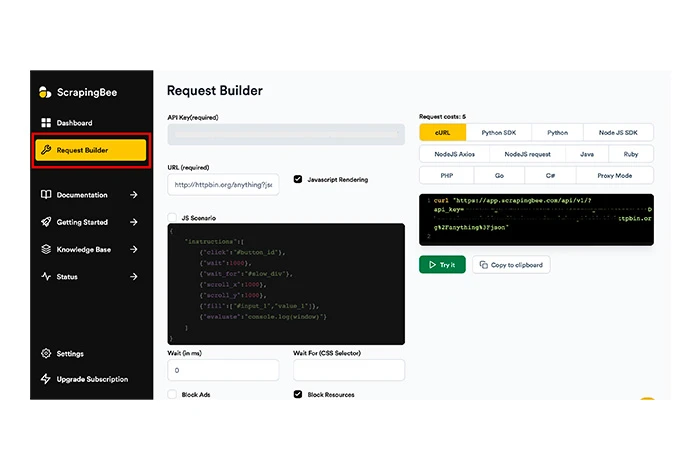

نحلة القشط

Scrapingbee هي أداة أخرى لتجميع مواقع الويب يمكنها مساعدتك في التجريد العام للويب، والتجريد المستند إلى صفحة نتائج محرك البحث (SERP)، واختراق النمو.

يمكن للأداة تنفيذ JavaScript على الصفحات وتدوير جميع الوكلاء لكل طلب لجعل صفحة HTML الأولية متاحة لك دون أي فرصة للحظر. يدير ScrapingBee اختبارات CAPTCHA والوكلاء والمتصفحات بحيث يمكنك بسهولة استخراج البيانات من الموقع الذي تريده.

مميزات سكرابنج بي

- يدعم دوران IP لتجريف الويب

- يوفر دوران الوكيل التلقائي

- يقدم تجريف الويب العام

- يستخرج مواقع الويب HTML وJSON وما إلى ذلك.

- لا ينشئ محركات تجريف الويب المخصصة لأي كود

إيجابيات وسلبيات Scrapingbee

- يدعم تجريف البيانات الجغرافية المستهدفة.

- يوفر واجهة برمجة تطبيقات منفصلة لتجريد بحث Google.

- تحدث أخطاء الخادم الداخلية بشكل متكرر جدًا.

تسعير Scrapingbee: لا تتوفر خطة مجانية | تبدأ الخطة المدفوعة من 4,077.57 روبية هندية شهريًا

Apify

Apify هو برنامج لتخريب الويب حيث يمكنك إنشاء أدوات تجريف الويب المختلفة ونشرها والإشراف عليها. يتيح لك إنشاء واجهات برمجة تطبيقات مختلفة لتجميع مواقع الويب وتحسين وكلاء مركز البيانات لاستخراج البيانات.

يحتوي Apify أيضًا على متجر حيث يقدم أدوات تجريف معدة مسبقًا لاستخراج مواقع الويب مثل Instagram وTwitter وخرائط Google وما إلى ذلك. ويأتي مزودًا بالعديد من الميزات لاستخراج الويب وأتمتة سير العمل واستخراج البيانات.

مميزات تطبيق Apify

- يقوم بتشغيل مهام غير محدودة في وقت واحد

- يدير الوكلاء لمراكز البيانات وSERPs

- يستخرج البيانات من Amazon وschema.org وصفحات الويب وما إلى ذلك.

- يدعم تدوير عناوين IP أثناء تجريف البيانات

- يقدم حل اختبار CAPTCHA وعرض JavaScript

- تصدير البيانات بتنسيقات مثل CSV وJSON وExcel وما إلى ذلك.

إيجابيات وسلبيات Apify

- يقدم دوران الوكيل كميزة مدمجة.

- يمكن الوصول إلى البيانات بتنسيقات متعددة عبر واجهات برمجة التطبيقات.

- قد تحدث مشكلات في توافق البرامج.

تسعير Apify: خطة مجانية متاحة | تبدأ الخطة المدفوعة من 4077.64 روبية هندية شهريًا

زينسكريب

Zenscrape عبارة عن واجهة برمجة التطبيقات (API) التي تدير جميع مشكلات تجريف الويب وتدعم استخراج بيانات HTML عالية الجودة. تعرض الأداة الطلبات عبر متصفح Chrome حديث مقطوع الرأس لتجميع البيانات بدقة ودقة.

يتم تصدير البيانات المستردة من مواقع الويب إلى تنسيقات متعددة مثل Excel وJSON. علاوة على ذلك، بفضل ميزة تحديد الموقع الجغرافي، يمكنك تحديد موقع الوكيل لعرض محتوى موقع الويب المستهدف جغرافيًا.

مميزات الزنسكريب

- يدعم الزحف على شبكة الإنترنت

- ينفذ تجريف بيانات الأسعار

- يقوم تلقائيًا بإلغاء معلومات جهات الاتصال من مواقع الويب

- يدير وكلاء المواقع القياسية والمتميزة

- دعم دوران IP وحل CAPTCHA

إيجابيات وسلبيات Zenscrape

- كما أنه يدعم استخراج بيانات HTML من مواقع الويب.

- وقت استجابة مواقع الويب سريع جدًا في Zenscrape.

- تحتاج إلى استخدام أداة تابعة لجهة خارجية لتحويل البيانات المستردة إلى تنسيقات ملفات مختلفة.

تسعير Zenscrape: خطة مجانية متاحة | تبدأ الخطة المدفوعة من 2,496.26 روبية هندية شهريًا

مكشطة الويب

Web Scraper عبارة عن أداة استخراج عبر الإنترنت يمكنك استخدامها لاستخراج البيانات بشكل منتظم ومجدول. ويمكن دمجها في أنظمة أخرى لاستخدام البيانات المستخرجة. باستخدام أداة الكشط هذه، يمكنك استخراج البيانات بكميات كبيرة وتشغيل مهام الكشط لمواقع ويب متعددة بشكل متزامن.

ميزات مكشطة الويب

- أتمتة إجراءات استخراج البيانات بسرعة

- تكوين كاشطات دون الترميز

- يستخرج بيانات الموقع مع دعم التنقل متعدد المستويات

- يستخدم خرائط الموقع لتخصيص بيانات مواقع الويب

- تصدير البيانات بتنسيقات CSV وXLSX وJSON وتنسيقات أخرى.

إيجابيات وسلبيات مكشطة الويب

- يمكنك أيضًا جدولة إلغاء موقع الويب بناءً على الأسابيع والأيام والساعات وما إلى ذلك.

- يمكنه تدوير IP بعناوين IP متعددة.

- يستغرق إعداده الكثير من الوقت.

- يتم الاحتفاظ بالبيانات المستردة لمدة تصل إلى 60 يومًا فقط.

تسعير مكشطة الويب: تتوفر خطة مجانية | تبدأ الخطة المدفوعة من 4,162.90 روبية هندية شهريًا

كيفية اختيار مكشطة الويب؟

لاختيار مكشطة الويب المناسبة، يجب عليك مراعاة العوامل التالية:

- نظام التشغيل المدعوم: يجب أن يدعم مكشطة الويب التي تخطط لشرائها نظام التشغيل الذي تستخدمه.

- الدعم السحابي: مع هذا الدعم، ستتمكن من حفظ البيانات المنظمة عبر السحابة.

- التكامل: يمكّنك التكامل مع الأنظمة الأساسية الأخرى من نقل البيانات المستردة بسهولة إلى منصات أخرى.

- التدريب: نظرًا لأن استخدام أداة تخريد الويب يتطلب معرفة برمجية، فيجب عليك اختيار أداة توفر مواد تدريبية وافرة.

- التسعير: ضع في الاعتبار أسعار البرنامج وتأكد من أنه يقع في حدود ميزانيتك.

كيف يعمل تجريف الويب؟

يتم إجراء تجريف الويب في ثلاث خطوات بسيطة. أولاً، يحاكي روبوت الكشط التصفح البشري ويحذف الموقع، وثانيًا، يقوم بتحليل البيانات من عقدة البيانات. وأخيرًا، يقوم بتنزيل البيانات التي تم تحليلها وتحويلها. وفيما يلي التعداد التفصيلي لكل خطوة بالتفصيل.

الخطوة 1: يحاكي روبوت تجريف الويب أي إنسان أثناء تصفح موقع ويب معين. بعد ذلك، يقوم بإدخال عنوان URL المستهدف ويرسل الطلبات إلى الخادم. بمجرد الانتهاء من ذلك، يوفر الخادم المعلومات مرة أخرى إلى ملف HTML.

الخطوة 2: باستخدام كود HTML، يصل الروبوت إلى عقدة البيانات ويقوم بتحليل البيانات وفقًا لما يطلبه كود الاستخراج.

الخطوة 3: بناءً على تكوين الروبوت، يتم تنظيف البيانات المسروقة وتحويلها إلى تنسيق بيانات منظمة مثل JSON. بعد ذلك، تصبح البيانات جاهزة للاستيراد أو النقل إلى قواعد بيانات مختلفة.

مقارنة بين أفضل أدوات استخراج الويب

فيما يلي مقارنة بين أفضل أدوات تجريف الويب بناءً على أنظمة التشغيل المدعومة، وتوافر النسخة التجريبية المجانية، وتقييم المستخدم الإجمالي.

| برمجة | نظام التشغيل المدعوم | تجربة مجانية | تقييم |

| أوكتوبرس | ويندوز، ماك | متاح | 4 |

| ParseHub | ويندوز، ماك، لينكس | غير متاح | 4.5 |

| كشط بوت | ويندوز، ماك | متاح | 3.5 |

| نحلة القشط | على شبكة الإنترنت | متاح لمدة 14 يوما | 4.1 |

| Apify | على شبكة الإنترنت | مجاني للاستخدام | 4.9 |

| زينسكريب | على شبكة الإنترنت | أداة مجانية لتحليل البيانات | 3.8 |

| مكشطة الويب | ويندوز، ماك | متاح لمدة 7 أيام | 4.1 |

خاتمة

بعد قراءة المقال، ربما تكون قد فهمت أدوات استخراج البيانات من موقع الويب وكيف يمكن أن تساعدك في استخراج البيانات. في هذه المقالة، قمنا بإدراج أفضل البرامج لاستخراج البيانات واستيرادها من مواقع الويب.

استنادًا إلى ميزات مثل استخراج البيانات، وتدوير IP، وإدارة الوكيل، وما إلى ذلك، فقد تبين أن ParseHub وScraping Bot هما أفضل الأدوات لتجميع الويب. ومع ذلك، قبل اختيار أي أداة لتجميع الويب، تأكد من مراعاة متطلبات الأسعار والميزات الخاصة بك.

الأسئلة الشائعة المتعلقة بأدوات Web Scrapper

ما هي أدوات استخراج الويب؟

أدوات تجريف الويب هي برامج مصممة لتبسيط ميزة استخراج البيانات من مواقع الويب. تتيح لك هذه الأدوات إنشاء برنامج الروبوت الخاص بك والذي يمكنه إلغاء البيانات المطلوبة من مواقع الويب المحددة.

ما هو تجريف الويب المستخدم؟

يمكن استخدام تجريف الويب لأغراض متعددة مثل استخراج بيانات الوسائط الاجتماعية ومعلومات جهات الاتصال والبيانات العقارية ومعلومات تسعير الأسهم وغير ذلك الكثير.

كيفية استخراج البيانات من الموقع؟

لاستخراج البيانات من موقع الويب الخاص بك، يمكنك استخدام أدوات مختلفة لتجميع البيانات. بعض من أفضل الأدوات التي يمكنك وضعها في الاعتبار لتجريد الويب هي Zenscrape وApify وScrapingbee وSmartproxy وAgenty وما إلى ذلك.

ما هي فوائد استخدام أدوات تجريف الويب للشركات؟

باستخدام أدوات تجريف الويب، يمكن للشركات أتمتة عملية استخراج البيانات، وتوفير الوقت الثمين، واستخدام البيانات للحصول على رؤى قيمة. علاوة على ذلك، يمكن للشركات أيضًا حذف البيانات من مواقع ويب متعددة في وقت واحد باستخدام أدوات تحليل الويب هذه لتوفير الوقت والموارد.

هل المعرفة بالبرمجة ضرورية لاستخدام أدوات تجريف الويب؟

مطلوب معرفة أساسية بالبرمجة لاستخدام أداة تجريف موقع الويب. ومع ذلك، ليس من الضروري أن العديد من الأدوات لديها واجهات سهلة الاستخدام ويمكن استخدامها مع القليل من المعرفة التقنية أو معدومة.

كيف يمكنني استخراج البيانات مجانًا؟

لاستخراج بيانات موقع الويب مجانًا، يمكنك اختيار أدوات مجانية لاستخراج البيانات. تقدم هذه الأدوات خططًا مجانية أو مجانية الاستخدام تمامًا. تتضمن بعض هذه الأدوات Apify وZenscrape وOctoparse وما إلى ذلك.