نمذجة الموضوع مع Word2Vec

نشرت: 2022-05-02يتم تعريف الكلمة من قبل الشركة التي تحتفظ بها. هذا هو الأساس وراء Word2Vec ، وهي طريقة لتحويل الكلمات إلى أرقام وتمثيلها في مساحة متعددة الأبعاد. ستظهر الكلمات التي يتم العثور عليها بشكل متكرر بالقرب من بعضها البعض في مجموعة من المستندات (corpus) أيضًا بالقرب من بعضها في هذه المساحة. يقال أنها مرتبطة بالسياق.

Word2Vec هي طريقة للتعلم الآلي تتطلب مجموعة وتدريبًا مناسبًا. تؤثر جودة كلاهما على قدرته على تصميم موضوع بدقة. تصبح أي عيوب واضحة للعيان بسهولة عند فحص المخرجات لمواضيع محددة ومعقدة للغاية لأن هذه هي الأصعب في النمذجة بدقة. يمكن استخدام Word2Vec بمفرده ، على الرغم من أنه يتم دمجه بشكل متكرر مع تقنيات النمذجة الأخرى لمعالجة حدوده.

يوفر الجزء المتبقي من هذه المقالة خلفية إضافية حول Word2Vec ، وكيفية عمله ، وكيفية استخدامه في نمذجة الموضوع ، وبعض التحديات التي يقدمها.

ما هو Word2Vec؟

في سبتمبر 2013 ، نشر باحثو Google ، توماس ميكولوف ، كاي تشن ، جريج كورادو ، وجيفري دين الورقة البحثية بعنوان "التقدير الفعال لتمثيلات الكلمات في مساحة المتجهات" (pdf). هذا ما نشير إليه الآن باسم Word2Vec. كان الهدف من الورقة البحثية هو "تقديم التقنيات التي يمكن استخدامها لتعلم متجهات كلمات عالية الجودة من مجموعات البيانات الضخمة التي تحتوي على مليارات الكلمات ، ومع ملايين الكلمات في المفردات."

قبل هذه النقطة ، كانت أي تقنيات معالجة لغة طبيعية تعامل الكلمات كوحدات مفردة. لم يأخذوا في الاعتبار أي تشابه بين الكلمات. بينما كانت هناك أسباب وجيهة لهذا النهج ، إلا أنه كان له حدوده. كانت هناك مواقف لا يمكن أن يؤدي فيها توسيع نطاق هذه التقنيات الأساسية إلى تحسين كبير. ومن هنا تأتي الحاجة إلى تطوير تقنيات متطورة.

أظهرت الورقة أن النماذج البسيطة ، بمتطلباتها الحسابية المنخفضة ، يمكنها تدريب متجهات كلمات عالية الجودة. كما تستنتج الورقة ، "من الممكن حساب متجهات كلمات عالية الدقة للغاية من مجموعة بيانات أكبر بكثير." إنهم يتحدثون عن مجموعات المستندات (corpora) التي تحتوي على تريليون كلمة توفر حجمًا غير محدود تقريبًا من المفردات.

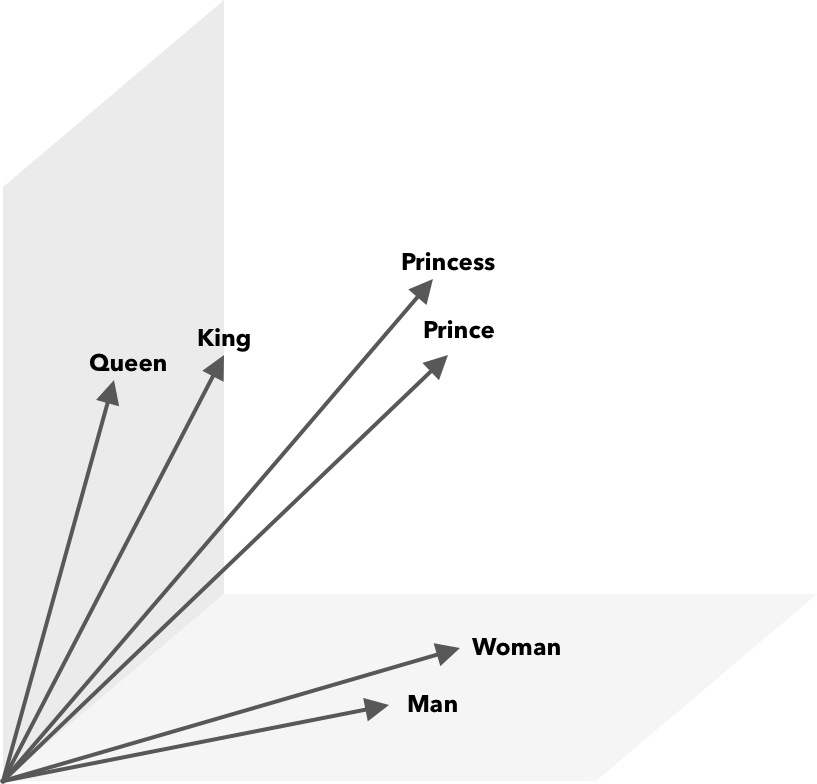

Word2Vec هي طريقة لتحويل الكلمات إلى أرقام ، في هذه الحالة متجهات ، بحيث يمكن اكتشاف أوجه التشابه رياضيًا. الفكرة هي أن نواقل الكلمات المتشابهة يتم تجميعها داخل مساحة المتجه.

فكر في إحداثيات خطوط الطول والعرض على الخريطة. باستخدام هذا المتجه ثنائي الأبعاد ، يمكنك بسرعة تحديد ما إذا كان موقعان قريبان نسبيًا من بعضهما البعض. لكي يتم تمثيل الكلمات بشكل مناسب في فضاء متجه ، لا يكفي بعدان. لذلك ، تحتاج النواقل إلى دمج العديد من الأبعاد.

كيف يعمل Word2Vec؟

يأخذ Word2Vec كمدخلاته مجموعة نصية كبيرة ويوجهها باستخدام شبكة عصبية ضحلة. الإخراج عبارة عن قائمة بالكلمات (المفردات) ، لكل منها متجه مقابل. تحدث الكلمات ذات المعنى المماثل مكانيًا على مسافة قريبة. رياضيا يتم قياس هذا من خلال تشابه جيب التمام ، حيث يتم التعبير عن التشابه الكلي بزاوية 0 درجة بينما لا يتم التعبير عن أي تشابه بزاوية 90 درجة.

يمكن ترميز الكلمات كمتجهات باستخدام أنواع مختلفة من النماذج. في ورقتهم ، ميكولوف وآخرون. نظر في نموذجين موجودين ، نموذج لغة الشبكة العصبية المغذية (NNLM) ونموذج لغة الشبكة العصبية المتكررة (RNNLM). بالإضافة إلى ذلك ، يقترحون نموذجين جديدين لوغاريتمي خطي ، وحقيبة متواصلة من الكلمات (CBOW) ، وتخطي متواصل للجرام.

في مقارناتهم ، كان أداء CBOW و Skip-gram أفضل ، لذلك دعونا نفحص هذين النموذجين.

يشبه CBOW NNLM ويعتمد على السياق لتحديد الكلمة المستهدفة. يحدد الكلمة المستهدفة بناءً على الكلمات التي تأتي قبلها وبعدها. وجد ميكولوف أن أفضل أداء حدث بأربع كلمات مستقبلية وأربع كلمات تاريخية. يطلق عليه "كيس الكلمات" لأن ترتيب الكلمات في التاريخ لا يؤثر على المخرجات. يشير مصطلح "مستمر" في المصطلح CBOW إلى استخدامه "التمثيل الموزع المستمر للسياق".

Skip-gram هو عكس CBOW. بالنظر إلى الكلمة ، فإنه يتنبأ بالكلمات المحيطة ضمن نطاق معين. يوفر النطاق الأكبر متجهات كلمات ذات جودة أفضل ولكنه يزيد من التعقيد الحسابي. يتم إعطاء وزن أقل للمصطلحات البعيدة لأنها عادة ما تكون أقل ارتباطًا بالكلمة الحالية.

عند مقارنة CBOW مع Skip-gram ، وجد أن الأخير يقدم نتائج أفضل جودة على مجموعات البيانات الكبيرة. على الرغم من أن CBOW أسرع ، إلا أن Skip-gram يتعامل مع الكلمات المستخدمة بشكل نادر بشكل أفضل.

أثناء التدريب ، يتم تعيين ناقل لكل كلمة. يتم تعديل مكونات هذا المتجه بحيث تكون الكلمات المتشابهة (بناءً على سياقها) أقرب معًا. فكر في هذا على أنه لعبة شد الحبل ، حيث يتم دفع الكلمات وسحبها في هذا المتجه متعدد الأبعاد في كل مرة يتم فيها إضافة مصطلح آخر إلى الفضاء.

يمكن إجراء العمليات الحسابية ، بالإضافة إلى تشابه جيب التمام ، على متجهات الكلمات. على سبيل المثال ، ينتج عن المتجه ("King") - المتجه ("Man") + المتجه ("Woman") متجه أقرب إلى المتجه الذي يمثل كلمة Queen.

Word2Vec لنمذجة الموضوع

يمكن الاستعلام عن المفردات التي تم إنشاؤها بواسطة Word2Vec مباشرة لاكتشاف العلاقات بين الكلمات أو إدخالها في شبكة عصبية للتعلم العميق. إحدى المشكلات المتعلقة بخوارزميات Word2Vec مثل CBOW و Skip-gram هي أنها تزن كل كلمة بالتساوي. المشكلة التي تنشأ عند العمل مع المستندات هي أن الكلمات لا تمثل معنى الجملة بالتساوي.

بعض الكلمات أهم من غيرها. وبالتالي ، غالبًا ما يتم استخدام استراتيجيات ترجيح مختلفة ، مثل TF-IDF ، للتعامل مع الوضع. يساعد هذا أيضًا في معالجة مشكلة المحور المذكورة في القسم التالي. مقاييس البحث تستخدم ContentExperience مزيجًا من TF-IDF و Word2Vec ، والتي يمكنك أن تقرأ عنها هنا في مقارنتنا مع MarketMuse.

بينما تلتقط عمليات تضمين الكلمات مثل Word2Vec معلومات مورفولوجية ودلالية ونحوية ، تهدف نمذجة الموضوع إلى اكتشاف بنية أو موضوعات دلالية كامنة في مجموعة.

وفقًا لـ Budhkar و Rudzicz (PDF) ، فإن الجمع بين تخصيص Dirichlet الكامن (LDA) مع Word2Vec يمكن أن ينتج ميزات تمييزية "لمعالجة المشكلة الناجمة عن غياب المعلومات السياقية المضمنة في هذه النماذج". يمكن العثور على قراءة أسهل على LDA2vec في هذا البرنامج التعليمي DataCamp.

تحديات Word2Vec

هناك العديد من المشكلات المتعلقة بحفلات الزفاف بشكل عام ، بما في ذلك Word2Vec. سنتطرق إلى بعض منها ، للحصول على تحليل أكثر تفصيلاً ، ارجع إلى "مسح لأساليب تقييم تضمين الكلمات" (pdf) بواسطة أمير باكاروف. سيؤثر الجسم وحجمه ، بالإضافة إلى التدريب نفسه ، بشكل كبير على جودة الإخراج.

كيف تقيم الناتج؟

كما يشرح باكاروف في ورقته البحثية ، سيقوم مهندس البرمجة اللغوية العصبية عادةً بتقييم أداء حفلات الزفاف بشكل مختلف عن اللغوي الحسابي أو مسوق المحتوى لهذه المسألة. فيما يلي بعض القضايا الإضافية المذكورة في الورقة.

- الدلالات فكرة غامضة. يعكس تضمين كلمة "جيدة" مفهومنا عن الدلالات. ومع ذلك ، قد لا ندرك ما إذا كان فهمنا صحيحًا أم لا. أيضًا ، للكلمات أنواع مختلفة من العلاقات مثل الترابط الدلالي والتشابه الدلالي. ما نوع العلاقة التي يجب أن تعكسها كلمة التضمين؟

- عدم وجود بيانات التدريب المناسبة. عند تدريب عمليات دمج الكلمات ، يقوم الباحثون في كثير من الأحيان بزيادة جودتها عن طريق تعديلها مع البيانات. هذا ما نشير إليه بملاءمة المنحنى. بدلاً من جعل النتيجة مناسبة للبيانات ، يجب على الباحثين محاولة التقاط العلاقات بين الكلمات.

- يعني عدم وجود ارتباط بين الطرق الجوهرية والخارجية أنه من غير الواضح أي فئة من الطرق مفضلة. يحدد التقييم الخارجي جودة المخرجات لاستخدامها لاحقًا في مهام معالجة اللغة الطبيعية الأخرى. يعتمد التقييم الجوهري على الحكم البشري على العلاقات بين الكلمات.

- مشكلة المحور. المحاور ، ناقلات الكلمات التي تمثل الكلمات الشائعة ، قريبة من عدد كبير من متجهات الكلمات الأخرى. قد يؤدي هذا الضجيج إلى تحيز التقييم.

بالإضافة إلى ذلك ، هناك نوعان من التحديات الهامة مع Word2Vec على وجه الخصوص.

- لا يمكنها التعامل مع الغموض بشكل جيد للغاية. نتيجة لذلك ، يعكس متجه الكلمة ذات المعاني المتعددة المتوسط ، وهو بعيد عن المثالية.

- يتعذر على Word2Vec التعامل مع الكلمات غير المطابقة للمفردات (OOV) والكلمات المتشابهة شكليًا. عندما يواجه النموذج مفهومًا جديدًا ، فإنه يلجأ إلى استخدام متجه عشوائي ، وهو ليس تمثيلًا دقيقًا.

ملخص

لا يضمن استخدام Word2Vec أو تضمين أي كلمة أخرى النجاح. جودة المخرجات تعتمد على التدريب المناسب باستخدام مجموعة مناسبة وكبيرة بما فيه الكفاية.

في حين أن تقييم جودة المخرجات يمكن أن يكون مرهقًا ، فإليك حلًا بسيطًا لمسوقي المحتوى. في المرة القادمة التي تقوم فيها بتقييم أداة تحسين المحتوى ، حاول استخدام موضوع محدد للغاية. تفشل نماذج الموضوعات ذات الجودة الرديئة عندما يتعلق الأمر بالاختبار بهذه الطريقة. إنها مناسبة للمصطلحات العامة ولكنها تتعطل عندما يصبح الطلب محددًا للغاية.

لذا ، إذا كنت تستخدم موضوع "كيفية زراعة الأفوكادو" ، فتأكد من أن الاقتراحات لها علاقة بزراعة النبات وليس الأفوكادو بشكل عام.

ساعد إنشاء تقنية MarketMuse NLG Technology في إنشاء هذه المقالة.

ماذا يجب ان تفعل الان

عندما تكون جاهزًا ... إليك 3 طرق يمكننا من خلالها مساعدتك في نشر محتوى أفضل بشكل أسرع:

- احجز وقتًا مع MarketMuse قم بجدولة عرض توضيحي مباشر مع أحد الاستراتيجيين لدينا لمعرفة كيف يمكن لـ MarketMuse مساعدة فريقك في الوصول إلى أهداف المحتوى الخاصة بهم.

- إذا كنت ترغب في معرفة كيفية إنشاء محتوى أفضل بشكل أسرع ، فتفضل بزيارة مدونتنا. إنه مليء بالموارد للمساعدة في توسيع نطاق المحتوى.

- إذا كنت تعرف جهة تسويق أخرى تستمتع بقراءة هذه الصفحة ، فشاركها معهم عبر البريد الإلكتروني أو LinkedIn أو Twitter أو Facebook.