ما المقصود بمراجعة موقع تحسين محركات البحث (SEO)؟

نشرت: 2021-08-11جدول المحتويات

ما هو تدقيق موقع SEO وكيف يتم إجراؤه؟ جنبًا إلى جنب مع خطة المحتوى واستراتيجية الرؤية العضوية ، يشكل هذا المستند (أو مجموعة من المستندات) حجر الزاوية في نشاط تحسين محركات البحث لديك. إن تطبيقه بشكل جيد سيضعك على طريق النجاح.

مع وضع ذلك في الاعتبار ، قررنا إرشادك خلال عملية إجراء تدقيق تحسين محركات البحث خطوة بخطوة .

تدقيق تحسين محركات البحث (SEO) عبارة عن مجموعة من التحليلات التي يقوم بها متخصص تحسين محركات البحث (SEO). ويهدف إلى التأكد من أن الموقع يلبي أحدث معايير تحسين محرك البحث وأنه لا يوجد شيء يقف في طريق اتباع استراتيجية للنمو العضوي.

الأهم من ذلك ، أن التدقيق في حد ذاته ليس استراتيجية. في بداية التعاون ، عادة ما نزود العميل بكلتا الوثيقتين في نفس الوقت. ومع ذلك ، فإن معظم عمليات التدقيق لا تتضمن تحليل الكلمات الرئيسية أو خطة المحتوى (توجد استثناءات).

إذا كان الموقع لا يحتوي على أخطاء أساسية ، فحتى التدقيق الأكثر شمولاً سيكشف عن بعض التجاعيد التي يجب تسويتها. إنه أفضل سيناريو لأنه يعني أنه يمكنك إطلاق إستراتيجية تحسين محركات البحث على الفور بدلاً من تنفيذ توصيات التدقيق ، مما قد يؤدي إلى تكاليف إضافية للعميل. بطريقة ما ، خبراء تحسين محركات البحث مثل الأطباء - كل ما تتمنى أن يقولوه هو "كل شيء على ما يرام".

يمكن لخبير تحسين محركات البحث (SEO) تقديم تقييم عام لصحة الموقع حتى في مرحلة الاقتباس. يعمل هذا التشخيص الأولي على تكييف عرض التدقيق ونطاق التحليل لاحتياجات العميل.

متى يتم إجراء تدقيق تحسين محركات البحث؟ 4 حالات عندما تحتاج واحد

أثناء قيامك بتنفيذ أي تحديثات فنية

يجب أن ينظر خبير تحسين محركات البحث في أي خطط للتحديثات الرئيسية قبل التنفيذ. تشمل التحديثات "الرئيسية" ما يلي:

- الانتقال إلى CMS آخر (نظام إدارة المحتوى) ،

- تحديث كود HTML ،

- تغيير عناوين URL أو بنية الموقع الداخلية ،

- إضافة أو إزالة أقسام أو صفحات أو ميزات معينة.

هل تعرف ما هو السبب الأكثر شيوعًا للنمو العضوي في Google؟ لا تعدل الخوارزمية ولكن يتم تنفيذ التحديثات الرئيسية دون دعم أو تحليل تحسين محركات البحث.

لهذا السبب ، يجب على وكالة أو خبير تحسين محركات البحث المشاركة في مشاريع تصميم الويب منذ البداية. إذا كنت على متن الطائرة منذ اليوم الأول ، فيمكنك التأكد من أن بنية الموقع نفسها تغذي إستراتيجية تحسين محركات البحث الخاصة بك.

لقضايا الرؤية العضوية

إذا كانت جهود تحسين محركات البحث لديك متوقفة ، فمن المتوقع حدوث انخفاض عشوائي في حركة المرور أو استقرار في الرؤية. ومع ذلك ، خلال حملة نشطة ، فإن عدم وجود نتائج هو سبب للقلق.

قد يشير الانخفاض المفاجئ في حركة المرور العضوية إلى وجود أخطاء على موقع الويب أو تحديث في خوارزمية Google أدى إلى تغيير تقييم المحتوى الحالي. في كلتا الحالتين ، قد تحتاج إلى إجراء تدقيق لتحسين محركات البحث يهدف إلى تحديد المشكلات التي تحتاج إلى إصلاح أو تعديل موقع الويب وفقًا لمعايير التقييم الجديدة التي تستخدمها روبوتات محركات البحث.

إذا كان هناك تسويق نشط للمحتوى و / أو استراتيجية لبناء الروابط ، فقد يشير الركود إلى وجود أخطاء غير مكتشفة والتي تعيق نموك بشكل فعال.

عند الشراكة مع وكالة جديدة لتحسين محركات البحث

تدقيق تحسين محركات البحث هو إجراء قياسي في بداية التعاون مع أي وكالة أو خبير متخصص في تحسين محركات البحث. لتشغيل استراتيجيتنا بشكل فعال ، نحتاج إلى معرفة أن الموقع يعمل بشكل جيد.

يميل العملاء إلى الاعتراض على هذه الفكرة ، بحجة أن موقع الويب الحديث لا يمكن أن يحتوي على أي أخطاء أو أن تدقيق تحسين محركات البحث تم إجراؤه بواسطة الوكالة السابقة في العام السابق.

ومع ذلك ، بصفتك متخصصًا يتحمل المسؤولية عن المشروع الجديد ونتائجه ، فلديك كل الحق في فحص موقع الويب على النحو الذي تراه مناسبًا.

كإجراء روتيني

حتى إذا أجريت تدقيقًا رئيسيًا لتحسين محركات البحث منذ بعض الوقت ، ولم تكن هناك تغييرات كبيرة في هذه الأثناء ، فمن الأفضل إجراء فحوصات دورية. ليس عليهم أن يتخذوا شكل عمليات تدقيق فنية شاملة من الألف إلى الياء. اعتمادًا على الطرق المحددة ، تشمل عمليات التدقيق الروتينية ما يلي:

- مراجعات شهرية أو ربع سنوية بناءً على الأخطاء التي تم رصدها أثناء المراجعة الأولية ،

- تركز التحليلات على القضايا الأساسية مثل أخطاء 404 الجديدة.

وبالتالي ، يهدف التدقيق الروتيني إلى التحقق مما إذا لم يحدث أي خطأ منذ الفحص الأخير. كما نعلم ، فإن أي موقع ويب هو شيء حي - الصفحات تأتي وتذهب ، أو أنها تغير موقعها. يميل العديد من الأشخاص في الشركة إلى إدارة المتاجر متوسطة الحجم عبر الإنترنت ، وهناك دائمًا مجال للخطأ البشري.

أنواع عمليات تدقيق تحسين محركات البحث (SEO)

تدقيق تقني كامل لتحسين محركات البحث

عند الحديث عن تدقيق تحسين محركات البحث ، فإننا نعني في الغالب الفحص الفني الشامل الذي يهدف إلى الكشف عن جميع أخطاء التحسين المحتملة وعيوبها. تركز عمليات التدقيق هذه على موقع الويب نفسه ، وتغطي وجهات النظر في الموقع وخارجه. يتم تقديم النتائج في تقرير تحسين محركات البحث (SEO) الذي تمت صياغته بواسطة خبير تحسين محركات البحث الذي يجمع البيانات باستخدام الأدوات المحددة ، ويحلل النتائج ، ويقدم توصيات معدلة وفقًا لمنتج العميل.

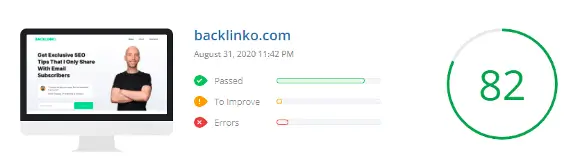

عمليات تدقيق آلية لتحسين محركات البحث

يمكن تجميع عمليات التدقيق التلقائية في فئتين:

- تقارير PDF متعمقة تم إنشاؤها بواسطة برامج الزحف الحديثة والمتخصصة مثل Sitebulb ؛

- يتم إجراء عمليات تدقيق مواقع الويب تلقائيًا بواسطة أدوات مجانية.

التقارير من كلا النوعين لها استخداماتها. ومع ذلك ، في حين أن النوع الأول يسهل عمل خبير متمرس ، فإن النوع الآخر عادة ما يرقى إلى تحليل متسرع لبعض البيانات الأساسية ، وهو ما لا يكفي لاستخلاص أي مجموعة أوسع من الاستنتاجات.

تتوفر تقارير النوع الثاني بشكل عام كحافز مجاني للعميل.

تدقيقات منافسة تحسين محركات البحث - قياس الأداء

هناك شيء آخر تمامًا هو تدقيق منافسة تحسين محركات البحث (SEO) ، وعادة ما يتم إجراؤه عندما نبدأ في تطوير إستراتيجية تحسين محركات البحث (SEO) الخاصة بك. فهو يجمع بين تحليل رؤية منافسيك مع مراجعة فنية قصيرة ومراجعة المحتوى للمنافسين المختارين.

يوفر هذا التدقيق:

- المعيار الحالي الخاص بك مقابل المنافسة . يوضح لك التدقيق كيف يتم تصنيف موقعك في رؤية Google مقارنةً بمنافسيك. يمكنك تحديث التدقيق كل ربع سنة لتحديد كيفية تأثير استراتيجيتك على وضعك في السوق.

- وفرة من المعرفة على طريق منافسينا إلى موقعهم ونتائجهم في الوقت الحاضر.

يمكنك استخدام التدقيق من أجل:

- إلقاء نظرة خاطفة على حلول التحسين التي تتجاوز التوصيات القياسية ،

- الخروج بأفكار جديدة لبناء الروابط ،

- والأهم من ذلك ، تحديد فجوة المحتوى ، والتي قد توضح لك مسارًا جديدًا للنمو العضوي - وهو شيء فاتك يولد الكثير من الزيارات للمنافسة.

عمليات تدقيق ما بعد التنفيذ

بعد المراجعة الأولى ، قد يشركك العميل في تنفيذ التوصيات (مما يبسط الأمور) أو يأخذها على عاتقه. في الحالة الأخيرة ، من الأفضل اختتام الإجراء بأكمله بفحص نهائي واحد عندما تمر بقائمة المراجعة نقطة تلو الأخرى. فقط للتأكد من أن كل شيء على ما يرام.

تدقيقات التجارة الإلكترونية

أولاً ، تدقيق التجارة الإلكترونية هو صفر في بنية موقع الويب ، بما في ذلك التنقل الرئيسي والفئات والفئات الفرعية. وبالتالي ، غالبًا ما تتطلب عمليات التدقيق الفنية للمتاجر عبر الإنترنت إضافة إستراتيجية استخدام الكلمات الرئيسية.

ثانيًا ، يجب أن ينظر التدقيق في ترقيم الصفحات وهيكل الموقع بالكامل لأن العديد من مطوري برامج التجارة الإلكترونية يعتبرون الاستخدام السيئ السمعة لـ rel = canonical و robots noindex علاجًا لجميع العلل. النتيجة النهائية: متاجر على الإنترنت تحتوي على 1000 SKU (وحدات حفظ المخزون) والتي تنتج أكثر من مليون صفحة زائدة عن الحاجة.

ثالثًا ، يجب أن ينصب التركيز على إزالة المحتوى المكرر - سواء الداخلي (المتكرر عبر خيارات المنتج المتعددة) أو الخارجي (عبر المتاجر المختلفة).

تدقيقات المحتوى

تركز عمليات تدقيق المحتوى (يجب عدم الخلط بينها وبين استراتيجية النمو أو خطة المحتوى) على تعظيم حركة المرور العضوية باستخدام الموارد الحالية. قد تشمل تحليلات:

- الحالة الحالية للربط الداخلي داخل النطاق - الهدف: تحديد ما إذا كانت جميع محتوياتك مرتبطة ببعضها البعض بشكل موضعي ، وما إذا كان هذا الرابط الوحيد في علامة تبويب الفئة ليس هو الطريقة الوحيدة لاكتشاف مقالة عالية القيمة.

- المشاكل المحتملة مع تفكيك الكلمات الرئيسية أو المواقف التي يتم فيها تقسيم موضوع واحد دون داع إلى عدة مقالات منفصلة ، لا يوجد أي منها لديه فرصة للحصول على مرتبة عالية.

- تحديد الثمار المنخفضة ، أي المحتوى الذي يتطلب تغييرات تجميلية فقط (الربط ، إعادة التحسين) لبدء توليد حركة مرور عضوية.

فقط عندما يكون كل شيء في حالة عمل جيدة ، يجب عليك المضي قدمًا في إنشاء محتوى جديد ومزيد من النمو.

تدقيق تحسين محركات البحث لخدمة محلية

تميل الشركات العاملة محليًا إلى استخدام مواقع الويب الأصغر حجمًا ، حيث تكون بنية الموقع وهندسة المعلومات ذات أهمية ثانوية.

الأولوية هنا هي تحليل الكلمات الرئيسية المناسب (المحلي) ، والذي سيكون بمثابة أساس لتخطيط صفحات العرض. إلى جانب ذلك ، ينصب التركيز على:

- مراجعة وتحسين الملف التعريفي للشركة على Google My Business ،

- إضافة أو تحسين البيانات المنظمة المحلية للأعمال ،

- تدقيق الارتباط الخارجي وعامل NAP (الاسم + العنوان + رقم الهاتف).

هل تدقيق SEO مجاني يستحق كل هذا العناء؟

عادةً ما تخدم عمليات تدقيق تحسين محركات البحث المجانية المتوفرة على الإنترنت غرضًا واحدًا فقط - للكشف عن مجموعة من الأخطاء (غالبًا ما تكون غير ذات صلة) من أجل تقديم خدمات مدفوعة في النهاية.

لاحظ أن عمليات التدقيق هذه يتم إنشاؤها تلقائيًا بواسطة الأدوات الرقمية بدلاً من صياغتها بواسطة خبراء تحسين محركات البحث.

في كثير من الأحيان ، يجب إكمال تدقيق تحسين محركات البحث من قبل العديد من الأشخاص المتخصصين في الأمور التقنية أو تحسين المحتوى.

في بعض الحالات ، يتطلب نطاق التدقيق أو حجم الموقع أو الموعد النهائي مشاركة فريق كامل يعمل من قبل وكالة تحسين محركات البحث.

وبالتالي ، لا يوجد شيء مثل تدقيق SEO موثوق به ومجاني لأي موقع ويب.

كيف تبدأ تدقيق SEO الخاص بك

أول شيء أفعله عند إجراء تدقيق (أو قبل ذلك ، عندما أحصل على استفسار من العميل) هو:

- تحقق من مخطط الرؤية العضوية في سينوتو

- استخدم موقع مشغل البحث:

يستغرق الأمر ما مجموعه خمس دقائق وغالبًا ما يتيح لي تحديد العديد من المشكلات على موقع الويب.

تذكر أنه في مرحلة عرض الأسعار (وفي بعض الحالات ، حتى عند إجراء التدقيق) ، قد لا يكون لديك حق الوصول إلى Google Search Console أو Analytics ، لذا فإن الأدوات الخارجية ضرورية .

يمنحك مجرد إلقاء نظرة خاطفة على مخطط رؤية الموقع في Senuto ثروة من المعلومات حول رفاهية الموقع. عند الفحص الدقيق ، ركز على النقاط التالية:

- اتجاه الرسم البياني - لمعرفة ما إذا كانت الرؤية تنمو بشكل مطرد على مدار العامين الماضيين ، دون حدوث ارتفاعات وانخفاضات مفاجئة. إذا كان الرسم البياني يبدو مسطحًا ، فعادةً ما يشير إلى نقص النشاط العضوي أو المشكلات الرئيسية التي تعيق النمو.

- إذا لاحظت أي قطرات مفاجئة في إطار زمني قصير ، فجرّب :

- مقارنة الحالات الشاذة بقائمة تحديثات الخوارزمية الرئيسية المعروفة في بحث Google. إذا كانت متداخلة ، فأنت على الأقل تعرف ما الذي تواجهه.

- استخدام WayBackMachine لمعرفة كيف كان شكل الموقع قبل شهر من السقوط وبعده. في معظم الحالات ، تنخفض الرؤية بعد اكتمال عمليات الترحيل دون دعم أحد خبراء تحسين محركات البحث.

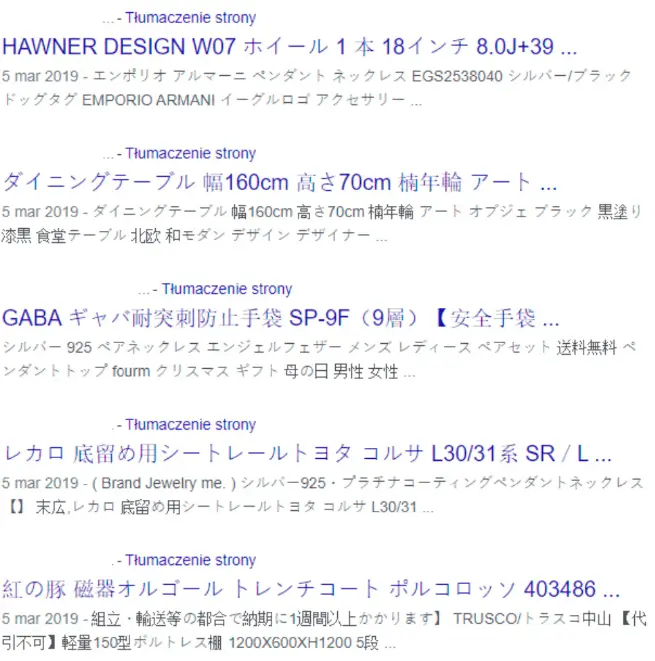

هناك دعوة جيدة أخرى وهي استخدام الموقع الذي يتم إغفاله بشكل شائع: domain.com. انقر خلال النتائج القليلة الأولى من أجل:

- قم بعمل تقدير تقريبي لحجم الموقع - على الرغم من أنه يجب عليك الانتقال إلى Google Search Console + الزاحف المحدد للحصول على البيانات الأكثر دقة ،

- راجع الجودة العامة لعلامات العنوان وعلامات الوصف التعريفي وعرض النتائج.

- كثيرًا: ابحث عن الأخطاء الأساسية مثل القرصنة أو مشكلات الفهرسة.

مثال على ذلك:

لاحظ العميل الذي يدير أعماله منذ سنوات انخفاضًا في عدد الطلبات والاستفسارات الجديدة من موقع الشركة على الويب. باستخدام الأمر site: domain.pl ، تم حل اللغز على الفور:

النقاط الرئيسية التي يجب التحقق منها أثناء تدقيق تحسين محركات البحث

في عالم التحليل الفني ، تحول التركيز من العلامات الفردية مثل رؤوس Hx إلى المزيد من المشكلات العالمية: هندسة الموقع أو الهيكل أو العرض (والذي ينتج ، من بين أشياء أخرى ، عن براعة Google المتزايدة في التعامل مع أنواع وتقنيات المواقع المختلفة) .

تشمل أكبر التحديات في إنشاء دليل فريد حول عمليات تدقيق تحسين محركات البحث ما يلي:

- التنوع الهائل في المواقف والمواقع التي يجب فحصها أثناء عملية التدقيق. تولد الأهداف والأنواع وأنظمة إدارة المحتوى المختلفة عددًا لا يحصى من التكوينات الممكنة.

- الاختلافات الناتجة في وزن المشكلات المكتشفة والحلول المحتملة لها.

من الناحية النظرية ، يمكنني صياغة قائمة منفصلة بأفضل ممارسات التحسين والأخطاء الشائعة لكل نظام إدارة محتوى ونظام تجارة إلكترونية. مع وضع ذلك في الاعتبار ، قد يكون من الأكثر دقة استدعاء القائمة أدناه - مدعومة بخبرتي من عشرات المراجعات - شيء على غرار: أخطاء تحسين محركات البحث الرائعة وأين يمكن العثور عليها.

الزحف والفهرسة

ملف robots.txt

يدير ملف robots.txt المواقع التي تريد إخفاءها من روبوتات محرك البحث في الموقع. إنه يعمل على منع الزحف بدلاً من الفهرسة نفسها. نادرًا ما تحتوي ملفات robots.txt في هذه الأيام على أخطاء ، ولكنها قد تتأذى حقًا عند حدوثها.

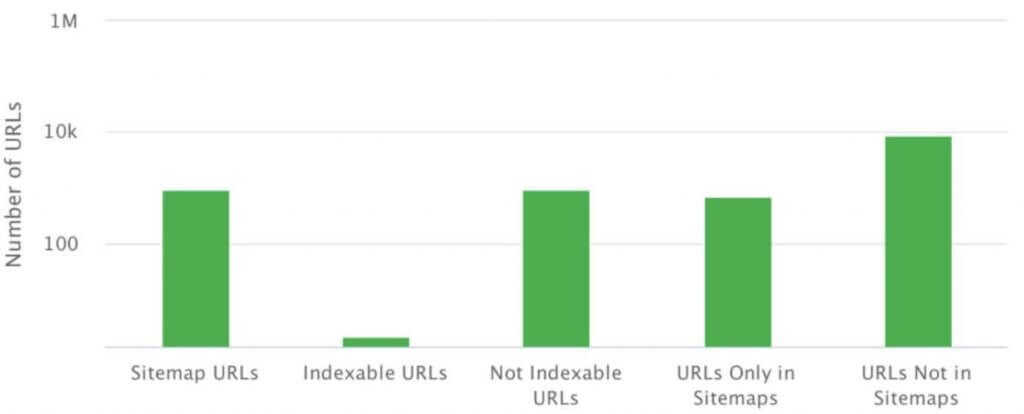

خريطة موقع XML

خريطة موقع XML هي ملف أو مجموعة ملفات تحتوي على قائمة بجميع الصفحات التي تريد فهرستها في بنية معينة.

يمكنك تحديد موقع خريطة الموقع على أي عنوان. ومع ذلك ، يجب أن تقدم البيانات بتنسيق XML ، بما يتوافق مع المواصفات.

تتضمن الأخطاء الأساسية المتعلقة بخرائط مواقع XML ما يلي:

- عدم وجود خريطة موقع XML ،

- أخطاء في بناء الجملة (تم الإبلاغ عنها في GSC) ، والتي تمنع Google من استرداد خريطة الموقع ،

- عدم توافق خريطة الموقع وهيكل موقع الويب ،

- عدم تضمين ملفات مثل الرسومات ومقاطع الفيديو في خريطة الموقع.

الصفحات اليتيمة

لا ترتبط الصفحات اليتيمة داخليًا ، ولكنها غالبًا ما تُعرض بشكل صحيح وتستجيب برمز الحالة 200. تظهر في Google Search Console ، وفي بعض الأحيان تتسلق الرتب وتولد حركة مرور.

تظهر الصفحات اليتيمة لأسباب عديدة ، بدءًا من أخطاء CMS وانتهاءً بالأخطاء البشرية في الارتباط الداخلي أو الخارجي.

Rel = متعارف عليه

لا تعد Rel = canonical مشكلة عند استخدامها على النحو المنشود - للإشارة إلى عنوان الصفحة الأصلي في حالة حدوث ازدواج داخلي. ومع ذلك ، غالبًا ما يُخطئ في اعتباره دواءً سحريًا لجميع الصفحات المزعجة والهياكل سيئة التخطيط.

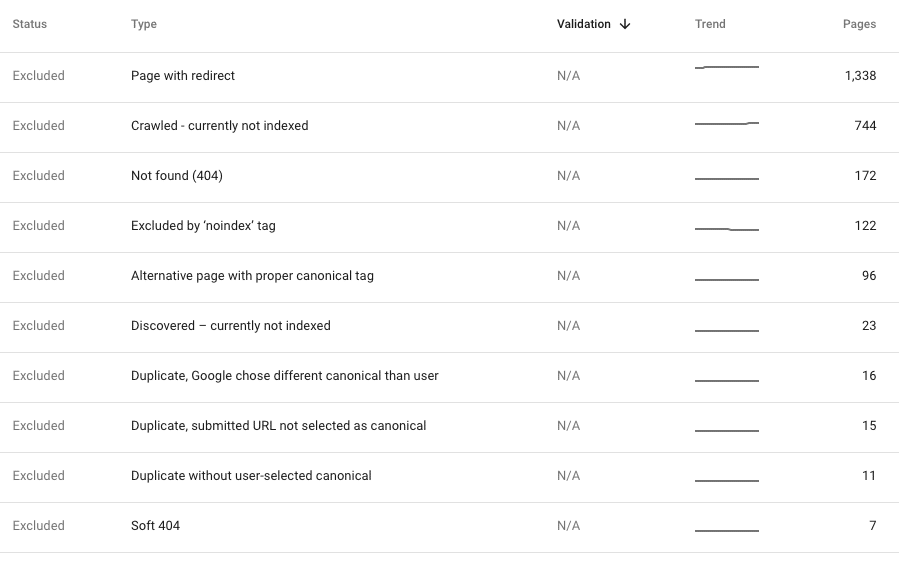

أخطاء 404 داخلية

في أي وقت نكتشف أخطاء 404 داخلية في بنية الموقع المباشر ، أي في عملية الزحف الحالية ، يجب أن يكون تصحيحها من أولوياتنا. تشير مثل هذه الأخطاء إلى أن موقعنا يحتوي على روابط لصفحات لم تعد موجودة ، وهو أمر غير مرغوب فيه للمستخدمين والروبوتات على حد سواء. ومع ذلك ، في معظم الحالات ، يكون الزحف نظيفًا ، لكن GSC يكشف عن أطنان من 404.

بشكل عام ، يشير هذا إلى إحدى المشكلات المذكورة أعلاه: أخطاء في بنية الموقع ، أو خريطة موقع XML خاطئة تشير إلى صفحات غير موجودة ، أو أصداء ترحيل تمت معالجته بشكل خاطئ مع عمليات إعادة توجيه خاطئة.

للأسف ، يتم أحيانًا فهرسة هذه الأخطاء ببطء بواسطة Google. ومع ذلك ، إذا كانت حديثة نسبيًا ، فيجب علينا فحص الموقف لمعرفة سبب حدوثها. إذا كان الزحف الجديد للموقع نظيفًا ، فيجب أن نقرر أفضل طريقة لتصحيح الأخطاء المكتشفة في GSC. عادةً ما يكون الحل الأمثل هو إعادة توجيه الزائرين إلى أقرب مكافئ موضوعي للمحتوى الإشكالي.

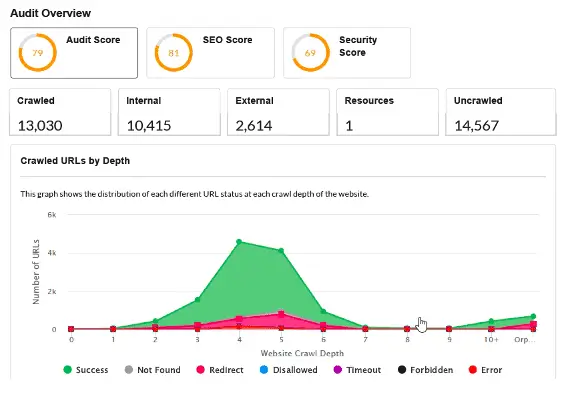

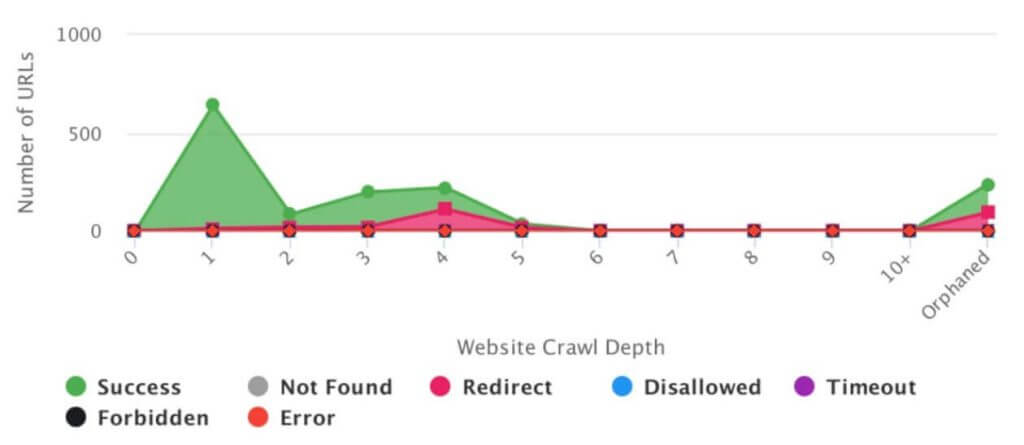

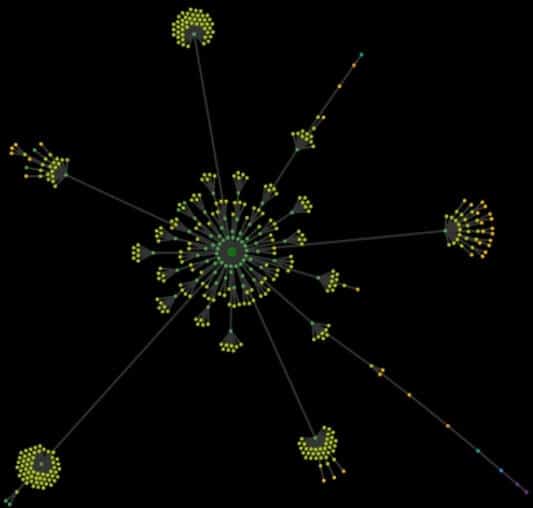

تحليل بنية الموقع

مع عدم وجود طريقة لتصور المظهر الفعلي لموقع الويب ، كل ما لديك هو ملف Excel مشفر يحتوي على آلاف عناوين URL. يتيح لك تحليل بنية الموقع (ما يسمى بخريطة الزحف) اكتشاف الأخطاء والاختناقات في بنية الموقع في لحظة.

بشكل عام ، تعد خريطة الزحف تصورًا لجميع عناوين URL الموجودة على موقع الويب ، بدءًا من الصفحة الرئيسية. المبدأ بسيط: إذا كان ما تراه للوهلة الأولى هو ترتيب مثالي و "زهور" متناغمة للهيكل بدون اختناقات ، فإن الأمور ليست سيئة. كلما كانت الخريطة أكثر فوضوية ، كلما احتجت إلى مزيد من التفكير في جذور المشكلات.

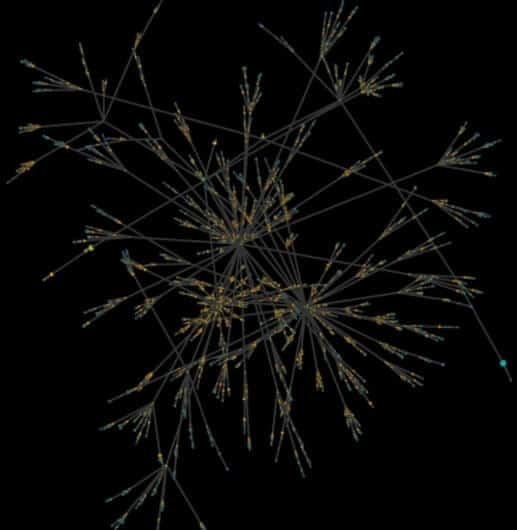

تُظهر الصورة أدناه خريطة زحف لموقع ويب للمحتوى. من حيث تحسين محركات البحث (SEO) ، تم التخطيط لهيكلها بشكل صحيح منذ البداية ، مع أخصائي تحسين محركات البحث (SEO) يراقب العملية بأكملها. للوهلة الأولى ، ترى النظام والانسجام والأقسام والفئات المقسمة بوضوح والارتباط الصحيح.

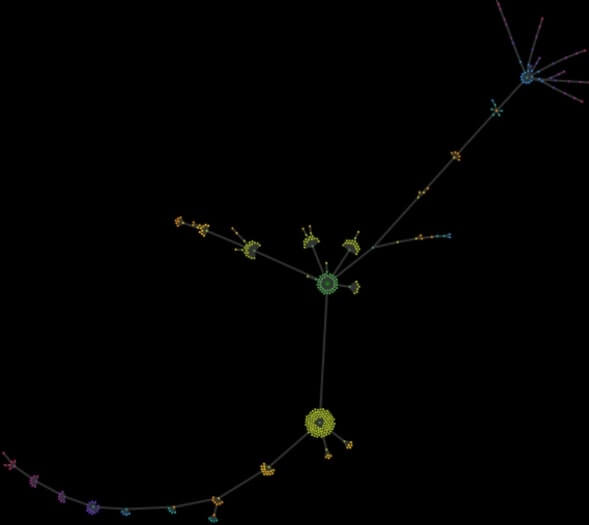

تُظهر الصورة أدناه خريطة زحف لموقع ويب للمحتوى تم تطويره لسنوات. تمت إضافة أقسام جديدة وتوسيعها دون الكثير من التفكير. في مرحلة ما ، طلب العميل المساعدة ، قائلاً إنه يضيع على موقع الويب الخاص به. كشفت الخريطة عن فوضى تامة ، لذلك كان الهيكل بحاجة إلى إعادة تصميم من الصفر.

بالإضافة إلى ذلك ، أضفت خريطة زحف لصفحة محلية صغيرة تتكون من عدة صفحات عروض وعشرات من الأخبار. "الطرفان" الغريبان والمثيران للدهشة هما نتاج إضافات التقويم ، والتي أنتجت صفحات جديدة زائدة عن الحاجة ولكنها قابلة للفهرسة بعمق زحف يصل إلى أكثر من 50 نقرة من الصفحة الرئيسية.

عوامل الموقع

عنوان الفوقية

استخدمها لصالحك وقم بتحسين عناوين صفحاتك بكلمات رئيسية تتماشى مع استراتيجيتك. إلى جانب ذلك ، تؤثر عناوين الصفحات على إمكانية النقر على موقع الويب في نتائج البحث.

تشمل الأخطاء الأكثر شيوعًا المتعلقة بالعناوين ما يلي:

- إنشاء عناوين لا تستند إلى البحث عن الكلمات الرئيسية واستراتيجية الرؤية العضوية ،

- عدم وجود مخطط عنوان عام ، على سبيل المثال: [مكون فريد للصفحة] - [مكون عادي / اسم / علامة تجارية] ،

- عناوين مكررة داخل الموقع - تشير غالبًا إلى محتوى مكرر.

غالبًا ما نقول إن طول العناوين يجب أن يتراوح بين 65 و 75 حرفًا (حسب عرض الحرف). ومع ذلك ، من الناحية العملية ، من المهم أكثر ما إذا كانت تحتوي على كلماتنا الرئيسية المستهدفة أم لا.

ميتا الوصف

لا يخضع محتوى علامات وصف التعريف للتقييم بواسطة الخوارزمية. ومع ذلك ، فإن بنائه المناسب يعزز ظهور موقع الويب في نتائج البحث ، مما يُترجم إلى إمكانية النقر بشكل أفضل على القائمة.

تشمل الأخطاء الأكثر شيوعًا المتعلقة بالوصف التعريفي ما يلي:

- نقص الوصف التعريفي ،

- أوصاف مكررة داخل الموقع (والتي قد تشير إلى محتوى مكرر مثل العناوين المكررة) ،

- الطول المفرط للأوصاف.

من الناحية المثالية ، يجب أن تحتوي كل صفحة تهدف إلى إنشاء حركة مرور عبر محرك البحث على وصف تعريفي خاص بها مع عبارة تحث المستخدم على اتخاذ إجراء. ومع ذلك ، فإن هذا غالبًا ما يثبت أنه غير واقعي. في العديد من الحالات مثل المتاجر عبر الإنترنت ، يمكننا إنشاء أوصاف تعريفية فريدة للصفحات والفئات الأساسية ، بينما بالنسبة لصفحات المنتج - إنشاء أوصاف تعريفية من قالب مليء بميزات المنتج.

التسلسل الهرمي للرأس Hx

لدينا جميعًا إحساس بالشكل الذي يبدو عليه التسلسل الهرمي المناسب. ومع ذلك ، أثناء عمليات تدقيق تحسين محركات البحث ، نواجه بشكل روتيني رؤوس H1 بشعار.

تأثير رؤوس Hx على الرتب مثير للجدل إلى حد كبير ، خاصة في عصر HTML5. ومع ذلك ، لا يزال استخدامها يمثل ممارسة قياسية في عالم تحسين محركات البحث (SEO).

وفقًا لذلك ، يجب أن يكون لديك رأس H1 واحد فقط لكل صفحة. يجب أن يحتوي على العنوان الرئيسي بالإضافة إلى الكلمات الرئيسية الهامة.

لا يهم عدد الرؤوس الأخرى ، طالما أنك تلتزم بمبادئ الأولوية والتداخل (H3 داخل H2) وما إلى ذلك.

أثناء عمليات تدقيق تحسين محركات البحث (SEO) ، عادةً ما تنخفض مشكلات الرأس إلى أسفل قائمة الأولويات.

جافا سكريبت

في معظم الحالات ، يكون استخدام جافا سكريبت أمرًا طبيعيًا ولا يتعارض مع الفهرسة أو العرض ، وهو ما يعد من أقوى الحلول التي تتبعها Google. ومع ذلك ، في نسبة صغيرة من الحالات ، فإنه يسبب أخطاء حرجة في رؤية الموقع.

كقاعدة عامة ، كل ما عليك فعله هو التحقق مما إذا كان الموقع يتطلب إجراءً إضافيًا (عادةً نقرة) لعرض محتوى إضافي تم إنشاؤه بواسطة JavaScript. إذا حدث ذلك ، فمن المحتمل ألا ينفذ GoogleBot هذا الإجراء.

طريقة بسيطة وفعالة للتحقق من ذلك هي إجراء عمليتي زحف ، واحدة تلو الأخرى ، باستخدام الأداة المفضلة لديك. يجب أن يحلل الزحف الأول HTML فقط ، مع إيقاف تشغيل محرك Chrome. يجب أن يشتمل الآخر على JavaScript ، مع تشغيل محرك Chrome.

ستكشف المقارنة بين عمليتي زحف عن الاختلافات في البنية والارتباط ومحتوى كلا الإصدارين. الاختلافات نفسها ليست مشكلة - إذا كانت الأداة التي تم تشغيل العرض بها قادرة على الزحف إلى موقع الويب ، فمن المحتمل أن تدير Google أيضًا.

بالإضافة إلى ذلك ، من الجيد النقر فوق الصفحات الأساسية لموقع الويب وملاحظة الموارد الإضافية التي يتم تحميلها في Chrome DevTools ، إن وجدت. ركز انتباهك على العناصر الرئيسية ، مثل القائمة والارتباط الداخلي وتنفيذ المحتوى.

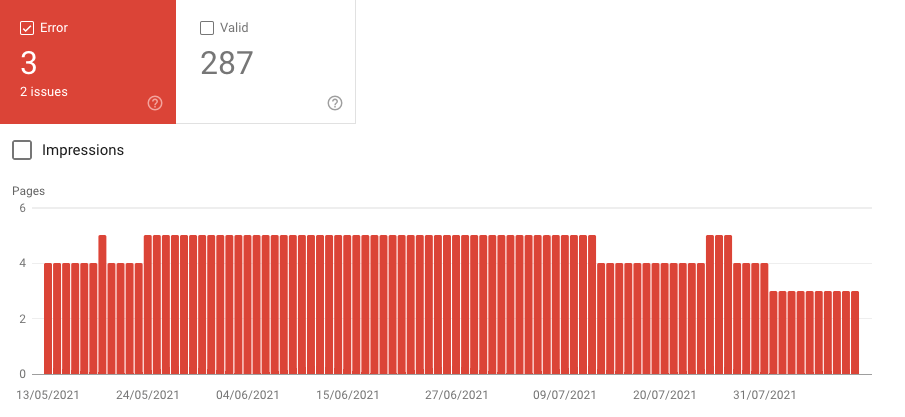

البيانات المنظمة / المقتطفات المنسقة

في معظم مواقع الويب ، يتم استخدام البيانات المنظمة تلقائيًا ، وهي ميزة إضافية. ومع ذلك ، لا يزال من الممكن أن تولد مشكلات تمت مناقشتها أدناه:

- عدم وجود بيانات منظمة.

- تقليل استخدام التنسيقات إلى الحد الأدنى (سيناريو متكرر). تقدم معظم التنسيقات حقول محتوى مطلوبة واختيارية لملئها. ومع ذلك ، غالبًا ما تقصر أنظمة التجارة الإلكترونية البيانات المضمنة في تنسيق المنتج على المعلومات المطلوبة.

- الفشل في وضع علامة على التنقل في مسارات التنقل - أداة بسيطة ومفيدة قد تعزز مظهر قائمتك في نتائج البحث.

- استخدام محدود للبيانات المنظمة. تقدم Google حاليًا معرضًا يضم 31 تنسيقًا مدعومًا - بما في ذلك الشعارات والتنسيقات المحلية والمقالات - لاستخدامها ودمجها بطرق لا تعد ولا تحصى.

عوامل تجربة المستخدم

سرعة تحميل الصفحة

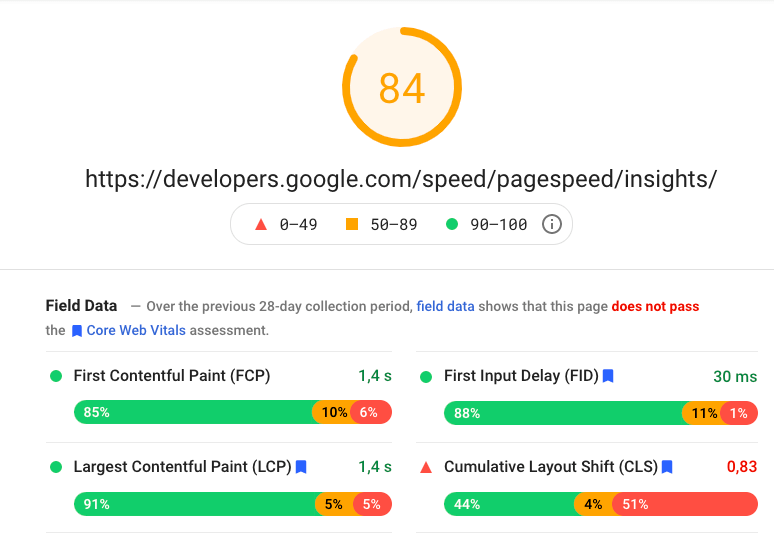

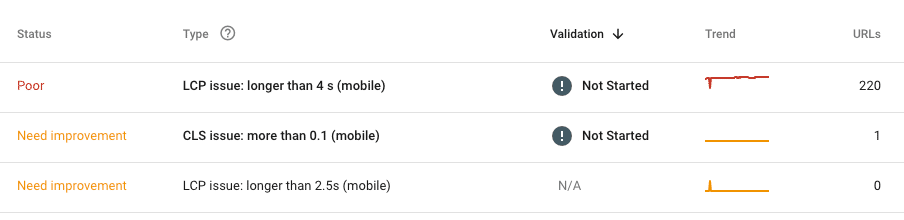

ليس هناك من ينكر أن سرعة تحميل الصفحة مهمة. يكفي أن نقول إن Google نفسها لم تعد تتحدث عن السرعة وحدها ، واستبدلت بـ "Core Web Vitals" ليتم تضمينها في الخوارزمية الأساسية في عام 2021.

حاليًا ، المعلمات الرئيسية التي يجب مراعاتها هي:

LCP - أكبر رسم محتوى - تقييم سرعة تحميل المحتوى الرئيسي ،

FID - أول تأخير للإدخال - تقييم سرعة استجابة الموقع لإجراءات المستخدم ،

CLS - تغيير التخطيط التراكمي - تقييم التغييرات المفاجئة في تخطيط الموقع عند التحميل.

تتضمن مجموعة أدواتنا بشكل أساسي منتجات Google: بيانات من GSC و PageSpeed Insights. كلاهما غير كامل ، يجب أن يخدمنا كمصدر رئيسي للتحليل ، ليتم استكماله بأداة محددة عند الحاجة.

مهم!

لا تقم أبدًا بتقييم سرعة الموقع على أساس الصفحة الرئيسية فقط. إنه أسوأ شيء يجب تضمينه في التدقيق. اتبع النهج الذي تعرفه من التحليلات الأخرى - قسّم الموقع إلى أقسام متشابهة ، بافتراض أن الأخطاء المكتشفة تظهر مرة أخرى عبر الموقع.

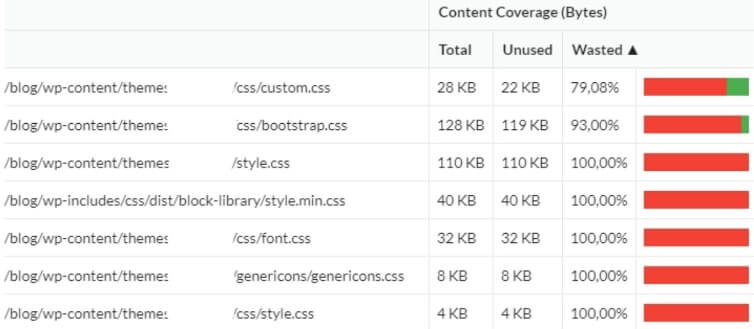

ما هي أكبر مشكلة الآن في سرعة الموقع؟ في مرحلة التطوير ، تكون الأولوية لتقديم الموقع بأسرع ما يمكن ، وليس لتحسين السرعة. وبالتالي ، غالبًا ما يلجأ المطورون إلى الأطر الجاهزة (دون الكثير من التفكير). نتيجة لذلك ، ينتهي الأمر بالمالك بالعشرات من الملفات الزائدة عن الحاجة التي لن يتم استخدامها مطلقًا. لهذا السبب ، أكمل تدقيق تحسين محركات البحث بتحليل استخدام الشفرة الفعلي أثناء العرض. غالبًا ما يتبين أنه حتى 3/4 من الكود يتم تركه دون استخدام

تحسين الهاتف المحمول

في العصر الحديث ، نادرًا ما نقوم بتدقيق المواقع التي لا تستجيب تمامًا. تم تكييف معظم المواقع بالكامل للأجهزة المحمولة - وهذا لا يعني بالضرورة تطبيق فلسفة الجوال أولاً.

على مدار العامين الماضيين ، لم أواجه أي موقع ويب لن يستجيب من البداية إلى النهاية. ومع ذلك ، فإن الشيطان يكمن في التفاصيل (تمامًا كما في حالة الأخطاء المتعلقة بالسرعة) ، لذا انتبه للأخطاء المعزولة مثل الصفحات التي يكتشف فيها GSC أو الزاحف مشكلات تحسين الهاتف المحمول. في معظم الحالات ، تنجم عن أخطاء بشرية (مرة أخرى ، تمامًا مثل الأخطاء المتعلقة بالسرعة) أو من محاولات إلقاء ميزات جديدة عرضًا ، غير مدرجة في الخطة الأصلية ، في موقع الويب الرئيسي ونظام إدارة المحتوى.

تحليل محتوى

في مُحسّنات محرّكات البحث (SEO) ، يشتمل محتوى موقع الويب على كل المحتوى خارج منطقة المعيارية ، أي العناصر الثابتة في الكود المصدري.

الازدواجية

في معظم الحالات ، يكون المحتوى المكرر الداخلي هو نتاج:

أخطاء في تصميم الموقع (الميزات والهيكل)

مثال:

مؤسسة مالية تقدم خدمات للعملاء الأفراد ورجال الأعمال والشركات الكبيرة. التنقل بناءً على نوع العرض الذي كان العميل مهتمًا به. عند الاختيار ، تمت إعادة توجيه المستخدمين إلى أحد الأقسام الثلاثة المخصصة:

https://domain.pl/individual-clients/

https://domain.pl/entrepreneur/

https://domain.pl/business/

يمكن للعميل تصفح العرض المخصص ، لكن الجزء الأول من عنوان URL ظل دون تغيير. لسوء الحظ ، تداخل محتوى العروض الثلاثة بنسبة 90٪. وبالتالي ، أنشأ موقع الويب 3 هياكل قابلة للتبديل تقريبًا بنفس المحتوى. إنه أحد الأخطاء الناتجة عن عدم وجود دعم تحسين محركات البحث في مرحلة التصميم. بسبب اللوائح الداخلية للعميل ، ثبت أن المشكلة يكاد يكون من المستحيل حلها. كان الحل الوحيد هو إطلاق موقع ويب جديد بعد عام واحد من التدقيق.

الأخطاء البشرية أو أخطاء التطوير

مثال:

كان للعميل نفس المحتوى في التذييل والقائمة الرئيسية. الحل ، الذي لا ينبغي أن يكون مشكلة بشكل عام ، تسبب في متاعب كبيرة. يتألف موقع الويب من حوالي 20 صفحة ، لكن خطأ بسيطًا في الارتباط الداخلي تسبب في تذييل الصفحة لمضاعفة موقع الويب إلى ما لا نهاية. ينشئ كل ارتباط في التذييل مكونًا إضافيًا في عنوان URL للتذييل. نتيجة لذلك ، انتهى الأمر بالعميل بعناوين مثل:

https://domain.pl/history/ history / history / contact / rules / history / contact / contact /

نوع الموقع

مثال:

للأسف ، يعد تكرار المحتوى الداخلي (والخارجي) أمرًا روتينيًا على مواقع التجارة الإلكترونية. لإدراك ذلك ، تخيل متجرًا يقدم منتجات مماثلة بأشكال متعددة. على سبيل المثال ، الهواتف الذكية بخمسة ألوان أو الملابس بأحجام مختلفة.

لا نريد حظر الفهرسة أو استخدام rel = canonical لمتغيرات مختلفة لمواصلة اكتساب حركة المرور من الذيل الطويل. ومع ذلك ، فإن هذا يترك لنا محتوى مكررًا أو شبه مكرر.

من الناحية المثالية ، يجب أن نفكر في كتابة أوصاف فريدة لكل منتج. ومع ذلك ، في حالة وجود العديد من وحدات SKU والتناوب العالي للمنتج ، فإن الحل الوحيد هو إنشاء أوصاف مختلفة للمنتج تلقائيًا على أساس ميزات المنتج الفريدة ومجموعاتها.

إصدارات URL متعددة وتنفيذ SSL

لسنوات ، اعتمد تحليل مشكلات النسخ الداخلي على التحقق من عمليات إعادة توجيه الصفحة الرئيسية إلى الإصدارات مع (خارج) www ومع (خارج https. هذه مشكلة نادرة في الوقت الحاضر. إلى جانب ذلك ، تعلمت Google التعامل معها بكفاءة عالية.

الأخطاء الأكثر شيوعًا المتعلقة بـ SSL:

- في المواقع التي تحتوي على روابط قائمة مشفرة ، قد تظل روابط "http" في أماكن عبر الموقع بين "https" الجديد. نتيجة لذلك ، ينتهي بنا الأمر بطبقة جديدة من عمليات إعادة التوجيه داخل موقع الويب.

- قد لا يتضمن الترحيل إلى SSL جميع الموارد. نتيجة لذلك ، قد يستمر تحميل عناصر مثل الرسومات أو البرامج النصية من إصدار "http".

الربط الداخلي

يؤثر الارتباط الداخلي على الزحف والفهرسة ووضوح كل صفحة ، حيث تمنح الروابط سلطة / سلطة داخلية للمواقع المستهدفة. تحليل الارتباط الداخلي عبارة عن مجموعة من عمليات التحقق المنفصلة المتعلقة بما يلي:

عناصر التنقل الدائمة: قائمة التنقل الرئيسية ، التذييل ، الشريط الجانبي

يجب التخطيط للربط الدائم ، وخاصة قائمة التنقل الرئيسية ، جنبًا إلى جنب مع استراتيجية استخدام الكلمات الرئيسية. عند إنشاء ارتباط رئيسي ، فإن البساطة هي المفتاح - لا تفرط في التفكير ، لأن كود HTML النظيف يعمل دائمًا بشكل أفضل.

عندما نقارن استراتيجيتنا بالواقع ونثبت أن القائمة الرئيسية تحتوي على جميع العناصر الضرورية ، فلنتحقق من الروابط الداخلية الدائمة ولكن الزائدة عن الحاجة عبر الموقع. يمكنك غالبًا اكتشافها في التذييل ، الحاوية المعتادة لأي شيء تقريبًا. إنه يستحق كل هذا الجهد لأن كل رابط فائض جديد يزعج التدفق الداخلي للسلطة.

بعض الروابط والصفحات ، مثل القواعد واللوائح أو سياسة الخصوصية ، ضرورية. ومع ذلك ، يمكن التخلص من البعض الآخر. على سبيل المثال ، هل أنت متأكد من أن كل طريقة شحن تحتاج إلى رابط منفصل في التذييل يؤدي إلى صفحة منفصلة؟ سوف يتناسبون جميعًا مع واحد. بصرف النظر عن الروابط المطلوبة ، دعنا ننظم الروابط الداخلية الخاصة بنا لتجنب الروابط الزائدة عن الحاجة إلى الصفحات التي لن يتم تصنيفها لعباراتنا الرئيسية.

الربط التلقائي - المشاركات / المنتجات المقترحة

الارتباط التلقائي يعني الارتباط بالمشاركات المقترحة (على المدونات) أو المنتجات المقترحة (على مواقع التجارة الإلكترونية). بشكل عام ، إذا تمت إدارة هذه الآليات بواسطة حلول جاهزة مدمجة في CMS (WordPress) ، فيجب أن يعمل كل شيء بسلاسة. إذا تم إنشاء الروابط بتنسيق HTML نظيف يشكل جزءًا من شفرة المصدر ، فكل ما نحتاجه هو القليل من التحسين. للأسف ، غالبًا ما تستخدم هذه الميزات حلولًا ديناميكية تستند إلى JavaScript (Case Onely + H & M) أو الأسوأ من ذلك ، حلول الشركات الخارجية المضمنة كنصوص من مجالات أخرى.

يستخدم الربط الفردي بين الصفحات بشكل رئيسي في أقسام المحتوى

يدعم الارتباط السياقي عبر المقالات نمو رؤية قسم المحتوى. ومع ذلك ، غالبًا ما يتم تجاهله. ونتيجة لذلك ، فإن الروابط الوحيدة التي تشير إلى المقالات هي تلك الموجودة في صفحات الفئات.

تحليل الربط السياقي بسيط نسبيًا. كل ما عليك فعله هو مزج بيانات الزحف على الارتباط الداخلي بمعلومات عن حركة المرور العضوية الحالية (GSC / Analytics). بالإضافة إلى ذلك ، يمكنك تضمين بيانات على الروابط الخارجية الواردة لتحديد المقالات التي تتمتع بأكبر قدر من الصلاحيات. أضف بيانات عن رؤية الكلمات الرئيسية الأولية (Senuto) لمعرفة المناطق التي تحتاج إلى اهتمامك وكيفية إصلاحها.

الربط الخارجي

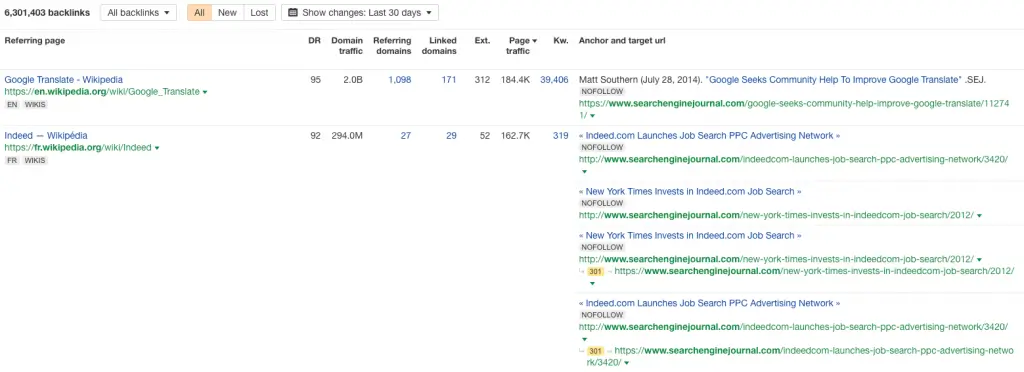

ربط تحليل ملف التعريف

لحسن الحظ ، فإن ملفات تعريف الارتباط الضعيفة نادرة بشكل متزايد ، على الرغم من أنه لا يزال بإمكانك مواجهة الروابط التي تم إنشاؤها باستخدام GSA أو Xrummer أو منشئ تلقائي آخر.

في الغالبية العظمى من الحالات ، تكون الروابط المهملة هي:

- تذكار جهود تحسين محركات البحث التي بذلها المتخصصون منذ بضع سنوات مضت

- الإشارة إلى اختراق الموقع لتحميل الرسائل الاقتحامية (SPAM) والتي تم ربطها من قبل المخترق

- منتج الكاشطات ومولدات الرسائل الاقتحامية (SPAM) التي تقوم بتنزيل محتوى الموقع.

عند فحص ملف تعريف الارتباط ، قم بتطبيق القاعدة الذهبية العالمية - التركيز على الحالات الشاذة.

من الأسهل اكتشافها في مخططات نمو الروابط الخلفية. كل الارتفاعات والانخفاضات المفاجئة قيد التحليل.

توزيع الربط العميق

يعمل تحليل تحسين محركات البحث (SEO) لتوزيع الروابط عبر الصفحة الرئيسية والصفحات الأخرى من الموقع على تقييم جودة ما يسمى بالرابط العميق وبالتالي تحديد الأقسام أو الصفحات التي تتمتع بأعلى سلطة خارجية. يخبرنا هذا ما إذا كان توزيع الارتباط الخاص بنا متساويًا ، وأي الصفحات يمكن أن تكون عُقدًا مهمة في الهيكل وتعمل كموزعين للطاقة للربط الداخلي.

الروابط الصادرة

من الأمور التي يتم تجاهلها بشكل متكرر تحليل الروابط الخارجية للموقع. عندما تقوم بفحص موقع ويب بناءً على المحتوى أو المحتوى الذي ينشئه المستخدم ، فمن المؤكد أنه يتضمن عشرات الروابط إلى المجالات الخارجية. على مر السنين ، تنتهي صلاحية العديد منهم أو ينتقلون أو ينتقلون إلى مواقع الويب الضارة. كرر تحليل الارتباط الصادر - باستخدام أداة زاحف أو أداة خارجية - مرة واحدة على الأقل في السنة.

الروابط الخلفية المكسورة والمفقودة

الروابط الخلفية المعطلة هي الروابط الواردة التي تشير إلى صفحة الخطأ 404 وتتجاهلها Google. مع نمو موقع الويب الخاص بك ، تظهر الروابط الخلفية المعطلة بشكل طبيعي - تغير الصفحات موقعها ، ويتم حذف بعضها ، ويرتكب الأشخاص أخطاء عند ربط المحتوى الخاص بنا. الروابط الخلفية المكسورة هي أيضًا نتيجة قياسية لعمليات الترحيل غير الصحيحة ، حيث نسي المطورون عمليات إعادة التوجيه ، ولم يغير موقع الويب هيكله فحسب ، بل فقد أيضًا جميع الروابط باستثناء الصفحة الرئيسية في غضون يوم واحد.

يجب تجميع جميع الروابط الخلفية المفقودة معًا وإعادة توجيهها إلى الصفحة ذات الصلة بالموضوع. كحل أخير ، قد نعيد توجيههم إلى موقع آخر على الموقع الإلكتروني أو الصفحة الرئيسية. إنها الطريقة الوحيدة لاستعادة السلطة التي اكتسبوها في مجالنا. أثناء تواجدك فيه ، راجع مجالات الربط - إذا أمكن ، أعد توجيه روابط الجودة فقط ، ودع البريد العشوائي يشير إلى 404.