BERT: Googles größtes Update seit Jahren

Veröffentlicht: 2022-12-01Googles BERT ging Ende 2019 live und wirkte sich auf fast 10 % aller Suchanfragen aus. Dies ist wohl eines der größten Algorithmus-Updates des Jahres 2019. Hier finden Sie alles, was SEOs und Websitebesitzer über Googles fortschrittliches Modell zur Verarbeitung natürlicher Sprache wissen sollten.

Was ist Googles BERT?

BERT ist ein Deep-Learning-Algorithmus und die Abkürzung für Bidirectional Encoder Representations from Transformers. Der Algorithmus half dabei, relevantere Ergebnisse für komplizierte Suchanfragen zu finden.

Welche Auswirkungen hatte die Aktualisierung des BERT-Algorithmus auf die Google-Suche?

Das hat Google gesagt:

„Diese Verbesserungen zielen darauf ab, das Sprachverständnis zu verbessern, insbesondere bei Abfragen in natürlicher Sprache/Konversation, da BERT der Suche helfen kann, die Nuancen und den Kontext von Wörtern in der Suche besser zu verstehen und diese Abfragen besser mit hilfreichen Ergebnissen abzugleichen.

Insbesondere bei längeren, eher konversationalen Suchanfragen oder Suchen, bei denen Präpositionen wie „for“ und „to“ für die Bedeutung von Bedeutung sind, kann die Suche den Kontext der Wörter in Ihrer Suchanfrage verstehen. Sie können auf eine Weise suchen, die sich für Sie natürlich anfühlt.“

Tatsächlich wird sich das BERT-Update laut Google auf 1 von 10 englischen Suchanfragen in den USA auswirken, das sind 10 % der Suchanfragen. Dies ist das bedeutendste Update von Google in den letzten 5 Jahren, zumindest laut ihnen:

Wir verbessern unser Verständnis von Abfragen erheblich, was den größten Sprung nach vorne in den letzten fünf Jahren und einen der größten Sprünge nach vorne in der Geschichte der Suche darstellt.

Die Einführung von BERT verursachte in der ersten Woche der Einführung des neuen Algorithmus große Ranking-Schwankungen. SEOs bei Webmaster World kommentieren die Schwankungen seit Anfang der Woche und vermerken die größte Ranking-Schwankung, die die SEO-Welt seit RankBrain getroffen hat.

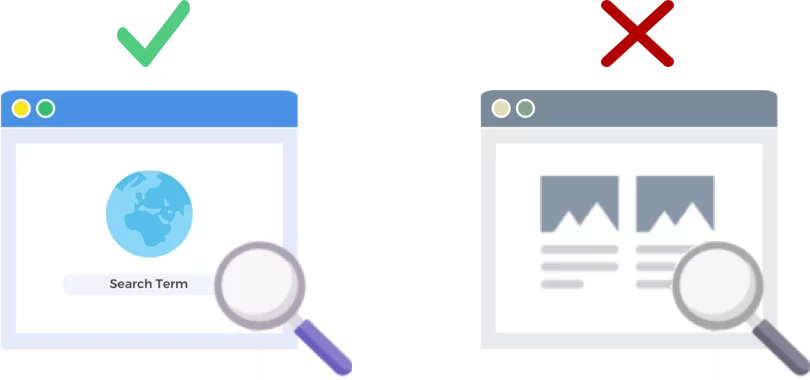

BERT analysiert Suchanfragen, NICHT Webseiten

Die Veröffentlichung des BERT-Algorithmus vom 24. Oktober 2019 verbessert, wie der Suchmaschinengigant Suchanfragen (nicht Webseiten) analysiert und versteht.

Wie funktioniert BERT?

BERT verbessert Googles Verständnis von Suchanfragen mithilfe eines bidirektionalen Kontextmodells (das ist das B in BERT). Google hat letztes Jahr um diese Zeit ein wenig über die Mechanik von BERT gesprochen, als sie BERT als neue Technik für das Vortraining zur Verarbeitung natürlicher Sprache (Natural Language Processing, NLP) ankündigten.

Was ist Vortraining? Vorschulung bedeutet nur, einer Maschine beizubringen, wie sie Aufgaben erledigen soll, bevor Sie ihr tatsächlich Arbeit geben. Herkömmliche Datensätze vor dem Training werden mit einigen tausend bis einigen hunderttausend von Menschen gekennzeichneten Beispielen geladen.

Pre-Training gibt es schon seit einiger Zeit, aber was BERT besonders macht, ist, dass es sowohl kontextbezogen (die Bedeutung jedes Wortes ändert sich basierend auf den Wörtern um es herum) als auch bidirektional ist – die Bedeutung eines Wortes wird basierend auf den Wörtern davor und verstanden Danach.

Laut Googles Blog:

In dem Satz „ Ich habe auf das Bankkonto zugegriffen “ würde ein unidirektionales kontextuelles Modell „ Bank “ darstellen, basierend auf „ Ich habe auf das zugegriffen “, aber nicht auf „ Konto “. Allerdings stellt BERT „ Bank “ dar, indem es sowohl seinen vorherigen als auch seinen nächsten Kontext verwendet – „Ich habe auf das … Konto zugegriffen “ –, beginnend ganz unten in einem tiefen neuronalen Netzwerk, wodurch es zutiefst bidirektional wird.

Das Google BERT-Update baut auf den jüngsten Fortschritten beim maschinellen Lernen und der Entitätserkennung auf. Grundsätzlich hilft BERT dabei, alle Wortarten und den Kontext der Wörter zu identifizieren, bevor Google eine Suche verarbeitet.

Was bedeutet BERT für Suchergebnisse?

Laut Google bedeutet dies, dass Benutzer relevantere Ergebnisse sehen werden, Ergebnisse, die besser der Absicht der Suche eines Benutzers entsprechen. Diese Algorithmusverbesserung umfasst reguläre Ergebnisse und Rich-Snippet-Ergebnisse.

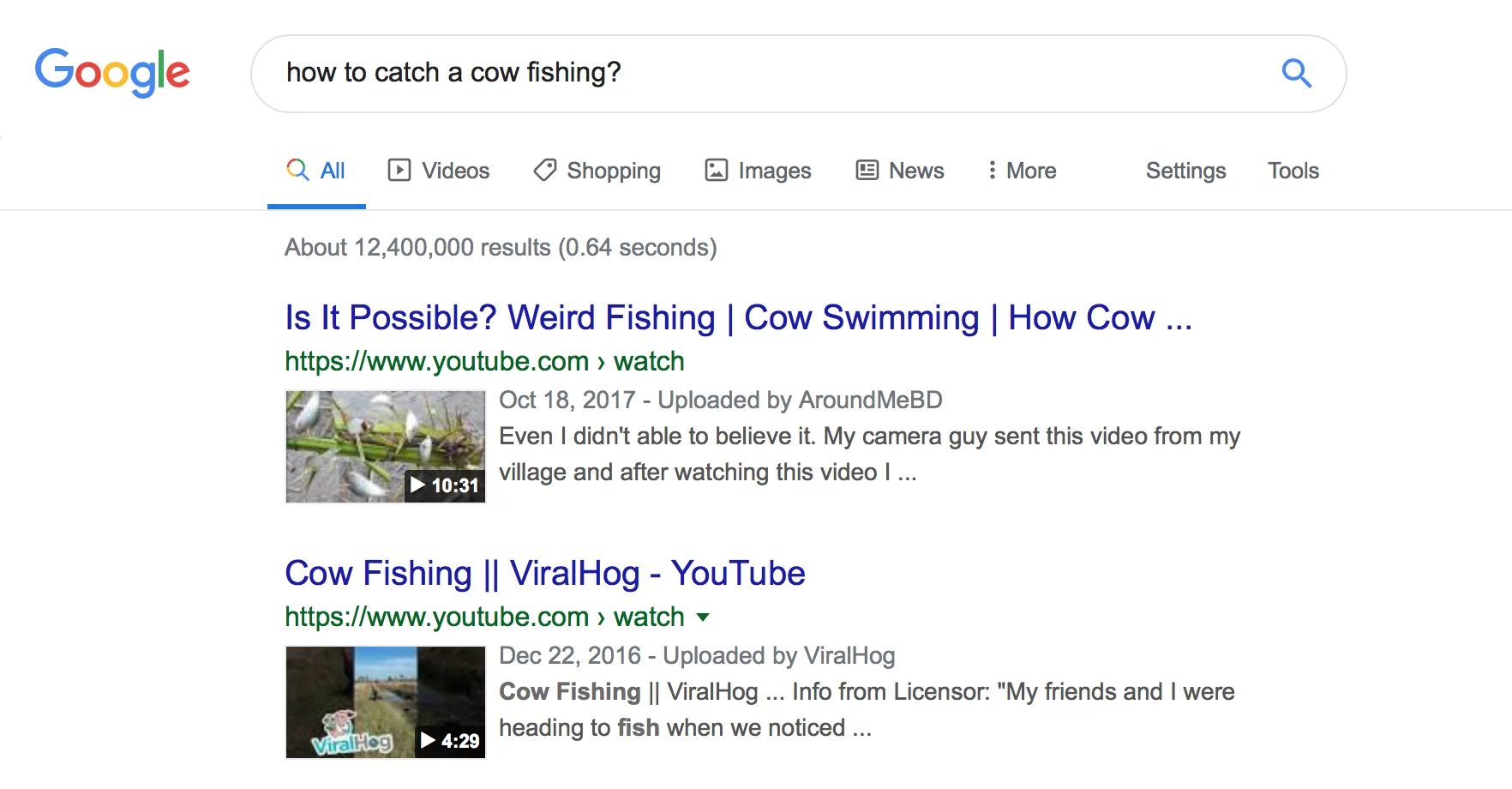

Google lieferte in seinem Blog-Eintrag zur Ankündigung von BERT einige hilfreiche Beispiele.

Das Beispiel der Kosmetikerin

Zunächst einmal haben wir einen Benutzer, der zu verstehen versucht, ob Kosmetikerinnen im Rahmen ihrer Arbeit viel Zeit auf den Beinen verbringen.

Sie können unten sehen, dass Google vor BERT die Abfrage „Stehen Kosmetikerinnen bei der Arbeit viel“ gelesen und ein Ergebnis produziert hat, das Arten von Arbeitsumgebungen für Kosmetikerinnen vergleicht.

Nachdem BERT Google einen Artikel über die körperlichen Anforderungen als Kosmetikerin veröffentlicht hat, entspricht dies viel mehr den Informationen, die der Suchende ursprünglich zu finden versuchte.

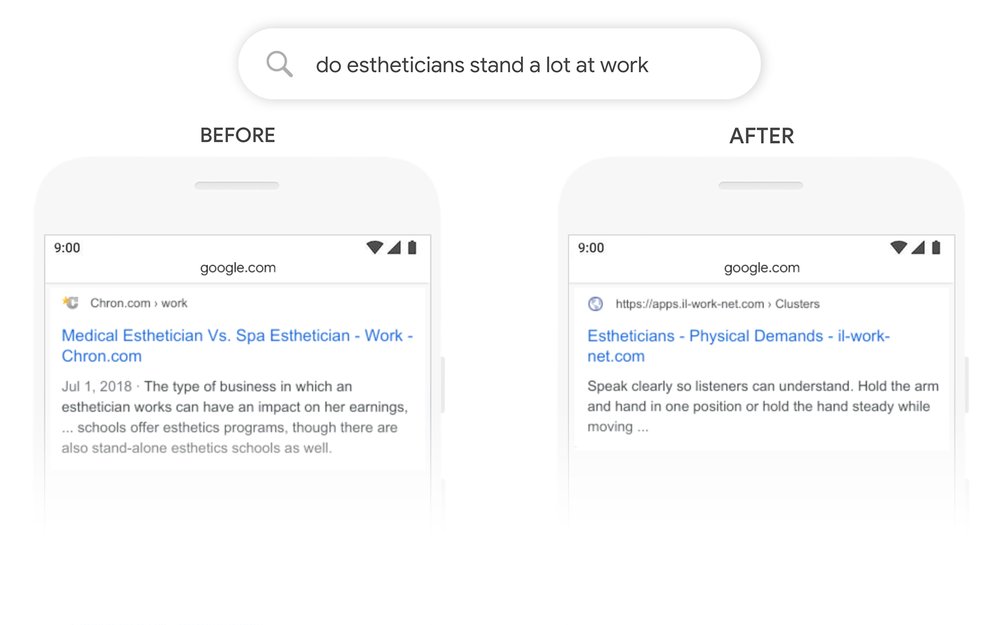

Das Beispiel der Mathe-Übungsbücher

In diesem Beispiel sucht ein Benutzer nach Mathe-Übungsbüchern für Erwachsene, findet aber Mathe-Übungsbücher für Kinder.

Nach BERT erkennt Google den Kontext der Suchanfrage richtig und berücksichtigt den zweiten Teil der Suche „nach Erwachsenen“ besser.

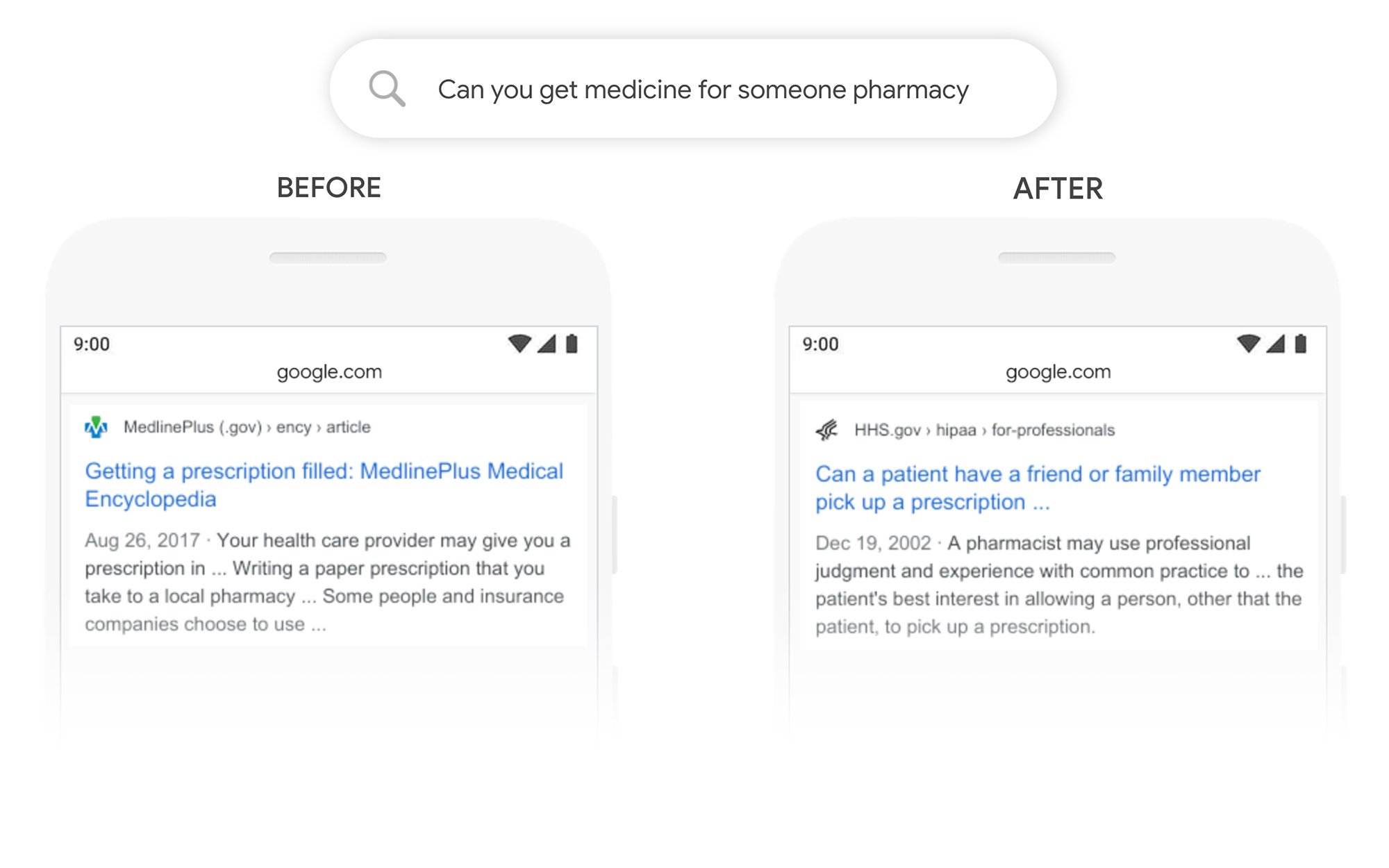

Das Beispiel „Können Sie Medikamente für jemand anderen abholen“.

In diesem Beispiel gibt die Abfrage „Können Sie Medikamente für jemanden in der Apotheke besorgen“ ein Ergebnis darüber zurück, wie Rezepte im Allgemeinen ausgefüllt werden, und nicht, wie sie für einen Drittanbieter ausgefüllt werden. Nach BERT versteht Google das Ziel des Nutzers besser und zeigt an, ob ein Patient sein Rezept von einem Freund oder Familienmitglied abholen lassen kann oder nicht.

Was kann ich tun, um nach BERT besser zu ranken?

Für alle Keywords, bei denen Sie Rankings verlieren, sollten Sie einen Blick auf die überarbeitete Suchergebnisseite werfen, um besser zu verstehen, wie Google die Suchabsicht Ihrer Zielbegriffe sieht. Überarbeiten Sie dann Ihre Inhalte entsprechend, um die Ziele des Benutzers besser zu erfüllen.

Wenn Sie Rankings unter BERT verloren haben, ist es eher ein Problem, wie gut Ihre Seite mit der Suchabsicht eines Benutzers übereinstimmt (hilft einem Benutzer, sein Ziel zu erreichen), als ein Problem mit der Inhaltsqualität.

Angesichts der Tatsache, dass BERT die Sprachsuche im Laufe der Zeit wahrscheinlich weiter unterstützen wird, empfehlen wir Websites außerdem, klare und prägnante Texte zu schreiben. Verwenden Sie keine Füllwörter, seien Sie nicht vage, kommen Sie direkt auf den Punkt.

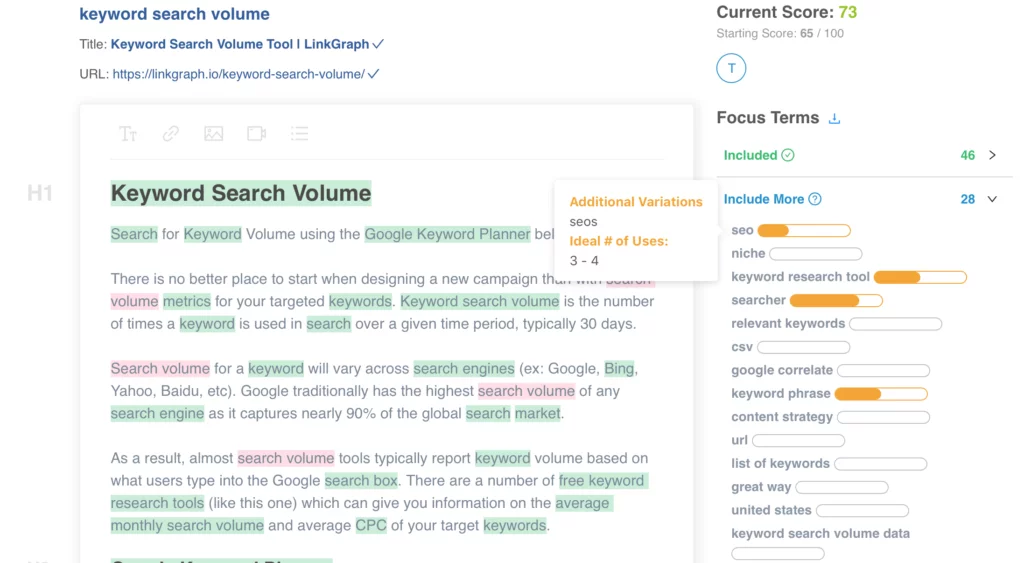

Benötigen Sie Hilfe bei der Optimierung Ihrer Inhalte? Schauen Sie sich den On Page Content Optimizer von LinkGraph an, wenden Sie sich an ein Mitglied unseres Teams unter [email protected] oder vereinbaren Sie noch heute ein Meeting, um die Einrichtung vorzunehmen.

Wo kann ich mehr erfahren?

Dawn Anderson hat Anfang dieses Monats auf der Pubcon eine großartige Präsentation zum Thema „Google BERT and Family and the Natural Language Understanding Leaderboard Race“ gehalten, und Sie können sich ihre Präsentation ansehen.

Danke, dass du mein #Pubcon hast. Hier ist mein Deck <3 <3 https://t.co/aGYDI9pfdY

– Dawn Anderson (@dawnieando) 10. Oktober 2019

Jeff Dean hat kürzlich auch eine Keynote zu AI bei Google einschließlich BERT gehalten, die Sie sich ansehen können.