Die 7 besten Web-Scraping-Tools online im Jahr 2023

Veröffentlicht: 2023-11-17Zusammenfassung: Web-Scraping-Tools optimieren den Datenextraktionsprozess von Websites, um datengesteuerte Entscheidungen zu treffen. Lassen Sie uns einige der besten Schabewerkzeuge erkunden, die Sie für diesen Zweck verwenden können.

Website-Scraping-Tools spielen beim Extrahieren von Daten von Websites eine entscheidende Rolle. Sie ermöglichen Benutzern das Sammeln, Analysieren und Organisieren von Informationen für verschiedene Zwecke, einschließlich Forschung, Analyse und Wettbewerbserkenntnisse. Sie können den gesamten Prozess der Datenextraktion automatisieren und erheblich zur datengesteuerten Entscheidungsfindung in verschiedenen Bereichen beitragen.

In diesem Artikel lernen wir die besten Web-Extraktionstools kennen, die beim Exportieren von Daten nützlich sein können. Doch zunächst erfahren wir, was genau Web Scraping ist.

Inhaltsverzeichnis

Was ist Web Scraping?

Web Scraping ist eine automatisierte Methode zum Sammeln von Massendaten von verschiedenen Websites. Bei den extrahierten Daten handelt es sich um unstrukturierte Daten in HTML, die in strukturierte Daten wie Tabellenkalkulationen und Datenbanken umgewandelt werden.

Es gibt mehrere Möglichkeiten, Daten von Websites zu entfernen, z. B. mithilfe von APIs und Software sowie durch die Erstellung eines eigenen Codes dafür. Viele Softwarebeispiele bieten integrierte Scraping-Bots oder ermöglichen Ihnen die Erstellung eigener Scraping-Bots für das Web-Scraping.

Liste der 7 Web-Scraping-Tools von 2023 in Indien für Anfänger

- Octoparse

- ParseHub

- Scraping-Bot

- Scrapingbee

- Apify

- Zenscrape

- Web-Scraper

Hier finden Sie eine detaillierte Auflistung der besten Web-Scraping-Tools basierend auf ihren Funktionen, Preisen, Vor- und Nachteilen usw., um Ihnen bei der Auswahl der besten Software zu helfen.

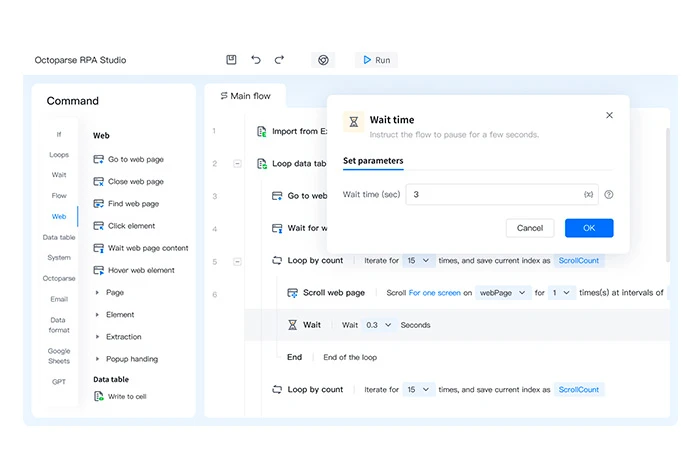

Octoparse

Octoparse ist ein Web-Scraping-Tool, mit dem Sie Ihre Webseiten in wenigen Sekunden in strukturierte Daten umwandeln können. Es handelt sich um eine Software ohne Code, die relevante Informationen aus verschiedenen Arten von Websites oder Webseiten extrahieren kann.

Die unstrukturierten Daten, die von jeder Website extrahiert werden, werden in strukturierten Dateiformaten wie HTML, Nur-Text, Excel usw. gespeichert.

Octoparse-Funktionen

- Exportiert Daten in mehrere Formate wie Excel, CSV und JSON

- Plant den Datenexport in Datenbanken

- Bietet mehrere Vorlagen zum Scrapen von Daten

- Erstellt Web-Scraper ohne Code

- Erstellt 750 Aufgaben für Web Scraping

Vor- und Nachteile von Octoparse

- Es unterstützt die automatische IP-Rotation beim Extrahieren von Daten von einer Website, um die Wahrscheinlichkeit einer Rückverfolgung zu verringern.

- Sie können über Cloud-Server auch Daten aus mehreren Clouds extrahieren.

- Begrenzte Optionen zur Anpassung der Software verfügbar.

Preise für Octoparse: Kostenloser Plan verfügbar | Der kostenpflichtige Plan beginnt bei 6.241,54 INR/Monat

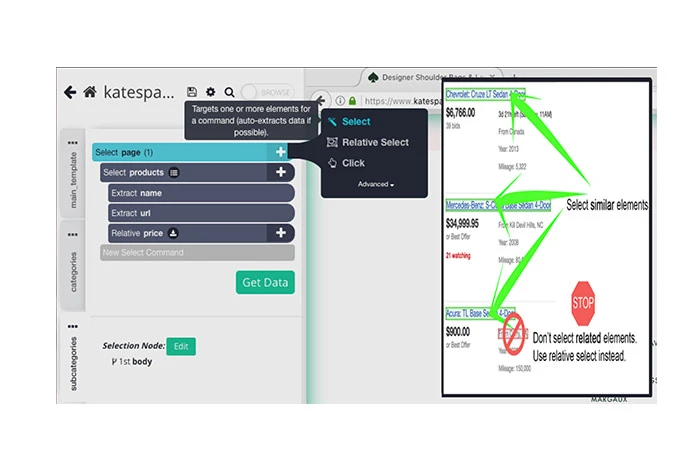

ParseHub

Das kostenlose Scrapping-Tool ParseHub kann zum Scraping von Daten von verschiedenen Websites verwendet werden. Sie müssen lediglich die Website zum Verschrotten auswählen, die Daten zum Verschrotten auswählen und die gescrapten Daten in verschiedene Formate exportieren.

Es kann zum Speichern von Daten von verschiedenen Servern, zum Rendern von JavaScript, zum Lösen von CAPTCHAs usw. verwendet werden. Mit der Planungsfunktion können Sie auch die Datenextraktion auf verschiedenen Websites planen.

ParseHub-Funktionen

- Automatische Rotation der IP-Adressen zum Crawlen von Websites

- Importiert die Scraped-Daten in mehrere Formate wie JSON und Excel

- Verschrottet Vertriebskontakte aus Verzeichnissen, Communities, sozialen Medien usw.

- Bietet mehrere APIs zum Aggregieren von Daten aus verschiedenen Quellen

- Extrahiert Daten aus Tabellen, Karten und Diagrammen

Vor- und Nachteile von ParseHub

- Es bietet eine Integration mit Dropbox, um extrahierte Daten zu speichern.

- Sie können damit Bilder, Texte, Attribute usw. aus Websites extrahieren.

- Für Benutzer mit geringen technischen Kenntnissen kann es schwierig sein, die Software zu verwenden.

Preise für ParseHub: Kostenloser Plan verfügbar | Der kostenpflichtige Plan beginnt bei 15.736,69 INR/Monat

Scraping-Bot

Scraping Bot bietet eine Web-Scraping-API zum Extrahieren von HTML-Daten aus verschiedenen Quellen, ohne blockiert zu werden. Es bietet mehrere APIs, die auf den jeweiligen Sektor zugeschnitten sind, um die relevantesten Daten zu extrahieren. Sobald die Daten analysiert sind, werden sie automatisch im JSON-Format importiert, um sie in den vorhandenen Workflow zu integrieren.

Scraping-Bot-Funktionen

- Unterstützt gleichzeitige Serveranfragen

- Automatisiert den Datenerfassungsvorgang

- Extrahiert Kundendaten, um Vertriebskontakte zu finden

- Bietet sentimentale Analysen

- Kuratiert Inhalte aus verschiedenen Quellen, um die Content-Strategie zu verbessern

Vor- und Nachteile von Scraping Bot

- Es unterstützt auch JavaScript-Rendering.

- Bietet Geotargeting, um Websites basierend auf Ihrem geografischen Standort zu filtern

- Es benötigt viel Systemspeicher und RAM.

Scraping Bot-Preise: Kostenloser Plan verfügbar | Der kostenpflichtige Plan beginnt bei 3.476,21 INR/Monat

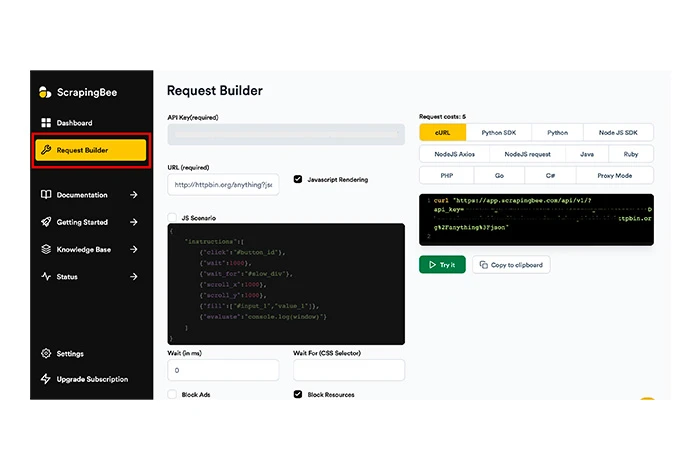

Scrapingbee

Scrapingbee ist ein weiteres Website-Scraping-Tool, das Ihnen beim allgemeinen Web-Scraping, beim Search Engine Result Page (SERP)-basierten Scraping und beim Growth Hacking helfen kann.

Das Tool kann JavaScript auf Seiten ausführen und alle Proxys für jede Anfrage rotieren, um Ihnen die Roh-HTML-Seite ohne Gefahr einer Blockierung zur Verfügung zu stellen. ScrapingBee verwaltet die CAPTCHAs, Proxys und Browser, sodass Sie problemlos Daten von der gewünschten Site extrahieren können.

Funktionen von Scrapingbee

- Unterstützt IP-Rotation für Web Scraping

- Bietet automatische Proxy-Rotation

- Bietet allgemeines Web-Scraping

- Extrahiert Webseiten-HTML, JSON usw.

- Erstellt benutzerdefinierte Web-Scraping-Engines ohne Code

Vor- und Nachteile von Scrapingbee

- Unterstützt geografisch ausgerichtetes Daten-Scraping.

- Bietet eine separate API für das Scraping der Google-Suche.

- Interne Serverfehler treten sehr häufig auf.

Scrapingbee-Preise: Kein kostenloser Plan verfügbar | Der kostenpflichtige Plan beginnt bei 4.077,57 INR/Monat

Apify

Apify ist eine Web-Scraping-Software, mit der Sie verschiedene Web-Scraping-Tools erstellen, bereitstellen und überwachen können. Sie können damit verschiedene APIs für das Website-Scraping erstellen und Rechenzentrums-Proxys für die Datenextraktion optimieren.

Apify hat auch einen Shop, in dem es vorgefertigte Scraping-Tools zum Scraping von Websites wie Instagram, Twitter, Google Maps usw. anbietet. Es verfügt über mehrere Funktionen für Web-Scraping, Workflow-Automatisierung und Datenextraktion.

Funktionen von Apify

- Führt unbegrenzt viele Aufgaben gleichzeitig aus

- Verwaltet Proxys für Rechenzentren und SERPs

- Extrahiert Daten von Amazon, schema.org, Webseiten usw.

- Unterstützt die Rotation von IP-Adressen beim Scraping von Daten

- Bietet CAPTCHA-Lösung und JavaScript-Rendering

- Exportiert Daten in Formaten wie CSV, JSON, Excel usw.

Vor- und Nachteile von Apify

- Bietet Proxy-Rotation als integrierte Funktion.

- Über APIs kann auf Daten in mehreren Formaten zugegriffen werden.

- Es können Probleme mit der Softwarekompatibilität auftreten.

Apify-Preise: Kostenloser Plan verfügbar | Der kostenpflichtige Plan beginnt bei 4.077,64 INR/Monat

Zenscrape

Zenscrape ist eine API, die alle Web-Scraping-Probleme verwaltet und die Extraktion hochwertiger HTML-Daten unterstützt. Das Tool rendert Anfragen über einen modernen Headless-Chrome-Browser für eine präzise und genaue Datenaggregation.

Die von Websites abgerufenen Daten werden in mehrere Formate wie Excel und JSON exportiert. Darüber hinaus können Sie mit der Geolokalisierungsfunktion den Proxy-Standort auswählen, um geografisch ausgerichtete Website-Inhalte anzuzeigen.

Zenscrape-Funktionen

- Unterstützt Web-Crawling

- Führt Preisdaten-Scraping durch

- Löscht automatisch Kontaktinformationen von Websites

- Verwaltet Standard- und Premium-Website-Proxys

- Unterstützt IP-Rotation und CAPTCHA-Lösung

Vor- und Nachteile von Zenscrape

- Es unterstützt auch die HTML-Datenextraktion von Websites.

- Die Reaktionszeit von Websites ist in Zenscrape sehr schnell.

- Sie müssen ein Drittanbieter-Tool verwenden, um abgerufene Daten in verschiedene Dateiformate zu konvertieren.

Preise für Zenscrape: Kostenloser Plan verfügbar | Der kostenpflichtige Plan beginnt bei 2.496,26 INR/Monat

Web-Scraper

Web Scraper ist ein Online-Scraping-Tool, das Sie für die regelmäßige und geplante Datenextraktion verwenden können. Es kann in andere Systeme integriert werden, um die extrahierten Daten zu nutzen. Mit diesem Scraping-Tool können Sie die Daten in großen Mengen extrahieren und die Scraping-Aufgaben mehrerer Websites gleichzeitig ausführen.

Funktionen von Web Scraper

- Automatisiert schnell den Datenextraktionsprozess

- Konfiguriert Scraper ohne Codierung

- Extrahiert Site-Daten mit Unterstützung für mehrstufige Navigation

- Verwendet Sitemaps zur Anpassung der Website-Daten

- Exportiert Daten in CSV, XLSX, JSON und anderen Formaten.

Vor- und Nachteile von Web Scraper

- Sie können das Website-Scraping auch auf der Grundlage von Wochen, Tagen, Stunden usw. planen.

- Es kann IP mit mehreren IP-Adressen rotieren.

- Die Einrichtung nimmt viel Zeit in Anspruch.

- Die abgerufenen Daten werden nur bis zu 60 Tage gespeichert.

Web Scraper-Preise: Kostenloser Plan verfügbar | Der kostenpflichtige Plan beginnt bei INR 4.162,90/Monat

Wie wählt man einen Web Scraper aus?

Um den richtigen Webscraper auszuwählen, müssen Sie die folgenden Faktoren berücksichtigen:

- Unterstütztes Betriebssystem: Der Web Scraper, den Sie kaufen möchten, muss das von Ihnen verwendete Betriebssystem unterstützen.

- Cloud-Unterstützung: Mit dieser Unterstützung können Sie strukturierte Daten über die Cloud speichern.

- Integration: Die Integration mit anderen Plattformen ermöglicht Ihnen die einfache Übertragung der abgerufenen Daten auf andere Plattformen.

- Schulung: Da die Verwendung eines Web-Scrapping-Tools Programmierkenntnisse erfordert, müssen Sie ein Tool auswählen, das umfangreiche Schulungsmaterialien bietet.

- Preisgestaltung: Berücksichtigen Sie die Preisgestaltung der Software und stellen Sie sicher, dass sie innerhalb Ihres Budgets liegt.

Wie funktioniert Web Scraping?

Das Web-Scraping erfolgt in drei einfachen Schritten. Erstens simuliert der Scraping-Bot das Surfen durch Menschen und löscht die Website, zweitens analysiert er Daten vom Datenknoten. Schließlich werden die analysierten Daten heruntergeladen und konvertiert. Hier ist die detaillierte Aufzählung jedes Schritts im Detail.

Schritt 1: Der Web-Scraping-Bot simuliert einen Menschen beim Surfen auf einer bestimmten Website. Anschließend gibt es die Ziel-URL ein und sendet Anfragen an einen Server. Sobald dies erledigt ist, liefert der Server Informationen an die HTML-Datei zurück.

Schritt 2: Mit HTML-Code erreicht der Bot den Datenknoten und analysiert die Daten gemäß den Anweisungen des Scraping-Codes.

Schritt 3: Basierend auf der Bot-Konfiguration werden die gescrapten Daten bereinigt und in das strukturierte Datenformat wie JSON konvertiert. Danach stehen die Daten zum Import oder Transport in verschiedene Datenbanken bereit.

Vergleich der besten Web-Extraktionstools

Hier ist ein Vergleich der besten Web-Scraping-Tools basierend auf ihren unterstützten Betriebssystemen, der Verfügbarkeit kostenloser Testversionen und der Gesamtbewertung der Benutzer.

| Software | Unterstütztes Betriebssystem | Kostenlose Testphase | Bewertung |

| Octoparse | Windows, Mac | Verfügbar | 4 |

| ParseHub | Windows, macOS, Linux | Nicht verfügbar | 4.5 |

| Scraping-Bot | Windows, Mac | Verfügbar | 3.5 |

| Scrapingbee | Webbasiert | Verfügbar für 14 Tage | 4.1 |

| Apify | Webbasiert | Kostenlose Nutzung | 4.9 |

| Zenscrape | Webbasiert | Kostenloses Datenanalysetool | 3.8 |

| Web-Scraper | Windows, Mac | Verfügbar für 7 Tage | 4.1 |

Abschluss

Nachdem Sie den Artikel gelesen haben, haben Sie vielleicht die Website-Scraping-Tools verstanden und wissen, wie sie Ihnen bei der Datenextraktion helfen können. In diesem Artikel haben wir Top-Software zum Extrahieren und Importieren von Daten von Websites aufgelistet.

Basierend auf Funktionen wie Datenextraktion, IP-Rotation, Proxy-Verwaltung usw. haben sich ParseHub und Scraping Bot als die besten Tools für Web Scraping erwiesen. Bevor Sie sich jedoch für ein Web-Scraping-Tool entscheiden, sollten Sie unbedingt Ihre Preis- und Funktionsanforderungen berücksichtigen.

Häufig gestellte Fragen zu Web Scrapper Tools

Was sind Web-Extraktionstools?

Web-Scraping-Tools sind Softwareprogramme, die dazu dienen, die Datenextraktionsfunktion von Websites zu optimieren. Mit diesen Tools können Sie Ihren eigenen Bot erstellen, der die erforderlichen Daten von bestimmten Websites entfernen kann.

Wofür wird Web Scraping verwendet?

Web Scraping kann für verschiedene Zwecke verwendet werden, z. B. zum Extrahieren von Social-Media-Daten, Kontaktinformationen, Immobiliendaten, Aktienkursinformationen und vielem mehr.

Wie extrahiere ich Daten von der Website?

Um die Daten von Ihrer Website zu extrahieren, können Sie verschiedene Data-Scraping-Tools verwenden. Einige der besten Tools, die Sie für Web Scraping in Betracht ziehen können, sind Zenscrape, Apify, Scrapingbee, Smartproxy, Agenty usw.

Welche Vorteile bietet der Einsatz von Web-Scraping-Tools für Unternehmen?

Durch den Einsatz von Web-Scraping-Tools können Unternehmen den Datenextraktionsprozess automatisieren, wertvolle Zeit sparen und die Daten nutzen, um wertvolle Erkenntnisse zu gewinnen. Darüber hinaus können Unternehmen mit diesen Web-Parsing-Tools auch Daten von mehreren Websites gleichzeitig löschen, um Zeit und Ressourcen zu sparen.

Sind für die Verwendung von Web-Scraping-Tools Programmierkenntnisse erforderlich?

Für die Verwendung eines Website-Scraping-Tools sind grundlegende Programmierkenntnisse erforderlich. Dies ist jedoch nicht notwendig, da viele Tools über benutzerfreundliche Oberflächen verfügen und mit geringen oder keinen technischen Kenntnissen verwendet werden können.

Wie kann ich kostenlos Daten scrapen?

Um die Website-Daten kostenlos zu scrappen, können Sie kostenlose Daten-Scraping-Tools wählen. Diese Tools bieten kostenlose Pläne oder sind völlig kostenlos zu nutzen. Zu diesen Tools gehören Apify, Zenscrape, Octoparse usw.