Sind Sie es leid, dass ChatGPT Ihre Inhalte auswertet? Schützen Sie Ihre Inhalte JETZT

Veröffentlicht: 2023-07-06

In der heutigen digitalen Landschaft ist der Schutz Ihrer Inhalte, Daten und Ihres Webverkehrs von größter Bedeutung. Mit dem Aufkommen von ChatGPT und anderen KI-Sprachmodellen wächst die Sorge, dass diese Tools Inhalte zu ihrem eigenen Vorteil ausnutzen könnten. Als Herausgeber ist es wichtig zu verstehen, wie diese Bots funktionieren und welche potenziellen Risiken sie mit sich bringen.

In diesem Artikel erkunden wir die Welt des ChatGPT- und LLM-Scrapings und diskutieren Strategien, um Ihren Website-Verkehr auszutricksen und zu schützen.

Woher weiß ich, dass ChatGPT meine Inhalte scrapt?

ChatGPT, verschiedene Plugins und andere Sprachmodelle haben aufgrund ihrer bemerkenswerten Fähigkeit, menschenähnlichen Text zu generieren, Starstatus erlangt. Diese Tools haben Mitarbeiter aus verschiedenen Branchen übernommen und entlassen, darunter Content-Erstellung, Kundenservice und sogar kreatives Schreiben. Obwohl sie in vielerlei Hinsicht hilfreich sein können, ist es wichtig zu verstehen, dass es Fälle gibt, in denen sie zum Scrapen von Inhalten missbraucht werden können.

Unter Scraping versteht man im Zusammenhang mit dem Internet den Prozess, bei dem mithilfe automatisierter Bots Informationen von Websites extrahiert werden. Diese Bots besuchen verschiedene Webseiten, sammeln Daten und nutzen diese, um KI-Modelle weiter zu trainieren. Wenn ChatGPT oder andere LLMs Inhalte auswerten, nutzen sie im Wesentlichen die gesammelten Daten, um ihre Fähigkeiten zur Textgenerierung zu verbessern.

Das Hauptproblem entsteht jedoch, wenn dieser Scraping-Prozess geistige Eigentumsrechte verletzt und das Geschäft von Verlagen und Medienorganisationen beeinträchtigt. Es ist wichtig, sich darüber im Klaren zu sein, wie Ihre Inhalte gecrackt werden können und welche möglichen Folgen dies für Ihren Webverkehr hat.

Die Probleme beim Schaben

Eines der Hauptprobleme beim Scraping besteht darin, dass es dazu führen kann, dass Sie die Kontrolle über Ihre Inhalte verlieren. Wenn der Inhalt Ihrer Website gelöscht wird, kann er ohne Ihre Zustimmung für andere Zwecke verwendet und an anderer Stelle verbreitet werden. Dies untergräbt Ihre Autorität als ursprünglicher Ersteller und stellt die Aufrechterhaltung der Genauigkeit und Integrität Ihrer Inhalte vor Herausforderungen.

Scraping kann erhebliche Auswirkungen auf das Suchmaschinenranking Ihrer Website haben. Suchmaschinen priorisieren originelle und einzigartige Inhalte, und wenn gelöschte Inhalte an anderer Stelle veröffentlicht werden, kann dies die Sichtbarkeit und Relevanz Ihrer Website in den Suchergebnissen beeinträchtigen. Dies kann zu einem Rückgang des organischen Traffics und potenziellen Umsatzeinbußen führen.

Es kann auch zu einer verzerrten Darstellung Ihrer Marke oder Organisation führen. Wenn gescrapte Inhalte unangemessen oder aus dem Kontext gerissen verwendet werden, können sie Ihre Absichten falsch darstellen, was zu Verwirrung oder sogar Rufschädigung führen kann. Der Schutz Ihrer Markenidentität und die Sicherstellung, dass Ihre Inhalte verantwortungsvoll und mit der richtigen Quellenangabe verwendet werden, sind von entscheidender Bedeutung.

Die Lösung des Scraping-Problems erfordert einen vielschichtigen Ansatz. Als Inhaltsersteller oder Websitebesitzer können Sie verschiedene Maßnahmen ergreifen, um Ihre Inhalte vor Scraping zu schützen. Die Implementierung von Technologien wie CAPTCHA, IP-Blockierung oder Inhaltszugriffsbeschränkungen kann dazu beitragen, automatisierte Bots davon abzuhalten, auf Ihre Website zuzugreifen und diese zu scannen.

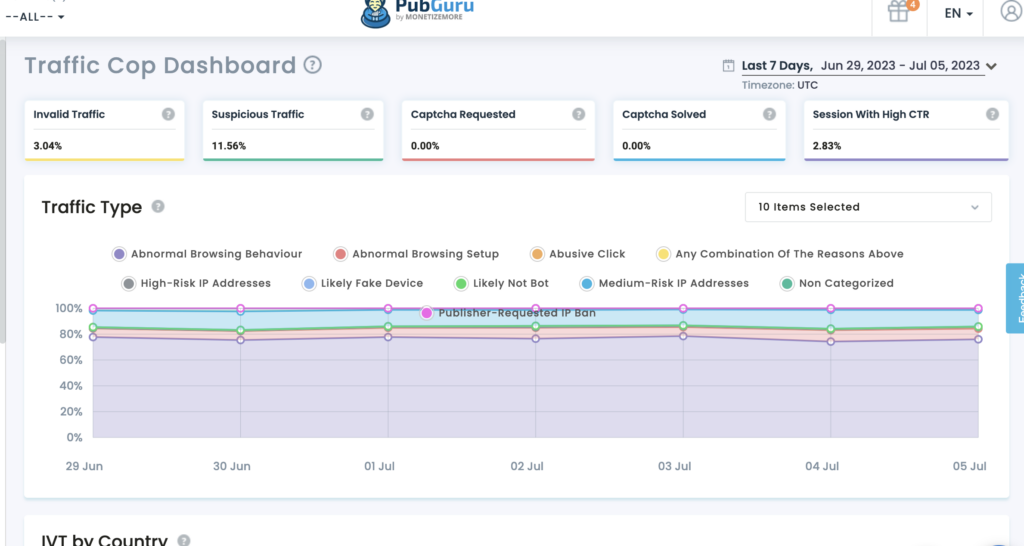

Darüber hinaus kann die regelmäßige Überwachung des Datenverkehrs auf Ihrer Website und die Analyse des Benutzerverhaltens dabei helfen, verdächtige Aktivitäten zu erkennen, die auf Scraping hinweisen könnten. Indem Sie wachsam und proaktiv bleiben, können Sie geeignete Maßnahmen ergreifen, um die Auswirkungen des Scrapings auf Ihre Inhalte und Ihr Geschäft abzumildern.

Für KI-Entwickler und Organisationen, die LLMs wie ChatGPT nutzen, ist es außerdem wichtig, ethischen Überlegungen Vorrang einzuräumen. Die Implementierung strenger Richtlinien und Richtlinien, die den Missbrauch von Scraping verhindern, kann dazu beitragen, das unbefugte Sammeln von Inhalten zu verhindern. Eine verantwortungsvolle KI-Entwicklung zielt darauf ab, ein Gleichgewicht zwischen Innovation und der Achtung der Rechte an geistigem Eigentum zu finden.

Wie kratzt ChatGPT Ihre Inhalte?

Um dieses Problem effektiv anzugehen, ist es wichtig, den von ChatGPT-Bots eingesetzten Scraping-Prozess zu verstehen. Diese Bots verwenden eine Technik, die als Web-Crawling bekannt ist. Dabei besuchen sie Webseiten und folgen Links, um Informationen zu sammeln. Diese Informationen werden dann zum Trainieren des KI-Modells verwendet. Das Scraping von Inhalten kann für Verlage und Medienunternehmen aus mehreren Gründen schädlich sein.

Erstens kann es zu Einnahmeverlusten führen, wenn gelöschte Inhalte ohne Genehmigung erneut veröffentlicht werden. Dies kann die Fähigkeit der ursprünglichen Herausgeber zur Monetarisierung ihrer Inhalte beeinträchtigen und zu finanziellen Verlusten führen. Darüber hinaus kann es den Ruf der Herausgeber schädigen, da ihre Inhalte bei der erneuten Veröffentlichung durch ChatGPT-Bots möglicherweise falsch dargestellt oder aus dem Zusammenhang gerissen werden.

Zweitens sind die Auswirkungen auf die Benutzererfahrung ein erhebliches Problem. Wenn ChatGPT-Bots eine Website mit Anfragen zum Scrapen von Inhalten überfluten, kann dies den Server überlasten und die Ladegeschwindigkeit für legitime Benutzer verlangsamen. Dies kann Besucher frustrieren und sie davon abhalten, zur Website zurückzukehren, was zu einem Rückgang des Datenverkehrs und möglicherweise zu Einbußen bei Engagement und Werbeeinnahmen führt.

Schließlich können sich gelöschte Inhalte auch auf das Suchmaschinenranking einer Website auswirken. Suchmaschinen priorisieren einzigartige und originelle Inhalte und bestrafen Websites mit duplizierten oder gelöschten Inhalten. Wenn ChatGPT-Bots Inhalte von Herausgebern auslesen und erneut veröffentlichen, kann sich dies negativ auf die Suchmaschinenoptimierungsbemühungen (SEO) der ursprünglichen Ersteller auswirken. Dies kann zu einer geringeren Sichtbarkeit und einem geringeren organischen Traffic führen, was der Online-Präsenz der Verlage schadet.

Angesichts dieser Risiken müssen Herausgeber ihre Inhalte und ihren Webverkehr proaktiv vor ChatGPT und LLM-Scraping schützen. Die Implementierung von Maßnahmen wie CAPTCHAs , IP-Blockierung und Benutzeragentenerkennung kann dabei helfen, automatisierte Bots zu identifizieren und zu blockieren, die versuchen, Inhalte abzugreifen. Darüber hinaus können die regelmäßige Überwachung des Webverkehrs und die Analyse von Mustern dabei helfen, ungewöhnliche Scraping-Aktivitäten zu erkennen und entsprechende Maßnahmen zu ergreifen.

Darüber hinaus können Verlage rechtliche Möglichkeiten zum Schutz ihrer Inhalte erkunden. Urheberrechtsgesetze und geistige Eigentumsrechte können durchgesetzt werden, um das unbefugte Scraping und die Neuveröffentlichung ihrer Werke zu verhindern. Die Suche nach Rechtsberatung und die Einleitung der erforderlichen rechtlichen Schritte gegen rechtsverletzende Unternehmen können eine starke Botschaft aussenden und künftige Scraping-Versuche abschrecken.

Auch die Zusammenarbeit und Kommunikation zwischen Verlagen, Medienunternehmen und KI-Entwicklern ist bei der Bewältigung dieses Problems von entscheidender Bedeutung. Der Aufbau von Partnerschaften und offenen Dialogen kann zur Entwicklung ethischer Praktiken und Richtlinien für die KI-Schulung führen und so sicherstellen, dass die Rechte der Inhaltsersteller respektiert werden und gleichzeitig die KI-Technologie vorangetrieben wird.

Wie können Sie ChatGPT einen Schritt voraus sein und Ihren Website-Verkehr schützen?

Wir stellen vor: Traffic Cop: Ihr Schutz gegen unbefugtes Scraping

Traffic Cop von MonetizeMore ist eine hochmoderne Lösung, die als robuster Schutzschild fungiert und Ihre digitalen Assets effektiv vor Scraping-Bots und unbefugtem Zugriff schützt.

Schützen Sie Ihre Inhalte: Mit Traffic Cop bleiben Ihre wertvollen Inhalte vor unbefugtem Scraping geschützt. Seine fortschrittlichen Algorithmen für maschinelles Lernen ermöglichen es ihm, legitimen Benutzerverkehr und bösartige Bots zu identifizieren und zu unterscheiden. Traffic Cop blockiert effektiv Scraping-Versuche und stellt sicher, dass Ihre Inhalte exklusiv für Ihre Website bleiben.

Sichern Sie Ihre Daten: Daten sind das Lebenselixier von Online-Unternehmen. Traffic Cop hilft Ihnen, die Integrität und Vertraulichkeit Ihrer Daten zu wahren. Das preisgekrönte Tool verwendet hochentwickelte Algorithmen, um Datenerfassungsaktivitäten zu identifizieren und zu blockieren und so sicherzustellen, dass Ihre Daten geschützt bleiben.

Erhaltung des Web-Verkehrs: Der Web-Verkehr ist für den Erfolg jedes Online-Unternehmens von entscheidender Bedeutung. Unbefugtes Scraping kann jedoch Ihre Ressourcen erschöpfen, die Leistung Ihrer Website beeinträchtigen und Ihre SEO-Bemühungen untergraben. Traffic Cop ist Ihr wachsamer Wächter, der bösartige Bots in Schach hält und Ihren Webverkehr schützt. Durch die Implementierung fortschrittlicher Bot-Erkennungsmechanismen und proaktiver Maßnahmen wird sichergestellt, dass echte Benutzer ununterbrochenen Zugriff auf Ihre Website haben, wodurch das Benutzererlebnis verbessert und Ihr Conversion-Potenzial maximiert wird.

Warum Traffic Cop wählen?

- Umfassender Schutz: Traffic Cop bietet einen umfassenden Schutz gegen Scraping-Versuche und schützt gleichzeitig Ihre Inhalte, Daten und Ihren Webverkehr.

- Erweiterte Bot-Erkennung: Unterscheidet genau zwischen echten Benutzern und bösartigen Bots und verhindert so unbefugten Zugriff und Scraping-Aktivitäten.

- Proaktive Sicherheitsmaßnahmen: Diese Technologie nutzt modernste Algorithmen, um Scraping-Versuche in Echtzeit zu erkennen und zu blockieren und so potenziellen Bedrohungen immer einen Schritt voraus zu sein.

- Verbesserte Benutzererfahrung: Indem Traffic Cop Ihren Webverkehr schützt und bösartige Bots fernhält, gewährleistet es echten Benutzern einen unterbrechungsfreien Zugriff, verbessert deren Benutzererfahrung und erhöht die Konversionsraten.

Ansonsten:

Nutzen Sie Ratenbegrenzung: Implementieren Sie ratenbegrenzende Maßnahmen, um die Anzahl der Anfragen pro IP-Adresse oder Benutzer zu begrenzen und zu verhindern, dass Bots Ihre Website mit Scraping-Versuchen überfordern.

Ratenbegrenzung ist eine wirksame Technik zur Verhinderung von Scraping-Angriffen, indem die Anzahl der Anfragen begrenzt wird, die ein Benutzer oder eine IP-Adresse innerhalb eines bestimmten Zeitraums stellen kann. Durch die Festlegung angemessener Grenzwerte können Sie sicherstellen, dass echte Benutzer auf Ihre Website zugreifen können, und gleichzeitig Bots davon abhalten, Ihre Inhalte zu durchsuchen. Die Implementierung einer Ratenbegrenzung kann dazu beitragen, die Leistung und Verfügbarkeit Ihrer Website aufrechtzuerhalten.

Schützen Sie Ihre RSS-Feeds: Wenn Sie RSS-Feeds zur Syndizierung bereitstellen, stellen Sie sicher, dass diese vor Scraping geschützt sind, indem Sie Authentifizierungsmechanismen hinzufügen oder API-Schlüssel implementieren.

RSS-Feeds können eine wertvolle Quelle für die Syndizierung von Inhalten sein, können aber auch zum Ziel von Scraping-Bots werden. Um Ihre RSS-Feeds zu schützen, ist es wichtig, Authentifizierungsmechanismen oder API-Schlüssel zu implementieren. Durch die Anforderung einer Authentifizierung können Sie sicherstellen, dass nur autorisierte Benutzer oder Anwendungen auf Ihre RSS-Feeds zugreifen und diese nutzen können. Darüber hinaus kann Ihnen die Implementierung von API-Schlüsseln dabei helfen, den Zugriff auf Ihre Feeds zu verfolgen und zu kontrollieren und so unbefugte Scraping-Versuche zu verhindern.

Durch die Implementierung dieser Strategien können Sie das Risiko von ChatGPT- und LLM-Scraping erheblich reduzieren und so Ihre Inhalte, Daten und Ihren Webverkehr schützen.

Tun Sie dies, um mit der KI-Apokalypse Schritt zu halten.

Während ChatGPT und andere LLMs sich weiterentwickeln, müssen Herausgeber bestimmte Schlüsselaspekte berücksichtigen, um ihre Inhalte und ihren Webverkehr zu schützen:

- Bleiben Sie auf dem Laufenden: Halten Sie sich über die neuesten Fortschritte in den Bereichen KI und Technologien zur Verarbeitung natürlicher Sprache auf dem Laufenden. Dies wird Ihnen helfen, die potenziellen Risiken und Chancen dieser Tools zu verstehen.

- Überprüfen Sie Ihre Nutzungsbedingungen: Stellen Sie sicher, dass Ihre Nutzungsbedingungen Scraping-Aktivitäten ausdrücklich verbieten, und legen Sie die Konsequenzen bei einem Verstoß gegen diese Bedingungen fest.

- Erkunden Sie rechtliche Möglichkeiten: Wenn Sie den Verdacht haben, dass durch Scraping Ihre geistigen Eigentumsrechte verletzt werden, wenden Sie sich an Rechtsexperten, um die verfügbaren Rechtsbehelfe zu prüfen.

- Engagieren Sie sich mit der Branche: Arbeiten Sie mit Branchenverbänden und Organisationen zusammen, um gemeinsam die Herausforderungen durch Scraping anzugehen und sich für bessere Schutzmaßnahmen einzusetzen.

Durch die proaktive Berücksichtigung dieser Faktoren können Herausgeber ihre Inhalte, Daten und ihren Webverkehr im Zeitalter von ChatGPT und neuen LLM-Technologien besser schützen.

Zusätzlich zu diesen wichtigen Überlegungen sollten sich Verlage auch der potenziellen Auswirkungen von ChatGPT und LLMs auf die Einbindung ihres Publikums bewusst sein. Mit der Zunahme von KI-generierten Inhalten besteht die Möglichkeit, dass Leser hinsichtlich der Authentizität und Zuverlässigkeit der von ihnen konsumierten Informationen skeptischer werden. Verlage sollten Maßnahmen ergreifen, um Vertrauen bei ihrem Publikum aufzubauen, indem sie KI-generierte Inhalte klar kennzeichnen und Transparenz über die Informationsquelle schaffen.

Ein weiterer wichtiger Gesichtspunkt sind die möglichen ethischen Auswirkungen von KI-generierten Inhalten. Da LLMs immer fortschrittlicher werden, muss sichergestellt werden, dass die generierten Inhalte keine Vorurteile oder Fehlinformationen aufrechterhalten. Verlage sollten Richtlinien und Überprüfungsprozesse festlegen, um sicherzustellen, dass KI-generierte Inhalte ihren redaktionellen Standards und Werten entsprechen.

Beachten Sie außerdem die sich entwickelnde Rechtslandschaft rund um KI-generierte Inhalte. Mit der zunehmenden Verbreitung dieser Technologien können neue Vorschriften und rechtliche Rahmenbedingungen zur Regelung ihrer Nutzung eingeführt werden. Sich über diese Entwicklungen auf dem Laufenden zu halten und sich mit Rechtsexperten zu beraten, kann Verlagen dabei helfen, die rechtlichen Komplexitäten von KI-generierten Inhalten zu bewältigen.

Abschluss

Der Schutz Ihrer Inhalte, Daten und Ihres Webverkehrs vor ChatGPT-Scraping ist für die Aufrechterhaltung der Integrität Ihres Unternehmens von entscheidender Bedeutung. Es gefährdet ihren Umsatz und ihr Benutzererlebnis und beeinträchtigt ihre Online-Sichtbarkeit und ihren Ruf. Durch das Verständnis des Scraping-Prozesses, die Implementierung von Schutzmaßnahmen, die Prüfung rechtlicher Optionen und die Förderung der Zusammenarbeit können Verlage ihre Inhalte schützen und die mit KI-gesteuertem Scraping verbundenen Risiken mindern.

Traffic Cop von MonetizeMore bietet eine umfassende Lösung, um Ihre Inhalte, Daten und Ihren Webverkehr zu schützen. Durch die Nutzung fortschrittlicher Bot-Erkennung und proaktiver Sicherheitsmaßnahmen ermöglicht Traffic Cop Ihnen, sich auf Ihr Kerngeschäft zu konzentrieren und gleichzeitig Ihre digitalen Assets effektiv zu schützen.

Nutzen Sie Traffic Cop noch heute und genießen Sie die Gewissheit, dass Ihre Online-Präsenz vor unbefugtem Scraping geschützt ist.

Lernen Sie Aleesha Jacob kennen, eine erfahrene B2B-Content- und SEO-Managerin mit über sieben Jahren Erfahrung in der Erstellung datengesteuerter Inhalte, die die Conversions für SAAS-Unternehmen ankurbeln. Durch die Zusammenarbeit mit Ad-Tech-Unternehmen und Kunden wie BMW und Heineken bringt Aleesha eine Fülle von Fachwissen mit. Mit ihren unübertroffenen Fähigkeiten bei der Erstellung überzeugender Inhalte hilft sie Unternehmen jeder Größe, mehr Leads zu generieren, den Umsatz zu steigern und ihre Online-Präsenz auszubauen.