Sind Ihre Daten wirklich zuverlässig? 8 Möglichkeiten zur Bestimmung der Datenqualität

Veröffentlicht: 2022-11-30Die Datenqualität misst, wie gut ein Datensatz dem strategischen Entscheidungsprozess eines Unternehmens dient, basierend auf Datengenauigkeit, Vollständigkeit und Konsistenz.

Wie Harvard-Wirtschaftsprofessorin Melissa Perri bei Amplify feststellte, ist die Gewinnung von Daten durch Benutzerforschung als ein wesentliches Werkzeug für Unternehmen anerkannt. Produktteams gewinnen, wenn sie riesige Datenmengen aufnehmen und herausfinden, wie sie sich differenzieren können. Perri sagte: „Was wir uns ansehen sollten, sind Tonnen von Kunden- und Benutzerforschung, technologische Auswirkungen, Benutzerdaten, Marktforschung und -daten, Finanzdaten und Auswirkungen auf den Verkauf.“

Echtzeitdaten und Datenexpertise sind erforderlich, um die richtige Produktstrategie festzulegen, sie in Gang zu setzen und schnelles Wachstum zu bewältigen. Perri fuhr fort: „Viele Organisationen und Menschen werden sich einfach auf Vermutungen und das, was ihrer Meinung nach das nächste sein sollte, stürzen, anstatt sich die Zeit zu nehmen, all diese Zahlen tatsächlich zu knacken und herauszufinden, was als nächstes kommt.“

Daten sind eindeutig untrennbar mit einem gut konzipierten Produkt und einem profitablen Geschäft verbunden, daher müssen Sie sicherstellen, dass Ihre Datenqualität der Aufgabe gewachsen ist.

Die zentralen Thesen

- Die Datenqualität sollte Genauigkeit, Vollständigkeit und Konsistenz widerspiegeln und in Ihr Data-Governance-Framework passen.

- Die Verwendung der richtigen Datentools liefert detaillierte Einblicke in das Benutzerverhalten.

- Die Anwendung eines funktionsübergreifenden Ansatzes und die Verwendung von Daten so zeitnah wie möglich tragen wesentlich dazu bei, dass Ihre Entscheidungsfindung auf zuverlässigen Informationen basiert.

- Identifizieren Sie, welche Produktmetriken bei der Analyse von Daten am hilfreichsten sind, um die Produktstrategie mit dem Geschäftsumsatz zu verbinden.

- Daten müssen nützlich sein, daher ist ihre Fähigkeit, von einer Vielzahl von Teams in Ihrem Unternehmen leicht verstanden zu werden, von größter Bedeutung.

Was ist Datenqualität?

Die Datenqualität misst die Leistung Ihrer Daten basierend auf verschiedenen Faktoren wie Genauigkeit, Vollständigkeit und Konsistenz . Ihr Maß für die Datenqualität sollte jedoch spezifisch für Ihre Produkt- und Geschäftsziele sein.

Stellen Sie sich zu Beginn diese Fragen:

- Passen Ihre Daten in ein wohldefiniertes und gepflegtes System?

- Ermöglicht es Ihnen, wichtige Ziele zuverlässig und vorausschauend zu verfolgen?

- Wissen die Teams in Ihrer Organisation, wie man Daten verwendet, um Hypothesen über Ihr Produkt und Ihre Benutzer zu testen?

- Sind diese Teams zuversichtlich, dass die Daten ihre Hypothesen genau validieren oder widerlegen, oder bezweifeln sie ihre Relevanz?

Ihre Datenqualität sollte in Ihr Data-Governance-Framework passen und Sie voranbringen, nicht von anderen Aktivitäten oder Geschäftsfunktionen ablenken.

- „Garbage in, Garbage out“ gilt nach wie vor für die Welt der Daten.

- Eine ausgeklügelte Datennutzung kann zu einer schnelleren Markteinführung und einem schnelleren Umsatzwachstum führen.

- Weniger absichtliches Datenmanagement kann irreführend sein.

- Beispielsweise können duplizierte Daten Metriken künstlich aufblähen und zu einem suboptimalen Ressourcenmanagement führen.

- Inkonsistenzen bei der Benennung von Ereignissen und Eigenschaften (Ihrer Datentaxonomie) können die Identifizierung gemeinsamer Benutzerabläufe erschweren und somit die Fähigkeit Ihres Produktteams beeinträchtigen, von Benutzern zu lernen. Lernen wie man

- Effektive Data Governance bildet die Grundlage für saubere Daten und robuste Analysen, die produktgesteuertes Wachstum (PLG) vorantreiben.

Es ist nicht ungewöhnlich, dass Daten unterschiedlich interpretiert werden. Aber wenn Teams die Vertrauenswürdigkeit von Analysen ständig in Frage stellen, bedeutet dies wahrscheinlich, dass Sie über Daten von geringer Qualität, eine inkonsistente Taxonomie oder die falschen Datentools zu ihrer Verwaltung verfügen.

Erfahren Sie mehr über das Entwerfen Ihrer Datentaxonomie in unserem Kurs „Grundlagen der Datentaxonomie“ . Beginnen Sie dann mit der Instrumentierung Ihrer Daten mithilfe unseres Leitfadens zur Verhaltensdaten- und Ereignisverfolgung .

8 Möglichkeiten, die Qualität eines bestimmten Datensatzes zu bewerten

Es ist wichtig, die Vorstellung Ihres Unternehmens von Datenqualität und den richtigen Tools herauszufinden, aber möglicherweise stecken Sie bereits in suboptimalen Arbeitsabläufen mit unzuverlässigen Daten fest. Wenn Sie Ihren organisatorischen Ansatz überdenken und versuchen, die Qualität eines bestimmten Datensatzes zu bewerten, verwenden Sie die folgenden acht Methoden, um Ihre Datenqualität zu bestimmen:

- Finden Sie heraus, wie sich die Datenqualität auf die Ziele Ihres Unternehmens auswirkt, indem Sie auf Genauigkeit, Vollständigkeit und Konsistenz sowie auf Sicherheit und Compliance mit Data Governance achten.

- Streben Sie nach einer einzigen Quelle der Wahrheit, um Ressourcen effektiv zu priorisieren und die Kosten für rückwirkende Datenbereinigungen zu vermeiden.

- Verwenden Sie eine seriöse Analyseplattform mit einem gut etablierten zugrunde liegenden Schema und schlüsselfertigen Integrationen. Dadurch wird sichergestellt, dass Sie die volle Leistungsfähigkeit verschiedener Kanäle mit einer ganzheitlichen und transparenten Perspektive in Echtzeit nutzen können.

- Verwenden Sie funktionsübergreifende Ansätze wie Patreon, um sicherzustellen, dass die Daten für alle Beteiligten relevant und überzeugend sind. Verschiedene Rollen oder Teams bewerten die Datenqualität in Bezug auf ihre eigenen Funktionen.

- Sie können die Relevanz Ihrer Daten einschätzen, indem Sie untersuchen, wie häufig Ihre Teams darauf verweisen. Wenn es nützlich ist, werden sie es verwenden.

- Sie können die Datenqualität auch anhand der Kosteneffizienz und Betriebszeit Ihrer Datensysteme beurteilen. Auch die Übersichtlichkeit und Konsistenz Ihres Datenschemas spielen eine Rolle.

- Konvertibilität und Visualisierung von Daten sind ebenfalls wichtige praktische Überlegungen, um sicherzustellen, dass Ihre Teams die Informationen klar verstehen können.

- Stellen Sie in einem sich schnell verändernden Geschäftsumfeld sicher, dass Ihre Systeme Daten so zeitnah wie möglich verarbeiten können. Dies ermöglicht Produktagilität und letztendlich das Überleben des Unternehmens.

Indem Sie sicherstellen, dass Ihre Metriken genau und angemessen kontextualisiert sind, schaffen Sie die Voraussetzungen für durchgehend zuverlässige Informationen.

Allgemeine Datenqualitätsmetriken

Auf dem Weg zur Integration von Echtzeitdaten in eine gut ausgestattete Analyseplattform und zur Verknüpfung von Produktstrategien mit Geschäftseinnahmen benötigen Sie Datenqualitätskennzahlen, auf die Sie sich verlassen können:

- Die Häufigkeit , mit der sich ein Team mit Produktmetriken und -daten beschäftigt, könnte seine Qualität widerspiegeln – wenn die Daten nützlich sind, kommen sie immer wieder zurück.

- Die Betriebszeit/Ausfallzeit des Systems spiegelt auch wider, ob Sie die Daten praktisch nutzen können.

- Die Kosten für die Wartung dieses Systems und sein ROI sind ebenfalls relevante Kennzahlen.

- Sie können die Datenqualität teamspezifisch bewerten .

- Zum Beispiel könnten Marketing und Vertrieb die Absprungraten von E-Mails untersuchen, weil sie ihre Arbeit nicht erledigen können, wenn sie die Menschen nicht erreichen können.

- Datenfehler oder Auslassungen (leere Werte) spiegeln auch die Datenqualität wider.

- Die Konvertierbarkeit von Daten – wie einfach es ist, Daten in verschiedene Formate oder Verwendungszwecke zu verschieben – ist eine relevante Metrik, ebenso wie die Fähigkeit, sie schnell zu visualisieren .

- Ein etabliertes Datenschema ist eine Qualitätsmetrik, da Verwirrung und Probleme mit der Datenqualität entstehen können, wenn sich ein zugrunde liegendes Schema zu häufig ändert.

Best Practices für die Datenqualität

Was sind einige Best Practices, wenn wir uns von diesen Metriken leiten lassen?

Theoretisch müssen sich Teams einig sein und effektiv zusammenarbeiten. In der Praxis sollten sie ihr ereignisbasiertes Schema etablieren und verstehen und die Ressourcen bereitstellen, die für eine klare Datenabfrage in Echtzeit erforderlich sind. Denken Sie daran: Daten müssen nützlich sein.

- Produktmanager, Ingenieure aus verschiedenen Entwicklungsteams, Designer und andere relevante Interessengruppen sollten alle frühzeitig in eine Datenmanagement- und Governance-Strategie eingebunden werden.

- Datenmanagementstrategien sollten die für die KPIs des Produktmanagements relevanten Ereignisse definieren und die Nachverfolgung dieser Ereignisse berücksichtigen. Metriken können sich im Laufe der Zeit ändern oder erweitern, aber sie sollten immer die organisatorische Relevanz aufweisen.

- Das ereignisbasierte Schema von Amplitude behandelt Daten als „Ereignisse“ oder jede auftretende Benutzeraktion oder -interaktion. In der Zwischenzeit sind „Eigenschaften“ Details zu diesen Benutzern und Ereignissen.

- Sie sollten Ereignisse nicht automatisch verfolgen. Die enorme Zeit, die erforderlich ist, um eine riesige Menge nicht vertrauenswürdiger Daten zu bereinigen, macht die automatische Verfolgung ineffizient und unzuverlässig.

- Cloud-Speicher ermöglichen Datenabfragen in Echtzeit, und Data Warehouses werden ebenfalls häufig verwendet. Beide können und sollten synchronisiert werden.

Beste Datenqualitätstools

Sie benötigen die richtigen Datentools, um Annahmen zu validieren und eine Produktstrategie zu entwickeln. Echtzeit-Datenverwaltungssoftware gewährleistet vollständige, genaue, sichere, qualitativ hochwertige und vertrauenswürdige Daten.

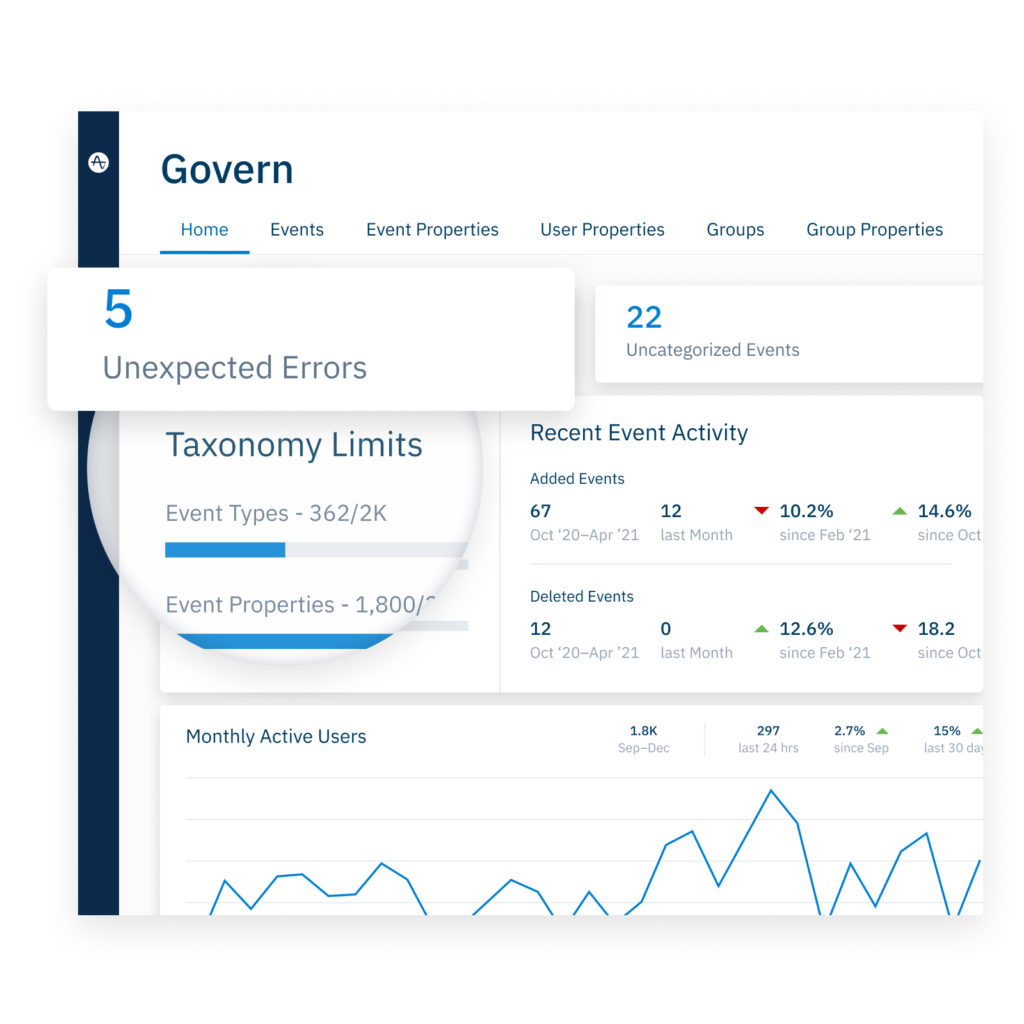

Amplitude

Um Ihnen das Streamen von Daten in Amplitude zu erleichtern, können unsere Pipelines für die Datenaufnahme Mobil-, Web-, Backend- und Kampagnendaten verbinden – der erste Schritt zu einer ganzheitlichen Sicht auf das Kundenerlebnis. Schlüsselfertige Integrationen in wichtige Cloud-Apps und Data Warehouses (einschließlich Snowflake) zusammen mit APIs und SDKs beschleunigen den Einrichtungsprozess. Schließlich können Sie mit unserer Data Governance Bedingungen festlegen, damit Sie von Beginn des Prozesses an nur vertrauenswürdige Daten sammeln.

Sie sollten bestimmte Benutzerverhalten untersuchen, um zu sehen, wie sie die Kundenbedürfnisse beleuchten. Denken Sie daran, dass Datenqualität Produktqualität bedeutet. Die Identitätsauflösung von Amplitude vereinheitlicht Daten, die über mehrere Berührungspunkte hinweg gesammelt wurden – ob das nun Medienaufrufe, Anmeldungen, Einkäufe oder Lesebestätigungen sind – im Gegensatz zu Analysetools mit einem begrenzteren Fokus.

Darüber hinaus können eine intuitive Benutzeroberfläche und leicht verständliche Visualisierungen die Daten auch für nicht-technische Teams zugänglich machen.

Andere Datenqualitätstools

Weitere Datentools sind:

- Beschleunigungsdaten

- Atacama Eins

- Großes Auge

- Informatik

- Monte Carlo

- SAP-Datendienste

Erfahren Sie mehr über diese und andere Datenqualitätstools auf einer Softwarebewertungsseite wie Gartner.

Vertrauen Sie Ihrem Fundament, bevor Sie bauen

Datenqualität hilft Ihrem Unternehmen, das zu tun, was es tun soll, und verschafft oft erhebliche Wettbewerbsvorteile. Eine hohe Datenqualität wird durch eine zugängliche Analyseplattform aufrechterhalten und realisiert.

Vertrauenswürdige Daten beseitigen das Rätselraten bei wichtigen strategischen Entscheidungen, die Sie treffen müssen. Eine benutzerfreundliche Self-Service-Plattform mit den richtigen Tools kann Ihre Produkt- und Datenteams bei der Sammlung robuster, zuverlässiger Analysen unterstützen.

Optimieren Sie Ihre Datenstrategie und führen Sie Ihr Team zu vertrauenswürdigen Analysen mit dem Verhaltensdaten- und Ereignis-Tracking-Leitfaden von Amplitude.