Verständnis der NLP-Algorithmen von Google für eine bessere Inhalts-SEO

Veröffentlicht: 2022-06-04

Natural Language Processing, oder NLP, ist einer der komplexesten und innovativsten Fortschritte in der künstlichen Intelligenz (KI) und den Suchmaschinenalgorithmen. Und es überrascht nicht, dass Google zu einem führenden Unternehmen im NLP-Bereich geworden ist. Mit der Hinzufügung des SMITH-Algorithmus im Jahr 2021 und seines früheren natürlichen Sprachalgorithmus BERT hat Google eine KI entwickelt, die die menschliche Sprache kompetent versteht. Und diese Technologie kann bei der Erstellung von KI-generierten Inhalten verwendet werden.

Mit außergewöhnlicher Genauigkeit haben die NLP-Algorithmen von Google das KI-Spiel verändert. Was bedeutet das also für SEO? Dieser Artikel wird in alle Details der NLP-Technologien von Google eintauchen und wie Sie sie nutzen können, um in den Suchmaschinenergebnissen besser zu ranken.

Was ist Natural Language Processing?

Die Verarbeitung natürlicher Sprache (NLP) ist ein Gebiet der Informatik und der künstlichen Intelligenz, bei dem untersucht wird, wie Computer die menschliche Sprache verstehen können. Im Gegensatz zu früheren Formen der KI verwendet NLP Deep Learning.

NLP gilt als wichtiger Bestandteil der künstlichen Intelligenz, da es Computern ermöglicht, auf eine Weise mit Menschen zu interagieren, die sich natürlich anfühlt.

Während NLP so klingen mag, als ob sein Zweck darin bestehe, die Suchergebnisse von Google zu verbessern und Autoren aus dem Geschäft zu drängen, wird diese Technologie auf vielfältige Weise über SEO hinaus eingesetzt.

Hier sind die häufigsten:

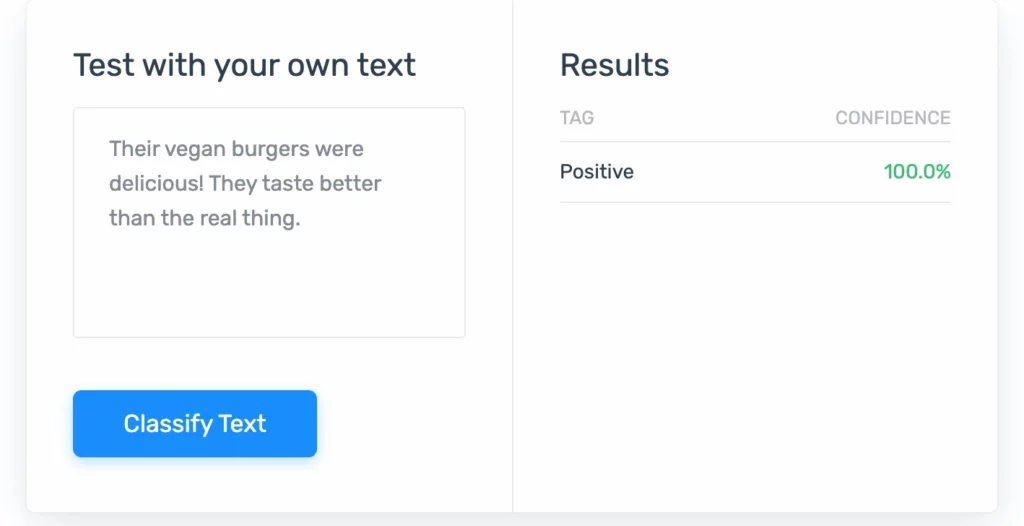

1. Stimmungsanalyse: NLP, das die emotionalen Ebenen von Menschen misst, um Dinge wie die Kundenzufriedenheit zu bestimmen.

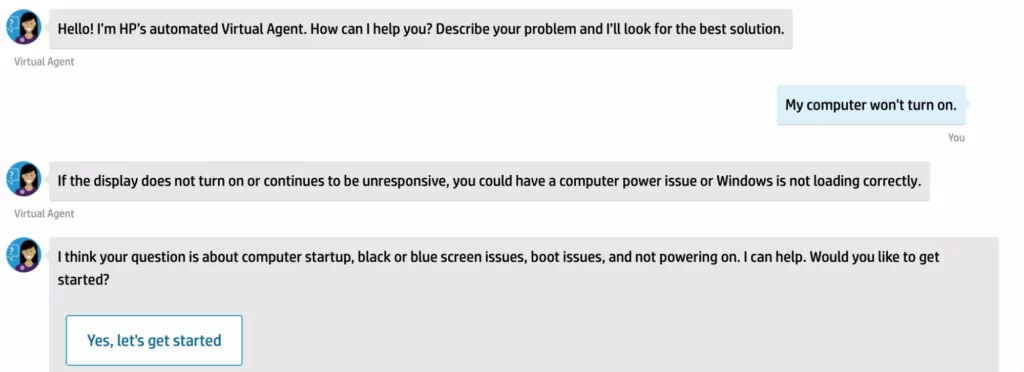

2. Chatbots: Dies sind die Chat-Bildschirme, die auf Hilfeseiten oder allgemeinen Websites erscheinen. Sie haben ein Händchen dafür, die Arbeitsbelastung der Kundendienstzentren zu reduzieren.

4. Spracherkennung: Dieses NLP nimmt Audio und übersetzt es in Befehle und mehr.

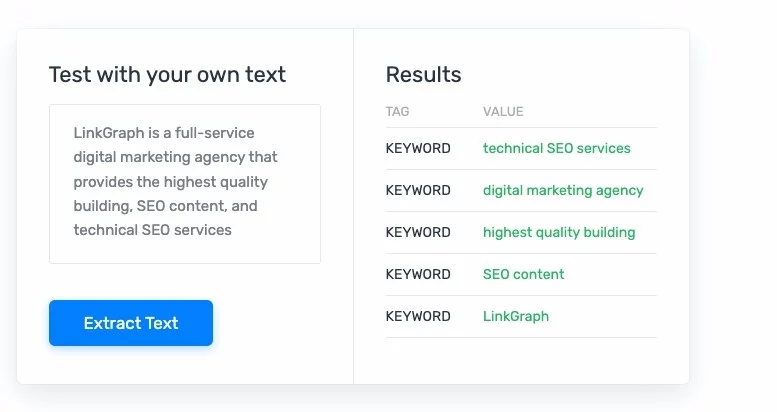

Textklassifizierung, -extraktion und -zusammenfassung: Diese Formen von NLP können Text analysieren und ihn dann neu formatieren, damit er für Menschen einfacher zu verwenden, zu analysieren und zu verstehen ist. Die Textextraktion kann sehr hilfreich sein, wenn es um Aufgaben wie die medizinische Kodierung und das Auffinden von Fehlern bei der Abrechnung geht.

Was ist Deep Learning?

Deep Learning ist eine Kategorie des maschinellen Lernens, die den neuronalen Netzen im menschlichen Gehirn nachempfunden ist. Diese Form des maschinellen Lernens wird oft als ausgefeilter angesehen als typische KI-Lernmodelle.

Da sie das menschliche Gehirn widerspiegeln, können sie auch menschliches Verhalten widerspiegeln – und viel lernen! Häufig verwenden Deep-Learning-Algorithmen ein zweiteiliges System. Ein System trifft Vorhersagen, während das andere die Ergebnisse verfeinert.

Deep Learning wird seit einiger Zeit in Haushaltsgeräten, öffentlichen Umgebungen und am Arbeitsplatz eingesetzt. Zu den häufigsten Anwendungen gehören:

- Selbstfahrende Autos

- Sprachfernbedienungen

- Erkennung von Kreditkartenbetrug

- Medizinische Geräte

- Satellitengestützte Landesverteidigung

Wie wirkt sich NLP auf SEO aus?

Nur wenige Aktualisierungen des PageRank von Google haben die SEO-Standards wie Natural Language Processing-Bots gestört. Mit der Einführung von SMITH von Google sahen wir, wie SEO-Spezialisten sich bemühten, zu verstehen, wie der Algorithmus funktioniert und wie man Inhalte produziert, die den Standards des Algorithmus entsprechen. Wie bei den meisten Algorithmus-Updates zeigt sich jedoch oft mit der Zeit, wie Sie Inhaltsstandards erfüllen und übertreffen können, um sicherzustellen, dass Ihre Inhalte die besten Chancen haben, in die SERPs zu gelangen.

Im Wesentlichen hilft NLP Google dabei, Suchenden bessere Suchergebnisse basierend auf ihrer Absicht und einem klareren Verständnis des Inhalts einer Website bereitzustellen. Das bedeutet, dass nur die Seiten mit den besten Inhalten ihren Platz in den SERPs einnehmen konnten. Darüber hinaus werden verschiedene Inhalte, die nicht der Absicht eines Suchenden entsprechen, in einem tieferen SERP vergraben oder gar nicht angezeigt.

Was ist Google BERT?

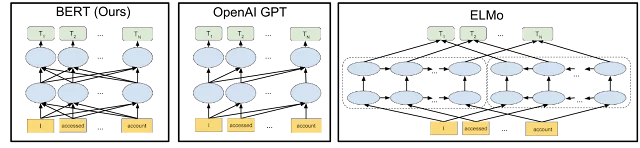

Der BERT-Algorithmus (Bidirectional Encoder Representations from Transformers) wurde 2019 eingeführt und hat als größte Änderung seit PageRank Wellen geschlagen. Dieser Algorithmus ist ein NLP, das Text versteht, um bessere Suchergebnisse zu liefern.

Genauer gesagt ist BERT ein neuronales Netzwerk, das den Kontext von Wörtern in einem Satz besser verstehen soll. Der Algorithmus ist in der Lage, die Beziehungen zwischen Wörtern in einem Satz zu lernen, indem er eine Technik verwendet, die als Vortraining bezeichnet wird.

Das Ziel des BERT-Algorithmus ist es, die Genauigkeit von Verarbeitungsaufgaben natürlicher Sprache zu verbessern, wie z. B. maschinelle Übersetzung und Beantwortung von Fragen.

Wie funktioniert der Google BERT-Algorithmus?

Der BERT-Algorithmus kann sein Ziel erreichen, indem er eine Technik namens Transfer Learning verwendet. Transfer Learning ist eine Technik, die verwendet wird, um die Genauigkeit eines neuronalen Netzwerks zu verbessern, indem ein vorab trainiertes Netzwerk verwendet wird, das bereits mit einem großen Datensatz trainiert wurde.

Im Gegensatz zu vielen Updates von Google ist das Innenleben von BERT Open Source. Der BERT-Algorithmus basiert auf einem Papier, das 2018 von Google veröffentlicht wurde. Diese Open-Source-Erklärung beinhaltet, dass BERT ein bidirektionales Kontextmodell verwendet, um die Bedeutung einzelner Wörter oder Sätze besser zu verstehen. Das Ergebnis ist eine fein abgestimmte Inhaltsklassifikation.

Zum Beispiel:

Wenn Sie nach einer Stange für die Happy Hour oder einer Stange für Ihre Bankdrückgeräte suchen, zeigt Google Ihnen die richtige Art von Stange, je nachdem, wie das Wort im Kontext einer Seite verwendet wird.

Was macht BERT noch anders?

BERT verwendete Cloud- Tensor-Verarbeitungseinheiten (TPUs) , die die Fähigkeit des NLP beschleunigten, aus vorhandenen Textbeispielen als Vortrainingssystem zu lernen. Vortraining ist eine Technik, die verwendet wird, um ein neuronales Netzwerk mit einem großen Datensatz zu trainieren, bevor es zur Verarbeitung von Daten verwendet wird. Das vortrainierte Netzwerk wird dann verwendet, um Daten zu verarbeiten, die den Daten ähnlich sind, die zum Trainieren des Netzwerks verwendet wurden. Durch die Verwendung von Cloud-TPUs konnte BERT Daten schnell verarbeiten – superschnell. Und auch die Google Cloud konnte getestet werden.

Nach Millionen von Trainingssitzungen ist der BERT-Algorithmus in der Lage, eine höhere Genauigkeit als frühere Algorithmen zur Verarbeitung natürlicher Sprache zu erreichen, da er in der Lage ist, den Kontext von Wörtern in einem Satz besser zu verstehen.

Wie viele Textbeispiele brauchte BERT? BERT verwendete Millionen, sogar Milliarden von Beispielen, um die natürliche Sprache (nicht nur Englisch) vollständig zu erfassen.

Wie hat sich das Bert-Update von Google auf Websites ausgewirkt?

Die Auswirkungen des BERT-Updates auf Websites waren zweifach. Erstens verbesserte das Update die Genauigkeit der Google-Suchergebnisse. Dies bedeutete, dass Websites, die in den Suchergebnissen von Google höher eingestuft wurden, eine höhere Klickrate (CTR) aufwiesen.

Zweitens hat das BERT-Update die Bedeutung von Website-Inhalten erhöht. Dies bedeutet, dass Websites mit qualitativ hochwertigen und relevanten Inhalten in den Suchergebnissen von Google eher einen höheren Rang einnehmen.

Was sind die Einschränkungen von Google Bert?

BERT ist ein leistungsstarkes Tool, aber es gibt einige Einschränkungen in seinen Fähigkeiten. Während man sich leicht davon hinreißen lässt, wie ordentlich dieses NLP-Modell ist, ist es wichtig zu bedenken, dass das BERT-Modell nicht für alle menschlichen kognitiven Prozesse geeignet ist. Und dies können Einschränkungen in den Fähigkeiten zum Verstehen von Inhalten sein.

BERT ist ein Nur-Text-Algorithmus

Erstens ist BERT nur für Verarbeitungsaufgaben natürlicher Sprache wirksam, die Text beinhalten. Es kann nicht für Aufgaben verwendet werden, die Bilder oder andere Datenformen beinhalten. Denken Sie jedoch daran, dass BERT Ihren Alt-Text lesen kann , was Ihnen helfen kann, in der Google-Bildsuche zu erscheinen.

BERT versteht das „ganze Bild“ nicht

Zweitens ist BERT nicht effektiv für Aufgaben, die ein extrem hohes Maß an Verständnis erfordern. Im Wesentlichen ist BERT ein Profi im Umgang mit Wörtern innerhalb von Sätzen, aber nicht in der Lage, ganze Artikel zu verstehen.

Zum Beispiel kann BERT verstehen, dass die „Fledermaus“ im folgenden Satz eher auf das Säugetier als auf einen hölzernen Baseballschläger bezogen ist: Die Fledermaus hat die Mücke gefressen. Aber es ist nicht effektiv für Aufgaben, die das Verständnis komplexer Sätze oder Absätze erfordern.

Was ist der Google SMITH-Algorithmus?

Der Google SMITH-Algorithmus (oder Siamese Multi-depth Transformer-based Hierarchical) ist ein Ranking-Algorithmus, der von Google-Ingenieuren entwickelt wurde. Der Algorithmus betrachtet die natürliche Sprache, lernt die Bedeutungsmuster in Bezug auf Phrasen in Bezug auf ihre Entfernung voneinander und erstellt eine Informationshierarchie, mit der Seiten genauer indexiert werden können.

Dadurch kann SMITH die Inhaltsklassifizierung effizienter durchführen.

Ein weiteres interessantes Feature von SMITH ist, dass es als Textprädiktor fungieren kann. Es gibt andere Unternehmen, die mit NLP große Wellen geschlagen haben (denken Sie an die berüchtigte GPT-3- Beta von Open AI im letzten Jahr). Einige dieser Technologien könnten anderen dabei helfen , ihre eigenen Suchmaschinen zu bauen .

Wie hat sich das SMITH-Update von Google auf Websites ausgewirkt?

Das SMITH-Update von Google hatte erhebliche Auswirkungen auf Websites. Das Update wurde entwickelt, um die Genauigkeit der Suchergebnisse zu verbessern, indem es Websites bestraft, die manipulative Techniken anwenden, um ihren Rang zu beeinflussen. SMITH wurde entwickelt, um auf eine breite Palette manipulativer Techniken abzuzielen, darunter Spam-Links, Black-Hat-SEO und künstliche Intelligenz, und hat die Messlatte für qualitativ hochwertige Inhalte und organischen Linkaufbau höher gelegt.

Einige der häufigsten manipulativen Techniken, auf die SMITH abzielte, waren enthalten

- Keyword-Stuffing

- Linkkauf

- übermäßige Verwendung von Ankertext.

Websites, bei denen festgestellt wurde, dass sie diese Techniken verwenden, wurden von Google abgestraft, was zu einer Verschlechterung ihres Suchrankings führte.

Was ist der Unterschied zwischen dem SMITH-Update von Google und dem Google BERT?

Sowohl das BERT-Modell als auch das SMITH-Modell bieten den Webcrawlern von Google ein besseres Sprachverständnis und eine bessere Seitenindizierung. Wir wissen, dass Google bereits lange Inhalte mag, aber wenn SMITH live ist, versteht Google längere Inhalte noch besser. SMITH wird die Bereiche Nachrichtenempfehlungen, verwandte Artikelempfehlungen und Dokumenten-Clustering verbessern.

So passen Sie Ihre SEO-Strategie für Google NLP-Algorithmen an

Während Google behauptet, dass Sie nicht für BERT oder SMITH optimieren können, kann das Verständnis, wie man für NLP optimiert, einen Einfluss auf die Leistung Ihrer Website in den SERPs haben. Wenn Sie jedoch wissen, dass sich BERT auf die Bereitstellung der Benutzerabsicht konzentriert, bedeutet dies, dass Sie die Absicht jeder Suchanfrage verstehen sollten, für die Sie optimieren möchten.

Google ist oft etwas zurückhaltend, wenn es darum geht, wann sie ihre Algorithmen einführen, und sie sind weiterhin verschwiegen, wann SMITH vollständig eingeführt wird. Aber es ist immer am besten anzunehmen, dass sie begonnen haben, für die Änderung zu optimieren.

SMITH ist wahrscheinlich nur eine von vielen Iterationen in Googles langfristigem Ziel , seine Dominanz in NLP und maschineller Lerntechnologie aufrechtzuerhalten. Da Google sein Verständnis vollständiger Dokumente verbessert, wird eine gute Informationsarchitektur noch wichtiger .

Wie können Sie Ihre Inhalte für die NLP-Algorithmen von Google optimieren?

- Stellen Sie sicher, dass Ihre Inhalte gut formatiert und leicht lesbar sind. Pflegen Sie Best Practices für Überschriften und andere Best Practices für die Lesbarkeit. Diese beinhalten:

- Halten Sie Ihre Sätze unter 20 Wörtern

- Verwenden Sie Aufzählungslisten für aufgelistete Elemente, die größer als 2 sind

- Verwenden Sie die richtige Überschriftenhierarchie

- Vermeiden Sie es, den Lesern einen undurchdringlichen Textblock zu präsentieren

- Verwenden Sie eine klare, prägnante und leicht verständliche Sprache. Machen Sie Ihre Satzstrukturen nicht zu kompliziert. Indem Sie Ihre Satzlänge begrenzen, werden Sie wahrscheinlich auch Ihre Gedanken rationalisieren.

- Vermeiden Sie komplexe oder schwierige Wörter, die die Algorithmen von Google verwirren könnten. Lassen Sie den Thesaurus hinter sich und halten Sie Ihre Sätze geradlinig. Denken Sie daran, dass der kürzeste Weg oft der beste ist.

- Verwenden Sie Schlüsselwörter und Fokusbegriffe, die für Ihr Thema relevant sind . Semantisch verwandte Focus-Begriffe können Google Natural Language Processors helfen, die Gesamtheit Ihrer Seite besser zu verstehen.

- Stellen Sie sicher, dass Ihre Inhalte frisch und aktuell sind. Denken Sie daran, dass die Motivation dieser NLP-Algorithmen darin besteht, die Suchergebnisse zu verbessern und gleichzeitig Spam und veraltete Inhalte auszusortieren.

- Schreiben Sie interessante und ansprechende Inhalte, die die Leute lesen wollen. Sie können nichts falsch machen, wenn Sie Suchenden die besten Inhalte für ihre Bedürfnisse bieten . Berücksichtigen Sie die Suchabsicht und thematische Tiefe.

- Ihre Kundenbewertungen sind wichtig. Das NLP von Google kann wahrscheinlich Stimmungsanalysen von Entitäten durchführen, also ignorieren Sie schlechte Bewertungen nicht. Wenn Sie negative Bewertungen erhalten (egal ob in englischer oder Mars-Sprache), können Sie darauf wetten, dass die Google-Stimmungsanalyse Sie in den SERPs nach unten drängt.

- Geben Sie klare Antworten auf die Fragen der Suchenden. Wenn Sie in einem hervorgehobenen Snippet landen möchten, bringen Sie die NLPs von Google nur dorthin, wenn Sie die Textextraktion mithilfe der Entitätsanalyse durchlaufen. Dies bedeutet, dass Google die Möglichkeit hat, bestimmte Informationen zu verfeinern, die den Suchenden angezeigt werden.

Die Zukunft von Google NLPs

Google Natural Language API und Cloud TPU sind jetzt für jedermann verfügbar . Wenn Sie also eine Deep-Learning-Plattform für maschinelles Lernen verwenden könnten, um NLP-Aufgaben auszuführen, können Sie die natürlichen Sprach-APIs von Google verwenden. Sie können sogar an der Schulung von Google Cloud NLPs teilnehmen, wenn Sie möchten!

Optimieren Sie für Google Natural Language API und erhalten Sie Ergebnisse

Eines ist klar: Natürliche Sprach-APIs sind gekommen, um zu bleiben. Wie wir an der Entwicklung zwischen dem BERT-Modell und dem SMITH-Modell sehen können, werden die Google-Suchalgorithmen Ihre Inhalte immer besser verstehen.

Lassen Sie Ihr Mantra gleich bleiben: Konzentrieren Sie sich auf den Inhalt, konzentrieren Sie sich auf die Qualität. Während SEOs weiter lernen und experimentieren werden, um herauszufinden, was für die NLP-Algorithmen von Google am besten funktioniert, halten Sie sich immer an Best Practices für SEO. Denken Sie daran, dass das, was Sie schreiben, Ihr Ranking beeinflusst, aber auch das, was Ihre Kunden und Besucher schreiben, dank der Stimmungsanalyse. Erfahren Sie mehr über den BERT-Algorithmus.

Das KI-Content-Generierungstool von SearchAtlas basiert auf der Natural Language API von Google, sodass Sie mit geringem Aufwand qualitativ hochwertige Inhalte erstellen können.