Wie wirkt sich ChatGPT auf den automatisierten Bot-Verkehr aus?

Veröffentlicht: 2023-06-28

Das Aufkommen von ChatGPT und ähnlichen KI-Technologien bringt sowohl Chancen als auch Herausforderungen mit sich. Als Herausgeber ist es von entscheidender Bedeutung, die potenziellen Auswirkungen von ChatGPT auf den automatisierten/Bot-Verkehr zu untersuchen und wirksame Strategien zu entwickeln, um die negativen Folgen abzumildern. In diesem Artikel werden die Auswirkungen von ChatGPT auf die Generierung von Bot-Traffic, Content Scraping und die Verletzung von geistigem Eigentum untersucht und umsetzbare Initiativen zur Lösung dieser Bedenken vorgestellt.

1. Erleichterung der Bot-Traffic-Generierung durch Code-Erstellung

Die Fähigkeit von ChatGPT, Code zu generieren, ist ein unschätzbar wertvolles Werkzeug für die Aufklärung und Fehlerbehebung. Allerdings können böswillige Akteure diese Fähigkeit ausnutzen, um Code zu erstellen, der auf Websites mit automatisiertem Bot-Verkehr abzielt. Besonders anfällig sind werbebasierte Websites, deren Umsatzgenerierung auf authentischem Nutzerengagement beruht.

Da Werbetreibende in der Regel für Impressionen und Klicks auf der Grundlage von Benutzerinteraktionen bezahlen, können durch Bots generierte Interaktionen diese Kennzahlen künstlich in die Höhe treiben. Infolgedessen zahlen Werbetreibende möglicherweise für Interaktionen, die nicht von echten Benutzern, sondern von Bots initiiert werden.

Dieses Fehlverhalten führt nicht nur zu finanziellen Verlusten für Werbetreibende, sondern untergräbt auch das Vertrauen in Online-Werbeplattformen. Werbetreibende erwarten, dass ihre Investitionen ein echtes menschliches Publikum erreichen und ansprechen. Wenn ihre Anzeigen stattdessen im Bot-Verkehr angezeigt werden, untergräbt dies die Wirksamkeit und den Wert ihrer Werbekampagnen. Solche Vorfälle können dem Ruf der Werbeplattform und der mit ihr verbundenen Publisher schaden, da Werbetreibende davor zurückschrecken, ihre Budgets Plattformen zuzuweisen, die anfällig für Bot-Betrug sind.

Verlage müssen diese potenziellen Auswirkungen kennen und geeignete Maßnahmen ergreifen, um die Risiken zu mindern. Dazu gehört die Implementierung robuster Mechanismen zur Betrugserkennung und -prävention, die Zusammenarbeit mit seriösen Werbenetzwerken, die hochentwickelte Bot-Erkennungsalgorithmen verwenden, und die Überwachung von Verkehrsmustern, um Anomalien zu identifizieren, die auf Bot-Aktivität hinweisen könnten. Durch die aktive Auseinandersetzung mit dem Problem des Bot-Traffics können Publisher die Integrität ihrer Engagement-Kennzahlen wahren und Vertrauen bei Werbetreibenden aufbauen.

2. Intensivierung des Content Scraping

ChatGPT und ähnliche Systeme können verschiedene Aufgaben ausführen, einschließlich Web Scraping, bei dem es darum geht, Daten von Websites für verschiedene Zwecke zu extrahieren. Bedauerlicherweise könnte die Verwendung von ChatGPT-ähnlichen Systemen zu einem Anstieg des Content Scraping führen. Diese Aktivität kann entweder die autorisierte oder unbefugte Vervielfältigung von Online-Inhalten umfassen, die dann für andere Zwecke verwendet oder monetarisiert werden. Das Scraping von Inhalten kann auch eine übermäßige Belastung für die Server der Zielwebsites darstellen und deren Leistung und Verfügbarkeit für legitime Benutzer beeinträchtigen.

Wenn gelöschte Inhalte an anderer Stelle monetarisiert werden, entgehen den Herausgebern der Traffic und das Engagement, die ihr ursprünglicher Inhalt generiert hätte. Darüber hinaus kann Content Scraping eine übermäßige Belastung für die Server der Zielwebsites darstellen. Wenn zahlreiche Scraping-Anfragen gestellt werden, kann dies zu einer erhöhten Serverlast und Bandbreitennutzung führen, was möglicherweise zu Leistungseinbußen oder sogar Ausfallzeiten führen kann. Bei legitimen Benutzern kann es zu langsameren Seitenladezeiten oder Schwierigkeiten beim Zugriff auf die Website kommen, was sich auf ihr gesamtes Benutzererlebnis auswirkt.

Aus rechtlicher Sicht wirft Content Scraping Bedenken hinsichtlich Urheberrechtsverletzungen und geistigen Eigentumsrechten auf. Das unbefugte Scrapen und Reproduzieren von Inhalten ohne ordnungsgemäße Quellenangabe oder Genehmigung kann einen Verstoß gegen das Urheberrecht darstellen. Verlage haben das Recht, ihre Originalwerke zu schützen und zu kontrollieren, wie sie verwendet und verbreitet werden.

Um der Intensivierung des Content Scraping entgegenzuwirken, können Verlage verschiedene Maßnahmen ergreifen. Dazu kann die Implementierung technischer Schutzmaßnahmen wie Bot-Erkennungsalgorithmen, CAPTCHA-Systeme oder Ratenbegrenzungsmechanismen gehören, um Scraping-Versuche zu erkennen und einzudämmen. Darüber hinaus können Verlage rechtliche Möglichkeiten nutzen, um ihre Inhalte zu schützen, einschließlich der Registrierung von Urheberrechten, der Ausstellung von Deaktivierungsmitteilungen an rechtsverletzende Parteien und der Einleitung rechtlicher Schritte gegen Wiederholungstäter.

Für Verlage ist es wichtig, wachsam zu bleiben und ihre Inhalte aktiv auf unbefugte Vervielfältigung zu überwachen. Durch proaktive Maßnahmen zum Schutz ihres geistigen Eigentums und zur Abmilderung der Auswirkungen von Content Scraping können Verlage die Kontrolle über ihre Inhalte behalten, ihre Einnahmequellen schützen und ihre gesetzlichen Rechte wahren.

3. Bedenken hinsichtlich der Verletzung von geistigem Eigentum und Urheberrechten

Eine Zunahme des Content Scraping, unterstützt durch ChatGPT und ähnliche Technologien, könnte zu weit verbreiteten Verletzungen von geistigem Eigentum und Urheberrechten führen. Dieser eskalierende Trend gefährdet die Fähigkeit der Ersteller von Originalinhalten, angemessenen Nutzen aus ihrer Arbeit zu ziehen.

Beim Content Scraping handelt es sich um das unbefugte Extrahieren und erneute Veröffentlichen von Online-Inhalten, häufig ohne Angabe einer ordnungsgemäßen Quellenangabe oder ohne Einholung der Erlaubnis der ursprünglichen Ersteller. Diese Praxis untergräbt die Grundprinzipien des geistigen Eigentums, wonach Urheber das Recht haben sollten, die Verbreitung, Nutzung und Monetarisierung ihrer Werke zu kontrollieren.

Wenn Inhalte ohne Zustimmung gelöscht und erneut veröffentlicht werden, schmälert dies das Einnahmepotenzial für die ursprünglichen Ersteller. Sie verpassen die Möglichkeit, ihre Inhalte über legitime Kanäle wie Werbung, Abonnements oder Lizenzvereinbarungen zu monetarisieren. Darüber hinaus wird ihnen durch das Fehlen einer angemessenen Quellenangabe die Anerkennung und Glaubwürdigkeit entzogen, die sie für ihre kreativen Bemühungen verdienen.

Darüber hinaus kann Content Scraping zu einer verwässerten Online-Umgebung führen, in der duplizierte Inhalte verschiedene Plattformen überschwemmen. Dies führt nicht nur zu Verwirrung bei Nutzern, die nach zuverlässigen und authentischen Quellen suchen, sondern behindert auch das Wachstum und die Vielfalt der Originalinhalte. Die Verbreitung von Scraping-Inhalten verringert den Anreiz für Urheber, ihre Zeit, Ressourcen und ihr Talent in die Produktion hochwertiger, origineller Werke zu investieren.

Aus rechtlicher Sicht verstößt das Scraping von Inhalten ohne Genehmigung häufig gegen das Urheberrecht. Diese Gesetze gewähren den Erstellern von Inhalten ausschließliche Rechte, einschließlich des Rechts zur Vervielfältigung, Verbreitung, Anzeige und Anpassung ihrer Werke. Das unbefugte Scrapen und erneute Veröffentlichen von urheberrechtlich geschütztem Material verstößt gegen diese Rechte und kann für die Täter rechtliche Konsequenzen nach sich ziehen.

Um diese Bedenken auszuräumen, müssen Inhaltsersteller und -herausgeber bei der Überwachung und dem Schutz ihres geistigen Eigentums wachsam bleiben. Sie können verschiedene Strategien zur Bekämpfung von Content Scraping anwenden, einschließlich der Implementierung technischer Maßnahmen zur Erkennung und Verhinderung von Scraping-Versuchen, der Anbringung von Wasserzeichen oder digitalen Fingerabdrücken ihrer Inhalte sowie der Einleitung rechtlicher Schritte gegen Wiederholungstäter.

Mildernde Maßnahmen

Angesichts dieser potenziellen Auswirkungen ist es unbedingt erforderlich, Strategien zu entwickeln, um den Missbrauch von ChatGPT und ähnlichen Technologien einzudämmen. Zu diesen Strategien gehören die Implementierung strengerer Bot-Erkennungsmechanismen, die Entwicklung von Tools zur Bewertung des Schutzniveaus von Websites vor Content Scrapern, die Aufklärung von Herausgebern über die potenziellen Risiken und die Schaffung rechtlicher Rahmenbedingungen, die die unbefugte Nutzung solcher Technologien verhindern.

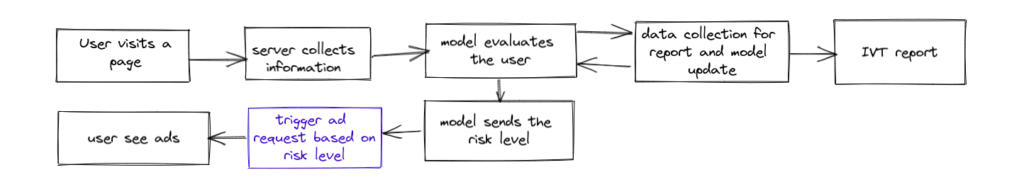

Um die potenziellen negativen Auswirkungen von ChatGPT und ähnlichen Technologien abzumildern, können Verlage von der Nutzung fortschrittlicher Bot-Erkennungslösungen wieTraffic Cop profitieren .Traffic Cop, eine preisgekrönte Bot-Blockierungslösung von MonetizeMore, bietet einen wirksamen Schutz gegen Bot-generierten Datenverkehr, sichert die Integrität der Engagement-Metriken und schützt die Investitionen der Werbetreibenden.

Mit seinen fortschrittlichen Algorithmen und maschinellen Lernfunktionen ist Traffic Cop darauf ausgelegt, bösartige Bots, Klickfarmen und andere betrügerische Aktivitäten zu erkennen und zu blockieren. Durch die Integration von Traffic Cop in ihre Websites können Herausgeber sicherstellen, dass ihre werbebasierten Plattformen vor den negativen Auswirkungen des Bot-Verkehrs geschützt sind, wie z. B. überhöhten Engagement-Metriken, ungenauen Leistungsmetriken und verschwendeten Werbeausgaben.

Diese umfassende Bot-Blockierungslösung verbessert nicht nur die Genauigkeit und Zuverlässigkeit der Engagement-Metriken, sondern trägt auch dazu bei, das Vertrauen der Werbetreibenden in die Plattform aufrechtzuerhalten. Durch die proaktive Blockierung von Bots stellt Traffic Cop sicher, dass die Budgets der Werbetreibenden für echtes Nutzerengagement verwendet werden, was zu mehr Transparenz und einer höheren Kapitalrendite führt.

Darüber hinaus bietet Traffic Cop Publishern detaillierte Einblicke und Berichte zum Bot-Traffic, sodass sie Muster analysieren, das Ausmaß des Bot-Problems verstehen und notwendige Maßnahmen ergreifen können, um ihre Anzeigenleistung und Benutzererfahrung weiter zu optimieren.

Durch den Einsatz von Traffic Cop können Publisher die Herausforderungen, die bösartige Bot-Aktivitäten mit sich bringen, souverän meistern und so eine sicherere und vertrauenswürdigere Werbeumgebung sowohl für Publisher als auch für Werbetreibende gewährleisten. Es ermöglicht Publishern, die Kontrolle über ihre Websites zu übernehmen, ihre Einnahmequellen zu schützen und ihre Beziehungen zu Werbetreibenden zu stärken.

Um mehr über diesen Bot-Killer und seine Fähigkeiten zur Milderung der negativen Auswirkungen von GPT-ähnlichen Systemen zu erfahren, können Sie Traffic Cop hier 7 Tage lang testen!

Syed Tanveer Jishan ist ein erfahrener Spezialist für maschinelles Lernen, der sich auf die Erkennung von Anomalien spezialisiert hat und über ein Jahrzehnt Erfahrung in Wissenschaft und Industrie, insbesondere in der Werbetechnologie, verfügt. Er leitete erfolgreich die Entwicklung von Traffic Cop, einem bahnbrechenden Betrugserkennungstool für MonetizeMore, das zu einer Verzehnfachung der Rückforderung von Werbeeinnahmen führte. Als akademischer Forscher hat Syed mehrere neuartige Forschungsarbeiten veröffentlicht und dabei praktisches und akademisches Fachwissen im Bereich des maschinellen Lernens vereint. Seine Fähigkeiten und Erfahrungen ermöglichen es ihm, Unternehmen dabei zu helfen, ihre Einnahmen vor Betrug zu schützen und die betriebliche Effizienz mithilfe künstlicher Intelligenz zu verbessern.