Wie können Sie Ihr Crawl-Budget optimieren und Rankings verbessern?

Veröffentlicht: 2017-01-14Inhaltsverzeichnis

- 1 Was ist Crawl-Budget?

- 2 Warum ist das Crawl-Budget wichtig?

- 3 Wann ist Crawl-Budget ein Problem?

- 4 So optimieren Sie Ihr Crawl-Budget

- 5 1. Website-Struktur verbessern

- 6 2.Beheben Sie defekte Links

- 7 3. Verwenden Sie Rich Media-Inhalte sorgfältig

- 8 4. Sitemap aufräumen

- 9 5. Bauen Sie externe Links auf

- 10 6.Interne Verlinkung organisieren

- 11 7. Nutzen Sie Feeds

- 12 8.Umleitungsketten entfernen

- 13 9. Stellen Sie sicher, dass Ihre Seiten gecrawlt werden können

Jeder weiß, was Suchmaschinenoptimierung ist und wie wichtig eine gut strukturierte Website, relevante Keywords, hochwertige Inhalte, richtiges Tagging, eine saubere Sitemap und andere technische Standards sind. Aber es besteht die Möglichkeit, dass Sie nicht über die Crawl-Optimierung nachgedacht haben.

Die Optimierung des Crawl-Budgets geht noch eine Stufe tiefer als die Suchmaschinenoptimierung. Während sich die Suchmaschinenoptimierung mehr auf den Optimierungsprozess für Benutzeranfragen konzentriert, konzentriert sich die Crawl-Optimierung darauf, wie die Suchmaschinen-Bots (Web-Spider) auf Ihre Website zugreifen.

In diesem Artikel gehen wir durch die Mechanik hinter der Zuweisung von Crawl-Budgets durch Suchmaschinen zu Websites und Tipps, die Ihnen helfen, das Beste aus Ihrem Crawl-Budget zu machen, um Rankings, organischen Traffic und vor allem Indexierung zu maximieren.

Was ist Crawl-Budget?

Das Crawl-Budget ist einfach die Anzahl der Seiten, die der Suchmaschinen-Spider Ihre Website in einem bestimmten Zeitraum durchsucht. Das Crawling-Budget wird im Allgemeinen durch die Größe und den Zustand Ihrer Website und die Anzahl der Links bestimmt, die auf Ihre Website verweisen.

Das Crawl-Budget ist ein wichtiger SEO-Faktor, dem oft zu wenig Beachtung geschenkt wird. Suchmaschinen verwenden Spider-Bots, um Webseiten zu crawlen, Informationen zu sammeln und sie ihrem Index hinzuzufügen. Darüber hinaus weisen sie auch auf Links auf den von ihnen besuchten Seiten hin und versuchen, diese neuen Seiten ebenfalls zu crawlen.

Der Googlebot ist beispielsweise der Webspider, der neue Seiten entdeckt und sie dem Google-Index hinzufügt. Die meisten Webdienste und SEO-Tools vertrauen darauf, dass diese Webspider nützliche Informationen sammeln.

Warum ist das Crawl-Budget wichtig?

Die Crawlbarkeit einer Website ist ein primärer und entscheidender Schritt, um ihre Durchsuchbarkeit sicherzustellen. Wenn Sie sich fragen, ob die Optimierung des Crawl-Budgets für Ihre Website wichtig ist oder nicht, lautet die Antwort natürlich JA. Ihre SEO-Bemühungen und die Crawl-Optimierung werden wahrscheinlich Hand in Hand gehen.

So einfach es auch ist, es ist ganz logisch, dass Sie sich Gedanken über das Crawl-Budget machen sollten, da es für Google einfacher ist, Ihre Website zu finden und zu indizieren. Wenn Ihre Website mehr gecrawlt wird, erhalten Sie schnellere Updates, wenn Sie neue Inhalte veröffentlichen. Je größer Ihr Crawl-Budget ist, desto schneller geschieht dies.

Dies wird Ihnen auch helfen, die allgemeine Benutzererfahrung für Ihre Website zu verbessern, was die Sichtbarkeit verbessert und letztendlich zu besseren SERP-Rankings führt. Tatsache ist, dass die kürzlich gecrawlten Seiten mehr Sichtbarkeit in den SERPs erhalten und wenn eine Seite eine Weile nicht gecrawlt wurde, wird sie nicht gut ranken.

Wann ist das Crawl-Budget ein Problem?

Es ist nicht so, dass das Crawl-Budget oft ein Problem darstellt. Wenn Sie den URLs Ihrer Website proportionale Crawls zugewiesen haben, ist dies kein Problem. Aber nehmen wir an, Ihre Website hat 200.000 URLs und Google crawlt nur 2.000 Seiten pro Tag auf Ihrer Website, dann könnte es 100 Tage dauern, bis Google die URLs identifiziert oder aktualisiert hat – jetzt ist dies ein Problem.

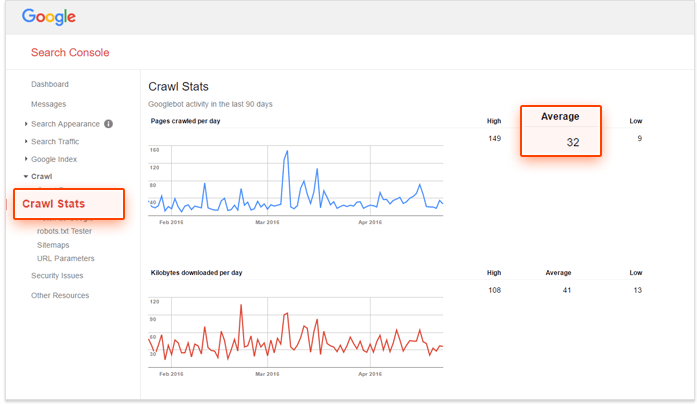

Wenn Sie nach einer Lösung suchen und prüfen möchten, ob Ihr Crawl-Budget optimiert werden muss, verwenden Sie die Google Search Console und die Anzahl der URLs auf Ihrer Website, um die „Crawl-Nummer“ Ihrer Website zu berechnen. Wie macht man das?

– Zuerst müssen Sie auswerten, wie viele Seiten auf Ihrer Website vorhanden sind. Sie können dies tun, indem Sie eine Website erstellen: Suche auf Google,

– Zweitens, gehen Sie zu Ihrem Google Search Console-Konto und gehen Sie zu Crawl und dann zu Crawl Stats. Wenn Ihr Konto nicht richtig konfiguriert ist, erhalten Sie diese Daten nicht.

– Der dritte Schritt besteht darin, die Gesamtzahl der Seiten auf Ihrer Website durch die durchschnittliche Anzahl der Seiten zu dividieren, die pro Tag auf Ihrer Website gecrawlt werden.

Wenn diese Zahl größer als 10 ist, müssen Sie Ihr Crawl-Budget optimieren. Wenn es weniger als 5 ist, bravo! Sie müssen nicht weiterlesen.

So optimieren Sie Ihr Crawl-Budget

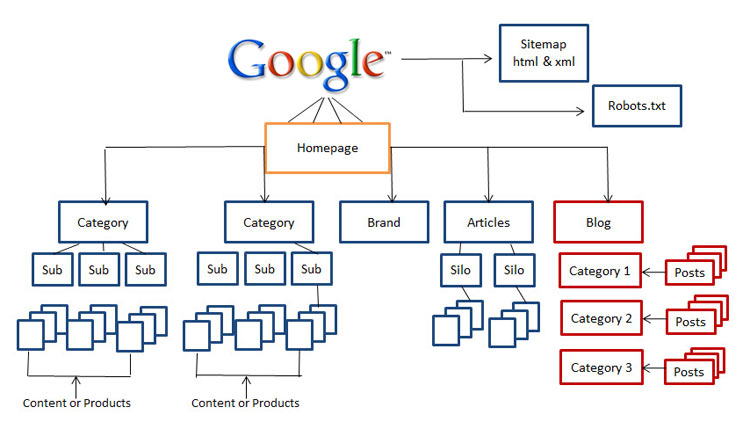

1. Website-Struktur verbessern

Heute ist die Bedeutung der Standortstruktur ein entscheidender Faktor. SEO-Meister wie Rand Fishkin raten, um sicherzustellen, dass die Benutzer Ihrer Website während ihres Besuchs nicht mehr als drei Klicks von der Startseite entfernt sind. Es ist wirklich ein großartiger Ratschlag für SEOs in Bezug auf die Benutzerfreundlichkeit, da Ihre Besucher wahrscheinlich nicht tiefer in Ihre Website eintauchen werden.

Wenn Sie also keine saubere, einfach zu navigierende und suchmaschinenfreundliche Website haben, ist es jetzt an der Zeit, Ihre Website neu zu strukturieren.

2.Beheben Sie defekte Links

Dies ist einer der grundlegenden Unterschiede zwischen Suchmaschinenoptimierung und Crawl-Optimierung. Defekte Links spielen nicht nur eine wesentliche Rolle beim Absenken Ihres Rankings, sondern behindern auch die Fähigkeit des Googlebots, Ihre Website zu indizieren und zu ranken.

Der Algorithmus von Google hat sich im Laufe der Jahre erheblich verbessert, und alles, was sich auf die Benutzererfahrung auswirkt, wirkt sich wahrscheinlich auf die SERPs aus. Google versucht seit jeher, das Nutzerverhalten zu kopieren und die Algorithmen zu aktualisieren. Wir sollten also immer die Benutzererfahrung berücksichtigen, wenn wir Websites für die Suchmaschinen optimieren.

3. Verwenden Sie Rich Media-Inhalte sorgfältig

Heutzutage hat Google Mühe, Silverlight und nur einige andere Dateien zu crawlen, aber es gab Zeiten, in denen Google Rich-Media-Inhalte wie Flash, Javascript und HTML nicht crawlen konnte.

Obwohl Google die meisten Ihrer Rich Media-Dateien lesen kann, gibt es andere Suchmaschinen, die dies möglicherweise nicht können. Das bedeutet, dass Sie diese Dateien mit Bedacht verwenden sollten, und manchmal möchten Sie sie möglicherweise auf den Seiten, die Sie ranken möchten, vollständig vermeiden.

4.Sitemap aufräumen

Bemühen Sie sich, Ihre Sitemap zu bereinigen und auf dem neuesten Stand zu halten, um sie vor Unordnung zu schützen, die die Benutzerfreundlichkeit Ihrer Website beeinträchtigen könnte, einschließlich blockierter Seiten, nicht kanonischer Seiten, unnötiger Weiterleitungen und 400-Level-Seiten. Die Verwendung von XML-Sitemaps ist der beste Weg, um Ihren Benutzern und Spider-Bots zu helfen.

Es gibt verschiedene Tools auf dem Markt, um Ihre Sitemap zu bereinigen. Sie können den XML-Sitemap-Generator verwenden, um eine saubere Sitemap zu erstellen, die alle Seiten ausschließt, die von der Indizierung blockiert sind, Dinge wie 301- und 302-Weiterleitungen und nicht kanonische Seiten finden und beheben.

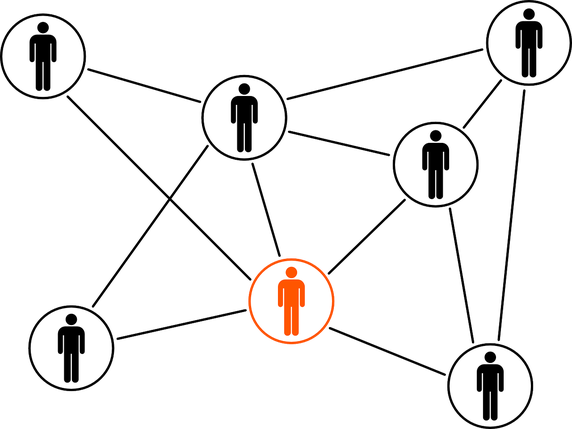

5. Bauen Sie externe Links auf

Linkbuilding ist ein allzeit heißes Thema und wird in naher Zukunft nicht verschwinden. Das Entdecken neuer Communities, der Aufbau von Online-Beziehungen und der Aufbau von Markenwerten sind einige der Vorteile, die Sie bereits in Ihrem Linkbuilding-Prozess haben sollten.

Wenn dies durch Best Practices durchgeführt wird, sind externe Links die Links, die auf eine externe Domain verweisen, und die wichtigste Quelle für höhere Rankings. Obwohl externe Links die am schwierigsten zu manipulierenden Metriken sind, sind sie eine großartige Möglichkeit für Suchmaschinen, die Popularität und Relevanz einer Webseite zu ermitteln.

6. Organisieren Sie die interne Verlinkung

Obwohl der Aufbau interner Links nicht viel mit der Optimierung des Crawl-Budgets zu tun hat, bedeutet dies nicht, dass Sie ihn ignorieren können. Eine gut organisierte und gepflegte Seitenstruktur trägt dazu bei, dass Ihre Inhalte sowohl für die Benutzer als auch für die Spider-Bots leicht sichtbar sind, ohne dass genügend Crawl-Budget ausgegeben wird.

Ein gut strukturiertes internes Verlinkungssystem verbessert auch die Benutzererfahrung. Wenn Sie Benutzern helfen, jeden Bereich mit wenigen Klicks zu erreichen, und Dinge leicht zugänglich machen, werden Besucher im Allgemeinen länger auf Ihrer Website bleiben, was Ihre SERP-Rankings verbessern wird.

7. Nutzen Sie Feeds

Verschiedene Feeds wie RSS, Atom und XML helfen Ihrer Website dabei, Inhalte für Benutzer bereitzustellen, selbst wenn diese nicht auf Ihrer Website surfen. Dies ist die beste Möglichkeit für Benutzer, die günstigsten Websites zu abonnieren und regelmäßige Updates zu erhalten, wenn neue Inhalte veröffentlicht werden.

Seit langem haben sich RSS-Feeds als gute Möglichkeit erwiesen, die Leserschaft und das Engagement Ihrer Website zu steigern. Außerdem gehören sie auch zu den meistbesuchten Seiten der Webspider von Google. Wenn Ihre Website ein Update hat, können Sie es an den Feed Burner von Google senden, damit Sie sicher sind, dass es richtig indexiert ist.

8.Umleitungsketten entfernen

Jede URL, auf die Sie umleiten, verschwendet ein wenig Ihres Crawl-Budgets. Wenn Ihre Website lange Weiterleitungsketten hat, was bedeutet, dass Sie eine große Anzahl von 301- und 302-Weiterleitungen hintereinander haben, können Webspider abspringen, bevor sie Ihre Zielseite erreichen, und Ihre Seite wird letztendlich nicht indexiert. Wenn Sie nach Best Practices für Weiterleitungen suchen, ist es besser, so wenige Weiterleitungen wie möglich auf Ihrer Website zu haben, und nicht mehr als zwei hintereinander.

9.Stellen Sie sicher, dass Ihre Seiten gecrawlt werden können

Wenn Suchmaschinen-Spider-Bots in der Lage sind, Ihre Webseiten zu finden, Links auf Ihrer Website zu finden und ihnen zu folgen, dann können sie gecrawlt werden. Daher müssen Sie Ihre robots.txt- und .htaccess-Dateien so konfigurieren, dass sie die kritischen Seiten Ihrer Website nicht blockieren.

Möglicherweise müssen Sie auch die Textdateien der Seiten bereitstellen, die auf Rich-Media-Inhalten wie Flash, Silverlight usw. basieren.

Nur durch das Verbieten in der robots.txt können Sie nicht garantieren, dass eine Seite nicht mehr deindexiert wird. Wenn es externe Dinge wie eingehende Links gibt, die weiterhin Zugriffe auf die Seite leiten, die Sie nicht zugelassen haben, kann Google davon ausgehen, dass die Seite immer noch relevant ist. In diesem Fall müssen Sie die Indexierung der Seite manuell sperren. Sie können dies ganz einfach tun, indem Sie den HTTP-Header X-Robots-Tag oder das Robots-Meta-Tag noindex verwenden.

Beachten Sie, dass Sie bei Verwendung des noindex-Meta-Tags oder des X-Robots-Tags die Seite in robots.txt nicht verbieten sollten. Die Seite muss gecrawlt werden, bevor das Tag gesehen und befolgt wird.

Fazit: Die Optimierung des Crawl-Budgets ist keine leichte Aufgabe und sicherlich kein „schneller Gewinn“. Wenn Sie eine kleine oder mittelgroße Website haben, die gut gepflegt ist, sind Sie wahrscheinlich in Ordnung. Aber wenn Sie eine komplexe und unorganisierte Site-Struktur mit Tausenden von URLs haben und Server-Log-Dateien über Ihren Kopf hinausgehen, ist es möglicherweise an der Zeit, Fachleute oder Experten anzurufen, um Ihnen zu helfen.