Die Bedeutung von /robots.txt

Veröffentlicht: 2020-07-27Zuletzt aktualisiert am 27. Juli 2020

In einem früheren Blog haben wir die Vorteile der Datei sitemap.xml auf unserer Website besprochen. In diesem Blog werden wir die Bedeutung der Datei /robots.txt auf unserer Website erörtern.

In einem früheren Blog haben wir die Vorteile der Datei sitemap.xml auf unserer Website besprochen. In diesem Blog werden wir die Bedeutung der Datei /robots.txt auf unserer Website erörtern.

Was ist /Robots.Txt?

Die /robots.txt ist eine Textdatei, die sich im Stammverzeichnis des Webservers unserer Website befindet. Es ist eine wichtige Datei, da sie verwendet wird, um den Webrobotern Anweisungen zum Webinhalt unserer Website zu geben. Web Robots, Crawler oder Spider sind Programme, die von Suchmaschinen verwendet werden, um den Webinhalt einer Website zu indexieren. Diese gegebenen Anweisungen werden The Robots Exclusion Protocol genannt.

Die Datei /robots.txt ist eine öffentliche Datei, auf die durch Eingabe einer URL wie http://wwwmysite.com/robots.txt zugegriffen werden kann. Jeder kann den Inhalt der Datei und die Speicherorte sehen, auf die die Webroboter keinen Zugriff haben sollen. Das bedeutet, dass die Datei /robots.txt nicht dazu verwendet werden sollte, kritische Informationen auf Ihrer Website zu verbergen.

Die /robots.txt ist das erste, wonach die Suchmaschinen-Roboter suchen, wenn sie eine Website besuchen... Click To TweetSyntax und Inhalt der Robot.txt-Datei

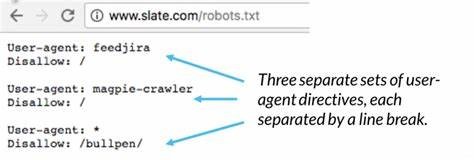

Die Anweisungen in der Datei /robots.txt beinhalten den Speicherort unserer Site-Sitemap, auf welches Verzeichnis die Web-Roboter zugreifen sollen und auf welche Seiten wir nicht wollen und auf welche Seiten die Web-Roboter nicht zugreifen sollen. Eine einfache Syntaxanweisung der Datei /robots.txt lautet:

User-Agent: *

Nicht zulassen: /

Die Zeile „User-agent: *“ bedeutet, dass die Anweisungen in der Datei für alle Roboter gelten. Das „Disallow: /“ weist den Roboter an, keine Seiten auf der Website zu crawlen.

Weitere Standardanweisungen in /robots.txt können sein:

- Vollständigen Zugriff auf den Inhalt der Website zulassen, aber einen Ordner oder eine Seite blockieren:

User-Agent: *

Nicht zulassen: /Ordner/

Nicht zulassen: /page.html

- Vollständigen Zugriff auf den Inhalt der Website zulassen, aber eine Datei blockieren:

User-Agent: *

Nicht zulassen: /Dateiname.pdf

- Vollständigen Zugriff auf den Inhalt der Website zulassen, aber das Crawlen eines bestimmten Web-Robots blockieren:

User-Agent: *

Nicht zulassen:

User-Agent: Googlebot

Nicht zulassen: /

Eine Liste einiger Webroboter finden Sie unter https://www.robotstxt.org/db.html

Wir müssen die „Disallow“-Zeile für jedes URL-Präfix trennen, das wir ausschließen möchten. Globing und reguläre Ausdrücke werden weder in der User-agent- noch in der Disallow-Zeile unterstützt. Das „*“ im User-Agent-Feld ist ein spezieller Wert, der „jeder Roboter“ bedeutet.

Richtig:

User-Agent: *

Nicht zulassen: /Dateiname.pdf

Nicht zulassen: /Ordner1/

Nicht zulassen: /Ordner2/

Fehler:

User-Agent: *

Nicht zulassen: /Dateiname.pdf

Nicht zulassen: /Ordner1/ /Ordner2/

Nicht zulassen: /Ordner3/*

Warum ist Robots.txt so wichtig?

Wir sollten die Bedeutung der Datei /robots.txt kennen, da eine unsachgemäße Verwendung der Datei das Ranking einer Website beeinträchtigen kann. Es ist die erste Datei, nach der der Suchmaschinen-Roboter sucht, wenn er eine Website besucht.

Die Datei /robots.txt enthält Anweisungen, die steuern, wie die Suchmaschinen-Roboter die Webseiten der Website sehen und mit ihnen interagieren. Diese Datei sowie die Bots, mit denen sie interagiert, sind grundlegende Elemente der Funktionsweise einer Suchmaschine.

Die /robots.txt ist das erste, wonach die Suchmaschinen-Roboter suchen, wenn sie eine Website besuchen, weil sie wissen möchten, ob sie die Berechtigung haben, auf den Inhalt der Website zuzugreifen und welche Ordner, Seiten und Dateien gecrawlt werden können.

Einige der Gründe für eine /robots.txt-Datei auf unserer Website können sein:

- Wir haben Inhalte, die wir für Suchmaschinen blockieren möchten.

- Es gibt bezahlte Links oder Anzeigen, die spezielle Anweisungen für verschiedene Webroboter benötigen.

- Wir möchten den Zugriff auf unsere Website durch seriöse Roboter einschränken.

- Wir entwickeln eine Live-Site, aber Sie möchten noch nicht, dass Suchmaschinen sie indizieren.

- Einige oder alle der oben genannten Aussagen treffen zu, aber wir haben keinen vollständigen Zugriff auf unseren Webserver und wie er konfiguriert ist.

Andere Methoden können die oben genannten Gründe kontrollieren, aber die Datei /robots.txt ist ein richtiger und unkomplizierter zentraler Ort, um sich darum zu kümmern. Wenn wir keine /robots.txt-Datei auf unserer Website haben, haben die Suchmaschinen- Roboter vollen Zugriff auf unsere Website.

Was bedeuten die SCHLÜSSELWÖRTER der Anweisung?

„User-agent:“ -> Geben Sie an, welche Anweisungen auf einen bestimmten Roboter angewendet werden sollen. Eine Aussage wie „User-agent: *“ bedeutet, dass die Anweisungen für alle Roboter gelten. Eine Aussage wie „User-Agent: Googlebot“ bedeutet, dass die Anweisungen nur für den Googlebot gelten.

„Disallow:“ -> Sagen Sie den Web-Robotern, welche Ordner sie nicht anschauen sollen. Das heißt, wenn Sie beispielsweise nicht möchten, dass Suchmaschinen die Bilder auf Ihrer Website indizieren, können Sie diese Bilder in einem Ordner ablegen und ihn wie „Disallow: /images/“ ausschließen.

„Erlauben:“ -> Sagen Sie einem Roboter, dass es in Ordnung ist, eine Datei in einem Ordner zu sehen, der durch andere Anweisungen „Nicht zugelassen“ wurde. Zum Beispiel:

User-Agent: *

Nicht zulassen: /Bilder/

Zulassen: /images/myphoto.jpg

„Sitemap:“ -> Teilen Sie einem Roboter den Speicherort der Sitemap-Datei der Website mit. Zum Beispiel:

User-Agent: *

Sitemap: https://www.mysite.com/sitemap.xml

Nicht zulassen: /Bilder/

Zulassen: /images/myphoto.jpg

Robots Meta-Tag, ist es wichtig?

Wir haben die Bedeutung und Verwendung der Datei /robots.txt auf unserer Website besprochen, aber es gibt eine andere Möglichkeit, den Besuch von Webrobotern auf unseren Websites zu kontrollieren. Dieser andere Weg führt über ein Robots-Meta-Tag.

<meta name="ROBOTS" content="NOINDEX, FOLLOW">

Wie jedes <meta>-Tag sollte es im <head>-Abschnitt der HTML-Seite platziert werden. Außerdem ist es am besten, es auf jeder Seite Ihrer Website zu platzieren, da ein Roboter auf einen Deep-Link zu jeder Seite Ihrer Website stoßen kann.

Wie jedes <meta>-Tag sollte es im <head>-Abschnitt der HTML-Seite platziert werden. Außerdem ist es am besten, es auf jeder Seite Ihrer Website zu platzieren, da ein Roboter auf einen Deep-Link zu jeder Seite Ihrer Website stoßen kann.

Das Attribut „name“ muss „ROBOTS“ sein.

Gültige Werte für das Attribut „content“ sind: „INDEX“, „NOINDEX“, „FOLLOW“, „NOFOLLOW“. Mehrere durch Kommas getrennte Werte sind zulässig, aber offensichtlich sind nur einige Kombinationen sinnvoll. Wenn es kein Robots-<meta>-Tag gibt, ist der Standardwert „INDEX, FOLLOW“, sodass Sie dies nicht buchstabieren müssen. Andere mögliche Verwendungen des robots <meta>-Tags sind:

<meta name="ROBOTS" content="INDEX, NOFOLLOW">

<meta name="ROBOTS" content="NOINDEX, NOFOLLOW">

Die Verwendung des Meta-Tags bezieht sich eher auf bestimmte Seiten, von denen wir nicht möchten, dass sie von Webrobotern gecrawlt werden. Es wird nicht häufig verwendet, und es ist genauer und einfacher, den Besuch zu kontrollieren Webroboter über die Datei /robots.txt.

Fazit

Wir haben gesehen, wie wichtig die /robots.txt auf unserer Website ist, ihre Syntax und was wir damit für die Vorteile unserer Website tun können. Wir haben auch die Verwendung des Robots-Meta-Tags und seine Einschränkungen gesehen.

Wenn wir es jedoch verwenden, müssen wir sicherstellen, dass es ordnungsgemäß verwendet wird. Eine falsche /robots.txt-Datei kann die Web-Roboter daran hindern, unsere Website-Seiten zu indizieren, oder, was noch wichtiger ist, wir müssen sicherstellen, dass wir keine Seiten blockieren, die die Suchmaschinen ranken müssen.

—–

Geschrieben von Arturo S.