Alpträume von Suchmaschinenoptimierungskampagnen – Schurkenentwickler

Veröffentlicht: 2022-01-13

Jeder SEO-Berater stößt irgendwann in seiner Karriere auf den Albtraum der Suchmaschinenoptimierung, sich mit einem Schurkenentwickler auseinandersetzen zu müssen.

Im Folgenden finden Sie einige Umrisse dessen, was einen unseriösen Entwickler ausmacht und welche Auswirkungen dies auf die Bemühungen der Suchmaschinenoptimierungskampagne Ihres Kunden haben kann, erfolgreich zu sein und eine rentable online PROFITABLE Einheit zu werden.

Hier, bei That Company, sind wir nicht nur darauf spezialisiert, nicht nur White-Label-PPC-Dienste, sondern auch Suchmaschinenoptimierungsdienste direkt für Kunden anzubieten, sondern wir betreiben auch eine sehr gesunde lokale SEO-Agentur.

Als White-Label-Dienstleister agieren wir als Teammitglieder unserer White-Label-Partnerunternehmen. Wir können direkt mit den Kunden unserer White-Label-Partner unter deren Markennamen zusammenarbeiten oder wir können für den White-Label-Partner als Berater arbeiten und der White-Label-Partner kann dann unsere Empfehlungen zur Umsetzung durch ihn oder seinen Kunden weitergeben.

Kürzlich brachte uns einer unserer sehr starken White-Label-Suchmaschinenoptimierungspartner einen neuen Kunden, mit dem wir direkt unter dem Markennamen White Labels zusammenarbeiten würden. Während unseres ersten Onboarding-Gesprächs mit dem Endbenutzer-Kunden wurde deutlich, dass wir es mit dem Albtraum der Suchmaschinenoptimierung zu tun hatten, mit einem unseriösen Entwickler fertig zu werden.

Der Vertrag wurde am 4. April 2021 ausgeführt, und wir müssen noch sehen, dass die meisten unserer Empfehlungen im Namen des Kunden umgesetzt wurden.

Der Vertrag wurde am 4. April 2021 ausgeführt, und wir müssen noch sehen, dass die meisten unserer Empfehlungen im Namen des Kunden umgesetzt wurden.

Bei der Vorbereitung auf dieses erste Onboarding-Gespräch führe ich eine erste Analyse aller Dokumente durch, um einen strategischen Plan zu formulieren.

Eines dieser Dokumente ist das Ergebnis eines Website-Audit-Tool-Crawlings, das Folgendes ergab:

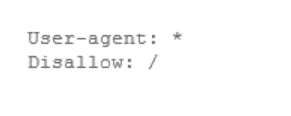

- txt Crawler blockieren – 1 Fehler

- XML nicht gefunden – 1 Fehler

- Fehlende Sitemap.xml-Referenz – 1 Fehler

Von Anfang an sah es so aus, als könnte ich mit einer Standard-On-Page-Optimierungsstrategie beginnen.

Und genau das habe ich vorbereitet, um es dem Kunden bei meinem ersten Anruf zu präsentieren.

Wir sollten später herausfinden, warum es in unseren Berichtsdaten wenige Site-Audit-Fehler gab, aber wir werden das unten behandeln.

On-Boarding-Verfahren zur Verwaltung von Kampagnen zur Suchmaschinenoptimierung

Während des Onboarding-Call-Prozesses für die Suchmaschinenoptimierung versuchen wir, mehrere Elemente zu gewinnen, die für unseren Erfolg für den Kunden geschäftskritisch sind.

Wir bitten um Zugang zu ihrer Website-Verwaltung und ihren Website-Serverdateien.

Nach etwa einem Monat wurde vom Entwickler kein Zugriff gewährt, und der Kunde hatte, wie wir herausfanden, nie Zugriff auf seine Website.

Weitere Gespräche später erfuhren wir, dass der Kunde seit 15 Jahren bei diesem Entwickler und sogenannten SEO-Experten war.

In all dieser Zeit gab es nicht einmal ein einfaches Google Analytics-Setup für die Website.

Weitere Beweise für einen Schurkenentwickler.

Als wir das Konto übernahmen, hatte der Kunde 349 Keywords in den Top 100 der Google SERPs, nur 1 Keyword auf Position 1, seinen Markennamen und nur 11 Keywords auf Seite 1.

Ziemlich ungesunde Ergebnisse, um in einer sehr begrenzten Branche online erfolgreich sein zu können.

Es wurde bekannt, dass der Kunde versuchte, sich von diesem Entwickler zu scheiden und sogar anwaltlichen Rat eingeholt hatte. Dieser Rat lautete: „Tue dies sehr vorsichtig“.

Sogar der Rechtsberater des Kunden wusste, dass dieser Entwickler den Kunden im Griff hatte.

Jeder SEO-Berater stößt irgendwann in seiner Karriere auf den Albtraum der Suchmaschinenoptimierung, sich mit einem Schurkenentwickler auseinandersetzen zu müssen. Klicken Sie hier, um zu twitternWas ist mit dem oben erwähnten Robots.txt-Block?

Nun, wir haben nur drei Fehler gesehen, die von unserem Site-Audit-Tool generiert wurden, obwohl es normalerweise Hunderte, wenn nicht Tausende sind. Von:

- fehlende Meta-Beschreibungen

- fehlende Seitentitel

- doppelte Meta-Beschreibungen

- doppelte Seitentitel

- lange Seitentitel

- kurze Seitentitel

- lange Meta-Beschreibungen

- kurze Meta-Beschreibungen

- fehlende h1-tags

- mehrere h1-Tags

- umgeleitete interne URLs

- defekte externe Links

- defekte interne Links

- fehlende kanonische Tags

- und viele mehr…

Aber es wurde keiner dieser Fehler gemeldet.

Eine visuelle Überprüfung der Website Seite für Seite zeigte, dass diese Website nicht so perfekt sein könnte.

Also haben wir den Block in der robots.txt-Datei erneut besucht und tatsächlich war er da.

Der Entwickler blockierte Google und unsere Site-Audit-Tools, sodass keine Seiten gecrawlt wurden, mit Ausnahme von zufälligen Links, die die Site im Laufe der Zeit aufgegriffen hatte, sodass Google die verlinkte Seite crawlen konnte, aber keine andere, weshalb Seiten indiziert wurden.

Wenn dies keine betrügerische Webentwicklung ist, wissen wir sicherlich nicht, was betrügerische Webentwicklung ist, aber wir hatten die Anzeichen von Anfang an erkannt.

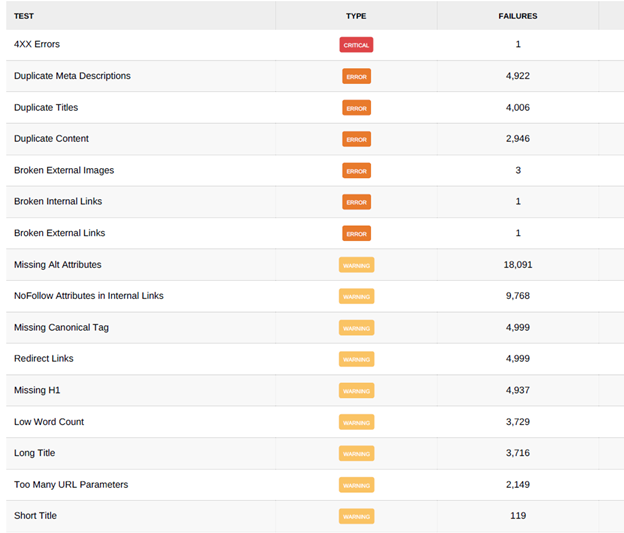

Sobald wir den Webentwickler dazu gebracht hatten, den Crawl-Block zu entfernen, hat sich die gesamte Landschaft der Suchmaschinenoptimierung drastisch verändert.

Wir hatten die Website am frühen Morgen des 17. Mai 2021 mit unserem Basis-Site-Audit-Tool gecrawlt und hatten immer noch keine gecrawlten Seiten und einen Site-Score von 50 %, wie im Bild unten zu sehen.

Später am selben Tag wurde die Crawling-Blockierung aufgehoben, was dazu führte, dass das Crawling-Limit von 5.000 Seiten erreicht und der Site-Score auf 22 % reduziert wurde.

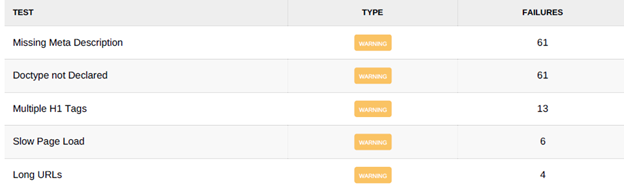

Bitte beachten Sie, dass das Limit unseres Basis-Website-Audit-Crawling-Tools 5.000 Seiten pro Crawling beträgt. Unten sind einige Screenshots der Ergebnisse, nachdem die Crawl-Blockierung aufgehoben wurde.

Screenshot 1:

Screenshot 2:

Nach allen Maßstäben war diese Seite ein Alptraum für die Suchmaschinenoptimierung. Alles wegen eines betrügerischen Entwicklers.

Viele der gemeldeten Fehler waren auf doppelte Seiten oder einfach auf fehlende Seiten zurückzuführen. Links in der Fußzeile und den oberen Menüs der Website führen zu nicht existierenden Seiten.

Wenn Sie bedenken, dass unser Crawling-Tool für die Überprüfung der Basissite auf 5.000 Seiten pro Crawling beschränkt ist, werden Sie feststellen, dass mehrere Probleme gemeldet werden, die diese Grenze überschreiten.

Speziell:

- Doppelte Meta-Beschreibungen

- Fehlende kanonische Tags

- Umgeleitete Links

Bei der Überprüfung der von uns gefundenen Daten kamen die umgeleiteten Links beispielsweise von einem Fußzeilen-Link oder einem Top-Menü-Link.

Wir haben dem Entwickler Anweisungen zur Korrektur gegeben, was normalerweise drei bis vier E-Mails mit dem Kunden dauerte, der dann die Empfehlung an den Entwickler übermittelte.

Mit dem Limit von 5.000 gecrawlten Seiten pro Crawl würde der nächste Crawl jedes Mal, wenn der Webentwickler eine Empfehlung umsetzt, zeigen, dass es 5.000 neue Probleme im Zusammenhang mit dem ursprünglichen Problem gibt, das sich im Laufe der Zeit für jedes Problem wiederholt hat.

Seit Anfang Juni wurden keine Empfehlungen mehr umgesetzt und der Kunde kämpft weiterhin mit seiner SEO-Kampagne.

Seit Anfang Juni wurden keine Empfehlungen mehr umgesetzt und der Kunde kämpft weiterhin mit seiner SEO-Kampagne.

Dies führte letztendlich dazu, dass der Kunde uns als seine SEO-Berater fragte, ob er einfach von vorne anfangen sollte.

Unsere Antwort war ein herzliches JA!

Wir haben mit dem Kunden überprüft, wie viele Empfehlungen wir in den letzten Monaten abgegeben haben. Dass nichts implementiert worden war und die Website des Kunden nirgendwohin führte, bis wir die Kontrolle über das Schicksal der Website erlangen konnten.

Dies führte dazu, dass unser White-Label-Partner einen lohnenden Auftrag für den Neuaufbau der Website und die Bereitstellung des vollständigen Zugriffs für den Kunden und unser White-Label-SEO-Team erhielt.

Der letzte Imbiss für alle Websitebesitzer ist, IHRE EIGENE WEBSITE ZU BESITZEN!

Zwei der ersten Fragen, die Sie sich bei der Suche nach einem Webentwickler stellen müssen, sind:

- Werde ich Administratorzugriff auf meine Website haben?

- Habe ich Administratorzugriff auf die Serverdateien meiner Website?

Wenn die Antwort auf eine dieser Fragen nein lautet, müssen Sie sich zurückziehen und den Alptraum der Suchmaschinenoptimierung vermeiden, wie ein unseriöser Webentwickler Ihre Suchmaschinenoptimierungskampagne und letztendlich Ihr Online-Geschäft ruinieren kann.