Was ist ein SEO-Website-Audit?

Veröffentlicht: 2021-08-11Inhaltsverzeichnis

Was ist ein SEO-Website-Audit und wie wird es durchgeführt? Zusammen mit einem Inhaltsplan und einer Strategie für die organische Sichtbarkeit bildet dieses Dokument (oder eine Reihe von Dokumenten) den Grundstein Ihrer SEO-Aktivitäten. Eine gute Umsetzung bringt Sie auf Erfolgskurs.

Vor diesem Hintergrund haben wir uns entschlossen , Sie Schritt für Schritt durch den Prozess der Durchführung eines SEO-Audits zu führen .

Ein SEO-Audit ist eine Reihe von Analysen, die von einem SEO-Spezialisten durchgeführt werden. Es soll sicherstellen, dass die Seite den neuesten Standards der Suchmaschinenoptimierung entspricht und einer Strategie für organisches Wachstum nichts im Wege steht.

Wichtig ist, dass ein Audit an sich keine Strategie ist. Zu Beginn der Zusammenarbeit stellen wir dem Auftraggeber in der Regel beide Dokumente gleichzeitig zur Verfügung. Die meisten Audits beinhalten jedoch keine Keyword-Analyse oder einen Inhaltsplan (es gibt Ausnahmen).

Wenn die Website keine grundlegenden Fehler enthält, wird selbst die gründlichste Prüfung nur ein paar Falten aufdecken, die es auszubügeln gilt. Es ist das Best-Case-Szenario, denn es bedeutet, dass Sie unsere SEO-Strategie sofort starten können, anstatt Audit-Empfehlungen umzusetzen, die zusätzliche Kosten für den Kunden verursachen würden. In gewisser Weise sind SEO-Experten wie Ärzte – man möchte ihnen nur sagen „alles in Ordnung“.

Ein SEO-Experte kann bereits in der Angebotsphase eine allgemeine Einschätzung zum Zustand der Website abgeben. Diese Vordiagnose dient dazu, das Prüfungsangebot und den Analyseumfang auf die Bedürfnisse des Mandanten abzustimmen.

Wann sollte ein SEO-Audit durchgeführt werden? 4 Situationen, in denen Sie eine brauchen

Während Sie technische Updates implementieren

Ein SEO-Experte sollte alle Pläne für größere Updates vor der Implementierung prüfen. Zu den „großen“ Updates gehören:

- Übertragung auf ein anderes CMS (Content Management System),

- Aktualisierung des HTML-Codes,

- Ändern von URLs oder interner Seitenstruktur,

- Hinzufügen oder Entfernen bestimmter Abschnitte, Seiten oder Funktionen.

Wissen Sie, was der häufigste Killer des organischen Wachstums bei Google ist? Keine Algorithmus-Optimierungen, sondern größere Updates, die ohne SEO-Unterstützung oder -Analyse implementiert werden.

Aus diesem Grund sollte bei Webdesign-Projekten von Anfang an eine SEO-Agentur oder ein Experte mitwirken. Wenn Sie vom ersten Tag an an Bord sind, können Sie sicherstellen, dass die Website-Struktur selbst Ihre SEO-Strategie antreibt.

Für organische Sichtbarkeitsprobleme

Wenn Ihre SEO-Bemühungen ins Stocken geraten, ist mit zufälligen Traffic-Einbrüchen oder einem Sichtbarkeitsplateau zu rechnen. Während einer aktiven Kampagne ist das Fehlen von Ergebnissen jedoch ein Grund zur Sorge.

Ein plötzlicher Rückgang des organischen Traffics kann auf Fehler auf der Website oder ein Update im Google-Algorithmus hinweisen, das die Bewertung der vorhandenen Inhalte verändert hat. In beiden Fällen benötigen Sie möglicherweise ein SEO-Audit, um die Probleme zu identifizieren, die behoben werden müssen, oder um die Website an die neuen Bewertungskriterien von Suchmaschinen-Robotern anzupassen.

Wenn eine aktive Content-Marketing- und/oder Linkbuilding-Strategie vorhanden ist, kann eine Stagnation auf das Vorhandensein von unentdeckten Fehlern hindeuten, die Ihr Wachstum effektiv hemmen.

Bei der Partnerschaft mit einer neuen SEO-Agentur

Ein SEO-Audit ist ein Standardverfahren zu Beginn der Zusammenarbeit mit jeder auf SEO spezialisierten Agentur oder jedem Experten. Um unsere Strategie effektiv umzusetzen, müssen wir wissen, dass die Website in gutem Zustand ist.

Kunden wehren sich dagegen eher mit dem Argument, dass eine moderne Website keine Fehler enthalten darf oder dass im Jahr zuvor ein SEO-Audit durch die damalige Agentur durchgeführt wurde.

Als Spezialist, der die Verantwortung für das neue Projekt und seine Ergebnisse übernimmt, haben Sie jedoch das Recht, die Website nach eigenem Ermessen zu überprüfen.

Als Routine

Auch wenn Sie das Haupt-SEO-Audit bereits vor einiger Zeit durchgeführt haben und sich in der Zwischenzeit keine größeren Änderungen ergeben haben, ist es am besten, regelmäßige Überprüfungen durchzuführen. Sie müssen nicht von Grund auf die Form umfassender technischer Audits annehmen. Routineaudits umfassen je nach gewählter Methode:

- monatliche oder vierteljährliche Überprüfungen auf der Grundlage von Fehlern, die während der Erstprüfung festgestellt wurden,

- Analysen konzentrierten sich auf Kernthemen wie die neuen 404-Fehler.

Ein Routineaudit soll also überprüfen, ob seit der letzten Inspektion nichts schief gelaufen ist. Wie wir wissen, ist jede Website etwas Lebendiges – Seiten kommen und gehen, oder sie wechseln ihren Standort. Mittelgroße Online-Shops werden in der Regel von mehreren Personen im Unternehmen verwaltet, und es gibt immer Raum für menschliche Fehler.

Arten von SEO-Audits

Ein vollständiges technisches SEO-Audit

Wenn wir von einem SEO-Audit sprechen, meinen wir meistens die umfassende technische Inspektion, die darauf abzielt, alle potenziellen Optimierungsfehler und Unvollkommenheiten aufzudecken. Diese Audits konzentrieren sich auf die Website selbst und decken die Onsite- und Offsite-Perspektiven ab. Die Ergebnisse werden in einem SEO-Bericht präsentiert, der von einem SEO-Experten erstellt wird, der mit ausgewählten Tools Daten sammelt, die Ergebnisse analysiert und auf das Produkt des Kunden abgestimmte Empfehlungen ausspricht.

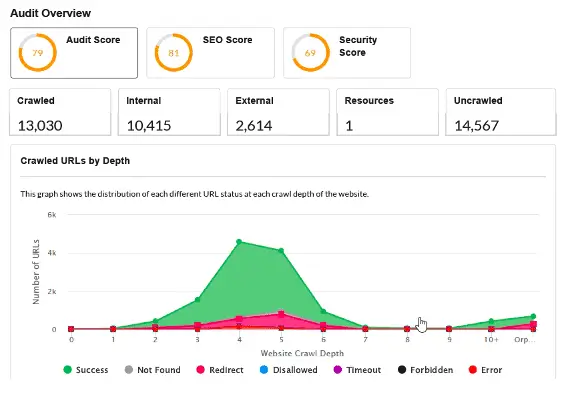

Automatische SEO-Audits

Automatische Audits können in zwei Kategorien eingeteilt werden:

- ausführliche PDF-Berichte, die von modernen und spezialisierten Crawlern wie Sitebulb generiert werden;

- Website-Audits, die automatisch von kostenlosen Tools durchgeführt werden.

Berichte beider Typen haben ihre Verwendung. Während der erste Typ die Arbeit eines erfahrenen Experten erleichtert, läuft der andere in der Regel auf eine voreilige Analyse einiger grundlegender Daten hinaus, die nicht ausreicht, um umfassendere Schlussfolgerungen zu ziehen.

Berichte des zweiten Typs sind in der Regel als kostenloser Kundenanreiz erhältlich.

SEO Wettbewerbsaudits – Benchmarking

Etwas ganz anderes ist ein SEO-Wettbewerbsaudit, das normalerweise durchgeführt wird, wenn wir mit der Entwicklung Ihrer SEO-Strategie beginnen. Es kombiniert die Sichtbarkeitsanalyse Ihrer Konkurrenz mit einem kurzen technischen und inhaltlichen Audit ausgewählter Konkurrenten.

Diese Prüfung bietet:

- Ihr aktueller Maßstab gegenüber der Konkurrenz . Das Audit zeigt Ihnen, wie Ihre Website in der Google-Sichtbarkeit im Vergleich zu Ihren Konkurrenten rangiert. Sie können das Audit vierteljährlich aktualisieren, um festzustellen, wie sich Ihre Strategie auf Ihre Marktposition auswirkt.

- ein Füllhorn an Wissen über den Weg unserer Wettbewerber zu ihrer heutigen Position und ihren Ergebnissen.

Sie können das Audit verwenden, um:

- Erhalten Sie einen Einblick in Optimierungslösungen , die über die Standardempfehlungen hinausgehen,

- sich neue Ideen für den Linkaufbau einfallen lassen,

- und, was wichtig ist, definieren Sie die Inhaltslücke , die Ihnen möglicherweise einen neuen Weg zum organischen Wachstum aufzeigt – etwas, das Sie verpasst haben und das viel Verkehr für die Konkurrenz generiert.

Audits nach der Implementierung

Nach dem ersten Audit kann der Kunde Sie in die Umsetzung der Empfehlungen einbeziehen (was die Dinge vereinfacht) oder es selbst übernehmen. Im letzteren Fall schließen Sie den gesamten Vorgang am besten mit einer Endkontrolle ab, wenn Sie die Checkliste Punkt für Punkt durchgehen. Nur um sicherzugehen, dass alles in Ordnung ist.

E-Commerce-Audits

Zunächst konzentriert sich ein E-Commerce-Audit auf die Website-Architektur, einschließlich Hauptnavigation, Kategorien und Unterkategorien. Folglich erfordern technische Audits für Online-Shops häufig das Hinzufügen einer Keyword-Verwendungsstrategie.

Zweitens sollte das Audit die Paginierung und die gesamte Site-Struktur untersuchen, da viele Entwickler von E-Commerce-Software die berüchtigte Verwendung von rel=canonical und robots noindex als Allheilmittel ansehen. Die Folge: Onlineshops mit 1000 SKU (Stock Keeping Units), die mehr als eine Million redundante Seiten generieren.

Drittens sollte der Fokus darauf liegen, Duplicate Content zu eliminieren – sowohl intern (wiederholt über mehrere Produktoptionen) als auch extern (über verschiedene Geschäfte hinweg).

Inhaltsprüfungen

Inhaltsprüfungen (nicht zu verwechseln mit einer Wachstumsstrategie oder einem Inhaltsplan) konzentrieren sich auf die Maximierung des organischen Verkehrs unter Nutzung vorhandener Ressourcen. Sie können die Analyse umfassen von:

- Aktueller Stand der internen Verlinkung innerhalb der Domain – das Ziel: Feststellen, ob alle Ihre Inhalte thematisch aufeinander verlinken und ob nicht der eine einsame Link im Kategorie-Tab die einzige Möglichkeit ist, einen hochwertigen Artikel zu entdecken.

- Mögliche Probleme mit Keyword-Kannibalisierung oder Situationen, in denen ein einzelnes Thema unnötigerweise in wenige separate Artikel aufgeteilt wird, von denen keiner eine Chance auf einen Top-Rank hat.

- Identifizierung der niedrig hängenden Früchte, d. h. des Inhalts, der nur kosmetische Änderungen (Verlinkung, Neuoptimierung) erfordert, um organischen Traffic zu generieren.

Erst wenn alles in Ordnung ist, sollten Sie mit der Erstellung neuer Inhalte und dem weiteren Wachstum fortfahren.

SEO-Audit eines lokalen Dienstes

Lokal agierende Unternehmen nutzen eher kleinere Websites, bei denen Seitenstruktur und Informationsarchitektur zweitrangig sind.

Im Vordergrund steht hier eine geeignete (lokale) Keyword-Analyse , die als Grundlage für die Planung von Angebotsseiten dient. Außerdem liegt der Fokus auf:

- Überprüfung und Optimierung des Unternehmensprofils bei Google My Business,

- Hinzufügen oder Optimieren der strukturierten Daten des lokalen Unternehmens,

- Prüfung der externen Verlinkung und des NAP-Faktors (Name + Adresse + Telefonnummer).

Lohnt sich ein kostenloses SEO-Audit?

Im Internet kostenlos verfügbare SEO-Audits dienen meist nur einem Zweck – viele (oft irrelevante) Fehler aufzudecken, um am Ende kostenpflichtige Dienste anzubieten.

Beachten Sie, dass diese Audits in der Regel automatisch von digitalen Tools generiert und nicht von SEO-Experten erstellt werden.

Oft muss ein SEO-Audit von mehreren Personen durchgeführt werden, die sich auf technische Angelegenheiten oder die Optimierung von Inhalten spezialisiert haben.

In einigen Fällen erfordern Auditumfang, Websitegröße oder Frist die Beteiligung eines ganzen Teams, das von einer SEO-Agentur beschäftigt wird.

Daher gibt es kein vertrauenswürdiges kostenloses SEO-Audit irgendeiner Website.

So beginnen Sie Ihr SEO-Audit

Das erste, was ich mache, wenn ich ein Audit durchführe (oder früher, wenn ich die Anfrage von einem Kunden bekomme), ist:

- Überprüfen Sie das organische Sichtbarkeitsdiagramm in Senuto

- Verwenden Sie die Website des Suchoperators:

Es dauert insgesamt fünf Minuten und lässt mich oft viele Probleme auf der Website identifizieren.

Denken Sie daran, dass Sie in der Angebotsphase (und in einigen Fällen sogar bei der Durchführung des Audits) möglicherweise keinen Zugriff auf die Google Search Console oder Analytics haben, sodass externe Tools ein Muss sind .

Nur ein Blick in das Sichtbarkeitsdiagramm der Website in Senuto gibt Ihnen eine Fülle von Informationen über das Wohlbefinden der Website. Konzentrieren Sie sich bei näherer Betrachtung auf folgende Punkte:

- Diagrammrichtung – um zu sehen, ob die Sichtbarkeit in den letzten Jahren stetig gewachsen ist, ohne plötzliche Spitzen und Einbrüche. Wenn das Diagramm flach aussieht, deutet dies normalerweise auf einen Mangel an organischer Aktivität oder auf größere Probleme hin, die das Wachstum behindern.

- Wenn Sie innerhalb kurzer Zeit einen plötzlichen Abfall bemerken, versuchen Sie Folgendes :

- Vergleich der Anomalien mit der Liste der wichtigsten bekannten Algorithmus-Updates in der Google-Suche. Wenn sie sich überschneiden, wissen Sie zumindest, womit Sie es zu tun haben.

- Verwenden Sie die WayBackMachine, um zu sehen, wie die Website einen Monat vor und nach dem Drop aussah. In den meisten Fällen sinkt die Sichtbarkeit, nachdem Migrationen ohne die Unterstützung eines SEO-Experten abgeschlossen wurden.

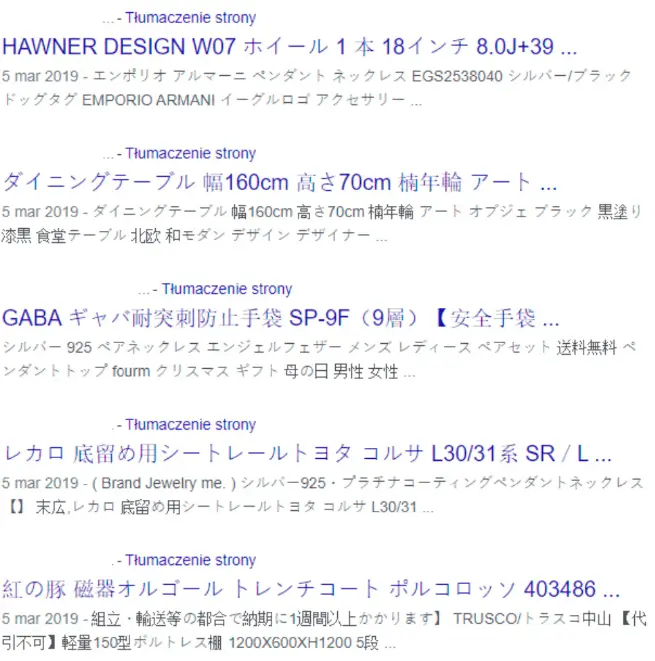

Ein weiterer guter Aufruf ist die Verwendung des häufig übersehenen site:domain.com-Operators. Klicken Sie sich durch die ersten Ergebnisse, um:

- eine grobe Schätzung der Website-Größe vornehmen – auch wenn Sie für die genauesten Daten zur Google Search Console und Ihrem ausgewählten Crawler gehen sollten,

- Sehen Sie sich die allgemeine Qualität von Titel-Tags, Meta-Beschreibungs-Tags und die Präsentation der Ergebnisse an.

- häufig: Finden Sie grundlegende Fehler wie Website-Hacking oder Indexierungsprobleme.

Fallbeispiel:

Ein Kunde, der sein Geschäft seit Jahren betreibt, bemerkt einen Einbruch bei den Bestellungen und neuen Anfragen auf der Firmenwebsite. Mit dem Befehl site:domain.pl wurde das Rätsel sofort gelöst:

Wichtige Punkte, die während eines SEO-Audits überprüft werden sollten

In der Welt der technischen Analyse hat sich der Fokus von einzelnen Tags wie Hx-Headern auf globalere Themen verlagert: Website-Architektur, -Struktur oder -Rendering (was unter anderem aus Googles zunehmender Kompetenz im Umgang mit verschiedenen Website-Typen und -Technologien resultiert). .

Zu den größten Herausforderungen bei der Erstellung eines einzigartigen Leitfadens für SEO-Audits gehören:

- Die große Vielfalt an Situationen und Standorten, die während eines Audits inspiziert werden müssen. Unterschiedliche Ziele, Typen und CMS erzeugen eine Vielzahl möglicher Konfigurationen.

- Die daraus resultierenden Unterschiede in der Gewichtung erkannter Probleme und ihrer möglichen Lösungen.

Theoretisch könnte ich für jedes CMS und E-Commerce-System eine separate Liste mit bewährten Optimierungsmethoden und häufigen Fehlern erstellen. In Anbetracht dessen wäre es wahrscheinlich genauer, die folgende Liste – unterstützt durch meine Expertise aus Dutzenden von Audits – so zu nennen wie: Fantastische SEO-Fehler und wo sie zu finden sind.

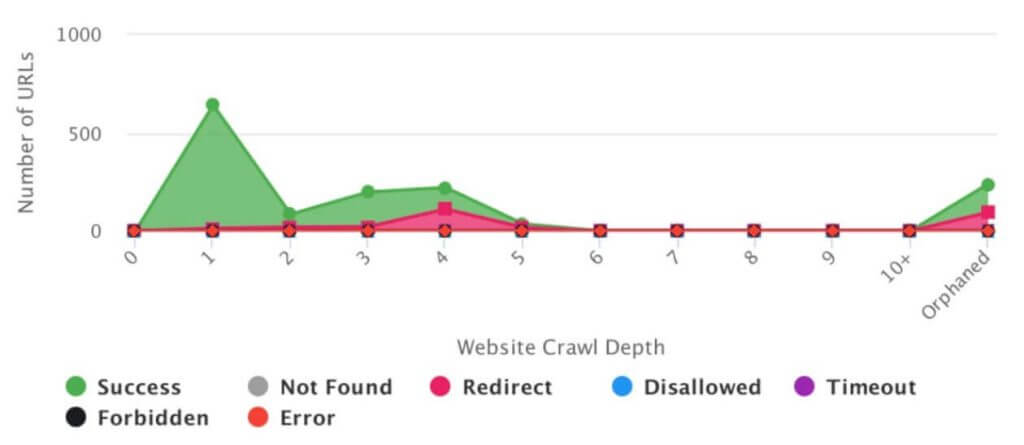

Crawling und Indexierung

Robots.txt

Die robots.txt-Datei verwaltet die Standorte auf der Website, die Sie vor Suchmaschinen-Robotern verbergen möchten. Es dient eher dazu, das Crawling zu blockieren, als die Indexierung selbst. Heutzutage enthalten robots.txt-Dateien selten Fehler, aber es kann wirklich weh tun, wenn sie es tun.

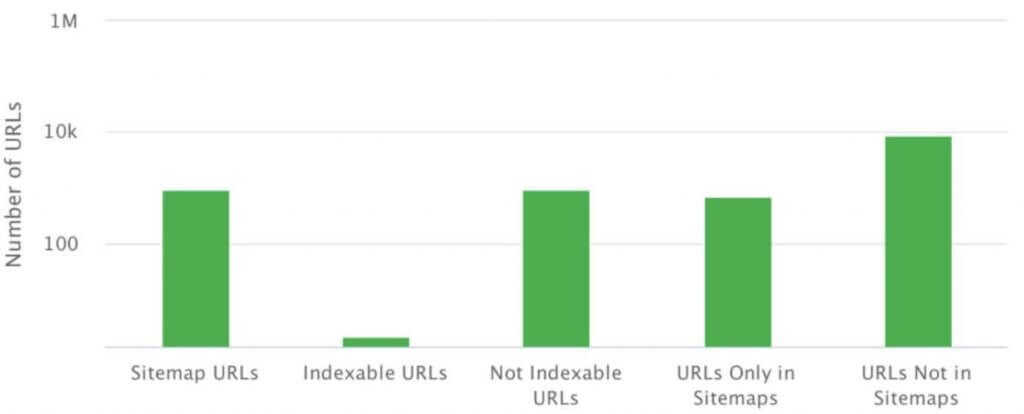

Eine XML-Sitemap

Eine XML-Sitemap ist eine Datei oder eine Reihe von Dateien, die eine Liste aller Seiten enthalten, die Sie in einer bestimmten Struktur indiziert haben möchten.

Sie können die Sitemap unter jeder Adresse finden. Es muss jedoch Daten im XML-Format darstellen, das der Spezifikation entspricht.

Zu den grundlegenden Fehlern in Bezug auf XML-Sitemaps gehören:

- das Fehlen einer XML-Sitemap,

- Syntaxfehler (gemeldet in GSC), die Google daran hindern, die Sitemap abzurufen,

- Inkompatibilität von Sitemap und Website-Struktur,

- Versäumnis, Dateien wie Grafiken und Videos in die Sitemap aufzunehmen.

Verwaiste Seiten

Verwaiste Seiten werden intern nicht verlinkt, aber sie werden oft korrekt gerendert und antworten mit einem 200-Statuscode. Sie erscheinen in der Google Search Console und klettern manchmal sogar in den Rängen nach oben und generieren Traffic.

Verwaiste Seiten tauchen aus vielen Gründen auf, angefangen bei CMS-Fehlern bis hin zu menschlichen Fehlern bei der internen oder externen Verlinkung.

Rel=kanonisch

Rel=canonical ist bei bestimmungsgemäßer Verwendung – um bei interner Duplizierung auf die ursprüngliche Seitenadresse zu referenzieren – kein Problem. Es wird jedoch oft fälschlicherweise als Allheilmittel für alle lästigen Seiten und schlecht geplanten Strukturen angesehen.

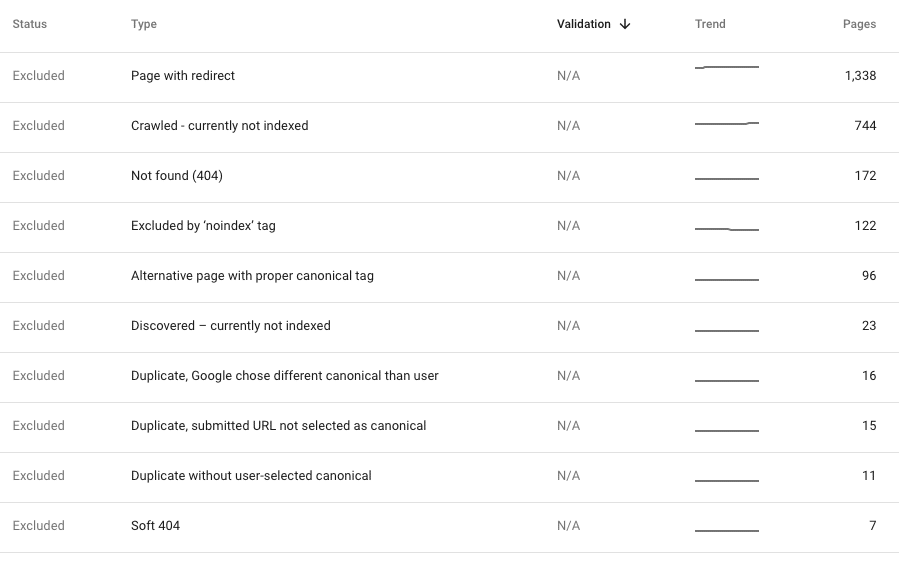

Interne 404-Fehler

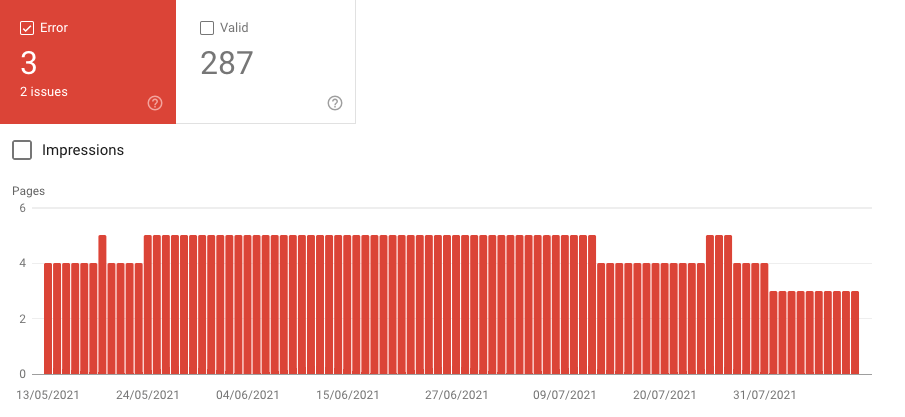

Jedes Mal, wenn wir interne 404-Fehler in der Live-Site-Struktur entdecken, d. h. in unserem aktuellen Crawl, sollte ihre Korrektur unsere Priorität sein. Solche Fehler bedeuten, dass unsere Website Links zu Seiten enthält, die nicht mehr existieren, was sowohl für Benutzer als auch für Bots unerwünscht ist. In den meisten Fällen ist das Crawlen jedoch sauber, aber GSC zeigt Tonnen von 404.

Im Allgemeinen deutet dies auf eines der oben aufgeführten Probleme hin: Fehler in der Websitestruktur, eine fehlerhafte XML-Sitemap, die auf nicht vorhandene Seiten verweist, oder Echos einer misslungenen Migration mit falschen Weiterleitungen.

Leider werden diese Fehler manchmal langsam von Google indiziert. Wenn sie jedoch relativ frisch sind, sollten wir die Situation untersuchen, um zu sehen, warum sie auftreten. Wenn ein neuer Crawl der Website sauber ist, müssen wir entscheiden, wie wir die in GSC erkannten Fehler am besten beheben können. Normalerweise besteht die optimale Lösung darin, Besucher auf die thematisch nächste Entsprechung des problematischen Inhalts umzuleiten.

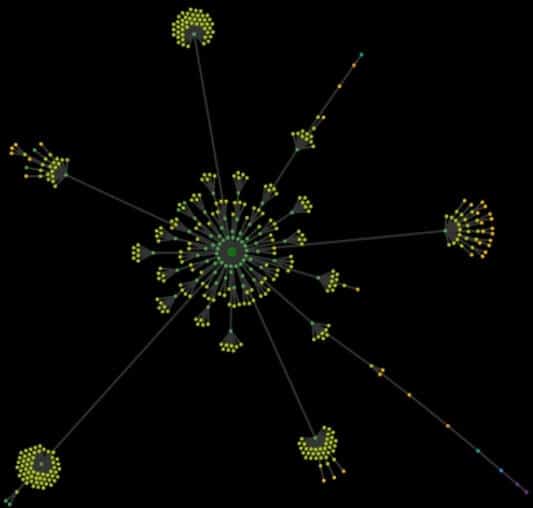

Analyse der Website-Architektur

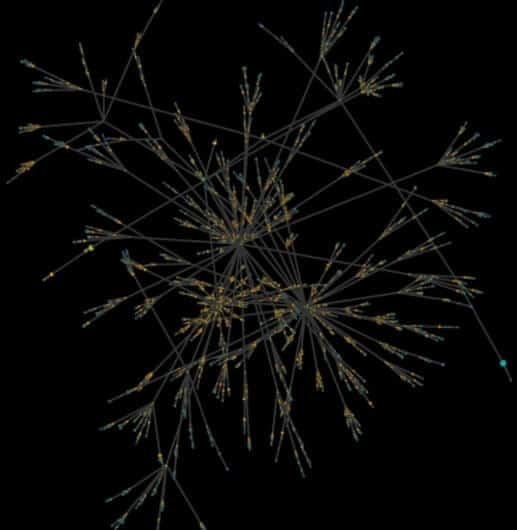

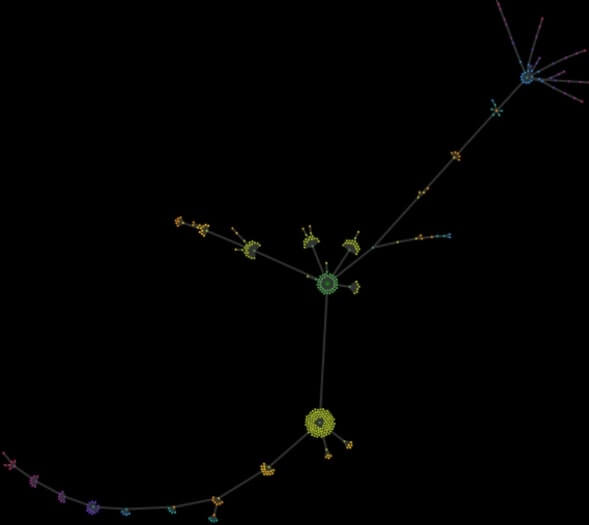

Ohne die Möglichkeit, das tatsächliche Aussehen der Website zu visualisieren, haben Sie nur ein kryptisches Excel mit Tausenden von URLs. Die Analyse der Seitenarchitektur (die sogenannte Crawl Map) lässt Sie Fehler und Engpässe in der Seitenstruktur sofort erkennen.

Im Allgemeinen ist eine Crawl Map eine Visualisierung aller auf der Website gefundenen URLs, beginnend mit der Homepage. Das Prinzip ist einfach: Wenn Sie auf den ersten Blick perfekte Ordnung und harmonische „Blumen“ der Struktur ohne Engstellen sehen, ist die Sache nicht schlecht. Je chaotischer die Karte ist, desto mehr müssen Sie über die Wurzeln der Probleme nachdenken.

Das Bild unten zeigt eine Crawlmap einer Content-Website. SEO-technisch war der Aufbau von Anfang an richtig geplant, ein SEO-Spezialist begleitete den gesamten Prozess. Auf den ersten Blick sehen Sie Ordnung, Harmonie, klar gegliederte Bereiche und Kategorien sowie die richtige Verlinkung.

Das Bild unten zeigt eine Crawl-Map einer Content-Website, die über Jahre hinweg entwickelt wurde. Ohne viel Nachdenken wurden neue Abschnitte hinzugefügt und erweitert. Irgendwann bat der Kunde um Hilfe und sagte, dass er sich auf seiner eigenen Website verirrt. Die Karte offenbarte ein totales Chaos, sodass die Struktur von Grund auf neu geplant werden musste.

Als Extra füge ich eine Crawl-Karte einer kleinen lokalen Seite hinzu, die aus mehreren Angebotsseiten und einem Dutzend Nachrichtenartikeln besteht. Die beiden seltsamen und überraschenden „Schwänze“ sind das Produkt von Kalendererweiterungen, die neue redundante, aber indexierbare Seiten mit einer Crawling-Tiefe von bis zu über 50 Klicks von der Startseite generierten.

Faktoren vor Ort

Meta-Titel

Nutzen Sie es zu Ihrem Vorteil und bereichern Sie Ihre Seitentitel mit strategiekonformen Keywords. Außerdem wirken sich Seitentitel auf die Klickbarkeit der Website in den Suchergebnissen aus.

Die häufigsten Fehler in Bezug auf Titel sind:

- Erstellen von Titeln, die nicht auf Keyword-Recherche und der Strategie der organischen Sichtbarkeit basieren,

- das Fehlen eines globalen Titelschemas, zum Beispiel: [eine für die Seite eindeutige Komponente] – [eine reguläre Komponente/Name/Marke],

- doppelte Titel innerhalb der Website – oft ein Hinweis auf doppelte Inhalte.

Wir sagen oft, dass Titel etwa 65-75 Zeichen lang sein sollten (abhängig von der Buchstabenbreite). In der Praxis ist es jedoch wichtiger, ob sie unsere zielgerichteten Keywords enthalten.

Meta-Beschreibung

Der Inhalt von Meta-Description-Tags unterliegt keiner Auswertung durch den Algorithmus. Dennoch verbessert die richtige Konstruktion das Erscheinungsbild der Website in den Suchergebnissen, was zu einer besseren Anklickbarkeit des Eintrags führt.

Die häufigsten Fehler in Bezug auf die Meta-Beschreibung sind:

- das Fehlen einer Meta-Beschreibung,

- doppelte Beschreibungen innerhalb der Website (was auf doppelte Inhalte wie doppelte Titel hinweisen kann),

- Überlänge der Beschreibungen.

Idealerweise sollte jede Seite, die Suchmaschinen-Traffic generieren soll, eine eigene Meta-Beschreibung mit einem Call-to-Action haben. Dies erweist sich jedoch oft als unrealistisch. In vielen Fällen, wie z. B. Online-Shops, können wir einzigartige Meta-Beschreibungen für Kernseiten und Kategorien erstellen, während wir für Produktseiten Meta-Beschreibungen aus einer mit Produktfunktionen gefüllten Vorlage generieren.

Hx-Header-Hierarchie

Wir alle haben ein Gefühl dafür, wie eine richtige Header-Hierarchie aussieht. Bei SEO-Audits begegnen wir jedoch routinemäßig H1-Headern mit einem Logo.

Die Auswirkungen von Hx-Headern auf die Ränge sind sehr umstritten, insbesondere in der HTML5-Ära. Ihre Verwendung ist jedoch immer noch Standard in der Welt der SEO.

Dementsprechend sollten Sie nur einen H1-Header pro Seite haben. Es sollte den Haupttitel sowie wichtige Keywords enthalten.

Die Anzahl der anderen Header spielt keine Rolle, solange Sie sich an die Prinzipien der Priorität und Verschachtelung (H3 in H2) usw. halten.

Während SEO-Audits fallen Header-Probleme normalerweise ganz nach unten in die Prioritätenliste.

JavaScript

In den meisten Fällen ist die Verwendung von JavaScript natürlich und beeinträchtigt nicht die Indexierung oder das Rendering, was die Stärke von Google ist. In einem kleinen Prozentsatz der Fälle verursacht es jedoch Fehler, die für die Sichtbarkeit der Website kritisch sind.

In der Regel müssen Sie nur prüfen, ob die Website eine zusätzliche Aktion (normalerweise einen Klick) erfordert, um zusätzliche, durch JavaScript generierte Inhalte anzuzeigen. Wenn dies der Fall ist, führt der GoogleBot diese Aktion wahrscheinlich nicht aus.

Eine einfache und effektive Methode, um dies zu überprüfen, besteht darin, zwei Crawls nacheinander mit Ihrem bevorzugten Tool auszuführen. Der erste Crawl sollte nur HTML mit ausgeschalteter Chrome-Engine analysieren. Der andere sollte JavaScript enthalten, wenn die Chrome-Engine eingeschaltet ist.

Ein Vergleich zwischen zwei Crawls zeigt Unterschiede in der Struktur, der Verlinkung und dem Inhalt beider Versionen. Die Unterschiede an sich sind kein Problem – wenn das Tool mit eingeschaltetem Rendering die Website crawlen kann, wird Google das vermutlich auch hinbekommen.

Darüber hinaus ist es eine gute Idee, durch die Kernseiten der Website zu klicken und in Chrome DevTools zu beobachten, welche zusätzlichen Ressourcen geladen werden, falls vorhanden. Konzentrieren Sie sich auf Schlüsselelemente wie Menü, interne Verlinkung und Inhaltsimplementierung.

Strukturierte Daten / Rich Snippets

Auf den meisten Websites werden strukturierte Daten automatisch verwendet, was ein Plus ist. Sie können jedoch immer noch Probleme verursachen, die unten beschrieben werden:

- Der Mangel an strukturierten Daten.

- Die Verwendung von Formaten auf das Nötigste reduziert (ein häufiges Szenario). Die meisten Formate bieten erforderliche und optionale Inhaltsfelder zum Ausfüllen. E-Commerce-Systeme begrenzen die im Produktformat enthaltenen Daten jedoch häufig auf die erforderlichen Informationen.

- Das Versäumnis, die Breadcrumbs-Navigation zu taggen – ein einfaches und nützliches Tool, das das Erscheinungsbild Ihres Eintrags in den Suchergebnissen verbessern kann.

- Eingeschränkte Nutzung strukturierter Daten. Derzeit bietet Google eine Galerie mit 31 unterstützten Formaten an – darunter Logos, lokale Formate, Artikel – die auf unzählige Arten verwendet und kombiniert werden können.

Faktoren der Benutzererfahrung

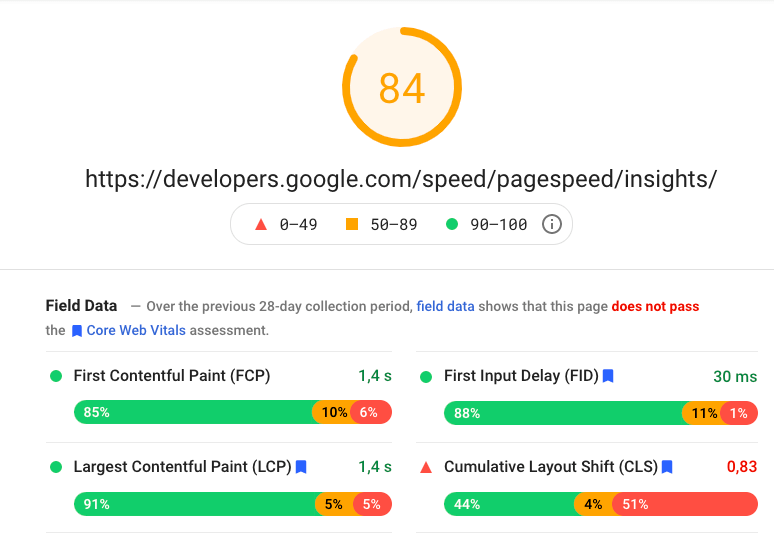

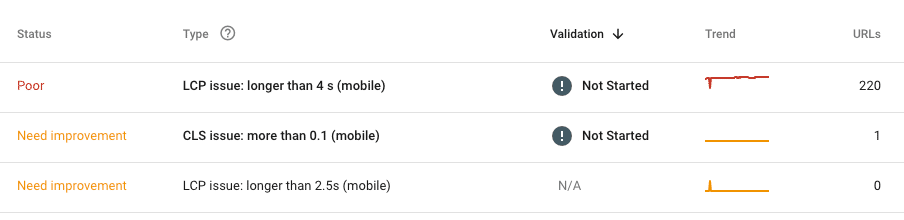

Seitenladegeschwindigkeit

Es ist nicht zu leugnen, dass die Ladegeschwindigkeit von Seiten wichtig ist. Es genügt zu sagen, dass Google selbst nicht mehr nur von Geschwindigkeit spricht und sie durch „Core Web Vitals“ ersetzt, die 2021 in den Kernalgorithmus aufgenommen werden sollen.

Derzeit sind die wichtigsten zu berücksichtigenden Parameter:

LCP – Largest Contentful Paint – Bewertung der Ladegeschwindigkeit von Hauptinhalten,

FID – First Input Delay – Bewertung der Reaktionsgeschwindigkeit der Website auf Benutzeraktionen,

CLS – Cumulative Layout Shift – Bewertung plötzlicher Änderungen im Site-Layout beim Laden.

Unser Toolkit umfasst hauptsächlich Google-Produkte: Daten von GSC und PageSpeed Insights. Beide sind unvollkommen, sie müssen uns als Hauptanalysequelle dienen, um sie bei Bedarf mit einem ausgewählten Tool zu ergänzen.

Wichtig!

Bewerten Sie niemals die Geschwindigkeit einer Website nur anhand der Homepage. Es ist das Schlimmste, was man in ein Audit aufnehmen kann. Gehen Sie so vor, wie Sie es von anderen Analysen kennen – unterteilen Sie die Website in ähnliche Abschnitte und gehen Sie davon aus, dass die erkannten Fehler auf der gesamten Website erneut auftreten.

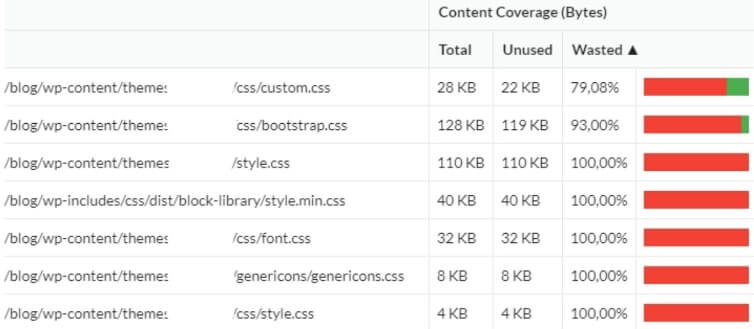

Was ist jetzt das größte Problem mit der Website-Geschwindigkeit? In der Entwicklungsphase steht die schnellstmögliche Bereitstellung der Website im Vordergrund, nicht die Geschwindigkeitsoptimierung. Folglich greifen Entwickler oft (ohne viel Vorbedacht) auf vorgefertigte Frameworks zurück. Infolgedessen erhält der Eigentümer Dutzende von redundanten Dateien, die niemals verwendet werden. Vervollständigen Sie deshalb Ihr SEO-Audit mit einer Analyse der tatsächlichen Code-Nutzung während des Renderns. Oft stellt sich heraus, dass sogar 3/4 des Codes ungenutzt bleiben

Mobile Optimierung

In der heutigen Zeit prüfen wir selten Websites, die überhaupt nicht reagieren. Die meisten Websites sind vollständig für mobile Geräte angepasst – was nicht unbedingt die Anwendung der Mobile-First-Philosophie impliziert.

In den letzten 2 Jahren ist mir keine Website begegnet, die von Anfang bis Ende nicht reagiert hätte. Der Teufel steckt jedoch im Detail (genau wie bei geschwindigkeitsbezogenen Fehlern), achten Sie also auf einzelne Fehler wie die Seiten, auf denen GSC oder Crawler Probleme mit der mobilen Optimierung erkennen. In den meisten Fällen resultieren sie aus menschlichen Fehlern (wiederum genau wie geschwindigkeitsbedingte Fehler) oder aus dem Versuch, neue Funktionen, die nicht im ursprünglichen Plan enthalten waren, beiläufig in die Hauptwebsite und das CMS zu werfen.

Inhaltsanalyse

Website-Content umfasst im SEO alle Inhalte außerhalb des Boilerplate-Bereichs, also der festen Bestandteile des Quellcodes.

Vervielfältigung

In den meisten Fällen ist interner Duplicate Content das Produkt von:

Fehler im Website-Design (Funktionen und Struktur)

Beispiel:

Ein Finanzinstitut bot Dienstleistungen für Einzelkunden, Unternehmer und große Unternehmen an. Navigation basierend auf der Art des Angebots, an dem der Kunde interessiert war. Nach der Auswahl wurden die Benutzer zu einem von drei speziellen Abschnitten weitergeleitet:

https://domain.pl/individual-clients/

https://domain.pl/unternehmer/

https://domain.pl/business/

Der Kunde konnte das dedizierte Angebot durchsuchen, aber der erste Teil der URL blieb unverändert. Leider überschnitten sich die Inhalte aller drei Angebote zu 90%. So schuf die Website 3 nahezu austauschbare Strukturen mit gleichem Inhalt. Dies ist einer der Fehler, die durch den Mangel an SEO-Unterstützung in der Designphase verursacht werden. Aufgrund interner Vorschriften des Kunden war das Problem praktisch nicht zu beheben. Die einzige Lösung bestand darin, ein Jahr nach dem Audit eine neue Website zu starten.

Menschliche Fehler oder Entwicklungsfehler

Beispiel:

Ein Client hatte den gleichen Inhalt in der Fußzeile und im Hauptmenü. Die Lösung, die im Allgemeinen kein Problem darstellen sollte, verursachte ziemlichen Ärger. Die Website umfasste etwa 20 Seiten, aber ein einfacher Fehler bei der internen Verlinkung führte dazu, dass die Fußzeile die Website ins Unendliche multiplizierte. Jeder Link im Footer erzeugt eine zusätzliche Komponente in der URL des Footers. Als Ergebnis erhielt der Kunde Adressen wie:

https://domain.pl/history/ history/history/contact/rules/history/contact/contact/

Art der Website

Beispiel:

Leider ist die Duplizierung interner (und externer) Inhalte auf E-Commerce-Websites Routine. Stellen Sie sich dazu ein Geschäft vor, das ähnliche Produkte in mehreren Varianten anbietet. Zum Beispiel Smartphones in fünf Farben oder Kleidung in mehreren Größen.

Wir wollen die Indexierung nicht blockieren oder rel=canonical für verschiedene Varianten verwenden, um weiterhin Traffic aus dem Long Tail zu gewinnen. Dies hinterlässt uns jedoch doppelte Inhalte oder Beinahe-Duplikate.

Idealerweise sollten wir erwägen, für jedes Produkt eindeutige Beschreibungen zu schreiben. Bei vielen SKUs und hoher Produktrotation hilft jedoch nur die automatische Generierung unterschiedlicher Produktbeschreibungen auf Basis einzigartiger Produktmerkmale und deren Kombinationen.

Mehrere URL-Versionen und SSL-Implementierung

Die Analyse interner Duplizierungsprobleme beruhte jahrelang darauf, Homepage-Redirects auf die Versionen mit (ohne) www und ohne https zu prüfen. Heutzutage ist es ein seltenes Problem. Außerdem hat Google gelernt, damit sehr effizient umzugehen.

Die häufigsten Fehler im Zusammenhang mit SSL:

- Auf Websites mit fest codierten Menü-Links können die „http“-Links an einigen Stellen auf der Website neben dem neuen „https“ verbleiben. Als Ergebnis erhalten wir eine neue Ebene von Weiterleitungen innerhalb der Website.

- Die Migration zu SSL umfasst möglicherweise nicht alle Ressourcen. Daher können Elemente wie Grafiken oder Skripte immer noch von der „http“-Version geladen werden.

Interne Verlinkung

Die interne Verlinkung wirkt sich auf das Crawling, die Indexierung und die Sichtbarkeit jeder Seite aus, da Links ihren Zielorten interne Macht/Autorität verleihen. Die Analyse der internen Verlinkung besteht aus einer Reihe separater Prüfungen in Bezug auf:

Permanente Navigationselemente: Hauptnavigationsmenü, Fußzeile, Seitenleiste

Die permanente Verlinkung, insbesondere der Hauptnavigation, sollte zusammen mit der Keyword-Nutzungsstrategie geplant werden. Bei der Erstellung von Hauptlinks ist Einfachheit der Schlüssel – denken Sie nicht zu viel nach, denn ein sauberer HTML-Code funktioniert immer am besten.

Wenn wir unsere Strategie mit der Realität vergleichen und feststellen, dass das Hauptmenü alle notwendigen Elemente enthält, lassen Sie uns nach dauerhaften, aber redundanten internen Links auf der gesamten Website suchen. Sie können sie oft in der Fußzeile erkennen, dem üblichen Container für so ziemlich alles. Der Aufwand lohnt sich, denn jede neue redundante Verbindung stört den internen Stromfluss.

Einige Links und Seiten, wie Regeln und Vorschriften oder Datenschutzbestimmungen, sind ein Muss. Andere sind jedoch wegwerfbar. Sind Sie sich beispielsweise sicher, dass jede Versandart einen eigenen Link in der Fußzeile benötigt, der auf eine eigene Seite führt? Sie passen alle auf einen. Lassen Sie uns neben den erforderlichen Links unsere internen Links organisieren, um redundante Links zu Seiten zu vermeiden, die für unsere Schlüsselphrasen nicht ranken.

Automatische Verlinkung – vorgeschlagene Beiträge/Produkte

Automatisches Verlinken bedeutet, auf vorgeschlagene Posts (auf Blogs) oder vorgeschlagene Produkte (auf E-Commerce-Websites) zu verlinken. Wenn diese Mechanismen von vorgefertigten Lösungen verwaltet werden, die in das CMS (WordPress) eingebettet sind, sollte im Allgemeinen alles reibungslos funktionieren. Wenn die Links in sauberem HTML generiert werden, das Teil des Quellcodes ist, brauchen wir vielleicht nur ein wenig Optimierung. Leider verwenden diese Funktionen oft dynamische Lösungen auf Basis von JavaScript (Case Onely+H&M) oder, noch schlimmer, die Lösungen externer Unternehmen, die als Skripte aus anderen Domänen eingebunden werden.

Individuelle Verlinkung zwischen Seiten, die hauptsächlich in Inhaltsbereichen verwendet werden

Die kontextbezogene Verlinkung über Artikel hinweg unterstützt das Wachstum der Sichtbarkeit von Inhaltsabschnitten. Dennoch wird es oft übersehen. Folglich sind die einzigen Links, die auf die Artikel verweisen, die von den Kategorieseiten.

Eine kontextbezogene Verknüpfungsanalyse ist relativ einfach. Alles, was Sie tun müssen, ist, Crawl-Daten zur internen Verlinkung mit Informationen zum aktuellen organischen Traffic (GSC/Analytics) zu mischen. Außerdem können Sie Daten zu den externen eingehenden Links hinzufügen, um festzustellen, welche Artikel die größte Autorität haben. Fügen Sie Daten zur Sichtbarkeit von Seed-Keywords (Senuto) hinzu, um zu sehen, welche Bereiche Ihre Aufmerksamkeit erfordern und wie Sie sie beheben können.

Externe Verlinkung

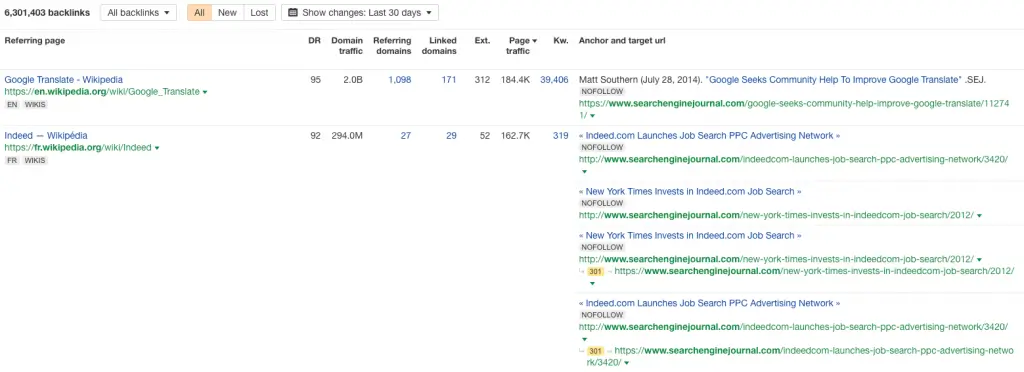

Linkprofilanalyse

Glücklicherweise werden schlechte Linkprofile immer seltener, obwohl Sie immer noch auf Links stoßen können, die mit GSA, Xrummer oder einem anderen automatischen Generator erstellt wurden.

In den allermeisten Fällen handelt es sich bei trashigen Links um:

- das Andenken an SEO-Bemühungen von Spezialisten vor ein paar Jahren

- das Signal, dass die Seite gehackt wurde, um SPAM hochzuladen, der dann vom Hacker verlinkt wurde

- das Produkt von Scrapern und SPAM-Generatoren, die Website-Inhalte herunterladen.

Wenden Sie bei der Überprüfung des Linkprofils die universelle goldene Regel an – konzentrieren Sie sich auf Anomalien.

Es ist am einfachsten, sie in Backlink-Wachstumsdiagrammen zu erkennen. Alle plötzlichen Spitzen und Einbrüche müssen analysiert werden.

Deep-Linking-Verteilung

Die SEO-Analyse der Linkverteilung auf der Homepage und anderen Seiten der Website dient dazu, die Qualität der sogenannten Deep-Linkings zu beurteilen und so die Bereiche oder Seiten mit der höchsten externen Autorität zu lokalisieren. So erfahren wir, ob unsere Linkverteilung gleichmäßig ist und welche Seiten wichtige Knotenpunkte in der Struktur sein könnten und als Kraftverteiler für die interne Verlinkung dienen.

Ausgehende Links

Ein häufig vernachlässigter Punkt ist die Analyse der ausgehenden Links der Website. Wenn Sie eine Website anhand von Inhalten oder benutzergenerierten Inhalten untersuchen, enthält sie sicherlich mehrere Dutzend Links zu externen Domänen. Im Laufe der Jahre verfallen viele von ihnen, wechseln den Besitzer oder gehen auf schädliche Websites. Wiederholen Sie Ihre Outbound-Link-Analyse – mit einem Crawler oder einem externen Tool – mindestens einmal im Jahr.

Kaputte & verlorene Backlinks

Kaputte Backlinks sind Ihre eingehenden Links, die auf die 404-Fehlerseite verweisen und von Google ignoriert werden. Wenn Ihre Website wächst, erscheinen fehlerhafte Backlinks ganz natürlich – Seiten ändern den Standort, einige werden gelöscht und Menschen machen Fehler beim Verlinken unserer Inhalte. Defekte Backlinks sind auch eine Standardfolge von misslungenen Migrationen, bei denen die Entwickler die Weiterleitungen vergessen haben und die Website nicht nur ihre Struktur geändert hat, sondern auch alle Links außer der Homepage innerhalb eines Tages verloren hat.

Alle verlorenen Backlinks sollten zusammengefasst und auf die thematisch verwandte Seite umgeleitet werden. Als letzten Ausweg können wir sie an eine andere Stelle auf der Website oder der Homepage weiterleiten. Nur so können sie die Autorität zurückfordern, die sie für unsere Domain erlangt haben. Wenn Sie schon dabei sind, überprüfen Sie die verlinkenden Domains – leiten Sie nach Möglichkeit nur qualitativ hochwertige Links um und lassen Sie den Spam auf 404 verweisen.