BERT: Google のここ数年で最大のアップデート

公開: 2022-12-01Google の BERT は 2019 年後半に公開され、すべての検索のほぼ 10% に影響を与えました。 間違いなく 2019 年最大のアルゴリズム アップデートの 1 つです。Google の高度な自然言語処理モデルについて、SEO 担当者とサイト所有者が知っておくべきことはすべてここにあります。

Google の BERT とは何ですか?

BERT は深層学習アルゴリズムであり、トランスフォーマーからの双方向エンコーダー表現の略です。 このアルゴリズムは、複雑な検索クエリに対してより関連性の高い結果を表示するのに役立ちました。

BERT アルゴリズムの更新は Google 検索にどのような影響を与えましたか?

これはGoogleが言ったことです:

「これらの改善は、特により自然な言語/会話のクエリに対する言語理解の向上を目的としています。BERT は、検索が検索内の単語のニュアンスと文脈をよりよく理解し、それらのクエリをより適切な結果と一致させるのに役立つためです。

特に、より長く、より会話的なクエリ、または「for」や「to」などの前置詞が意味に大きく関係する検索の場合、検索はクエリ内の単語のコンテキストを理解できます。 自分にとって自然な方法で検索できます。」

実際、Google によると、BERT の更新は、米国の英語検索の 10 分の 1 に影響を与えます。これは、検索クエリの 10% に相当します。 これは、少なくとも Google によると、過去 5 年間で最も重要な更新です。

過去 5 年間で最大の飛躍であり、検索の歴史の中で最大の飛躍の 1 つである、クエリを理解する方法を大幅に改善しています。

BERT の導入により、新しいアルゴリズムの展開の最初の週にランキングが大きく変動しました。 Webmaster World の SEO 担当者は、週の初めから変動についてコメントしており、RankBrain 以来、SEO の世界を襲った最大のランキング変動に注目しています。

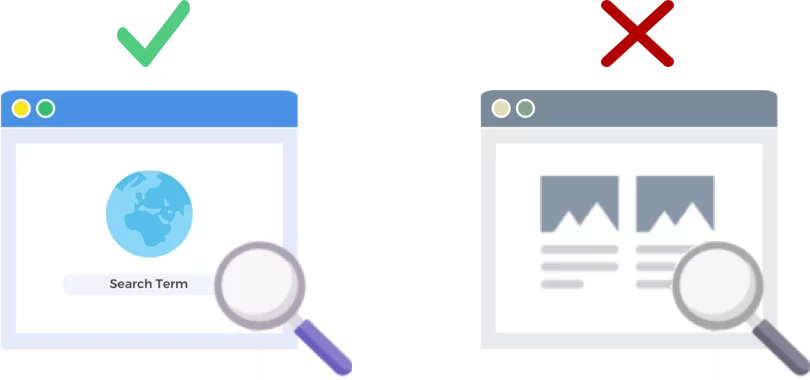

BERT は Web ページではなく検索クエリを分析します

BERT アルゴリズムの 2019 年 10 月 24 日のリリースでは、検索エンジンの巨人が (Web ページではなく) 検索クエリを分析および理解する方法が改善されています。

BERT はどのように機能しますか?

BERT は、双方向 (BERT の B) コンテキスト モデルを使用して、検索クエリに対する Google の理解を向上させます。 Google は、昨年の今頃、自然言語処理 (NLP) 事前トレーニングの新しい手法として BERT を発表したときに、BERT の仕組みについて少し話しました。

プレトレーニングとは? 事前トレーニングとは、実際にタスクを実行させる前に、マシンにタスクの実行方法を教えることです。 従来、トレーニング前のデータセットには、人間がラベル付けした数千から数十万のサンプルがロードされていました。

事前トレーニングはかなり前からありましたが、BERT を特別なものにしているのは、それがコンテキスト (各単語の意味はその前後の単語に基づいて変化する) と双方向の両方であることです。単語の意味は、その前と前の両方の単語に基づいて理解されます。その後。

Google のブログによると:

「銀行口座にアクセスしました」という文では、一方向のコンテキスト モデルは、「口座」ではなく「私にアクセスしました」に基づいて「銀行」を表します。 しかし、BERT は「銀行」を前と次の両方のコンテキスト (「私は …口座にアクセスしました」) の両方を使用して表現し、ディープ ニューラル ネットワークの最下部から開始するため、双方向性が深くなります。

Google BERT の更新は、機械学習とエンティティ認識の最近の進歩に基づいています。 基本的に、BERT は、Google が検索を処理する前に、すべての品詞と単語の文脈を識別するのに役立ちます。

検索結果に対する BERT の意味

Google によると、これは、ユーザーがより関連性の高い結果、つまりユーザーの検索の意図によりよく一致する結果を目にするようになることを意味します。 このアルゴリズムの改善は、通常の結果とリッチ スニペットの結果にまたがります。

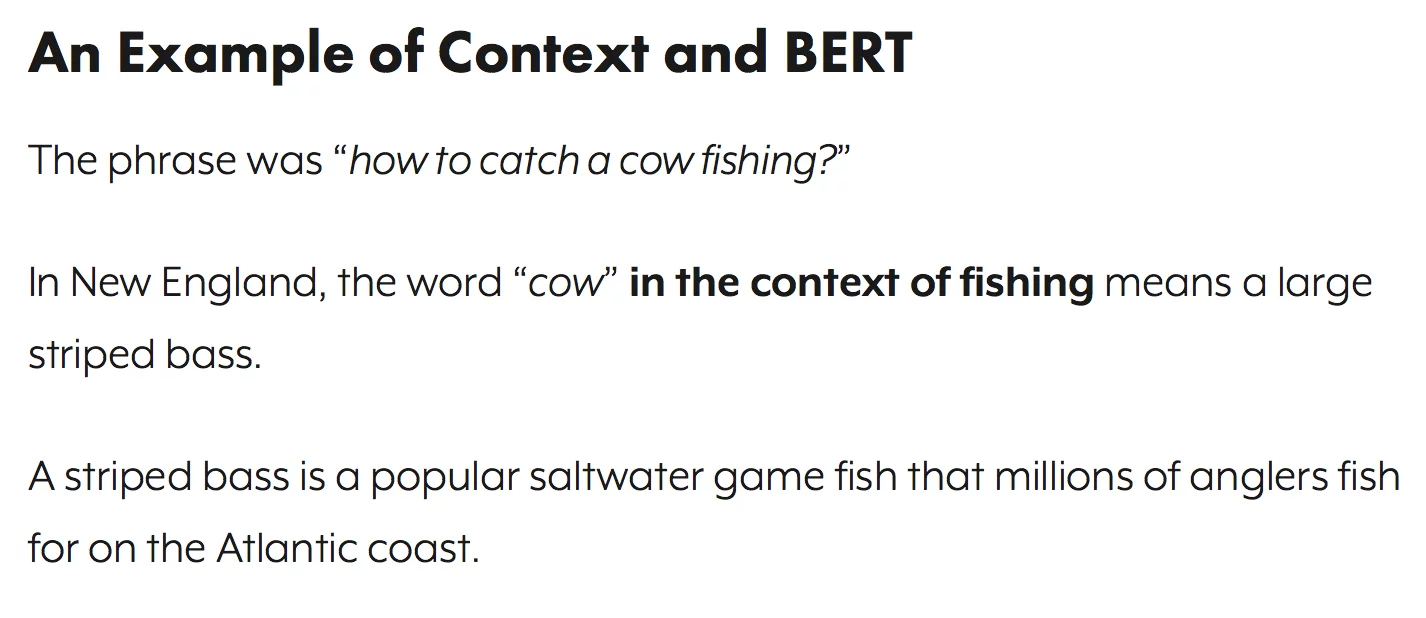

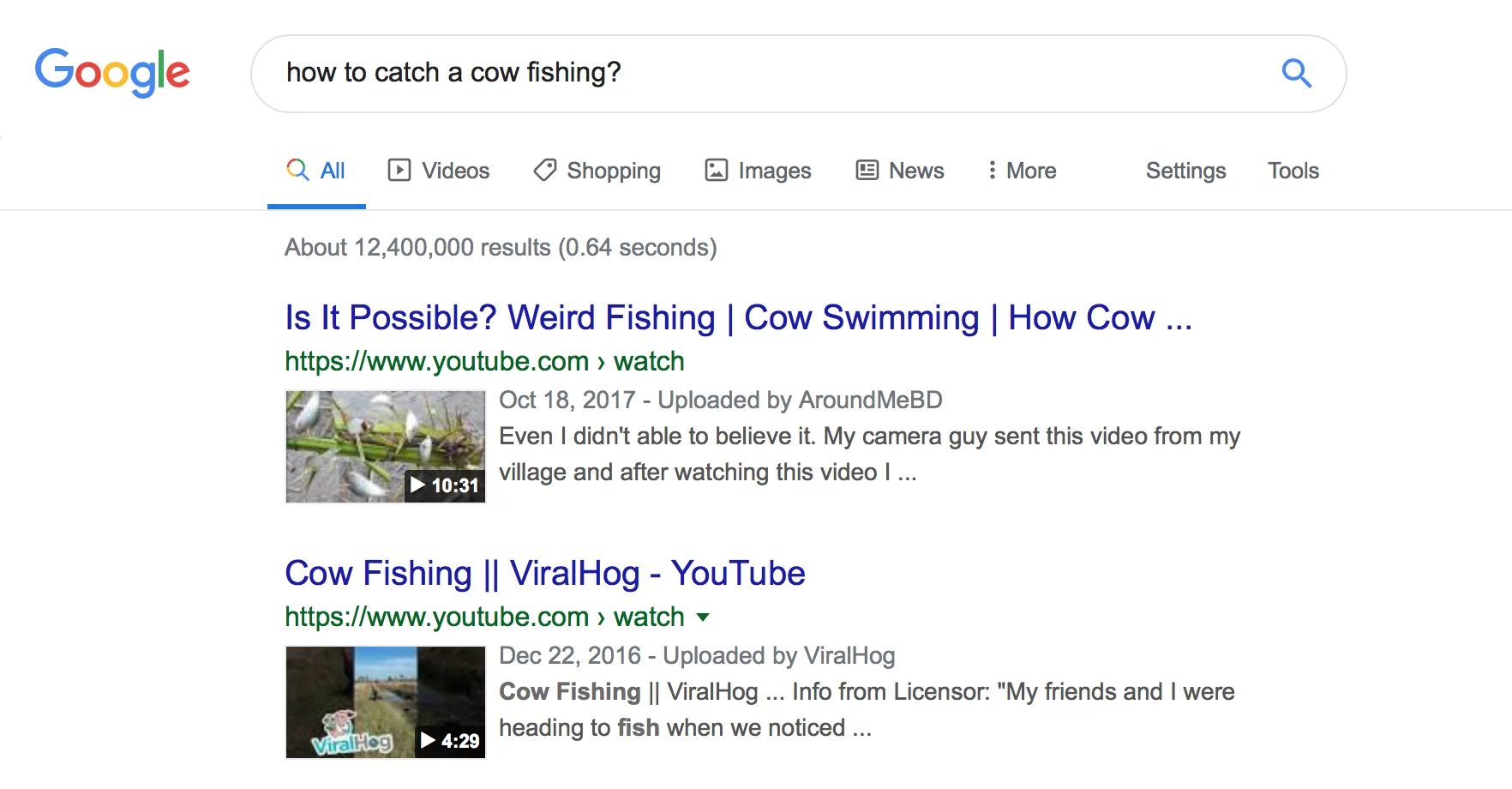

Google は、BERT を発表するブログ エントリでいくつかの役立つ例を提供しています。

エステティシャンの例

まず、エステティシャンが仕事の一環として多くの時間を足で過ごすかどうかを理解しようとしているユーザーがいます。

以下は、BERT Google が「エステティシャンは仕事で多く立っているか」というクエリを読み取り、エステティシャンの作業環境の種類を比較する結果を生成する前に示したものです。

BERT の後、Google はエステティシャンになるための身体的要求に関する記事を表示しています。これは、検索者が最初に表示しようとしていた情報とより一致しています。

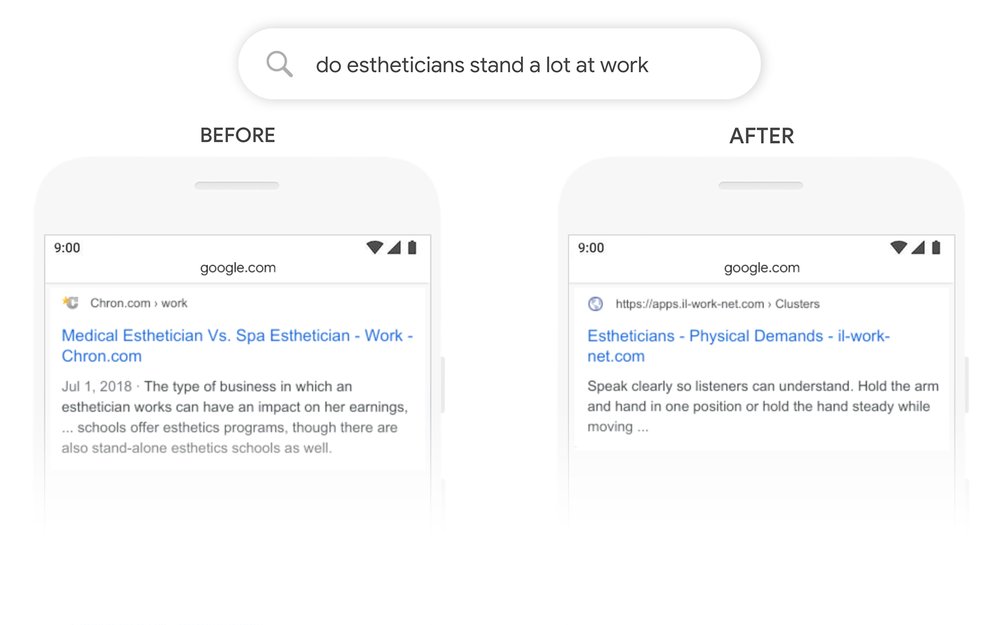

数学の練習帳の例

この例では、ユーザーは大人向けの数学の練習帳を探していますが、子供向けの数学の練習帳を表示しています。

BERT の後、Google はクエリのコンテキストを正しく認識し、「成人向け」検索の 2 番目の部分をより適切に説明します。

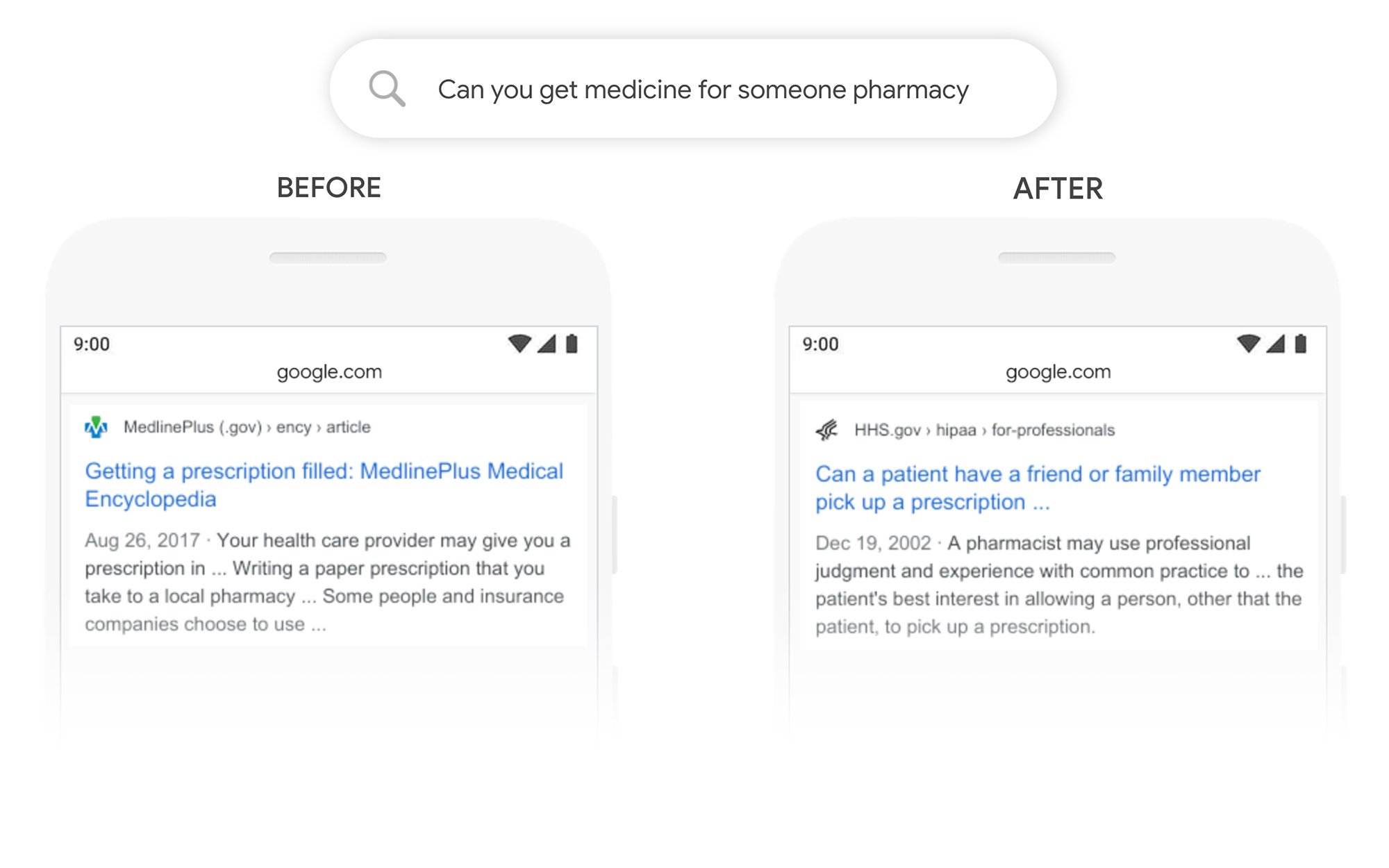

他の誰かのために薬を受け取ることはできますか? 例

この例では、「誰かの薬局で薬を入手できますか」というクエリは、サードパーティの処方箋の記入方法ではなく、一般的な処方箋の記入方法に関する結果を返します。 BERT の後、Google はユーザーの目的をよりよく理解し、患者が友人や家族に処方箋を受け取ってもらうことができるかどうかについての情報を表示します。

BERT 後にランクを上げるにはどうすればよいですか?

ランキングを失ったキーワードについては、改訂された検索結果ページを見て、Google がターゲット用語の検索意図をどのように見ているかをよりよく理解する必要があります。 次に、それに応じてコンテンツを修正して、ユーザーの目標をよりよく満たすようにします。

BERT でランキングを失った場合、コンテンツの品質の問題よりも、ページがユーザーの検索意図にどれだけ一致するか (ユーザーが目標を達成するのに役立つか) に関連する問題である可能性が高くなります。

BERT は今後音声検索の取り組みをさらにサポートする可能性が高いため、Web サイトには明確で簡潔なコピーを作成することもお勧めします。 つなぎ言葉を使わず、あいまいにせず、まっすぐに要点を述べてください。

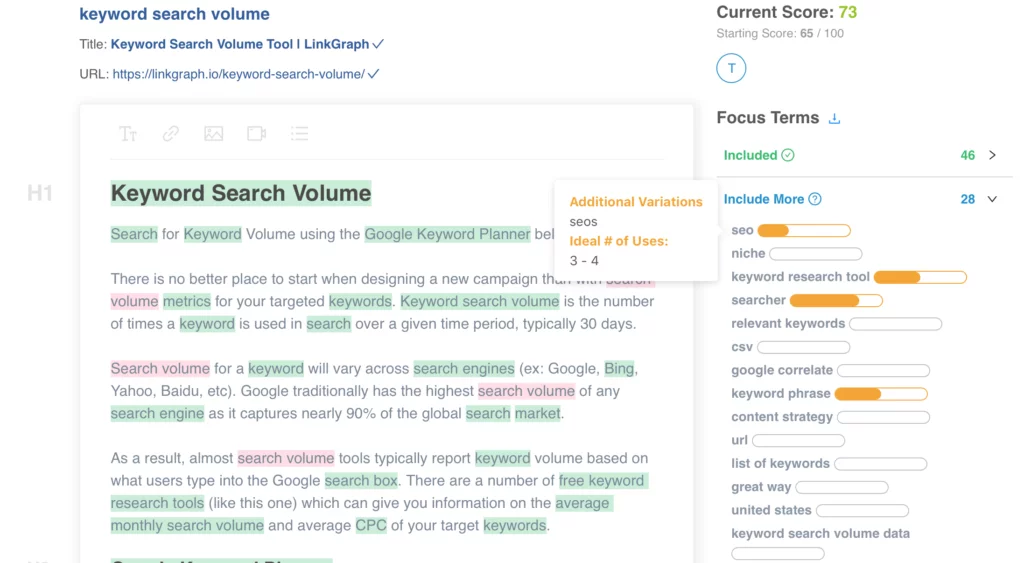

コンテンツの最適化についてサポートが必要ですか? LinkGraph のオン ページ コンテンツ オプティマイザーを確認するか、[email protected] でチームのメンバーに連絡するか、ミーティングをスケジュールして今すぐセットアップを行います。

詳細はどこで確認できますか?

Dawn Anderson は、今月初めに Pubcon で「Google BERT and Family and the Natural Language Understanding Leaderboard Race」という素晴らしいプレゼンテーションを行いました。彼女のプレゼンテーションを見ることができます。

#Pubcon をご利用いただきありがとうございます。 ここに私のデッキがあります <3 <3 https://t.co/aGYDI9pfdY

— ドーン・アンダーソン (@dawnieando) 2019 年 10 月 10 日

Jeff Dean は最近、BERT を含む Google の AI で基調講演を行いました。