クロール予算を最適化してランキングを上げる方法は?

公開: 2017-01-14目次

- 1クロール予算とは何ですか?

- 2クロール予算が重要なのはなぜですか?

- 3クロール予算はいつ問題になりますか?

- 4クロール予算を最適化する方法

- 51.サイト構造を改善する

- 62.壊れたリンクを解決する

- 73.リッチメディアコンテンツを慎重に使用する

- 84.サイトマップをクリーンアップする

- 95.外部リンクを構築する

- 106.内部リンクを整理する

- 117.フィードを利用する

- 128.リダイレクトチェーンを削除します

- 139.ページがクロール可能であることを確認する

誰もが検索エンジン最適化とは何か、よく構成されたサイトの重要性、関連するキーワード、質の高いコンテンツ、適切なタグ付け、クリーンなサイトマップ、その他の技術基準を知っています。 しかし、クロールの最適化について考えたことがない可能性があります。

クロール予算の最適化は、検索エンジン最適化よりもさらに深いレベルになります。 検索エンジン最適化はユーザーのクエリを最適化するプロセスに重点を置いていますが、クロール最適化は検索エンジンボット(Webスパイダー)がサイトにアクセスする方法に重点を置いています。

この記事では、検索エンジンがウェブサイトにクロール予算を割り当てる方法の背後にある仕組みと、ランキング、オーガニックトラフィック、そして最も重要なインデックス作成を最大化するためにクロール予算を最大限に活用するためのヒントについて説明します。

クロール予算とは何ですか?

クロール予算は、検索エンジンスパイダーが特定の期間にWebサイトをクロールするページ数です。 クロールバジェットは通常、サイトのサイズと状態、およびサイトを指すリンクの数によって決まります。

クロール予算は重要なSEO要因であり、十分な注意が払われていないことがよくあります。 検索エンジンはスパイダーボットを使用してWebページをクロールし、情報を収集してインデックスに追加します。 さらに、アクセスしたページのリンクを指摘し、それらの新しいページもクロールしようとします。

たとえば、Googlebotは、新しいページを検出してGoogleインデックスに追加するWebスパイダーです。 ほとんどのWebサービスとSEOツールは、これらのWebスパイダーを信頼して有用な情報を収集します。

クロール予算が重要なのはなぜですか?

Webサイトのクロール可能性は、検索可能性を確保するための主要かつ重要なステップです。 クロール予算を最適化することがあなたのウェブサイトにとって重要であるかどうか疑問に思っているなら、答えはもちろんイエスです。 SEOの取り組みとクロールの最適化は、おそらく密接に関連しています。

簡単ですが、Googleがウェブサイトを見つけてインデックスに登録するのが簡単になるため、クロールの予算について心配する必要があるのは非常に論理的です。 Webサイトにクロールが多い場合は、新しいコンテンツを公開するときに更新が速くなることを意味します。 したがって、クロール予算が大きいほど、これはより速く発生します。

これは、Webサイトの全体的なユーザーエクスペリエンスを向上させるのにも役立ち、可視性が向上し、最終的にはSERPランキングが向上します。 事実、最近クロールされたページはSERPでより多くの可視性を獲得し、ページがしばらくクロールされていない場合、ランクが上がらないということです。

クロール予算はいつ問題になりますか?

クロール予算がしばしば問題を引き起こすわけではありません。 WebサイトのURLに比例クロールを割り当てている場合、それは問題ではありません。 しかし、たとえば、ウェブサイトに200,000のURLがあり、Googleがサイトで1日に2,000ページしかクロールしない場合、GoogleがURLを識別または更新するのに100日かかる可能性があります。これが問題です。

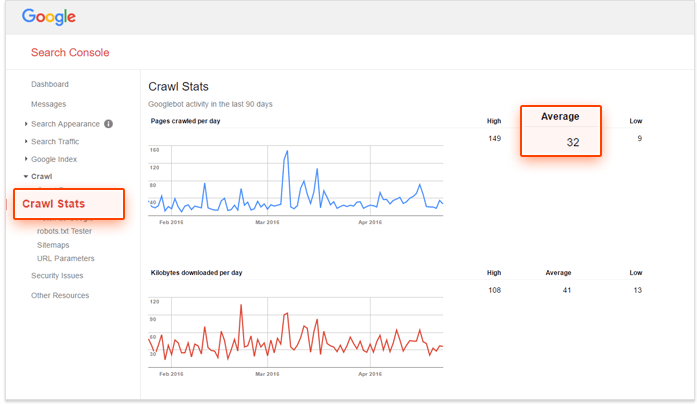

解決策を探していて、クロール予算を最適化する必要があるかどうかを確認したい場合は、Google検索コンソールとサイトのURLの数を使用して、Webサイトの「クロール数」を計算します。 これを行う方法?

–まず、Webサイトに何ページあるかを評価する必要があります。これは、次のサイトを実行することで実行できます。Googleで検索、

–次に、Google検索コンソールアカウントに移動し、[クロール]、[クロール統計]の順に移動します。 アカウントが適切に構成されていない場合、このデータは取得されません。

– 3番目のステップは、サイトの総ページ数を、Webサイトで1日にクロールされた平均ページ数で割ることです。

この数が10より大きい場合は、クロールバジェットの最適化を検討する必要があります。 5未満の場合は、ブラボー! さらに読む必要はありません。

クロール予算を最適化する方法

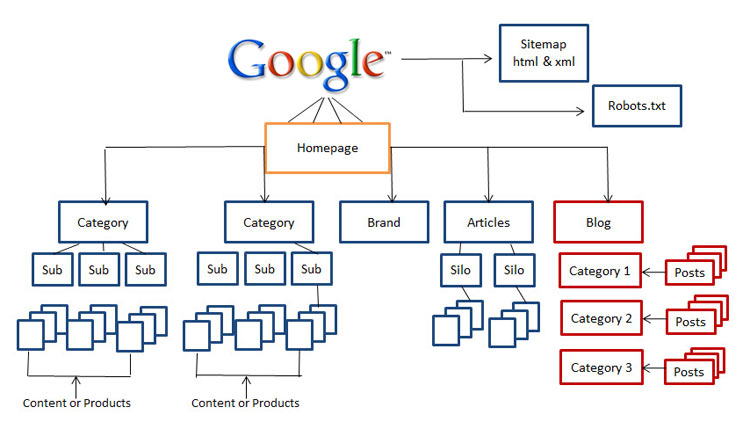

1.サイト構造を改善する

今日、サイト構造の重要性は重要な要素です。 Rand FishkinのようなSEOマスターは、Webサイトのユーザーが訪問中にホームページから3クリック以内に離れていることを確認するようアドバイスしています。 あなたの訪問者があなたのウェブサイトを深く掘り下げる可能性が低いので、それは使いやすさの点でSEOにとって本当に素晴らしいアドバイスです。

したがって、クリーンでナビゲートしやすく、検索エンジンに適したWebサイトがない場合は、今度はWebサイトの再構築を開始します。

2.壊れたリンクを解決する

これは、検索エンジン最適化とクロール最適化の基本的な違いの1つです。壊れたリンクはランキングを下げるのに重要な役割を果たすだけでなく、Googlebotがウェブサイトのインデックスを作成してランク付けする機能を大幅に妨げます。

Googleのアルゴリズムはここ数年で大幅に改善されており、ユーザーエクスペリエンスに影響を与えるものはすべてSERPに影響を与える可能性があります。 Googleは常にユーザーの行動をコピーし、アルゴリズムを更新しようとしてきました。 したがって、検索エンジン用にWebサイトを最適化するときは、常にユーザーエクスペリエンスを考慮する必要があります。

3.リッチメディアコンテンツを慎重に使用する

現在、GoogleはSilverlightとその他の一部のファイルのみをクロールするのに苦労していますが、Flash、JavaScript、HTMLなどのリッチメディアコンテンツをクロールできない場合がありました。

ただし、Googleはほとんどのリッチメディアファイルを読み取ることができますが、他の検索エンジンでは読み取れない場合があります。 これは、これらのファイルを賢く使用する必要があることを意味し、ランク付けしたいページでそれらを完全に避けたい場合があります。

4.サイトマップをクリーンアップします

ブロックされたページ、非正規ページ、不要なリダイレクト、400レベルのページなど、Webサイトのユーザビリティを損なう可能性のある混乱から保護するために、サイトマップをクリーンアップして最新の状態に保つように努めてください。 XMLサイトマップを使用することは、スパイダーボットだけでなくユーザーを支援するための最良の方法です。

サイトマップをクリーンアップするためのさまざまなツールが市場に出回っています。 XMLサイトマップジェネレータを使用して、インデックス作成からブロックされたすべてのページを除外するクリーンなサイトマップを作成し、301および302リダイレクトや非正規ページなどを検索して修正できます。

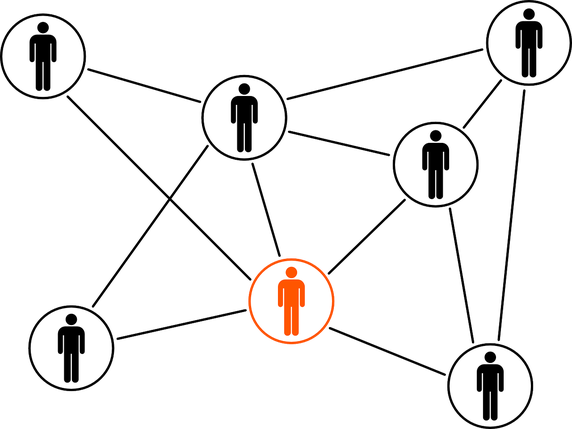

5.外部リンクを構築する

リンクビルディングは常にホットな話題であり、近い将来になくなることはありません。 新しいコミュニティを発見し、オンラインで関係を確立し、ブランド価値を構築することは、リンク構築プロセスですでに持っているはずの特典の一部です。

ベストプラクティスを通じて行われる場合、外部リンクは、外部ドメインを指すリンクであり、より高いランキングを取得するための最も重要なソースです。 外部リンクは操作が最も難しい指標ですが、検索エンジンがWebページの人気と関連性を知るための優れた方法です。

6.内部リンクを整理する

内部リンクの構築はクロールバジェットの最適化とはあまり関係がありませんが、これは無視できるという意味ではありません。 適切に編成され、維持されているサイト構造により、十分なクロール予算を費やすことなく、コンテンツをユーザーやスパイダーボットに簡単に表示できます。

適切に構造化された内部リンクシステムも、ユーザーエクスペリエンスを向上させます。 ユーザーが数回クリックするだけで任意のエリアに到達できるようにし、物事に簡単にアクセスできるようにすることで、通常、訪問者がWebサイトに長く滞在できるようになり、SERPランキングが向上します。

7.フィードを利用する

RSS、Atom、XMLなどのさまざまなフィードは、ユーザーがWebサイトを閲覧していないときでも、Webサイトがコンテンツをユーザーに配信するのに役立ちます。 これは、ユーザーが最も有利なサイトにサブスクライブし、新しいコンテンツが公開されるたびに定期的に更新を取得するための最良の方法です。

長い間、RSSフィードはあなたのウェブサイトの読者とエンゲージメントを高める良い方法であることが証明されています。 その上、それらはまたグーグルのウェブスパイダーによって最も訪問されたサイトの1つです。 ウェブサイトに更新があった場合は、それをGoogleのFeed Burnerに送信して、適切にインデックスに登録されていることを確認できます。

8.リダイレクトチェーンを削除します

リダイレクト先の各URLは、クロール予算の少しを浪費します。 Webサイトに長いリダイレクトチェーンがある場合、つまり、301および302リダイレクトが連続して多数ある場合、Webスパイダーは、宛先ページに到達する前にドロップオフする可能性があり、最終的にはページのインデックスが作成されません。 リダイレクトのベストプラクティスを探している場合は、Webサイトでのリダイレクトをできるだけ少なくし、連続して2つ以下にすることをお勧めします。

9.ページがクロール可能であることを確認します

検索エンジンのスパイダーボットがあなたのウェブページを見つけ、あなたのウェブサイト内のリンクを見つけてたどることができれば、それらはクロール可能です。 そのため、robots.txtファイルと.htaccessファイルを構成して、Webサイトの重要なページをブロックしないようにする必要があります。

また、フラッシュ、シルバーライトなどのリッチメディアコンテンツ上にあるページのテキストファイルを提供する必要がある場合もあります。

robots.txtで許可しない場合のみ、ページのインデックス解除を停止することを保証できません。 許可されていないページにトラフィックを誘導し続ける着信リンクなどの外部的なものがある場合、Googleはそのページが引き続き関連していると見なす場合があります。 この場合、ページのインデックス作成を手動でブロックする必要があります。 これは、X-Robots-TagHTTPヘッダーまたはnoindexrobotsメタタグを使用して簡単に行うことができます。

noindexメタタグまたはX-Robots-Tagを使用する場合は、robots.txtのページを禁止しないでください。タグが表示されて従う前に、ページをクロールする必要があります。

結論:クロール予算の最適化は簡単な作業ではなく、確かに「迅速な勝利」ではありません。 あなたが中小規模のウェブサイトを持っていて、それがよく維持されているなら、あなたはおそらく大丈夫です。 しかし、何千ものURLを含む複雑で整理されていないサイト構造があり、サーバーログファイルが頭に浮かぶ場合は、専門家や専門家に連絡して支援を求める時期かもしれません。