/robots.txtの重要性

公開: 2020-07-27最終更新日:2020年7月27日

以前のブログで、当社のWebサイトにあるsitemap.xmlファイルの利点について説明しました。 このブログでは、Webサイトの/robots.txtファイルの重要性について説明します。

以前のブログで、当社のWebサイトにあるsitemap.xmlファイルの利点について説明しました。 このブログでは、Webサイトの/robots.txtファイルの重要性について説明します。

/Robots.Txtとは何ですか?

/robots.txtは、当社のWebサイトのWebサーバーのルートディレクトリにあるテキストファイルです。 当サイトのWebコンテンツをWebロボットに指示するために使用される重要なファイルです。 Webロボット、クローラー、またはスパイダーは、検索エンジンがWebサイトのWebコンテンツにインデックスを付けるために使用するプログラムです。 これらの与えられた指示は、ロボット排除プロトコルと呼ばれます。

/robots.txtファイルは、http://wwwmysite.com/robots.txtのようなURLを入力することでアクセスできる公開ファイルです。 ファイルの内容と、Webロボットにアクセスさせたくない場所は誰でも見ることができます。 これは、/robots.txtファイルを使用してWebサイトの重要な情報を非表示にしないことを意味します。

/robots.txtは、検索エンジンロボットがWebサイトにアクセスするときに最初に検索するものです...クリックしてツイートRobot.txtファイルの構文とコンテンツ

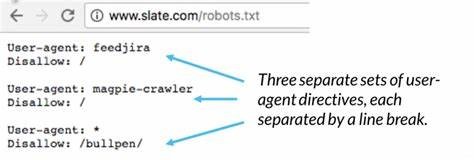

/robots.txtファイルに記載されている手順には、サイトサイトマップの場所、Webロボットにアクセスさせたいディレクトリと望まないディレクトリ、およびWebロボットにアクセスさせたいページと望まないページが含まれています。 /robots.txtファイルの簡単な構文命令は次のとおりです。

ユーザーエージェント: *

禁止:/

「User-agent:*」行は、ファイル内の指示がすべてのロボットに適用されることを意味します。 「Disallow:/」は、サイト上のどのページもクロールしないようにロボットに指示します。

/robots.txtの他の標準的な手順は次のとおりです。

- Webサイトのコンテンツへのフルアクセスを許可しますが、フォルダーまたはページをブロックします。

ユーザーエージェント: *

禁止:/ folder /

禁止:/page.html

- Webサイトのコンテンツへのフルアクセスを許可しますが、ファイルをブロックします。

ユーザーエージェント: *

許可しない:/file-name.pdf

- Webサイトのコンテンツへのフルアクセスを許可しますが、特定のWebロボットのクロールをブロックします。

ユーザーエージェント: *

禁止:

ユーザーエージェント:Googlebot

禁止:/

いくつかのWebロボットのリストについては、https://www.robotstxt.org/db.htmlにアクセスしてください。

除外するURLプレフィックスごとに「Disallow」行を区切る必要があります。 グロービングと正規表現は、User-agent行でもDisallow行でもサポートされていません。 User-agentフィールドの「*」は、「任意のロボット」を意味する特別な値です。

正しい:

ユーザーエージェント: *

許可しない:/file-name.pdf

禁止:/ folder1 /

禁止:/ folder2 /

エラー:

ユーザーエージェント: *

許可しない:/file-name.pdf

禁止:/ folder1 / / folder2 /

禁止:/ folder3 / *

Robots.txtが重要なのはなぜですか?

ファイルの不適切な使用はWebサイトのランキングに悪影響を与える可能性があるため、/robots.txtの重要性を知っておく必要があります。 これは、検索エンジンロボットがWebサイトにアクセスしたときに最初に検索するファイルです。

/robots.txtファイルには、検索エンジンロボットがサイトのWebページをどのように表示して操作するかを制御する命令が含まれています。 このファイルは、それが相互作用するボットと同様に、検索エンジンがどのように機能するかの基本的な要素です。

/robots.txtは、検索エンジンロボットがウェブサイトにアクセスするときに最初に検索するものです。これは、サイトコンテンツにアクセスする権限があるかどうか、およびクロールできるフォルダー、ページ、ファイルを知りたいためです。

/robots.txtファイルを当社のWebサイトに掲載する理由には、次のようなものがあります。

- 検索エンジンからブロックしたいコンテンツがあります。

- さまざまなWebロボットに特別な指示が必要な有料のリンクや広告があります。

- 評判の良いロボットからのサイトへのアクセスを制限したいと考えています。

- 私たちはライブサイトを開発していますが、検索エンジンがまだそれをインデックスに登録することを望まないでしょう。

- 上記の一部またはすべてが当てはまりますが、Webサーバーとその構成方法に完全にアクセスすることはできません。

他の方法で上記の理由を制御できますが、/ robots.txtファイルは、それらを処理するための適切で直接的な中心的な場所です。 ウェブサイトに/robots.txtファイルがない場合、検索エンジンロボットはサイトに完全にアクセスできます。

インストラクションのキーワードの意味は何ですか?

「user-agent:」 ->特定のロボットに適用する命令を指定します。 「User-agent:*」のようなステートメントは、ディレクティブがすべてのロボットに適用されることを意味します。 「ユーザーエージェント:Googlebot」のようなステートメントは、手順がGooglebotにのみ適用されることを意味します。

「許可しない:」 ->Webロボットに表示してはならないフォルダを指示します。 つまり、たとえば、検索エンジンでサイトの画像にインデックスを付けたくない場合は、それらの画像を1つのフォルダに配置し、「Disallow:/images/」のように除外できます。

「許可:」 ->他の指示によって「許可されていない」フォルダ内のファイルを表示しても問題がないことをロボットに伝えます。 例えば:

ユーザーエージェント: *

禁止:/ images /

許可:/images/myphoto.jpg

「サイトマップ:」 ->ウェブサイトサイトマップファイルの場所をロボットに伝えます。 例えば:

ユーザーエージェント: *

サイトマップ:https://www.mysite.com/sitemap.xml

禁止:/ images /

許可:/images/myphoto.jpg

Robots Metaタグ、それは重要ですか?

Webサイトで/robots.txtファイルの重要性と使用法について説明しましたが、Webロボットのサイトへのアクセスを制御する別の方法があります。 この別の方法は、RobotsMetaタグを使用する方法です。

<meta name =” ROBOTS” content =” NOINDEX、FOLLOW”>

他の<meta>タグと同様に、HTMLページの<head>セクションに配置する必要があります。 また、ロボットはサイトの任意のページへのディープリンクに遭遇する可能性があるため、サイトのすべてのページに配置することをお勧めします。

他の<meta>タグと同様に、HTMLページの<head>セクションに配置する必要があります。 また、ロボットはサイトの任意のページへのディープリンクに遭遇する可能性があるため、サイトのすべてのページに配置することをお勧めします。

「name」属性は「ROBOTS」である必要があります。

「content」属性の有効な値は、「INDEX」、「NOINDEX」、「FOLLOW」、「NOFOLLOW」です。 複数のコンマ区切り値を使用できますが、明らかに、意味のある組み合わせは一部のみです。 robots <meta>タグがない場合、デフォルトは「INDEX、FOLLOW」であるため、それを詳しく説明する必要はありません。 robots<meta>タグの他の可能な使用法は次のとおりです。

<meta name =” ROBOTS” content =” INDEX、NOFOLLOW”>

<meta name =” ROBOTS” content =” NOINDEX、NOFOLLOW”>

メタタグの使用は、Webロボットにクロールさせたくない特定のページに関連しています。 これは一般的には使用されておらず、訪問を制御する方がより正確で簡単です。 /robots.txtファイルを介したWebロボット。

結論

私たちは、私たちのウェブサイトで/robots.txtの重要性、それらの構文、そして私たちのウェブサイトの利益のためにそれを使って何ができるかを見てきました。 また、robotsメタタグの使用とその制限も確認しました。

ただし、使用する場合は、正しく使用されていることを確認する必要があります。 誤った/robots.txtファイルは、WebロボットによるWebサイトページのインデックス作成をブロックする可能性があります。さらに重要なことに、検索エンジンがランク付けする必要のあるページをブロックしていないことを確認する必要があります。

-

アルトゥーロSによって書かれました。