あなたが必要とする唯一のSaaSテクニカルSEOガイド

公開: 2022-08-18このデジタル時代では、ほとんどの組織がアクセシビリティ、機能、および汎用性を求めて、競合他社より優位に立つことができます。 これにより、サービスとしてのソフトウェア (SaaS) が企業にとって実行可能なオプションになりました。 SaaS は、複雑なソフトウェアと IT インフラストラクチャへのアクセスを企業に提供し、シンプルさ、柔軟性、手頃な価格を兼ね備えています。

しかし、テクノロジーが急速に発展し、顧客のニーズが変化しているため、SaaS ドメインはテクノロジーに精通した企業との競争に満ちています。

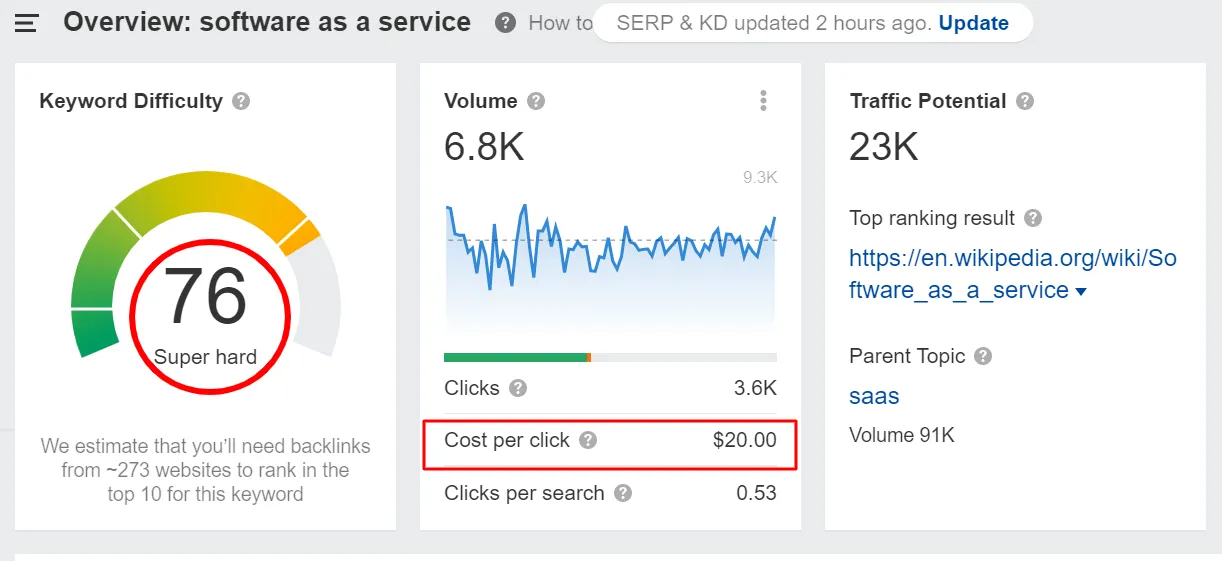

「サービスとしてのソフトウェア」というキーワードは、キーワードの難易度が高いだけでなく、クリック単価も高くなります。

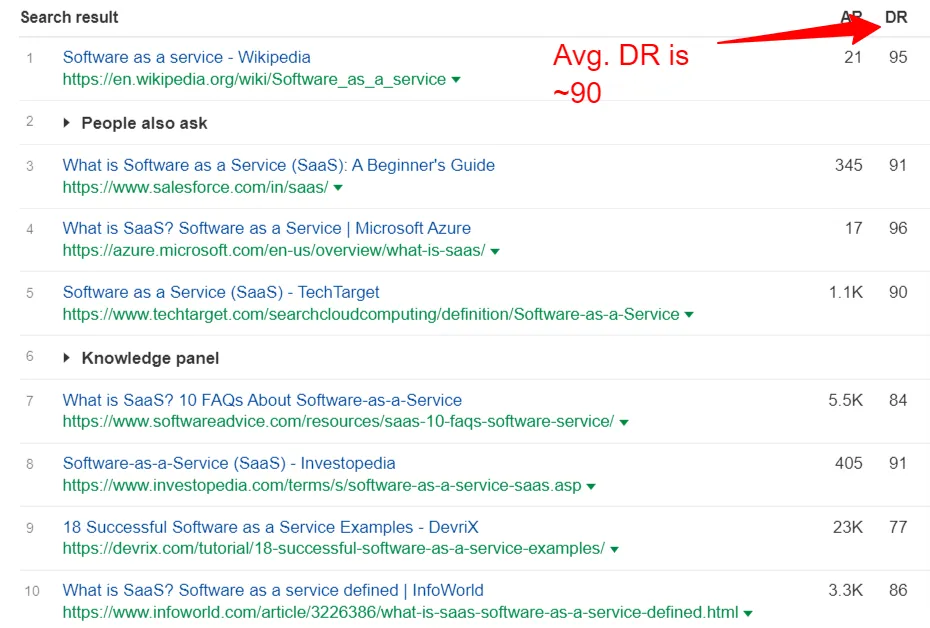

さらに、このキーワードのトップ 10 Web サイト ランキングのドメイン レーティングは高く、90 近くあります。

これはすべて、SaaS の人気が高まるにつれて、この分野での競争も激化することを示しています。 このますます競争が激化する状況において、適格なリードを見つけ、引き付け、育成し、変換することは、SaaS マーケターにとって大きな課題です。

ここで、ビジネス Web サイトの SaaS 技術的 SEO の健全性が明らかになります。 ただし、ほとんどの SaaS クライアントにとって、コンテンツ マーケティングとリンク構築戦略が優先事項です。 SEO の技術的な側面はほとんど注目されていません。これは、通常、SaaS 企業の技術的な SEO は彼らにとって「技術的」すぎるためです。

これはある日まで、Web ページのランキングとトラフィックが不明な理由でタンクに落ち込むまで続きます。または、SEO にほとんど影響を与えずにサイトを移行したいと考えています。 その場合、企業は効果的でないか、作業に時間がかかる受動的な決定を下す傾向があります。

これが、サイトの技術的健全性を改善するための積極的な対策を講じることができるように、定期的な技術的 SEO 健全性チェックをクライアントに推奨する理由です。

この投稿の終わりまでに、SaaS ビジネスの技術的な SEO がいかに広大で複雑であるかを知ることができます。 また、技術的な SEO 最適化の重要性についても学びます。

以下に共有されている情報が複雑すぎたり、実装方法がわからない場合は、当社の技術専門家チームがお手伝いします。 お電話またはメールですぐに対応いたします。

それでは始めましょう。

第1章:テクニカルSEOとは?

テクニカル SEO は、ウェブサイトの技術的側面を改善することに重点を置いているため、サイトが検索エンジンの重要な技術的要件を満たしていることを確認できます。 SaaS テクニカル SEO にリソースを投資する主な目的は、クロール、インデックス作成、レンダリング、Web サイト アーキテクチャなどのテクニカル検索の側面を優先することで、オーガニック ランキングを高めることです。

言うまでもなく、企業が技術的な SEO への投資に失敗すると、オンラインでのプレゼンスが打撃を受けます。 Google やその他の検索エンジン ボットは、Web サイトをクロールし、さまざまな要因でページを評価します。 Web サイトがクロールに対応していない場合、これらの検索クローラーは重要なページをクロールしてインデックスに登録することができません。

したがって、SaaS 企業向けのテクニカル SEO は、オーガニックリーチを拡大し、可視性を向上させる確実な方法です。

ほとんどの企業、特に SaaS 企業は、自社のサイトで技術的な SEO の問題を管理するのが難しいと感じています。

- SaaS のビジネス リーダーは、リード生成、顧客獲得、インバウンド マーケティング、数字の達成など、他の優先事項に集中しすぎています。 そのため、技術的な SEO はほとんど頭にありません。

- SaaS ドメインは、常に新しいコンテンツとアセットを生み出しています。 これにより、技術的な Web サイト管理が困難になります。

- 技術的な SEO の問題を発見するのは難しく、時間がかかります。 多くの場合、問題が発見されたときには手遅れです。 次の戦略 (受動的戦略) は、効果が現れるまでに数週間または数か月かかります。 したがって、サイトの技術的な健全性を判断するための対策を積極的に講じることが賢明です。

- テクニカル SEO は通常、 (ページ上とは異なり)目に見えない要素を指します。 たとえば、サイト構造、読み込み時間、XML サイトマップの問題は、実際に問題が発生するまで (または事前に監視しない限り) わかりません。

これらすべてが、SaaS ブランドのテクニカル SEO を難しくしています。

Growfusely の SaaS テクニカル SEO へのアプローチ

Growfusely では、Web サイトの健全性とパフォーマンスの 4 つの側面を調査することで、SaaS ビジネスのテクニカル SEO に取り組みます。 この4つの質問を自問自答します。

- ページは検索エンジンによってクロール可能ですか?

技術的に健全な Web サイトは、検索エンジンのクローラーがすべてのコンテンツとコードを簡単にクロールして分析できるように編成および構造化されています。

ここでは、情報アーキテクチャとサイトマップの観点からサイトのクリーン度を調べます。 クロール可能性を高め、ウェブサイトのエラーを最小限に抑えるために、さまざまなツールを適用します。 また、robots.txt の効果的な使用、クロール ルールの実装、内部リンク構造、サイトマップの更新など、いくつかの側面についても確認します。

- ページは検索エンジンによってインデックス可能ですか?

インデックス作成は、検索ボットがコンテンツを効果的に評価してレンダリングしたことを確認するクロールの重要な側面です。 ページがインデックスに登録されている場合、クローラーが検索結果に含めるコンテンツの関連性とコンテキストを評価したことを意味します。

この質問に答えるために、キャッシング、JavaScript と動的レンダリング、正規タグ、リダイレクトなどの側面を監視しています。

- ウェブサイトは安全ですか?

Web サイトのセキュリティは、サイトの技術的健全性の重要な側面です。 SaaS Web サイトのセキュリティに問題があると、訪問者だけでなく検索エンジンの信頼も損なわれる可能性があります。 これにより、SERP での Web サイトの可視性とランキングが大幅に制限される可能性があります。

ここでは、Web サイトが SEO 基準を満たしているかどうか、HTTPS などのセキュリティのベスト プラクティスを実装しているかどうかを確認します。

- サイトのパフォーマンス (速度) はどの程度ですか?

Web サイトの速度は、サイトのユーザー エクスペリエンスとパフォーマンスを決定する重要な要素です。 あなたの SaaS Web サイトには優れたコンテンツがあるかもしれませんが、十分に高速でなければ、SERP でランク付けできません。

大きな画像は Web サイトが遅くなる最も一般的な理由の 1 つですが、サイトのパフォーマンスを向上させる要因は他にもいくつかあります。 したがって、サイトを高速化するために、画像の圧縮、モバイル対応の向上、JavaScript/CSS の最小化、キャッシュ、および CDN の実装に注意を払っています。

次の章では、SaaS ビジネスの技術的な SEO 監査の重要な側面と、Web サイトのクローラーがどのように機能するかについて説明します。 また、SaaS Web サイトの技術的な SEO 分析を開始するのに十分なデータを準備する方法も共有します。

第 2 章: SaaS ビジネスのテクニカル SEO 監査: 何を、なぜ、どのように?

SaaS ビジネス オーナーとして、技術的な SEO 監査を実行する際に注意しなければならない膨大な量に圧倒されるのはよくあることです。 しかし、最小の技術的問題を適切に解決することで、ランキングとトラフィックが急増する可能性があることを知って驚かれることでしょう。

テクニカル SEO のさまざまなセクションを理解することから始めましょう。 これにより、何が正しく機能しておらず、何をする必要があるかを知ることができます。

1. サイト構造/情報アーキテクチャ

ウェブサイトの構造によって、重要なページとそうでないページが Google に伝えられます。 検索ボットは、サイト構造を使用して、サイトのコンテンツをクロールおよびランク付けします。

サイト構造は、コンテンツがどのように編成され、リンクされ、サイト訪問者に提示されるかを扱います。 したがって、ウェブサイトを適切に構成すれば、視聴者に利益をもたらし、検索ボットがページを適切にインデックス化できるようになります.

簡単に言えば、サイトの構造は、どのコンテンツが SERP で上位にランクされるかに影響を与える可能性があります。 サイト構造は非常に重要です。

- 検索エンジンに重要な情報を見つける場所とページ間の関係を伝えるため、Google のガイドとして機能します。

- 内部リンク構造により、どの投稿が重要であるかが Google に伝えられるため、すべてのコンテンツが互いに競合するのを防ぐことができます。

- 構造が明確であれば、サイトのナビゲーションが良好であることを意味するため、UX が向上します。 これは、人々があなたのウェブサイトで探しているものを簡単に入手できることを意味します.

内部リンク、ナビゲーション、カテゴリやタグなどの分類法、パンくずリストは、Web サイトを構成するためによく使用されます。

サイト構造を改善するためのベスト プラクティスをいくつか紹介します。

- 効果的な内部リンクのためにピラークラスターまたはハブスポークを使用する

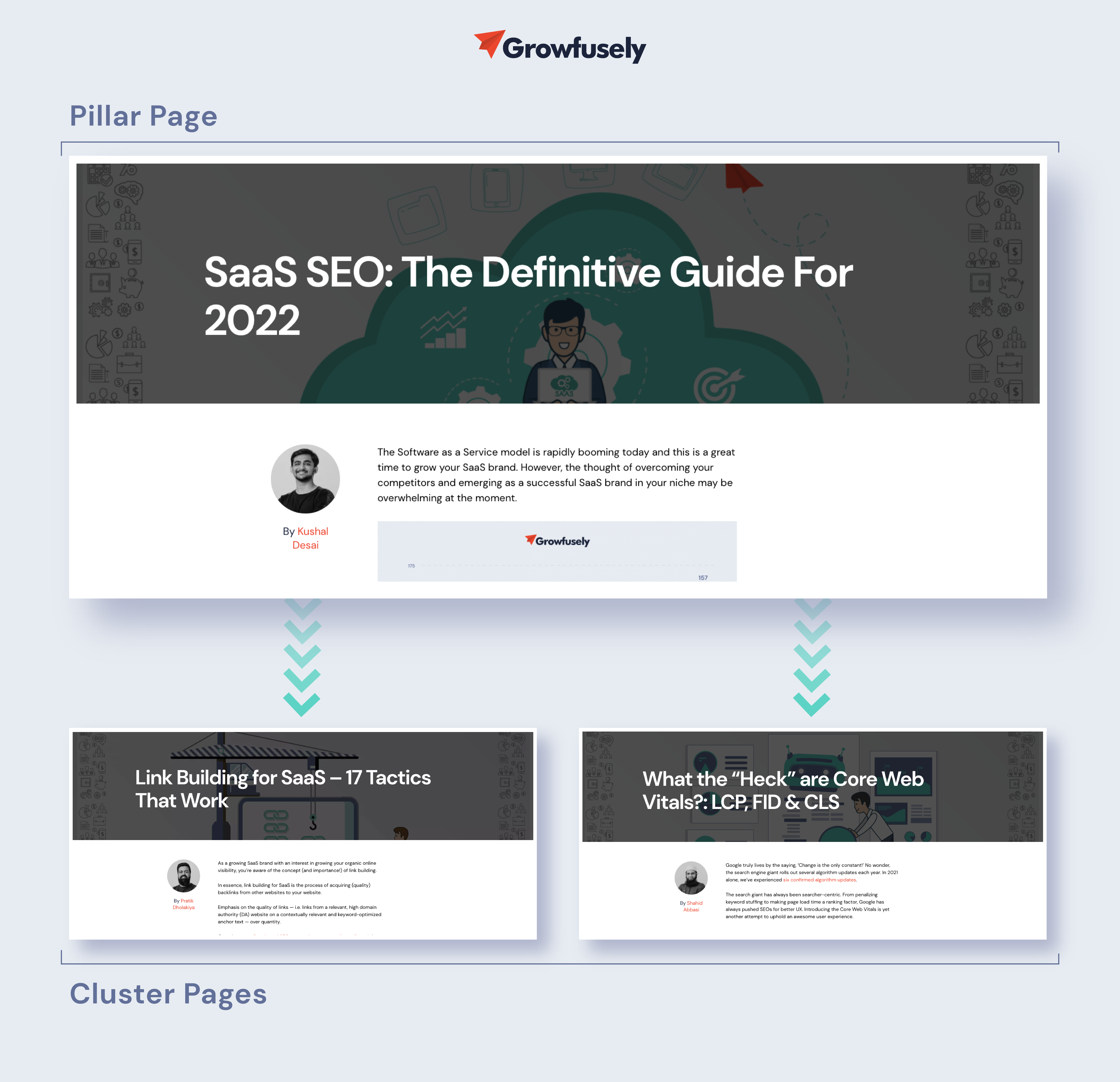

オンラインで利用できる SaaS コンテンツが非常に多いため、Google は、あなたがドメインの権威であるかどうかを知りたがっています。 権威を確立する最善の方法の 1 つは、コンテンツをピラー ページとトピック クラスターに編成することです。

ピラーページは、トピックに関する包括的な概要を提供します。 クラスターは、包括的なトピックを中心とした相互リンクされた記事のコレクションです。

私たちのブログは、ピラークラスターコンテンツ戦略によって生きています。

このモデルは、読者に相互接続されたエクスペリエンスを保証し、価値を提供し、ドメイン内の権威としての地位を確立します. これは、Google が「SaaS SEO」というトピックに最適なリソースであることを示しています。

- キーワード共食いを修正

キーワードのカニバリゼーションは、2 つ以上のページが同じキーワードと意図を求めて競合する SaaS Web サイトにとって大きな問題です。

たとえば、グラフィック デザイン プラットフォームの Canva が、「ソーシャル メディア グラフィック」というキーワードでランク付けしたいとします。 そのため、彼らは「ソーシャル メディア グラフィックスを強化するためのベスト プラクティス」というタイトルの投稿を共有しています。 数年後、新しいソーシャル戦術が出現し、別の投稿を作成しますが、同じキーワードをターゲットにしています.

これは、キーワード カニバリゼーションの典型的なケースです。 新しい投稿が公開されると、Google はどのページをランク付けするかを決めるのに苦労します。 ほとんどの場合、どちらにもランク付けされません。

このような問題は、サイトのランキングに悪影響を及ぼす可能性があります。

Google Search Console と SEMRush の Position Tracking Tool は、カニバリゼーションの問題を発見するための優れたツールです。 または、Google で「site:[ドメイン] キーワード」検索演算子を使用して、複数のページに同じ意図があるかどうかを確認できます。

- カテゴリ編成の URL 構造を採用する

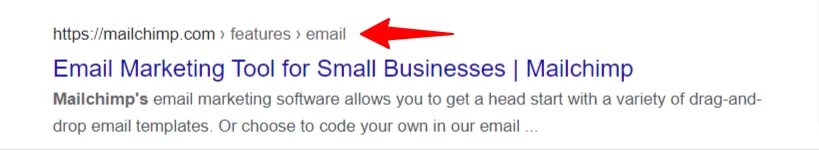

ルート ドメインにピラー ページを配置し、その URL からサポート コンテンツを構築することは、ユーザー エクスペリエンスを向上させるだけでなく、ウェブサイトを通じてリンク エクイティを渡すことにも役立ちます。

Hotjarがこれを簡単に行う方法を確認してください。

ピラーページのドメイン – https://www.hotjar.com/heatmaps/

サポート コンテンツ ドメイン – https://hotjar.com/heatmaps/examples

ルート ドメインの URL を継続する方法に注意してください。

- ウェブサイトの分類を作成する

ウェブサイトの分類により、ウェブマスターは論理的な方法でコンテンツを分類できます。 説明的な用語間の関係と類似性を定義し、ユーザーがページをナビゲートしやすくします。

覚えておいてください –コンテンツまたはそのレイアウトが魅力的でない場合、訪問者の 38% はページへの関与をやめます。

視覚的には、分類法は Web サイトのセクションやブログのカテゴリのように見えます。

マーケティング アトリビューション ソフトウェアのウェブサイトの架空の例を見てみましょう。 あなたは、訪問者が「マルチチャネル アトリビューション ソリューション」を求めてあなたのウェブサイトを訪れていることを認識しています。

この場合、訪問者が探しているものをすばやく見つけるのに役立つカテゴリを設定する必要があります。 したがって、次のようなマーケティング アトリビューション ソリューションを提供できます。

- 組織の役割 – CMO、ディレクター、マーケティング責任者、またはマーケティング マネージャー

- 業界セグメント – 代理店、e コマース、金融サービス、法律、旅行、または SaaS

したがって、よく計画された分類法は、顧客や見込み客が Web サイトと対話する方法を完全に変えることができます。

2.クロール

前述のように、クロールは Google の検出プロセスであり、検索エンジンがスパイダーを送信して Web を精査し、新しいコンテンツや更新されたコンテンツを探します。 ボットは Web ページを取得し、そこにあるリンクをたどって新しい URL を見つけます。 これらのクローラーは新しいコンテンツを見つけると、それをインデックス (Caffeine) に追加し、後で検索者が類似のコンテンツを探すときに取得できるようにします。

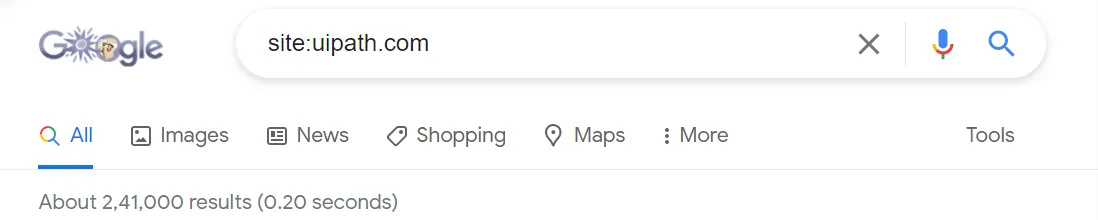

したがって、ページをクロールしてインデックスに登録することは、SERP に表示されるために重要です。 ページがクロールされ、インデックスに登録されているかどうかを確認するには、検索演算子「site:yourdomain.com」を使用します。

上記で共有された結果の数は、サイトでインデックスされたページの大まかなアイデアを提供します. より正確な情報については、GSC のインデックス カバレッジ レポートを使用してください。

Web ページが SERP に表示されない理由はいくつかあります。

- あなたのサイトは開設されたばかりで、Google のクローラはまだクロールしていません。

- あなたのサイトは外部のウェブサイトからリンクされていません。

- あなたのサイトのナビゲーションはクロールに適していません。

- あなたのサイトには、検索エンジンをブロックしているクローラー ディレクティブが含まれています。

- あなたのサイトは最近、スパムのような SEO 戦術を使用したとして Google のペナルティを受けました。

重要な Web ページをインデックスに登録して SERP に登録する方法の 1 つは、サイトのクロール方法を Google に指示することです。

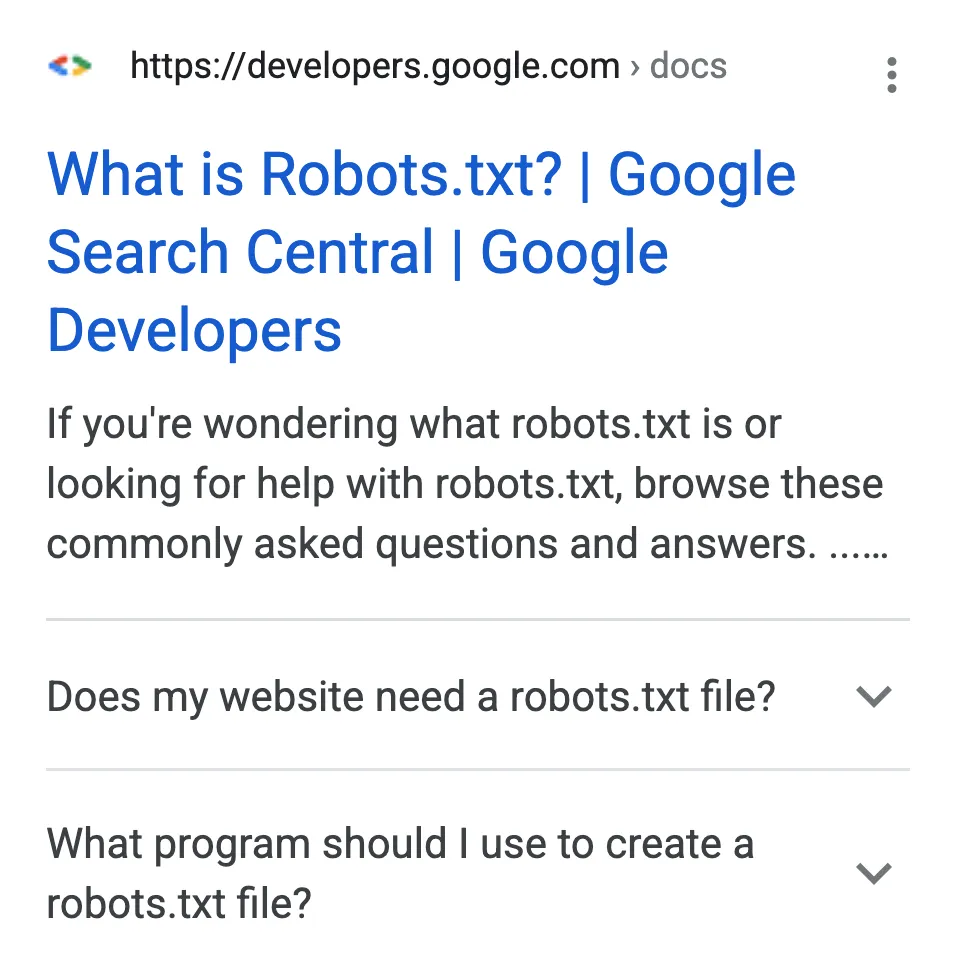

- Robots.txt ファイルを確認する

robots.txt ファイルは、サイトのどの部分を検索ボットでクロールする必要があり、どの部分をクロールしてはならないかを示しています。 特定の robots.txt ディレクティブを通じて、Web サイトをクロールする速度も共有します。

robots.txt ファイルは、Web サイトのルート ディレクトリにあります。

検索ボットが robots.txt ファイルを処理する方法は次のとおりです。

- ボットが robots.txt ファイルを見つけられない場合、ボットは Web サイトのクロールに進みます。

- ボットが robots.txt ファイルを見つけると、共有された提案に従い、クロールを続行します。

- ボットが robots.txt ファイルにアクセスしようとしたときにエラーが発生し、そのファイルが存在するかどうかを判断できない場合、ボットはクロールを続行しません。

- Flash と JavaScript のナビゲーション

Flash と JS ナビゲーションはサイトの見栄えを良くしますが、検索エンジンにはかなり悪影響を及ぼします。 ボットにとって、JS フレームと Flash は、ページのコンテンツにアクセスできない壊れたリンクのようなものです。

今日、Google はそれらをリンク発見に使用することでより良くなっています。 Google は JavaScript、AJAX、Flash を実行できますが、他の検索エンジンはそれらに苦労しています。

同様に、Google はそれらをインデックスに登録できますが、他の検索エンジンはできません。 したがって、サイトのクロール性を向上させたい場合は、JS ナビゲーションと Flash が検索ボットにとって魅力的であることを確認する必要があります。

- 閃光

すばらしい Flash アニメーションを作成し、その中で強力なブランド メッセージを共有することができます。 しかし、検索エンジンの場合、コンテキストを提供するのは、キーワードが豊富なコンテンツやアンカー テキストのない一連の画像だけです。

そのため、Web サイトに Flash アニメーションを使用している場合は、それを取り除くか、Flash なしでナビゲーション バーを複製することをお勧めします。

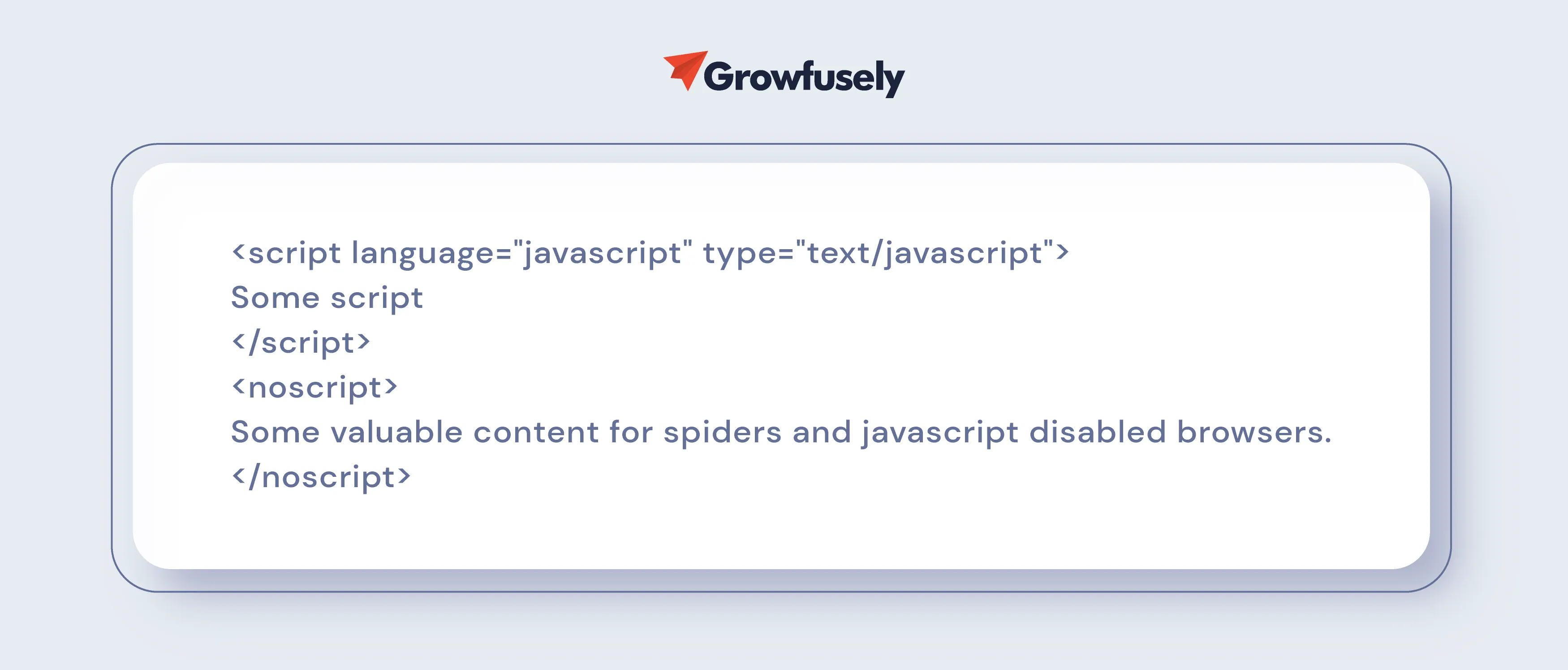

- JavaScript ナビゲーション

Web サイトのナビゲーションに JavaScript が使用されている場合、そのランキングは確実に低下します。 これは、検索ボットがスクリプトを正確に読み取るという保証がないためです。

この問題に取り組むには、テクニカル SEO チームに、有害なスクリプトを削除するか、noscript セクションを含めるよう依頼してください。

- XML/ HTML サイトマップ

ご存知のように、すべての Web サイトには、人間とボットの 2 種類の訪問者がいます。

Google のスパイダーは XML サイトマップを使用して機械可読のサイトマップまたはインデックスを作成しますが、人間は HTML サイトマップを参照して Web サイトをナビゲートします。

XML サイトマップは、次の理由から重要です。

- 検索エンジンが Web サイトのすべての URL を認識していることを確認する

- URL に関する追加のコンテキストを提供して、Google がウェブサイトをよりよく理解できるようにします

- インデックスでのサイトの可視性を向上させる

- インデックスに登録されたサイトマップ URL の数を監視する

- 優先ページについて検索エンジンに伝える

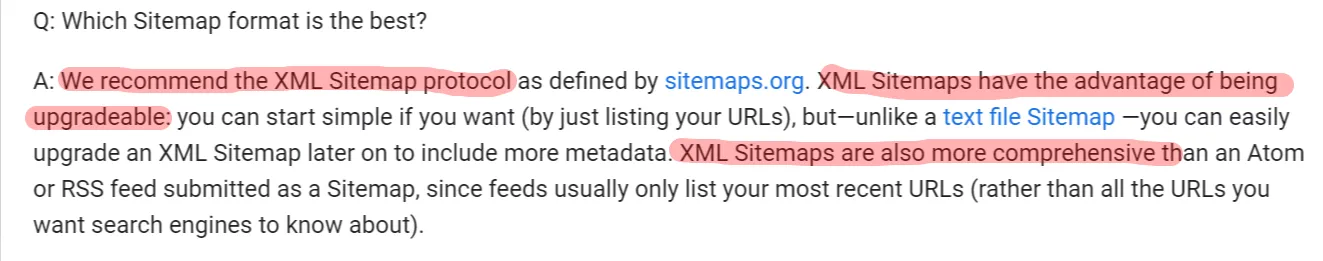

では、HTML サイトマップは必要でしょうか?

はい! ユーザーは HTML サイトマップから大きな恩恵を受けることができます。 さらに、このサイトマップはアーカイブされたコンテンツにリンクしています。 したがって、このサイトマップは、リンクされていない多くのコンテンツを公開する場合に役立ちます.

これがGoogleがそれらについて言わなければならないことです.

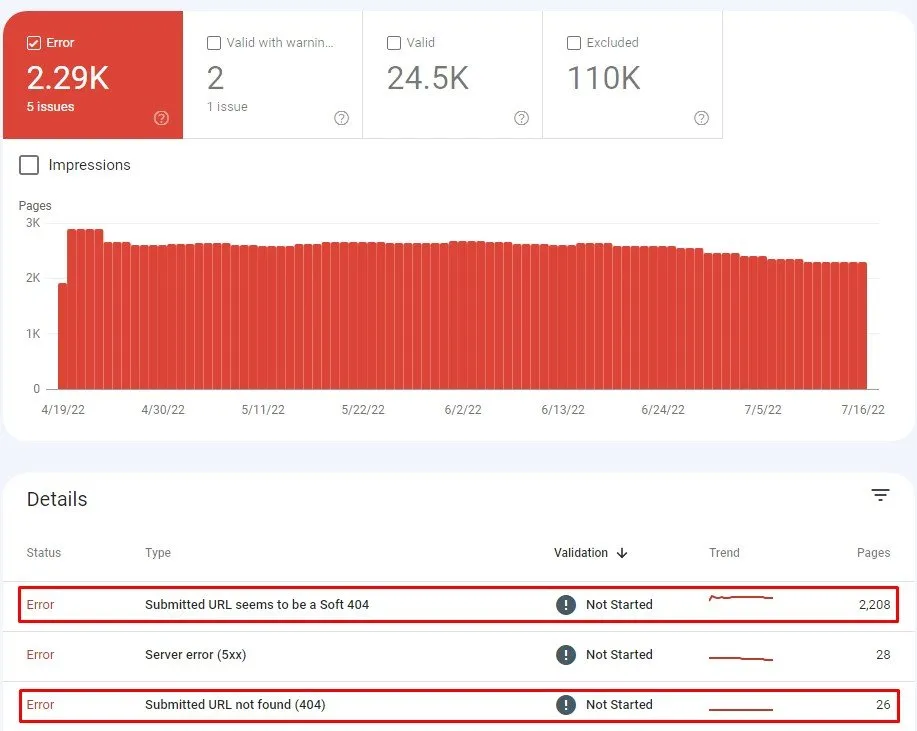

- 壊れた内部リンク

内部リンクが壊れているかリンクが無効になっていると、Google のクローラーがコンテンツをスキャンしてインデックスに登録できなくなります。 404 Page Not Found、400 Bad Request、Timeout などのエラー コードは、壊れたリンクを示しています。

ページにそのようなリンクが多すぎると、Web サイトが無視されている可能性があります。 さらに、クローラーが壊れたリンクに遭遇すると、それらを分類するために壊れているかどうかを検証するために時間と予算を浪費します。

したがって、GSC を使用して、エラーを返すページを検出します。 ダッシュボードで、

インデックス > カバレッジ > エラー

ここで、これらのリンクを修正します。 リンク切れの原因を調べることから始めます。 これらの質問を使用して、この問題を解決してください。

- タイプミスが原因ですか?

- 最近、画像、ビデオ、ファイル、または Web ページ全体を削除しましたか?

- ページの名前を変更したり移動したりして、リンクを更新するのを忘れていませんか?

- 移動または削除されたコンテンツにリンクしていますか?

- ドメイン名を変更したか、サイトを新しい URL に移動しましたか?

理由がわかれば、壊れたリンクを修正するための解決策を見つけるのに役立ちます。

たとえば、古いページを削除して代わりに新しいページを作成した場合、ユーザーが古いページにアクセスしようとすると、古いページに 404 ページが見つかりませんというエラーが表示されます。

この場合、ページを削除するときは、訪問者を新しい場所に送り、ページが完全に削除されたことを検索ボットに通知する 301 リダイレクトを必ず使用してください。

- 内部リダイレクト

SaaS Web サイトは、コンテンツを変更したりページを移動したりして、読者が最新の更新を確実に入手できるようにすることがよくあります。 したがって、これらのサイトではリダイレクトが比較的一般的です。

リダイレクトは、次の場合によく使用されます。

- ウェブサイトの統合

- コンテンツの更新または削除

- 404 を返すページを修正する

- 情報アーキテクチャの変更

- サイト移行中。

多くの場合、リダイレクトが必要です。 たとえば、元の URL がインデックスに登録されているか、ユーザーが頻繁にアクセスする場合に必要です。 元の URL がニュースレターやホワイト ペーパーなどのコンテンツで使用されている場合にも、リダイレクトが必要になることがあります。

ただし、リダイレクトは検索エンジン クローラーに「余分なホップ」を追加するため、あまり多くのリダイレクトを使用することは避けてください。

- リダイレクト チェーン(2 クリック以上)

リダイレクト チェーンは自然に発生しますが、UX (サイト速度の低下) とクロール バジェットに大きな影響を与え、インデックス作成の問題を引き起こします。 検索エンジンが不要な 3XX ステータス コードを取得するたびに、ボットは待機する必要があり、優先ページをクロールする時間が少なくなります。

Google ボットは、リダイレクトが多すぎると (5 回のホップまたはクリックの後)、クロールを中止します。 したがって、 John Mueller は、この数よりも少ないホップ数を推奨しています。

3. レンダリング

ブラウザがページをリクエストすると、Googlebot はウェブページを取得してコードを実行し、必要なコンテンツにアクセスしてウェブサイトの構造を理解します。 このプロセスはレンダリングと呼ばれます。 これらのボットがプロセス中に収集した情報は、Web ページのランク付けに使用されます。

レンダリングは、すべてのページの 2 つの状態の間で発生します –

- サーバーからの応答である初期 HTML 。 これには、ページの作成に必要な HTML とリソースへのリンク、つまり JavaScript、CSS、および画像が保持されます。

- 一般に DOM (Document Object Model) として知られている、レンダリングされた HTML 。 これは、初期の HTML と、HTML によって呼び出された JS による変更を表します。

DOM を見つけるには、ブラウザの開発者ツールに移動し、[コンソール] をクリックします。

Duda Webinar で、Martin Splitt が HTML をレシピとして例えながらレンダリングについて説明しています。

HTML がレシピである場合、大量のテキスト、画像、その他のものなど、さまざまな要素が含まれている可能性があります。 しかし、レシピは説明書が書かれた一枚の紙にすぎません。

CSS、JavaScript ファイル、動画、画像などの Web ページ リソースは、実際の物理的な構成要素です。

ブラウザで表示および操作する Web サイトは、最終的な食品の準備です。

このすべてにおいて、レンダリングは料理を調理するプロセスです。

健全な Core Web Vitals スコアを確保するには、効率的なレンダリングが不可欠です。

- クリティカル レンダリング パス/遅延読み込み

Googleによると、クリティカル レンダリング パスの最適化とは、現在のユーザー アクションに関連するコンテンツの表示を優先することです。

これは、ブラウザーが HTML、CSS、および JavaScript をピクセルに変換するために実行する一連の手順です。 これには、DOM、 CSS オブジェクト モデル (CSSOM) 、レンダー ツリー、およびレイアウトが含まれます。

クリティカル レンダリング パスを最適化することで、最初のレンダリングまでの時間を短縮できます。

遅延読み込みは、重要な UI アイテムのみをレンダリングする Web およびモバイル アプリの最適化手法です。 その後、重要でないアイテムをレンダリングします (ノンブロッキング)。 このように、遅延読み込みはクリティカル レンダリング パスの長さを短縮する効果的な方法であり、それによって読み込み時間の短縮につながります。

- Javascript フレームワークのレンダリング

JavaScript は、Angular、React、および Blaze UI レンダリング ライブラリをサポートしています。 DOM を使用して DOM 要素を操作し、ブラウザーに出力を表示します。 DOM は、HTML ファイル内の要素間に親子関係と隣接する兄弟関係を設定します。

- <head> 内の無効な HTML 要素

<head> には、URL に <noscript> タグが含まれているため、無効な HTML 要素が含まれていることがよくあります。 このタグは、ブラウザーでスクリプトを無効にしているユーザー、またはスクリプトをサポートしていないブラウザーを使用しているユーザー向けの代替コンテンツを定義します。

<head> で使用する場合は、要素 (<link>、<style>、および <meta>) のみを含める必要があります。 JavaScript をレンダリングしないクローラーにとって、他の HTML 要素を含めることは困難な場合があります。 他の要素が存在するとレンダリングが妨げられるため、メタ ロボットなどの重要なタグが見落とされます。

- リソース URL (画像、CSS、JS) リダイレクトが壊れている

この URL は、アクセスできない別の URL にリダイレクトされるリソース URL です。 リダイレクトされた URL (301 または 302) は、ページの場所が変更され、ユーザーが元の URL ではなく新しい URL に送られることを意味します。

リソースが利用できなくなると、レンダリングに影響し、ユーザー エクスペリエンスが低下する可能性があります。

4. 索引付け

インデックス作成とは、Web ページがクロールされ、コンテンツとそのコンテキストが分析された後、Google のインデックスまたは Web 検索に Web ページを追加するプロセスです。 このプロセスは、検索エンジンが情報を整理するのに役立ち、ユーザーの検索クエリに対して超高速の応答を提供できるようにします。

そのため、検索ボットがページをクロールした後、ブラウザーと同じようにレンダリングします。 その際、検索エンジンはコンテンツを分析し、インデックスまたはデータベースに保存します。

Web ページをインデックスに登録するよう検索エンジンに指示する方法を理解しましょう。

- 正規化

検索エンジンが複数のページで同じコンテンツをクロールする場合、どれをインデックスに登録すればよいかわかりません。 そこで正規化が役立ちます。 正規化により、優先ページについて検索エンジンに指示できます。

したがって、 rel=”canonical”タグを使用すると、検索エンジンは、重複を無視しながら、コンテンツの優先バージョンをより適切にインデックスに登録できます。

rel="canonical"タグを追加すると、検索エンジンにこのページをインデックスしないでください。 代わりに、「このページ」をインデックスに登録してください。これがマスター バージョンだからです。

正規化を適切に行うと、コンテンツの各部分に URL が 1 つだけ含まれるようになります。 コンテンツの重複によるペナルティはありませんが、インデックス作成の問題が発生し、SEO 戦略が損なわれる可能性があります。

したがって、 rel=”canonical”タグを使用して、Google に canonical を選択させ、他のものを検索結果から除外するように促すのが賢明です。

- ロボット メタ タグ

これらのタグは、HTML の <head> 内で使用されます。 robots メタ タグの一般的なメタ ディレクティブを次に示します。

- index/noindex:これは、ページをクロールし、取得のためにインデックスに保持する必要があるかどうかを検索エンジンに伝えます。 「noindex」を選択すると、検索結果からページを除外するようにボットに指示することになります。

Google にシン ページのインデックスを作成させたくないが、訪問者がアクセスできるようにしたい場合は、「noindex」を使用します。

SaaS Web サイトの場合、ユーザー生成のプロファイル ページに「noindex」を使用できます。

- follow/nofollow:ページ上のリンクをたどるべきかどうかを検索エンジンに通知します。 「nofollow」を選択すると、検索エンジンはリンクをたどったり、リンク エクイティを渡したりしません。

「Nofollow」は「noindex」と組み合わせて使用されることがよくあります。これは、ウェブマスターがページのインデックス登録を阻止し、クローラーがそのページのリンクをたどらないようにする場合に使用されます。

- noarchive:ページのキャッシュ コピーを保存しないように検索エンジンに指示します。 デフォルトでは、すべての検索エンジンがインデックスされたページの表示可能なコピーを維持します。

ただし、価格が変化する複数のサービスがある場合は、「noarchive」を選択できます。 これにより、訪問者に古い価格が表示されるのを防ぐことができます。

5. ステータスコード

HTTP ステータス コードの分析は、テクニカル SEO 監査の重要な部分です。 それらを追跡すると、Web サイト構造内のエラーを見つけるのに役立ちます。

SEO 監査の一環として、これらのステータス コードをチェックして、期待どおりかどうかを確認し、必要に応じて修正を適用して、内部リンク構造を改善する必要があります。

主要なステータス コードを見てみましょう。

を。 3XX

- 301 永久移動または 301 リダイレクト

このステータス コードは、リソースが永続的であることを示します。 したがって、要求されたリソースの代わりに、要求を別の URL にリダイレクトする必要があります。

これらのステータス コードは、サイトの移行の場合、または SEO 値をある URL から別の URL に永続的に転送する必要がある場合に使用されます。

- 302件見つかりました

302 found は、リソースが一時的に別の場所に移動されたことを示す一時的なリダイレクトです。

302 ステータス コードの良い例:ゲーテッド コンテンツ キャンペーンを 1 か月実行していて、302 を使用して URL A から URL B にユーザーを送信しています。キャンペーンが終了する 1 か月後、302 リダイレクトを削除します。

302 ステータス コードの悪い例: Web サイトの移行中、ほとんどの開発者は 301 ではなく 302 を実装します。したがって、シグナルはすぐに新しい URL に渡されません (数か月かかる場合があります)。 したがって、新しい URL は以前のものほど成功しません。

他にもいくつかの 301 リダイレクト ステータス コードがあります。

- 303 その他を参照:これは、最初の要求に対して間接的な応答を提供することを目的としています。

- 304 Not Modified:これは、要求されたリソースが最後に要求されてから変更されていないことを示します。 したがって、お客様には返却されません。 代わりに、キャッシュされたバージョンが使用されます。

- 307 一時リダイレクト/内部リダイレクト:この一時ステータス コードは、ターゲット ページが一時的に別の URL にあることを示します。

その URL への自動リダイレクトがある場合、リクエストのメソッドを変更してはならないことをユーザーに知らせます。

b. 4XX

- 401無許可

HTTP認証に失敗したことを示すエラーです。 これは、要求されたページがユーザー名とパスワードの組み合わせを必要とするか、IP アドレスに基づいてアクセスが許可されていないことを意味します。

- 404 ファイルが見つかりません

このステータス コードは、要求されたソースが見つからないことを示します。 これは、一時的または永続的な一般的なステータス コードです。 優れた UX を確保するには、次のようなカスタム 404 を作成します。

- ページが存在しないことを示します

- ウェブサイトのデザインに統合されています

- アクセス可能なコンテンツへのリンクを提供します

- インデックス可能ではありません

さらに、ページが存在しない場合、重要なバックリンクがない場合、または同等のコンテンツが利用できない場合は、404 を設定します。

- 410 ゴーン

これらのステータス コードは、要求されたページが利用できないことを示しています。 このステータス コードが 404 と異なるのは、この微妙な点にあります。 ページは既に存在しますが、削除されており、置き換えられません。 これにより、正確で決定的なメッセージが検索ボットに送信されます。

c. 5XX

- 500内部サーバーエラー

このステータス コードは、サーバーでリクエストの処理に問題があったが、具体的なことを明示的に指摘できないことを示します。

- 503 サービスを利用できません

このステータス コードは、サービスが一時的に利用できず、後で利用できるようになることを示します。 多くの開発者は、Web サイトのメンテナンスが予定されているときにこれを使用しますが、この方法はお勧めしません。

503 の正しい使い方:サーバーがビジー状態で、現在リクエストを処理できません。

503 の不適切な使用:過去または遠い将来の「 Retry-After 」値 (後で再試行) で503 を提供しています。

6. モバイルフレンドリー

レスポンシブ デザインでは、同じコードを使用して、表示される画面サイズに合わせて Web サイトを調整します。 Google ボットはデスクトップではなくモバイル バージョンの Web サイトをインデックスに登録するため、モバイル対応はテクニカル SEO の大きな部分を占めます。

したがって、今日、モバイルフレンドリーなデザインを持つことは選択肢ではありません. Google は早い段階でモバイル ファースト インデックスを導入し、Web マスターに、これがないとランキングが低下することを伝えました。

ユーザーと Google にとってウェブサイトをモバイル フレンドリーにする方法を見てみましょう。

を。 AMP を使用する

しばらくの間、モバイルのトレンドがデスクトップを追い抜いてきたことは誰もが知っています。 この傾向は、Googleがモバイル ブラウジング用にサイトを最適化するための Google のオープンソースの取り組みであるAccelerated Mobile Pages (AMP) プロジェクトを思いつくのに十分でした。

AMP は、既存の HTML に基づく特定のフレームワークを使用して、ブラウザとの情報交換を合理化します。 これにより、読み込み時間が短縮され、シームレスで素早いユーザー エクスペリエンスが実現します。

AMP は、注意して使用する限りうまく機能します。

なんで?

- AMP には、深刻な設計上の制約があります。 AMP では単一のスタイルシートが許可されているため、インライン スタイルを使用できます。これにより、HTTP リクエストが 1 つに減ります。

また、CSS のサイズは 50 キロバイトに制限されています。 適切な設計を作成するには十分ですが、それでも開発者は効率的なコーディングを使用する必要があります。

- リンクの構築は、AMP では複雑になる可能性があります。 ウェブサイトがあなたの AMP ページにリンクすると、バックリンクはあなたのドメインではなく Google のドメインを指します。

AMP はスピードがすべてです。 したがって、理想的な Web デザインなどの UX の他の側面は、パフォーマンスに次ぐものです。 しかし、私たちが生きているモバイル フレンドリーな時代を考えると、より高速なページの読み込みは UX の観点から価値のある資産です。

b. プログレッシブ Web アプリ

現実的に考えてみましょう。ユーザーは、インターネットでアクセスするすべてのサイトにアプリをインストールするわけではありません。 そのため、プログレッシブ Web アプリが作成されました。

PWA は、ネイティブ アプリに似た UX を提供するため、SEO 領域で非常に人気があります。 アプリのメンテナンスを複雑にすることなく、リテンションとパフォーマンスを向上させることができます。

たとえば、通知パネルに表示されるプッシュ通知などの機能を使用すると、ユーザーがアプリ ストアにアクセスしなくても、お気に入りの Web サイトをホーム画面に追加できるようにしながら、簡単に視聴者を再獲得できます。

PWA はすばやくレンダリングされるため、モバイル デバイスとデスクトップでリッチなエクスペリエンスが提供されます。 さらに、それらは応答性が高く、発見可能であり、接続性に依存せず、他のページよりも優れたエンゲージメントを保証します.

運送会社の Uber は、ローエンドのデバイスや低速のネットワークを使用している乗客が配車を予約できるようにする先進的な Web アプリ、m.uber を構築しています。

同様に、Flipkart Lite は、Web とネイティブ アプリの長所を組み合わせた PWA です。

c. レスポンシブ デザイン

レスポンシブ Web デザインが SEO の取り組みを補完する方法を次に示します。

- サイトの使いやすさ

レスポンシブ デザインはモバイル検索用にサイトを最適化するため、サイトの機能が向上し、デバイス間で一貫した UX が提供されます。 このように、あなたのサイトのユーザビリティと Google はランキングの向上を支持します。

- クイックページ読み込み

レスポンシブ デザインに従う Web サイトは通常、読み込みが速く、ユーザー エクスペリエンスと検索結果のランキングが向上します。

- 低直帰率

Web サイトにレスポンシブ デザインを使用すると、Web サイトが他の Web サイトよりも魅力的になるだけでなく、コンテンツを整理された方法で配信できます。 したがって、あなたのウェブサイトは理解しやすくなり、訪問者はより長く滞在します.

これらすべてにより、UX が向上し、直帰率が低くなります。

- 重複コンテンツ禁止

レスポンシブ Web サイト設計に従うことで、使用するデバイスに関係なく単一の URL を使用できます。 これにより、Google を混乱させ、ランキングに悪影響を与える重複コンテンツの問題が解決されます。

- ソーシャルシェアリング

ソーシャル メディアは直接的なランキングではありませんが、視聴者を増やすのに役立ちます。 応答性の高い Web サイトを使用すると、訪問者がソーシャル メディアでコンテンツを簡単に共有できるため、ドメイン内での認知度と権限が向上します。

7. ウェブサイトのセキュリティ

Google makes sure that its users find search results that are safe to use and do not compromise user information or personal data. Thus, website security can significantly impact a site's SEO performance.

Without a secure website, you cannot rank well in the search result pages or dominate your keyword category.

Website security encompasses all the precautionary measures taken to protect the site against malicious threats or attacks. More often than not, unsecured websites allow hackers to access the site code, allowing them to hide keywords, redirects, and links and create subpages that boost the income of their nefarious websites.

Google and other search engines flag malware and unscrupulous websites, thereby warning users not to access them.

Here are a few steps you can take to protect your website from such attacks and improve your rankings in the SERPs.

a. HTTPS

HTTPS is an encrypted version of the HTTP that protects the communication between your browser and server against being intercepted by attackers. IT offers confidentiality, integrity, and authentication to website traffic.

The security comes with the use of SSL (Secure Sockets Layer) that encrypts the information being transmitted from the user's computer to the website they are on. Today, almost all websites use SSL to protect their information, especially when users need to share sensitive data like credit card numbers or personal data.

Installing HTTPS and allowing indexing are the top measures you should take, allowing Google to read your website ensure that the data transmitted is secure. Further, HTTPS enables the use of modern protocols for enhancing security and website speed.

To encourage sites to implement this security, Google uses HTTPS (HyperText Transfer Protocol Secure) as a (lightweight) ranking signal. Simply put, if your site uses HTTPS, it will get a small boost in its search rankings.

Follow these tips to implement HTTPS –

- Install an SSL Certificate from a Certificate Authority like DigiCert, Comodo Cybersecurity, or Verisign.

- Decide on whether you need a single, multi-domain, or wildcard certificate.

- Use relative URLs for resources on the same secure domain and protocol relative URLs for other domains.

- Update your website's address in Google Webmaster Tools. This will ensure that Google indexes your site's content under the new URLs.

- Avoid blocking HTTPS sites from crawling using robots.txt and allow indexing of your pages by search engines.

Besides improving site security, HTTPS improves site speed when protocols like TLS 1.3 and HTTP/2 are used. Let's learn more about these protocols in the next section.

b. HTTP/2

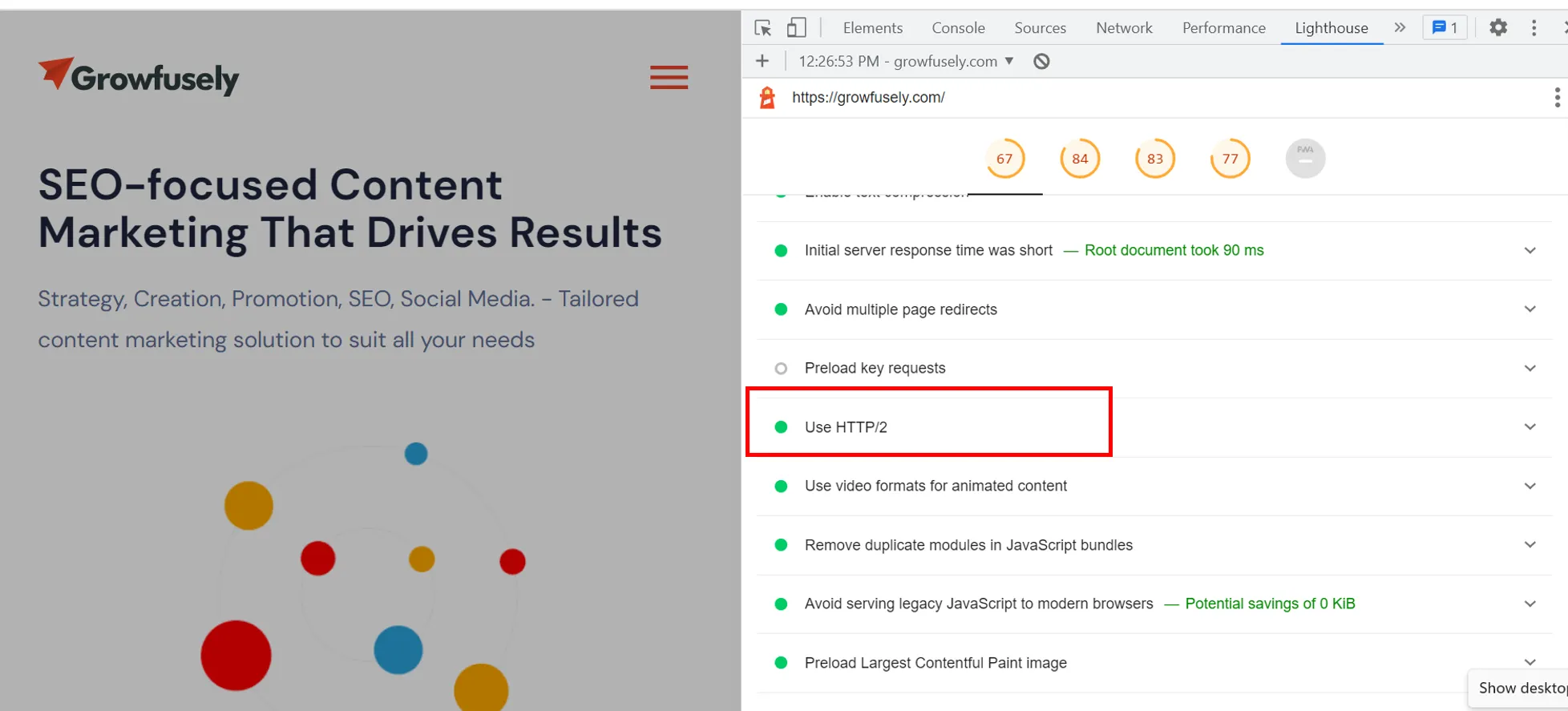

When you do a Google Lighthouse audit report, you will come across HTTP/2. In this screenshot, you can see that it's green for our website; however, it often pops up as an opportunity to improve page loading speed for several other sites.

HTTP/2 is a protocol that governs the communication between the browser making requests and the server holding the requested information.

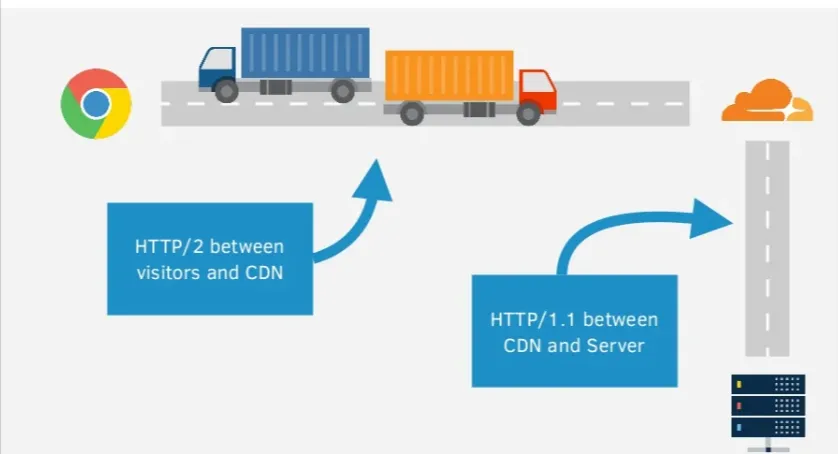

Tom Anthony from Distilled, amazingly explains HTTP/2, using the truck analogy.

The truck represents the client's request to the server and the road traveled is the network connection. Once the request is made, the server will load the response and send it back to the browser.

The problem with HTTP is that anyone can see what the truck is carrying. With HTTPS, there's a layer of protection to the responses. So, it's like the truck is going through a tunnel and no one is able to see what's inside.

However, the problem is –

- Small requests take time and multiple requests means some have to wait

- Mobile connections increase the latency and round trip time

HTTP/2 solves this issue by allowing multiple requests per connection while ensuring security when used with HTTPS. Further, HTTP/2 has a feature – server push, where the server can respond to a request with multiple responses at once.

So, for instance, if the server knows that the HTML needs other assets like CSS and JavaScript files, it can send them back with the HTML rather than delivering them individually.

If your server supports HTTP/2, you can ensure it automatically serves content on the new protocol by using a CDN.

c. TLS Protocols

TLS or Transport Layer Security is a protocol that ensures data privacy and security of information when it is transmitted. It offers server authentication and encryption of communications between the web application and server.

TLS is like an upgraded/ redesigned version of SSL that supports more encryption algorithms. Though the implementation of TLS doesn't guarantee increased visibility, the website gains user trust, thereby reducing your site's bounce rate and having a positive impact on its rankings.

d. Cipher Suites on Server

Cipher suites are sets of methods or cryptographic algorithms used to encrypt messages between users or servers and other servers. They secure a network connection through SSL/TLS and are typically made of the following algorithms –

- The key exchange algorithm that dictates how symmetric keys will be exchanged

- The authentication algorithm that dictates how server and client authentication will be carried out

- The bulk encryption algorithm tells which symmetric key algorithm will be used to encrypt the actual data

- Message Authentication Code (MAC) algorithm that dictates the method used to perform data integrity checks.

Cypher is critical for the security level, compatibility, and performance of your HTTPS traffic. They determine how secure it is, who can see it, how it's displayed on the browser, and how fast users can see your site.

e. HTTP Response Headers

HTTP headers often get ignored during technical SEO audits. These are the directives passed along through HTTP header response. Websites using these headers are known to be hardened against notorious security vulnerabilities.

Reviewing HTTP headers can offer valuable assets about your site's technical SEO performance. Here are five security headers you should be aware of.

- Content-Security-Policy (CSP)は、Web サイトをクロス サイト スクリプティング (XSS) やデータ インジェクション攻撃から保護するのに役立ちます。

- Strict-Transport-Security ヘッダーは、攻撃者が HTTPS 接続を HTTP にダウングレードするのを防ぎます。 これは、HTTP Strict Transport Security ヘッダー (HSTS) とも呼ばれます。

- X-Content-Type-Optionsは、たとえばユーザー生成コンテンツを通じて発生する可能性のあるいくつかのエクスプロイトを阻止します。

- X-Frame-Optionsはクリックジャッキング攻撃を阻止するため、実装すると便利なセキュリティ対策になります。

- Referrer-Policyを使用すると、サイト訪問者がリンクをクリックして別の Web サイトにアクセスしたときに送信される情報を Web マスターが制御できます。 これにより、訪問者を参照しているサイトの URL に存在する機密情報が第三者に漏洩するのを防ぎます。

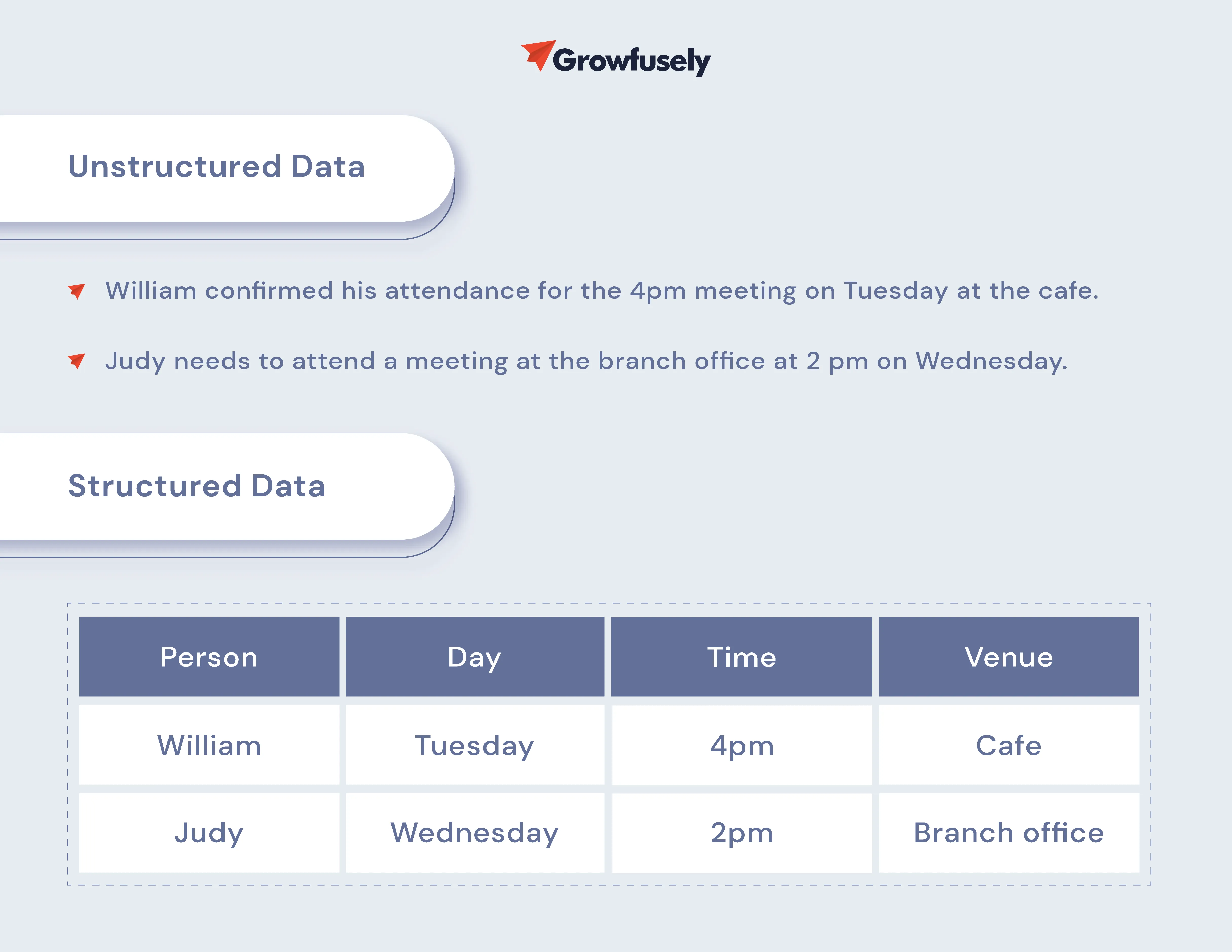

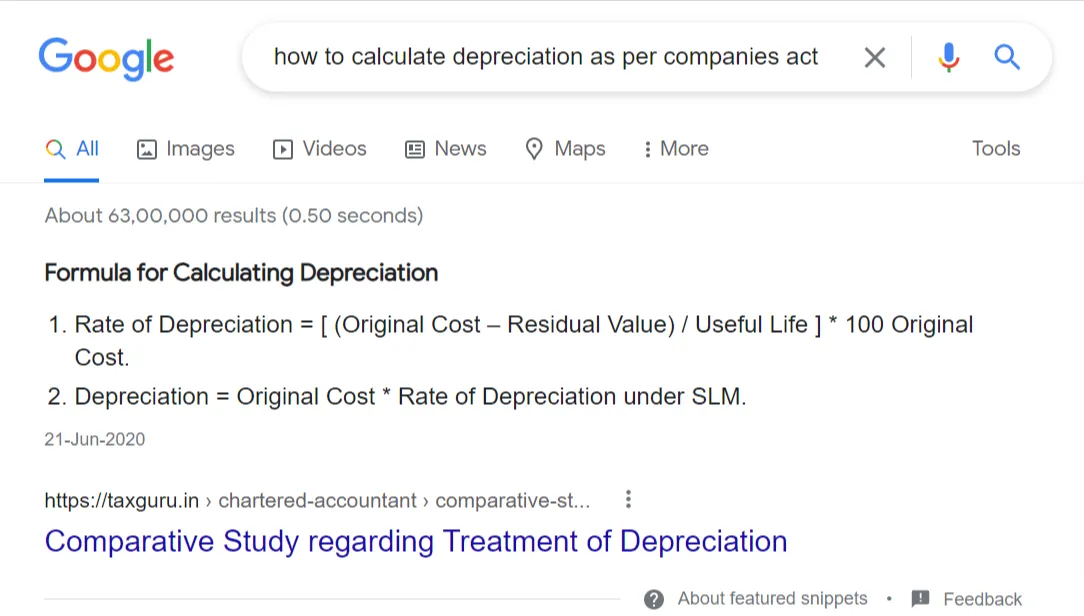

8. 構造化データ

構造化データは検索エンジンの言語であり、コンテンツをよりよく理解できるようにします。 これは、検索エンジンがオンライン コンテンツを文脈化し、理解し、検索クエリと正確に一致させるのに役立つ信頼できる語彙 (機械可読な文脈) です。

構造化データはランキング要因ではありませんが、検索エンジンがコンテンツを正確にランク付けし、リッチ スニペットの形式で SERP に直接より多くの情報を表示できるようにします。

SEO の世界では、構造化データとは、ページに何らかの形式のマークアップを実装して、コンテンツに関する追加のコンテキストを提供することです。 構造化データを追加すると、ウェブサイトはリッチ スニペット、リッチ カード、カルーセル、ナレッジ グラフ、ブレッドクラムなどの強化された結果を活用できます。

通常、検索エンジンは、microdata、JSON-LD、microformats の 3 つの構文をサポートしています。 また、Schema.org と Microformats.org の 2 つの語彙もサポートしています。

これについてもっと学びましょう。

を。 スキーマ マークアップ

スキーマ マークアップはスキーマとも呼ばれます。 これは、ページのコンテンツを体系的に記述する標準化されたタグのセマンティック ボキャブラリであり、検索エンジンがコンテンツのコンテキストを取得しやすくします。

現在利用可能なスキーマは797 ありますが、SEO の価値に最も貢献する次のスキーマを追加することをお勧めします。

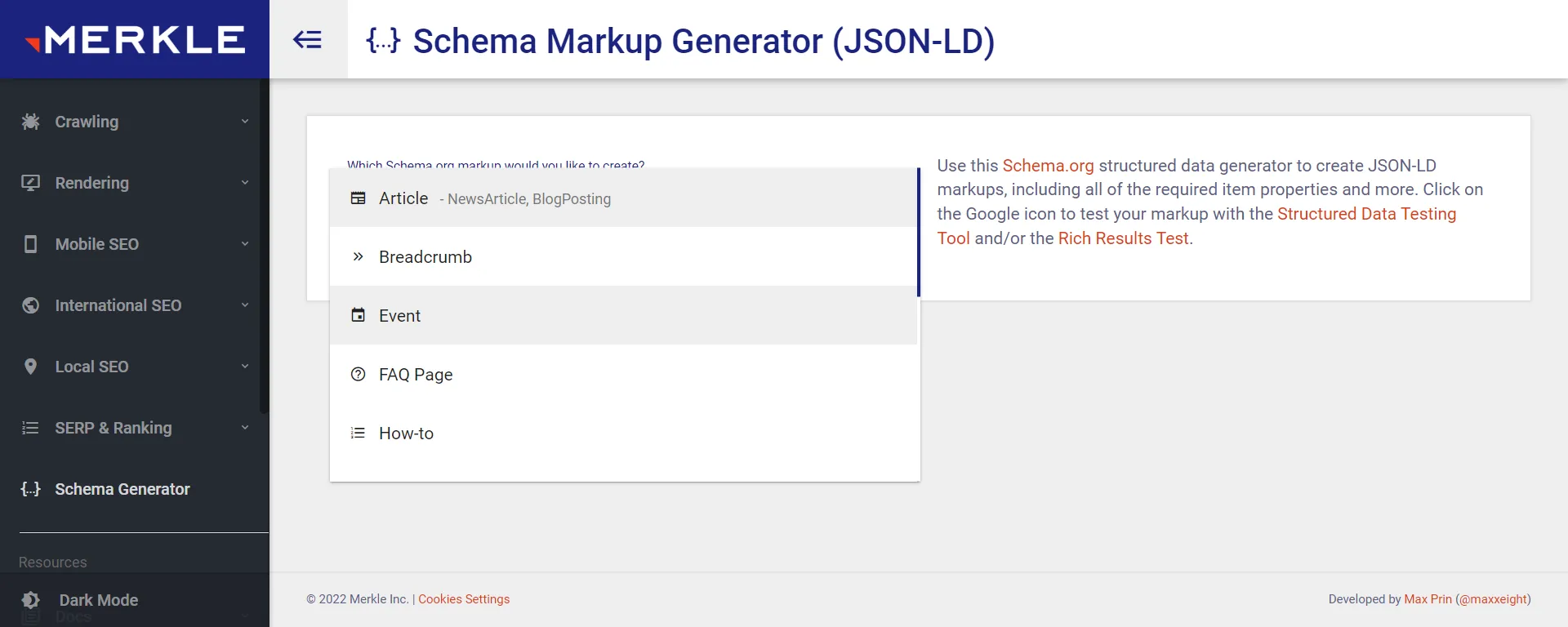

Merkle Schema Markup Generator は、Web サイトのスキーマ マークアップを生成するのに役立ちます。

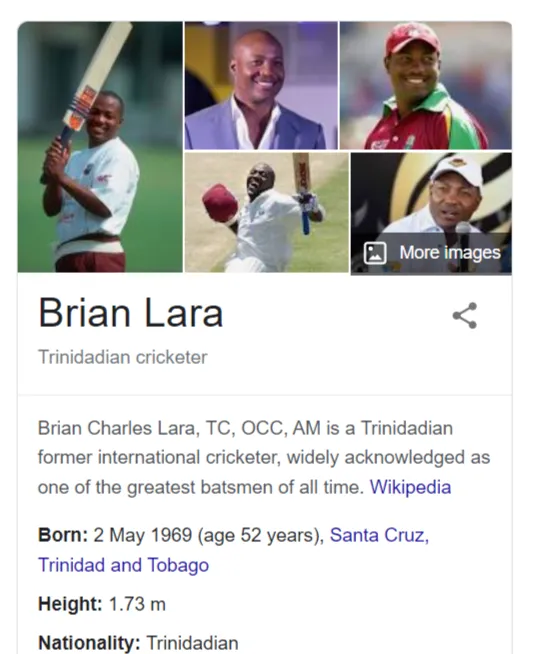

- 個人:ページに記載されている個人に関する基本情報を検索エンジンと共有します。 このマークアップは、ブログの著者の略歴セクションまたはチームの詳細に言及するページに適用できます。

- Organization/LocalBusiness:これは、会社の Web サイトの About Us ページまたは Contact Us セクションに追加する重要なスキーマです。

- 製品:このマークアップは製品ページに追加されるため、詳細な検索スニペットが得られます。

- ブレッドクラム:ブレッドクラムを使用すると、ユーザーは Web サイトを簡単にナビゲートし、階層内のページの位置を確認できます。 このマークアップは、このエクスペリエンスを検索スニペットにもたらします。

- 記事:これは、Web サイトの記事やブログの投稿に追加される人気のあるマークアップです。 これにより、Google はコンテンツに関する基本情報を取得できます。 たとえば、Google は見出し、著者、発行日などに関連するデータを取得します。

- ハウツー: SaaS Web サイトにハウツー コンテンツがある場合は、このマークアップを活用する必要があります。 このマークアップは、段階的なアプローチを使用して特定の目標を達成する方法を Google が理解するのに役立ちます。

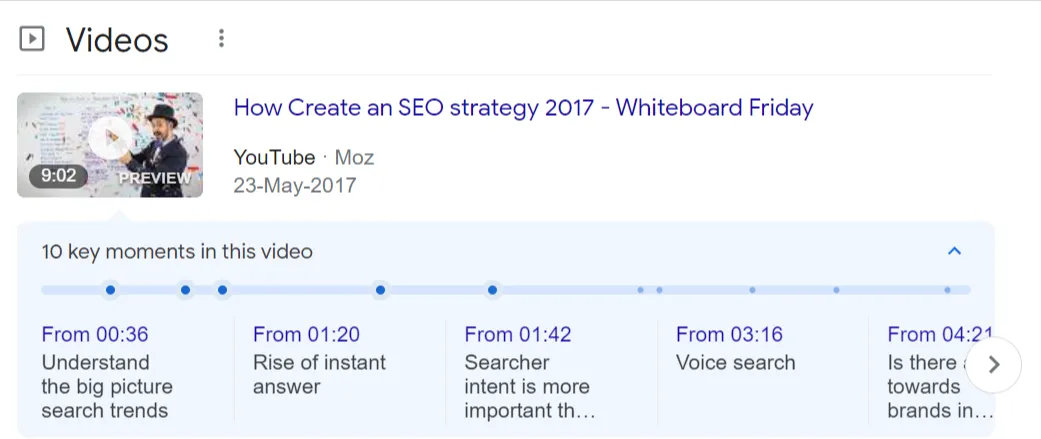

- FAQPage: FAQPageマークアップは、よくある質問のリストと包括的な回答を共有するページで使用されます。

- VideoObject:このマークアップは、動画コンテンツに関する基本情報を Google に提供するため、Web サイトでホストされている動画に追加されます。 指定する必要がある要素は、動画の説明、動画の長さ、サムネイルの URL、アップロード日です。

b. マイクロデータと JSON-LD

Google は JSON-LD と microdata 構造の両方をサポートしていますが、前者は軽量であるため、Google が推奨する構造化データ形式です。

- JSON-LD (リンクされたデータの JavaScript オブジェクト表記)

前述のように、JSON-LD は最も人気のある構造化マークアップ スクリプトであり、Google で最も推奨されるバージョンです。 これは、HTML ドキュメントの残りの部分を乱すことなく、コードのブロックとして実装できるためです。

- マイクロデータ

Microdata を使用すると、機械で読み取り可能なタグを使用して、Web ページ上のさまざまな HTML 要素にラベルを付けることができます。 実際、これは、構造化データの Web ページ上のアイテムと値を強調する一連のタグに基づいています。

HTMLソースコードに埋め込まれているため、microdataの実装・編集・削除に時間がかかります。

c. リッチ スニペット

URL、タイトル、説明とともに表示される情報を保持するあらゆる形式のオーガニック検索結果リストは、リッチ スニペットです。

関連する Web ページに構造化データを実装しても、リッチ スニペットでの表示が保証されるわけではないことに注意してください。

Google は、特定の結果をリッチ スニペットまたはリッチ カードとして表示する際に、ウェブサイトのオーソリティ、信頼性、およびその他の要因などの要因を考慮します。

9. 移行

ドメイン名の変更や HTTPS の実装は賢明な方法ですが、ウェブサイトのランキングを維持しながらこれらすべてを行うのは簡単ではありません。 Web サイトのトラフィックやコンバージョンを失うことなくスムーズに移行を完了するには、厳密で細心の注意を払った調査、計画、実行、および監視が必要です。

それが SEO 移行のすべてです。移行を行う際に、検索ランキング、オーソリティ、およびインデックス作成シグナルを転送します。

適切に実行されない場合に SEO に影響を与えるさまざまなタイプの移行を見てみましょう。

を。 ドメインの移行

これは、すべてのコンテンツとリソースとともに、現在の Web サイトの URL を新しいものに変更するときです。 ドメインの移行は通常、ブランド変更、場所固有のドメインへの変更、またはホストされたサービスをドメインに移動するときに行われます。

コンテンツの変更、つまり、コンテンツの統合と書き換え、コンテンツのプルーニングなどが含まれます。 これらすべてがウェブサイトの分類法と内部リンクに影響を与え、サイトのオーガニック検索の可視性に影響を与えます.

ここでは、SEO を損なわずにドメインを変更するための簡単なヒントをいくつか紹介します。

- 新しいドメインの履歴を確認してください。 たとえば、そのバックリンク ネットワークについて学習し (これにはAhrefs バックリンク チェッカーを使用します)、過去に赤旗が立てられていないかどうかを確認します。

- 古いドメインを新しいドメインにリダイレクトします。 これは、ドメイン レジストラーまたはホスティング プロバイダーを通じて調整できます。

- Google Search Console を使用して新しいサイトを確認します。 このプラットフォームは、各ページのキーワードのパフォーマンスに関する情報を提供し、上位の技術的問題を指摘します。

- ビジネス プロフィールの古い URL に関するすべての言及を更新します。

- 新しい URL で Google アナリティクスを更新します。

b. 再起動

ウェブサイトのリニューアルは企業にとってエキサイティングな時期ですが、サイトの SEO パフォーマンスに深刻な悪影響を与える可能性があります。 このサイトでは、コンテンツの欠落、リダイレクトの誤りまたは欠落、内部リンク構造の変更、エラー ページを指すインバウンドリンク、JS でレンダリングされたコンテンツの変更、およびその他の技術的な問題などの問題が発生します。

たとえば、ウェブサイトのリニューアル後に直面する最悪の問題の 1 つは、クロールとインデックス作成の問題です。

再起動中にトラフィックが失われないようにするためにできることをいくつか紹介します。

- 優先コンテンツを新しい Web サイトに移行する

- 必要に応じて 301 リダイレクトを正しく完全に実装する

- 内部リンク構造とインバウンドリンクを改善する

- ページ上の最適化をすべて移行する

- 再起動前のテクニカル SEO 監査を実施する

- モバイル レンダリングおよび JavaScript でレンダリングされるコンテンツとリンクの変更に注意してください

c. CMS の変更

CMS の再プラットフォーム化は、ある CMS から別の CMS に移動するときに発生します。 これは通常、Web サイトをよりインタラクティブで機能豊富にし、パフォーマンスを向上させるために行われます。

たとえば、WordPress から Drupal に移行したり、Drupal 7 から Drupal 9 にアップグレードしたりします。

CMS を変更する場合、ウェブマスターはウェブサイトにいくつかの変更を加えます。 すべての CMS の変更によってトラフィックが失われるわけではありませんが、このプロセスはサイトの SEO パフォーマンスに影響を与えます。 CMS の変更には、古い URL 構造を維持できない、メタ タグと H1 の異なるテンプレート、サービス ファイル (robots.txt と XML サイトマップ) への異なるアプローチなどの問題が伴います。

これらの問題を克服する方法を次に示します。

- この投稿で言及したクローラーのいずれかを使用してクロールを実行します。 これにより、主要な技術的問題が指摘されます。

- メタ情報、URL 構造、サイト アーキテクチャ、正規タグ、robots.txt、構造化データ、Hreflang などの CMS 機能を評価します。

- URL マップでリダイレクトする URL を指定します。

d. HTTP から HTTPS

これは、サイト プロトコルを安全でない「http」から安全な「https」に変更する場合です。

SEO フレンドリーな HTTPS 移行を確実に成功させる方法は次のとおりです。

- JetOtopus や Screaming Frog などのクローラーを使用して、現在の http サイトに存在する URL と内部リンクをクロールします。

- SEMRush または Ahrefs を活用して、現在のキーワードのパフォーマンスを監視します。

- 信頼できるソースから SSL 証明書を購入し、最新であることを確認してください。

- 各 URL をマッピングして、HTTP サイトのどの URL が新しい HTTPS サイトのどこにリダイレクトされるかを概説します。

- コンテンツとデザインの変更は待つことができます。

- サイト内のハードコーディングされたリンクを HTTPS に更新します。 サーバー側の 301 リダイレクトを使用して、ユーザーと検索エンジンを HTTPS ページにリダイレクトします。

- HTTP を使用してサード パーティのサイトにリンクしている可能性がある、安全でないコンテンツがないか Web サイトをスキャンします。

- robots.txt ファイルを更新して、まだ http ディレクトリまたはファイルを指している可能性があるハードコーディングされたリンクまたはブロック ルールを削除します。

- サイトが忙しい時間帯に移行を実行することは避けてください。

- HTTPS バージョンを有効にします。

- HTTPS バージョンを GSC に追加し、優先ドメイン ステータスを設定します。

- 新しいバージョンのサイトについては、GSC でサイトマップを送信してください。

- サイトが正しくクロールされ、インデックスに登録されていることを確認します。

- 履歴が失われないように、[管理] と [プロパティの設定] で Google アナリティクス プロファイルを HTTP から HTTPS に更新してください。

- ターゲットを絞ったキーワードの掲載結果を定期的に監視しますが、数週間の変動が予想されます。

10. コア Web バイタル

ページ エクスペリエンスとユーザー エクスペリエンスは、Google がページをランク付けする際の中心となる 2 つの要素です。 Core Web Vitals (CWV) は、Google のパラメーターに基づいてページ エクスペリエンス スコアを評価する特定の要素です。

CWV は、ページ エクスペリエンスの 3 つの重要な側面である、読み込みのパフォーマンス、応答性、視覚的な安定性を評価します。 これらのメトリクスは、訪問者がページに到達したときの UX に直接関連する要因を測定します。

- Largest Contentful Paint (LCP) :読み込みは、Web ページ上の最大のアセット (画像または大きなテキスト ブロック) が表示可能になるまでにかかった時間を測定します。

- 最初の入力遅延 (FID):対話性は、Web サイトの訪問者がページを操作できるようになるまでの時間を測定します。 リンクをクリックできるようになるまで、またはフィールドに入力できるようになるまでの遅延です。

- Cumulative Layout Shift (CLS):この指標は、ページの視覚的な安定性に関連しています。 ページの読み込み中に移動要素や不安定な要素があると、ユーザーが間違ったリンクをクリックする原因となり、ユーザーの不満やページ エクスペリエンスの低下につながります。

さらに、Google は、HTTPS、モバイル フレンドリー、安全なブラウジング、インタースティシャル ポップアップの欠如などの要素も考慮しています。

Core Web Vitals について詳しく知りたい場合は、見逃してはならない CWV のすべての側面に光を当てる詳細な投稿を読むことをお勧めします。

それでは、CWV を改善するために実行できるさまざまな対策を見てみましょう。

を。 リッチメディアとスクリプトの圧縮

圧縮とは、ソース コードから不要な文字を削除して、コードを最小化または縮小することを意味します。 たとえば、空白の削除、条件ステートメントの最適化、密接に配置された変数宣言の結合、改行文字と冗長データの削除などです。

リッチ メディアとスクリプトの圧縮は、ファイル サイズが小さいため、アプリケーションの読み込み時間と全体的な Web パフォーマンスを向上させる効果的な手法です。

b. CSS スプライト

CSS スプライトは、複数の画像を Web サイトで使用する単一の画像ファイルに結合するのに役立ち、それによって Web サイトのパフォーマンスが向上します。

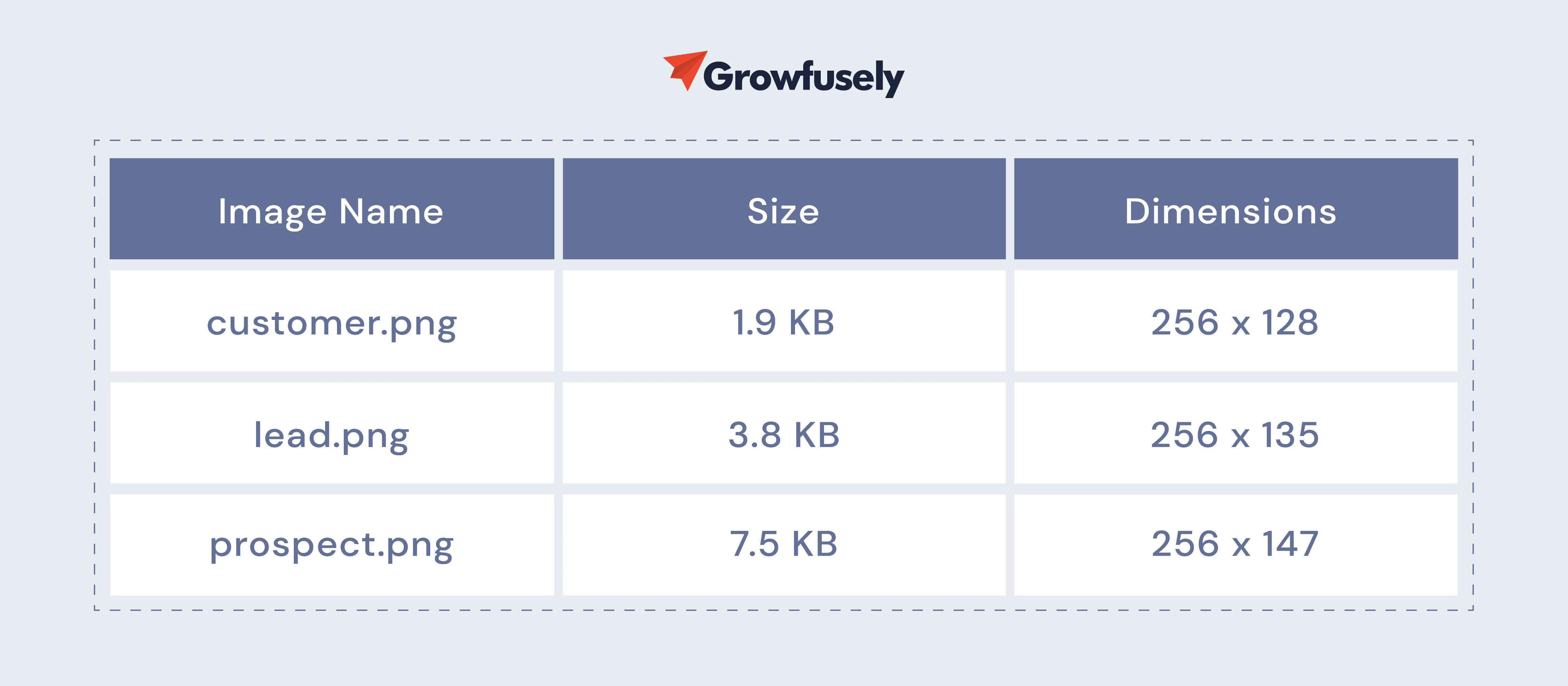

小さな画像を大きな画像に結合するのは直観に反するように聞こえるかもしれませんが、スプライトはパフォーマンスの向上に役立ちます。 これらのファイルをチェックしてください。

これらのサイズを合計すると、合計で 13.2 KB になります。 しかし、これらの画像を 1 つのファイルに追加すると、さらに重くなります。 しかし、これらの画像は単一の HTTP リクエストで読み込まれます。 このように、ブラウザーは Web サイトによって行われる同時要求の数を制限し、それによってサイトのパフォーマンスを向上させます。

c. CDN

コンテンツ配信ネットワークまたは CDN は、アセット (画像、CSS、JavaScript) を複数のエッジ ロケーションにキャッシュすることで、サイトのパフォーマンスとページの読み込み時間を向上させることが知られています。 これらは、ユーザーから 60 ミリ秒以内に地理的に分散されています。

静的コンテンツをキャッシュすることで、CDN は CWV スコアを上げながら、エンド ユーザーの全体的なエクスペリエンスを向上させることができます。

- CDN はどのように LCP を改善しますか?

CDN は、エンド ユーザーの近くにあるサーバー ファーム内のサイトの静的コンテンツを予約します。 したがって、コンテンツは、ユーザーデバイスとの間を移動する距離が短くなります。 これにより、ロード時間が大幅に短縮されます。

- CDN はどのように FID を改善しますか?

Web サイトの読み込みにかかる時間が短いほど、ユーザーはより速く要素を操作できます。 CDN を使用すると、ユーザーは最小限のレイテンシーでウェブサイトの要素を利用できるため、全体的な遅延が減少します。

- CDN はどのように CLS を改善しますか?

累積レイアウト シフトは、画像のサイズが不適切な場合や、画像がゆっくりと表示される場合によく発生します。 CDN を使用すると、静的アセットはユーザーに配信される前に最適化され、サイズ変更されます。

ここで注意すべきもう 1 つのポイントは、ユーザーが複数のデバイスを使用して Web サイトにアクセスしており、インターネットの品質がさまざまであることです。

d. サーバー速度の最適化

行われたリクエストに対するサーバーの応答が速ければ速いほど、サイトの速度指標に改善が見られます。 多くの場合、複雑なエンタープライズ Web サイトには、複数の要求を処理し、ファイルやスクリプトを提供するためにビジー状態のサーバーがあります。

これらのプロセスを最適化して、読み込み時間を短縮することをお勧めします。 サーバー速度を最適化するための簡単なヒントを次に示します。

- ホスティング プランをアップグレードします。 適正な価格で優れたパフォーマンスを提供するものを選択してください。

- 最新バージョンの PHP を使用します。

- データベースがどのように機能するかを調査し、最適化の機会を見つけます。

e. 並列ダウンロードと縮小

ページの読み込み時間を短縮する最善の方法の 1 つは、スプライトを介してダウンロードするリソースの数を減らすことです。 または、CSS/JS などの外部リソースを組み合わせて縮小することもできます。

ただし、これらの最適化が機能しない場合は、並列ダウンロードが機能します!

並列ダウンロードは、複数のドメインで同時に実行される複数のダウンロードですが、ホストは 1 つのホストです。 並列ダウンロードの主な利点は、ダウンロード時間が短縮されるため、ページ全体のパフォーマンスが向上することです。

通常、ブラウザは同時ダウンロード数を制限しています。 ただし、並列ダウンロードを有効にすると、リソース要求が複数のドメインに分割されます。 そのため、ロード時間が大幅に短縮されます。

サイトのブロックに時間がかかっている場合、またはほとんどのユーザーが古いブラウザー (IE6/7 など) を使用している場合は、並列ダウンロードを実装するとパフォーマンスが向上する可能性があります。

f. キャッシング

ユーザーがページにアクセスすると、ブラウザはサーバーと通信します。 このプロセスには一連のタスクが含まれます。つまり、PHP の処理、データベースへのリクエストの作成、ファイルをブラウザに送り返して完全に形成されたページに組み立てます。

このプロセスには、数秒または永遠にかかる場合があります。

ページ キャッシングにより、サーバーの応答プロセスが高速化され、TTFB (Time to First Byte) またはサーバーの応答時間が短縮されます。 これは、超高速の応答時間に変換され、ページ エクスペリエンスが向上します。

11. コンテンツの最適化

テクニカル SEO はコンテンツとはまったく関係ありませんが、その一部はオンページ SEO (コンテンツ中心型) と重なっています。 したがって、コンテンツの最適化と、それが検索ランキングに与える影響について説明します。

を。 エンティティの最適化–

SEO におけるエンティティの役割は非常に大きいです。 時間の経過とともに、Google はキーワード検索とクエリの真の意味を識別する能力を向上させてきました。 現在、用語ベースの検索からエンティティに移行しています。

簡単に言えば、検索エンジンはエンティティ検索を通じてのみコンテンツを発見するようになりました。エンティティ検索は、関連するソースを検索クエリにマッピングする際にボットがユーザーの意図を理解するために使用する方法です。 このフレームワークに沿っていない検索の専門家は失敗する運命にあります。

アイデアをエンティティに分類すると、コンテンツにコンテキストと関連性を追加できます。 エンティティ検索用にコンテンツを最適化するためにマーケティング担当者が行う必要があることは次のとおりです。

- 検証済みのセマンティック要素を Web インフラストラクチャに統合します。

- コンテンツ内のあいまいな言葉を見つけて排除します。

- コンテキスト内で検索者の関心を引き付けます。

b. 重複コンテンツ

重複したコンテンツは訪問者に価値を与えず、検索エンジンを混乱させます。 また、検索エンジンがコンテンツのオーソリティ、関連性、信頼などの指標を統合する方法を妨げるため、いくつかの技術的な SEO の問題を引き起こす可能性もあります。

重複コンテンツに対処する最善の方法は、優先されない URL バージョンから優先ページへの 301 リダイレクトを実装することです。

また、多くの場合、コンテンツの重複は、HTTP を HTTPS に適切にリダイレクトしないなどの技術的な問題が原因です。 これもチェックが必要です。

GSC のインデックス カバレッジ レポートは、重複コンテンツを見つけるのに非常に役立ちます。 このレポートを使用すると、簡単に見つけることができます –

- ユーザーが選択した正規なしで複製 – 優先バージョンに正規化されていない URL。

- Google が独自に見つけた URL で正規を無視することを選択した場所を複製します。 代わりに、Google が選択した canonical を割り当てます。

- 送信された URL が正規として選択されていない重複 – ここで、Google は、XML サイトマップを介して送信するときに、定義した正規を無視することを選択しました。

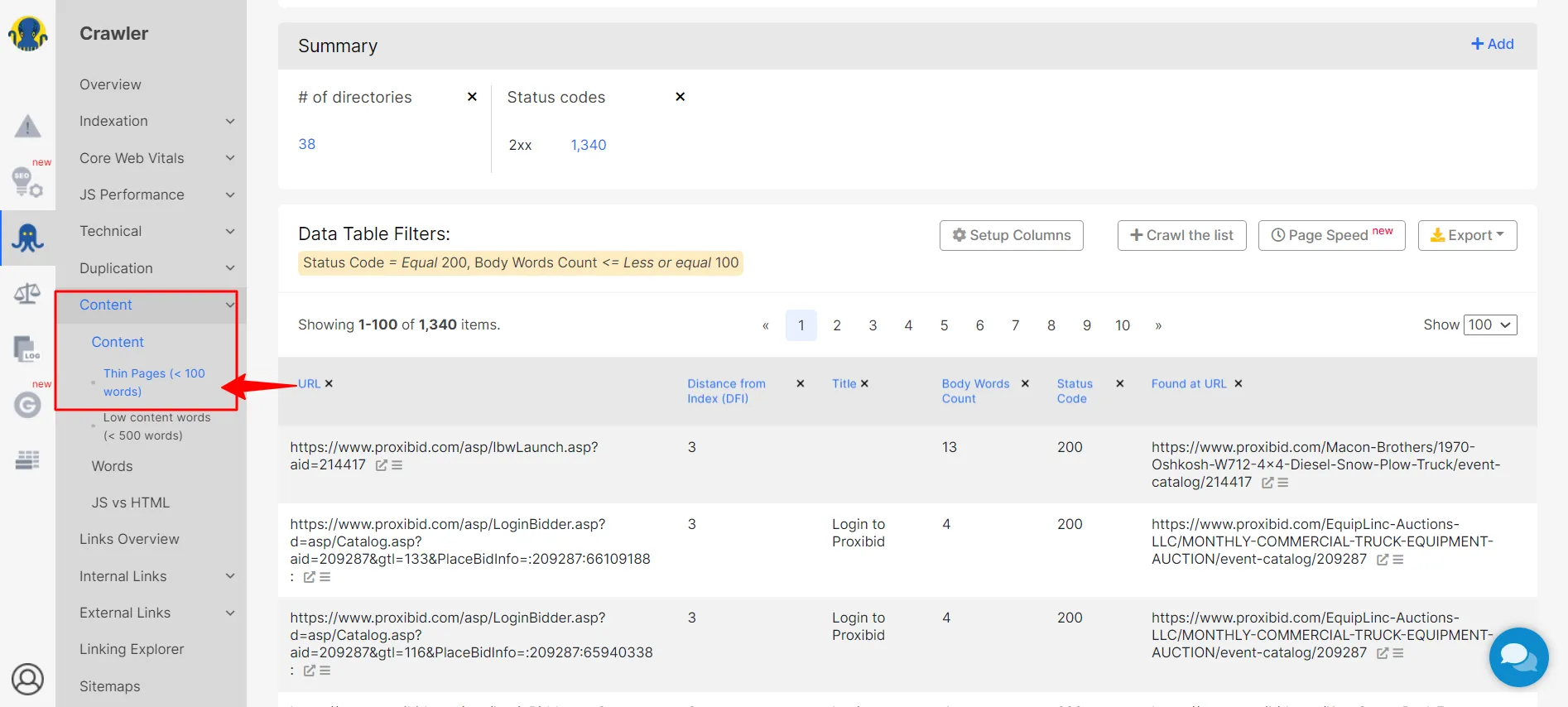

c. シンコンテンツ

シン コンテンツとは、サイトのコンテンツ、テキスト、または視覚要素がユーザーの意図に関連していないか、ユーザーが探しているものを提供していない場合です。 ユーザーにとって薄いコンテンツはほとんど価値がないため、多くの場合、ユーザーはより多くの情報を求めます。

シン コンテンツは、SEO クローラーを使用して簡単に見つけることができます。

これらのページを見つけたら、最初にすべきことは、古いコンテンツを改善することです。 数年前に Google の Gary Illyes がこの件について語ったことを確認してください。

また、これらのページでは no-index メタ タグを使用してください。 それらを完全に削除する代わりに、それらをインデックスに登録しないようにして、クロール時にこれらをカウントしないように Google に指示します。

12. ユーザーインターフェース

技術的な問題は、サイトの UI とユーザー エクスペリエンスに悪影響を及ぼす可能性があります。 たとえば、コンテンツが正しく表示されない、CTA ボタンが機能しない、またはメインのコンバージョン ページが検索結果に表示されない場合があります。

その結果、ユーザー エクスペリエンスが低下するだけでなく、ユーザー アクティビティやコンバージョンが減少します。 したがって、技術的な SEO 監査をタイムリーに行うことが重要です。

たとえば、インデックス作成の問題、robots.txt、コンテンツの重複、コンテンツ表示の問題、構造化データのエラー、ユーザー インターフェースの有効性を低下させる可能性のあるコード エラーがないかどうかを確認する必要があります。

注意すべきいくつかの要因を次に示します。

を。 使いやすさ

技術的なエラーを見つける最善の方法の 1 つは、ユーザビリティ テストです。 これらのテスト中に、ウェブマスターは人々を募集して、ウェブサイトの要素とどのように相互作用するかを確認します。 ユーザーが苦労している場所、ユーザーを混乱させたりイライラさせたりするもの、または障害に遭遇するかどうかを観察します。

人々が苦労している場合、検索エンジン ボットがサイトをクロールする際に問題が発生している可能性があります。

ここでは、技術的な SEO の問題を特定するのに役立つユーザビリティ テストの質問をいくつか紹介します。

- トピックに関するページを簡単に見つけることができますか?

- クリックスルーすると、Web サイトの要素は正常に機能しますか?

- 不適切と思われるページはありますか?

- ウェブサイトの読み込みは速いですか?

- ウェブサイトのレイアウトは読みやすく、理解しやすいですか?

b. ナビゲーション

ボットは、ユーザーと同じようにサイトをナビゲートします。 したがって、サイトのナビゲーションを改善し、すべての訪問者がアクセスできるようにすることが重要です。

これにアプローチする最善の方法は、コンテンツ階層を作成することです。つまり、コンテンツを広いカテゴリに分割してから、狭いサブカテゴリを作成します。 これにより、訪問者 (およびボット!) が探しているコンテンツに簡単に移動できます。

UX を最適化するために、ナビゲーション ブレッドクラムを活用することも検討する必要があります。 パンくずリストも構造化データの一種で、Google が SERP でページのコンテンツを整理するのに役立ちます。

c. ポップアップ

邪魔にならないポップアップはユーザーにとって便利ですが、邪魔になるポップアップは、最終的にサイトの SEO に影響を与える長期的な UX/UI の問題を引き起こす可能性があります。 これらのポップアップまたはバナー広告がページの 15% 以上を占める場合、 CLS (累積レイアウト シフト) も引き起こし、UX を著しく妨げます。

言うまでもなく、Google は彼らに有利ではありません。

ソリューション?

Google が嫌うインタースティシャルは避けてください。

- メイン コンテンツを覆うポップアップ。ユーザーは、ページを探索し続けるためにポップアップを閉じる必要があります。

- メイン コンテンツにアクセスする前に閉じる必要があるスタンドアロンのポップアップ。

- ポップアップのように見えるセクションを含む不正なページ レイアウト。

- ユーザーがページをクリックしたときに予期せず起動するポップアップ。

- 訪問者が誤ってクリックした場合に閉じてリダイレクトするのが難しいモーダルをオーバーレイします。

d. 信頼性

UI は、Web サイトが信頼性を伝えるための主要なモードです。 たとえば、サイトのデザイン品質は、Web サイトのコンテンツが信頼できるかどうかについて多くのことを語ることができます。 質の高いウェブサイトのデザインは常に目立ち、評判が良く、視聴者に深い印象を与えます。

UI を通じて信頼性を伝える方法をいくつか紹介します。

- デザインの品質:サイトの構成や視覚的なデザインなどの要素を適切に行うことで、サイトの信頼性を高めることができます。 一方、壊れたリンク、タイプミス、およびその他のエラーの増加は、サイトの信頼性を急速に低下させ、Web サイトが細部にまで注意を払っていないことを訪問者に伝えます。

- 事前開示:訪問者は、ウェブサイトが探しているすべての情報について透明であることを高く評価しています。 たとえば、サイトで連絡先情報やカスタマー サービスの詳細を事前に共有したいと考えています。 同様に、e コマース Web サイトの場合、ユーザーは送料が事前に開示されることを期待しています。

- 正確で更新された情報:正確で最新の情報を共有することは、その Web サイトがドメイン内の権威であることを示しています。

- 権威ある出版物への接続: Web サイトに権威のある Web サイトからのバックリンクと外部リンクがある場合、彼らは共有された情報が孤立して存在するものではないと信じています。 これにより、サイトの信頼性が大幅に向上します。

第 3 章: クローラーのすべてと、クローラーが Web サイトをクロールする方法

SaaS のスタートアップや企業向けの技術的な SEO の核心に入る前に、検索エンジンはログインしたアプリケーションをクロールしないことを理解することが重要です。

ログイン Web アプリについて

ログインした Web アプリケーション データがインデックスに登録されないようにする方法は次のとおりです。

- それをサブドメインに配置し、robots.txt でそのサブドメインをブロックします

- ログインしたページは、ロボットでブロックできるサブフォルダーに配置します。 txt (たとえば、site.com/app/ の次に Disallow: /app/)

逆に、コンテンツをクロールさせたい場合は、ログインの壁の後ろに置かないでください。

ログアウトしたユーザーが時々アクセスできるログイン済みのコンテンツがあることを示す方法はありますが (ペイウォールのあるニュース出版物を考えてみてください)、SaaS アプリの 99.9% はこれについて考える必要はありません。

それでは、クロールとは何か、クローラーがどのようにクロールするのかについてのセクションに移りましょう。

前述したように、検索ボットが Web サイトを簡単にクロールできるようにする Web サイトを構築することは、ページのランキングにとって重要です。 ただし、Web サイトをボット対応にする方法を知るには、ボットがサイトをクロールする方法を理解する必要があります。

クローラーはどのように Web サイトをクロールしますか?

検索エンジンのボット、クローラー、またはスパイダーは、インターネットを体系的にクロールしてページをインデックスに登録します。 あるページを読んだり、コピーを作成したり、次のページに移動したりと、すばやく移動します。 これらのクロールされたコピーは、他のページと共にインデックスに保存されます。

インデックス作成は、ボットが必要なときにページをすばやく見つけるのに役立ちます。 また、クローラーはリンクと HTML コードを検証して、これらのページに存在するコンテンツを理解します。

その意味で、「クロール」と「インデックス作成」は 2 つの異なる用語 (しばしば同じ意味で使用されます) ですが、同じプロセスの重要な部分です。

SERP でのサイトのランキングを向上させるために Web クローラーがどのように機能するかを次に示します。

- 彼らは URL を掘り出す

ボットが実行するタスクの 1 つは、URL を検出することです。 彼らはこれを介してこれを行います–

– クローラーが過去に検索した Web ページ

– 既にクロールされたページからの Web リンクのクロール

– ウェブマスターが共有するサイトマップを使用して URL をクロールする

URL の発掘は、ボットが Web ページのコンテンツを理解するのに役立ちます。これにより、ページにコンテキストが与えられ、SERP で上位にランクされる可能性が高まります。

- 住所を調べる

URL を見つけた後、ボットは検索エンジンから提供されたアドレスまたはシードをチェックアウトします。 ボットは各 URL にアクセスし、ページ上のリンクをコピーして、今後の探索のために URL バンクに追加します。

サイトマップは、クローラーが以前に発見した情報やリンクにアクセスするのに役立ち、次に調査する URL を決定できるようにします。

- インデックスへのエントリー

ボットがアドレスを調査したら、それらをインデックスに追加します。 後で参照できるように、テキスト ドキュメント、画像、ビデオ、およびその他のファイルを保存します。

- インデックスの更新

検索ボットは、Web ページのインデックスを作成するだけでなく、コンテンツのキーワード、コンテンツの一意性、およびページにコンテキストを提供する重要なシグナルも監視します。 また、新しいページ、既存のコンテンツの変更、無効なリンクにも注意を払います。 これにより、インデックスが常に更新されます。

- 頻繁なクロール

検索ボットは、インターネットを継続的にクロールするために存在します。 検索エンジン ソフトウェアは、クロールするサイトとページ、およびクロールの頻度を決定します。

クロールの頻度を決定する要因には、ページの認識された重要性、Web サイトのクロール需要、最近の更新、検索者の関心レベルなどがあります。 そのため、Web サイトが人気がある場合、クローラーは頻繁にクロールし、SERP に表示され、ユーザーが最新のコンテンツにアクセスできるようにします。

Web サイトを SERP でランク付けしたい場合は、そのページが検索エンジンによってクロールされ、インデックスに登録される必要があります。

新しい Web ページがインデックスに登録されているかどうかは、どうすればわかりますか?

これを確認する最も簡単な方法は、「site:」検索コマンドを使用することです。 Google で「site:yourdomain.com」を検索します。 これにより、そのドメインのインデックスに登録されているすべてのページが表示されます。

クロールまたはインデックス登録の問題に関するより具体的な情報については、サイトマップをGoogle ウェブマスター ツールに送信してください。

要約すると、サイトの構造とナビゲーションが明確であれば、ボットがサイトのコンテンツにアクセスできるようになり、ページのランキングが高くなる可能性が高くなります。

しかし、これらの秘密のクローラーを使用しているのは検索エンジンだけではありません。 SEO は、Web クロール ツールを使用して Web サイトの健全性を分析し、強力なバックリンク データベースを維持できます。 Web サイトの主要な問題の中でも、これらのツールはリンク切れ、コンテンツの重複、欠落しているタイトルやメタデータを見つけることができます。

サイトのページをくまなく調べて SEO の健全性を分析し、ボトルネックやエラーを特定できる Web クロール ツールまたは Web クローラーをいくつか見てみましょう。

クロール ツール

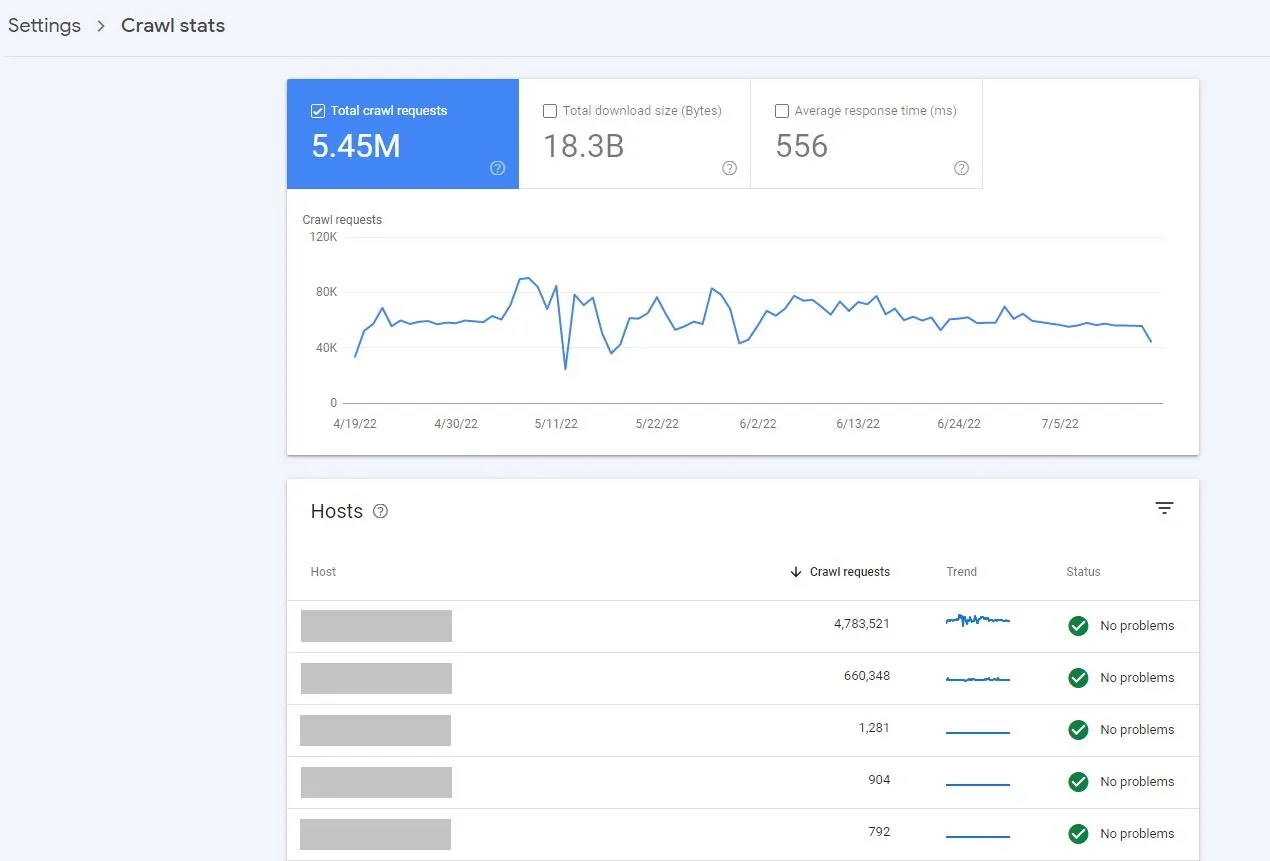

1.Googleサーチコンソール(無料)

Google Search Consoleのクロール統計レポートは、サイトでの Google のクロール履歴に関するデータを提供する無料のツールです。 Search Console でこのレポートにアクセスするには、[設定] (プロパティ設定) > [クロール統計] をクリックします。

このレポートは、興味深い洞察を共有しています -

- サイトの一般公開

- 平均ページ応答時間

- Google によるリクエストの数

- クロールの応答と目的

- Googlebot の種類

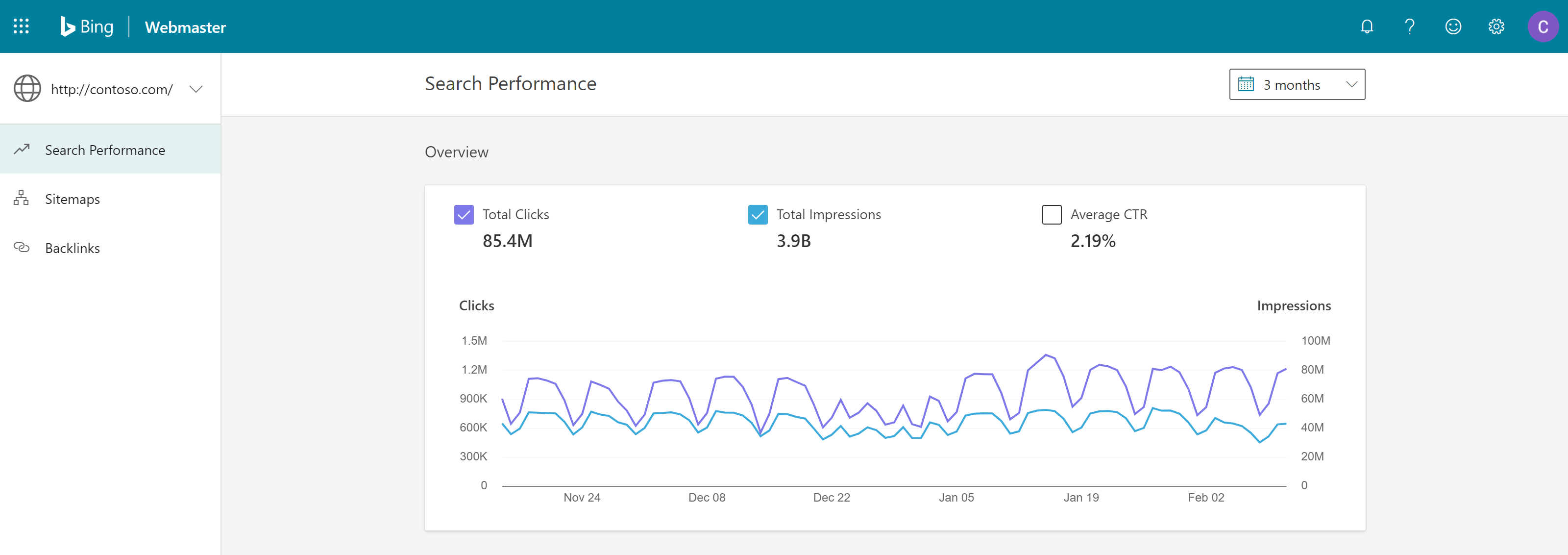

2. Bing ウェブマスター ツール (無料)

Microsoft の Bing は、多様なユーザー層を持つ第 2 位の検索エンジンです。 この検索エンジンの月間検索ボリュームは、全世界で 120 億件にのぼります。 したがって、Bing を無視する余裕のある SaaS ビジネスはありません。

Bing Webmaster Toolsは、Web マスターが SERP でサイトの検索パフォーマンスを改善できるようにする無料のサービスです。 ユーザーは自分の Web サイトを Bing インデックス クローラーに追加して、クリックとインプレッションの観点からサイトのパフォーマンスを監視できます。

このツールにより、ユーザーは次のことができます –

- サイトのパフォーマンスを監視する

- Bing ボットがどのように Web サイトをクロールし、インデックスを作成するかを確認する

- クロールする新しいページを送信する

- クロールされたくないコンテンツを削除する

- マルウェアの問題を特定して解決します。

ツールのクロール制御機能により、ユーザーは Bingbot がページとリソースを要求する速度を制御できます。

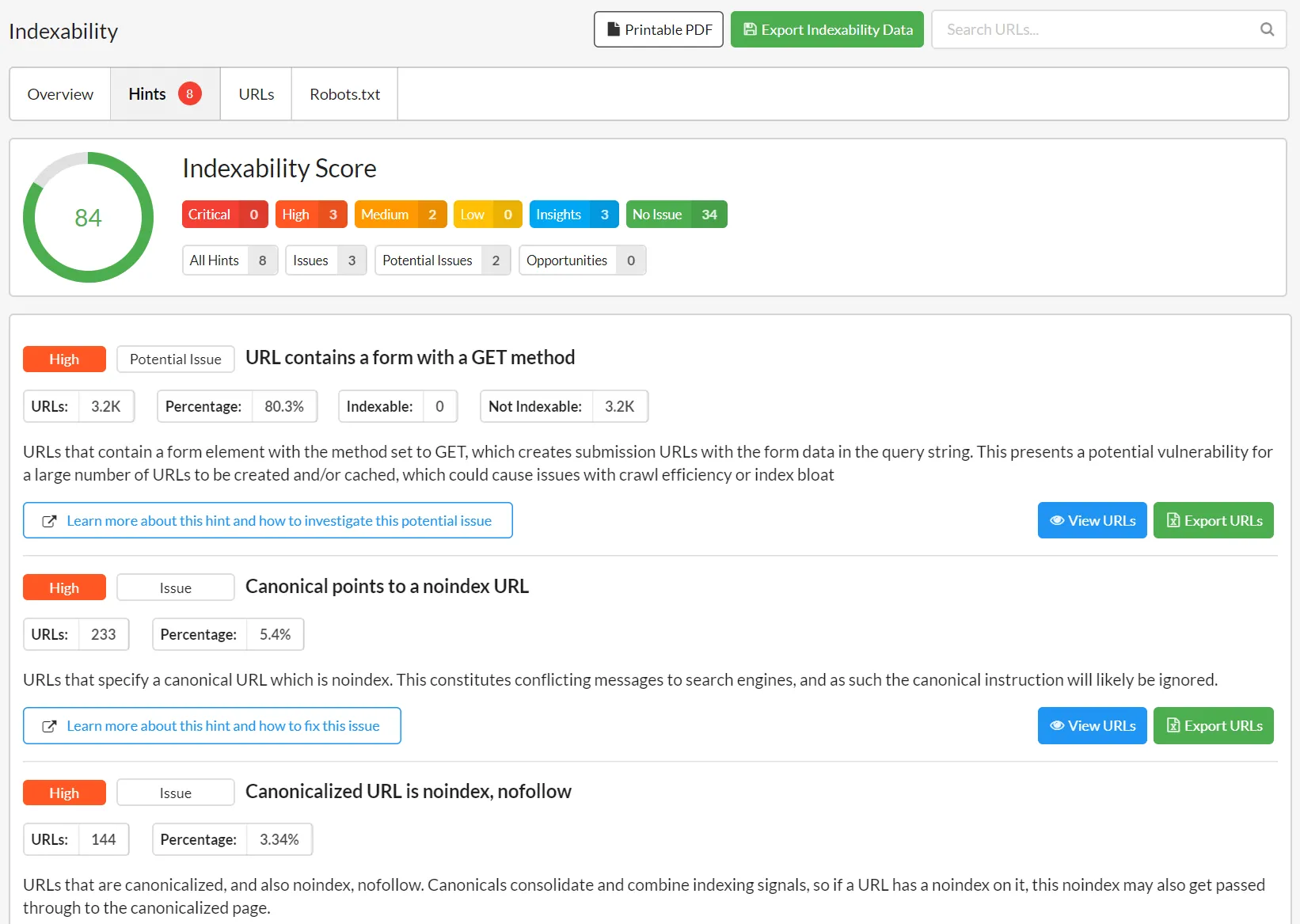

3. Ahrefs ウェブマスター ツールまたは AWT (ウェブサイト所有者は無料)

Ahrefs ウェブマスター ツールは、サイトの検索パフォーマンスを向上させ、より多くのトラフィックを引き付けるのに役立ちます。 このツールは、大量の SEO インサイトを提供します

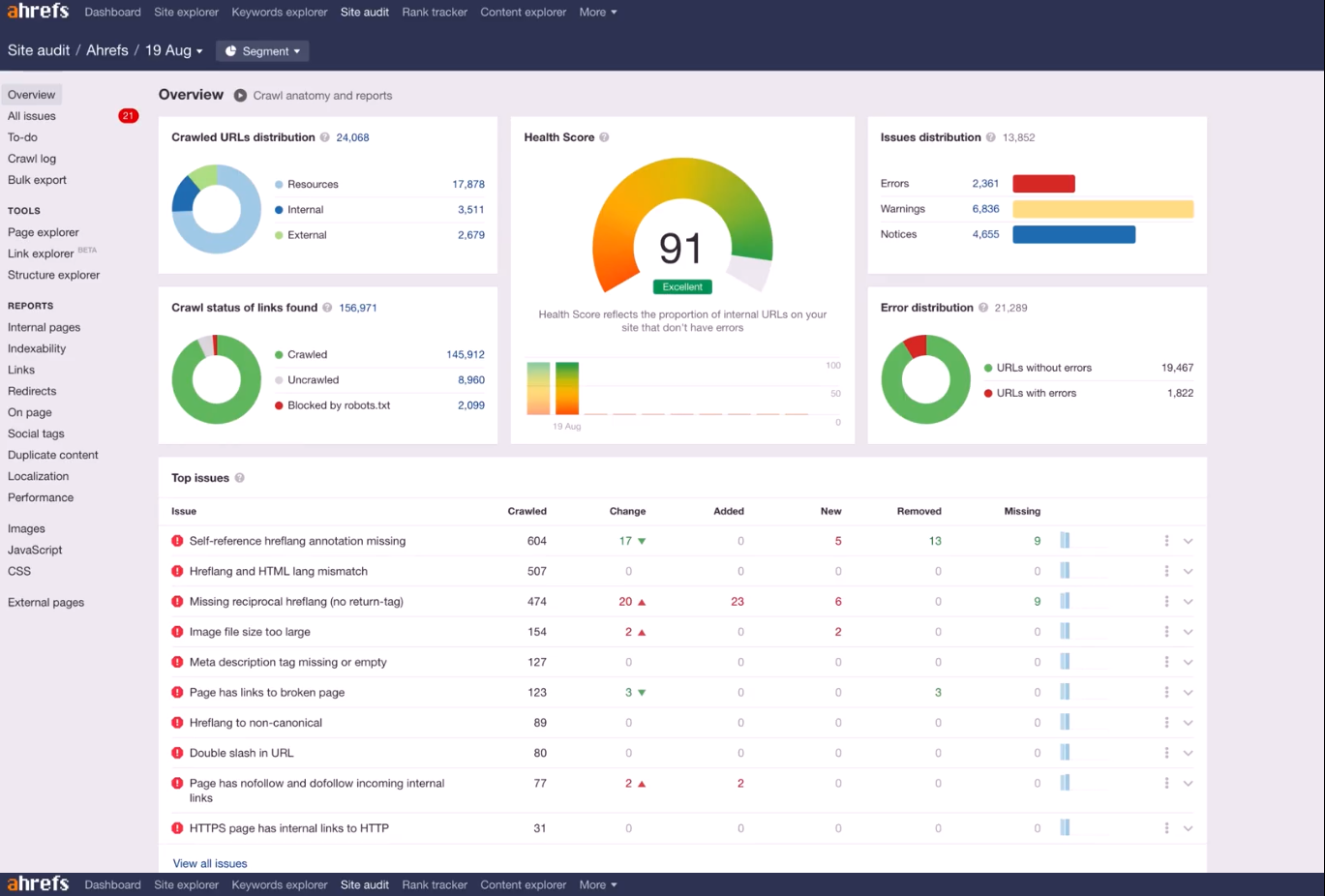

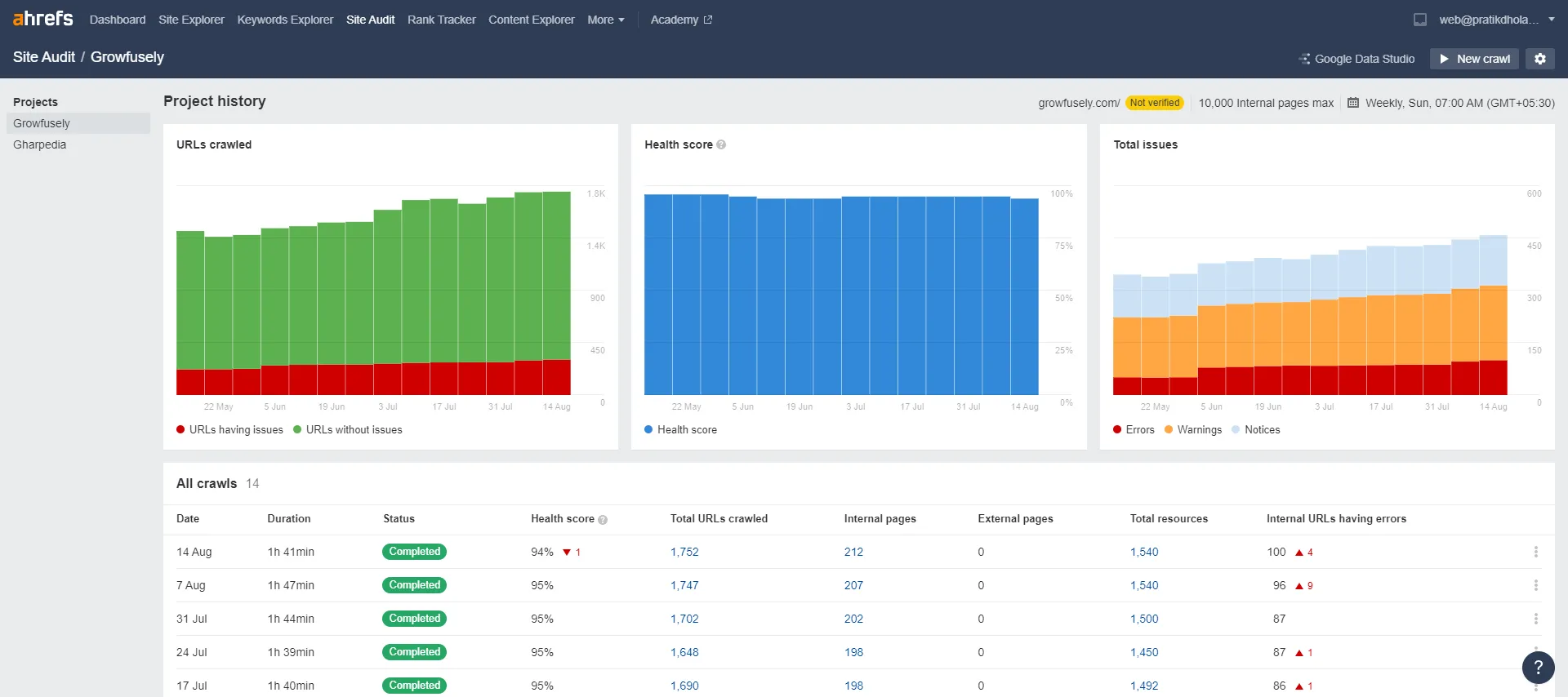

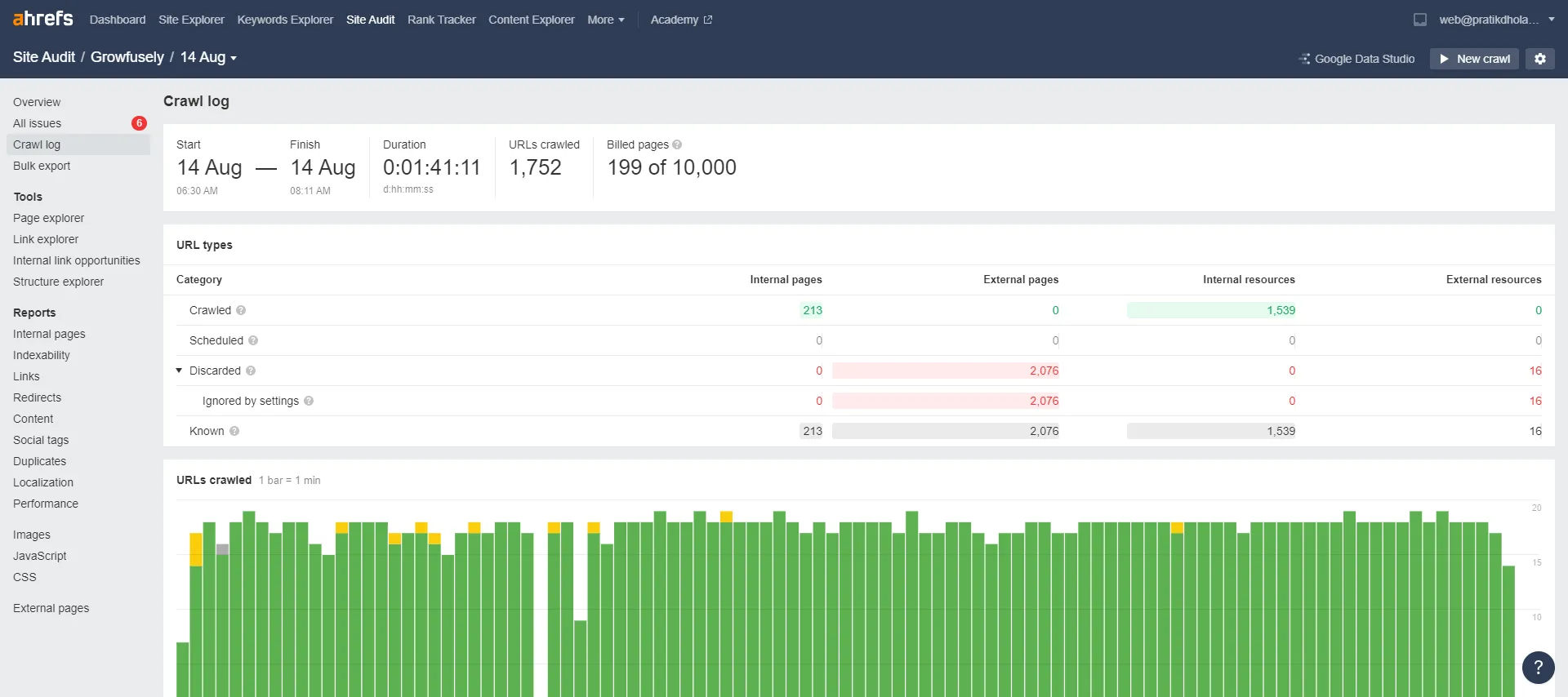

このプラットフォームには、サイト監査やサイト エクスプローラーなどのセクションがあり、サイトの健全性、キーワード ランキング、バックリンク プロファイルを監視、報告、改善します。 AWT 上のデータはユーザー フレンドリーな方法で視覚化されるため、ユーザーは簡単に問題の優先順位を付けることができます。

Ahrefs サイト監査のクロール ログにより、ユーザーは、検索エンジン ボットが Web サイトをクロールするときに発生するクロールの問題を診断できます。

さらに、[レポート] の下の [インデックス可能性] タブには、インデックスを作成できるページとできないページが表示されます。 また、その他の詳細とともに、非インデックス化の原因も示します。

4. Screaming Frog (最大 500 URL まで無料)

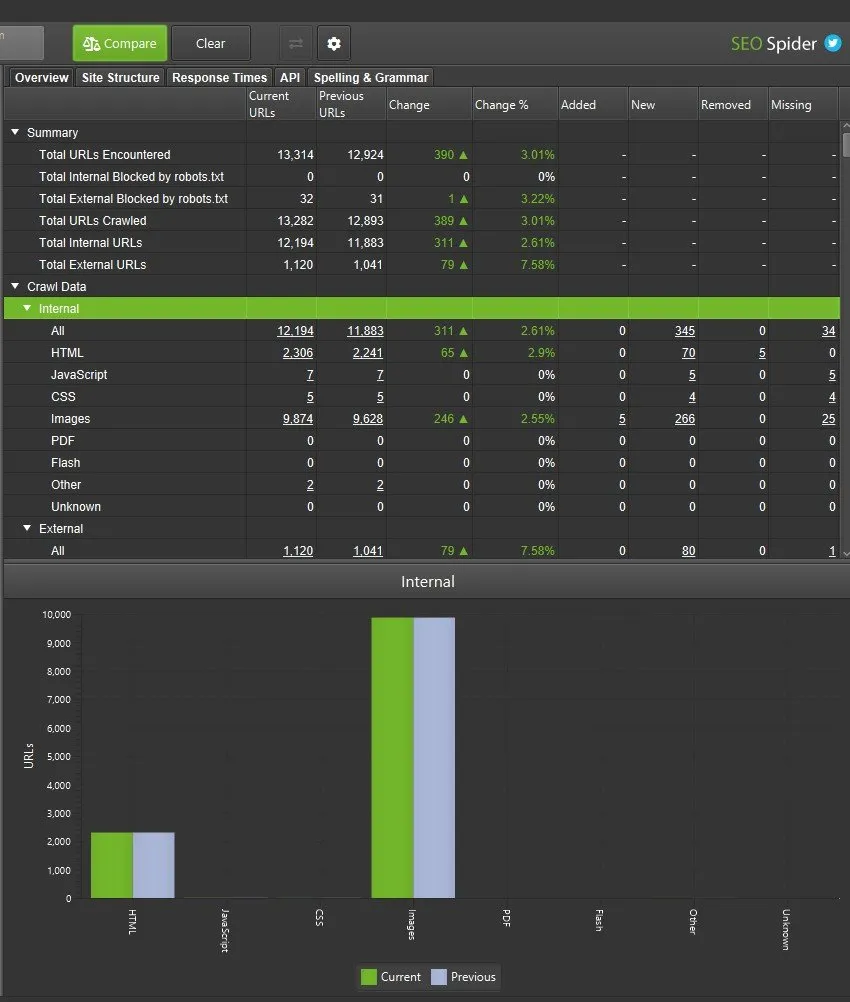

Screaming Frog SEO Spider は、技術的な問題を見つけてオンサイトの SEO を改善するのに役立つ高速で効果的なクローラーです。 このツールは、ユーザーがリアルタイムで結果を分析するのに役立ち、情報に基づいた意思決定を行うことができます。

SEO Spider は柔軟なクローラーであり、小規模および大規模な Web サイトをクロールして、壊れたリンクや重複したコンテンツを見つけ、リダイレクトを監査し、メタデータを分析し、XML サイトマップを生成し、サイト アーキテクチャを視覚化します。 ユーザー インターフェイスで収集されたクロール データを簡単に表示およびフィルター処理できます。

さらに、サイトの監査をスケジュールし、クロール間の SEO の問題と機会の進行状況を追跡できます。

このツールは 500 個の URL を無料でクロールできます。その後、制限を解除して高度な機能にアクセスするには、ライセンスを購入する必要があります。 また、ユーザーはオンサイトの SEO 要素 (URL、ページ タイトル、メタ説明、見出しなど) をスプレッドシートにエクスポートすることもできます。 これは、堅牢な SEO 戦略を考案するのに役立ちます。

全体として、Screaming Frog は使いやすいツールであり、小規模な Web サイトに最適です。

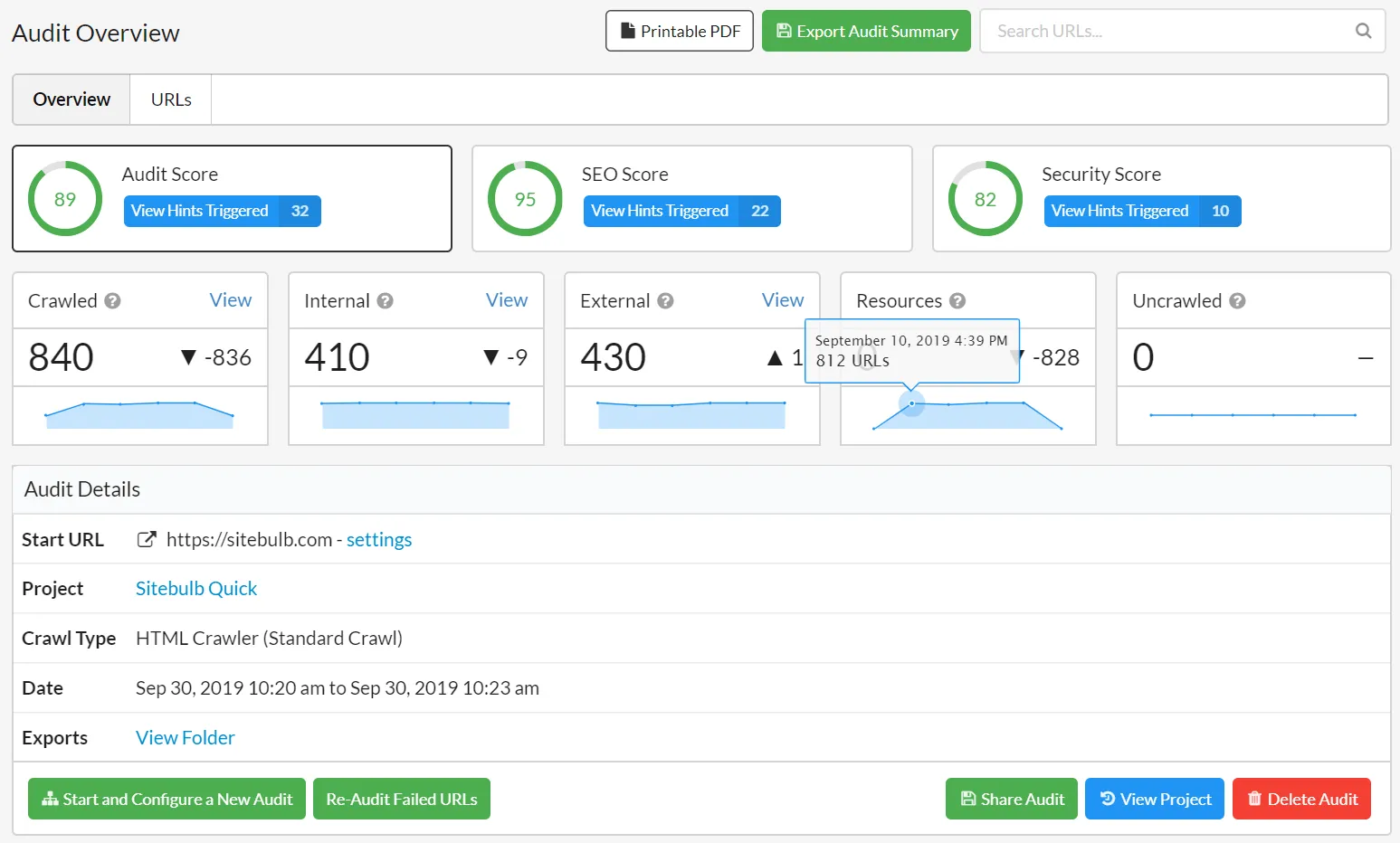

5. サイトバルブ (14 日間無制限アクセス)

Sitebulb は単なる Web サイト クローラーではありません。 このツールは Web サイトを監査し、直感的な推奨事項と視覚化を提供するため、技術的な SEO サイト監査を次のレベルに引き上げます。 ツールが提供する視覚的なレポートは、最も重要な問題と機会に優先順位を付け、ジャーニーの次のステップを提案します。

優先順位付けされたヒントにより、ユーザーは最も重要なものを確認できるため、問題を特定して解決する時間を節約できます。

このツールは、ウェブサイトの技術的な側面に注目するだけでなく、コンテンツの読みやすさやアクセシビリティなどの指標にも注目しています。 このツールには Google アナリティクスと Search Console が統合されているため、Web サイトでの SEO の機会を理解するための強力なツールとなっています。

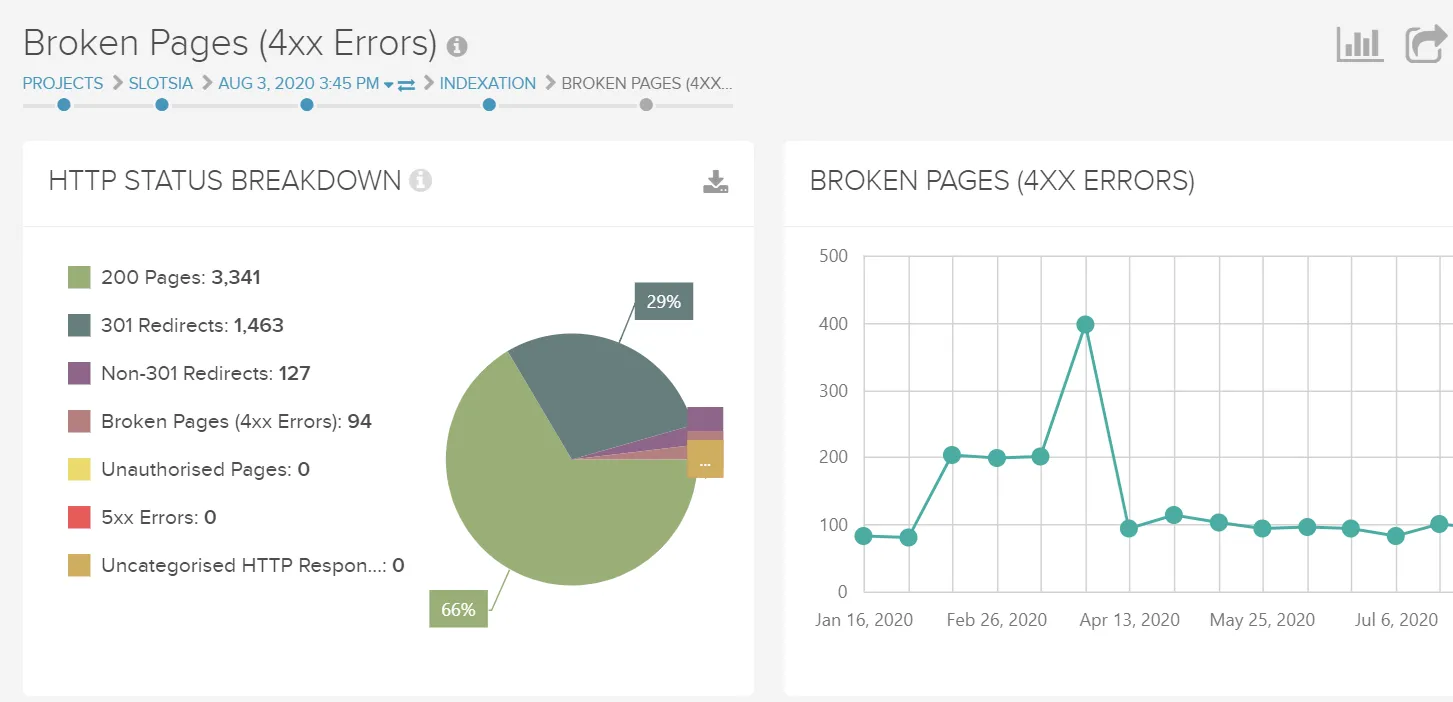

6.ディープクロール

DeepCrawl は、機能の長いリストと詳細な調査機能を提供するため、SaaS Web サイトに最適なツールです。 また、代理店が複数のクライアント Web サイトとそのクロール バジェットを管理できるようにする機能も提供します。 さらに、このプラットフォームは、パスワードで保護されたページや robots.txt を無視する機能などの高度な設定を提供します。

Using DeepCrawl for monitoring your site's technical health can take the guesswork out of spotting issues, especially if you don't have a seasoned SEO professional on your team. The tool can crawl anywhere from 200-page websites to 2.5 million page websites while effectively unearthing technical issues.

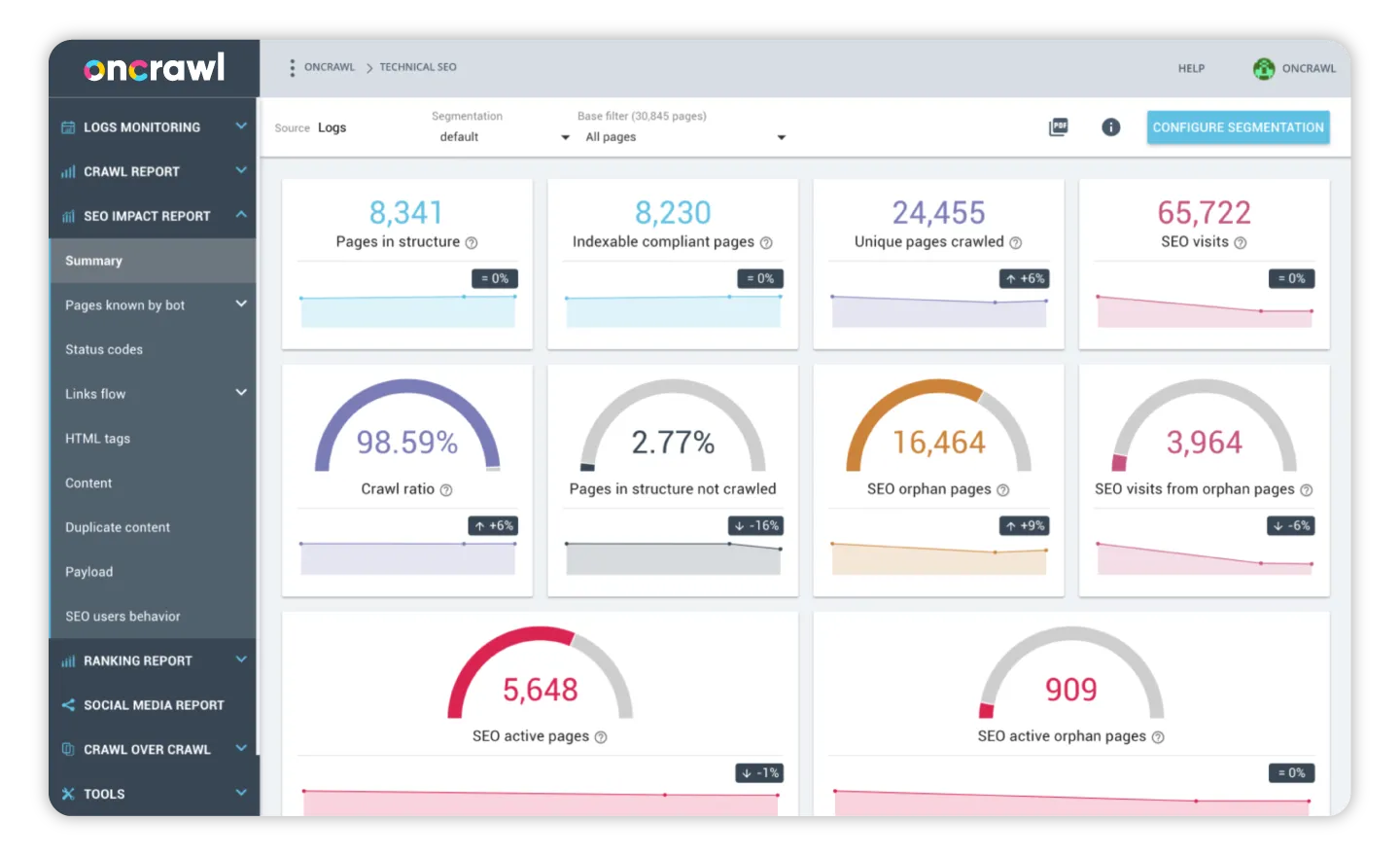

7. Oncrawl (14-day free trial)

Oncrawl is an in-depth SEO crawler and log analyzer that analyzes websites like Google, regardless of their size. The tool relies on more than 600 indicators, advanced data exploration, and actionable dashboards to help you understand how search bots see a website.

Using this tool will give you a clear understanding of the technical issues harming your site performance. You can audit your site to improve the content, HTML quality, page speed, site architecture, and more, thereby driving revenue to your site.

Oncrawl Log Analyzer offers insights into bot behavior, thus allowing you to boost crawl budget and organic traffic.

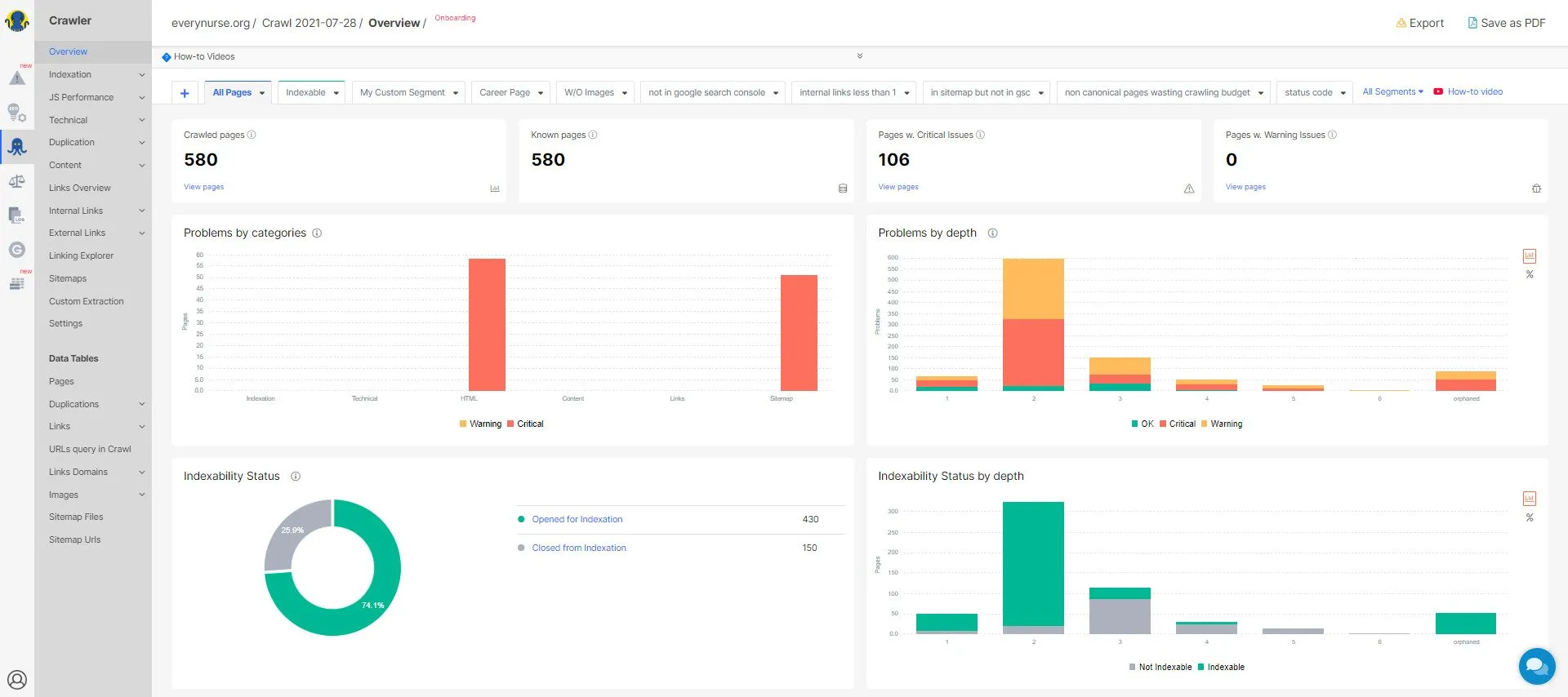

8. JetOctopus (7-day free trial)

JetOctopus is an effective technical SEO tool that offers a range of flexible options for crawling and analyzing logs. The tool's Google Search Console visualization makes it easy for SEO professionals to identify issues in a website and solve them.

The website crawler and log analyzer have no project limits and can crawl large enterprise websites within minutes. JetOctopus has a problem-centric dashboard that clearly shows the scale of issues, allowing users to prioritize them accordingly. The visualizations offer information by category, depth, and load times, thus making it easy for users to navigate between these data sets and visualizations.

JetOctopus's dashboard is devoid of clutter and easy to navigate. The tool focuses on covering website analytics from various angles. Moreover, it offers several filters to drill through the required information. There's also an option to compare crawls, allowing you to see which issues have been resolved and the ones that are yet to be addressed.

The GSC module in JetOctopus allows users to connect their accounts to Search Console. This helps them track their keyword performance on a daily basis.

All the website crawlers shared above are designed to effortlessly crawl websites and spot major crawl issues. Yet, I have shared a few factors that should be considered when investing in a website crawler.

- It should have a user-friendly and clutter-free interface.

- It should highlight the key issues, allowing users to prioritize the most pressing crawl issues.

- It should effectively locate broken links and pages, redirect issues, HTTP/ HTTPS issues, and other issues.

- It should easily detect the robot.txt file and sitemap.

- It should connect with Google Analytics and Search Console for complete data on site performance. This will help you get input about the site's visitors and to investigate your site's traffic patterns.

- It should support multiple devices and file formats.

- It should have a strong customer support team.

- It should have a transparent pricing structure with no hidden expenses.

Though using one of the above-mentioned crawlers can help you spot the key issues in the website, I would recommend using multiple tools. Doing so will audit your website from different angles, allowing no issue to escape.

Also, remember to configure your chosen crawlers in a way you want them to crawl and not to crawl portions of the website. They should be able to handle various web technologies your website is built in.

SaaS is a dynamic field where firms need to consistently come up with the latest content. This makes updating SaaS marketing websites and managing their technical aspects challenging.

Luckily, relying on an SEO-friendly CMS (content management system) makes website management straightforward. Failing to use a suitable CMS could send the wrong signals to search bots, thereby hurting your ranking and traffic.

By choosing the right CMS you can build a strong foundation for your technical SEO efforts. Hence, let's discuss how to choose the right CMS to improve your site's technical health.

Chapter 4: Platforms/CMS for Building SaaS Marketing Websites

A CMS that understands technical SEO features will allow you to control aspects like noindex tags, canonical tags, sitemaps, schema markup, pagination, status codes, and more. Thus, an SEO-friendly CMS will give you the power to control what can or cannot be crawled or indexed by search engines.

Trending Platforms/CMS SaaS Firms Are Using

1. WordPress

WordPress was always believed to be a traditionally-designed CMS. However, over the years, this CMS has evolved to include core features that can cater to any SaaS platform, namely APIs, plugins, themes, extensibility, and scalability. Thus, WordPress is a lifesaver for people who cannot code and want to save their time and resources.

It also offers the multisite feature that allows website owners to create and manage a network of websites on a single dashboard.

Grytics , for instance, is an analytical tool for social groups on LinkedIn and Facebook. The service monitors these groups and finds influencers and people who are most engaged. Their marketing website is built on WordPress. Its WordPress backend is clutter-free and customized to the business needs.

Pros

- Used by thousands of SaaS companies across the globe.

- Ensures easy setup, right from installation to adding plugins of varying complexities.

- Offers a wide scope for customization with countless plugins and themes.

- The Yoast SEO plugin is great at assisting webmasters with all their SEO needs. It is good at managing the technical aspects of a website, including XML sitemaps, canonical URLs, meta descriptions, and more.

- The WordPress REST API is a plus for SaaS firms looking to build their marketing website. The API aims at making WordPress a full-fledged application framework. It allows users to move data in and out of applications using a simple HTTP request. Thus, SaaS could be working on a custom WordPress backend and admin panels.

Cons

- WordPress にはいくつかのセキュリティ上の懸念があります。

- CMS はプラグインに過度に依存しています。 そのため、ユーザーは常に自分のものではないコードを扱っています。

- WordPress を更新するたびに、コストが増加します。

次に、理想的な WordPress ホスティングについて考える必要があります。 優れた WordPress ホスティングにより、インストールと Web サイトが以前よりも安全で、高速で、シンプルになります。 言い換えれば、ウェブマスターが扱いたくないすべての問題を処理してくれます。

私たちが推奨する上位2つのWordPressホスティングプロバイダーは次のとおりです–

- キンスタ

Kinstaは、サーバーのパワーと最適化を備えたプランを提供するクラウドベースの WordPress ホストです。 いくつかの WordPress 管理ツールを提供し、クラウドベースのホストに期待されるすべての速度とスケーリングの利点を提供します.

- WPエンジン

WPEngine は、最速で最も信頼性の高い WordPress ホスティングの 1 つです。 WordPress 固有のサポート、サイトの自動バックアップ、無料の CDN と SSL を提供します。 WPEngine は、サイトが迅速かつ安全に読み込まれるようにしながら、ビジネス要件に従ってホスティング パッケージを調整します。

これは、Web サイトの技術的な側面に手を加えたくない企業にとって理想的な WordPress ホスティング サービスです。

WordPress は信頼性が高く、設定も簡単です。 したがって、カスタム マーケティング Web サイトの場合、ほとんどの SaaS 企業は WordPress を使用します。

WordPress 以外にも、あまり有名ではなく、初期段階の SaaS マーケティング Web サイト用に CMS をセットアップするために使用される CMS があります。 それらを見てみましょう。

2. CMS を作成する

Craft CMS は SaaS スペースの新参者ですが、使いやすいため、SaaS マーケティング サイトでますます適用されています。

立ち上げ以来、 Craftはコンテンツ管理に対する革新的なアプローチを備えた印象的な CMS として浮上してきました。 CMS を使用すると、ユーザーはコンテンツの作成、戦略、および設計と開発のプロセス全体を制御できます。 この二重ライセンスの CMS は、多くの使いやすさとアクセシビリティをもたらしながら、クリエイティブ プロセス全体を強化することが知られています。

このプラットフォームは、MailChimp、Salesforce などのツールに簡単に接続できるため、すぐに統合できます。 SaaS 企業のテクニカル SEO に関して言えば、CMS を使用すると、すぐに注意が必要な重要な要素をユーザーが完全に制御できます。

長所

- イベント、製品、会場、ウィジェット、カテゴリなど、さまざまな種類のコンテンツを管理できるため、WordPress よりも柔軟です。

- シンプルで使いやすいデザインのインターフェースを備えています。

- 信じられないほどの読み込み速度を実現します。

- 優れたライブ プレビューとコンテンツ モジュールがあります。 たとえば、画面を 2 つのビュー、つまり CMS パネルとページ プレビューに分割できます。

- Craft CMS Web サイトは脆弱性で有名ではありません。 これは、堅牢なセキュリティ機能を提供する Yii PHP フレームワーク上に構築されています。

- Craft プラグインのエコシステムはしっかりと構築されています。 毎週新しいプラグインが導入され、プラットフォームの機能が拡張されています。

短所

- Craft の 1 つの Web サイト ライセンスは約 300 ドルです。

- Craft CMS ではクリエイティブを完全に制御できます。つまり、事前に作成されたテーマはありません。 そのため、初心者はこの CMS を操作するのが難しいと感じるかもしれません。

- コミュニティが小さいため、Craft CMS 開発者を見つけるのは困難です。

通常、Craft CMS は、高速で安定したホスティングでうまく機能します。 Craft CMS 上に構築された SaaS マーケティング サイトに適した 2 つのホスティング プロバイダーを次に示します。

- アルカステック

Arcustech は、Craft CMS およびその他の PHP/MySQL アプリケーションおよびフレームワーク用の完全マネージド型 VPS ホスティングです。 したがって、Craft CMS 開発者は「24 時間」サーバー管理を行う必要はありません。

提供される VPS プランは非常に柔軟で、ウェブマスターはいつでも拡張できます。 そのため、小規模から始めて、ニーズに応じて成長させることができます。

- AWS

AWS は、EC2、Lightsail、S3 などを提供するアンマネージド クラウド サービスです。 このオンデマンド クラウド コンピューティング プラットフォームは、Craft CMS にデプロイできます。

- デジタルオーシャン

DigitalOcean は、開発者のクラウド コンピューティングを簡素化します。 これにより、優れた開発環境とワークフローを備えた Craft CMS を利用した Web サイトを立ち上げることができます。

- クラウドウェイズ

Cloudways は、開発者がこの CMS でアプリを簡単に構築、デプロイ、および管理できる超高速の Craft CMS ホスティングです。 その高度なホスティング機能は、アプリのパフォーマンスを最適化するために作られています。 したがって、ホスティングの煩わしさを心配することなく、すべての CMS アプリケーションをデプロイできます。

- ハイパーレーン

Hyperlane ホスティングは、WordPress of Craft を使用するクリエイティブエージェンシーやデザイナー向けに構築されています。 これは、開発者が Craft CMS サイトを構築および維持できる超高速のクラウド ホスティングです。

ホスティングは、Web サイトの共同作業と管理に必要な開発者ツールも提供します。

3.ウィックス

Wix は、プログラマーでなくても専門的なビジネス Web サイトを構築できるユーザーフレンドリーなプラットフォームです。 そのドラッグ アンド ドロップ機能は完全な創造の自由を提供し、サイト ビルダーは SaaS マーケティング Web サイトのルック アンド フィールを完全にカスタマイズできます。

長所

- ウェブサイトをゼロから構築する手間を省きたい企業にとって、優れたリソースであることが証明されているテンプレートの膨大なコレクションを提供します.

- 直感的なドラッグ アンド ドロップ インターフェイスを提供し、Web サイトを効果的にカスタマイズできます。

- Wix Apps マーケットでは、特定のタスクを実行するためのプラグインを提供しています。

- Wixには、すべてのSEOの手間のかかる作業を行う組み込みのSEO管理システムがあります.

- ソーシャルコンテンツを作成できます。

- Wixには、企業が購読者リストを簡単に作成できるメールマーケティングツールが含まれています。

短所

- テンプレートは交換できません。 あるテンプレートから別のテンプレートにコンテンツを転送することはできません。 したがって、十分に検討してテンプレートを選択してください。

- 無料プランを選択した場合、Web サイトに Wix ブランドを表示する必要があります。

- Web サイトのパフォーマンスと分析ボードへのアクセスを追跡するには、有料プランが必要です。

- Wix でウェブサイトを構築したら、それを譲渡することはできません。

4.スクエアスペース

SquareSpace は、Web マスターが単一のダッシュボードからサイトを設計、ホスト、および管理するためのオールインワン サブスクリプションを提供する SaaS マーケティング Web サイト ビルダーです。

セルフホストではありません。 したがって、自己ホスト型のサイト ビルダーである WordPress や Magento ほど拡張可能ではありません。 ただし、CMS は使いやすく、SaaS マーケティング担当者が必要とするすべての SEO の考慮事項が含まれています。

そのため、WordPress の経験がなく、すぐに SaaS マーケティング Web サイトを立ち上げたい場合は、SquareSpace が適しています。

長所

- その管理セクションは、簡単なナビゲーションとアプリケーションのために構築されています。 見つけやすい設定を備えた信じられないほどシンプルなインターフェイスを提供します。

- 優れた SEO 機能を提供し、そのページは、SERP で上位にランク付けするために必要なすべての SEO ベスト プラクティスに従っています。

たとえば、タイトル、代替テキスト、およびキーワードを管理できるため、検索ボットがコンテンツを見つけやすくなります.

- SquareSpace は、Web サイトの基本的な技術的側面、つまり Web サイトのセキュリティ、ソフトウェアの更新、バックアップなどを処理します。 したがって、これらについて心配する必要はありません

短所

- SquareSpace はいくつかの SEO 機能を提供していますが、基本的な機能に限定されています。 A/B テストなどの高度なマーケティング機能がありません。

- このプラットフォームは、サードパーティのアプリ、プラグイン、または拡張機能をサポートしていません。 これにより、初心者が SaaS マーケティング Web サイトをカスタマイズするのが難しくなります。

- メガ メニューのサポートがないため、何百ページもあるエンタープライズ レベルの SaaS マーケティング サイトには向いていません。

5.ハブスポットCMS

SaaS マーケティング担当者は、セキュリティ、手頃な価格、パフォーマンス、スケーラビリティ、利便性、および操作の容易さを確保しながら、マーケティング Web サイトを簡単に管理できる CMS を必要としています。 HubSpot のような CMS を選択すると、これらすべてが保証されるだけでなく、費用が節約され、成長とスケーリングの課題が制限され、ビジネスが成熟するにつれて強力なマーケティングに備えることができます。

HubSpot は、SaaS マーケティング Web サイトの作成を可能にすると同時に、SaaS 購入ジャーニー全体に合わせてカスタマイズできる最初で唯一の CMS です。

長所

- オールインワン プラットフォーム (CMS と CRM を組み合わせたもの) を使用すると、すべての SaaS マーケティング コンテンツを 1 か所で作成、管理、および実行できます。 サイトのマーケティング ニーズに合わせて、完全に統合されたマーケティング ツールを提供します。

このプラットフォームは、A/B テスト、ページの最適化、訪問者の活動記録など、いくつかのマーケティング ツールを提供し、SaaS マーケティング Web サイトを成長マシンに変えることができます。

- 初心者から非技術者まで使える使いやすいCMSです。 このプラットフォームは、モジュール、テンプレート、およびドラッグ アンド ドロップ機能により、マーケターにとって使いやすいコンテンツ編集エクスペリエンスを保証します。

- 標準の SSL 証明書とグローバルにホストされたコンテンツ配信ネットワーク (CDN) を含む高度なセキュリティ機能を提供します。 これにより、安全なブラウジング エクスペリエンスと 99.99% のアップタイムが保証されます。

- 通常、SaaS コンテンツ管理システムは、月額または年額の莫大な料金を要求します。 また、追加のストレージ、訪問者、または複数のユーザーに対する隠れた料金も発生します。 HubSpot CMS は、追加料金なしの定額料金で提供されます。

短所

- HubSpot のマーケットプレイスには、限られたテンプレートとモジュールしかありません。 機能を追加する必要がある場合は、追加料金で HubSpot 開発者を雇う必要があります。

- これは、管理された Web サイト コンテンツ ホスティング サービスです。 したがって、WordPress とは異なり、HubSpot ユーザーはホスティングが必要になる場合があります。 他の場所で SaaS マーケティング サイトを構築して HubSpot でホストすることはできません。

- HubSpot のインターフェイスは使いやすいですが、CSS の知識がないと、テンプレートの操作が難しくなる可能性があります。

6.ウェブフロー

Webflow は、SaaS ビジネスが構造化されたプロフェッショナルなカスタム マーケティング Web サイトを構築できるようにする、クラウドベースのゼロコードの「ビジュアル」CMS およびホスティング プラットフォームです。 そのため、Webflow を使用することで、SaaS マーケティング担当者はビジュアル エディターの機能を活用して、カスタム Web サイトをゼロから作成するという柔軟性を追加できます。

そのため、SaaS Web サイト開発者にとって、Webflow は Web サイト開発プロセスを大幅にスピードアップできます。

長所

- チームの全員で機能します。 デザイナーや開発者からコンテンツ マネージャーやストラテジストまで、誰もが Webflow を使用して目的を達成できます。

たとえば、開発者は Webflow の REST API を使用して端末からコンテンツを追加、更新、および削除できます。 同様に、コンテンツ マネージャーは、顧客のコンテンツ構造を作成して、ビジネス固有のニーズを満たすことができます。

- リアルタイムで書き込み、編集できます。 場合によっては、フロントエンドでコンテンツを追加および更新する方が簡単です。 これにより、これらの更新がページの全体的な流れにどのように影響するかを確認できます。

- 自動で一貫性のある更新を可能にします。 投稿の見出しを更新すると、プラットフォームはサイト全体で自動的に変更します。

- このプラットフォームでは、コーディングを必要とせずに無限のカスタマイズ オプションが可能です。

短所

- Webflow は、WordPress のようなオープンソースの CMS よりも高価です。

- Webflow はノーコードですが、HTML や CSS に関する予備知識や経験がないと、完璧な SaaS マーケティング Web サイトを設計するときに達成できることが制限される可能性があります。

- プラットフォームには、組み込みの技術的な SEO コントロールがありません。

SaaS Web サイトの技術的要素を改善すると、SERP でのサイトのパフォーマンスとランキングが大幅に向上します。

しかし、SEO の技術的な側面に慣れていない場合、主題の複雑さと範囲に圧倒されるのは自然なことです (それを実装することは言うまでもありません!)。

プロセスから汗とストレスを取り除いてください! Growfusely のテクニカル SEO スペシャリスト チームに連絡して、SaaS ビジネスを次のレベルに引き上げましょう。 お客様のケースを慎重に調査し、ウェブサイトをより速く、クロールしやすく、検索エンジンにとってより理解しやすいものにするための最善の技術的ソリューションを提案します。

TLDR

テクニカル SEO についてよく読んだことがあれば、それがカバーする側面のほとんど (Web サイトの速度を除く) がランキング要因ではないことに気付くでしょう。

では、なぜこれらの問題を見つけて解決するのにそれほど多くの時間を費やす必要があるのでしょうか?

技術的な SEO は、ページがインデックスされるかどうかに間接的に大きな影響を与えるため、SERP での位置に影響を与えます。

考えてみてください – Web サイトの robots.txt ファイルが検証されていない場合、検索ボットはコンテンツにアクセスしようとしてクロール バジェットを浪費します。 同様に、カノニカル URL がない場合、コンテンツの重複によってサイトのリンク エクイティが希薄化されます。

したがって、技術的な SEO は、コンテンツやサービスに必要な注目を集めることを目指す SaaS ビジネスにとって重要です。

テクニカル SEO とオンページのどちらが最も重要か?

答え – 両方!

だから、ここであなたがすべきことです。

- 技術的な SEO 監査から始めて、コンテンツの強力な基盤を築きましょう。 技術的な SEO の開始時またはサイトの移行/再設計時に時間を費やします。

これにより、上位の問題を特定して解決できるため、今後の胸やけを大幅に軽減できます。

- 技術的なボックスがチェックされたら、オンページ SEO に投資します。 もちろん、テクニカル SEO は継続的なプロセスです。

- 最後に、ソーシャル チャネルや電子メールでコンテンツを宣伝し、アウトリーチを通じてバックリンクを獲得することを含むオフページ SEO をお見逃しなく。

あなたのビジネスにとってのテクニカル SEO の重要性についてはもうお分かりいただけたと思います。オンラインでの存在感を高めるために、上記の戦術を使用してください。

この件に関して質問や懸念がある場合は、いくつかの技術的な SEO トピックをカバーしているブログにアクセスすることをお勧めします。 または、このテーマについて喜んでご案内いたします。

よくある質問 (FAQ)

1. テクニカル SEO には何が含まれますか?

テクニカル SEO には、最新の検索エンジンがコンテンツを適切にクロール、レンダリング、およびインデックス付けすることを保証する Web サイトのすべての技術的側面が含まれます。

テクニカル SEO の範囲は、ホスティングや Web サイトのパフォーマンスから、メタ ロボット タグや XML サイトマップに至るまで、Web サイトのすべての技術的側面を網羅しているため、戸惑うことがあります。

しかし、テクニカル SEO により、検索エンジンはあなたの Web サイトを高品質のリソースとして認識し、ユーザーがサイトにアクセスしたときに優れた UX を約束することができます。 これらすべてにより、Web サイトのクロール、インデックス作成、およびレンダリングが正しく行われます。

2. テクニカル SEO とオンページ SEO の違いは何ですか?

テクニカル SEOには、検索エンジンがコンテンツを効果的にクロールしてインデックスに登録できるようにするために行われるすべての取り組みが含まれます。

つまり、ウェブサイトのコンテンツ以外の側面に適用される SEO 戦術が含まれます。

オンページ SEO は、主にページ上のコンテンツに関係しています。 コンテンツを最適化するために使用されるすべての戦術が含まれます。これには、関連するキーワードを調査して含めるか、ユーザー エクスペリエンスが訪問者の期待と同等であることを確認するかが含まれます。

要約すると、テクニカル SEO とオンページ SEO の違いは次のとおりです。

3. Web サイトを移行する際に従うべき技術的な SEO チェックリストはありますか?

サイトの移行を計画している場合は、締め切りを含む明確なロードマップが必要です。これを怠ると、サイトのランキングが大幅に低下します。

サイトの移行を行う場合は、次の手順をお勧めします。

これは、Web サイトを再設計または移行する際に、既存のランキングとトラフィックを維持するために使用できる包括的な SEO チェックリストです。 この投稿では、移行前、移行中、移行後のすべての URL を比較するWeb サイト再設計 SEO スプレッドシートも提供しています。

4. Web サイトの技術的な健全性をどのように評価しますか?

コンテンツがどれほど優れていても、Web サイトに未解決の技術的問題があると、パフォーマンスが低下することは間違いありません。 したがって、Web サイトの技術的な健全性を定期的に測定することが重要です。

テクニカル SEO には、クロール、インデックス作成、レンダリング、Web サイト アーキテクチャなどの重要な要素が含まれます。 したがって、これらの技術的側面をよりよく反映するメトリックとツールを使用して評価されます。

これには、次の簡単な手順に従ってください。

- 技術監査を使用して Web サイトのクロールを分析します。 ログ ファイルを確認し、データをクロールすることをお勧めします。 これにより、Google や他の検索エンジンがどのようにページをクロールし、コンテンツを解釈しているかがわかります。

- 検索エンジンが Web ページを正しくレンダリングしていることを確認してください。 検索者やクローラーが見つけにくいものは、正しくレンダリングされません。

- ページのインデックス作成を確認します。 これにより、検索ボットによってインデックスに登録され、無視されたページが強調表示され、サイトの健全性を明確に把握できます。

- 上位のテクニカル SEO 指標を監視して、Web サイトのパフォーマンスを把握します。

画像ソース – Ahrefs、Danscartoons、Sitemap FAQ、Uber、Flipkart、Technicalseo.com、Twitter、Bing、Screamingfrog、Sitebulb、Deepcrawl、Oncrawl