BERT: la mayor actualización de Google en años

Publicado: 2022-12-01El BERT de Google se lanzó a fines de 2019 e impactó casi el 10% de todas las búsquedas. Posiblemente una de las actualizaciones de algoritmos más grandes de 2019, aquí está todo lo que los SEO y los propietarios de sitios deben saber sobre el modelo avanzado de procesamiento de lenguaje natural de Google.

¿Qué es el BERT de Google?

BERT es un algoritmo de aprendizaje profundo y abreviatura de Representaciones de codificador bidireccional de transformadores. El algoritmo ayudó a mostrar resultados más relevantes para consultas de búsqueda complicadas.

¿Cuál fue el efecto de la actualización del algoritmo BERT en la búsqueda de Google?

Esto es lo que dijo Google:

“Estas mejoras están orientadas a mejorar la comprensión del lenguaje, particularmente para consultas conversacionales/en lenguaje más natural, ya que BERT puede ayudar a Search a comprender mejor los matices y el contexto de las palabras en las búsquedas y combinar mejor esas consultas con resultados útiles.

Particularmente para consultas más largas y conversacionales, o búsquedas donde las preposiciones como "para" y "a" son muy importantes para el significado, la Búsqueda podrá comprender el contexto de las palabras en su consulta. Puedes buscar de una manera que te resulte natural”.

De hecho, según Google, la actualización del BERT tendrá un impacto en 1 de cada 10 búsquedas en inglés en los EE. UU., es decir, el 10 % de las consultas de búsqueda. Esta es la actualización más importante de Google en los últimos 5 años, al menos según ellos:

Estamos logrando una mejora significativa en la forma en que entendemos las consultas, lo que representa el mayor avance en los últimos cinco años y uno de los mayores avances en la historia de la Búsqueda.

La introducción de BERT provocó importantes fluctuaciones en la clasificación durante la primera semana de la implementación del nuevo algoritmo. Los SEO de Webmaster World han estado comentando sobre las fluctuaciones desde el comienzo de la semana, señalando la mayor fluctuación en las clasificaciones que ha afectado al mundo del SEO desde RankBrain.

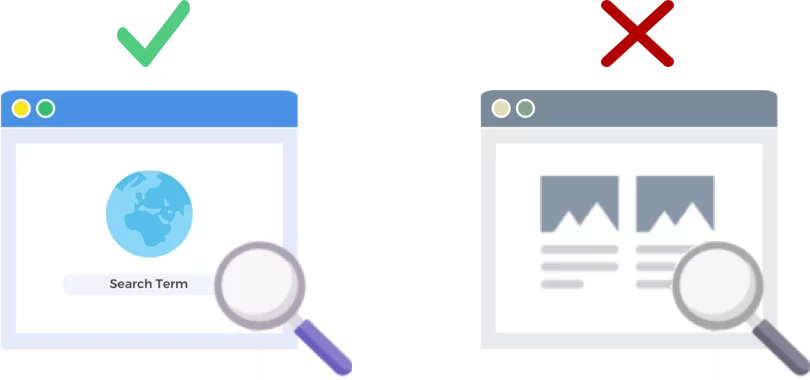

BERT analiza consultas de búsqueda NO páginas web

El lanzamiento del 24 de octubre de 2019 del algoritmo BERT mejora la forma en que el gigante de los motores de búsqueda analiza y comprende las consultas de búsqueda (no las páginas web).

¿Cómo funciona BERT?

BERT mejora la comprensión de Google de las consultas de búsqueda utilizando un modelo de contexto bidireccional (que es la B en BERT). De hecho, Google habló un poco sobre la mecánica de BERT en esta época el año pasado cuando anunciaron BERT como una nueva técnica para el preentrenamiento de Procesamiento del lenguaje natural (NLP).

¿Qué es el pre-entrenamiento? El entrenamiento previo es simplemente enseñarle a una máquina cómo hacer tareas, antes de que realmente le des trabajo. Tradicionalmente, los conjuntos de datos previos al entrenamiento se cargan con unos pocos miles a unos cientos de miles de ejemplos etiquetados por humanos.

El entrenamiento previo ha existido por un tiempo, pero lo que hace que BERT sea especial es que es tanto contextual (el significado de cada palabra cambia según las palabras que la rodean) como bidireccional: el significado de una palabra se entiende en función de las palabras anteriores y después de.

Según el blog de Google:

En la oración " Accedí a la cuenta bancaria ", un modelo contextual unidireccional representaría " banco " basado en " Accedí a " pero no a " cuenta ". Sin embargo, BERT representa " banco " utilizando tanto su contexto anterior como el siguiente: " Accedí a la ... cuenta ", comenzando desde el fondo de una red neuronal profunda, haciéndola profundamente bidireccional.

La actualización de Google BERT se basa en avances recientes en aprendizaje automático y reconocimiento de entidades. Básicamente, BERT ayuda a identificar todas las partes del discurso y el contexto de las palabras antes de que Google procese una búsqueda.

¿Qué significa BERT para los resultados de búsqueda?

Según Google, significa que los usuarios comenzarán a ver resultados más relevantes, resultados que se ajustan mejor a la intención de búsqueda de un usuario. Esta mejora del algoritmo abarcará resultados regulares y resultados de fragmentos enriquecidos.

Google proporcionó algunos ejemplos útiles en su entrada de blog anunciando BERT.

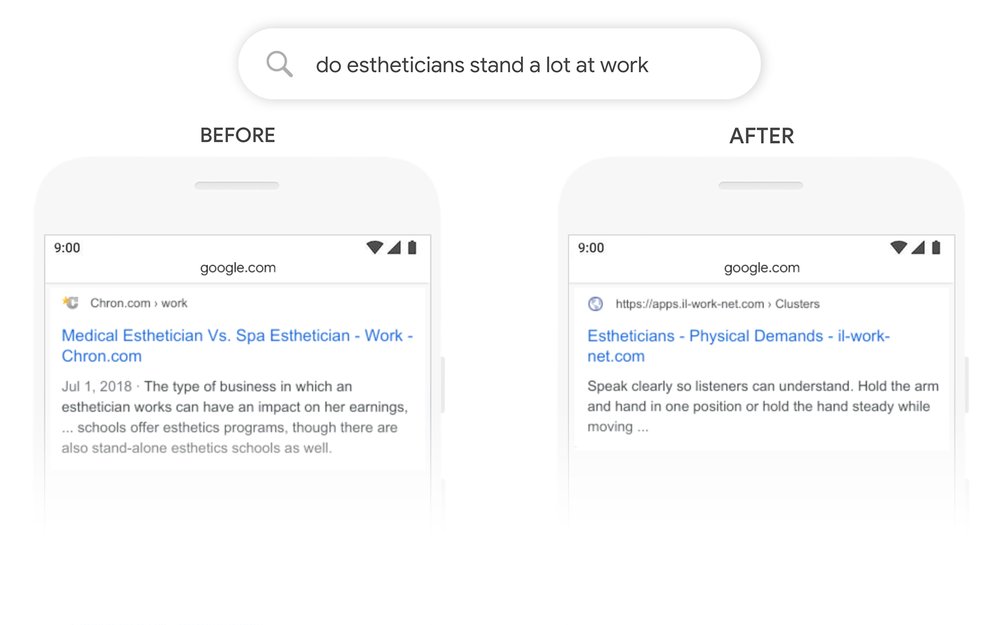

El ejemplo de la esteticista

En primer lugar, tenemos un usuario que intenta comprender si los esteticistas pasan mucho tiempo de pie como parte del trabajo.

Puede ver a continuación que antes de BERT, Google leyó la consulta "¿Los esteticistas soportan mucho en el trabajo?" y produjo un resultado comparando los tipos de entornos de trabajo para los esteticistas.

Después de BERT, Google está mostrando un artículo sobre las exigencias físicas de ser un esteticista, mucho más en línea con la información que el buscador originalmente estaba tratando de encontrar.

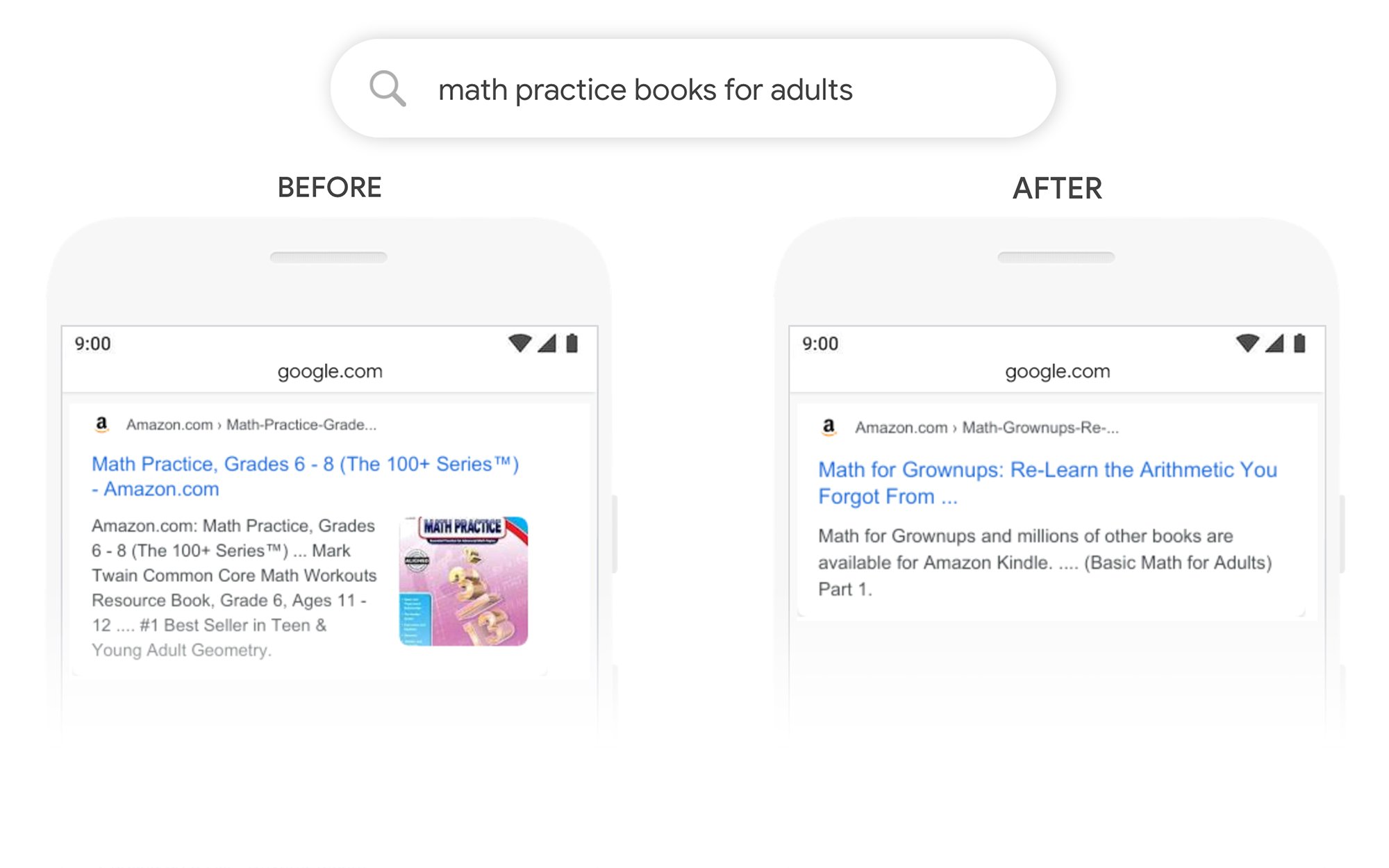

El ejemplo de los libros de práctica de matemáticas

En este ejemplo, un usuario está buscando libros de práctica de matemáticas para adultos, pero encuentra libros de práctica de matemáticas para niños.

Después de BERT, Google reconoce correctamente el contexto de la consulta, explicando mejor la segunda parte de la búsqueda "para adultos".

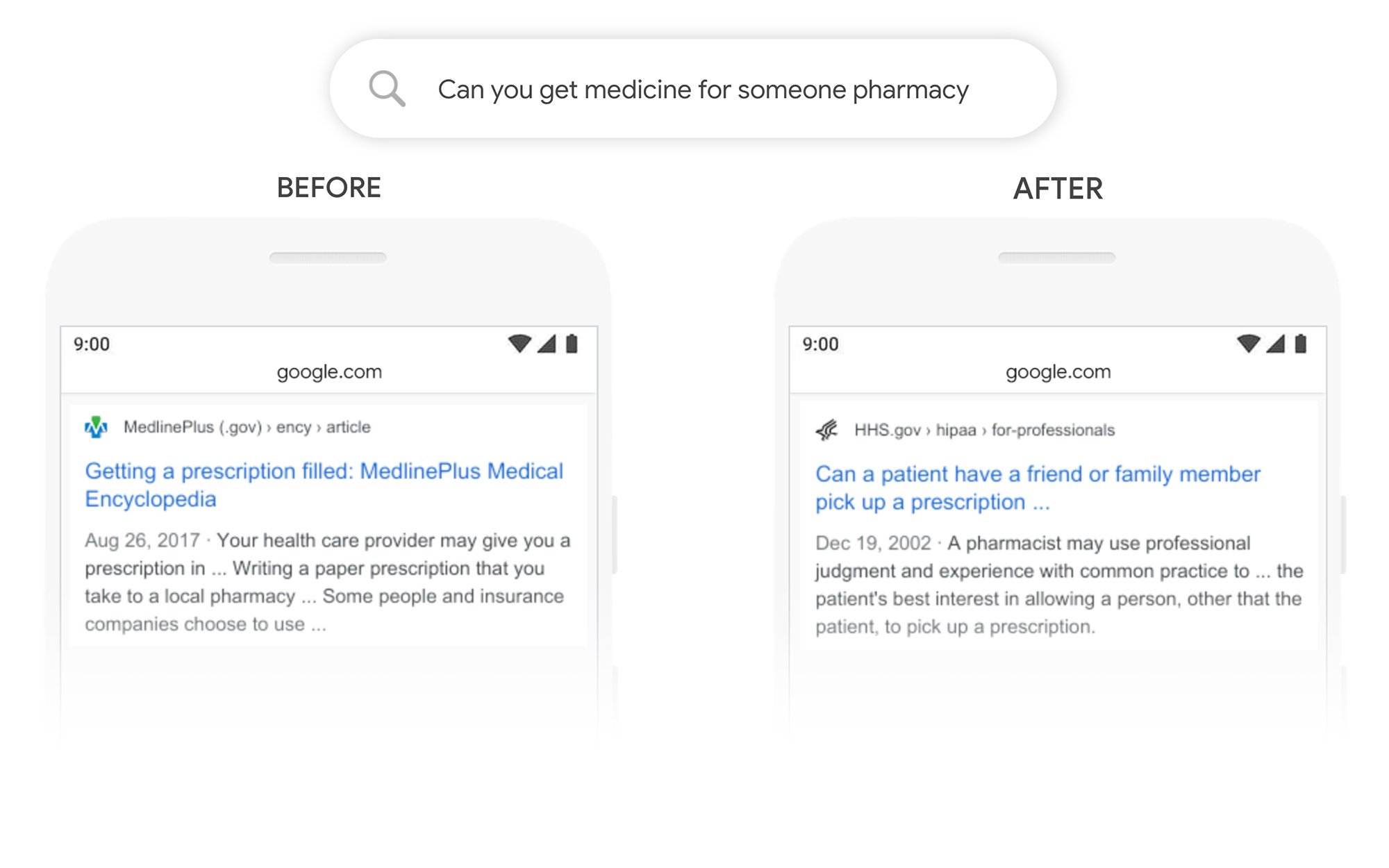

El ejemplo de ¿Puedes recoger medicamentos para otra persona?

En este ejemplo, la consulta "¿puede obtener medicamentos para una farmacia?" devuelve un resultado sobre cómo surtir las recetas en general, en lugar de cómo surtirlas para un tercero. Después de BERT, Google comprende mejor el objetivo del usuario y muestra una pieza sobre si un paciente puede pedirle a un amigo o familiar que recoja su receta.

¿Qué puedo hacer para posicionarme mejor después de BERT?

Para cualquier palabra clave en la que pierda clasificaciones, debe echar un vistazo a la página de resultados de búsqueda revisada para comprender mejor cómo Google está viendo la intención de búsqueda de sus términos objetivo. Luego revise su contenido en consecuencia para cumplir mejor con los objetivos del usuario.

Si perdió clasificaciones en BERT, es más probable que sea un problema relacionado con qué tan bien su página coincide con la intención de búsqueda de un usuario (ayuda a un usuario a alcanzar su objetivo) que un problema de calidad del contenido.

Dado que es probable que BERT respalde aún más los esfuerzos de búsqueda por voz con el tiempo, también recomendamos que los sitios web escriban una copia clara y concisa. No use lenguaje de relleno, no sea vago, vaya directo al grano.

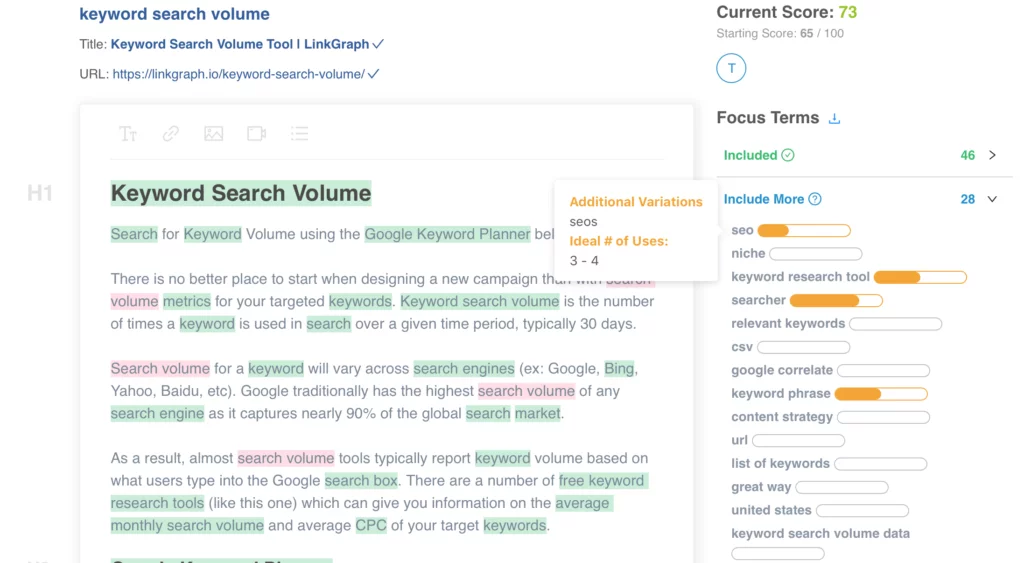

¿Necesita ayuda para optimizar su contenido? Consulte el Optimizador de contenido en la página de LinkGraph, comuníquese con un miembro de nuestro equipo en [email protected] o programe una reunión para configurarlo hoy.

¿Dónde puedo obtener más información?

Dawn Anderson hizo una gran presentación a principios de este mes en Pubcon sobre "Google BERT y la familia y la carrera de clasificación de comprensión del lenguaje natural", y puede ver su presentación.

Gracias por tener mi #Pubcon. Aquí está mi mazo <3 <3 https://t.co/aGYDI9pfdY

— Dawn Anderson (@dawnieando) 10 de octubre de 2019

Jeff Dean también hizo recientemente un discurso de apertura sobre IA en Google, incluido BERT, que puede ver.