¿Estás cansado de que ChatGPT raspe tu contenido? Proteja su contenido AHORA

Publicado: 2023-07-06

En el panorama digital actual, proteger su contenido, datos y tráfico web es de suma importancia. Con el surgimiento de ChatGPT y otros modelos de lenguaje de IA, existe una creciente preocupación acerca de que estas herramientas extraigan contenido para su propio beneficio. Como editor, es esencial comprender cómo funcionan estos bots y los riesgos potenciales que plantean.

En este artículo, exploraremos el mundo del raspado de ChatGPT y LLM y discutiremos estrategias para burlar y proteger el tráfico de su sitio web.

¿Cómo sé que ChatGPT está raspando mi contenido?

ChatGPT, varios complementos y otros modelos de lenguaje han ganado el estatus de estrella debido a su notable capacidad para generar texto similar al humano. Estas herramientas se han hecho cargo y han despedido a empleados de varias industrias, incluida la creación de contenido, el servicio al cliente e incluso la escritura creativa. Si bien pueden ser útiles de muchas maneras, es fundamental comprender que hay casos en los que se pueden utilizar de forma indebida para extraer contenido.

Scraping, en el contexto de Internet, se refiere al proceso de extracción de información de sitios web utilizando bots automatizados. Estos bots visitan diferentes páginas web, recopilan datos y los usan para entrenar aún más los modelos de IA. Cuando ChatGPT u otros LLM extraen contenido, esencialmente utilizan los datos que recopilan para mejorar sus capacidades de generación de texto.

Sin embargo, el principal problema surge cuando este proceso de extracción infringe los derechos de propiedad intelectual y perjudica el negocio de los editores y las organizaciones de medios. Es esencial ser consciente de cómo se puede raspar su contenido y sus posibles consecuencias en su tráfico web.

Los problemas con el raspado

Uno de los principales problemas con el raspado es que puede llevar a perder el control sobre su contenido. Cuando se raspa el contenido de su sitio web, se puede reutilizar y distribuir en otro lugar sin su consentimiento. Esto socava su autoridad como creador original y plantea desafíos para mantener la precisión y la integridad de su contenido.

El raspado puede tener un impacto significativo en la clasificación de los motores de búsqueda de su sitio web. Los motores de búsqueda priorizan el contenido original y único, y cuando el contenido extraído se publica en otro lugar, puede diluir la visibilidad y la relevancia de su sitio web en los resultados de búsqueda. Esto puede resultar en una disminución en el tráfico orgánico y una posible pérdida de ingresos.

También puede conducir a una representación distorsionada de su marca u organización. Cuando el contenido extraído se usa de manera inapropiada o fuera de contexto, puede tergiversar sus intenciones, lo que genera confusión o incluso daños a su reputación. Es crucial proteger la identidad de su marca y garantizar que su contenido se use de manera responsable y con la atribución adecuada.

Abordar el problema del raspado requiere un enfoque multifacético. Como creador de contenido o propietario de un sitio web, puede tomar varias medidas para proteger su contenido para que no sea raspado. La implementación de tecnologías como CAPTCHA, bloqueo de IP o restricciones de acceso al contenido puede ayudar a disuadir a los bots automatizados de acceder y raspar su sitio web.

Además, monitorear regularmente el tráfico de su sitio web y analizar el comportamiento de los usuarios puede ayudar a identificar actividades sospechosas que pueden indicar un raspado. Si se mantiene atento y proactivo, puede tomar las medidas adecuadas para mitigar el impacto del scraping en su contenido y negocio.

También es esencial que los desarrolladores de IA y las organizaciones que utilizan LLM como ChatGPT prioricen las consideraciones éticas . La implementación de pautas y políticas estrictas que desalienten el uso indebido del scraping puede ayudar a prevenir la recopilación no autorizada de contenido. El desarrollo de IA responsable tiene como objetivo lograr un equilibrio entre la innovación y el respeto por los derechos de propiedad intelectual.

¿Cómo extrae ChatGPT tu contenido?

Comprender el proceso de raspado empleado por los bots de ChatGPT es crucial para tratar este problema de manera efectiva. Estos bots utilizan una técnica conocida como rastreo web, en la que visitan páginas web y siguen enlaces para recopilar información. Luego, esta información se utiliza para entrenar el modelo de IA. La extracción de contenido puede ser perjudicial para los editores y las empresas de medios por varias razones.

En primer lugar, puede provocar una pérdida de ingresos si el contenido extraído se vuelve a publicar sin permiso. Esto puede socavar la capacidad de los editores originales para monetizar su contenido y generar pérdidas financieras. Además, puede empañar la reputación de los editores, ya que su contenido puede ser tergiversado o sacado de contexto cuando los bots de ChatGPT lo vuelven a publicar.

En segundo lugar, el impacto en la experiencia del usuario es una preocupación importante. Cuando los bots de ChatGPT inundan un sitio web con solicitudes para extraer contenido, pueden sobrecargar el servidor y ralentizar la velocidad de carga para los usuarios legítimos. Esto puede frustrar a los visitantes y disuadirlos de regresar al sitio web, lo que genera una disminución en el tráfico y una posible pérdida de participación e ingresos publicitarios.

Por último, el contenido raspado también puede afectar la clasificación de los motores de búsqueda de un sitio web. Los buscadores priorizan el contenido único y original , penalizando los sitios web con contenido duplicado o raspado. Si los bots de ChatGPT raspan y vuelven a publicar contenido de los editores, puede afectar negativamente los esfuerzos de optimización de motores de búsqueda (SEO) de los creadores originales. Esto puede dar como resultado una menor visibilidad y un tráfico orgánico reducido, lo que perjudica la presencia en línea de los editores.

Dados estos riesgos, los editores deben proteger proactivamente su contenido y el tráfico web del raspado de ChatGPT y LLM. La implementación de medidas como CAPTCHA , bloqueo de IP y detección de agentes de usuario puede ayudar a identificar y bloquear bots automatizados que intentan extraer contenido. Además, monitorear regularmente el tráfico web y analizar patrones puede ayudar a detectar cualquier actividad de raspado anormal y tomar las medidas apropiadas.

Además, los editores pueden explorar vías legales para proteger su contenido. Las leyes de derechos de autor y los derechos de propiedad intelectual se pueden hacer cumplir para evitar la extracción y la reedición no autorizadas de su trabajo. Buscar asesoramiento legal y emprender las acciones legales necesarias contra las entidades infractoras puede enviar un mensaje fuerte y disuadir futuros intentos de raspado.

La colaboración y la comunicación entre editores, empresas de medios y desarrolladores de IA también son cruciales para abordar este problema. El establecimiento de asociaciones y diálogos abiertos puede conducir al desarrollo de prácticas y pautas éticas para la capacitación en IA, asegurando que se respeten los derechos de los creadores de contenido mientras se avanza en la tecnología de IA.

¿Cómo adelantarse a ChatGPT y proteger el tráfico de su sitio web?

Presentamos Traffic Cop: su escudo contra el raspado no autorizado

Traffic Cop de MonetizeMore es una solución de vanguardia que actúa como un escudo sólido, protegiendo de manera efectiva sus activos digitales de los bots de raspado y el acceso no autorizado.

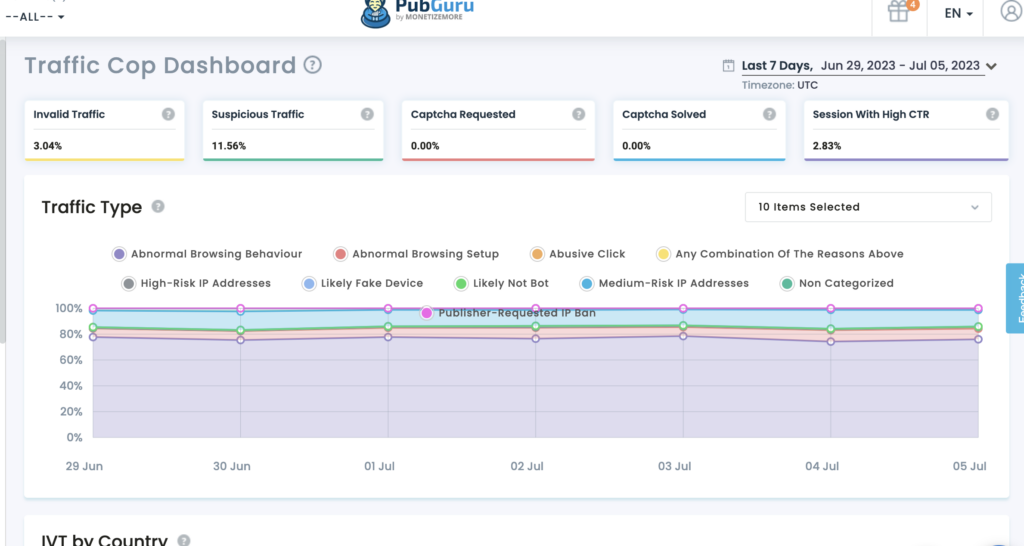

Protección de su contenido: con Traffic Cop, su contenido valioso permanece seguro contra el raspado no autorizado. Sus algoritmos avanzados de aprendizaje automático le permiten identificar y diferenciar entre el tráfico de usuarios legítimos y los bots maliciosos. Traffic Cop bloquea eficazmente los intentos de raspado, asegurando que su contenido siga siendo exclusivo de su sitio web.

Protección de sus datos: los datos son el elemento vital de los negocios en línea. Traffic Cop le ayuda a mantener la integridad y confidencialidad de sus datos. La herramienta galardonada emplea algoritmos sofisticados para identificar y bloquear las actividades de recopilación de datos, lo que garantiza que sus datos permanezcan protegidos.

Preservar el tráfico web: el tráfico web es esencial para el éxito de cualquier empresa en línea. Sin embargo, el raspado no autorizado puede agotar sus recursos, afectar el rendimiento del sitio y socavar sus esfuerzos de SEO. Traffic Cop es su centinela vigilante, mantiene a raya a los bots maliciosos y preserva su tráfico web. La implementación de mecanismos avanzados de detección de bots y medidas proactivas garantiza que los usuarios genuinos tengan acceso ininterrumpido a su sitio web, mejorando la experiencia del usuario y maximizando su potencial de conversión.

¿Por qué elegir Traffic Cop?

- Protección integral: Traffic Cop ofrece un escudo holístico contra los intentos de raspado, protegiendo su contenido, datos y tráfico web simultáneamente.

- Detección avanzada de bots: distingue con precisión entre usuarios genuinos y bots maliciosos, evitando el acceso no autorizado y las actividades de raspado.

- Medidas de seguridad proactivas: esta tecnología emplea algoritmos de vanguardia para identificar y bloquear los intentos de raspado en tiempo real, manteniéndose un paso por delante de las amenazas potenciales.

- Experiencia de usuario mejorada: al preservar su tráfico web y mantener a raya a los bots maliciosos, Traffic Cop garantiza el acceso ininterrumpido para usuarios genuinos, mejorando su experiencia y aumentando las tasas de conversión.

Aparte de eso:

Utilice la limitación de tasa: implemente medidas de limitación de tasa para restringir la cantidad de solicitudes por dirección IP o usuario, evitando que los bots abrumen su sitio web con intentos de raspado.

La limitación de velocidad es una técnica efectiva para evitar ataques de raspado al limitar la cantidad de solicitudes que un usuario o dirección IP puede realizar dentro de un período de tiempo específico. Al establecer límites razonables, puede asegurarse de que los usuarios genuinos puedan acceder a su sitio web y disuadir a los bots de intentar raspar su contenido. La implementación de límites de velocidad puede ayudar a mantener el rendimiento y la disponibilidad de su sitio web.

Proteja sus fuentes RSS: si proporciona fuentes RSS para sindicación, asegúrese de que estén protegidas contra el raspado agregando mecanismos de autenticación o implementando claves API.

Los feeds RSS pueden ser una fuente valiosa de sindicación de contenido, pero también pueden ser el objetivo de los bots de scraping. Para proteger sus fuentes RSS, es crucial implementar mecanismos de autenticación o claves API. Al requerir autenticación, puede asegurarse de que solo los usuarios o aplicaciones autorizados puedan acceder y consumir sus fuentes RSS. Además, la implementación de claves API puede ayudarlo a rastrear y controlar el acceso a sus fuentes, evitando intentos de extracción no autorizados.

Al implementar estas estrategias, puede reducir significativamente el riesgo de raspado de ChatGPT y LLM, protegiendo así su contenido, datos y tráfico web.

Haz esto para mantenerte al día con AI-Apocalypse.

A medida que ChatGPT y otros LLM continúan avanzando, los editores deben considerar ciertos aspectos clave para proteger su contenido y tráfico web:

- Manténgase informado: manténgase actualizado sobre los últimos avances en IA y tecnologías de procesamiento de lenguaje natural. Esto le ayudará a comprender los posibles riesgos y oportunidades de estas herramientas.

- Revise sus Términos de servicio: asegúrese de que sus Términos de servicio prohíban explícitamente las actividades de extracción y especifique las consecuencias de violar estos términos.

- Explore las opciones legales: si sospecha una infracción de sus derechos de propiedad intelectual debido al raspado, consulte con expertos legales para explorar los recursos legales disponibles.

- Involucrarse con la industria: colaborar con asociaciones y organizaciones de la industria para abordar colectivamente los desafíos que plantea el scraping y abogar por mejores medidas de protección.

Al considerar estos factores de manera proactiva, los editores pueden proteger mejor su contenido, datos y tráfico web en la era de ChatGPT y las tecnologías LLM emergentes.

Además de estas consideraciones clave, los editores también deben ser conscientes del impacto potencial de ChatGPT y LLM en la participación de su audiencia. Con el auge del contenido generado por IA, existe la posibilidad de que los lectores se vuelvan más escépticos sobre la autenticidad y confiabilidad de la información que consumen. Los editores deben tomar medidas para generar confianza con su audiencia al etiquetar claramente el contenido generado por IA y brindar transparencia sobre la fuente de la información.

Otra consideración importante son las posibles implicaciones éticas del contenido generado por IA. A medida que los LLM se vuelven más avanzados, existe la necesidad de garantizar que el contenido generado no perpetúe los sesgos o la información errónea. Los editores deben establecer pautas y procesos de revisión para garantizar que el contenido generado por IA se alinee con sus estándares y valores editoriales.

Además, tenga en cuenta el panorama legal en evolución que rodea el contenido generado por IA. A medida que estas tecnologías se vuelven más frecuentes, es posible que se establezcan nuevas regulaciones y marcos legales para regir su uso. Mantenerse al tanto de estos desarrollos y consultar con expertos legales puede ayudar a los editores a navegar por las complejidades legales del contenido generado por IA.

Conclusión

Proteger su contenido, datos y tráfico web del scraping de ChatGPT es crucial para mantener la integridad de su negocio. Amenaza sus ingresos y la experiencia del usuario y afecta su visibilidad y reputación en línea. Al comprender el proceso de scraping, implementar medidas de protección, explorar opciones legales y fomentar la colaboración, los editores pueden proteger su contenido y mitigar los riesgos asociados con el scraping impulsado por IA.

Traffic Cop de MonetizeMore ofrece una solución integral para mantener su contenido, datos y tráfico web seguros. Al aprovechar la detección avanzada de bots y las medidas de seguridad proactivas, Traffic Cop le permite concentrarse en su negocio principal mientras protege sus activos digitales de manera efectiva.

Adopte Traffic Cop hoy y disfrute de la tranquilidad de saber que su presencia en línea está protegida contra el raspado no autorizado.

Conozca a Aleesha Jacob, una administradora experimentada de SEO y contenido B2B con más de 7 años de experiencia en la elaboración de contenido basado en datos que impulsa las conversiones para las empresas SAAS. Después de haber trabajado con empresas de tecnología publicitaria y clientes como BMW y Heineken, Aleesha aporta una gran experiencia. Con sus habilidades inigualables en la creación de contenido atractivo, ayuda a las empresas de todos los tamaños a generar más clientes potenciales, aumentar los ingresos y aumentar su presencia en línea.