Alto riesgo, alta recompensa: cómo las marcas pueden usar la IA de manera ética

Publicado: 2023-07-18La IA generativa ya ha cambiado el mundo, pero no es oro todo lo que reluce. Si bien el interés de los consumidores en ChatGPT es alto, existe una creciente preocupación entre los expertos y los consumidores sobre los peligros de la IA para la sociedad. Las preocupaciones sobre la pérdida de empleo, la seguridad de los datos, la desinformación y la discriminación son algunas de las principales áreas que generan alarma.

La IA es el temor de más rápido crecimiento en los EE. UU., un 26 % más que hace solo un trimestre.

Sin duda, la IA cambiará la forma en que trabajamos, pero las empresas deben ser conscientes de los problemas que conlleva. En este blog, exploraremos las preocupaciones de los consumidores sobre el trabajo y la seguridad de los datos, cómo las marcas pueden aliviar las preocupaciones y protegerse a sí mismos y a los consumidores de los riesgos potenciales.

1. Salvaguardar la IA generativa

El contenido generativo de IA, como ChatGPT y el creador de imágenes DALL-E, se está convirtiendo rápidamente en parte de la vida diaria, con más de la mitad de los consumidores viendo contenido generado por IA al menos semanalmente. Como estas herramientas requieren grandes cantidades de datos para aprender y generar respuestas, la información confidencial puede colarse en la mezcla.

Con muchas partes móviles, las plataformas generativas de IA permiten a los usuarios contribuir con el código de varias maneras con la esperanza de mejorar los procesos y el rendimiento. La desventaja es que con muchas contribuciones, las vulnerabilidades a menudo pasan desapercibidas y la información personal puede quedar expuesta. Esta situación exacta es lo que le sucedió a ChatGPT a principios de mayo de 2023.

Con más de la mitad de los consumidores diciendo que las filtraciones de datos les llevarían a boicotear una marca, se debe priorizar la privacidad de los datos. Si bien se están dando pasos para redactar leyes sobre IA, mientras tanto, las marcas deben autoimponer reglas de transparencia y pautas de uso, y darlas a conocer al público.

2 de cada 3 consumidores quieren que las empresas que crean herramientas de IA sean transparentes sobre cómo se están desarrollando.

Hacerlo puede generar confianza en la marca, una moneda especialmente codiciada en este momento. Aparte de la calidad, la seguridad de los datos es el factor más importante a la hora de confiar en las marcas. Con la lealtad a la marca cada vez más frágil, las marcas deben asegurar a los consumidores que sus datos están en buenas manos.

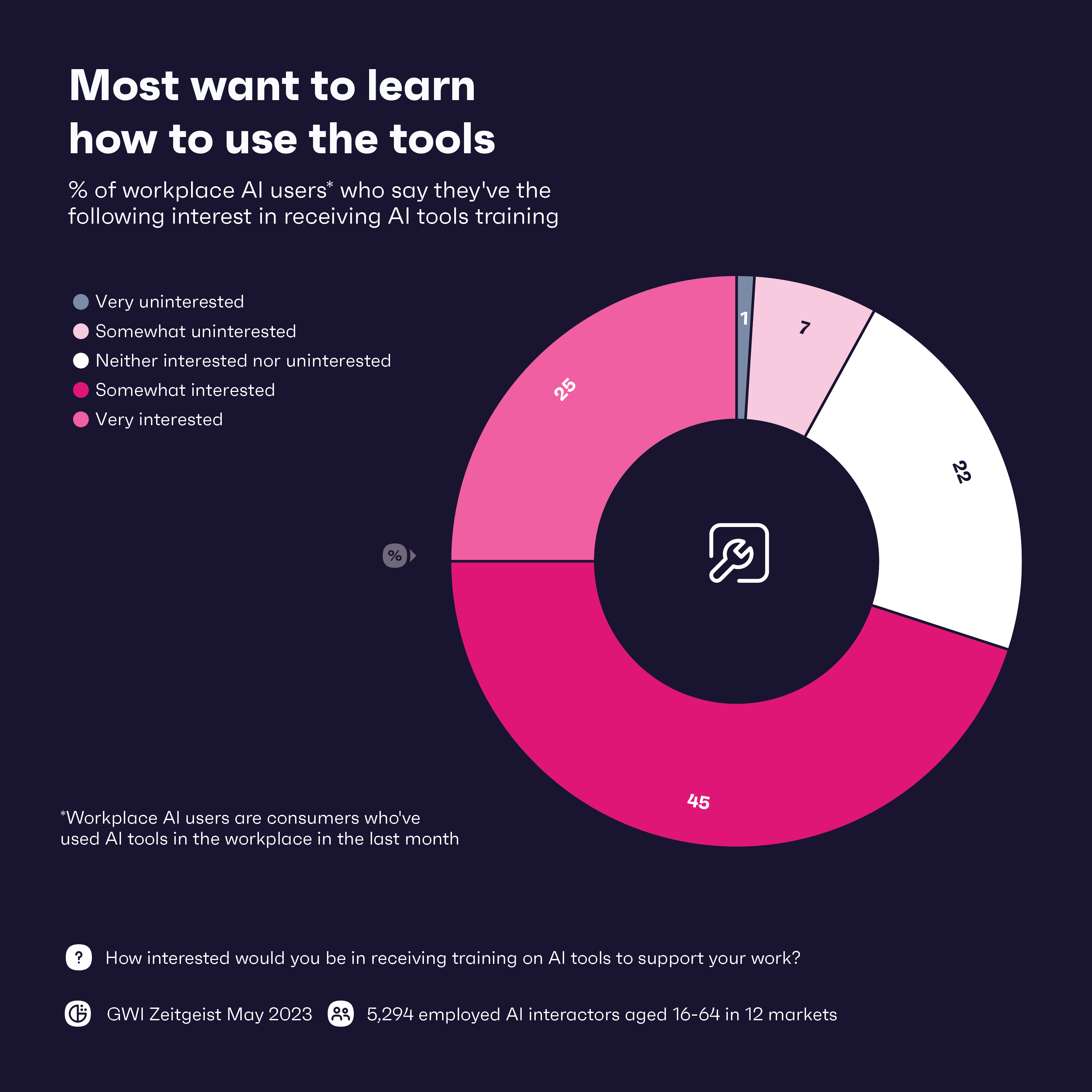

Entonces, ¿cuál es una de las mejores formas de proteger los datos en la era de la IA? La primera línea de defensa es capacitar al personal en herramientas de IA, con el 71 % de los trabajadores diciendo que estarían interesados en recibir capacitación. Combinar esto con la capacitación en protección de datos es igualmente importante. La educación es realmente clave aquí: armar a los trabajadores con el conocimiento necesario para garantizar que la privacidad de los datos sea una prioridad será de gran ayuda.

2. Mantener la realidad en un mundo de noticias falsas

Facebook tardó 4,5 años en llegar a los 100 millones de usuarios. En comparación, ChatGPT tardó poco más de dos meses en alcanzar ese hito.

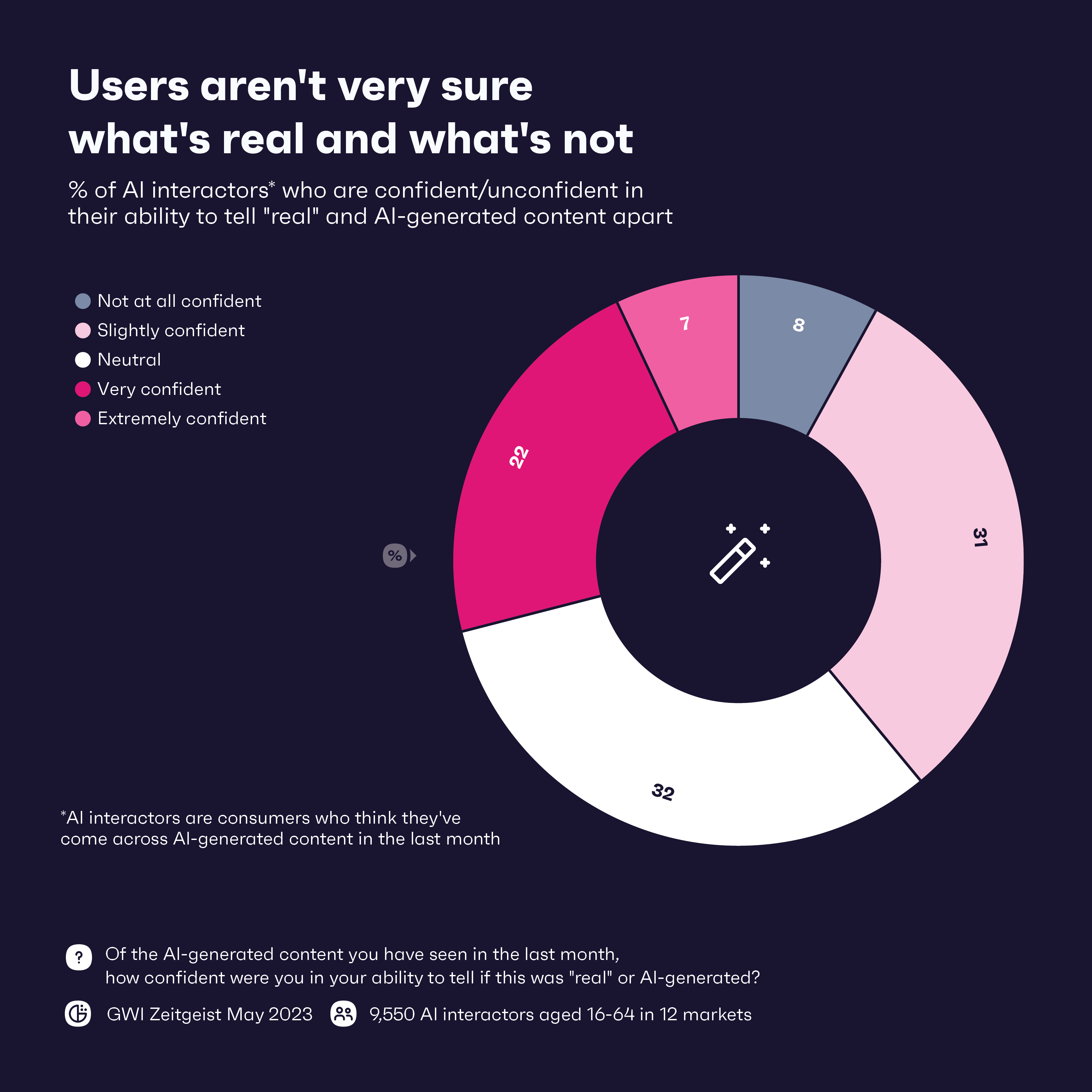

A pesar de lo impresionante que es el auge de la IA generativa, ha sido un imán para la creación de noticias falsas en forma de audios y videos, conocidos como falsificaciones profundas. La tecnología ya se ha utilizado para difundir información errónea en todo el mundo. Solo el 29% de los consumidores confía en su capacidad para diferenciar el contenido generado por IA y el contenido "real", lo que probablemente empeorará a medida que las falsificaciones profundas se vuelvan más sofisticadas.

Casi dos tercios de los usuarios de ChatGPT dicen que interactúan con la herramienta como lo harían con una persona real, lo que demuestra cuán potencialmente persuasiva podría ser la herramienta.

Pero los consumidores lo han visto venir; El 64 % dice que le preocupa que las herramientas de IA se puedan usar con fines no éticos. Con esta preocupación y la baja confianza en la detección de deepfakes, son las marcas las que pueden marcar la diferencia para proteger a los consumidores de esta última ola de noticias falsas y proporcionar educación sobre cómo identificar dicho contenido.

Las marcas pueden comenzar implementando la verificación de fuentes y realizando la debida diligencia en cualquier información que deseen compartir o promocionar. Del mismo modo, pueden asociarse o utilizar procesos internos de verificación de hechos en cualquier noticia que puedan recibir. Para la mayoría de las marcas, es probable que estas medidas ya estén implementadas, ya que las noticias falsas y la información errónea han proliferado durante años.

Pero a medida que los deepfakes se vuelven más inteligentes, las marcas deberán estar al tanto. Para vencerlos, es posible que las marcas deban recurrir a la IA una vez más en forma de herramientas de detección basadas en IA que puedan identificar y marcar el contenido generado por IA. Estas herramientas se convertirán en una necesidad en la era de la IA, pero puede que no sean suficientes, ya que los malos actores suelen estar un paso por delante. Pero, una combinación de herramientas de detección y supervisión humana para interpretar correctamente el contexto y la credibilidad podría frustrar lo peor.

La transparencia también es clave. Informar a los consumidores que está haciendo algo para abordar las noticias falsas generadas por IA puede ganarles puntos de confianza y ayudar a establecer estándares de la industria que pueden ayudar a todos a mantenerse al día contra las falsificaciones profundas.

3. Combatir los sesgos inherentes

Nadie quiere una pesadilla de relaciones públicas, pero esa es una posibilidad real si las marcas no verifican dos veces la información que obtienen de sus herramientas de IA. Recuerde, las herramientas de IA aprenden de los datos extraídos de Internet, datos que están llenos de prejuicios humanos, errores y discriminación.

Para evitar esto, las marcas deberían utilizar conjuntos de datos diversos y representativos para entrenar modelos de IA. Si bien eliminar por completo el sesgo y la discriminación es casi imposible, el uso de una amplia gama de conjuntos de datos puede ayudar a eliminar algunos de ellos. Más consumidores están preocupados por cómo se están desarrollando las herramientas de IA, y cierta transparencia sobre el tema podría hacer que confíen un poco más en estas herramientas.

Si bien todas las marcas deberían preocuparse por usar datos imparciales, ciertas industrias deben tener más cuidado que otras. Las marcas bancarias y de atención médica en particular deben ser muy conscientes de cómo utilizan la IA, ya que estas industrias tienen un historial de discriminación sistémica. Según nuestros datos, el comportamiento que causa daño a comunidades específicas es la razón principal por la que los consumidores boicotearían una marca, y dentro de los terabytes de datos utilizados para entrenar las herramientas de IA se encuentran datos potencialmente dañinos.

Además de una revisión detallada de los conjuntos de datos que se utilizan, las marcas también necesitan humanos, preferiblemente con capacitación diversa, de equidad e inclusión (DE&I), para supervisar todo el proceso. Según nuestro conjunto de datos de GWI USA Plus, DE&I es importante para el 70 % de los estadounidenses, y es más probable que compren de marcas que comparten sus valores.

4. Lograr el equilibrio adecuado con la automatización en el lugar de trabajo

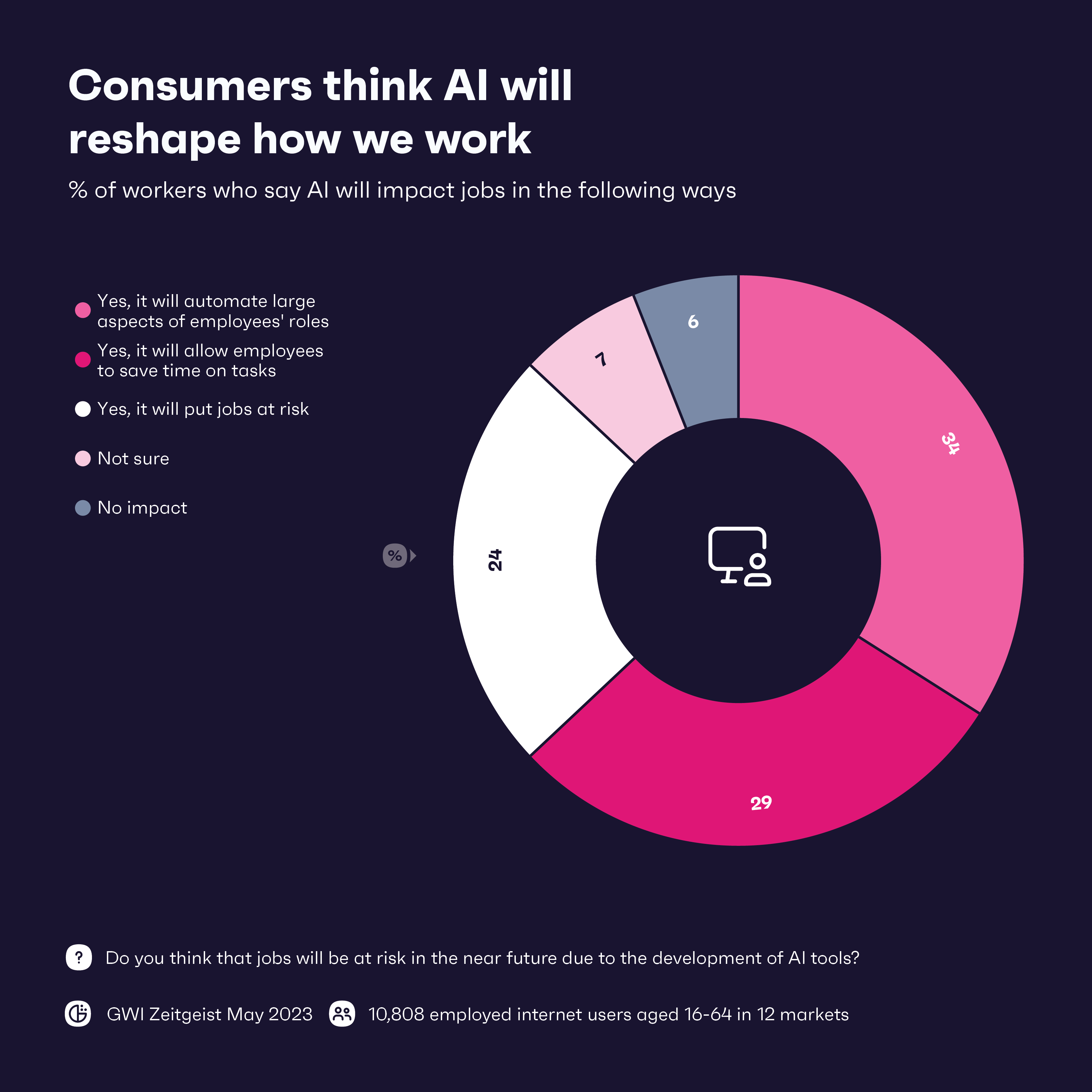

Dirijámonos al elefante en la habitación. ¿Será la IA amiga o enemiga de los trabajadores? No hay duda de que cambiará el trabajo tal como lo conocemos, pero el impacto de la IA en el lugar de trabajo dependerá de a quién le pregunte.

Lo que sí sabemos es que la gran mayoría de los trabajadores esperan que la IA tenga algún tipo de impacto en su trabajo. Se espera la automatización de grandes aspectos de los roles de los empleados, especialmente en las industrias de tecnología y fabricación/logística. En general, los trabajadores parecen entusiasmados con la IA, con 8 de 12 sectores que dicen que la automatización tendrá un impacto positivo.

Por otro lado, casi el 25 % de los trabajadores ven a la IA como una amenaza para los empleos, y aquellos que trabajan en las industrias de viajes y salud y belleza están particularmente nerviosos. La IA generativa parece estar mejorando exponencialmente cada mes, por lo que la pregunta es: si la IA puede ocuparse de las tareas mundanas ahora, ¿qué sigue?

Incluso si la IA elimina unos 80 millones de puestos de trabajo en todo el mundo, los trabajadores pueden encontrar formas de usar la IA de manera efectiva para mejorar sus propias habilidades, incluso en industrias vulnerables. El servicio al cliente está listo para experimentar importantes actualizaciones con IA, pero no puede suceder sin humanos. La IA generativa puede manejar la mayoría de las consultas, pero los humanos deben estar allí para manejar información confidencial y brindar un toque empático. Los humanos también pueden trabajar con IA para brindar soluciones y recomendaciones más personalizadas, lo cual es especialmente importante en las industrias de viajes y belleza.

La IA que automatiza algunas tareas puede liberar a los trabajadores para que contribuyan de otras maneras. Pueden dedicar más tiempo al pensamiento estratégico y a encontrar soluciones innovadoras, lo que posiblemente resulte en nuevos productos y servicios. Será diferente para cada empresa e industria, pero aquellos que sean capaces de lograr el equilibrio adecuado entre la IA y los trabajadores humanos deberían prosperar en la era de la IA.

El mensaje final: lo que necesita saber

La IA puede ser poderosa, pero las marcas deben ser conscientes de los riesgos. Deberán proteger los datos de los consumidores y estar al tanto de las noticias falsas. La transparencia será clave. Los consumidores están nerviosos por el futuro de la IA, y las marcas que les muestran que se están comportando de manera ética y responsable serán de gran ayuda.

La tecnología es emocionante y probablemente tendrá un impacto positivo en el lugar de trabajo en general. Pero las marcas deben proceder con cautela y tratar de lograr el equilibrio adecuado entre la tecnología y el capital humano. Los empleados necesitarán una amplia capacitación sobre ética, seguridad y aplicación correcta, y hacerlo mejorará sus habilidades. Al integrar herramientas de IA para trabajar junto con las personas, en lugar de reemplazarlas por completo, las marcas pueden lograr un equilibrio que las preparará para un futuro mejorado con IA.