¿Qué es el presupuesto de rastreo y cómo optimizarlo de manera inteligente?

Publicado: 2021-08-19Tabla de contenido

El análisis del presupuesto de rastreo es una de las tareas laborales de cualquier experto en SEO (especialmente si se trata de sitios web grandes). Una tarea importante, cubierta decentemente en los materiales proporcionados por Google. Sin embargo, como puede ver en Twitter, incluso los empleados de Google minimizan el papel del presupuesto de rastreo para obtener un mejor tráfico y clasificaciones:

¿Tienen razón en esto?

¿Cómo funciona Google y recopila datos?

A medida que abordamos el tema, recordemos cómo el motor de búsqueda recopila, indexa y organiza la información. Mantener estos tres pasos en un rincón de tu mente es esencial durante tu trabajo posterior en el sitio web:

Paso 1: gatear . Explorar recursos en línea con el propósito de descubrir, y navegar, todos los enlaces, archivos y datos existentes. Generalmente, Google comienza con los lugares más populares en la Web y luego procede a escanear otros recursos menos populares.

Paso 2: Indexación . Google intenta determinar de qué trata la página y si el contenido/documento bajo análisis constituye material único o duplicado. En esta etapa, Google agrupa el contenido y establece un orden de importancia (leyendo las sugerencias en las etiquetas rel=”canonical” o rel=”alternate” u otras).

Paso 3: Servir . Una vez segmentados e indexados, los datos se muestran en respuesta a las consultas de los usuarios. Aquí también es cuando Google ordena los datos según corresponda, teniendo en cuenta factores como la ubicación del usuario.

Importante: muchos de los materiales disponibles pasan por alto el Paso 4: representación de contenido . De forma predeterminada, Googlebot indexa el contenido de texto. Sin embargo, a medida que las tecnologías web continúan evolucionando, Google tuvo que idear nuevas soluciones para dejar de "leer" y comenzar a "ver" también. De eso se trata el renderizado. Le sirve a Google para mejorar sustancialmente su alcance entre los sitios web recién lanzados y ampliar el índice.

Nota : los problemas con la representación de contenido pueden ser la causa de un presupuesto de rastreo fallido.

¿Qué es el presupuesto de rastreo?

El presupuesto de rastreo no es más que la frecuencia con la que los rastreadores y los robots de los motores de búsqueda pueden indexar su sitio web, así como la cantidad total de URL a las que pueden acceder en un solo rastreo. Imagine su presupuesto de rastreo como créditos que puede gastar en un servicio o una aplicación. Si no recuerda "cargar" su presupuesto de rastreo, el robot se ralentizará y le hará menos visitas.

En SEO, "cobrar" se refiere al trabajo realizado para adquirir vínculos de retroceso o mejorar la popularidad general de un sitio web. En consecuencia, el presupuesto de rastreo es una parte integral de todo el ecosistema de la Web. Cuando está haciendo un buen trabajo con el contenido y los vínculos de retroceso, está elevando el límite de su presupuesto de rastreo disponible.

En sus recursos, Google no se aventura a definir explícitamente el presupuesto de rastreo. En cambio, apunta a dos componentes fundamentales del rastreo que afectan la minuciosidad de Googlebot y la frecuencia de sus visitas:

- límite de frecuencia de rastreo;

- demanda de rastreo.

¿Cuál es el límite de frecuencia de rastreo y cómo verificarlo?

En términos más simples, el límite de frecuencia de rastreo es la cantidad de conexiones simultáneas que Googlebot puede establecer al rastrear su sitio. Debido a que Google no quiere dañar la experiencia del usuario, limita la cantidad de conexiones para mantener un rendimiento fluido de su sitio web/servidor. En resumen, cuanto más lento sea su sitio web, menor será su límite de frecuencia de rastreo.

Importante: el límite de rastreo también depende de la salud general de SEO de su sitio web: si su sitio genera muchos redireccionamientos, errores 404/410 o si el servidor a menudo devuelve un código de estado 500, la cantidad de conexiones también disminuirá.

Puedes analizar los datos del límite de frecuencia de rastreo con la información disponible en Google Search Console, en el informe Estadísticas de rastreo .

Demanda de rastreo o popularidad del sitio web

Si bien el límite de la tasa de rastreo requiere que refine los detalles técnicos de su sitio web, la demanda de rastreo lo recompensa por la popularidad de su sitio web. En términos generales, cuanto mayor sea el rumor en torno a su sitio web (y en él), mayor será su demanda de rastreo.

En este caso, Google hace balance de dos cuestiones:

- Popularidad general: Google está más ansioso por ejecutar rastreos frecuentes de las URL que son generalmente populares en Internet (no necesariamente aquellas con vínculos de retroceso de la mayor cantidad de URL).

- Actualización de los datos del índice: Google se esfuerza por presentar solo la información más reciente. Importante: La creación de más y más contenido nuevo no significa que su límite de presupuesto de rastreo general vaya a aumentar.

Factores que afectan el presupuesto de rastreo

En la sección anterior, definimos el presupuesto de rastreo como una combinación del límite de tasa de rastreo y la demanda de rastreo. Tenga en cuenta que debe ocuparse de ambos, simultáneamente, para garantizar un rastreo adecuado (y, por lo tanto, la indexación) de su sitio web.

A continuación, encontrará una lista simple de puntos a tener en cuenta durante la optimización del presupuesto de rastreo.

- Servidor : el problema principal es el rendimiento. Cuanto menor sea su velocidad, mayor será el riesgo de que Google asigne menos recursos para indexar su nuevo contenido.

- Códigos de respuesta del servidor : cuanto mayor sea el número de redireccionamientos 301 y errores 404/410 en su sitio web, peores resultados de indexación obtendrá. Importante: Esté atento a los bucles de redireccionamiento: cada "salto" reduce el límite de frecuencia de rastreo de su sitio web para la próxima visita del bot.

- Bloqueos en robots.txt : si basa sus directivas de robots.txt en corazonadas, puede terminar creando cuellos de botella de indexación. El resultado: limpiará el índice, pero a expensas de su efectividad de indexación para páginas nuevas (cuando las URL bloqueadas estaban firmemente integradas en la estructura de todo el sitio web).

- Navegación facetada/identificadores de sesión/cualquier parámetro en las URL : lo más importante, tenga cuidado con las situaciones en las que una dirección con un parámetro puede parametrizarse aún más, sin restricciones. Si eso sucediera, Google llegaría a un número infinito de direcciones, gastando todos los recursos disponibles en las partes menos significativas de nuestro sitio web.

- Contenido duplicado: el contenido copiado (aparte de la canibalización) perjudica significativamente la efectividad de indexar contenido nuevo.

- Contenido delgado : que ocurre cuando una página tiene una proporción de texto a HTML muy baja. Como resultado, Google puede identificar la página como un Soft 404 y restringir la indexación de su contenido (incluso cuando el contenido es significativo, lo que puede ser el caso, por ejemplo, en la página de un fabricante que presenta un solo producto y no único). contenido del texto).

- Mala vinculación interna o falta de ella .

Herramientas útiles para el análisis del presupuesto de rastreo

Dado que no existe un punto de referencia para el presupuesto de rastreo (lo que significa que es difícil comparar los límites entre sitios web), equípese con un conjunto de herramientas diseñadas para facilitar la recopilación y el análisis de datos.

Consola de búsqueda de Google

GSC ha crecido muy bien a lo largo de los años. Durante un análisis de presupuesto de rastreo, hay dos informes principales que debemos examinar: la cobertura del índice y las estadísticas de rastreo.

Cobertura del índice en GSC

El informe es una fuente de datos masiva. Revisemos la información sobre las URL excluidas de la indexación. Es una excelente manera de comprender la escala del problema al que se enfrenta.

Los informes completos merecen un artículo separado, así que por ahora, concentrémonos en la siguiente información:

- Excluido por la etiqueta 'noindex' : en general, más páginas sin índice significan menos tráfico. Lo que plantea la pregunta: ¿cuál es el punto de mantenerlos en el sitio web? ¿Cómo restringir el acceso a estas páginas?

- Rastreado, actualmente no indexado , si ve eso, verifique si el contenido se muestra correctamente a los ojos de Googlebot. Recuerda que cada URL con ese estado desperdicia tu presupuesto de rastreo porque no genera tráfico orgánico.

- Descubierto, actualmente no indexado , uno de los problemas más alarmantes que vale la pena poner en la parte superior de su lista de prioridades.

- Duplicar sin canónico seleccionado por el usuario : todas las páginas duplicadas son extremadamente peligrosas, ya que no solo dañan su presupuesto de rastreo, sino que también aumentan el riesgo de canibalización.

- Duplicado, Google eligió un canónico diferente al del usuario ; en teoría, no hay necesidad de preocuparse. Después de todo, Google debería ser lo suficientemente inteligente como para tomar una decisión acertada en nuestro lugar. Bueno, en realidad, Google selecciona sus canónicas de forma bastante aleatoria, a menudo cortando páginas valiosas con una canónica que apunta a la página de inicio.

- Soft 404 : todos los errores "soft" son muy peligrosos, ya que pueden provocar la eliminación de páginas críticas del índice.

- URL enviada duplicada no seleccionada como canónica : similar al informe de estado sobre la falta de canónicas seleccionadas por el usuario.

Estadísticas de rastreo

El informe no es perfecto y, en lo que respecta a las recomendaciones, sugiero jugar también con los buenos registros antiguos del servidor, que brindan una visión más profunda de los datos (y más opciones de modelado).

Como ya he dicho, tendrá dificultades para buscar puntos de referencia para las cifras anteriores. Sin embargo, es una buena decisión echar un vistazo más de cerca a:

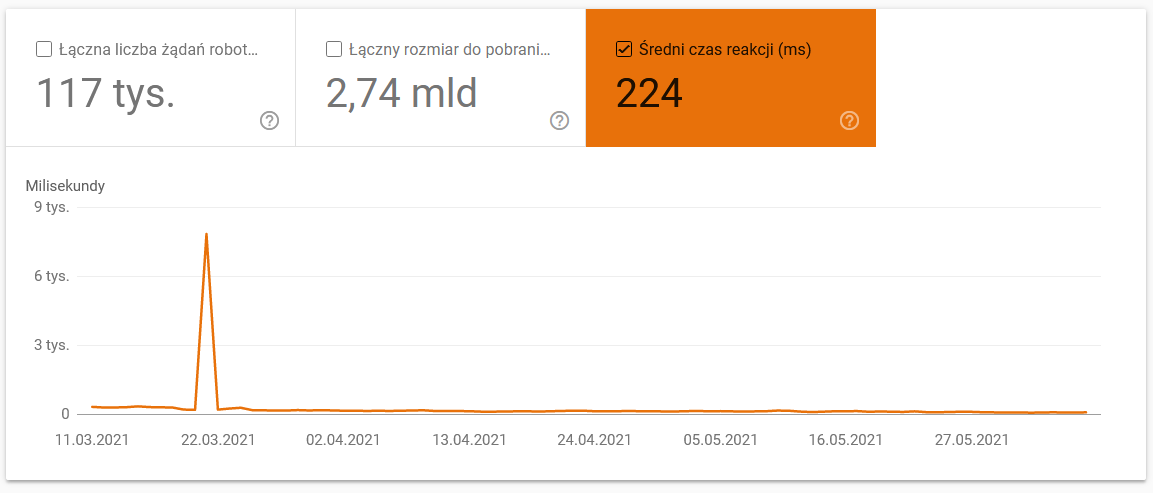

- Tiempo medio de descarga. La siguiente captura de pantalla muestra que el tiempo de respuesta promedio tuvo un impacto dramático, debido a problemas relacionados con el servidor:

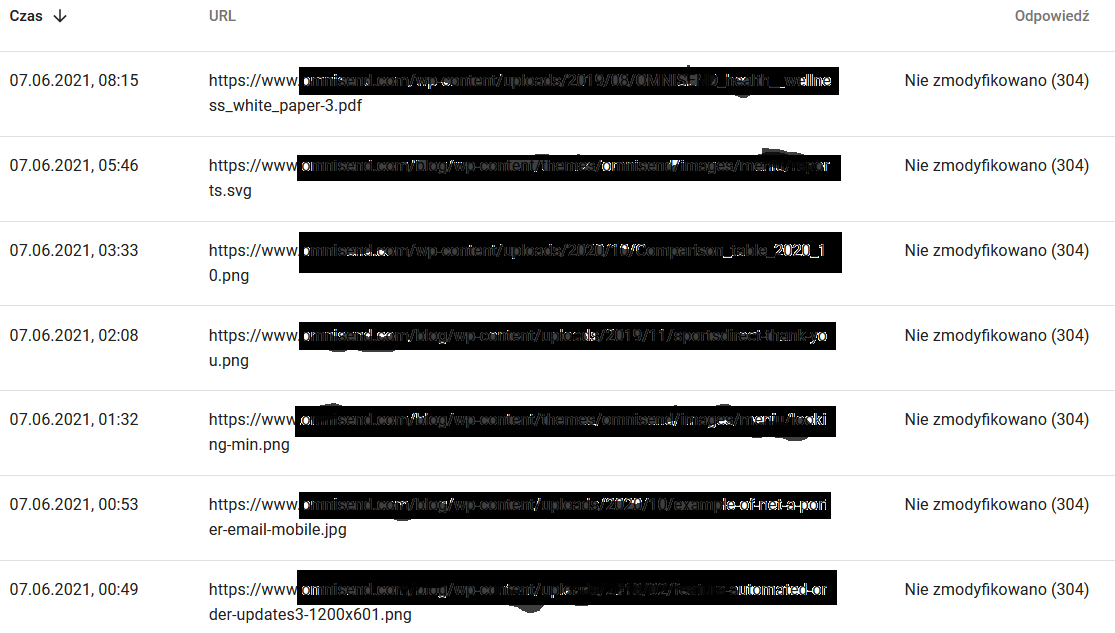

- Respuestas de rastreo. Mire el informe para ver, en general, si tiene un problema con su sitio web o no. Preste mucha atención a los códigos de estado del servidor atípicos, como los 304 a continuación. Estas URL no tienen ningún propósito funcional, pero Google desperdicia sus recursos rastreando su contenido.

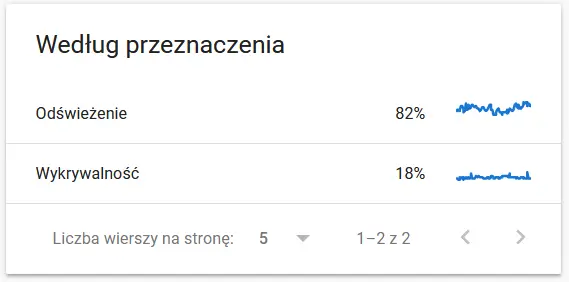

- Propósito de rastreo. En general, estos datos dependen en gran medida del volumen de contenido nuevo en el sitio web. Las diferencias entre la información recopilada por Google y el usuario pueden ser bastante fascinantes:

Contenido de una URL rastreada a los ojos de Google:

Mientras tanto, esto es lo que ve el usuario en el navegador:

Definitivamente una causa para el pensamiento y el análisis :)

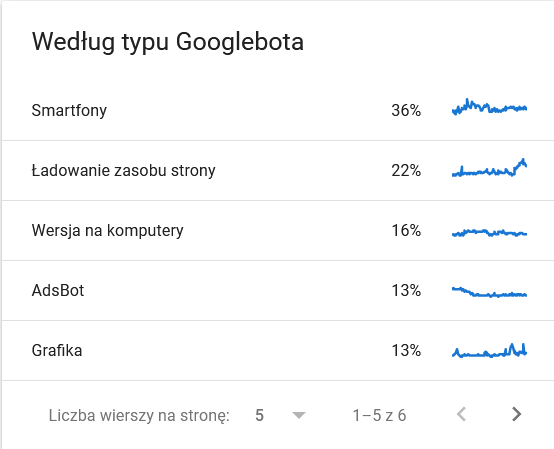

- Tipo de robot de Google . Aquí tienes a los bots que visitan tu sitio web en bandeja de plata, junto con sus motivaciones para analizar tu contenido. La captura de pantalla a continuación muestra que el 22% de las solicitudes se refieren a la carga de recursos de la página.

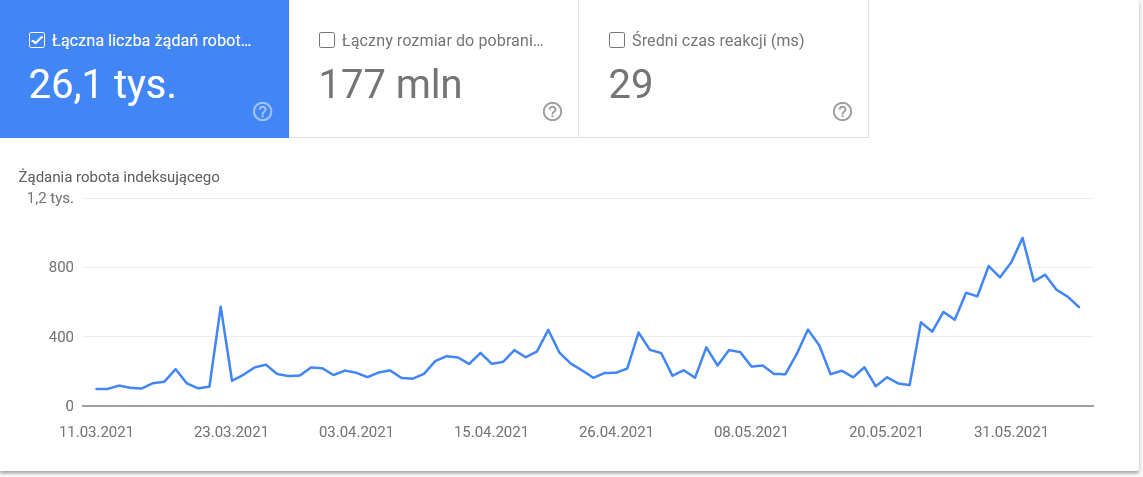

El total se disparó en los últimos días del marco de tiempo:

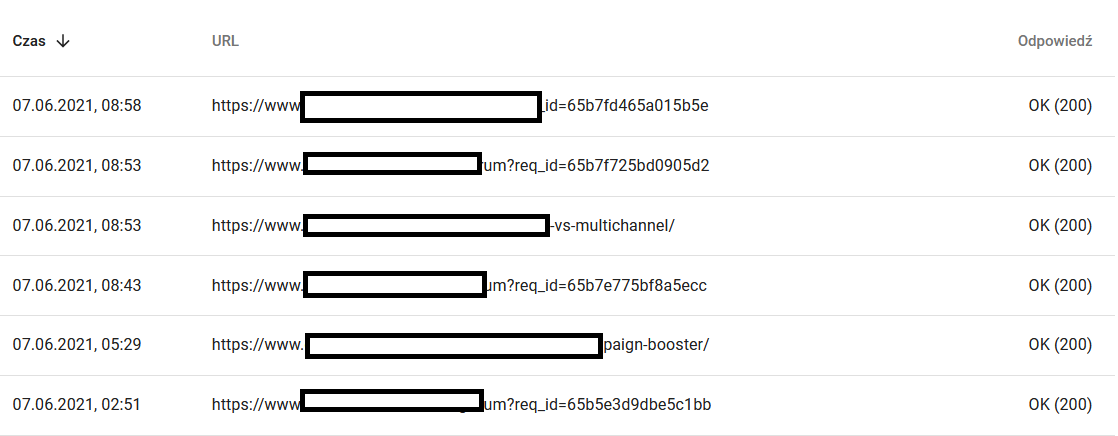

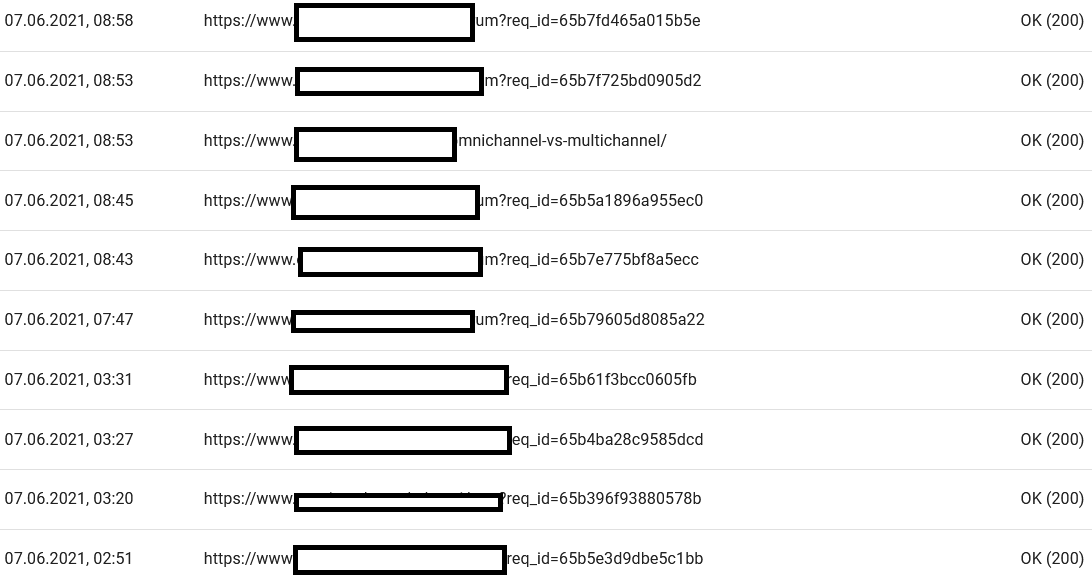

Una mirada a los detalles revela las URL que requieren una mayor atención:

Rastreadores externos (con ejemplos de Screaming Frog SEO Spider)

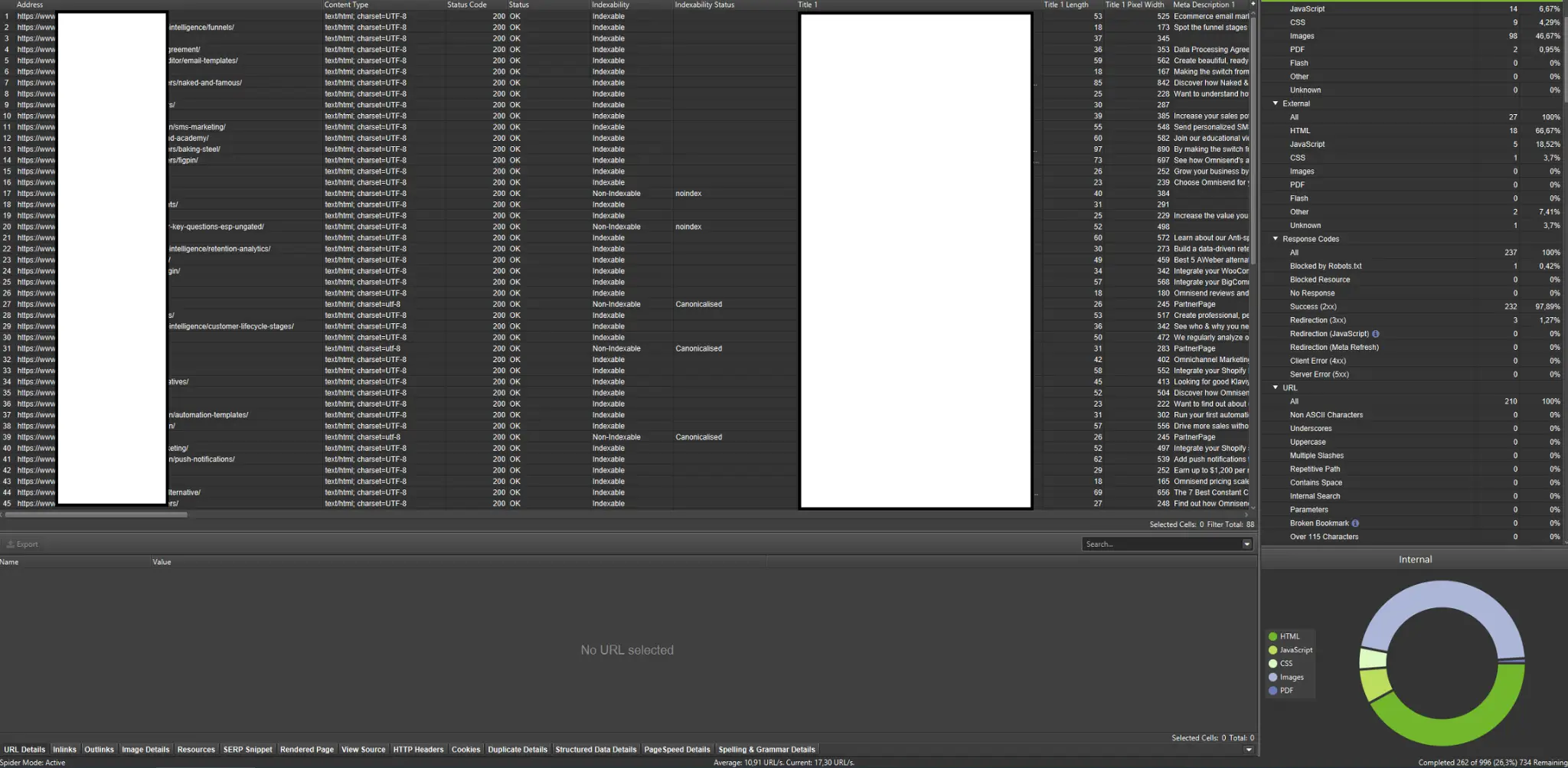

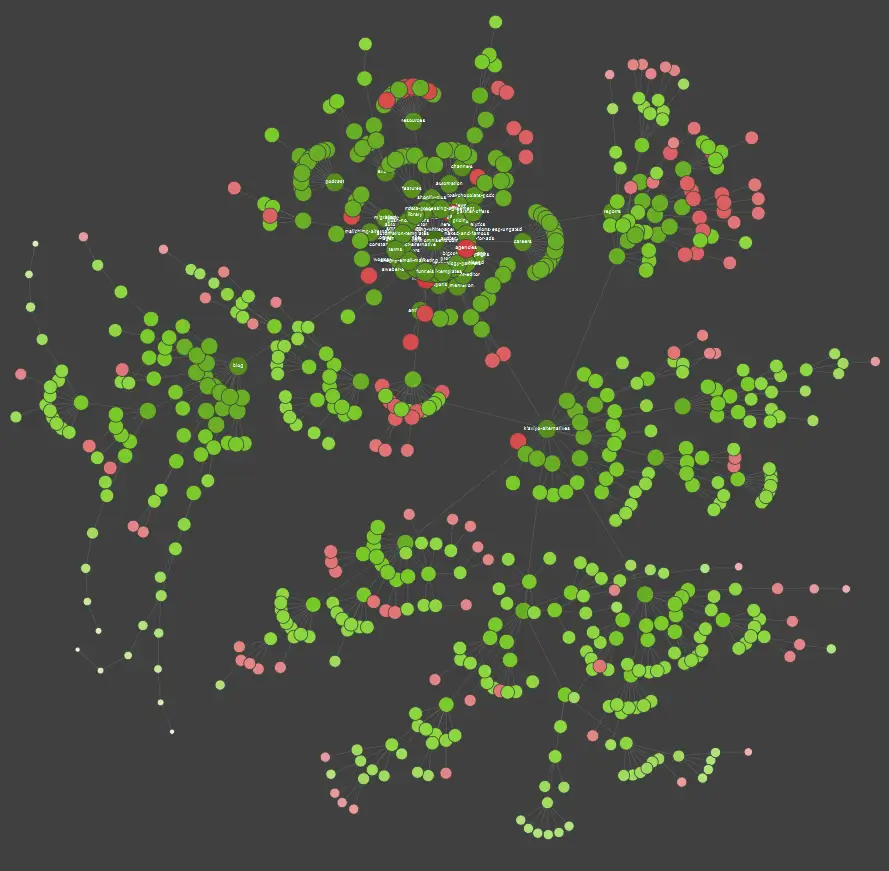

Los rastreadores se encuentran entre las herramientas más importantes para analizar el presupuesto de rastreo de su sitio web. Su objetivo principal es imitar los movimientos de los robots de rastreo en el sitio web. La simulación le muestra de un vistazo si todo va a la perfección.

Si eres un aprendiz visual, debes saber que la mayoría de las soluciones disponibles en el mercado ofrecen visualizaciones de datos.

En el ejemplo anterior, los puntos rojos representan páginas no indexadas. Tómese un tiempo para considerar su utilidad e impacto en el funcionamiento del sitio. Si los registros del servidor revelan que estas páginas desperdician mucho tiempo de Google sin agregar valor, es hora de revisar seriamente el punto de mantenerlas en el sitio web.

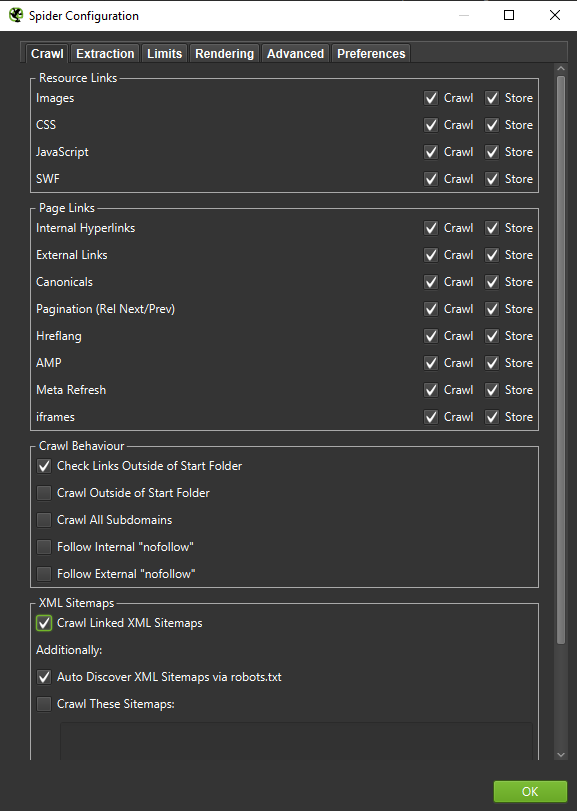

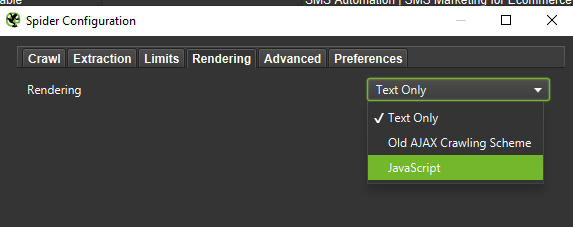

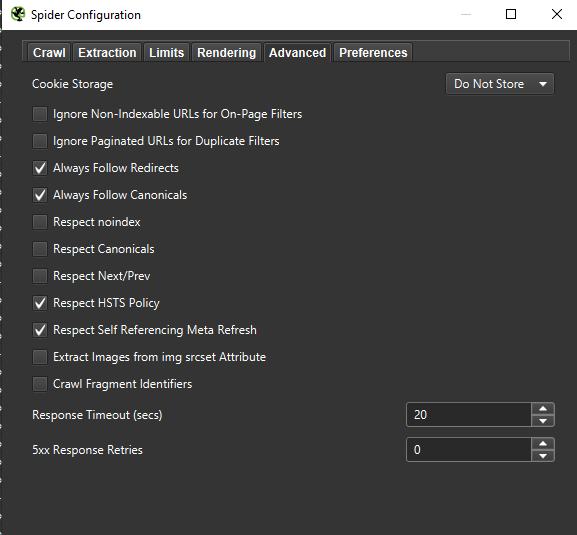

Importante : si queremos recrear el comportamiento de un Googlebot con la mayor precisión posible, la configuración correcta es imprescindible. Aquí puede ver configuraciones de muestra de mi computadora:

Al realizar un análisis en profundidad, es una buena decisión probar dos modos (solo texto, pero también JavaScript) para comparar las diferencias (si las hay).

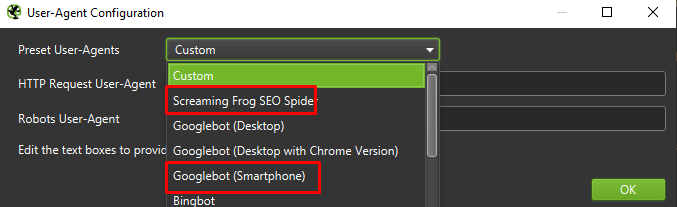

Finalmente, nunca está de más probar la configuración presentada anteriormente en dos agentes de usuario diferentes:

En la mayoría de los casos, solo tendrá que concentrarse en los resultados rastreados o presentados por el agente móvil.

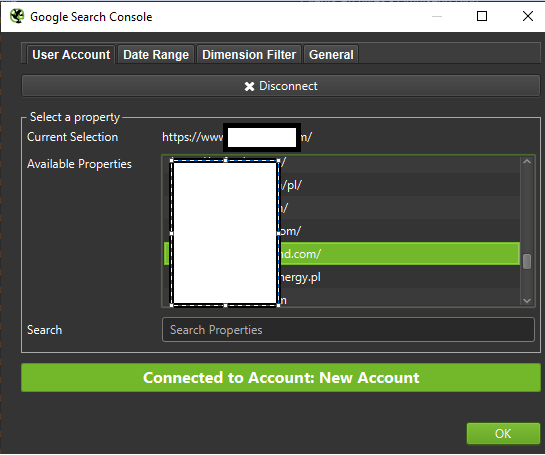

Importante: también sugiero aprovechar la oportunidad que brinda Screaming Frog y alimentar su rastreador con datos de GA y Google Search Console. La integración es una forma rápida de identificar el desperdicio del presupuesto de rastreo, como un cuerpo sustancial de URL potencialmente redundantes que no reciben tráfico.

Herramientas para el análisis de registros (Screaming Frog Logfile y otros)

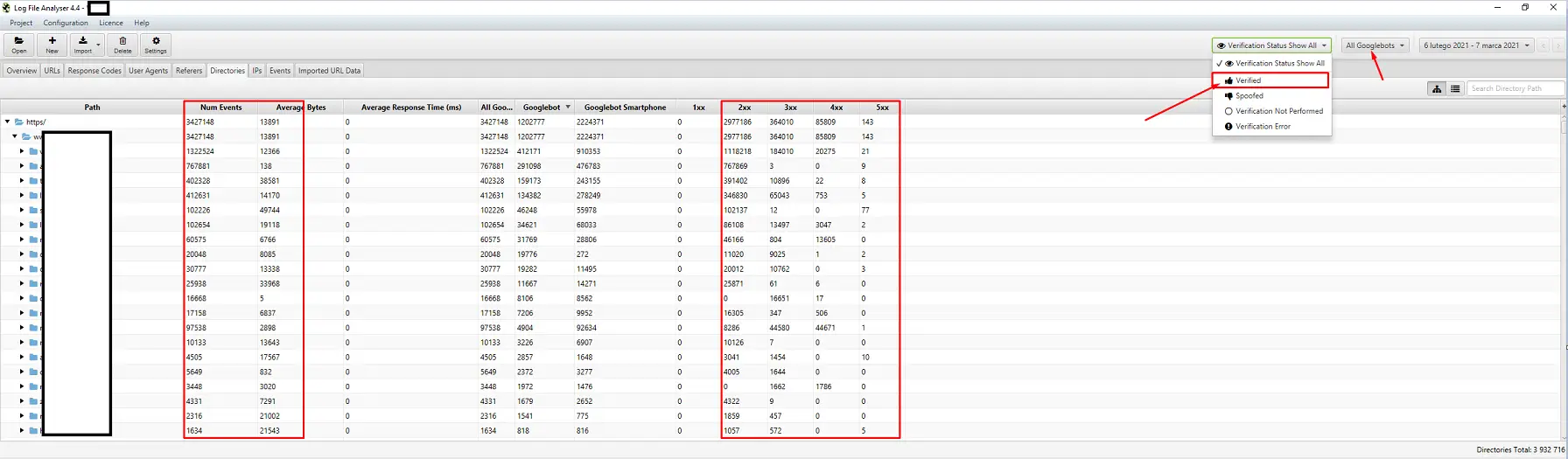

La elección de un analizador de registro del servidor es una cuestión de preferencia personal. Mi herramienta de acceso es Screaming Frog Log File Analyzer. Puede que no sea la solución más eficiente (cargar un paquete enorme de registros = colgar la aplicación), pero me gusta la interfaz. La parte importante es ordenar al sistema que muestre solo Googlebots verificados.

Herramientas para el seguimiento de la visibilidad

Una ayuda útil, ya que le permiten identificar sus páginas principales. Si una página tiene una clasificación alta para muchas palabras clave en Google (= recibe mucho tráfico), es posible que tenga una mayor demanda de rastreo (verifíquelo en los registros: ¿Google realmente genera más visitas para esta página en particular?).

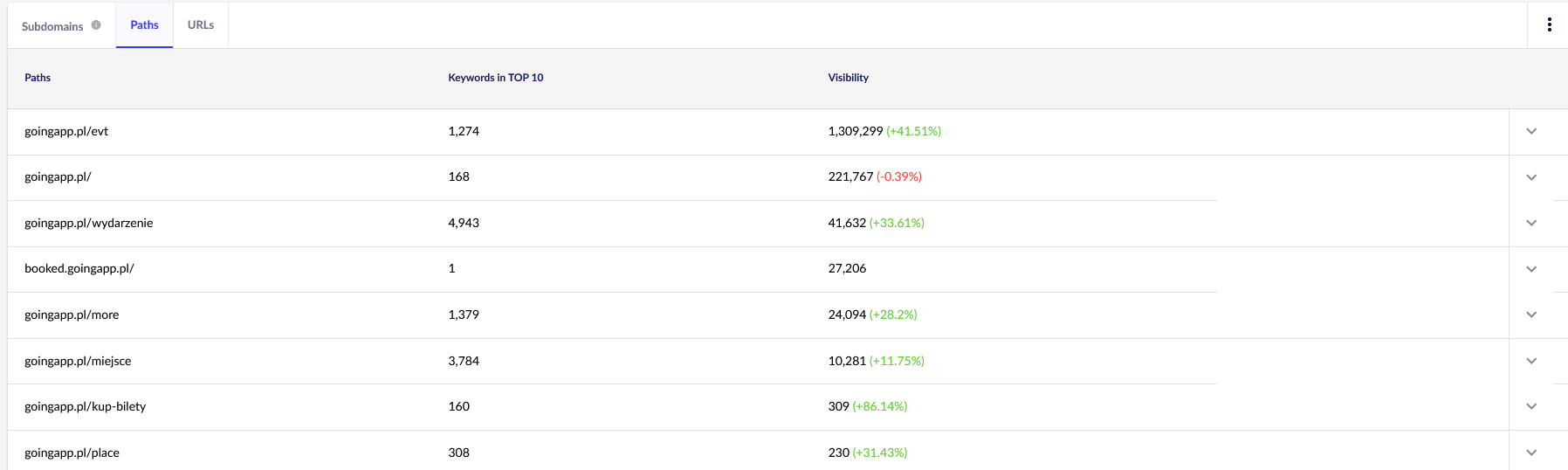

Para nuestros propósitos, necesitaremos informes generales en Senuto (Rutas y URL) para una revisión continua en el futuro. Ambos informes están disponibles en Análisis de visibilidad, en la pestaña Secciones. Echar un vistazo:

Nuestro principal punto de interés es el segundo informe. Vamos a ordenarlo para ver nuestra visibilidad de palabras clave (la lista y el número total de palabras clave para las que nuestro sitio web se clasifica en el TOP 10). Los resultados nos servirán para identificar el eje principal para la estimulación (y asignación eficiente) de nuestro presupuesto de rastreo.

Herramientas para análisis de backlinks (Ahrefs, Majestic)

Si una de sus páginas tiene una gran cantidad de enlaces entrantes, utilícela como pilar de su estrategia de optimización del presupuesto de rastreo. Las páginas populares pueden asumir el papel de centros que transfieren aún más el jugo. Además, una página popular con un grupo decente de enlaces valiosos tiene más posibilidades de atraer rastreos frecuentes.

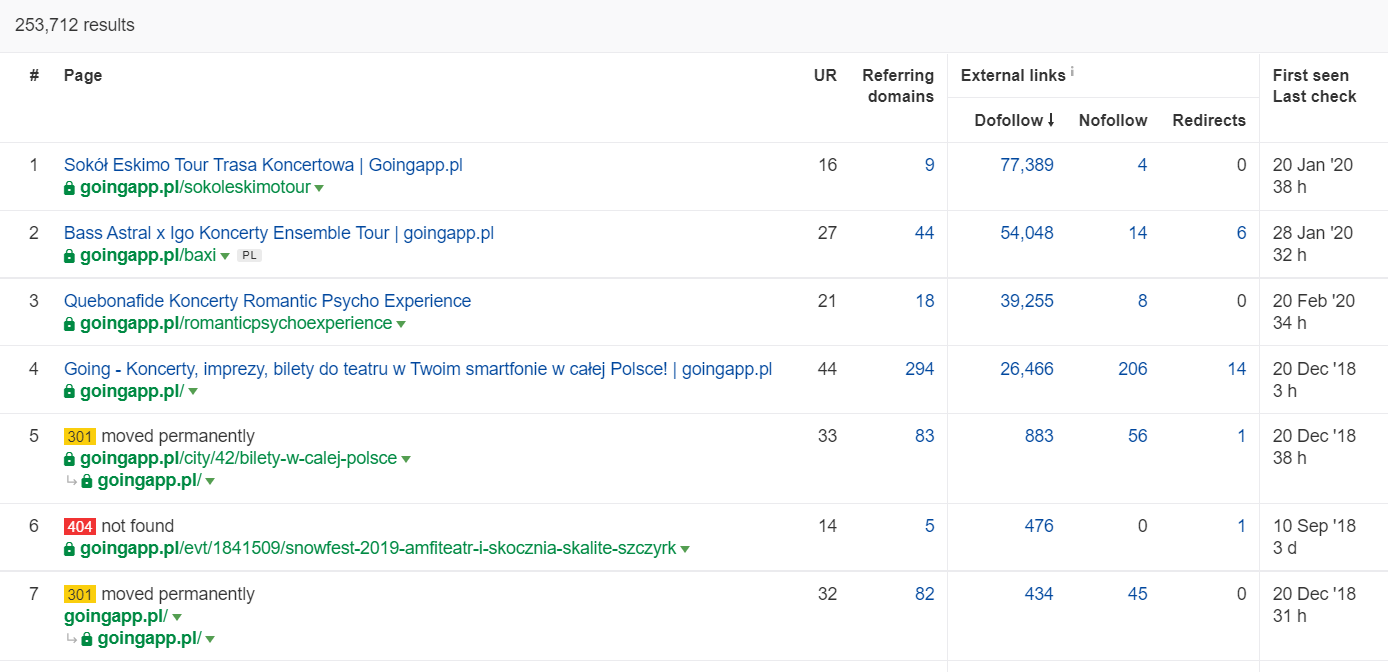

En Ahrefs necesitamos el reporte de Páginas, y para ser exactos, su parte titulada: “Best by links”:

El ejemplo anterior muestra que algunos LP relacionados con conciertos continuaron generando estadísticas sólidas para los vínculos de retroceso. Incluso con todos los conciertos cancelados debido a la pandemia, aún vale la pena usar páginas históricamente poderosas para despertar la curiosidad de los robots rastreadores y extender el jugo a los rincones más profundos de su sitio web.

¿Cuáles son los signos reveladores de un problema de presupuesto de rastreo?

No es fácil darse cuenta de que se trata de un presupuesto de rastreo problemático (excesivamente bajo). ¿Por qué? Principalmente, porque el SEO es una empresa extremadamente compleja. Los rangos bajos o los problemas de indexación también pueden ser la consecuencia de un perfil de enlace mediocre o la falta del contenido correcto en el sitio web.

Por lo general, un diagnóstico de presupuesto de rastreo implica verificar:

- ¿Cuánto tiempo pasa desde la publicación hasta la indexación de nuevas páginas (publicaciones de blog/productos), suponiendo que no solicite la indexación a través de Google Search Console?

- ¿Cuánto tiempo guarda Google las URL no válidas en su índice? Importante: las direcciones redirigidas son una excepción: Google las almacena a propósito.

- ¿Tiene páginas que ingresan al índice solo para abandonarlas más tarde?

- ¿Cuánto tiempo dedica Google a las páginas que no generan valor (tráfico)? Vaya a análisis de registro para averiguarlo.

¿Cómo analizar y optimizar el presupuesto de rastreo?

La decisión de sumergirse en la optimización del presupuesto de rastreo está dictada principalmente por el tamaño de su sitio web. Google sugiere que, en general, los sitios web de menos de 1000 páginas no deberían preocuparse por aprovechar al máximo sus límites de rastreo disponibles. En mi opinión, debe comenzar a luchar por un rastreo más eficiente y efectivo si su sitio web incluye más de 300 páginas y su contenido cambia dinámicamente (por ejemplo, sigue agregando nuevas páginas / publicaciones de blog).

¿Por qué? Es una cuestión de higiene SEO. Implemente buenos hábitos de optimización y una buena administración del presupuesto de rastreo en los primeros días, y tendrá menos que rectificar y rediseñar en el futuro.

Optimización del presupuesto de rastreo. Un procedimiento estándar

En general, el trabajo de análisis y optimización del presupuesto de captura consta de tres etapas:

- Recopilación de datos, que es el proceso de recopilar todo lo que sabemos sobre el sitio web, tanto de los webmasters como de herramientas externas.

- Análisis de visibilidad e identificación de frutos colgantes bajos. ¿Qué funciona como un reloj? ¿Que podría ser mejor? ¿Qué áreas tienen el mayor potencial de crecimiento?

- Recomendaciones para el presupuesto de rastreo.

Recopilación de datos para una auditoría de presupuesto de rastreo

1. Un rastreo completo del sitio web realizado con una de las herramientas disponibles comercialmente. El objetivo es completar un mínimo de dos rastreos: el primero simula el robot de Google, mientras que el otro obtiene el sitio web como un agente de usuario predeterminado (el agente de usuario de un navegador servirá). En esta etapa, solo le interesa descargar el 100% del contenido . Si nota que el rastreador entró en un bucle (cuando, después de un día de rastreo, todavía tenemos solo el 10% del sitio web en nuestro disco duro), informe que hay un problema y puede detener el rastreo. Un número razonable de URL para análisis, en el caso de sitios web grandes, es de alrededor de 250 a 300 mil páginas.

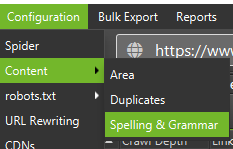

a) Lo que buscamos son principalmente redirecciones internas 301, errores 404, pero también las situaciones en las que sus textos pueden clasificarse como contenido delgado. Screaming Frog tiene la opción de detectar contenido casi duplicado:

2. Registros del servidor . El marco de tiempo ideal debería abarcar el último mes, sin embargo, en el caso de sitios web grandes, dos últimas semanas pueden ser suficientes. En el mejor de los casos, deberíamos tener acceso a los registros históricos del servidor para comparar los movimientos de Googlebot en el momento en que todo iba a la perfección.

3. Exportaciones de datos desde Google Search Console . En combinación con los puntos 1 y 2 anteriores, los datos de Index Coverage y Crawl Stats deberían brindarle una descripción bastante completa de todos los acontecimientos en su sitio web.

4. Datos de tráfico orgánico . Páginas principales según lo determinado por Google Search Console, Google Analytics, así como Senuto y Ahrefs. Queremos identificar todas las páginas que se destacan entre la multitud con sus estadísticas de alta visibilidad, volumen de tráfico o recuento de backlinks. Estas páginas deben convertirse en la columna vertebral de su trabajo en el presupuesto de rastreo. Los utilizaremos para mejorar el rastreo de las páginas más importantes.

5. Revisión del índice manual . En algunos casos, el mejor amigo de un experto en SEO es una solución sencilla. En este caso: ¡una revisión de los datos extraídos directamente del índice! Es una buena decisión revisar su sitio web con el combo de los operadores inurl: + site:.Finalmente, necesitamos fusionar todos los datos recopilados. Por lo general, usaremos un rastreador externo con funciones que permitan la importación de datos externos (datos de GSC, registros del servidor y datos de tráfico orgánico).

Análisis de visibilidad y frutas al alcance de la mano

El proceso amerita un artículo aparte, pero nuestro objetivo hoy es obtener una vista panorámica de nuestros objetivos para el sitio web y el progreso realizado. Estamos interesados en todo lo que se salga de lo común: caídas repentinas de tráfico (que no pueden explicarse por tendencias estacionales) y los cambios simultáneos en la visibilidad orgánica. Estamos comprobando qué grupos de páginas son los más fuertes porque se convertirán en nuestros CENTROS para impulsar a Googlebot más profundamente en nuestro sitio web.

En el mundo perfecto, dicha verificación debería cubrir todo el historial de nuestro sitio web desde su lanzamiento. Sin embargo, como el volumen de datos sigue creciendo cada mes, concentrémonos en analizar la visibilidad y el tráfico orgánico del último período de 12 meses.

Presupuesto de rastreo: nuestras recomendaciones

Las actividades enumeradas anteriormente diferirán según el tamaño del sitio web optimizado. Sin embargo, son los elementos más importantes que siempre considero cuando realizo un análisis de presupuesto de rastreo. El objetivo primordial es eliminar los cuellos de botella en su sitio web. En otras palabras, para garantizar la máxima capacidad de rastreo para Googlebots (u otros agentes de indexación).

1. Empecemos por lo básico: la eliminación de todo tipo de errores 404/410, el análisis de las redirecciones internas y su eliminación de los enlaces internos . Deberíamos concluir nuestro trabajo con un rastreo final. Esta vez, todos los enlaces deberían devolver un código de respuesta 200, sin redirecciones internas ni errores 404.

- En esta etapa, es una buena idea rectificar todas las cadenas de redirección detectadas en el informe de backlinks.

2. Después del rastreo, asegúrese de que la estructura de nuestro sitio web esté libre de duplicados evidentes .

- Verifique también la posible canibalización: además de los problemas que surgen al orientar la misma palabra clave con varias páginas (en resumen, deja de controlar qué página mostrará Google), la canibalización afecta negativamente a todo su presupuesto de rastreo.

- Consolide los duplicados identificados en una sola URL (generalmente la que tiene una clasificación más alta).

3. Verifique cuántas URL tienen la etiqueta noindex . Como sabemos, Google aún puede navegar por esas páginas. Simplemente no aparecen en los resultados de búsqueda. Estamos tratando de minimizar la proporción de etiquetas noindex en la estructura de nuestro sitio web.

- Caso en cuestión: un blog organiza su estructura con etiquetas; los autores afirman que la solución está dictada por la conveniencia del usuario. Cada publicación está etiquetada con 3 a 5 etiquetas, asignadas de manera inconsistente y no indexadas. El análisis de registros revela que es la tercera estructura más rastreada del sitio web.

4. Revisa el archivo robots.txt . Recuerde que implementar robots.txt no significa que Google no mostrará la dirección en el índice.

- Compruebe cuáles de las estructuras de direcciones bloqueadas aún se rastrean. ¿Tal vez cortarlos está causando un cuello de botella?

- Elimine las directivas obsoletas/innecesarias.

5. Analice el volumen de URL no canónicas en su sitio web. Google dejó de considerar rel=”canonical” como una directiva estricta. En muchos casos, el motor de búsqueda ignora completamente el atributo (la clasificación de los parámetros en el índice sigue siendo una pesadilla).

6. Analizar los filtros y su mecanismo subyacente . Filtrar los listados es el mayor dolor de cabeza de la optimización del presupuesto de rastreo. Los dueños de negocios de comercio electrónico insisten en implementar filtros aplicables en cualquier combinación (por ejemplo, filtrar por color + material + tamaño + disponibilidad… hasta la enésima vez). La solución no es óptima y debe limitarse al mínimo.

7. Arquitectura de la información en el sitio web : una que considere los objetivos comerciales, el tráfico potencial y el perfil de enlace actual. Supongamos que un enlace al contenido crítico para nuestros objetivos comerciales debe estar visible en todo el sitio (en todas las páginas) o en la página de inicio. Estamos simplificando aquí, por supuesto, pero la página de inicio y el menú superior/los enlaces en todo el sitio son los indicadores más poderosos para generar valor a partir de los enlaces internos. Al mismo tiempo, estamos tratando de lograr la distribución óptima de dominios: nuestro objetivo es la situación en la que podemos comenzar el rastreo desde cualquier página y aun así llegar a la misma cantidad de páginas (cada URL debe tener un enlace entrante COMO MÍNIMO) .

- Trabajar hacia una arquitectura de información sólida es uno de los elementos clave de la optimización del presupuesto de rastreo. Nos permite liberar algunos de los recursos del bot de una ubicación y redirigirlos a otra. También es uno de los mayores desafíos, ya que requiere la cooperación de las partes interesadas del negocio, lo que a menudo conduce a grandes batallas y críticas que socavan las recomendaciones de SEO.

8. Representación de contenido. Crítico en el caso de sitios web que pretenden basar su enlace interno en sistemas de recomendación que capturan el comportamiento del usuario. Sobre todo, la mayoría de estas herramientas se basan en archivos de cookies. Google no almacena cookies, por lo que no obtiene resultados personalizados. El resultado: Google siempre ve el mismo contenido o ningún contenido.

- Es un error común evitar que Googlebot acceda a contenido JS/CSS crítico. Este movimiento puede generar problemas con la indexación de la página (y hacer perder el tiempo de Google al mostrar contenido no disponible).

9. Rendimiento del sitio web: Core Web Vitals . Si bien soy escéptico sobre el impacto de CWV en las clasificaciones de sitios (por muchas razones, incluida la diversidad de dispositivos disponibles comercialmente y las diferentes velocidades de la conexión a Internet), es uno de los parámetros que más vale la pena discutir con un programador.

10. Sitemap.xml : compruebe si funciona y contiene todos los elementos clave (nada más que URL canónicas que devuelven un código de estado 200).

- Mi primera recomendación para optimizar sitemap.xml es dividir sus páginas por tipo o, cuando sea posible, por categoría. La división le dará control total sobre los movimientos de Google y la indexación del contenido.