BERT : la plus grande mise à jour de Google depuis des années

Publié: 2022-12-01Le BERT de Google a été mis en ligne fin 2019 et a touché près de 10 % de toutes les recherches. Sans doute l'une des plus grandes mises à jour d'algorithmes de 2019, voici tout ce que les référenceurs et les propriétaires de sites doivent savoir sur le modèle avancé de traitement du langage naturel de Google.

Qu'est-ce que le BERT de Google ?

BERT est un algorithme d'apprentissage en profondeur et l'abréviation de Représentations d'encodeurs bidirectionnels à partir de transformateurs. L'algorithme a aidé à afficher des résultats plus pertinents pour les requêtes de recherche complexes.

Quel a été l'effet de la mise à jour de l'algorithme BERT sur la recherche Google ?

Voici ce que Google a dit :

"Ces améliorations visent à améliorer la compréhension de la langue, en particulier pour les requêtes en langage naturel/conversationnel, car BERT est en mesure d'aider la recherche à mieux comprendre la nuance et le contexte des mots dans les recherches et à mieux faire correspondre ces requêtes avec des résultats utiles.

Particulièrement pour les requêtes plus longues et plus conversationnelles, ou les recherches où les prépositions comme "pour" et "à" comptent beaucoup pour le sens, la recherche sera en mesure de comprendre le contexte des mots de votre requête. Vous pouvez rechercher d'une manière qui vous semble naturelle.

En fait, selon Google, la mise à jour BERT aura un impact sur 1 recherche en anglais sur 10 aux États-Unis, soit 10 % des requêtes de recherche. Il s'agit de la mise à jour la plus importante de Google au cours des 5 dernières années, du moins selon eux :

Nous apportons une amélioration significative à la façon dont nous comprenons les requêtes, ce qui représente le plus grand bond en avant au cours des cinq dernières années et l'un des plus grands pas en avant de l'histoire de la recherche.

L'introduction de BERT a provoqué d'importantes fluctuations de classement au cours de la première semaine de déploiement du nouvel algorithme. Les référenceurs de Webmaster World ont commenté les fluctuations depuis le début de la semaine, notant la plus grande fluctuation des classements dans le monde du référencement depuis RankBrain.

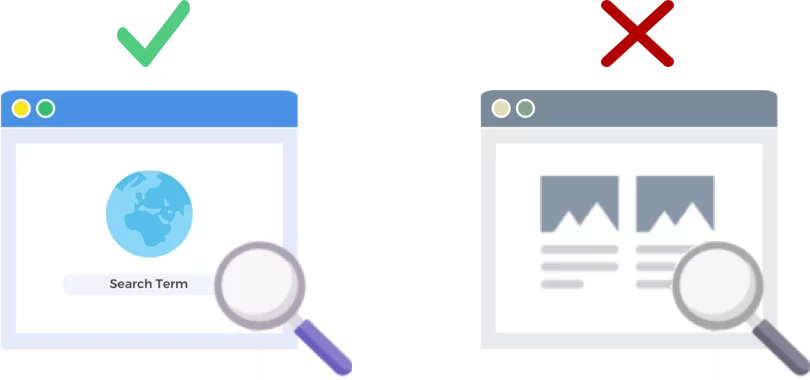

BERT analyse les requêtes de recherche PAS les pages Web

La version du 24 octobre 2019 de l'algorithme BERT améliore la façon dont le géant des moteurs de recherche analyse et comprend les requêtes de recherche (et non les pages Web).

Comment fonctionne le BERT ?

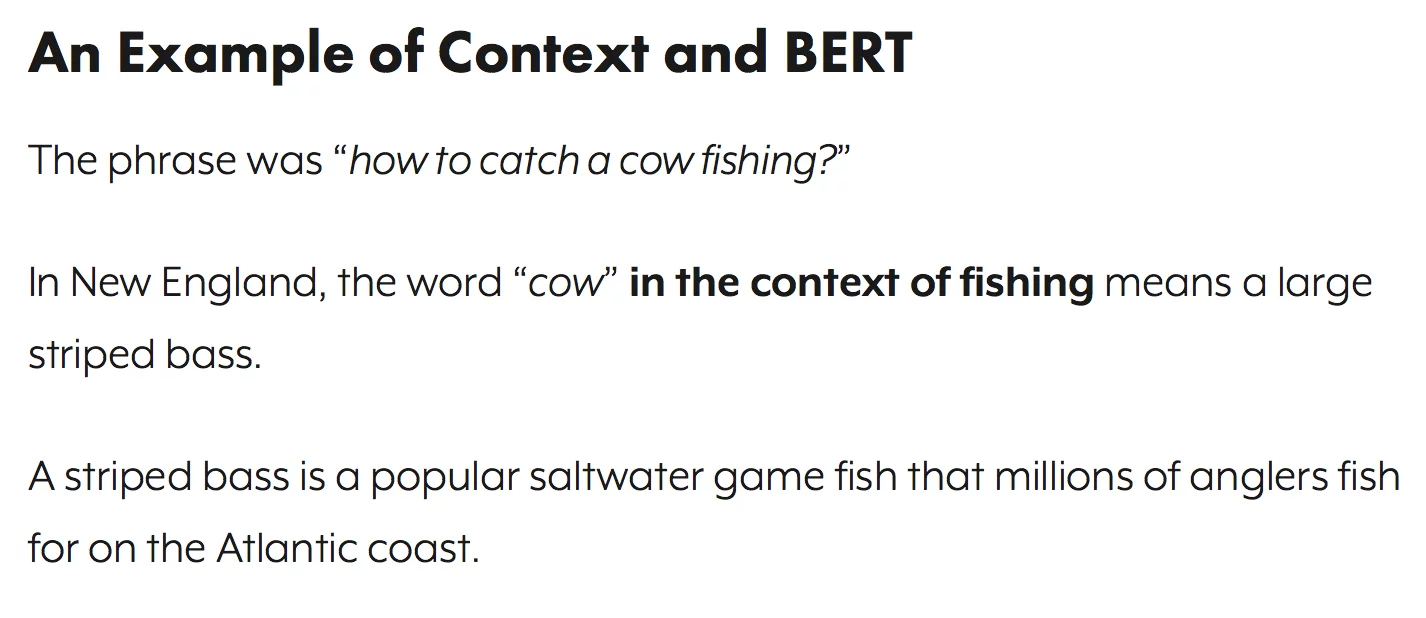

BERT améliore la compréhension de Google des requêtes de recherche en utilisant un modèle de contexte bidirectionnel (c'est le B dans BERT). Google a en fait parlé un peu des mécanismes du BERT à la même époque l'année dernière lorsqu'ils ont annoncé le BERT comme une nouvelle technique de pré-formation au traitement du langage naturel (NLP).

Qu'est-ce que la pré-formation ? La pré-formation consiste simplement à enseigner à une machine comment effectuer des tâches, avant de lui donner réellement du travail à faire. Traditionnellement, les ensembles de données de pré-formation sont chargés de quelques milliers à quelques centaines de milliers d'exemples étiquetés par l'homme.

La pré-formation existe depuis un moment, mais ce qui rend le BERT spécial, c'est qu'il est à la fois contextuel (le sens de chaque mot change en fonction des mots qui l'entourent) et bidirectionnel - le sens d'un mot est compris en fonction des mots à la fois Avant et après ça.

Par le blog de Google :

Dans la phrase « J'ai accédé au compte bancaire », un modèle contextuel unidirectionnel représenterait la « banque » basée sur « J'ai accédé au » mais pas au « compte ». Cependant, BERT représente la « banque » en utilisant à la fois son contexte précédent et suivant - « J'ai accédé au compte … » – en partant du bas d'un réseau neuronal profond, ce qui le rend profondément bidirectionnel.

La mise à jour de Google BERT s'appuie sur les avancées récentes en matière d'apprentissage automatique et de reconnaissance d'entités. Fondamentalement, BERT aide à identifier toutes les parties du discours et le contexte des mots avant que Google ne traite une recherche.

Que signifie BERT pour les résultats de recherche ?

Selon Google, cela signifie que les utilisateurs vont commencer à voir des résultats plus pertinents, des résultats qui correspondent mieux à l'intention de recherche d'un utilisateur. Cette amélioration de l'algorithme couvrira les résultats réguliers et les résultats d'extraits enrichis.

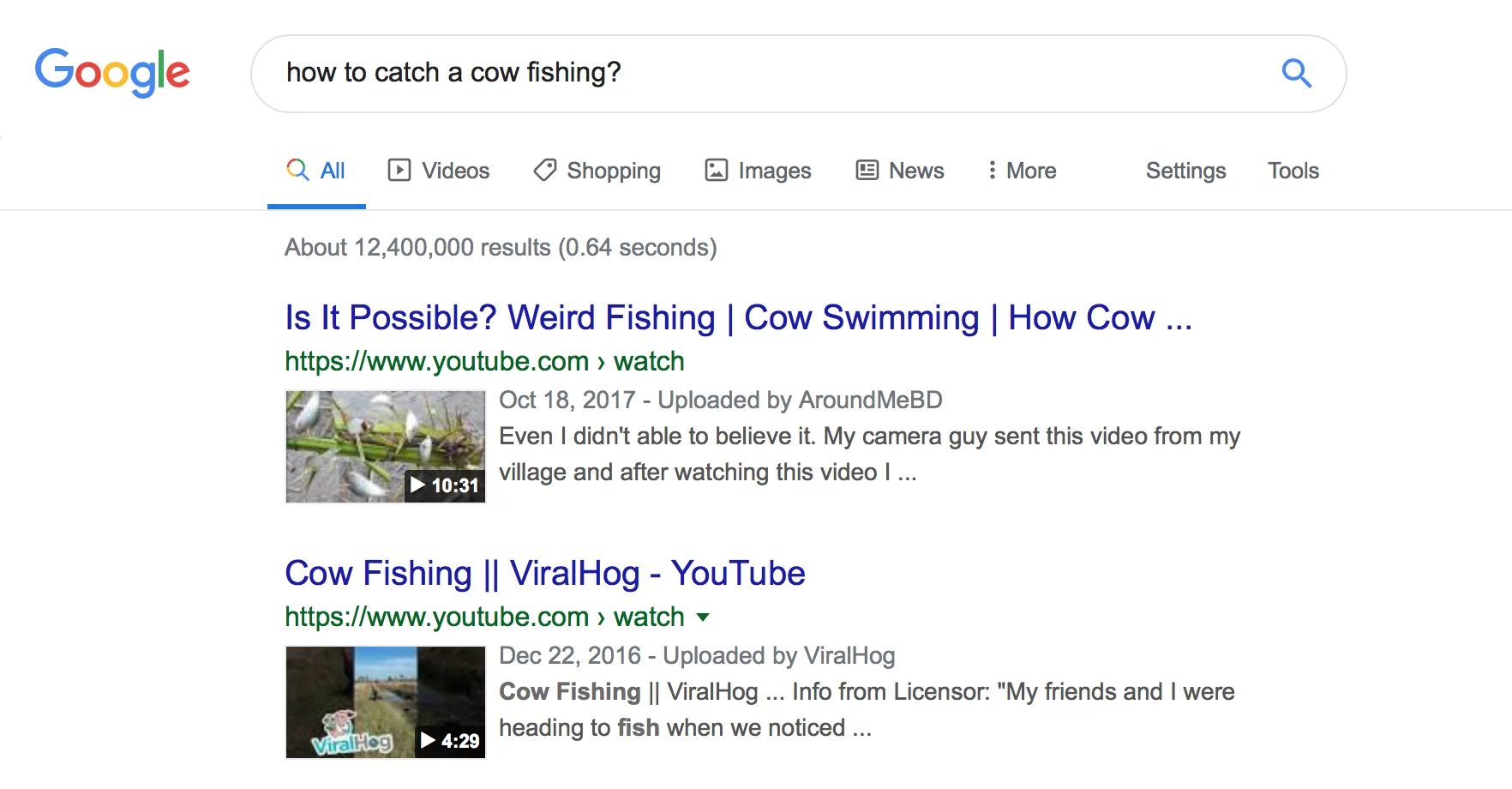

Google a fourni quelques exemples utiles dans son entrée de blog annonçant BERT.

L'exemple de l'esthéticienne

Tout d'abord, nous avons un utilisateur qui essaie de comprendre si les esthéticiennes passent beaucoup de temps debout dans le cadre de leur travail.

Vous pouvez voir ci-dessous qu'avant le BERT, Google a lu la requête "les esthéticiennes se tiennent-elles beaucoup au travail" et a produit un résultat comparant les types d'environnements de travail pour les esthéticiennes.

Après BERT, Google publie un article sur les exigences physiques d'être une esthéticienne, beaucoup plus conforme aux informations que le chercheur essayait à l'origine de faire apparaître.

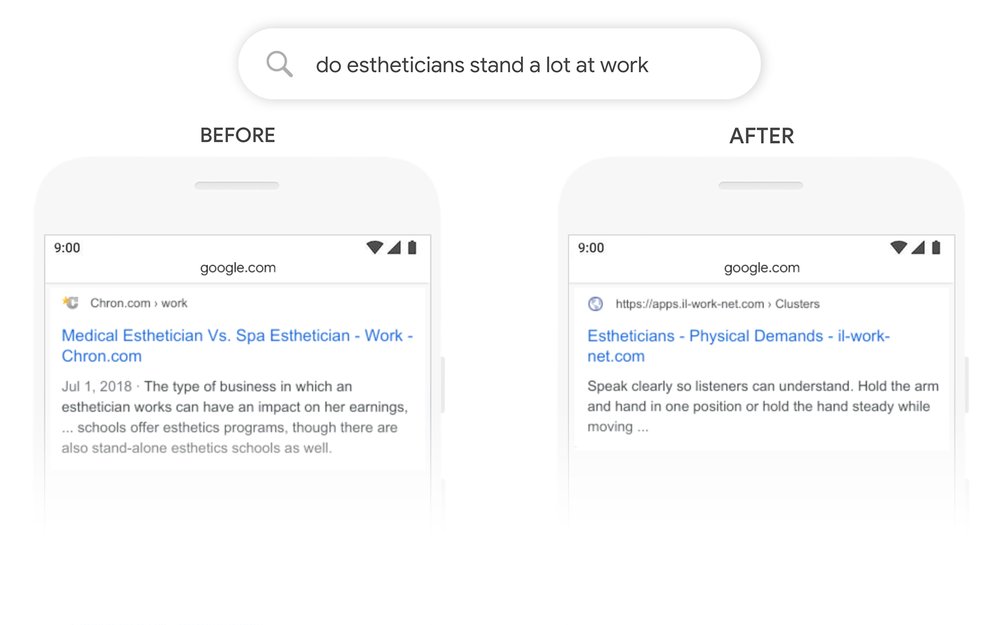

L'exemple de livres de pratique mathématique

Dans cet exemple, un utilisateur recherche des livres d'exercices mathématiques pour adultes, mais affiche des livres d'exercices mathématiques pour enfants.

Après BERT, Google reconnaît correctement le contexte de la requête, rendant mieux compte de la deuxième partie de la recherche « pour adultes ».

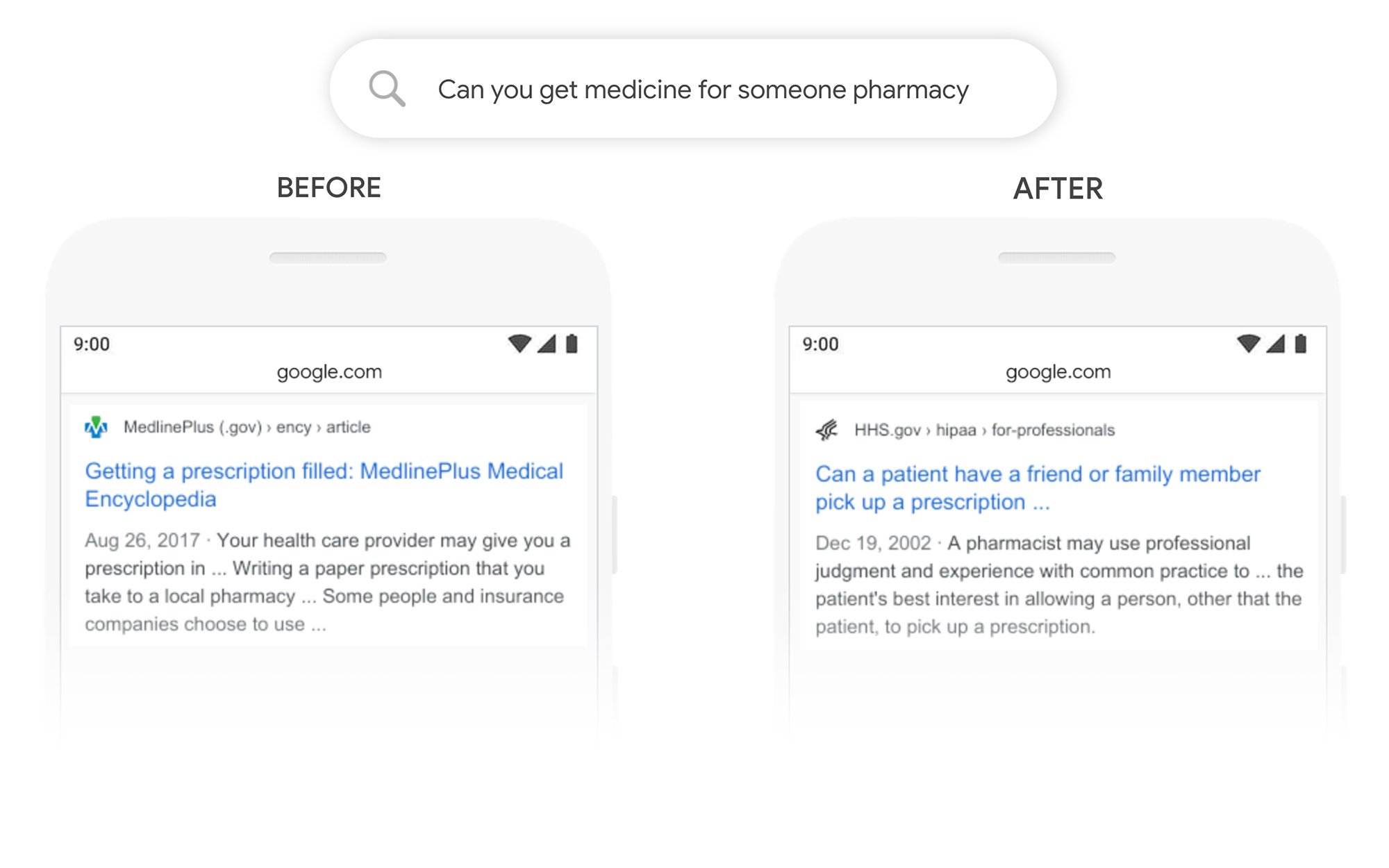

L'exemple Pouvez-vous prendre des médicaments pour quelqu'un d'autre

Dans cet exemple, la requête « pouvez-vous obtenir des médicaments pour quelqu'un dans une pharmacie » renvoie un résultat sur la façon de remplir les ordonnances en général, plutôt que sur la façon de les remplir pour un tiers. Après BERT, Google comprend mieux l'objectif de l'utilisateur et indique si un patient peut ou non demander à un ami ou à un membre de sa famille de récupérer son ordonnance pour lui.

Que puis-je faire pour mieux me classer après le BERT ?

Pour tous les mots clés où vous perdez votre classement, vous devriez consulter la page de résultats de recherche révisée pour mieux comprendre comment Google visualise l'intention de recherche de vos termes cibles. Révisez ensuite votre contenu en conséquence pour mieux répondre aux objectifs de l'utilisateur.

Si vous avez perdu des classements sous BERT, il est plus probable que ce soit un problème lié à la façon dont votre page correspond à l'intention de recherche d'un utilisateur (aide un utilisateur à atteindre son objectif) qu'à un problème de qualité du contenu.

Étant donné que le BERT est susceptible de soutenir davantage les efforts de recherche vocale au fil du temps, nous recommandons également aux sites Web de rédiger une copie claire et concise. N'utilisez pas de langage de remplissage, ne soyez pas vague, allez droit au but.

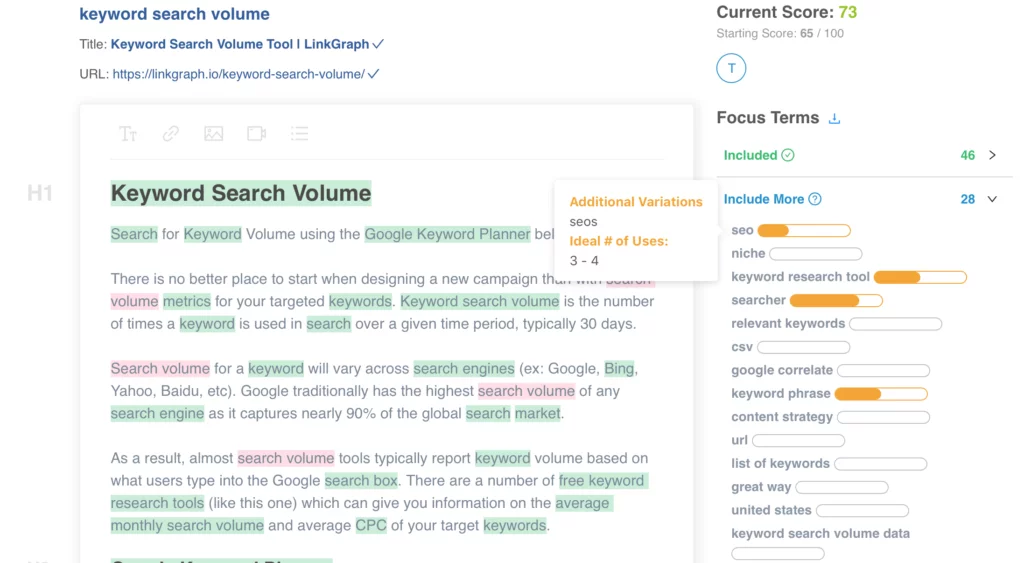

Besoin d'aide pour optimiser votre contenu ? Découvrez l'optimiseur de contenu sur page de LinkGraph, contactez un membre de notre équipe à [email protected] ou planifiez une réunion pour vous installer dès aujourd'hui.

Où puis-je en savoir plus ?

Dawn Anderson a fait une excellente présentation plus tôt ce mois-ci à Pubcon sur "Google BERT et la famille et la course aux classements pour la compréhension du langage naturel", et vous pouvez jeter un œil à sa présentation.

Merci d'avoir mon #Pubcon. Voici mon deck <3 <3 https://t.co/aGYDI9pfdY

– Aube Anderson (@dawnieando) 10 octobre 2019

Jeff Dean a également récemment fait un discours sur l'IA chez Google, y compris BERT, que vous pouvez regarder.