7 meilleurs outils de scraping Web en ligne en 2023

Publié: 2023-11-17Résumé : Les outils de web scraping rationalisent la procédure d'extraction de données à partir de sites Web pour prendre des décisions basées sur les données. Explorons quelques-uns des meilleurs outils de scraping que vous pouvez utiliser à cette fin.

Les outils de scraping de sites Web jouent un rôle déterminant dans l’extraction de données des sites Web. Ils permettent aux utilisateurs de collecter, d'analyser et d'organiser des informations à diverses fins, notamment la recherche, l'analyse et les informations sur la concurrence. Ils peuvent automatiser l’ensemble du processus d’extraction de données et contribuer de manière significative à la prise de décision basée sur les données dans divers domaines.

Dans cet article, nous découvrirons les meilleurs outils d’extraction Web qui peuvent s’avérer utiles lors de l’exportation de données. Mais d’abord, apprenons ce qu’est exactement le web scraping.

Table des matières

Qu’est-ce que le Web Scraping ?

Le Web scraping est un moyen automatisé de collecter des données en masse à partir de différents sites Web. Les données extraites sont des données non structurées au format HTML qui sont converties en données structurées telles que des feuilles de calcul et une base de données.

Il existe plusieurs façons de supprimer les données des sites Web, par exemple en utilisant des API, des logiciels et en créant votre propre code unique pour ceux-ci. De nombreux exemples de logiciels proposent des robots de scraping intégrés ou vous permettent de créer vos propres robots de scraping pour le web scraping.

Liste de 7 outils de Web Scraping de 2023 en Inde pour les débutants

- Poulpe

- ParseHub

- Robot racleur

- Abeille à gratter

- Apifier

- Zenscrape

- Grattoir Web

Voici l'énumération détaillée des meilleurs outils de web scraping en fonction de leurs fonctionnalités, prix, avantages et inconvénients, etc., pour vous aider à choisir le meilleur logiciel.

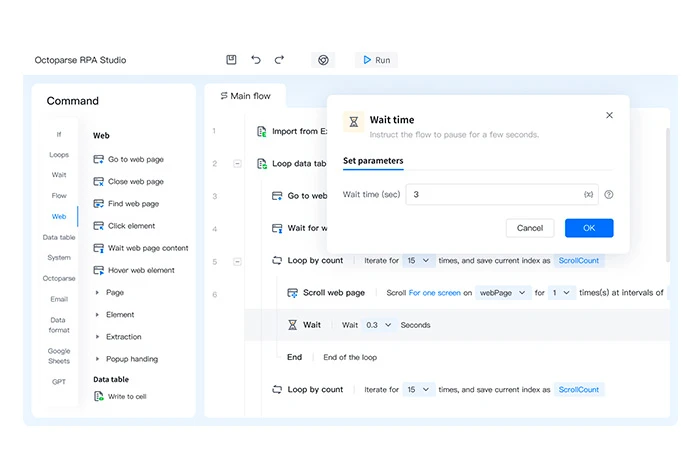

Poulpe

Octoparse est un outil de suppression de sites Web qui vous permet de transformer vos pages Web en données structurées en quelques secondes. Il s'agit d'un logiciel sans code qui peut extraire des informations pertinentes de différents types de sites Web ou de pages Web.

Les données non structurées qu'il extrait de n'importe quel site Web sont enregistrées dans des formats de fichiers structurés tels que HTML, texte brut, Excel, etc.

Caractéristiques d'Octoparse

- Exporte les données dans plusieurs formats comme Excel, CSV et JSON

- Planifie l'exportation des données vers des bases de données

- Fournit plusieurs modèles pour récupérer des données

- Construit des scrapers Web sans code

- Crée 750 tâches pour le web scraping

Avantages et inconvénients d'Octoparse

- Il prend en charge la rotation automatique des adresses IP lors de l'extraction de données d'un site Web afin de réduire les risques de traçage.

- Vous pouvez également extraire des données de plusieurs cloud via des serveurs cloud.

- Options limitées disponibles pour personnaliser le logiciel.

Tarification d'Octoparse : plan gratuit disponible | Le forfait payant commence à partir de 6 241,54 INR/mois

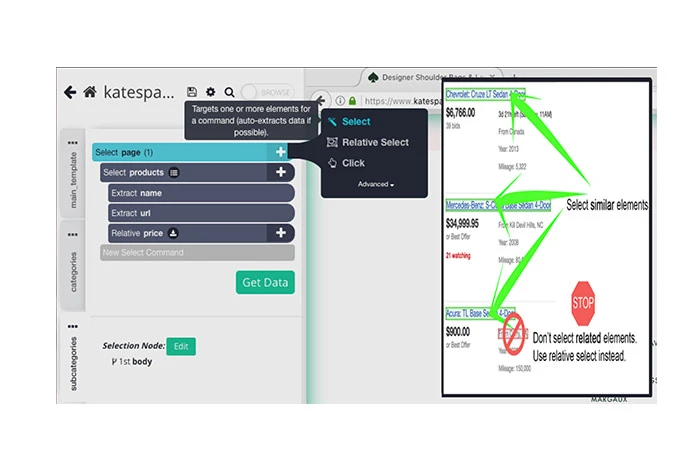

ParseHub

L'outil de suppression gratuit ParseHub peut être utilisé pour supprimer les données de divers sites Web. Tout ce que vous avez à faire est de sélectionner le site Web à supprimer, de choisir les données à supprimer et d'exporter les données récupérées dans différents formats.

Il peut être utilisé pour stocker des données provenant de divers serveurs, pour le rendu JavaScript, pour résoudre des CAPTCHA, etc. Grâce à sa fonction de planification, vous pouvez également planifier l'extraction de données sur divers sites Web.

Fonctionnalités de ParseHub

- Rotation automatique des adresses IP pour explorer les sites Web

- Importe les données récupérées dans plusieurs formats tels que JSON et Excel

- Supprime les pistes de vente des annuaires, des communautés, des réseaux sociaux, etc.

- Offre plusieurs API pour regrouper les données provenant de diverses sources

- Extrait les données des tableaux, des cartes et des graphiques

Avantages et inconvénients de ParseHub

- Il offre une intégration avec Dropbox pour enregistrer les données extraites.

- Vous pouvez l'utiliser pour extraire des images, du texte, des attributs, etc. de sites Web.

- Les utilisateurs ayant peu de connaissances techniques pourraient avoir des difficultés à utiliser le logiciel.

Tarification de ParseHub : plan gratuit disponible | Le forfait payant commence à partir de 15 736,69 INR/mois

Robot racleur

Scraping Bot fournit une API de web scraping pour extraire des données HTML de diverses sources sans être bloqué. Il propose plusieurs API adaptées à un secteur spécifique pour extraire les données les plus pertinentes. Une fois les données analysées, il les importe automatiquement au format JSON pour les intégrer au flux de travail existant.

Fonctionnalités du robot de grattage

- Prend en charge les requêtes de serveur simultanées

- Automatise la procédure de collecte de données

- Extrait les détails des clients pour trouver des prospects

- Propose une analyse sentimentale

- Organise le contenu de diverses sources pour améliorer la stratégie de contenu

Avantages et inconvénients du robot Scraping

- Il prend également en charge le rendu JavaScript.

- Fournit un ciblage géographique pour filtrer les sites Web en fonction de votre géolocalisation

- Cela prend beaucoup de mémoire système et de RAM.

Tarification du Scraping Bot : plan gratuit disponible | Le forfait payant commence à partir de 3 476,21 INR/mois

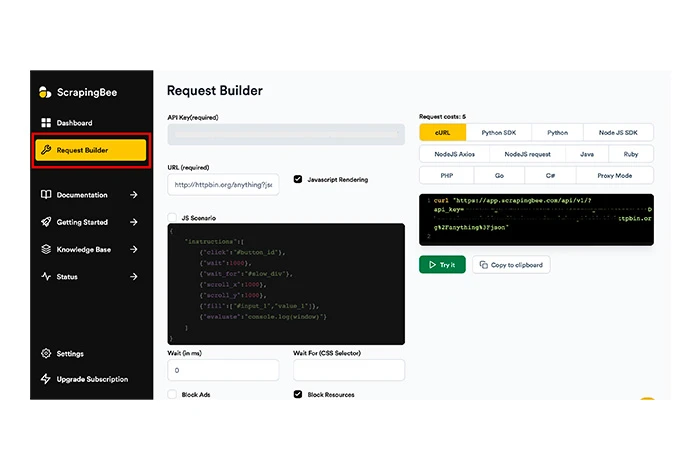

Abeille à gratter

Scrapingbee est un autre outil de scraping de sites Web qui peut vous aider avec le scraping général du Web, le scraping basé sur la page de résultats du moteur de recherche (SERP) et le piratage de croissance.

L'outil peut exécuter du JavaScript sur les pages et faire pivoter tous les proxys pour chaque demande afin de mettre la page HTML brute à votre disposition sans aucune chance d'être bloquée. ScrapingBee gère les CAPTCHA, les proxys et les navigateurs afin que vous puissiez facilement extraire les données du site de votre choix.

Caractéristiques de Scrapingbee

- Prend en charge la rotation IP pour le web scraping

- Fournit une rotation automatique du proxy

- Offre un scraping Web général

- Extrait les sites Web HTML, JSON, etc.

- Crée des moteurs de scraping Web personnalisés sans code

Avantages et inconvénients de Scrapingbee

- Prend en charge le grattage de données géo-ciblées.

- Fournit une API distincte pour le scraping de la recherche Google.

- Les erreurs internes du serveur se produisent très fréquemment.

Tarifs Scrapingbee : aucun plan gratuit disponible | Le forfait payant commence à partir de 4 077,57 INR/mois

Apifier

Apify est un logiciel de web scraping dans lequel vous pouvez créer, déployer et superviser divers outils de web scraping. Il vous permet de créer diverses API pour le scraping de sites Web et d'optimiser les proxys du centre de données pour l'extraction de données.

Apify dispose également d'une boutique dans laquelle il propose des outils de scraping prédéfinis pour le scraping de sites Web comme Instagram, Twitter, Google Maps, etc. Il est livré avec plusieurs fonctionnalités pour le scraping Web, l'automatisation des flux de travail et l'extraction de données.

Caractéristiques d'Apify

- Exécute un nombre illimité de tâches simultanément

- Gère les proxys pour les centres de données et les SERP

- Extrait les données d'Amazon, de schema.org, de pages Web, etc.

- Prend en charge la rotation des adresses IP lors de la récupération des données

- Offre une résolution CAPTCHA et un rendu JavaScript

- Exporte les données dans des formats tels que CSV, JSON, Excel, etc.

Avantages et inconvénients d'Apify

- Offre une rotation de proxy en tant que fonctionnalité intégrée.

- Les données sont accessibles dans plusieurs formats via des API.

- Des problèmes de compatibilité logicielle peuvent survenir.

Tarification Apify : plan gratuit disponible | Le forfait payant commence à partir de 4 077,64 INR/mois

Zenscrape

Zenscrape est une API qui gère tous les problèmes de web scraping et prend en charge l'extraction de données HTML de haute qualité. L'outil rend les requêtes via un navigateur Chrome sans tête moderne pour une agrégation de données précise et exacte.

Les données récupérées des sites Web sont exportées dans plusieurs formats comme Excel et JSON. De plus, grâce à sa fonction de géolocalisation, vous pouvez sélectionner l'emplacement proxy pour afficher le contenu du site Web géociblé.

Fonctionnalités de Zenscrape

- Prend en charge l'exploration du Web

- Effectue le scraping des données de prix

- Supprime automatiquement les informations de contacts des sites Web

- Gère les proxys de sites Web standard et premium

- Prise en charge de la rotation IP et de la résolution de CAPTCHA

Avantages et inconvénients de Zenscrape

- Il prend également en charge l'extraction de données HTML à partir de sites Web.

- Le temps de réponse des sites Web est très rapide dans Zenscrape.

- Vous devez utiliser un outil tiers pour convertir les données récupérées dans différents formats de fichiers.

Tarification de Zenscrape : plan gratuit disponible | Le forfait payant commence à partir de 2 496,26 INR/mois

Grattoir Web

Web Scraper est un outil de scraping en ligne que vous pouvez utiliser pour une extraction de données régulière et planifiée. Il peut être intégré à d’autres systèmes pour utiliser les données extraites. Avec cet outil de scraping, vous pouvez extraire les données en masse et exécuter simultanément les tâches de scraping de plusieurs sites Web.

Caractéristiques de Web Scraper

- Automatise rapidement la procédure d'extraction de données

- Configure les scrapers sans codage

- Extrait les données du site avec une prise en charge de la navigation à plusieurs niveaux

- Utilise des plans de site pour la personnalisation des données des sites Web

- Exporte les données au format CSV, XLSX, JSON et autres formats.

Avantages et inconvénients de Web Scraper

- Vous pouvez également planifier la suppression de sites Web en fonction des semaines, des jours, des heures, etc.

- Il peut faire pivoter l'IP avec plusieurs adresses IP.

- La mise en place prend beaucoup de temps.

- Les données récupérées ne sont conservées que jusqu'à 60 jours.

Tarifs Web Scraper : plan gratuit disponible | Le forfait payant commence à partir de 4 162,90 INR/mois

Comment choisir un grattoir Web ?

Pour choisir le bon web scraper, vous devez prendre en compte les facteurs suivants :

- Système d'exploitation pris en charge : le grattoir Web que vous envisagez d'acheter doit prendre en charge le système d'exploitation que vous utilisez.

- Prise en charge du cloud : avec cette prise en charge, vous pourrez enregistrer des données structurées sur le cloud.

- Intégration : L'intégration avec d'autres plateformes vous permet de transférer facilement les données récupérées vers d'autres plateformes.

- Formation : étant donné que l’utilisation d’un outil de suppression de sites Web nécessite des connaissances en programmation, vous devez choisir un outil proposant de nombreux supports de formation.

- Tarification : tenez compte du prix du logiciel et assurez-vous qu'il correspond à votre budget.

Comment fonctionne le Web Scraping ?

Le web scraping s’effectue en trois étapes simples. Premièrement, le robot de scraping simule la navigation humaine et supprime le site, deuxièmement, il analyse les données du nœud de données. Enfin, il télécharge et convertit les données analysées. Voici l’énumération détaillée de chaque étape en détail.

Étape 1 : Le robot de scraping Web simule n’importe quel humain lors de la navigation sur un site Web donné. Après cela, il saisit l'URL ciblée et envoie des requêtes à un serveur. Une fois cela fait, le serveur fournit des informations au fichier HTML.

Étape 2 : Avec le code HTML, le bot atteint le nœud de données et analyse les données comme commandé par le code de scraping.

Étape 3 : En fonction de la configuration du bot, les données récupérées sont nettoyées et converties au format de données structurées comme JSON. Après cela, les données sont prêtes à être importées ou transportées dans différentes bases de données.

Comparaison des meilleurs outils d'extraction Web

Voici une comparaison des meilleurs outils de scraping Web en fonction de leurs systèmes d'exploitation pris en charge, de la disponibilité des essais gratuits et de l'évaluation globale des utilisateurs.

| Logiciel | Système d'Exploitation pris en charge | Essai gratuit | Notation |

| Poulpe | Windows, Mac | Disponible | 4 |

| ParseHub | Windows, macOS, Linux | Pas disponible | 4.5 |

| Robot racleur | Windows, Mac | Disponible | 3.5 |

| Abeille à gratter | Basé sur le Web | Disponible pendant 14 jours | 4.1 |

| Apifier | Basé sur le Web | Utilisation gratuite | 4.9 |

| Zenscrape | Basé sur le Web | Outil d'analyse de données gratuit | 3.8 |

| Grattoir Web | Windows, Mac | Disponible pendant 7 jours | 4.1 |

Conclusion

Après avoir lu l'article, vous avez peut-être compris les outils de scraping de sites Web et comment ils peuvent vous aider dans l'extraction de données. Dans cet article, nous avons répertorié les meilleurs logiciels pour extraire et importer des données à partir de sites Web.

Basés sur des fonctionnalités telles que l'extraction de données, la rotation IP, la gestion des proxys, etc., ParseHub et Scraping Bot se sont révélés être les meilleurs outils de web scraping. Cependant, avant de choisir un outil de web scraping, assurez-vous de prendre en compte vos exigences en matière de prix et de fonctionnalités.

FAQ relative aux outils Web Scrapper

Que sont les outils d’extraction Web ?

Les outils de web scraping sont des logiciels conçus pour rationaliser la fonction d'extraction de données à partir de sites Web. Ces outils vous permettent de créer votre propre robot capable de supprimer les données requises de sites Web donnés.

A quoi sert le web scraping ?

Le web scraping peut être utilisé à plusieurs fins, telles que l'extraction de données sur les réseaux sociaux, d'informations sur les contacts, de données immobilières, d'informations sur le cours des actions et bien plus encore.

Comment extraire les données du site Internet ?

Pour extraire les données de votre site Web, vous pouvez utiliser différents outils de récupération de données. Certains des meilleurs outils que vous pouvez envisager pour le web scraping sont Zenscrape, Apify, Scrapingbee, Smartproxy, Agenty, etc.

Quels sont les avantages de l’utilisation d’outils de web scraping pour les entreprises ?

En utilisant des outils de web scraping, les entreprises peuvent automatiser le processus d'extraction de données, gagner un temps précieux et utiliser les données pour obtenir des informations précieuses. De plus, les entreprises peuvent également supprimer les données de plusieurs sites Web simultanément grâce à ces outils d'analyse Web afin d'économiser du temps et des ressources.

Des connaissances en codage sont-elles nécessaires pour utiliser les outils de web scraping ?

Des connaissances de base en codage sont nécessaires pour utiliser un outil de scraping de sites Web. Cependant, cela n’est pas nécessaire car de nombreux outils ont des interfaces conviviales et peuvent être utilisés avec peu ou pas de connaissances techniques.

Comment puis-je récupérer des données gratuitement ?

Pour récupérer gratuitement les données du site Web, vous pouvez choisir des outils de récupération de données gratuits. Ces outils proposent des forfaits gratuits ou sont totalement gratuits. Certains de ces outils incluent Apify, Zenscrape, Octoparse, etc.