Vous en avez assez que ChatGPT scrape votre contenu ? Protégez votre contenu MAINTENANT

Publié: 2023-07-06

Dans le paysage numérique d'aujourd'hui, la protection de votre contenu, de vos données et de votre trafic Web est de la plus haute importance. Avec l'émergence de ChatGPT et d'autres modèles de langage d'IA, on s'inquiète de plus en plus du fait que ces outils récupèrent du contenu pour leur propre bénéfice. En tant qu'éditeur, il est essentiel de comprendre le fonctionnement de ces bots et les risques potentiels qu'ils présentent.

Dans cet article, nous allons explorer le monde du scraping ChatGPT et LLM et discuter des stratégies pour déjouer et protéger le trafic de votre site Web.

Comment puis-je savoir que ChatGPT scrape mon contenu ?

ChatGPT, divers plugins et autres modèles de langage ont acquis le statut d'étoile en raison de leur remarquable capacité à générer du texte de type humain. Ces outils ont pris le relais et licencié des employés de divers secteurs, notamment la création de contenu, le service client et même l'écriture créative. Bien qu'ils puissent être utiles à bien des égards, il est essentiel de comprendre qu'il existe des cas où ils peuvent être utilisés à mauvais escient pour supprimer du contenu.

Le scraping, dans le contexte d'Internet, fait référence au processus d'extraction d'informations à partir de sites Web à l'aide de robots automatisés. Ces robots visitent différentes pages Web, collectent des données et les utilisent pour former davantage de modèles d'IA. Lorsque ChatGPT ou d'autres LLM récupèrent du contenu, ils utilisent essentiellement les données qu'ils collectent pour améliorer leurs capacités de génération de texte.

Cependant, le principal problème survient lorsque ce processus de grattage enfreint les droits de propriété intellectuelle et nuit aux activités des éditeurs et des médias. Il est essentiel d'être conscient de la façon dont votre contenu peut être scrapé et de ses conséquences potentielles sur votre trafic Web.

Les problèmes du scraping

L'un des principaux problèmes du scraping est qu'il peut entraîner une perte de contrôle sur votre contenu. Lorsque le contenu de votre site Web est extrait, il peut être réutilisé et distribué ailleurs sans votre consentement. Cela sape votre autorité en tant que créateur original et pose des problèmes pour maintenir l'exactitude et l'intégrité de votre contenu.

Le scraping peut avoir un impact significatif sur le classement des moteurs de recherche de votre site Web. Les moteurs de recherche donnent la priorité au contenu original et unique, et lorsque le contenu récupéré est publié ailleurs, il peut diluer la visibilité et la pertinence de votre site Web dans les résultats de recherche. Cela peut entraîner une diminution du trafic organique et une perte de revenus potentielle.

Cela peut également conduire à une représentation déformée de votre marque ou de votre organisation. Lorsque le contenu récupéré est utilisé de manière inappropriée ou hors contexte, il peut déformer vos intentions, ce qui peut semer la confusion ou même nuire à votre réputation. Il est crucial de protéger l'identité de votre marque et de vous assurer que votre contenu est utilisé de manière responsable et avec une attribution appropriée.

Résoudre le problème du scraping nécessite une approche à multiples facettes. En tant que créateur de contenu ou propriétaire de site Web, vous pouvez prendre plusieurs mesures pour protéger votre contenu contre le scraping. La mise en œuvre de technologies telles que CAPTCHA, le blocage IP ou les restrictions d'accès au contenu peut aider à dissuader les robots automatisés d'accéder à votre site Web et de le scraper.

De plus, la surveillance régulière du trafic de votre site Web et l'analyse du comportement des utilisateurs peuvent aider à identifier les activités suspectes pouvant indiquer un scraping. En restant vigilant et proactif, vous pouvez prendre les mesures appropriées pour atténuer l'impact du scraping sur votre contenu et votre activité.

Il est également essentiel pour les développeurs d'IA et les organisations utilisant des LLM comme ChatGPT de donner la priorité aux considérations éthiques . La mise en œuvre de directives et de politiques strictes qui découragent l'utilisation abusive du scraping peut aider à empêcher la collecte non autorisée de contenu. Le développement responsable de l'IA vise à trouver un équilibre entre l'innovation et le respect des droits de propriété intellectuelle.

Comment ChatGPT récupère-t-il votre contenu ?

Comprendre le processus de grattage utilisé par les bots ChatGPT est crucial pour traiter efficacement ce problème. Ces robots utilisent une technique connue sous le nom d'exploration du Web, où ils visitent des pages Web et suivent des liens pour collecter des informations. Ces informations sont ensuite utilisées pour former le modèle d'IA. Le scraping de contenu peut être préjudiciable aux éditeurs et aux entreprises de médias pour plusieurs raisons.

Premièrement, cela peut entraîner une perte de revenus si le contenu récupéré est republié sans autorisation. Cela peut compromettre la capacité des éditeurs d'origine à monétiser leur contenu et entraîner des pertes financières. De plus, cela peut ternir la réputation des éditeurs, car leur contenu peut être déformé ou sorti de son contexte lorsqu'il est republié par les bots ChatGPT.

Deuxièmement, l'impact sur l'expérience utilisateur est une préoccupation importante. Lorsque les bots ChatGPT inondent un site Web de demandes de récupération de contenu, cela peut surcharger le serveur et ralentir la vitesse de chargement pour les utilisateurs légitimes. Cela peut frustrer les visiteurs et les décourager de revenir sur le site Web, entraînant une diminution du trafic et une perte potentielle d'engagement et de revenus publicitaires.

Enfin, le contenu scrapé peut également affecter le classement des moteurs de recherche d'un site Web. Les moteurs de recherche donnent la priorité au contenu unique et original , pénalisant les sites Web avec du contenu dupliqué ou gratté. Si les robots ChatGPT récupèrent et republient le contenu des éditeurs, cela peut avoir un impact négatif sur les efforts d'optimisation des moteurs de recherche (SEO) des créateurs d'origine. Cela peut entraîner une baisse de visibilité et une réduction du trafic organique, ce qui nuit à la présence en ligne des éditeurs.

Compte tenu de ces risques, les éditeurs doivent protéger de manière proactive leur contenu et leur trafic Web contre le scraping ChatGPT et LLM. La mise en œuvre de mesures telles que les CAPTCHA , le blocage des adresses IP et la détection des agents utilisateurs peut aider à identifier et à bloquer les robots automatisés qui tentent de récupérer du contenu. De plus, la surveillance régulière du trafic Web et l'analyse des modèles peuvent aider à détecter toute activité de raclage anormale et à prendre les mesures appropriées.

De plus, les éditeurs peuvent explorer des voies légales pour protéger leur contenu. Les lois sur le droit d'auteur et les droits de propriété intellectuelle peuvent être appliqués pour empêcher le grattage et la republication non autorisés de leur travail. Demander des conseils juridiques et engager les poursuites nécessaires contre les entités contrevenantes peut envoyer un message fort et dissuader de futures tentatives de grattage.

La collaboration et la communication entre les éditeurs, les entreprises de médias et les développeurs d'IA sont également essentielles pour résoudre ce problème. L'établissement de partenariats et de dialogues ouverts peut conduire à l'élaboration de pratiques et de lignes directrices éthiques pour la formation à l'IA, garantissant que les droits des créateurs de contenu sont respectés tout en faisant progresser la technologie de l'IA.

Comment prendre de l'avance sur ChatGPT et protéger le trafic de votre site Web ?

Présentation de Traffic Cop : Votre bouclier contre le scraping non autorisé

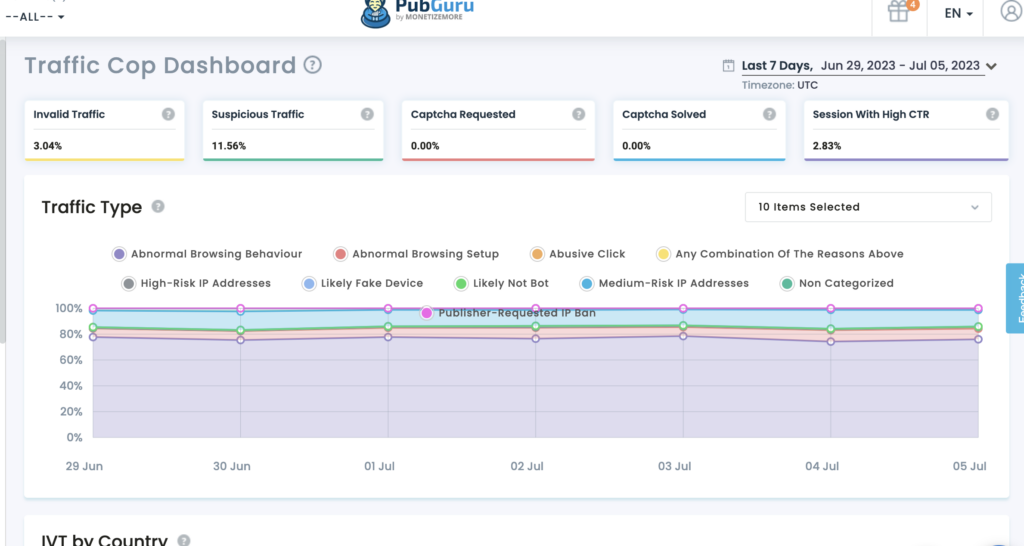

Traffic Cop de MonetizeMore est une solution de pointe qui agit comme un bouclier robuste, protégeant efficacement vos actifs numériques contre les bots et les accès non autorisés.

Protéger votre contenu : Avec Traffic Cop, votre précieux contenu reste protégé contre le grattage non autorisé. Ses algorithmes avancés d'apprentissage automatique lui permettent d'identifier et de différencier le trafic utilisateur légitime des robots malveillants. Traffic Cop bloque efficacement les tentatives de scraping, garantissant que votre contenu reste exclusif à votre site Web.

Sécurisation de vos données : les données sont la pierre angulaire des entreprises en ligne. Traffic Cop vous aide à maintenir l'intégrité et la confidentialité de vos données. L'outil primé utilise des algorithmes sophistiqués pour identifier et bloquer les activités de collecte de données, garantissant ainsi la protection de vos données.

Préservation du trafic Web : le trafic Web est essentiel au succès de toute entreprise en ligne. Cependant, le scraping non autorisé peut épuiser vos ressources, affecter les performances du site et saper vos efforts de référencement. Traffic Cop est votre sentinelle vigilante, gardant les robots malveillants à distance et préservant votre trafic Web. La mise en œuvre de mécanismes avancés de détection de robots et de mesures proactives garantit que les utilisateurs authentiques ont un accès ininterrompu à votre site Web, améliorant ainsi l'expérience utilisateur et maximisant votre potentiel de conversion.

Pourquoi choisir Traffic Cop ?

- Protection complète : Traffic Cop offre un bouclier holistique contre les tentatives de scraping, protégeant simultanément votre contenu, vos données et votre trafic Web.

- Détection avancée des bots : distingue avec précision les utilisateurs authentiques des bots malveillants, empêchant ainsi les accès non autorisés et les activités de scraping.

- Mesures de sécurité proactives : Cette technologie utilise des algorithmes de pointe pour identifier et bloquer les tentatives de scraping en temps réel, gardant une longueur d'avance sur les menaces potentielles.

- Expérience utilisateur améliorée : en préservant votre trafic Web et en gardant les robots malveillants à distance, Traffic Cop garantit un accès ininterrompu aux utilisateurs authentiques, améliorant leur expérience et augmentant les taux de conversion.

Autre que ça:

Utilisez la limitation du débit : mettez en œuvre des mesures de limitation du débit pour limiter le nombre de demandes par adresse IP ou utilisateur, empêchant les bots de submerger votre site Web avec des tentatives de grattage.

La limitation du débit est une technique efficace pour empêcher les attaques de scraping en limitant le nombre de requêtes qu'un utilisateur ou une adresse IP peut effectuer dans un laps de temps spécifique. En fixant des limites raisonnables, vous pouvez vous assurer que les utilisateurs authentiques peuvent accéder à votre site Web tout en décourageant les robots de tenter de récupérer votre contenu. La mise en œuvre de la limitation du débit peut aider à maintenir les performances et la disponibilité de votre site Web.

Protégez vos flux RSS : si vous fournissez des flux RSS pour la syndication, assurez-vous qu'ils sont protégés contre le scraping en ajoutant des mécanismes d'authentification ou en implémentant des clés API.

Les flux RSS peuvent être une source précieuse de syndication de contenu, mais ils peuvent également être ciblés par des bots. Pour protéger vos flux RSS, il est crucial de mettre en place des mécanismes d'authentification ou des clés API. En exigeant une authentification, vous pouvez vous assurer que seuls les utilisateurs ou applications autorisés peuvent accéder et utiliser vos flux RSS. De plus, la mise en œuvre de clés API peut vous aider à suivre et à contrôler l'accès à vos flux, en empêchant les tentatives de récupération non autorisées.

En mettant en œuvre ces stratégies, vous pouvez réduire considérablement le risque de grattage ChatGPT et LLM, protégeant ainsi votre contenu, vos données et votre trafic Web.

Faites cela pour suivre l'AI-Apocalypse.

Alors que ChatGPT et d'autres LLM continuent de progresser, les éditeurs doivent tenir compte de certains aspects clés pour protéger leur contenu et leur trafic Web :

- Restez informé : tenez-vous au courant des dernières avancées en matière d'IA et de technologies de traitement du langage naturel. Cela vous aidera à comprendre les risques et opportunités potentiels de ces outils.

- Passez en revue vos conditions d'utilisation : assurez-vous que vos conditions d'utilisation interdisent explicitement les activités de scraping et précisent les conséquences en cas de violation de ces conditions.

- Explorez les options juridiques : si vous soupçonnez une violation de vos droits de propriété intellectuelle en raison du grattage, consultez des experts juridiques pour explorer les recours juridiques disponibles.

- S'engager avec l'industrie : Collaborez avec les associations et organisations de l'industrie pour relever collectivement les défis posés par le scraping et plaider pour de meilleures mesures de protection.

En tenant compte de manière proactive de ces facteurs, les éditeurs peuvent mieux protéger leur contenu, leurs données et leur trafic Web à l'ère de ChatGPT et des technologies LLM émergentes.

En plus de ces considérations clés, les éditeurs doivent également être conscients de l'impact potentiel de ChatGPT et des LLM sur l'engagement de leur public. Avec l'essor du contenu généré par l'IA, il est possible que les lecteurs deviennent plus sceptiques quant à l'authenticité et à la fiabilité des informations qu'ils consomment. Les éditeurs doivent prendre des mesures pour instaurer la confiance avec leur public en étiquetant clairement le contenu généré par l'IA et en assurant la transparence sur la source de l'information.

Une autre considération importante est les implications éthiques potentielles du contenu généré par l'IA. À mesure que les LLM deviennent plus avancés, il est nécessaire de s'assurer que le contenu généré ne perpétue pas les préjugés ou la désinformation. Les éditeurs doivent établir des lignes directrices et des processus de révision pour s'assurer que le contenu généré par l'IA est conforme à leurs normes et valeurs éditoriales.

De plus, soyez conscient de l'évolution du paysage juridique entourant le contenu généré par l'IA. À mesure que ces technologies deviennent plus répandues, de nouvelles réglementations et cadres juridiques peuvent être mis en place pour régir leur utilisation. Se tenir au courant de ces développements et consulter des experts juridiques peut aider les éditeurs à naviguer dans les complexités juridiques du contenu généré par l'IA.

Conclusion

La protection de votre contenu, de vos données et de votre trafic Web contre le scraping ChatGPT est cruciale pour maintenir l'intégrité de votre entreprise. Cela menace leurs revenus et leur expérience utilisateur et affecte leur visibilité et leur réputation en ligne. En comprenant le processus de scraping, en mettant en œuvre des mesures de protection, en explorant les options juridiques et en favorisant la collaboration, les éditeurs peuvent protéger leur contenu et atténuer les risques associés au scraping basé sur l'IA.

Traffic Cop de MonetizeMore offre une solution complète pour assurer la sécurité de votre contenu, de vos données et de votre trafic Web. En tirant parti de la détection avancée des bots et des mesures de sécurité proactives, Traffic Cop vous permet de vous concentrer sur votre cœur de métier tout en protégeant efficacement vos actifs numériques.

Adoptez Traffic Cop aujourd'hui et profitez de la tranquillité d'esprit en sachant que votre présence en ligne est protégée contre le grattage non autorisé.

Rencontrez Aleesha Jacob, une gestionnaire chevronnée de contenu et de référencement B2B avec plus de 7 ans d'expérience dans la création de contenu axé sur les données qui alimente les conversions pour les entreprises SAAS. Ayant travaillé avec des entreprises de technologie publicitaire et des clients comme BMW et Heineken, Aleesha apporte une richesse d'expertise. Grâce à ses compétences inégalées dans la création de contenu attrayant, elle aide les entreprises de toutes tailles à générer plus de prospects, à augmenter leurs revenus et à développer leur présence en ligne.