Cinq technologies cognitives pour façonner l'avenir

Publié: 2019-12-04La technologie cognitive est un système avancé d'aide à la conduite basé sur l'IA. Une étude suggérée par Hackett Group a suggéré que 85% des responsables des achats sont engagés dans l'étude des technologies cognitives qui feront évoluer le programme opérationnel au cours des trois à cinq prochaines années. Seulement 32 % de tous ont la stratégie pour mettre en œuvre les technologies et parmi eux, 25 % ont suffisamment de capital et d'esprit pour exécuter les technologies. Je vous suggère les technologies cognitives les plus potentielles qui peuvent façonner votre avenir.

Alors que l'IA devient le fondement de l'avancement de notre vie quotidienne. Les organisations informatiques doivent adopter cette technologie nouvellement émergée afin de conserver leur position sur le marché. Dans la gestion des services, pour faire évoluer le système holistique, il est important d'intégrer les technologies cognitives. Cette approche offre d'énormes avantages potentiels pour façonner l'avenir des utilisateurs et de la gestion des services. En intégrant les technologies cognitives, vous pouvez offrir à vos utilisateurs des expériences personnalisées, avancées et conversationnelles qui ont abouti à des résultats meilleurs et plus rapides. Tout comme les utilisateurs de smartphones commandent leur assistant pour aider diverses tâches quotidiennes, vous obtiendrez l'expérience exacte avec le service desk demandant aux chatbots de vous aider dans différentes activités sans aucune intervention humaine. C'est ainsi que vous pouvez obtenir une satisfaction client élevée.

Analytique des mégadonnées

Big Data Analytics est le processus de gestion de l'énorme quantité de données pour dessiner des modèles, des tendances et des informations exploitables à l'aide de technologies avancées et de fonctionnalités informatiques. Il s'agit d'une forme d'analyse avancée impliquant des applications complexes avec des modèles prédictifs et des algorithmes statistiques, ces tâches sont effectuées par des systèmes d'analyse de haute performance. Ces systèmes et logiciels d'analyse spécialisés offrent de nombreux avantages, notamment de meilleures opportunités de revenus, une base de marketing de remarquage, un service client avancé, une efficacité opérationnelle et un meilleur avantage concurrentiel. Les applications basées sur les applications d'analyse de Big Data offrent des salles aux analystes de données, aux modélisateurs prédictifs, aux statisticiens et à d'autres professionnels dans ce domaine pour analyser les volumes croissants de données de transaction structurées et d'autres formes de données qui ne sont pas pratiquées par les programmes traditionnels de BI et d'analyse. Il entoure une fusion de données structurées et non structurées. Grâce à la connexion de capteurs, ces données sont collectées et connectées à l'IoT (Internet des objets). De nombreux outils et technologies sont utilisés :

- Bases de données NoSQL

- HadoopName

- FIL

- CarteRéduire

- Étincelle

- Hbase

- Ruche

- Cochon

Les applications d'analyse de données volumineuses incluent des données provenant de systèmes internes et de sources externes telles que des données météorologiques sur les consommateurs compilées par des fournisseurs de services d'information tiers. L'application d'analyse de flux est devenue courante dans les environnements de Big Data pour effectuer une analyse en temps réel des données qui alimentent les systèmes Hadoop via des moteurs de traitement de flux, tels que Spark, Flink et Storm. Des systèmes analytiques complexes sont intégrés à cette technologie pour gérer et analyser une grande quantité de données. Le Big Data est devenu extrêmement bénéfique dans l'analyse de la chaîne d'approvisionnement. En 2011, l'analyse des mégadonnées a commencé à prendre une position ferme dans les organisations et aux yeux du public. Avec le Big Data, Hadoop et d'autres technologies liées au Big Data ont commencé à émerger autour de lui. Principalement, l'écosystème Hadoop a commencé à prendre forme et à mûrir avec le temps. Les mégadonnées étaient principalement la plate-forme des grandes sociétés de systèmes Internet et de commerce électronique. Actuellement, il a été adopté par les détaillants, les sociétés de services financiers, les assureurs, les organisations de soins de santé, la fabrication et d'autres entreprises potentielles. Dans certains cas, les clusters Hadoop et les systèmes NoSQL sont utilisés au niveau préliminaire comme plates-formes d'atterrissage et zones de transit pour les données. Toute l'action est effectuée avant d'être chargée dans une base de données analytique pour analyser généralement sous une forme composée. Lorsque les données sont prêtes, elles peuvent être analysées avec un logiciel utilisé pour les processus d'analyse avancés. L'exploration de données, l'analyse prédictive, l'apprentissage automatique, l'apprentissage en profondeur sont les outils typiques pour conclure toute l'action. Dans ce spectre, il est très important de mentionner que le logiciel d'exploration de texte et d'analyse statistique joue un rôle central dans le processus d'analyse de données volumineuses. Pour les applications ETL et analytiques, les requêtes sont scriptées dans MapReduce avec divers langages de programmation tels que R, Python, Scala et SQL.

Apprentissage automatique :

L'apprentissage automatique est un processus continu avancé où les machines sont développées de manière à pouvoir effectuer leur tâche en tant qu'humain. Ces machines sont développées à l'aide de données de haute technologie pour effectuer leur tâche sans aucune intervention humaine. L'apprentissage automatique est une application de l'IA qui donne à une machine la capacité d'apprendre et d'améliorer un programme sans aucune action directe et explicite. Il est essentiellement axé sur le développement d'un programme informatique qui peut accéder aux données et les utiliser pour apprendre par eux-mêmes. Son objectif principal est de permettre aux machines d'apprendre automatiquement sans aucune aide humaine. L'apprentissage automatique est étroitement lié aux statistiques informatiques, avec l'étude de l'optimisation mathématique de la tâche d'apprentissage automatique. La tâche de l'apprentissage automatique peut être classée en plusieurs grandes catégories.

- Enseignement supervisé.

- Apprentissage semi-supervisé.

- Apprentissage automatique non supervisé.

- Apprentissage automatique de renforcement.

Toutes ces catégories d'apprentissage automatique classées offrent différentes nuances de tâches dans l'analyse des données et des informations et la prise de décisions essentielles :

- L'algorithme d'apprentissage crée une fonction supposée pour faire des prédictions sur la valeur de sortie. Les algorithmes d'apprentissage peuvent être comparés à leur sortie avec la sortie calculée et trouver des erreurs pour la modification du modèle selon les besoins.

- Les algorithmes d'apprentissage automatique non supervisés ne peuvent pas rectifier la bonne sortie, ils peuvent plutôt explorer les données et tirer des conclusions de l'ensemble de données pour décrire la structure cachée à partir de données non étiquetées.

- L'algorithme d'apprentissage automatique semi-supervisé est utilisé pour les données étiquetées et non étiquetées.

- Les algorithmes d'apprentissage automatique de renforcement interagissent avec l'environnement pour produire des actions et découvrir des récompenses et des erreurs. Le processus d'essais et d'erreurs est la caractéristique la plus importante de cet apprentissage. Pour activer ce processus, une simple rétroaction de récompense est essentielle pour savoir quelle action est la meilleure, ce qui est généralement appelé signal de renforcement.

À l'instar de l'analyse du Big Data, l'apprentissage automatique permet également d'analyser le volume massif de données. Il a tendance à fournir des résultats rapides et précis pour identifier les opportunités bénéfiques ou gérer le système de gestion des risques. Cependant, cela peut également nécessiter du temps et des ressources supplémentaires pour exécuter correctement l'ensemble du programme. C'est un processus très efficace pour gérer et surveiller une énorme quantité de données et d'informations.

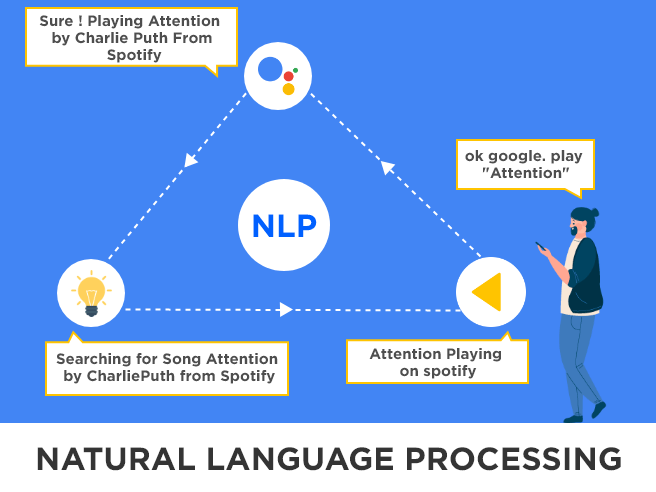

Traitement du langage naturel (TAL)

Le traitement du langage naturel consiste à former des machines dotées d'une intelligence humaine pour engendrer des changements dans leur langage et des réponses pour les rendre plus humaines. Cela fait en fait référence à la façon dont nous communiquons les uns avec les autres. La PNL est définie comme la manipulation automatique du langage naturel par l'utilisation du logiciel. L'étude du traitement du langage naturel a été lancée il y a plus de 50 ans. Elle est différente des autres types de données. Néanmoins, après avoir travaillé pendant tant d'années, le défi du processus de langage naturel n'est pas résolu dans une revue de linguistique mathématique, il a été publié par un scientifique passionné : "c'est difficile du point de vue de l'enfant, qui doit passer de nombreuses années à acquérir une langue … c'est difficile pour l'apprenant de langue adulte, c'est difficile pour le scientifique qui tente de modéliser les phénomènes pertinents, et c'est difficile pour l'ingénieur qui tente de construire des systèmes qui traitent de l'entrée et de la sortie du langage naturel. Ces tâches sont difficiles pour que Turing puisse à juste titre faire de la conversation fluide en langage naturel la pièce maîtresse de son test d'intelligence ».

Comme les scientifiques et les chercheurs en apprentissage automatique sont intéressés à travailler avec des données, la linguistique peut fonctionner dans le processus de la PNL. Les développeurs modernes ont suggéré que: «le but de la science linguistique est de pouvoir caractériser et expliquer la multitude d'observations linguistiques qui nous entourent, dans les conversations, l'écriture et d'autres médias. Cela a à voir en partie avec la taille cognitive de la façon dont les humains acquièrent, produisent et comprennent le langage, en partie avec la compréhension de la relation entre l'énoncé linguistique et le monde, et en partie avec la compréhension des structures linguistiques par quelle langue communique »

Intelligence artificielle

L'IA pilote l'automatisation des tâches principales avec des ordinateurs pour servir d'assistants numériques avancés. L'intelligence humaine est fondée pour sentir l'environnement, apprendre de l'environnement et traiter les informations de l'environnement. Cela signifie que l'IA intègre :

- Tromperie des sens humains, comme le toucher, le goût, la vue, l'odorat et l'ouïe.

- Tromperie des réponses humaines : robotique.

- Déception de l'apprentissage et du traitement : apprentissage automatique et apprentissage en profondeur.

L'informatique cognitive se concentre généralement sur l'imitation du comportement humain et sur la résolution de problèmes qui peuvent être résolus potentiellement encore mieux que l'intelligence humaine. L'informatique cognitive complète simplement les informations pour prendre des décisions plus facilement que jamais. Alors que l'Intelligence Artificielle est responsable de prendre la décision pour elle-même et de minimiser le rôle des humains. Les technologies qui fonctionnent derrière l'informatique cognitive s'apparentent aux technologies derrière l'IA qui incluent l'apprentissage en profondeur, l'apprentissage automatique, les réseaux de neurones, la PNL, etc. Bien que l'informatique cognitive soit étroitement associée à l'intelligence artificielle, lorsque leur utilisation pratique est apparue, ils sont complètement différents. L'IA est définie comme "la simulation des processus de l'intelligence humaine par des machines, en particulier des systèmes informatiques. Ces processus comprennent l'apprentissage (l'acquisition d'informations et de règles d'utilisation de l'information), le raisonnement (l'utilisation des règles pour parvenir à une conclusion approximative ou définitive) et l'autocorrection ». L'IA est un terme générique sous lequel une multitude de technologies, d'algorithmes, de théories et de méthodes permettent à l'ordinateur ou à tout appareil intelligent de fonctionner avec des technologies de haute technologie avec une intelligence humaine. L'apprentissage automatique et la robotique relèvent tous de l'intelligence artificielle qui permet aux machines d'offrir une intelligence augmentée et peut surpasser la perspicacité et la précision humaines. L'outil d'IA offre une gamme de nouvelles fonctionnalités dans votre entreprise. Les algorithmes d'apprentissage en profondeur intégrés aux outils d'IA les plus avancés. Les chercheurs et les spécialistes du marketing pensent que l'introduction de l'intelligence augmentée a une connotation plus neutre qui nous permettra de comprendre que l'IA est utilisée de manière à améliorer le produit et le service. L'IA peut être classée en quatre catégories :

Machines réactives : L'ordinateur d'échecs Deep Blue d'IBM a la capacité d'identifier les pièces sur l'échiquier et les prédictions en conséquence, bien qu'il ne puisse pas accéder aux expériences passées pour informer les futures. Il peut gérer et analyser les mouvements possibles. AlphaGO de Google est un autre exemple bien qu'il soit conçu pour fonctionner à des fins étroites et ne peut pas être appliqué à une autre situation.

Théorie de l'esprit : Cependant, ces types d'IA sont développés de manière à ce que les machines puissent prendre des décisions individuelles. Bien que cette technologie d'IA ait été développée il y a assez longtemps. Actuellement, il n'a aucune utilisation pratique.

Mémoire limitée : cette technologie d'intelligence artificielle a été développée pour effectuer une tâche à l'avenir dans le respect des expériences passées. Il a la capacité de prendre et de vous donner des conseils avancés sur toute décision importante concernant vos tâches. Par exemple : si vous conduisez, le système de navigation conçu par l'IA peut vous permettre de changer directement de voie pour atteindre votre destination.

Conscience de soi : l'IA est développée et peut vraiment avoir un sens et une conscience comme celle d'un corps humain. Les machines intégrées à la conscience de soi peuvent comprendre l'état actuel en utilisant les informations pour comprendre ce qu'une tierce personne ressent.

Automatisation des processus

L'automatisation des processus permet d'interconnecter les différentes fonctions, de traiter l'automatisation du flux de travail et d'avoir un minimum d'erreurs. L'automatisation des processus est l'utilisation de la technologie pour l'automatisation des activités. La première étape consiste à commencer par identifier les processus qui nécessitent une automatisation. Lorsque vous comprenez parfaitement le processus d'automatisation, vous devez planifier les objectifs de l'automatisation. Avant de lancer l'automatisation, vous devez vérifier les failles et les erreurs dans le processus. Voici une liste où vous pouvez déchiffrer pourquoi vous avez besoin d'un processus d'automatisation dans votre entreprise :

- Standardiser et rationaliser les processus.

- Résoudre le processus avec agilité en réduisant les coûts.

- Développer une meilleure allocation des ressources.

- Pour améliorer l'expérience client.

- Pour améliorer la conformité afin de réguler et de standardiser vos processus métier.

- Offrir une grande satisfaction aux employés.

- Pour améliorer la visibilité des performances de traitement.

Un ensemble de départements peut adopter le processus métier pour automatiser leur processus et faciliter le cycle de nature compliquée.

Source de l'image d'en-tête : https://bit.ly/2PfdWWm