Comment bénéficier de chaque mise à jour de l'algorithme Google : passé, présent et futur

Publié: 2018-04-13Les mises à jour de l'algorithme de Google sont des moments de l'histoire d'Internet.

Si vous travaillez dans le marketing numérique, ils pourraient même marquer des moments importants dans votre parcours professionnel.

Les plus grandes mises à jour de l'algorithme de Google obtiennent leur juste part de publicité grâce à nos médias d'information à la minute.

Pourquoi quelque chose qui est si caché dans les coulisses est-il si important?

Près de 75 % de toutes les recherches sur ordinateur proviennent de Google. Suivi par Baidu à un lointain 11 pour cent. Comme si dominer les ordinateurs de bureau n'était pas assez impressionnant, Google domine la recherche sur tablette et mobile, détenant plus de 92 % du trafic. Baidu, à 4 %, occupe la deuxième place.

Compte tenu de la domination de recherche de Google, une mise à jour de l'algorithme de Google est comme un tremblement d'Internet. Des industries entières sont ébranlées.

Les plus grandes mises à jour de l'algorithme de Google sont souvent baptisées d'un nom par Google ou la communauté de WebmasterWorld.

De quoi parle la danse Google ? Que veut vraiment Google ?

Selon Matt Cutts, Google veut que vous fassiez peu ou pas d'optimisation pour les moteurs de recherche. Ils préfèrent que vous vous concentriez sur la création d'un excellent contenu qui attire naturellement les backlinks.

Alors, à quoi ressemblent le passé, le présent et l'avenir des mises à jour de l'algorithme de Google ?

Et comment profiter des mises à jour ?

Passé : un bref historique des principales mises à jour de l'algorithme Google

Google veut la meilleure expérience utilisateur pour les chercheurs. C'est le motif de chaque mise à jour.

Explorons les changements d'algorithme de Google dans un ordre chronologique. Le modèle sera apparent et vous aurez une idée beaucoup plus claire de ce que Google recherche en termes de qualité.

Vincent | février 2009

En 2009, Google a fait une mise à jour appelée Vince. Cela n'a pas été perçu comme une mise à jour majeure. Vince était destiné à intégrer la confiance dans les recherches génériques, il a donc classé les grandes marques en tête pour les mots clés génériques.

Selon Matt Cutts, le changement de Vince n'a pas affecté les mots-clés de longue traîne. Voici une vidéo de Matt expliquant le changement.

Bien qu'il ne s'agisse pas d'une mise à jour majeure, il s'agissait d'un premier clin d'œil à l'autorité et aux modifications à venir de l'algorithme de Google.

Panda | février 2011

Suite à son annonce du 21 janvier 2011, Google a introduit l'algorithme Panda en février de la même année. L'algorithme a eu un impact sur 11,8 % des résultats de recherche aux États-Unis seulement, un pourcentage beaucoup plus élevé que ce que ses mises à jour régulières auraient.

Panda est l'algorithme de Google pour lutter contre le contenu de mauvaise qualité qui occupe un rang élevé sur ses pages de résultats de moteur de recherche (SERP).

Du 28 avril au 3 mai 2010, Google a apporté des modifications algorithmiques pour traiter le contenu de mauvaise qualité, mais cela s'est concentré sur les mots-clés de longue traîne.

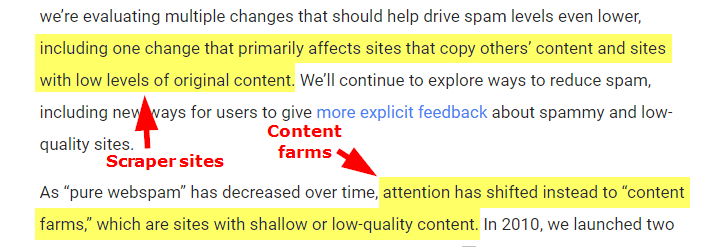

En 2011, Panda a poussé ce changement de qualité plus loin. Il ciblait les fermes de contenu et les sites de grattage.

L'image ci-dessous est un extrait de l'annonce de Google du 21 janvier 2011 qui expliquait clairement ce que l'algorithme ciblerait.

Google a mis à jour occasionnellement l'algorithme Panda de 2011 à 2016, date à laquelle il a annoncé que Panda était officiellement terminé et ne serait plus mis à jour de manière significative. Chaque fois que ces mises à jour ont eu lieu au fil des ans, les sites Web ont connu une variété d'expériences :

- Si le site a été affecté négativement par une mise à jour de Panda mais n'a apporté aucune modification pour améliorer la qualité, il a continué à voir des effets négatifs.

- Si le site était affecté négativement par une mise à jour de Panda mais apportait des modifications pour améliorer la qualité, il revenait dans les SERP de Google.

- Si le site avait un contenu de mauvaise qualité qui avait initialement échappé à une mise à jour de Panda, il était pris.

- Si le site était un faux positif (signalé par Panda comme étant de mauvaise qualité sans le mériter), il était libéré des pénalités.

- Si le site ne produisait que du contenu de haute qualité, il n'a subi aucun changement (ou peut-être même vu un changement positif dans les SERP).

En bref, Google souhaite que le contenu le meilleur, le plus pertinent et le plus à jour soit fourni aux internautes pour leurs termes de recherche.

Panda élimine le contenu qui viole cette intention de quelque manière que ce soit.

Haut Lourd | janvier 2012

L'algorithme Top Heavy rend difficile pour les sites Web dont le haut (c'est-à-dire l'en-tête, le titre, la barre de navigation supérieure, la zone du premier paragraphe) est chargé d'annonces de se classer haut dans les SERP.

Google a annoncé l'algorithme le 19 janvier 2012. Selon les mots de Google :

les sites qui n'ont pas beaucoup de contenu « au-dessus de la ligne de flottaison » peuvent être affectés par ce changement. Si vous cliquez sur un site Web et que la partie du site Web que vous voyez en premier n'a pas beaucoup de contenu visible au-dessus de la ligne de flottaison ou consacre une grande partie de l'écran initial du site aux publicités, ce n'est pas un très bon expérience utilisateur. De tels sites peuvent ne pas être aussi bien classés à l'avenir.

Tout comme Panda, Google a mis à jour Top Heavy de temps en temps.

Cette mise à jour n'affecte pas les annonces en superposition, les pop-up et les pop-under. Top Heavy se concentre sur les publicités statiques qui apparaissent au-dessus du pli. Un site contenant beaucoup de publicités mais pas trop lourd peut échapper à l'impact de cet algorithme.

Utilisez une extension de visionneuse de pliage pour savoir si votre site est susceptible d'être impacté par Top Heavy. L'extension vous aide à comprendre la quantité de contenu d'une page qui est immédiatement visible pour les visiteurs sous différentes résolutions d'écran, par rapport aux publicités.

Pingouin | avril 2012

Le 24 avril 2012, la mise à jour de l'algorithme Google Penguin a frappé les pages de résultats des moteurs de recherche.

Penguin pénalise les sites Web qui utilisent des tactiques de création de liens spammy pour améliorer leur classement dans les moteurs de recherche. Si un site Web crée des liens via des réseaux de liens à vocation SEO ou achète des liens, Penguin le punit en détruisant son classement.

Si vous avez participé à des réseaux de liens ou acheté des liens mais que vous ne pouvez pas les supprimer, vous pouvez utiliser l'outil de désaveu de Google. Vous pouvez également utiliser cet outil si vous remarquez que des spammeurs tentent d'attaquer votre site avec des liens de mauvaise qualité.

Les sites sur-optimisés et les sites qui ont d'autres formes de création de liens non naturels sont généralement piégés dans Penguin. Lorsque Penguin a été lancé, il a permis une rétroaction directe. Ce n'est plus ouvert. Les webmasters qui ont besoin d'aide peuvent participer et poser leurs questions sur Webmaster Central.

pirater | Août 2012

La mise à jour de l'algorithme pirate de Google a été mise en ligne en août 2012. Google utilise cet algorithme pour empêcher les sites de se classer en tête de leur SERP s'ils ont un nombre excessif de rapports de violation du droit d'auteur déposés contre eux via le système Digital Millennium Copyright Act (DMCA) de Google.

Google met à jour Pirate de temps en temps. Ainsi, des sites nouveaux et offensants peuvent être capturés par Pirate, d'autres précédemment capturés peuvent être libérés et les faux positifs peuvent être corrigés.

Le 10 août 2012, Google a annoncé le lancement de son algorithme de piratage en disant :

À partir de la semaine prochaine, nous commencerons à prendre en compte un nouveau signal dans nos classements : le nombre d'avis de suppression de droits d'auteur valides que nous recevons pour un site donné. Les sites avec un nombre élevé d'avis de suppression peuvent apparaître plus bas dans nos résultats. Ce changement de classement devrait aider les utilisateurs à trouver plus facilement des sources de contenu légitimes et de qualité

Cet algorithme est la réponse de Google à la montée en flèche des avis de violation des droits d'auteur qu'ils reçoivent. Au cours des 30 derniers jours précédant l'annonce du 10 août, Google avait reçu plus de 4,3 millions de demandes de suppression d'URL. C'est plus que toutes les demandes qu'ils ont reçues en 2009 réunies !

Au moment de la rédaction de cet article, Google a demandé la suppression de plus de 4 milliards d'URL.

Domaine de correspondance exacte | Septembre 2012

Exact Match Domain a été mis en ligne en septembre 2012. L'algorithme empêche les sites Web de mauvaise qualité de se classer en tête des moteurs de recherche simplement parce qu'ils ont des mots-clés de recherche correspondant exactement dans leurs noms de domaine.

Bulletin météo mineur : un petit changement d'algo Google à venir réduira les domaines de "correspondance exacte" de faible qualité dans les résultats de recherche.

— Matt Cutts (@mattcutts) 28 septembre 2012

jour de paie | Juin 2013

La mise à jour de l'algorithme Google Payday a été lancée pour nettoyer le spam des moteurs de recherche lié aux prêts sur salaire, à la pornographie, aux produits pharmaceutiques, aux industries financières, aux casinos et à ces cibles de requêtes fortement spammées. L'algorithme a été mis en ligne le 11 juin 2013.

Depuis son lancement initial en juin 2013, Payday a été mis à jour deux fois.

Le 16 mai 2014, Google a lancé Payday 2.0 pour lutter contre les sites de paye spammés.

Ensuite, juin 2014 était pour Payday 3.0 pour nettoyer les requêtes de recherche spam et fournir une meilleure protection contre les attaques SEO.

Colibri | Août 2013

La mise à jour de l'algorithme Google Hummingbird tire son nom du fait qu'elle est "rapide et précise". Il vise à classer les pages qui correspondent mieux aux significations d'une recherche que celles qui correspondent uniquement aux mots de la recherche.

En bref, Hummingbird est une refonte de l'algorithme de recherche de Google. Avec cette mise à jour de l'algorithme de Google, la société a officiellement nommé son algorithme de recherche The Hummingbird.

Cette mise à jour a également introduit le graphe de connaissances de Google.

Bien que Google ait annoncé l'algorithme le 26 septembre 2013, ils l'avaient lancé un mois avant l'annonce.

Pigeon | juillet 2014

La mise à jour de l'algorithme Google Hummingbird a malheureusement bouleversé la recherche locale, en particulier avec l'introduction du graphe de connaissances Google.

Ce trouble était exactement ce que la mise à jour Pigeon a corrigé, entre autres, les problèmes de recherche liés aux synonymes et à l'orthographe.

Cet algorithme vise à donner des résultats plus pertinents, utiles et précis pour les recherches locales qui sont étroitement liées aux signaux de classement de recherche Web habituels. Google utilise donc cet algorithme pour améliorer ses paramètres de classement de distance et de localisation.

Adapté aux mobiles | avril 2015

Mobile Friendly est une mise à jour de l'algorithme Google qui donne la priorité à la convivialité mobile lors de la fourniture de réponses à une requête. Cet algorithme a été mis en ligne le 21 avril 2015.

L'algorithme est la réponse de Google à l'augmentation spectaculaire de la préférence pour l'accès à Internet via des appareils mobiles au lieu d'un PC.

Un an seulement après le lancement de Mobile Friendly, davantage de personnes ont commencé à accéder à Internet à partir d'appareils mobiles et de tablettes qu'à partir d'ordinateurs de bureau. Le trafic de recherche mobile a augmenté pour Google, selon Hitwise.

Bien que Mobile Friendly ait semé la panique dans l'ensemble du secteur, la plupart de ces problèmes se sont installés lorsque les experts en référencement ont mieux compris et aligné sur les objectifs de Google.

RankBrain | Octobre 2015

L'objectif ultime d'une mise à jour de l'algorithme de Google est d'aider les chercheurs à répondre exactement à ce qu'ils recherchent.

La recherche est allée au-delà des textes pour inclure des recherches d'images et de voix, de sorte que le besoin de comprendre le contexte et les significations au-delà des mots (c'est-à-dire la recherche sémantique) a considérablement augmenté.

Environ 15 % des recherches quotidiennes de Google sont si uniques que personne n'a jamais utilisé ces termes de recherche auparavant. RankBrain utilise l'apprentissage automatique basé sur l'IA pour trouver les meilleures réponses à ces questions.

Afin de fournir des résultats sans faille, Google a développé RankBrain en avril 2015. Ce n'est que le 26 octobre 2015 que la société a officiellement annoncé l'algorithme.

D'après la vidéo de Bloomberg

RankBrain utilise l'intelligence artificielle pour intégrer de grandes quantités de langage écrit dans des entités mathématiques - appelées vecteurs - que l'ordinateur peut comprendre. Si RankBrain voit un mot ou une phrase avec laquelle il n'est pas familier, la machine peut deviner quels mots ou phrases pourraient avoir une signification similaire et filtrer le résultat en conséquence, ce qui la rend plus efficace pour gérer des requêtes de recherche inédites. .

Googles dit que RankBrain est leur troisième facteur de classement le plus influent. Selon Andrey Lipattev, stratège principal de la qualité de la recherche de Google, vos backlinks et votre contenu sont les deux autres facteurs de classement les plus importants.

Dans une interview de Backchannel, Jeff Dean de Google a déclaré que RankBrain était depuis passé de seulement 15 % des recherches à participer à presque toutes les recherches. L'apprentissage automatique alimenté par l'IA est devenu durable et est probablement utilisé de plus de façons que ce dont Google parle.

Celui-ci est toujours en cours de modifications, y compris la dernière mise à jour de l'algorithme de Google qui a eu lieu le 7 mars 2018.

Plus d'informations à ce sujet dans une minute. Finissons d'abord notre leçon d'histoire !

Interface publicitaire mobile | janvier 2017

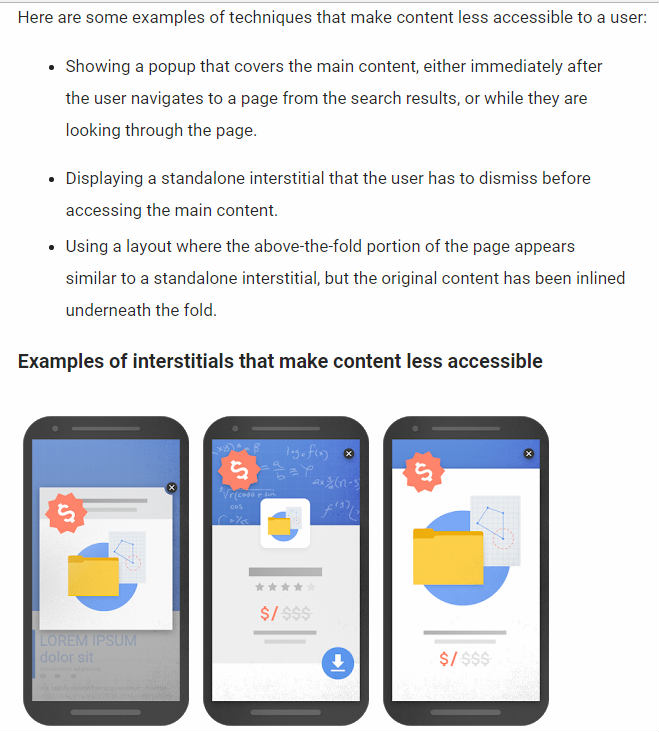

Les annonces mobiles intrusives et interstitielles ne contribuent pas à une expérience utilisateur agréable. Une mise à jour de l'algorithme de Google déployée le 10 janvier 2017 visait à lutter contre ce problème.

Les tweets de Gary Illyes et John Mueller ont confirmé ces changements.

ça roule, oui

— Gary "鯨理" Illyes (@methode) 10 janvier 2017

ça roule. Yay!

— Jean ☆.o(≧▽≦)o.☆ (@JohnMu) 11 janvier 2017

L'annonce de déploiement de Google a d'abord été accueillie avec enthousiasme par les webmasters, mais cela n'a pas duré longtemps.

Les experts en référencement ont noté que les performances de cet algorithme étaient décevantes. Les grandes marques semblent s'en tirer avec les publicités, tandis que les petites marques souffrent.

Alors, que répare Google avec cette pénalité ?

Comme toute autre mise à jour de l'algorithme de Google, celle-ci passera par des itérations pour atteindre son objectif.

Maintenant, cela nous emmène à travers les principales mises à jour du passé. Il est temps de nous concentrer sur le présent, l'ici et maintenant. Ensuite, nous pourrons aborder l'avenir des changements d'algorithmes de Google avec les yeux ouverts.

Présent : The Core, RankBrain et le 3/7 Google Dance

Depuis la mise à jour du 7 mars, les webmasters de cette année se demandent quand une mise à jour de l'algorithme de Google est une mise à jour "de base" ou "large".

C'est une chose intéressante et pertinente à considérer en ce moment. Voici la réponse de Google :

Chaque jour, Google publie généralement une ou plusieurs modifications destinées à améliorer nos résultats. Certains se concentrent sur des améliorations spécifiques. Certains sont de grands changements. La semaine dernière, nous avons publié une large mise à jour de l'algorithme de base. Nous le faisons régulièrement plusieurs fois par an….

– Google SearchLiaison (@searchliaison) 12 mars 2018

Une nouvelle mise à jour de l'algorithme de Google passe par plusieurs itérations.

Un algorithme fait partie du « cœur » lorsqu'il n'a plus besoin de l'attention des ingénieurs et développeurs de Google pour faire son travail.

Nous pouvons déduire une réponse de la question posée par Ammon Johns lors d'une session de questions-réponses sur Google en janvier 2018, et de la réponse donnée par Andrey Lipattsev de Google.

Ammon a demandé: "Une fois qu'ils ont oublié comment cela fonctionne, c'est essentiel?"

Andrey a répondu: "C'est tout à fait exact."

Mais cela ne signifie pas qu'une nouvelle mise à jour du noyau ne peut pas affecter le reste de ce qui est considéré comme le noyau.

Par exemple, prenez notre dernière mise à jour principale en 2018.

7 mars : la mise à jour principale pour le contenu sous-récompensé

Le 7 mars 2018, Google a lancé une mise à jour de l'algorithme de base qui stimule les pages de contenu "sous-récompensées".

Comme pour toute mise à jour, certains sites peuvent noter des baisses ou des gains. Il n'y a rien de mal avec les pages qui peuvent maintenant fonctionner moins bien. Au lieu de cela, c'est que les modifications apportées à nos systèmes profitent à des pages qui étaient auparavant sous-récompensées….

– Google SearchLiaison (@searchliaison) 12 mars 2018

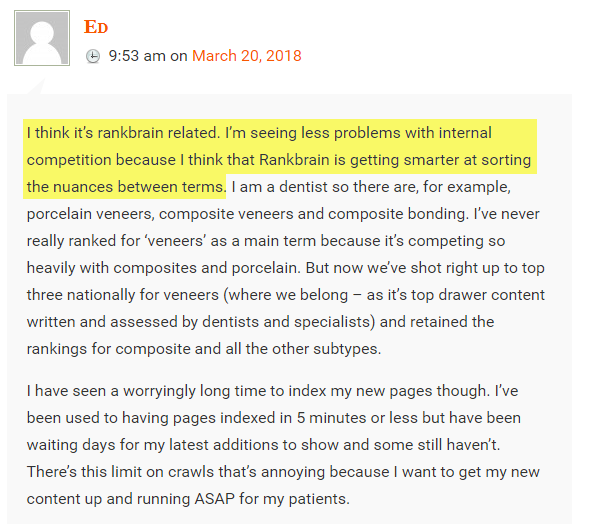

Les webmasters ont discuté de ce que signifie "sous-récompensé" et de l'impact du changement d'algorithme sur leurs sites Web. Une discussion sur le site Web de Marie Hayne suggère que ce changement pourrait être lié à RankBrain.

Marie Haynes a répondu Ed.

Notre article "SEO Mud Season : Google's 3/7 Core Update Affects Rankings and Traffic" vous explique comment la mise à jour de l'algorithme de Google influence les résultats de recherche et comment vous pouvez en tirer parti.

Les experts en sont venus à voir la mise à jour de l'algorithme Google du 7 mars comme la récompense de Google pour les efforts passés (non récompensés), un alignement avec les résultats de recherche actuels alimentés par l'IA et une préparation pour les mises à jour à venir.

En parlant de préparatifs pour l'avenir, quel est le chemin à parcourir ?

Futur : les experts prévoient des mises à jour Google à venir

Il est difficile de dire si ces modifications ou mises à jour à venir feront partie de l'algorithme de base, mais elles visent le même objectif : offrir aux chercheurs une expérience utilisateur agréable et fournir les meilleures informations pour chaque recherche Google.

L'algorithme de véracité (combat les fake news)

Suite à l'attaque des médias contre Google pour avoir fait la promotion de "fausses nouvelles", l'entreprise a pris des mesures pour lutter contre ce problème.

La suppression des fausses nouvelles des résultats de recherche de Google est devenue si importante que Danny Sullivan l'a qualifiée de « la plus grande crise de qualité de recherche de Google ».

Par exemple, lorsque les utilisateurs de Google recherchent "les femmes sont-elles mauvaises", ils peuvent tomber sur des résultats imparfaits comme "toutes les femmes ont de la prostituée et du mal en elles".

Google Home donne cette horrible réponse à "les femmes sont-elles mauvaises" vendredi. Bon article sur les problèmes; J'en aurai plus plus tard https://t.co/EUtrx4ZFul pic.twitter.com/Ec8mEqx8Am

– Danny Sullivan (@dannysullivan) 4 décembre 2016

Bien sûr, il y a une bonne raison pour laquelle ce résultat particulier s'est retrouvé en tête des SERP. L'auteur de cet article avait joué le jeu SEO correctement.

Pourtant, Google reste déterminé à fournir les meilleures informations possibles, et ce n'est probablement pas tout.

Ou la suggestion qu'Obama planifie un coup d'État.

Je sais que @ruskin147 a déjà partagé cela, mais voici mon propre Google Home m'informant qu'Obama planifie un coup d'État. pic.twitter.com/gs0s0ivF3L

– Danny Sullivan (@dannysullivan) 5 mars 2017

Encore une fois, puisque nous savons comment fonctionne l'algorithme de Google, nous pouvons comprendre pourquoi la meilleure correspondance a été considérée comme un article qui cible fortement les mots-clés donnés, "Obama planifie-t-il un coup d'État".

Le problème est que Google ne fournit pas les résultats factuels les plus précieux pour ces requêtes. Et ce n'est pas exactement un bon look pour Google.

Dans cet esprit, certaines des mesures que Google prend actuellement pour lutter contre les fausses nouvelles incluent :

1. Interdire les promoteurs de fausses nouvelles.

En 2015, Google a supprimé 780 millions de publicités. Ce nombre a plus que doublé pour atteindre 1,7 milliard d'annonces en 2016. Ces suppressions d'annonces ont conduit Google à interdire près de 200 éditeurs d'annonces qui ont publié de fausses nouvelles ou du contenu trompeur.

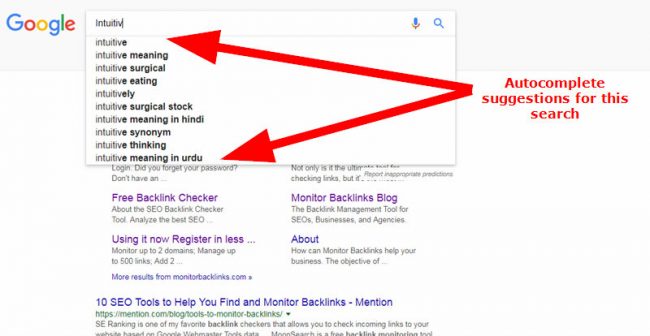

2. Permettre aux utilisateurs de signaler des prédictions de saisie semi-automatique offensantes.

Bien que Google offre aux chercheurs la possibilité de signaler des suggestions de saisie semi-automatique, le formulaire est caché dans les pages d'assistance de Google. L'entreprise expérimente actuellement une méthode de reporting plus intuitive et facilement accessible.

3. Dévalorisation des sources ne faisant pas autorité à l'aide d'algorithmes.

Google fabrique son algorithme pour dévaloriser les informations ne provenant pas de sources faisant autorité. Un exemple est l'histoire anti-Holocauste qui s'est classée numéro un sur Google mais qui a progressivement chuté dans les résultats de recherche après que The Guardian eut annoncé la situation.

Sur l'utilisation d'algorithmes pour lutter contre les sources d'information ne faisant pas autorité, a déclaré Google

Lorsque des informations ne faisant pas autorité figurent trop haut dans nos résultats de recherche, nous développons des approches évolutives et automatisées pour résoudre les problèmes, plutôt que de les supprimer manuellement un par un. Nous avons récemment apporté des améliorations à notre algorithme qui aideront à faire apparaître davantage de contenu crédible et de haute qualité sur le Web. Nous continuerons à modifier nos algorithmes au fil du temps afin de relever ces défis.

4. Utiliser des étiquettes de « vérification des faits ».

Google a annoncé en octobre 2016 avoir commencé à étiqueter "Fact Check" sur les articles de presse. Les articles d'actualité qui obtiennent cette étiquette doivent provenir de sites alignés sur les "caractéristiques des sites de vérification des faits" de Google ou des articles qui utilisent le balisage schema.org ClaimReview.

Le responsable des actualités de Google, Richard Gingras, en annonçant la balise "vérification des faits", a déclaré :

Aujourd'hui, nous ajoutons une autre nouvelle balise, "Vérification des faits", pour aider les lecteurs à trouver la vérification des faits dans les grands reportages. Vous verrez les articles marqués dans la zone d'histoire développée sur news.google.com et dans les applications Google Actualités et météo iOS et Android, en commençant par les États-Unis et le Royaume-Uni

5. Le système de confiance basé sur la connaissance.

L'intérêt de Google pour lutter contre les fausses nouvelles à l'aide d'un algorithme de véracité n'est pas nouveau. En 2015, les chercheurs de l'entreprise ont publié un article sur la confiance basée sur la connaissance (KBT), comme l'a rapporté le New Scientist .

Les chercheurs ont expliqué que KBT, une méthode alternative pour déterminer l'autorité de la page, utilisait la précision des informations au lieu du profil de lien pour déterminer l'autorité d'une page.

Le papier dit :

La qualité des sources Web est traditionnellement évaluée à l'aide de signaux exogènes tels que la structure des hyperliens du graphique. Nous proposons une nouvelle approche qui s'appuie sur des signaux endogènes , à savoir l'exactitude des informations factuelles fournies par la source. Une source qui contient peu de faux faits est considérée comme digne de confiance.

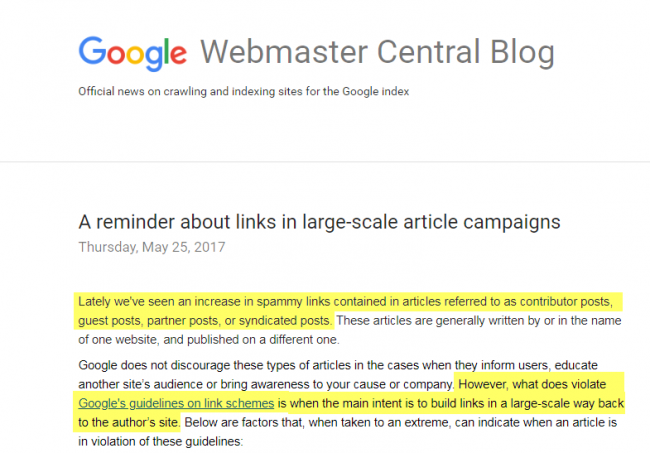

L'algorithme de publication d'invités (combat la publication d'invités manipulatrice)

Google pense que si votre objectif pour les blogs invités est de créer des liens vers votre site, alors le lien n'est pas naturel. Si vous le faites à grande échelle, vous enfreignez carrément les directives de Google.

Si vous publiez des messages d'invités sur un grand nombre de sites différents ou si vous avez de nombreuses contributions d'articles sur seulement quelques grands sites, Google percevra cela comme du spam. Cette pratique signifie à Google que votre intention de publier ces articles est d'obtenir des liens vers votre site.

L'algorithme de lien implicite (pour les mentions de marque)

Le brevet de Google suggère que les mentions de marque « sans lien » ou les liens implicites sont un élément clé de leur facteur de classement. Bien que la société n'ait annoncé aucun algorithme publié à cette fin, les experts sont convaincus que cela se produira à terme, car l'apprentissage automatique alimenté par l'IA continue d'influencer les classements.

Je le savais! RT @CyrusShepard : Ce brevet Google définit les citations sans lien comme des "liens implicites" http://t.co/cOxv0irklk

— Rand Fishkin (@randfish) 26 mars 2014

Bing dit qu'ils utilisent déjà des mentions sans lien dans leur facteur de classement. Cela donne aux petites entreprises un énorme avantage, en particulier celles qui ne sont pas capables de gagner des mentions dans la presse. Ces entreprises peuvent s'impliquer et inciter les conversions sur le web, tout cela à leur avantage.

L'algorithme d'indexation mobile-first

La mise à jour de l'algorithme de Google pour l'indexation mobile d'abord est déjà testée sur certains sites, selon Gary Illyes de Google. Google a une page de bonnes pratiques robuste qui détaille ses objectifs et ses attentes concernant ce changement.

Google dit :

L'indexation mobile d'abord signifie que Google utilisera principalement la version mobile du contenu pour l'indexation et le classement. Historiquement, l'index utilisait principalement la version de bureau du contenu d'une page lors de l'évaluation de la pertinence d'une page par rapport à la requête d'un utilisateur. Étant donné que la majorité des utilisateurs accèdent désormais à Google via un appareil mobile, l'index utilisera principalement la version mobile du contenu d'une page à l'avenir.

Google reconnaît que ce sera un grand changement. Les experts en référencement s'attendent à ce que ce changement se produise en 2018. Google indique qu'ils communiqueront leur processus aux webmasters une fois les tests terminés.

Des facteurs tels que le schéma, le contenu, le multimédia, les liens, etc. sont en cours de test.

Comment saisir et profiter de n'importe quelle danse Google

Si vous ne le savez pas déjà, le référencement n'est pas un moyen de tromper Google. C'est une façon de « danser » avec Google ; pour rendre votre contenu plus pertinent et utile pour les personnes qui en ont besoin et les rechercher sur Google.

Alors, comment saisir et danser avec chaque mise à jour de l'algorithme Google ?

- Privilégiez le contenu de qualité à la quantité et à la fréquence

- Gardez le linkbuilding naturel

- Obtenez des mentions de marque ou des liens implicites

- Conservez uniquement le contenu frais (et supprimez le contenu obsolète ou obsolète)

La qualité plutôt que la quantité et la fréquence

Google ne classe pas un site. Il classe les pages. La mise à jour du 7 mars cible les pages "sous-récompensées". Cela implique que Google ne se soucie pas tant du contenu de votre site Web que du fait que chaque page réponde complètement à la requête d'un internaute.

C'est pourquoi le contenu de forme longue obtient des classements plus élevés. Selon Moz, les articles entre 1800 et 3000 mots attirent plus de 15 fois plus de liens uniques que les articles de moins de 600 mots. Les internautes passent également plus de temps sur le contenu long, ce qui donne à Google un signal positif sur votre contenu.

Il n'est pas surprenant que la longueur moyenne d'un article d'un résultat de première page Google soit de 1 890 mots.

Créer des liens naturellement

Qu'est-ce que le linkbuilding naturel ? Cela signifie simplement créer des liens avec vos visiteurs humains à l'esprit, plutôt que de créer uniquement des liens pour les avantages du référencement. Cela signifie également ne pas essayer de manipuler l'algorithme actuel de Google pour améliorer le classement de votre site.

Aucun lien d'achat. Pas de création de liens sur des sites de mauvaise qualité. Pas de textes d'ancrage spammés. Portée minimale. Concentrez-vous sur la fourniture d'une valeur réelle aux lecteurs sur les sites qui placent vos liens.

Plus le nombre de backlinks pertinents que vous attirez est élevé, plus vous apprécierez chaque mise à jour de l'algorithme Google.

En bref, Google ne veut pas que vous "créiez des liens". Il veut que vous les attiriez , à partir des sources les plus naturelles et les plus pertinentes, en raison du fait que votre contenu étonnant est très attrayant et digne de liens.

Maintenant, la création de liens activement n'est pas totalement interdite, mais si vous voulez créer des liens, gardez-les naturels.

Cela signifie que vous ne devez faire appel qu'à des sites Web pertinents et faisant autorité lorsque vous créez activement des liens. Recherchez au moins une bonne autorité de domaine (> 40), un flux de confiance (> 10) et un flux de citations (> 10) avant de faire toute sensibilisation.

Lorsque vous créez des backlinks, utilisez une variété saine de textes d'ancrage (plutôt que de répéter le même mot clé exact encore et encore), des pages de destination et un statut nofollow/dofollow.

La première chose qui vous pénalisera, en cas de nouvelle mise à jour de l'algorithme, sera un profil de backlink laid ou non naturel.

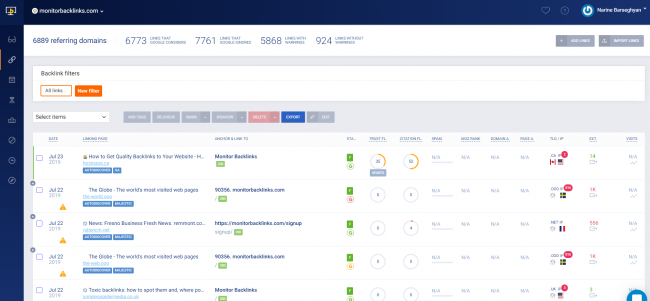

Pour cette raison, vous devez garder un œil sur votre profil de backlink. Une fois les backlinks créés, vous pouvez alors confirmer qu'ils sont tous de haute qualité et paraissent naturels. Notre propre Monitor Backlinks est notre outil de référencement de choix, bien sûr - nous l'avons conçu dans ce but précis.

Dans votre compte Monitor Backlinks, vous pouvez suivre le classement des mots clés, le trafic organique et, surtout, les backlinks.

Si vous n'êtes pas un utilisateur, vous pouvez commencer votre essai gratuit et consulter toutes ces statistiques par vous-même :

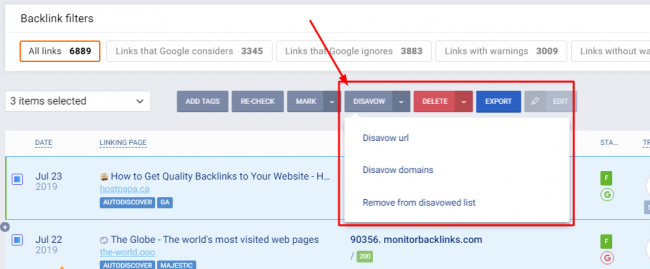

Et si vous repérez de mauvais backlinks qui ralentissent vos efforts de référencement ou qui pourraient vous valoir une pénalité lors de la prochaine mise à jour de l'algorithme, vous pouvez prendre des mesures ici pour les désavouer .

Désavouer les mauvais backlinks

Désavouer signifie simplement dire à Google que vous n'approuvez pas un backlink. Ensuite, le moteur de recherche n'en tiendra pas compte dans le classement SERP de votre site.

Voici un guide rapide sur la façon de désavouer les mauvais backlinks.

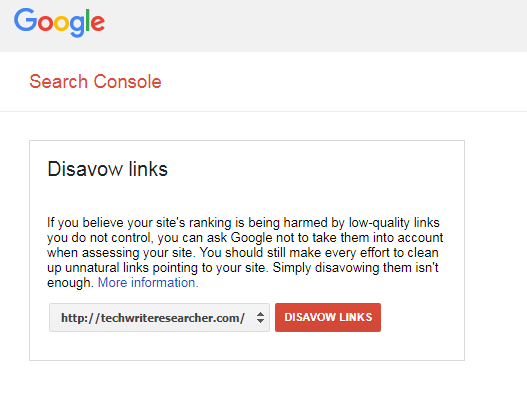

Si vous connaissez déjà les backlinks que vous souhaitez désavouer, vous pouvez le faire manuellement avec l'outil Google. Ouvrez l'outil et sélectionnez le site sur lequel vous souhaitez désavouer les liens, puis cliquez sur "Désavouer les liens".

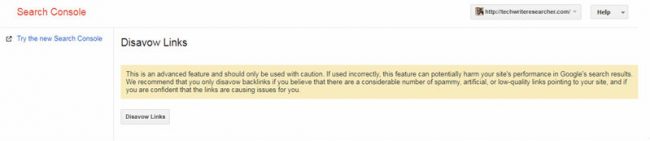

Vous recevrez le message ci-dessous. Continuez si vous êtes prêt.

Il n'y a qu'un seul problème. Il est presque impossible de savoir avec certitude quels backlinks négatifs vous avez recueillis délibérément ou non. Vous voudrez utiliser l'outil Monitor Backlinks pour faciliter ce nettoyage.

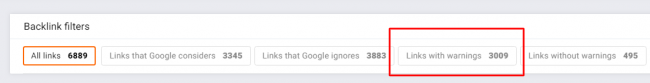

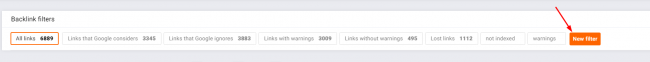

Rendez-vous sur votre compte Monitor Backlinks pour découvrir les backlinks de mauvaise qualité qui arrivent sur votre site. Votre tableau de bord comporte un ensemble de chiffres représentant votre profil de backlinks (comme illustré dans la capture d'écran ci-dessous).

Cliquez sur "Liens avec avertissements".

Votre tableau de bord répertoriera uniquement les sites comportant des avertissements.

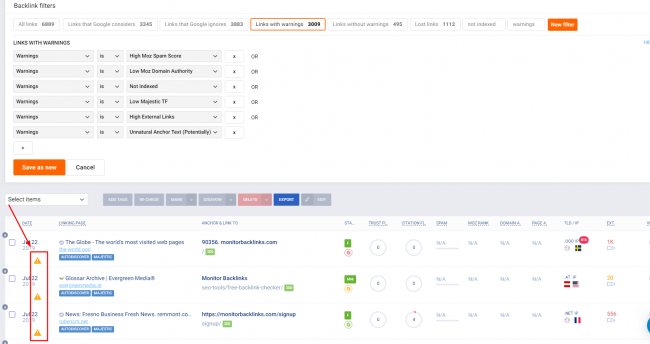

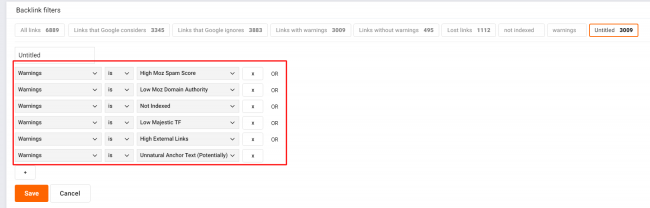

Votre but n'est pas de trouver tous les avertissements. Vous voulez vous concentrer sur les avertissements concernant les liens spammés. Utilisez la fonction Nouveau filtre en haut de votre tableau de bord pour réduire votre liste d'avertissements aux données les plus pertinentes.

Cliquez sur "Avertissements" pour obtenir une liste de tous les avertissements.

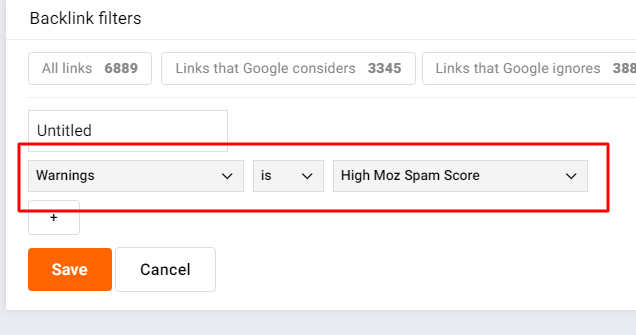

Vous voulez rendre cela facile à aborder. Commencez par sélectionner le "High Moz Scam Score". Moz Spam Score utilise 17 facteurs qui ont de puissantes capacités prédictives pour repérer les sites sujets aux pénalités de Google, c'est donc la meilleure mesure pour commencer à trouver de mauvais liens.

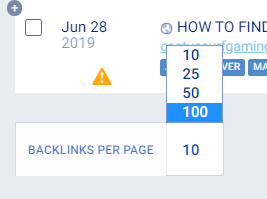

Si vous avez une longue liste de backlinks à parcourir, gagnez du temps en augmentant le nombre de liens affichés par page. Faites défiler vers le bas de la page. En bas à gauche, vous verrez une case pour changer le nombre en 100.

Dans l'exemple ici, j'ai plus de 900 backlinks avec un Moz Spam Score élevé. J'ai donc choisi d'afficher 100 backlinks par page.

Vous pouvez désavouer ces liens directement depuis votre tableau de bord Monitor Backlinks. Pour ce faire, sélectionnez les liens et cliquez sur "Désavouer" dans le menu du haut.

Si vous vous sentez enclin à vérifier manuellement les sites de spam liés à votre site avant de les désavouer, allez-y. Soyez juste prêt, cela va prendre beaucoup de temps et d'énergie.

Vous pouvez également désavouer les sites qui ont un texte d'ancrage non naturel ou des backlinks externes élevés. En ce qui concerne les liens externes élevés, je vous proposerai de choisir manuellement les sites à désavouer parfaitement sûrs. Les annuaires peuvent entrer dans cette catégorie.

Sur votre tableau de bord Monitor Backlinks, vous pouvez voir les sites que vous avez désavoués.

Terminé! Plus de risque SEO.

Citations et mentions de marque

Parfois, il est normal de ne pas avoir de lien vers votre site, car une mention de marque peut avoir le même poids.

Les discussions sur votre marque dans les forums et les blogs sont bonnes pour le référencement aujourd'hui. Vous voulez intervenir et contrôler les discussions sur votre marque ? Rejoignez des forums spécifiques à votre secteur, obtenez des fonctionnalités multimédias avec HARO et accédez aux podcasts et vlogs les plus populaires de votre secteur.

En bref, soyez reconnu dans votre industrie comme une autorité. Au fur et à mesure que vous développez votre influence dans l'industrie, vous serez cité, présenté et discuté. Tous ces liens, mentions et citations ont des avantages SEO juteux que vous ne voulez pas manquer.

Contenu frais uniquement

Si votre contenu fonctionne déjà bien dans les SERP de Google, vous voulez qu'il le reste.

La clé ici est de mettre à jour votre contenu de temps en temps. Éliminez les parties non pertinentes du contenu et infusez de nouvelles recherches et statistiques.

Vous ne voulez pas que vos visiteurs donnent à Google des signaux comportementaux négatifs à propos de votre contenu. Alors, gardez vos pages fraîches et pertinentes.

Prêt pour la prochaine mise à jour de l'algorithme Google ?

La prochaine mise à jour n'est pas loin dans le futur. C'est aujourd'hui ou demain ! Littéralement.

Google confirme qu'ils apportent des modifications quotidiennes à leurs algorithmes et des mises à jour de base non annoncées plusieurs fois par an.

Vous pouvez instantanément commencer à danser avec Google en apportant les modifications nécessaires et en corrigeant tout impact négatif dû à une mise à jour de l'algorithme de Google.

Vous pouvez également obtenir plus de jus de référencement Google en améliorant là où vous vous débrouillez déjà bien.

Continuez votre excellent travail et restez glacial.