Comprendre les algorithmes Google NLP pour un meilleur référencement de contenu

Publié: 2022-06-04

Le traitement du langage naturel, ou NLP, est l'une des avancées les plus complexes et les plus innovantes de l'intelligence artificielle (IA) et des algorithmes des moteurs de recherche. Et, sans surprise, Google est devenu un leader dans le domaine de la PNL. Avec l'ajout en 2021 de l'algorithme SMITH et de son précédent algorithme de langage naturel, BERT, Google a développé une IA qui comprend parfaitement le langage humain. Et cette technologie a la capacité d'être utilisée dans la création de contenu généré par l'IA.

Avec une précision exceptionnelle, les algorithmes NLP de Google ont changé le jeu de l'IA. Alors, qu'est-ce que cela signifie pour le référencement ? Cet article plongera dans tous les détails des technologies NLP de Google et comment vous pouvez les utiliser pour mieux vous classer dans les résultats des moteurs de recherche.

Qu'est-ce que le traitement automatique du langage naturel ?

Le traitement du langage naturel (TLN) est un domaine de l'informatique et de l'intelligence artificielle impliquant l'étude de la façon de faire comprendre aux ordinateurs le langage humain. Contrairement aux formes précédentes d'IA, la PNL utilise l'apprentissage en profondeur.

La PNL est considérée comme un élément important de l'intelligence artificielle car elle permet aux ordinateurs d'interagir avec les humains d'une manière qui semble naturelle.

Bien que la PNL puisse sembler avoir pour objectif d'améliorer les résultats de recherche de Google et de mettre les rédacteurs en faillite, cette technologie est utilisée de diverses manières au-delà du référencement.

Voici les plus courants :

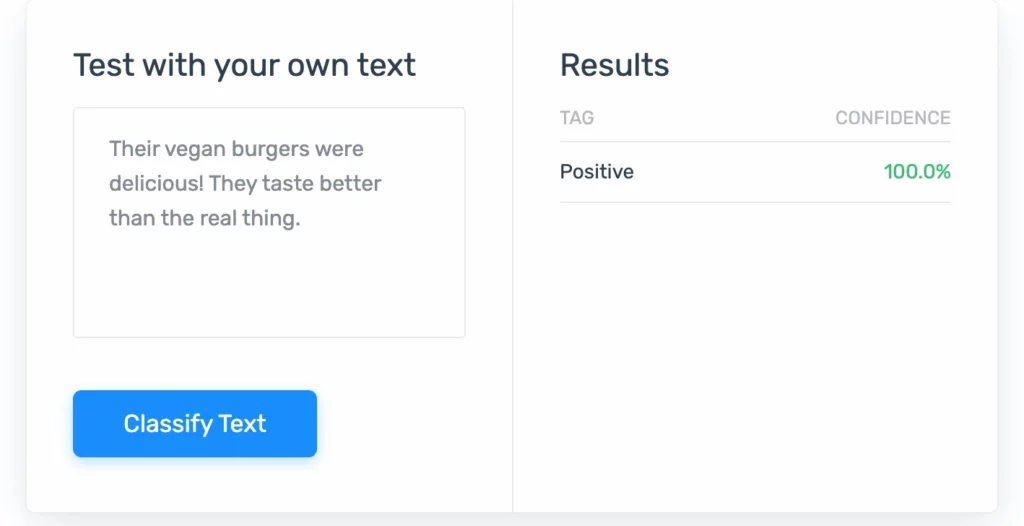

1. Analyse des sentiments : PNL qui évalue les niveaux émotionnels des gens pour déterminer des éléments tels que la satisfaction des clients.

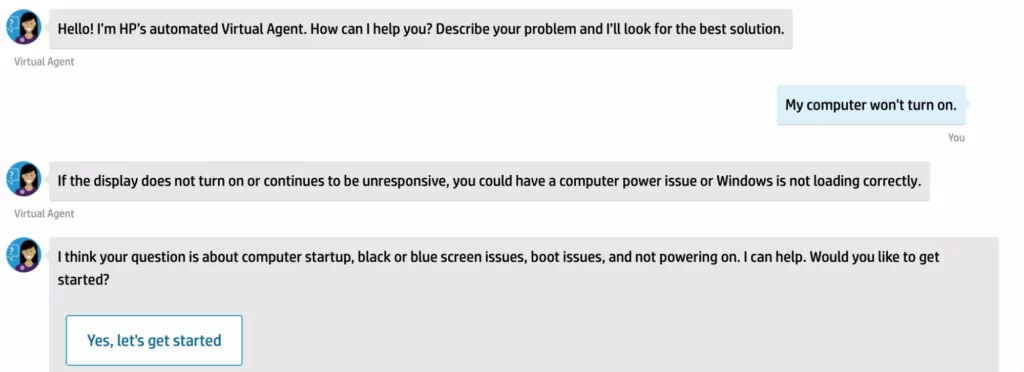

2. Chatbots : Ce sont les écrans de chat qui apparaissent sur les pages d'aide ou les sites Web généraux. Ils ont le don de réduire la charge de travail des centres de support client.

4. Reconnaissance vocale : Ce NLP prend l'audio et le traduit en commandes et plus encore.

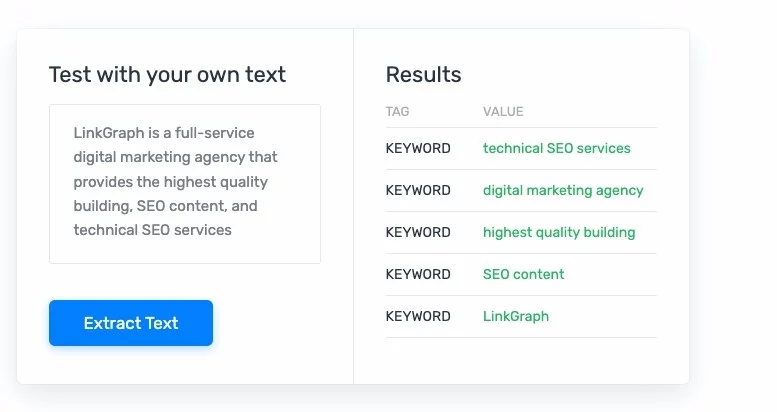

Classification, extraction et résumé de texte : ces formes de PNL peuvent analyser le texte, puis le reformater pour qu'il soit plus facile à utiliser, à analyser et à comprendre pour les humains. L'extraction de texte peut être très utile lorsqu'il s'agit de tâches telles que le codage médical et la détection d'erreurs de facturation.

Qu'est-ce que l'apprentissage en profondeur ?

L'apprentissage en profondeur est une catégorie d'apprentissage automatique qui s'inspire des réseaux de neurones du cerveau humain. Cette forme d'apprentissage automatique est souvent considérée comme plus sophistiquée que les modèles d'apprentissage typiques de l'IA.

Parce qu'ils reflètent le cerveau humain, ils peuvent également refléter le comportement humain et apprendre beaucoup ! Souvent, les algorithmes d'apprentissage en profondeur utilisent un système en deux parties. Un système fait des prédictions tandis que l'autre affine les résultats.

L'apprentissage en profondeur est utilisé dans les appareils ménagers, les environnements publics et le lieu de travail depuis un certain temps. Les applications les plus courantes incluent :

- Voitures autonomes

- Télécommandes vocales

- Détection de fraude à la carte de crédit

- Équipement médical

- Défense nationale par satellite

Comment la PNL affecte-t-elle le référencement ?

Peu de mises à jour du PageRank de Google ont perturbé les normes de référencement comme les robots de traitement du langage naturel. Avec le déploiement de SMITH de Google, nous avons vu des spécialistes du référencement se démener pour comprendre le fonctionnement de l'algorithme ainsi que la manière de produire du contenu conforme aux normes de l'algorithme. Cependant, comme la plupart des mises à jour d'algorithmes, le temps dévoile souvent comment respecter et dépasser les normes de contenu pour garantir que votre contenu a les meilleures chances de figurer dans les SERP.

Essentiellement, le NLP aide Google à fournir aux chercheurs de meilleurs résultats de recherche en fonction de leur intention et une compréhension plus claire du contenu d'un site. Cela signifie que seuls les sites fournissant le meilleur contenu ont conservé leur classement dans les SERP. De plus, le contenu divers qui ne répond pas à l'intention d'un chercheur sera enterré sur un SERP plus profond ou ne s'affichera pas du tout.

Qu'est-ce que Google BERT ?

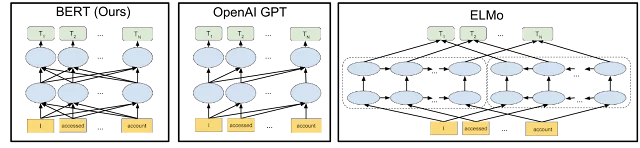

L'algorithme BERT (Bidirectional Encoder Representations from Transformers) a été déployé en 2019, et il a fait des vagues comme le plus grand changement depuis PageRank. Cet algorithme est un NLP qui fonctionne pour comprendre le texte afin de fournir des résultats de recherche supérieurs.

Plus précisément, BERT est un réseau de neurones conçu pour mieux comprendre le contexte des mots dans une phrase. L'algorithme est capable d'apprendre les relations entre les mots d'une phrase en utilisant une technique appelée pré-entraînement.

L'objectif de l'algorithme BERT est d'améliorer la précision des tâches de traitement du langage naturel, telles que la traduction automatique et la réponse aux questions.

Comment fonctionne l'algorithme Google BERT ?

L'algorithme BERT est capable d'atteindre son objectif en utilisant une technique appelée apprentissage par transfert. L'apprentissage par transfert est une technique utilisée pour améliorer la précision d'un réseau de neurones en utilisant un réseau pré-formé qui est déjà formé sur un grand ensemble de données.

Contrairement à de nombreuses mises à jour de Google, le fonctionnement interne de BERT est open source. L'algorithme BERT est basé sur un article publié par Google en 2018. Cette explication open source indique que BERT utilise un modèle contextuel bidirectionnel pour mieux comprendre la signification de mots ou de phrases individuels. Le résultat est une classification de contenu finement réglée.

Par exemple:

Si vous recherchez une barre pour l'happy hour par rapport à une barre pour votre équipement de développé couché, Google vous montrera le bon type de barre en fonction de la façon dont le mot est utilisé dans le contexte d'une page.

Quoi d'autre rend BERT différent?

BERT a utilisé des unités de traitement de tenseur cloud (TPU) qui ont accéléré la capacité du NLP à apprendre à partir d'échantillons de texte existants comme système de pré-formation. Le pré-apprentissage est une technique utilisée pour former un réseau de neurones sur un grand ensemble de données avant qu'il ne soit utilisé pour traiter des données. Le réseau pré-entraîné est ensuite utilisé pour traiter des données similaires aux données utilisées pour former le réseau. En utilisant des TPU cloud, BERT a pu traiter les données rapidement, très rapidement. Et le Google Cloud a également pu être testé.

Après des millions de sessions de formation, l'algorithme BERT est capable d'atteindre une plus grande précision que les algorithmes de traitement du langage naturel précédents car il est capable de mieux comprendre le contexte des mots dans une phrase.

De combien d'échantillons de texte le BERT avait-il besoin ? BERT a utilisé des millions, voire des milliards d'échantillons pour saisir pleinement le langage naturel (pas seulement l'anglais).

Comment la mise à jour Bert de Google a-t-elle affecté les sites Web ?

L'impact de la mise à jour du BERT sur les sites Web a été double. Premièrement, la mise à jour a amélioré la précision des résultats de recherche de Google. Cela signifie que les sites Web les mieux classés dans les résultats de recherche de Google ont enregistré un taux de clics (CTR) plus élevé.

Deuxièmement, la mise à jour du BERT a accru l'importance du contenu du site Web. Cela signifie que les sites Web qui ont un contenu pertinent et de haute qualité sont plus susceptibles d'être mieux classés dans les résultats de recherche de Google.

Quelles sont les limites de Google Bert ?

BERT est un outil puissant, mais il existe certaines limites à ses capacités. Bien qu'il soit facile de se laisser emporter par la qualité de ce modèle PNL, il est important de garder à l'esprit que le modèle BERT n'est pas capable de tous les processus cognitifs humains. Et ceux-ci peuvent être des limitations dans ses capacités de compréhension du contenu.

BERT est un algorithme de texte uniquement

Premièrement, BERT n'est efficace que pour les tâches de traitement du langage naturel impliquant du texte. Il ne peut pas être utilisé pour des tâches impliquant des images ou d'autres formes de données. Cependant, gardez à l'esprit que BERT peut lire votre texte alternatif, ce qui peut vous aider à apparaître dans les recherches d'images Google.

BERT ne comprend pas le « tableau d'ensemble »

Deuxièmement, le BERT n'est pas efficace pour les tâches qui nécessitent un degré de compréhension extrêmement élevé. Essentiellement, BERT est un pro des mots dans les phrases, mais pas capable de comprendre des articles entiers.

Par exemple, le BERT peut comprendre que la "chauve-souris" dans la phrase suivante fait référence au mammifère plutôt qu'à une batte de baseball en bois : la chauve-souris a dévoré le moustique. Mais il n'est pas efficace pour les tâches qui nécessitent la compréhension de phrases ou de paragraphes complexes.

Qu'est-ce que l'algorithme Google SMITH ?

L'algorithme Google SMITH (ou Siamese Multi-depth Transformer-based Hierarchical) est un algorithme de classement qui a été conçu par les ingénieurs de Google. L'algorithme examine le langage naturel, apprend les schémas de signification en relation avec les phrases en fonction de leur distance les unes par rapport aux autres et crée une hiérarchie d'informations qui permet d'indexer les pages avec plus de précision.

Cela permet à SMITH d'effectuer une classification de contenu plus efficacement.

Une autre caractéristique intéressante de SMITH est qu'il peut fonctionner comme un prédicteur de texte. Il y a d'autres entreprises qui ont fait de grosses vagues avec le NLP (pensez à la tristement célèbre bêta GPT-3 d'Open AI l'année dernière). Certaines de ces technologies pourraient aider les autres à créer leurs propres moteurs de recherche .

Comment la mise à jour SMITH de Google a-t-elle affecté les sites Web ?

La mise à jour SMITH de Google a eu un impact significatif sur les sites Web. La mise à jour a été conçue pour améliorer la précision des résultats de recherche, et elle l'a fait en pénalisant les sites Web qui utilisaient des techniques de manipulation pour influencer leur classement. conçu pour cibler un large éventail de techniques de manipulation, y compris les liens spammy, le référencement Black Hat et l'intelligence artificielle, SMITH a élevé la barre pour un contenu de qualité et la création de liens organiques.

Certaines des techniques de manipulation les plus courantes ciblées par SMITH comprenaient

- Remplissage de mot-clé

- achat de lien

- utilisation excessive du texte d'ancrage.

Les sites Web qui utilisaient ces techniques ont été pénalisés par Google, ce qui a entraîné une diminution de leur classement dans les recherches.

Quelle est la différence entre la mise à jour SMITH de Google et Google BERT ?

Le modèle BERT et le modèle SMITH offrent aux robots d'exploration de Google une meilleure compréhension de la langue et une meilleure indexation des pages. Nous savons que Google aime déjà le contenu long, mais lorsque SMITH est en ligne, Google comprend le contenu plus long encore plus efficacement. SMITH améliorera les domaines des recommandations d'actualités, des recommandations d'articles connexes et du regroupement de documents.

Comment ajuster votre stratégie de référencement pour les algorithmes Google NLP

Bien que Google affirme que vous ne pouvez pas optimiser pour BERT ou SMITH, comprendre comment optimiser pour NLP peut avoir un impact sur les performances de votre site dans les SERP. Cependant, sachant que BERT se concentre sur l'intention de l'utilisateur, vous devez comprendre l'intention de toute requête de recherche pour laquelle vous souhaitez optimiser.

Google est souvent un peu méfiant quant au déploiement de ses algorithmes, et continue de garder le secret sur le déploiement complet de SMITH. Mais il est toujours préférable de supposer qu'ils ont commencé à optimiser le changement.

SMITH n'est probablement qu'une des nombreuses itérations de l'objectif à long terme de Google de maintenir sa domination dans le NLP et la technologie d'apprentissage automatique. À mesure que Google améliore sa compréhension des documents complets, une bonne architecture de l'information sera encore plus importante .

Comment pouvez-vous optimiser votre contenu pour les algorithmes NLP de Google ?

- Assurez-vous que votre contenu est bien formaté et facile à lire. Maintenir les meilleures pratiques de titre et autres meilleures pratiques de lisibilité. Ceux-ci inclus:

- Gardez vos phrases de moins de 20 mots

- Utilisez des listes à puces pour les éléments répertoriés supérieurs à 2

- Utilisez la bonne hiérarchie des titres

- Évitez de présenter aux lecteurs un bloc de texte impénétrable

- Utilisez un langage clair, concis et facile à comprendre. Ne compliquez pas trop vos structures de phrases. En limitant la longueur de votre phrase, vous rationaliserez probablement également vos pensées.

- Évitez d'utiliser des mots complexes ou difficiles qui pourraient confondre les algorithmes de Google. Abandonnez le thésaurus et gardez vos phrases simples. Gardez à l'esprit que le chemin le plus court vers quelque chose est souvent le meilleur.

- Utilisez des mots-clés et des termes ciblés qui sont pertinents pour votre sujet . Les termes Focus liés sémantiquement peuvent aider les processeurs de langage naturel de Google à mieux comprendre l'intégralité de votre page.

- Assurez-vous que votre contenu est frais et à jour. N'oubliez pas que la motivation de ces algorithmes NLP est d'améliorer les résultats de recherche tout en éliminant le contenu indésirable et obsolète.

- Rédigez un contenu intéressant et engageant que les gens voudront lire. Vous ne pouvez jamais vous tromper en fournissant aux chercheurs le meilleur contenu pour leurs besoins . Gardez à l'esprit l'intention de recherche et la profondeur du sujet.

- Vos avis clients comptent. Le NLP de Google peut probablement effectuer une analyse des sentiments des entités, alors n'ignorez pas les mauvaises critiques. Si vous recevez des critiques négatives (qu'elles soient en anglais ou en martien), vous pouvez parier que l'analyse des sentiments des entités de Google vous fera chuter dans les SERP.

- Fournissez des réponses claires aux questions des chercheurs. Si vous souhaitez vous retrouver dans un extrait de code, les PNL de Google ne vous y mèneront que si vous effectuez une extraction de texte à l'aide d'une analyse d'entité. Cela signifie que Google a la capacité de se concentrer sur des informations spécifiques à afficher aux internautes.

L'avenir des NLP de Google

L'API de langage naturel de Google et le Cloud TPU sont désormais accessibles à tous . Ainsi, si vous pouviez utiliser une plate-forme d'apprentissage automatique en profondeur pour effectuer des tâches NLP, vous pouvez utiliser les API en langage naturel de Google. Vous pouvez même participer à la formation des NLP Google cloud si vous le souhaitez !

Optimisez pour l'API Google Natural Language et obtenez des résultats

Une chose est claire : les API de langage naturel sont là pour rester. Comme nous pouvons le voir dans la progression entre le modèle BERT et le modèle SMITH, les algorithmes de recherche Google ne feront que continuer à comprendre votre contenu de mieux en mieux.

Laissez votre mantra rester le même : concentrez-vous sur le contenu, concentrez-vous sur la qualité. Alors que les référenceurs continueront d'apprendre et d'expérimenter pour découvrir ce qui fonctionne le mieux pour les algorithmes NLP de Google, respectez toujours les meilleures pratiques en matière de référencement. Gardez à l'esprit que ce que vous écrivez affectera votre classement, mais ce que vos clients et visiteurs écriront également grâce à l'analyse des sentiments. En savoir plus sur l'algorithme BERT.

L'outil de génération de contenu IA de SearchAtlas est basé sur l'API de langage naturel de Google, ce qui vous permet de produire un contenu de la plus haute qualité avec un effort réduit.