Quel est l'impact de ChatGPT sur le trafic automatisé des bots ?

Publié: 2023-06-28

L'émergence de ChatGPT et de technologies d'IA similaires apporte à la fois des opportunités et des défis. En tant qu'éditeur, il est crucial d'examiner l'impact potentiel de ChatGPT sur le trafic automatisé/bot et de concevoir des stratégies efficaces pour atténuer ses conséquences négatives. Cet article explore les implications de ChatGPT sur la génération de trafic de robots, le scraping de contenu et la violation de la propriété intellectuelle et propose des initiatives concrètes pour répondre à ces préoccupations.

1. Facilitation de la génération de trafic de robots grâce à la création de code

La capacité de ChatGPT à générer du code est un outil inestimable pour l'éducation et le dépannage. Cependant, des acteurs malveillants peuvent exploiter cette capacité pour produire du code ciblant les sites Web avec un trafic automatisé de robots. Les sites Web basés sur la publicité, qui dépendent de l'engagement authentique des utilisateurs pour générer des revenus, sont particulièrement vulnérables.

Étant donné que les annonceurs paient généralement pour les impressions et les clics en fonction des interactions des utilisateurs, l'engagement généré par les bots peut gonfler artificiellement ces mesures. Par conséquent, les annonceurs peuvent payer pour des interactions non initiées par de vrais utilisateurs mais par des bots.

Cette faute professionnelle entraîne non seulement des pertes financières pour les annonceurs, mais érode également la confiance dans les plateformes de publicité en ligne. Les annonceurs s'attendent à ce que leurs investissements atteignent et engagent de véritables audiences humaines. Lorsque leurs publicités sont plutôt diffusées sur le trafic des bots, cela nuit à l'efficacité et à la valeur de leurs campagnes publicitaires. De tels incidents peuvent nuire à la réputation de la plateforme publicitaire et des éditeurs qui lui sont associés, car les annonceurs hésitent à allouer leurs budgets à des plateformes sensibles à la fraude par bot.

Les éditeurs doivent connaître cet impact potentiel et prendre les mesures appropriées pour atténuer les risques. Cela comprend la mise en œuvre de mécanismes robustes de détection et de prévention des fraudes, le partenariat avec des réseaux publicitaires réputés qui utilisent des algorithmes sophistiqués de détection de robots et la surveillance des modèles de trafic pour identifier les anomalies pouvant indiquer une activité de robots. En s'attaquant activement au problème du trafic de robots, les éditeurs peuvent maintenir l'intégrité de leurs mesures d'engagement et établir la confiance avec les annonceurs.

2. Intensification du scraping de contenu

ChatGPT et des systèmes similaires peuvent exécuter diverses tâches, y compris le grattage Web, qui implique l'extraction de données à partir de sites Web pour divers objectifs. Malheureusement, l'utilisation de systèmes de type ChatGPT pourrait entraîner une augmentation du grattage de contenu. Cette activité peut impliquer la duplication autorisée ou non du contenu en ligne, qui est ensuite réutilisé ou monétisé. Le scraping de contenu peut également imposer une charge excessive aux serveurs des sites Web ciblés, affectant leurs performances et leur disponibilité pour les utilisateurs légitimes.

Lorsque le contenu récupéré est monétisé ailleurs, les éditeurs sont privés du trafic et de l'engagement que leur contenu d'origine aurait générés. De plus, le scraping de contenu peut imposer une charge excessive aux serveurs des sites Web ciblés. Lorsque de nombreuses demandes de scraping sont effectuées, cela peut entraîner une augmentation de la charge du serveur et de l'utilisation de la bande passante, ce qui peut entraîner une dégradation des performances ou même des temps d'arrêt. Les utilisateurs légitimes peuvent rencontrer des temps de chargement de page plus lents ou des difficultés pour accéder au site Web, ce qui affecte leur expérience utilisateur globale.

D'un point de vue juridique, le scraping de contenu soulève des préoccupations concernant la violation du droit d'auteur et des droits de propriété intellectuelle. Le grattage et la reproduction non autorisés de contenu sans attribution ou autorisation appropriée peuvent enfreindre les lois sur le droit d'auteur. Les éditeurs ont le droit de protéger leurs œuvres originales et de contrôler la manière dont elles sont utilisées et distribuées.

Pour faire face à l'intensification du scraping de contenu, les éditeurs peuvent recourir à diverses mesures. Celles-ci peuvent inclure la mise en œuvre de protections technologiques telles que des algorithmes de détection de robots, des systèmes CAPTCHA ou des mécanismes de limitation de débit pour détecter et atténuer les tentatives de grattage. De plus, les éditeurs peuvent tirer parti des voies légales pour protéger leur contenu, y compris l'enregistrement des droits d'auteur, l'envoi d'avis de retrait aux parties contrevenantes et l'action en justice contre les récidivistes.

Il est essentiel que les éditeurs restent vigilants et surveillent activement leur contenu pour détecter toute duplication non autorisée. En prenant des mesures proactives pour protéger leur propriété intellectuelle et atténuer l'impact du scraping de contenu, les éditeurs peuvent garder le contrôle de leur contenu, protéger leurs sources de revenus et faire respecter leurs droits légaux.

3. Problèmes de violation de la propriété intellectuelle et du droit d'auteur

Une augmentation de la récupération de contenu, aidée par ChatGPT et des technologies similaires, pourrait entraîner une violation généralisée de la propriété intellectuelle et du droit d'auteur. Cette tendance croissante menace la capacité des créateurs de contenu original à tirer les bénéfices appropriés de leur travail.

Le scraping de contenu implique l'extraction et la republication non autorisées de contenu en ligne, souvent sans fournir d'attribution appropriée ni demander l'autorisation des créateurs originaux. Cette pratique porte atteinte aux principes fondamentaux de la propriété intellectuelle, selon lesquels les créateurs devraient avoir le droit de contrôler la distribution, l'utilisation et la monétisation de leurs œuvres.

Lorsque le contenu est extrait et republié sans consentement, cela diminue le potentiel de revenus des créateurs originaux. Ils perdent des opportunités de monétiser leur contenu via des canaux légitimes, tels que la publicité, les abonnements ou les accords de licence. De plus, le manque d'attribution appropriée les prive de la reconnaissance et de la crédibilité qu'ils méritent pour leurs efforts créatifs.

De plus, le scraping de contenu peut conduire à un environnement en ligne dilué où le contenu dupliqué inonde diverses plateformes. Cela crée non seulement de la confusion pour les utilisateurs à la recherche de sources fiables et authentiques, mais entrave également la croissance et la diversité du contenu original. La prévalence du contenu scrapé diminue l'incitation des créateurs à investir leur temps, leurs ressources et leur talent dans la production d'œuvres originales de haute qualité.

D'un point de vue juridique, le grattage de contenu sans autorisation enfreint souvent les lois sur le droit d'auteur. Ces lois accordent des droits exclusifs aux créateurs de contenu, y compris le droit de reproduire, distribuer, afficher et adapter leurs œuvres. Le grattage et la republication non autorisés de matériel protégé par le droit d'auteur enfreignent ces droits, ce qui peut exposer les auteurs à des conséquences juridiques.

Pour répondre à ces préoccupations, les créateurs et éditeurs de contenu doivent rester vigilants dans la surveillance et la protection de leur propriété intellectuelle. Ils peuvent employer diverses stratégies pour lutter contre le grattage de contenu, y compris la mise en œuvre de mesures techniques pour détecter et prévenir les tentatives de grattage, le filigrane ou l'empreinte numérique de leur contenu, et poursuivre des actions en justice contre les récidivistes.

Mesures d'atténuation

Compte tenu de ces impacts potentiels, il est impératif de développer des stratégies pour atténuer l'utilisation abusive de ChatGPT et de technologies similaires. Ces stratégies comprennent la mise en œuvre de mécanismes de détection de robots plus stricts, le développement d'outils pour évaluer les niveaux de protection des sites Web contre les grattoirs de contenu, l'éducation des éditeurs sur les risques potentiels et l'établissement de cadres juridiques qui traitent de l'utilisation non autorisée de ces technologies.

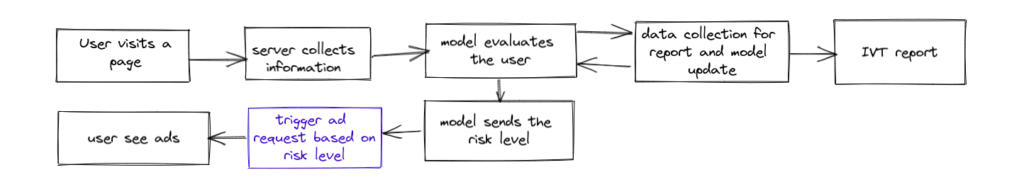

Pour atténuer les impacts négatifs potentiels de ChatGPT et de technologies similaires, les éditeurs peuvent bénéficier de l'utilisation de solutions avancées de détection de robots telles queTraffic Cop .Traffic Cop, une solution primée de blocage des bots proposée par MonetizeMore, offre une défense efficace contre le trafic généré par les bots, préservant l'intégrité des mesures d'engagement et protégeant les investissements des annonceurs.

Avec ses algorithmes avancés et ses capacités d'apprentissage automatique, Traffic Cop est conçu pour détecter et bloquer les robots malveillants, les fermes de clics et d'autres activités frauduleuses. En intégrant Traffic Cop à leurs sites Web, les éditeurs peuvent s'assurer que leurs plates-formes basées sur la publicité sont protégées des effets néfastes du trafic de bot, tels que des mesures d'engagement gonflées, des mesures de performances inexactes et des dépenses publicitaires inutiles.

Cette solution complète de blocage des robots améliore non seulement la précision et la fiabilité des mesures d'engagement, mais aide également à maintenir la confiance des annonceurs dans la plate-forme. En bloquant de manière proactive les bots, Traffic Cop garantit que les budgets des annonceurs sont alloués à un véritable engagement des utilisateurs, ce qui se traduit par une transparence accrue et un retour sur investissement plus élevé.

De plus, Traffic Cop fournit aux éditeurs des informations et des rapports détaillés sur le trafic des bots, leur permettant d'analyser les modèles, de comprendre l'ampleur du problème des bots et de prendre les mesures nécessaires pour optimiser davantage les performances de leurs annonces et l'expérience utilisateur.

En tirant parti de Traffic Cop, les éditeurs peuvent relever en toute confiance les défis posés par les activités malveillantes des bots, garantissant ainsi un environnement publicitaire plus sûr et plus fiable pour les éditeurs et les annonceurs. Il permet aux éditeurs de prendre le contrôle de leurs sites Web, de protéger leurs sources de revenus et de renforcer leurs relations avec les annonceurs.

Pour en savoir plus sur ce tueur de robots et ses capacités à atténuer les effets négatifs des systèmes de type GPT, vous pouvez commencer avec Traffic Cop pour un essai de 7 jours ici !

Syed Tanveer Jishan est un spécialiste chevronné de l'apprentissage automatique, spécialisé dans la détection d'anomalies avec une décennie d'expérience dans le milieu universitaire et l'industrie, notamment dans la technologie de la publicité. Il a dirigé avec succès le développement de Traffic Cop, un outil de détection de fraude révolutionnaire pour MonetizeMore, qui a permis de décupler la récupération des revenus publicitaires. En tant que chercheur universitaire, Syed a publié plusieurs travaux de recherche novateurs, fusionnant expertise pratique et académique dans le domaine de l'apprentissage automatique. Ses compétences et son expérience lui permettent d'aider les entreprises à protéger leurs revenus contre la fraude et à améliorer leur efficacité opérationnelle grâce à l'intelligence artificielle.