Quand les tests A/B n'en valent pas la peine

Publié: 2015-12-13Pour les geeks du marketing comme vous et moi, rien ne fait plus couler le sang qu'un test A/B. Ils sont rapides à courir et c'est très satisfaisant de voir les résultats affluer. Une fois que nous avons commencé, nous partons pour les courses, et il est difficile d'imaginer comment nous avons pu nous en passer. Si seulement nous pouvions faire cela avec tout : jouer deux bobines de nos grandes décisions de vie à la fois pour voir quels choix étaient les bons.

Mais sans une réflexion approfondie, les tests A/B peuvent en fait devenir une perte de temps précieux. Voici comment tirer le meilleur parti des tests A/B.

Qu'est-ce qu'un test A/B ? Comment ça marche?

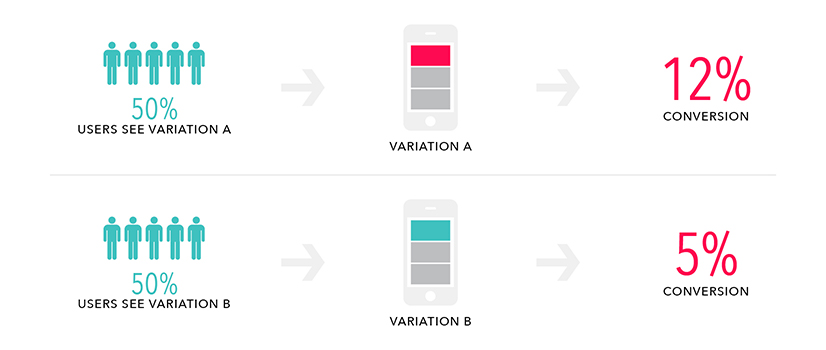

Les tests A/B vous permettent de tester une expérience ou un message pour voir s'il peut être amélioré. Dans un test A/B, vous présentez aux utilisateurs deux versions d'un site, d'une application ou d'une fonctionnalité (version A contre B). La version qui fonctionne le mieux, quelle que soit la métrique que vous suivez, gagne.

On peut tester à peu près n'importe quoi : boutons, polices, appels à l'action, styles de contenu éditorial et même des détails de niveau supérieur comme la vitesse de défilement, en plaçant une version devant le premier groupe d'utilisateurs, généralement le contrôle (A), et une variante (B) devant un deuxième ensemble d'utilisateurs. Le trafic est randomisé autant que possible, donc la seule variante que vous testez est celle modifiée dans la variante B. Vous pouvez tester plusieurs variables et/ou plusieurs variantes et c'est ce qu'on appelle les tests multivariés, un sujet pour un autre jour.

Utiliser les tests A/B pour tester une hypothèse

Utilisez les tests A/B pour tester des idées subjectives sur la façon de résoudre un problème avec des preuves objectives basées sur des données qui confirmeront si les idées sont valables.

Bien fait, le test A/B suit une recette de base. Commencez par un problème que vous aimeriez résoudre. Peut-être avez-vous des données ou des recherches sur les utilisateurs suggérant qu'il y a un problème, ou simplement une intuition éclairée dérivée de la connaissance de votre produit et de votre public.

Ensuite, développez une hypothèse identifiant ce qui semble être la meilleure solution à votre problème. Ensuite, exécutez votre test pour recueillir des preuves empiriques qui prouveront ou réfuteront finalement votre hypothèse. Enfin, agissez en fonction de ce que vous avez appris.

À quoi faire attention avant de se lancer dans un test A/B

Dans l'étude de 1835 de De Tocqueville sur le caractère américain ( Democracy in America ), il écrit qu'aux États-Unis, "l'opinion publique est divisée en mille nuances de différence sur des questions de très peu d'importance".

De Tocqueville, bien sûr, ne pouvait avoir aucune idée de la pertinence de ses remarques dans le contexte du marketing numérique et mobile. Certains résultats ne justifient tout simplement pas le temps qu'ils prennent pour être découverts. Sachez quand il est temps de faire un test A/B et quand votre temps peut être mieux utilisé ailleurs.

4 raisons de ne pas faire de test

1. Ne faites pas de test A/B lorsque : vous n'avez pas encore de trafic significatif

Les tests A/B sont devenus si omniprésents qu'il est difficile d'imaginer le monde du développement mobile ou de produits sans eux. Pourtant, sauter dans les profondeurs de la piscine de test avant même de se mouiller les chevilles pourrait être une erreur.

La signification statistique est un concept important dans les tests. En testant un groupe d'utilisateurs suffisamment important, vous déterminerez ce que l'utilisateur moyen préfère et vous réduirez la probabilité que la préférence que vous identifiez soit en fait le résultat d'une erreur d'échantillonnage.

Avez-vous constaté un mouvement parce que les utilisateurs préfèrent en fait la variante au contrôle ? Ou, par exemple, avez-vous sans le savoir servi la variante A aux personnes qui aiment les chats et la variante B aux personnes qui détestent les cheeseburgers, ce qui signifie que vos résultats ne vous disent rien sur votre utilisateur moyen ? Pour vous protéger contre ce type d'erreur d'échantillonnage, vous avez besoin d'une taille d'échantillon statistiquement significative. Comment déterminer si vos résultats sont suffisamment significatifs pour justifier une action ? Math!

Vous pouvez commencer par utiliser ce calculateur de signification A/B gratuit ( ou celui-ci , si vous préférez). Chaque calculateur compare les visiteurs et la conversion des deux côtés de votre variante A/B, fait un tas de calculs en arrière-plan et vous donne un « niveau de confiance » exprimé en pourcentage, vous permettant de savoir si votre test a ou n'a pas donné des résultats sur lesquels vous pouvez agir en toute confiance.

Tester quelque chose dont vous vous attendez à faire une énorme différence dans le taux de conversion est généralement faisable avec un trafic plus faible, mais pour tester de petits changements, comme la couleur d'un bouton, vous aurez besoin d' un échantillon plus grand. Si vous êtes inquiet, jouez avec ce calculateur pour voir si votre trafic est là où il devrait être avant de lancer un test A/B.

Si vous n'avez pas suffisamment d'utilisateurs pour obtenir des résultats significatifs, vos efforts pourraient être mieux dépensés pour attirer plus de clients au lieu d'expérimenter. Si vous décidez d'aller de l'avant et d'exécuter un test alors que votre base d'utilisateurs est encore petite, vous devrez peut-être laisser votre test en ligne pendant plusieurs semaines avant de voir des résultats significatifs.

2. Ne faites pas de test A/B si : vous ne pouvez pas passer le temps en toute sécurité

Andrew Cohen, fondateur et PDG de Brainscape, et instructeur à TechStars et à l'Assemblée générale, a déclaré : « L' exécution de tests fractionnés est simplement une tâche intensive en gestion , peu importe à quel point les plugins de test A/B sont bon marché et efficaces… sont devenus. Quelqu'un doit consacrer son temps à déterminer ce qu'il faut tester, à configurer le test et à vérifier et mettre en œuvre les résultats du test.

Bien que ces tâches puissent être exécutées avec une relative facilité, explique Cohen, cela nécessite toujours beaucoup de "bande passante mentale, qui est la ressource la plus rare de toute entreprise (en particulier une startup en démarrage)".

Passez du temps à décider ce que vous devez tester, afin de tirer le meilleur parti de votre temps de test A/B.

3. Ne faites pas de test A/B si : vous n'avez pas encore d'hypothèse éclairée

Collecter des informations. Identifiez votre problème. Définir une hypothèse. Ensuite, testez pour voir si vous avez raison. Traitez le test A/B comme une vraie science ! Un bon scientifique ne commence jamais une expérience sans hypothèse .

Pour définir votre hypothèse, connaissez le problème que vous souhaitez résoudre et identifiez un objectif de conversion. Par exemple, supposons que vos clients aient tendance à abandonner à un certain point de l'entonnoir de conversion.

Le problème : les clients chargent des articles dans leur panier, mais ne terminent jamais le processus d'achat.

Sur la base d'une petite étude de marché et de votre propre jugement bien informé, vous pensez que si vous ajoutez un bouton indiquant "Terminer mon achat", vous pourrez augmenter la conversion. Il est également important de définir votre métrique de réussite. Quelle est la plus petite augmentation de conversion que vous seriez heureux de voir ? (Et pourquoi ce nombre ? Qu'est-ce que cela signifie pour votre entreprise dans son ensemble de gagner cette augmentation ?) Cela est également lié à vos calculs de signification statistique. Pour cet exemple, supposons que vous souhaitiez augmenter la conversion de 20 %.

Une hypothèse scientifique est généralement écrite au format si/alors. Votre hypothèse devient donc : " Si j'ajoute un bouton "Terminer mon achat", 20 % de personnes supplémentaires suivront le processus d'achat."

À la fin de votre test, vous aurez des décisions à prendre. Si votre test est positif et confirme votre hypothèse, félicitations ! Vous gagnez. Votre hypothèse est maintenant une théorie éprouvée (prouvée dans le niveau de confiance en pourcentage que vous avez atteint, bien sûr). Si votre entreprise est suffisamment agile, vous pouvez immédiatement mettre en place une solution permanente. Vous voudrez peut-être continuer à tester des variantes plus petites pour voir s'il y a plus de place pour améliorer votre premier succès.

Si votre test est négatif et que votre hypothèse n'a pas été retenue, vous gagnez également ! Cela signifie que votre contrôle est la formule gagnante et que vous pouvez continuer à l'utiliser en toute confiance. Encore une fois, cependant, vous souhaiterez peut-être tester différentes variantes si vous n'obtenez pas les résultats dont vous avez besoin. Voyez s'il existe une autre façon de résoudre votre problème et développez une nouvelle hypothèse.

Si votre test n'est pas concluant, réexaminez votre problème. Êtes-vous sûr que le point douloureux est là où vous pensez qu'il est ? Avez-vous suffisamment de trafic pour fournir des résultats statistiquement significatifs ? N'oubliez pas que la réponse aux problèmes de votre produit ne se trouve pas nécessairement dans un test A/B.

4. Ne faites pas de test A/B si : il y a peu de risques à agir immédiatement

Lynn Wang , responsable du marketing chez Apptimize , déclare : « Les tests A/B doivent être ignorés dans les situations où vous savez qu'une idée améliorera presque certainement votre application et les risques associés à… la mise en œuvre de l'idée sont faibles. Elle ajoute : « Il n'y a aucune raison de consacrer du temps et des ressources à tester quelque chose qui est probablement bon et qui présente peu de risques. Passer à la mise en œuvre est parfaitement conseillé.

Ceci est particulièrement utile pour se rappeler si votre temps est limité. Gardez à l'esprit qu'un résultat donné peut être vrai, et en même temps, il peut être sans importance.

Un bon outil est aussi utile que son application intelligente

Les tests A/B sont une ressource incroyable. Des actions intelligentes et simples prises sur la base de résultats clairs de tests bien appliqués ont catapulté le succès dans le paysage numérique . Les entreprises qui réussissent savent quand il est temps d'être patientes et d'effectuer un test significatif. Ils savent également quand se fier à leur intuition ou à d'autres sources d'information, et avancer sans le soi-disant filet de sécurité d'une période de test prolongée ou prématurée qui n'ajoutera en fait aucune valeur.