Qu'est-ce qu'un audit de site Web SEO ?

Publié: 2021-08-11Table des matières

Qu'est-ce qu'un audit de site web SEO et comment le réaliser ? Accompagné d'un plan de contenu et d'une stratégie de visibilité organique, ce document (ou un ensemble de documents) constitue la pierre angulaire de votre activité SEO. Sa bonne mise en œuvre vous mettra sur la voie du succès.

Dans cet esprit, nous avons décidé de vous guider pas à pas dans le processus de réalisation d'un audit SEO .

Un audit SEO est un ensemble d'analyses réalisées par un spécialiste SEO. Il vise à s'assurer que le site répond aux dernières normes d'optimisation des moteurs de recherche et que rien ne s'oppose à la poursuite d'une stratégie de croissance organique.

Il est important de noter qu'un audit en soi n'est pas une stratégie. Au début de la coopération, nous fournissons généralement au client les deux documents en même temps. Pourtant, la plupart des audits n'incluent pas l'analyse des mots-clés ou un plan de contenu (des exceptions existent).

Si le site ne contient aucune erreur fondamentale, même l'audit le plus approfondi ne révélera que quelques défauts à aplanir. C'est le meilleur scénario car cela signifie que vous pouvez lancer notre stratégie de référencement tout de suite au lieu de mettre en œuvre des recommandations d'audit, ce qui générerait des coûts supplémentaires pour le client. D'une certaine manière, les experts en référencement sont comme des médecins - tout ce que vous voulez qu'ils disent, c'est "tout va bien".

Un expert en référencement peut donner une évaluation générale de la santé du site Web même au stade du devis. Ce diagnostic préalable permet d'adapter l'offre d'audit et le périmètre d'analyse aux besoins du client.

Quand réaliser un audit SEO ? 4 situations où vous en avez besoin

Lorsque vous implémentez des mises à jour techniques

Un expert en référencement devrait examiner tous les plans de mises à jour majeures avant la mise en œuvre. Les mises à jour « majeures » incluent :

- transfert vers un autre CMS (système de gestion de contenu),

- mise à jour du code HTML,

- modifier les URL ou la structure interne du site,

- ajouter ou supprimer des sections, des pages ou des fonctionnalités spécifiques.

Savez-vous quel est le tueur le plus courant de croissance organique chez Google ? Pas de modifications d'algorithmes, mais des mises à jour majeures mises en œuvre sans support ni analyse SEO.

Pour cette raison, une agence ou un expert SEO devrait participer aux projets de conception Web dès le début. Si vous êtes à bord dès le premier jour, vous pouvez vous assurer que la structure du site elle-même alimente votre stratégie de référencement.

Pour les problèmes de visibilité organique

Si vos efforts de référencement sont au point mort, des baisses de trafic aléatoires ou un plateau de visibilité sont à prévoir. Cependant, lors d'une campagne active, le manque de résultats est un motif d'inquiétude.

Une baisse soudaine du trafic organique peut indiquer des erreurs sur le site Web ou une mise à jour de l'algorithme de Google qui a modifié l'évaluation du contenu existant. Dans les deux cas, vous pouvez exiger un audit SEO visant à identifier les problèmes à résoudre ou à adapter le site Web aux nouveaux critères d'évaluation utilisés par les robots des moteurs de recherche.

S'il existe une stratégie active de marketing de contenu et/ou de création de liens, une stagnation peut suggérer la présence d'erreurs non détectées qui freinent efficacement votre croissance.

Lors d'un partenariat avec une nouvelle agence de référencement

Un audit SEO est une procédure standard au début de la coopération avec toute agence ou expert spécialisé en SEO. Pour exécuter efficacement notre stratégie, nous devons savoir que le site Web est en bon état de fonctionnement.

Les clients ont tendance à s'opposer à cette idée, arguant qu'un site Web moderne ne peut contenir aucune erreur ou qu'un audit SEO a été effectué par l'ancienne agence l'année précédente.

Cependant, en tant que spécialiste qui assume la responsabilité du nouveau projet et de ses résultats, vous avez parfaitement le droit d'inspecter le site Web comme bon vous semble.

Comme une routine

Même si vous avez effectué l'audit SEO principal il y a quelque temps et qu'il n'y a pas eu de changements majeurs entre-temps, il est préférable d'effectuer des vérifications périodiques. Ils n'ont pas à prendre la forme d'audits techniques à grande échelle à partir de zéro. Selon les méthodes choisies, les audits de routine impliquent :

- des revues mensuelles ou trimestrielles basées sur les erreurs relevées lors de l'audit initial,

- les analyses se sont concentrées sur des problèmes fondamentaux tels que les nouvelles erreurs 404.

Ainsi, un audit de routine vise à vérifier si rien ne s'est passé depuis la dernière inspection. Comme nous le savons, tout site Web est une chose vivante - les pages vont et viennent, ou elles changent d'emplacement. Les magasins en ligne de taille moyenne ont tendance à être gérés par plusieurs personnes au sein de l'entreprise, et il y a toujours de la place pour l'erreur humaine.

Types d'audits SEO

Un audit SEO technique complet

Quand on parle d'audit SEO, on entend surtout l'inspection technique à grande échelle visant à révéler toutes les erreurs et imperfections potentielles d'optimisation. Ces audits se concentrent sur le site Web lui-même, couvrant les perspectives sur site et hors site. Les résultats sont présentés dans un rapport SEO rédigé par un expert SEO qui recueille des données à l'aide d'outils sélectionnés, analyse les résultats et propose des recommandations adaptées au produit du client.

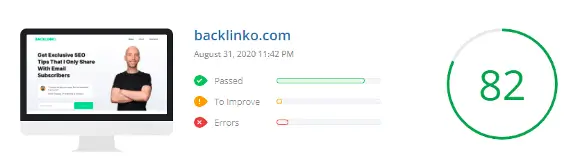

Audits SEO automatiques

Les audits automatiques peuvent être regroupés en deux catégories :

- des rapports PDF détaillés générés par des crawlers modernes et spécialisés tels que Sitebulb ;

- audits de sites Web effectués automatiquement par des outils gratuits.

Les rapports des deux types ont leurs utilisations. Cependant, alors que le premier type facilite le travail d'un expert chevronné, l'autre revient généralement à une analyse hâtive de quelques données de base, ce qui n'est pas suffisant pour tirer des conclusions plus larges.

Les rapports du deuxième type sont généralement disponibles en tant qu'incitatifs gratuits pour les clients.

Audits de concurrence SEO – benchmarking

Quelque chose d'autre est un audit de la concurrence SEO, généralement effectué lorsque nous commençons à développer votre stratégie de référencement. Il combine une analyse de visibilité de votre concurrence avec un court audit technique et de contenu des rivaux sélectionnés.

Cet audit fournit :

- votre référence actuelle face à la concurrence . L'audit vous montre comment votre site se classe dans la visibilité de Google par rapport à vos concurrents. Vous pouvez mettre à jour l'audit tous les trimestres pour déterminer comment votre stratégie affecte votre position sur le marché.

- une corne d'abondance de connaissances sur le chemin de nos concurrents vers leur position et leurs résultats actuels.

Vous pouvez utiliser l'audit pour :

- découvrir des solutions d'optimisation qui vont au-delà des recommandations standards,

- proposer de nouvelles idées pour la création de liens,

- et, surtout, définissez l' écart de contenu , qui peut vous montrer une nouvelle voie vers la croissance organique - quelque chose que vous avez manqué et qui génère beaucoup de trafic pour la concurrence.

Audits post-implantation

Après le premier audit, le client peut vous impliquer dans la mise en œuvre des recommandations (ce qui simplifie les choses) ou s'en charger lui-même. Dans ce dernier cas, il est préférable de conclure toute la procédure par une inspection finale lorsque vous parcourez la liste de contrôle point par point. Juste pour s'assurer que tout va bien.

Audits e-commerce

Tout d'abord, un audit de commerce électronique se concentre sur l'architecture du site Web, y compris la navigation principale, les catégories et les sous-catégories. Par conséquent, les audits techniques pour les boutiques en ligne nécessitent souvent l'ajout d'une stratégie d'utilisation de mots clés.

Deuxièmement, l'audit doit examiner la pagination et l'ensemble de la structure du site, car de nombreux développeurs de logiciels de commerce électronique considèrent l'utilisation notoire de rel=canonical et de robots noindex comme un remède à tous les maux. Le résultat : des boutiques en ligne avec 1000 SKU (stock-keeping units) qui génèrent plus d'un million de pages redondantes.

Troisièmement, l'accent devrait être mis sur l'élimination du contenu en double - à la fois interne (répété sur plusieurs options de produits) et externe (dans différents magasins).

Audits de contenu

Les audits de contenu (à ne pas confondre avec une stratégie de croissance ou un plan de contenu) se concentrent sur la maximisation du trafic organique avec l'utilisation des ressources existantes. Il peut s'agir d'analyses de :

- État actuel des liens internes au sein du domaine - l'objectif : déterminer si tous vos contenus sont liés les uns aux autres, et si ce seul lien dans l'onglet catégorie n'est pas le seul moyen de découvrir un article de grande valeur.

- Problèmes potentiels de cannibalisation des mots clés ou situations dans lesquelles un seul sujet est inutilement divisé en quelques articles distincts, dont aucun n'a une chance d'obtenir un premier rang.

- Identification du fruit à portée de main, c'est-à-dire le contenu qui ne nécessite que des changements cosmétiques (liaison, réoptimisation) pour commencer à générer du trafic organique.

Ce n'est que lorsque tout est en bon état de fonctionnement que vous devez procéder à la création de nouveau contenu et à une croissance supplémentaire.

Audit SEO d'un service local

Les entreprises opérant localement ont tendance à utiliser des sites Web plus petits, où la structure du site et l'architecture de l'information sont d'une importance secondaire.

La priorité ici est une analyse de mots clés (locale) appropriée, qui servira de base à la planification des pages d'offres. Par ailleurs, l'accent est mis sur :

- revoir et optimiser le profil de l'entreprise sur Google My Business,

- ajouter ou optimiser les données structurées Local Business,

- audit des liens externes et du facteur NAP (Nom + Adresse + Numéro de téléphone).

Un audit SEO gratuit en vaut-il la peine ?

Les audits SEO gratuits disponibles sur Internet n'ont généralement qu'un seul but : révéler une foule d'erreurs (souvent non pertinentes) afin de proposer au final des services payants.

Notez que ces audits ont tendance à être générés automatiquement par des outils numériques plutôt que rédigés par des experts SEO.

Souvent, un audit SEO doit être réalisé par plusieurs personnes spécialisées dans les questions techniques ou l'optimisation de contenu.

Dans certains cas, la portée de l'audit, la taille du site ou le délai nécessitent l'implication de toute une équipe employée par une agence de référencement.

Ainsi, il n'existe pas d'audit SEO gratuit et fiable d'un site Web.

Comment commencer votre audit SEO

La première chose que je fais lors d'un audit (ou plus tôt, lorsque je reçois la demande d'un client) est de :

- consultez le tableau de visibilité organique dans Senuto

- utilisez le site de l'opérateur de recherche :

Cela prend au total cinq minutes et me permet souvent d'identifier de nombreux problèmes sur le site Web.

N'oubliez pas qu'à l'étape du devis (et, dans certains cas, même lors de la réalisation de l'audit), vous n'aurez peut-être pas accès à Google Search Console ou Analytics, les outils externes sont donc indispensables .

Un simple coup d'œil dans le tableau de visibilité du site dans Senuto vous donne une mine d'informations sur le bien-être du site. En y regardant de plus près, concentrez-vous sur les points suivants :

- Direction du graphique - pour voir si la visibilité a augmenté régulièrement au cours des deux dernières années, sans pics ni baisses soudains. Si le graphique semble plat, cela suggère généralement le manque d'activité organique ou des problèmes majeurs qui entravent la croissance.

- Si vous remarquez des baisses soudaines dans un court laps de temps, essayez :

- comparant les anomalies à la liste des principales mises à jour d'algorithme connues dans la recherche Google. S'ils se chevauchent, au moins vous savez à quoi vous faites face.

- en utilisant la WayBackMachine pour voir à quoi ressemblait le site un mois avant et après la chute. Dans la plupart des cas, la visibilité chute après les migrations effectuées sans l'assistance d'un expert SEO.

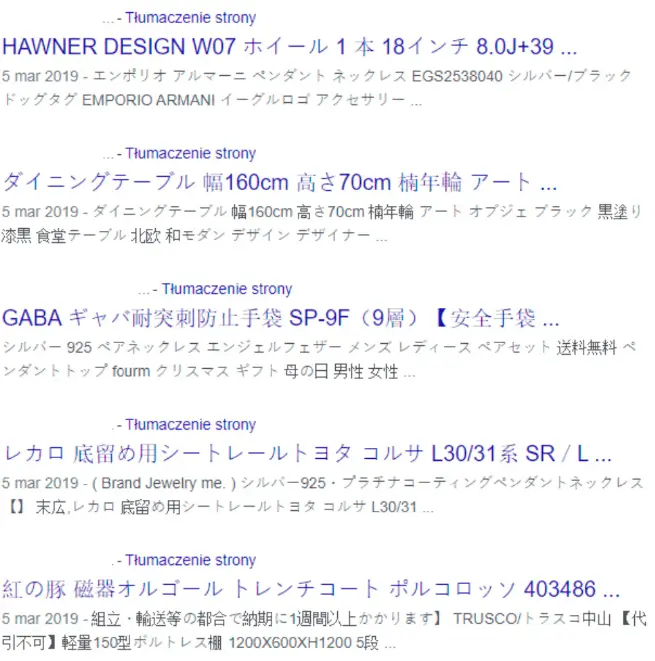

Un autre bon appel est d'utiliser l'opérateur site:domain.com couramment négligé. Cliquez sur les premiers résultats pour :

- faire une estimation approximative de la taille du site – même si vous devriez aller sur Google Search Console + votre robot d'exploration sélectionné pour les données les plus précises,

- voir la qualité générale des balises title, des balises meta description et la présentation des résultats.

- fréquemment : trouver des erreurs fondamentales telles que le piratage de sites ou des problèmes d'indexation.

Exemple :

Un client qui gère son entreprise depuis des années a remarqué une baisse du nombre de commandes et de nouvelles demandes sur le site Web de l'entreprise. Avec la commande site:domain.pl, le mystère a été résolu instantanément :

Points clés à vérifier lors d'un audit SEO

Dans le monde de l'analyse technique, l'attention s'est déplacée des balises individuelles telles que les en-têtes Hx vers des problèmes plus globaux : l'architecture, la structure ou le rendu du site (qui résulte, entre autres, des prouesses croissantes de Google dans la gestion de divers types de sites et technologies) .

Les plus grands défis dans la création d'un guide unique sur les audits SEO incluent :

- La grande variété de situations et de sites à inspecter lors d'un audit. Différents objectifs, types et CMS génèrent une myriade de configurations possibles.

- Les différences qui en résultent dans le poids des problèmes détectés et leurs solutions potentielles.

Théoriquement, je pourrais rédiger une liste séparée des meilleures pratiques d'optimisation et des erreurs courantes pour chaque CMS et système de commerce électronique. Dans cet esprit, il serait probablement plus précis d'appeler la liste ci-dessous - appuyée par mon expertise à partir de dizaines d'audits - quelque chose du genre : Fantastiques erreurs de référencement et où les trouver.

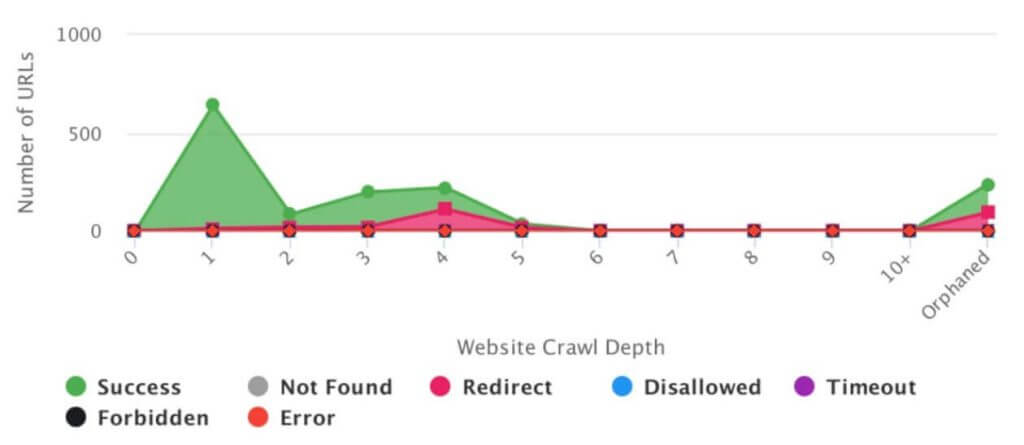

Crawling et indexation

Robots.txt

Le fichier robots.txt gère les emplacements sur le site que vous souhaitez masquer aux robots des moteurs de recherche. Il sert à bloquer l'exploration plutôt que l'indexation elle-même. De nos jours, les fichiers robots.txt contiennent rarement des erreurs, mais cela peut vraiment faire mal quand ils le font.

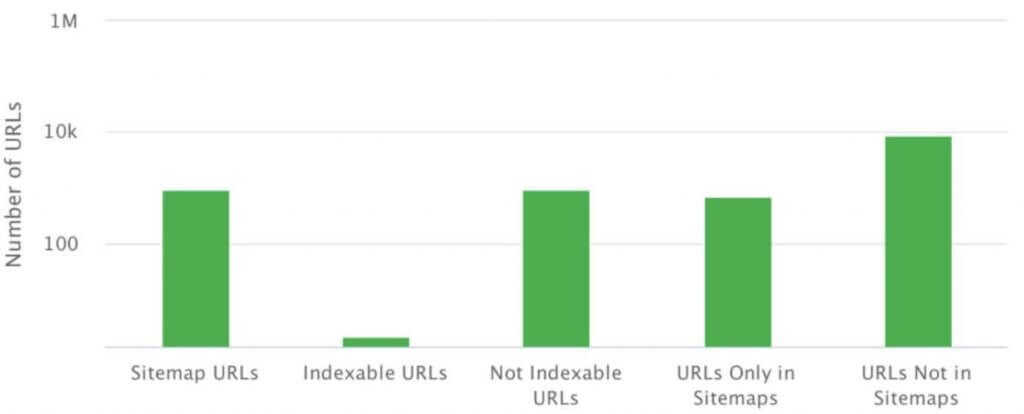

Un sitemap XML

Un sitemap XML est un fichier ou un ensemble de fichiers contenant la liste de toutes les pages que vous souhaitez voir indexées dans une structure donnée.

Vous pouvez localiser le plan du site à n'importe quelle adresse. Cependant, il doit présenter les données au format XML, conforme à la spécification.

Les erreurs de base relatives aux sitemaps XML incluent :

- l'absence d'un sitemap XML,

- des erreurs de syntaxe (rapportées dans GSC), qui empêchent Google de récupérer le sitemap,

- incompatibilité du plan du site et de la structure du site,

- omission d'inclure des fichiers tels que des graphiques et des vidéos dans le plan du site.

Pages orphelines

Les pages orphelines ne sont pas liées en interne, mais elles s'affichent souvent correctement et répondent avec un code d'état 200. Ils apparaissent dans Google Search Console, et parfois même gravissent les échelons et génèrent du trafic.

Les pages orphelines apparaissent pour de nombreuses raisons, à partir d'erreurs CMS et se terminant par des erreurs humaines dans les liens internes ou externes.

Rel=canonique

Rel=canonical n'est pas un problème lorsqu'il est utilisé comme prévu - pour référencer l'adresse de la page d'origine en cas de duplication interne. Cependant, il est souvent confondu avec une panacée pour toutes les pages gênantes et les structures mal planifiées.

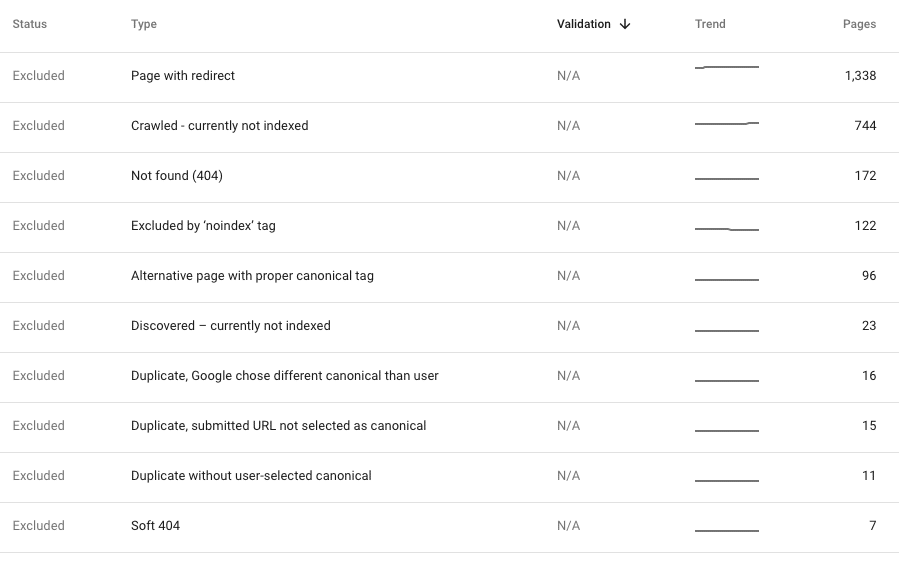

Erreurs 404 internes

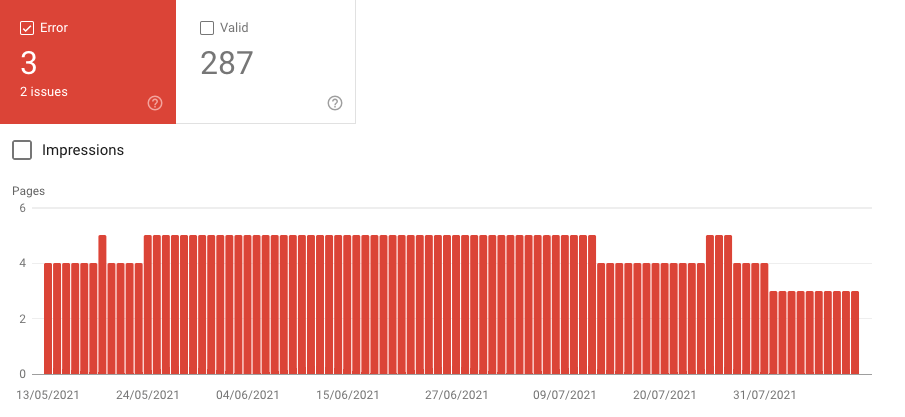

Chaque fois que nous détectons des erreurs internes 404 dans la structure du site en ligne, c'est-à-dire dans notre analyse actuelle, leur correction doit être notre priorité. De telles erreurs impliquent que notre site Web contient des liens vers des pages qui n'existent plus, ce qui est indésirable pour les utilisateurs et les bots. Cependant, dans la plupart des cas, le crawl est propre, mais GSC révèle des tonnes de 404.

Généralement, cela suggère l'un des problèmes énumérés ci-dessus : des erreurs dans la structure du site, un sitemap XML défectueux référençant des pages inexistantes ou des échos d'une migration mal gérée avec de mauvaises redirections.

Hélas, ces erreurs sont parfois lentement indexées par Google. Cependant, s'ils sont relativement récents, nous devrions inspecter la situation pour voir pourquoi ils se produisent. Si un nouveau crawl du site est propre, nous devons décider comment corriger au mieux les erreurs détectées dans GSC. Habituellement, la solution optimale consiste à rediriger les visiteurs vers l'équivalent thématique le plus proche du contenu problématique.

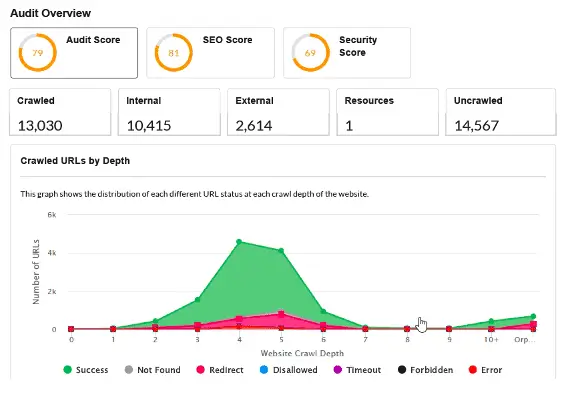

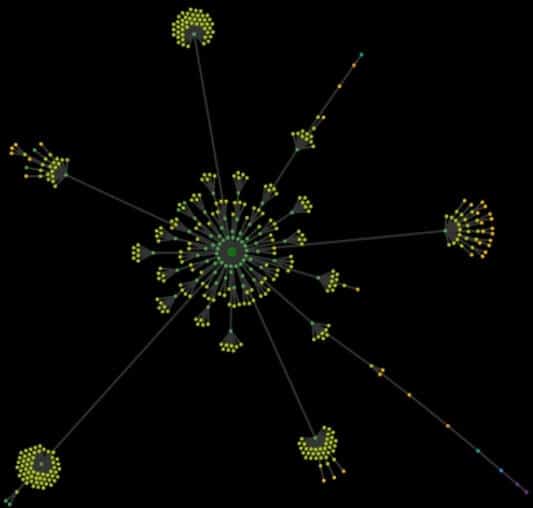

Analyse de l'architecture du site Web

Sans aucun moyen de visualiser l'apparence réelle du site Web, tout ce que vous avez est un Excel crypté avec des milliers d'URL. L'analyse de l'architecture du site (appelée crawl map) vous permet de détecter en un instant les erreurs et les goulots d'étranglement de la structure du site.

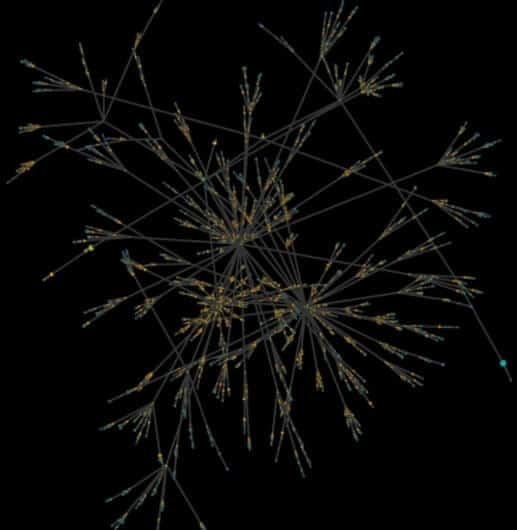

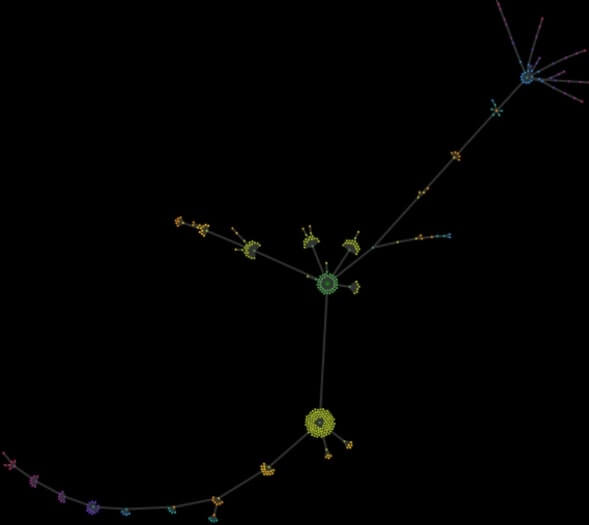

En général, une carte de crawl est une visualisation de toutes les URL trouvées sur le site Web, en commençant par la page d'accueil. Le principe est simple : si ce que l'on voit au premier coup d'œil est un ordre parfait et des « fleurs » harmonieuses de la structure sans goulots d'étranglement, les choses ne vont pas mal. Plus la carte est chaotique, plus vous devez réfléchir aux racines des problèmes.

L'image ci-dessous montre une carte d'exploration d'un site Web de contenu. En termes de référencement, sa structure a été correctement planifiée dès le départ, avec un spécialiste du référencement surveillant l'ensemble du processus. À première vue, vous voyez l'ordre, l'harmonie, des sections et des catégories clairement divisées et des liens corrects.

L'image ci-dessous montre une carte d'exploration d'un site Web de contenu développé pendant des années. De nouvelles sections ont été ajoutées et développées sans trop de prévoyance. À un moment donné, le client a demandé de l'aide en disant qu'il se perdait sur son propre site Web. La carte a révélé un chaos total, de sorte que la structure devait être replanifiée à partir de zéro.

En supplément, j'ajoute un crawl map d'une petite page locale composée de plusieurs pages d'offres et d'une dizaine d'actualités. Les deux "queues" étranges et surprenantes sont le produit d'extensions de calendrier, qui ont généré de nouvelles pages redondantes mais indexables à une profondeur d'exploration allant jusqu'à plus de 50 clics depuis la page d'accueil.

Facteurs sur place

Méta titre

Utilisez-le à votre avantage et agrémentez les titres de vos pages avec des mots-clés en adéquation avec votre stratégie. En outre, les titres de page ont un impact sur la cliquabilité du site Web dans les résultats de recherche.

Les erreurs les plus courantes concernant les titres incluent :

- créer des titres qui ne reposent pas sur la recherche de mots-clés et la stratégie de visibilité organique,

- l'absence de schéma de titre global, par exemple : [un composant unique pour la page] – [un composant/nom/marque régulier],

- titres en double dans le site - indiquant souvent un contenu en double.

Nous disons souvent que les titres doivent contenir environ 65 à 75 caractères (selon la largeur des lettres). Cependant, dans la pratique, il est plus important qu'ils contiennent nos mots-clés ciblés.

Meta Description

Le contenu des balises meta description n'est pas soumis à l'évaluation de l'algorithme. Pourtant, sa construction appropriée améliore l'apparence du site Web dans les résultats de recherche, ce qui se traduit par une meilleure cliquabilité de la liste.

Les erreurs les plus courantes concernant la méta description incluent :

- l'absence de meta description,

- descriptions en double dans le site (ce qui peut indiquer un contenu en double comme des titres en double),

- longueur excessive des descriptions.

Idéalement, chaque page destinée à générer du trafic sur les moteurs de recherche devrait avoir sa propre méta description avec un appel à l'action. Pourtant, cela s'avère souvent irréaliste. Dans de nombreux cas, tels que les magasins en ligne, nous pouvons créer des méta descriptions uniques pour les pages principales et les catégories, tandis que pour les pages de produits, générez des méta descriptions à partir d'un modèle rempli de caractéristiques du produit.

Hiérarchie des en-têtes Hx

Nous avons tous une idée de ce à quoi ressemble une hiérarchie d'en-tête appropriée. Pourtant, lors des audits SEO, nous rencontrons régulièrement des en-têtes H1 avec un logo.

L'impact des en-têtes Hx sur les classements est très discutable, en particulier à l'ère HTML5. Cependant, leur utilisation reste une pratique courante dans le monde du référencement.

Par conséquent, vous ne devriez avoir qu'un seul en-tête H1 par page. Il doit contenir le titre principal ainsi que des mots-clés importants.

Le nombre d'autres en-têtes n'a pas d'importance, tant que vous respectez les principes de priorité et d'imbrication (H3 dans H2), etc.

Lors des audits SEO, les problèmes d'en-tête tombent généralement au bas de la liste des priorités.

Javascript

Dans la plupart des cas, l'utilisation de JavaScript est naturelle et n'interfère pas avec l'indexation ou le rendu, qui est le point fort de Google. Cependant, dans un petit pourcentage de cas, cela provoque des erreurs critiques pour la visibilité du site.

En règle générale, il vous suffit de vérifier si le site nécessite une action supplémentaire (généralement un clic) pour afficher du contenu supplémentaire généré par JavaScript. Si c'est le cas, il est probable que GoogleBot n'effectuera pas cette action.

Une méthode simple et efficace pour vérifier cela consiste à exécuter deux crawls, l'un après l'autre, avec votre outil préféré. Le premier crawl doit analyser uniquement le HTML, avec le moteur Chrome désactivé. L'autre doit inclure JavaScript, avec le moteur Chrome activé.

Une comparaison entre deux crawls révélera des différences dans la structure, les liens et le contenu des deux versions. Les différences elles-mêmes ne sont pas un problème - si l'outil avec le rendu activé peut explorer le site Web, Google s'en sortira probablement aussi.

De plus, c'est une bonne idée de cliquer sur les pages principales du site Web et d'observer dans Chrome DevTools quelles ressources supplémentaires sont chargées, le cas échéant. Concentrez votre attention sur les éléments clés, tels que le menu, les liens internes et la mise en œuvre du contenu.

Données structurées / extraits enrichis

Sur la plupart des sites Web, les données structurées sont utilisées automatiquement, ce qui est un plus. Cependant, ils peuvent toujours générer des problèmes discutés ci-dessous :

- Le manque de données structurées.

- L'utilisation de formats réduits au strict minimum (scénario fréquent). La plupart des formats proposent des champs de contenu obligatoires et facultatifs à remplir. Pourtant, les systèmes de commerce électronique limitent souvent les données incluses dans le format Produit aux informations requises.

- L'absence de balises de navigation par fil d'Ariane - un outil simple et utile qui peut améliorer l'apparence de votre annonce dans les résultats de recherche.

- Utilisation limitée de données structurées. Actuellement, Google propose une galerie de 31 formats pris en charge - y compris des logos, des formats locaux, des articles - à utiliser et à combiner de multiples façons.

Facteurs d'expérience utilisateur

Vitesse de chargement des pages

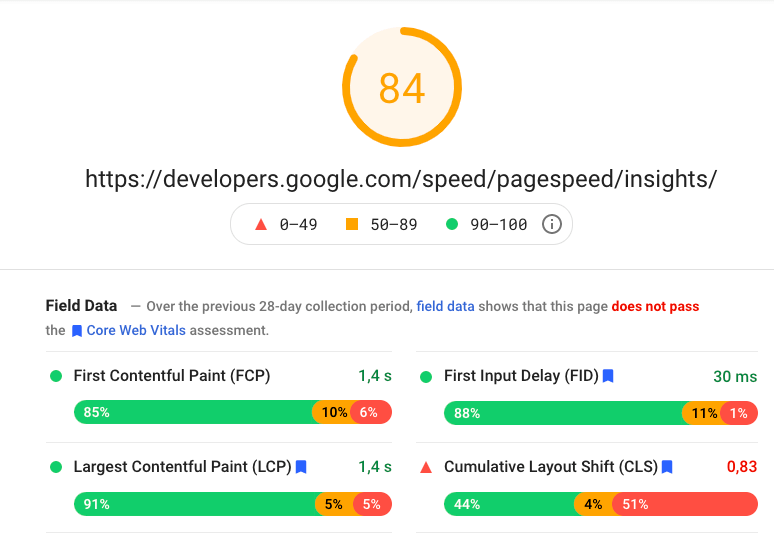

Il est indéniable que la vitesse de chargement des pages est importante. Autant dire que Google lui-même ne parle plus uniquement de vitesse, le remplaçant par "Core Web Vitals" à inclure dans l'algorithme de base en 2021.

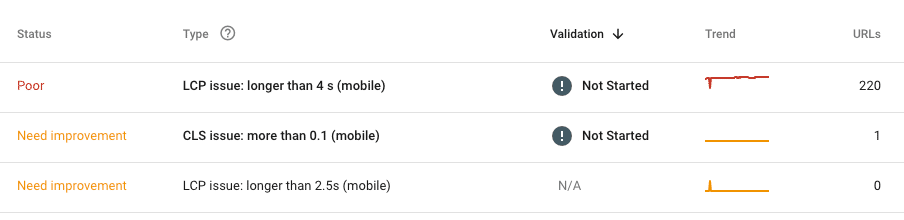

Actuellement, les paramètres clés à considérer sont :

LCP - Largest Contentful Paint - évaluant la vitesse de chargement du contenu principal,

FID - First Input Delay - évaluant la vitesse de réponse du site aux actions de l'utilisateur,

CLS - Cumulative Layout Shift - évaluation des changements soudains dans la disposition du site lors du chargement.

Notre boîte à outils comprend principalement des produits Google : les données de GSC et PageSpeed Insights. Les deux sont imparfaits, ils doivent nous servir de source principale d'analyse, à compléter avec un outil choisi en cas de besoin.

Important!

N'évaluez jamais la vitesse du site Web uniquement sur la base de la page d'accueil. C'est la pire chose à inclure dans un audit. Adoptez l'approche que vous connaissez d'autres analyses - divisez le site en sections similaires, en supposant que les erreurs détectées réapparaissent sur le site.

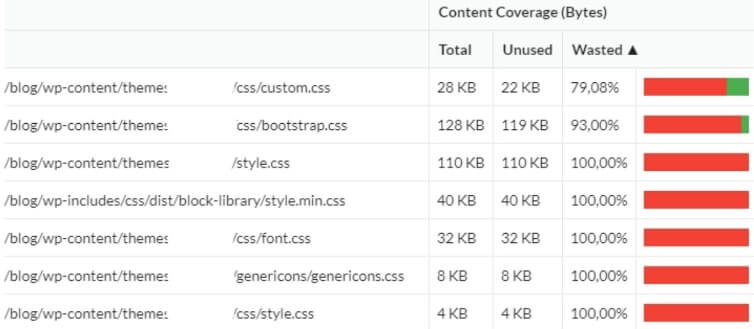

Quel est maintenant le plus gros problème avec la vitesse du site ? Au stade du développement, la priorité est de livrer le site Web le plus rapidement possible, et non d'optimiser la vitesse. Par conséquent, les développeurs ont souvent recours à des frameworks prêts à l'emploi (sans trop de réflexion). En conséquence, le propriétaire se retrouve avec des dizaines de fichiers redondants à ne jamais utiliser. Pour cette raison, complétez votre audit SEO par une analyse de l'utilisation réelle du code lors du rendu. Il s'avère souvent que même les 3/4 du code restent inutilisés

Optimisation mobile

À l'époque moderne, nous auditons rarement les sites qui ne répondent absolument pas. La plupart des sites sont entièrement adaptés aux appareils mobiles, ce qui n'implique pas nécessairement l'application de la philosophie mobile-first.

Au cours des 2 dernières années, je n'ai pas rencontré de site Web qui ne répondait pas du début à la fin. Cependant, le diable est dans les détails (tout comme dans le cas des erreurs liées à la vitesse), alors faites attention aux erreurs isolées telles que les pages où GSC ou crawler détectent des problèmes d'optimisation mobile. Dans la plupart des cas, ils résultent d'erreurs humaines (encore une fois, tout comme les erreurs liées à la vitesse) ou de tentatives de lancer de manière désinvolte de nouvelles fonctionnalités, non incluses dans le plan d'origine, dans le site Web principal et le CMS.

Analyse de contenu

Dans le référencement, le contenu du site Web comprend tout le contenu en dehors de la zone passe-partout, c'est-à-dire les éléments fixes du code source.

Reproduction

Dans la plupart des cas, le contenu dupliqué interne est le produit de :

Erreurs dans la conception du site Web (fonctionnalités et structure)

Exemple:

Une institution financière offrait des services aux particuliers, aux entrepreneurs et aux grandes entreprises. Navigation en fonction du type d'offre qui intéressait le client. Après avoir fait son choix, l'utilisateur était redirigé vers l'une des trois rubriques dédiées :

https://domain.pl/clients-individuels/

https://domain.pl/entrepreneur/

https://domain.pl/business/

Le client pouvait parcourir l'offre dédiée, mais la première partie de l'URL restait inchangée. Malheureusement, le contenu des trois offres se chevauchait à 90 %. Ainsi, le site a créé 3 structures quasi interchangeables avec le même contenu. C'est l'une des erreurs causées par le manque de support SEO au stade de la conception. En raison des réglementations internes du client, le problème s'est avéré pratiquement impossible à résoudre. La seule solution consistait à lancer un nouveau site Web un an après l'audit.

Erreurs humaines ou erreurs de développement

Exemple:

Un client avait le même contenu dans le pied de page et le menu principal. La solution, qui ne devrait généralement pas poser de problème, a causé pas mal de tracas. Le site comprenait une vingtaine de pages, mais une simple erreur de maillage interne a fait que le pied de page démultipliait le site à l'infini. Chaque lien dans le pied de page a généré un composant supplémentaire dans l'URL du pied de page. En conséquence, le client s'est retrouvé avec des adresses telles que :

https://domain.pl/history/history/history/contact/rules/history/contact/contact/

Type de site Web

Exemple:

Hélas, la duplication de contenu interne (et externe) est courante sur les sites de commerce électronique. Pour réaliser cela, imaginez un magasin proposant des produits similaires dans plusieurs variantes. Par exemple, des smartphones en cinq couleurs ou des vêtements en plusieurs tailles.

Nous ne voulons pas bloquer l'indexation ou utiliser rel=canonical pour différentes variantes afin de continuer à gagner du trafic à partir de la longue traîne. Pourtant, cela nous laisse avec du contenu en double ou presque des doublons.

Idéalement, nous devrions envisager de rédiger des descriptions uniques pour chaque produit. Cependant, lorsque nous avons de nombreux SKU et une rotation élevée des produits, la seule solution consiste à générer automatiquement des descriptions de produits différentes sur la base des caractéristiques uniques des produits et de leurs combinaisons.

Plusieurs versions d'URL et implémentation SSL

Pendant des années, l'analyse des problèmes de duplication interne reposait sur la vérification des redirections de la page d'accueil vers les versions sans www et sans https. Aujourd'hui, c'est un problème rare. De plus, Google a appris à le gérer de manière très efficace.

Les erreurs les plus courantes liées à SSL :

- Sur les sites avec des liens de menu codés en dur, les liens "http" peuvent rester à certains endroits sur le site parmi les nouveaux "https". En conséquence, nous nous retrouvons avec une nouvelle couche de redirections au sein du site Web.

- La migration vers SSL peut ne pas inclure toutes les ressources. Par conséquent, des éléments tels que des graphiques ou des scripts peuvent toujours être chargés à partir de la version "http".

Maillage interne

Les liens internes affectent l'exploration, l'indexation et la visibilité de chaque page, car les liens donnent un pouvoir/autorité interne à leurs emplacements cibles. L'analyse du maillage interne est un ensemble de contrôles distincts portant sur :

Éléments de navigation permanents : menu de navigation principal, pied de page, barre latérale

Les liens permanents, en particulier le menu de navigation principal, doivent être planifiés avec la stratégie d'utilisation des mots clés. Lors de la création d'un lien principal, la simplicité est essentielle - ne réfléchissez pas trop, car un code HTML propre fonctionne toujours mieux.

Lorsque nous comparons notre stratégie à la réalité et établissons que le menu principal contient tous les éléments nécessaires, vérifions les liens internes permanents mais redondants sur le site. Vous pouvez souvent les repérer dans le pied de page, le conteneur habituel pour à peu près n'importe quoi. Cela en vaut la peine, car chaque nouveau lien redondant perturbe le flux interne de puissance.

Certains liens et pages, tels que les règles et réglementations ou la politique de confidentialité, sont indispensables. Cependant, d'autres sont jetables. Par exemple, êtes-vous certain que chaque méthode d'expédition nécessite un lien distinct dans le pied de page, menant à une page distincte ? Ils tiendront tous sur un seul. Outre les liens obligatoires, organisons nos liens internes pour éviter les liens redondants vers des pages qui ne seront pas classées pour nos phrases clés.

Liaison automatique – publications/produits suggérés

Le lien automatique signifie un lien vers des articles suggérés (sur des blogs) ou des produits suggérés (sur des sites de commerce électronique). Généralement, si ces mécanismes sont gérés par des solutions toutes faites embarquées dans le CMS (WordPress), tout devrait bien se dérouler. Si les liens sont générés en HTML propre qui fait partie du code source, tout ce dont nous aurons peut-être besoin est une petite optimisation. Hélas, ces fonctionnalités utilisent souvent des solutions dynamiques basées sur JavaScript (Case Onely+H&M) ou, pire encore, les solutions de sociétés externes incluses sous forme de scripts d'autres domaines.

Liaison individuelle entre les pages utilisées principalement dans les sections de contenu

Les liens contextuels entre les articles sous-tendent la croissance de la visibilité de la section de contenu. Pourtant, il est souvent négligé. De ce fait, les seuls liens pointant vers les articles sont ceux des pages catégories.

Une analyse contextuelle des liens est relativement simple. Il vous suffit de mélanger les données de crawl sur le maillage interne avec les informations sur le trafic organique actuel (GSC/Analytics). En outre, vous pouvez inclure des données sur les liens entrants externes pour déterminer quels articles ont la plus grande autorité. Ajoutez des données sur la visibilité des mots-clés de départ (Senuto) pour voir quels domaines nécessitent votre attention et comment les corriger.

Liaison externe

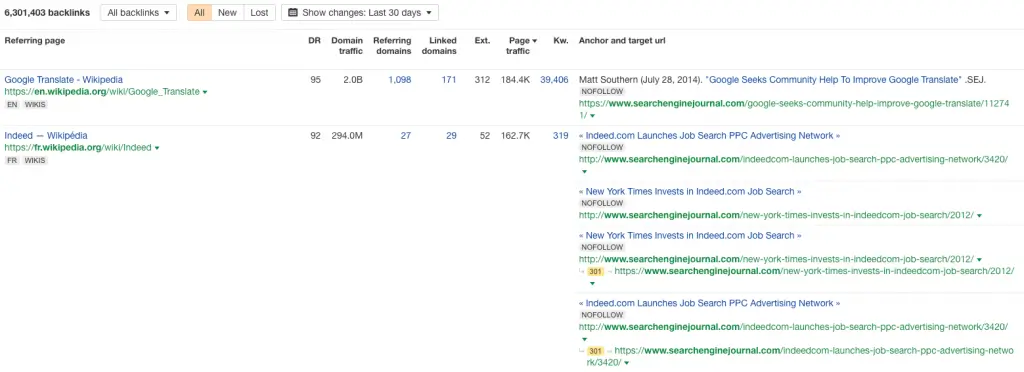

Analyse du profil des liens

Heureusement, les profils de liens médiocres sont de plus en plus rares, même si vous pouvez toujours rencontrer des liens créés avec GSA, Xrummer ou un autre générateur automatique.

Dans la grande majorité des cas, les liens trash sont :

- le souvenir des efforts SEO faits par des spécialistes il y a quelques années

- le signal que le site a été piraté pour télécharger du SPAM, qui a ensuite été lié par le pirate

- le produit des scrapers et des générateurs de SPAM qui téléchargent le contenu du site.

Lors de l'inspection du profil de lien, appliquez la règle d'or universelle - concentrez-vous sur les anomalies.

Il est plus facile de les repérer sur les graphiques de croissance des backlinks. Tous les pics et chutes soudains sont à analyser.

Distribution de liens profonds

L'analyse SEO de la distribution des liens sur la page d'accueil et d'autres pages du site Web sert à évaluer la qualité des liens dits profonds et ainsi identifier les sections ou les pages avec la plus haute autorité externe. Cela nous indique si notre distribution de liens est uniforme et quelles pages pourraient être des nœuds importants dans la structure et servir de distributeurs de puissance pour les liens internes.

Liens sortants

Une question souvent négligée est l'analyse des liens sortants du site Web. Lorsque vous inspectez un site Web basé sur du contenu ou du contenu généré par l'utilisateur, il comprend sûrement plusieurs dizaines de liens vers des domaines externes. Au fil des ans, beaucoup d'entre eux expirent, changent de mains ou vont sur des sites Web nuisibles. Répétez votre analyse des liens sortants – avec un crawler ou un outil externe – au moins une fois par an.

Backlinks cassés et perdus

Les backlinks cassés sont vos liens entrants qui pointent vers la page d'erreur 404 et sont ignorés par Google. Au fur et à mesure que votre site Web se développe, des backlinks cassés apparaissent naturellement - les pages changent d'emplacement, certaines sont supprimées et les gens font des erreurs lorsqu'ils lient notre contenu. Les backlinks cassés sont également une conséquence standard des migrations mal gérées, où les développeurs ont oublié les redirections, et le site Web a non seulement changé sa structure, mais a également perdu tous les liens sauf la page d'accueil en un jour.

Tous les backlinks perdus doivent être regroupés et redirigés vers la page thématiquement liée. En dernier recours, nous pouvons les rediriger vers un autre emplacement sur le site Web ou la page d'accueil. C'est le seul moyen de récupérer l'autorité qu'ils ont acquise pour notre domaine. Pendant que vous y êtes, passez en revue les domaines de liaison - si possible, redirigez uniquement les liens de qualité et laissez le spam pointer vers 404.