BERT: Pembaruan Terbesar Google dalam Beberapa Tahun

Diterbitkan: 2022-12-01BERT Google ditayangkan pada akhir 2019 dan memengaruhi hampir 10% dari semua pencarian. Bisa dibilang salah satu pembaruan algoritme terbesar tahun 2019, inilah semua yang harus diketahui oleh SEO dan pemilik situs tentang model pemrosesan bahasa alami Google yang canggih.

Apa itu BERT Google?

BERT adalah algoritma pembelajaran mendalam dan kependekan dari Representasi Encoder Bidirectional dari Transformers. Algoritme membantu memunculkan hasil yang lebih relevan untuk kueri penelusuran yang rumit.

Apa pengaruh pembaruan algoritma BERT pada pencarian Google?

Inilah yang dikatakan Google:

“Peningkatan ini berorientasi pada peningkatan pemahaman bahasa, terutama untuk kueri bahasa/percakapan yang lebih alami, karena BERT dapat membantu Penelusuran lebih memahami nuansa dan konteks kata dalam Penelusuran dan mencocokkan kueri tersebut dengan hasil yang bermanfaat dengan lebih baik.

Khususnya untuk kueri percakapan yang lebih panjang dan lebih banyak, atau penelusuran dengan kata depan seperti "untuk" dan "untuk" sangat berarti bagi artinya, Penelusuran akan dapat memahami konteks kata dalam kueri Anda. Anda dapat mencari dengan cara yang terasa alami bagi Anda.”

Faktanya, menurut Google pembaruan BERT akan berdampak pada 1 dari 10 pencarian bahasa Inggris di AS, itu adalah 10% dari permintaan pencarian. Inilah update Google yang paling signifikan dalam 5 tahun terakhir, setidaknya menurut mereka:

Kami melakukan peningkatan yang signifikan pada cara kami memahami kueri, yang merupakan lompatan terbesar dalam lima tahun terakhir, dan salah satu lompatan terbesar dalam sejarah Penelusuran.

Pengenalan BERT menyebabkan fluktuasi peringkat besar pada minggu pertama penyebaran algoritma baru. SEO di Dunia Webmaster telah mengomentari fluktuasi sejak awal minggu, mencatat fluktuasi peringkat terbesar yang melanda dunia SEO sejak RankBrain.

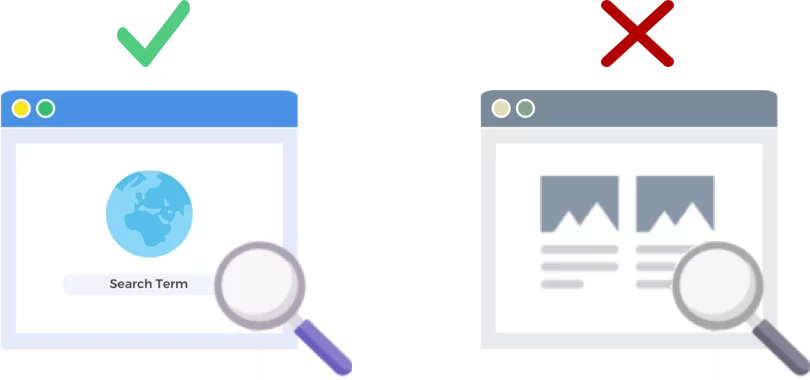

BERT Menganalisis Kueri Pencarian, BUKAN Halaman Web

Rilis algoritme BERT pada 24 Oktober 2019 meningkatkan cara raksasa mesin pencari menganalisis dan memahami permintaan pencarian (bukan halaman web).

Bagaimana BERT Bekerja?

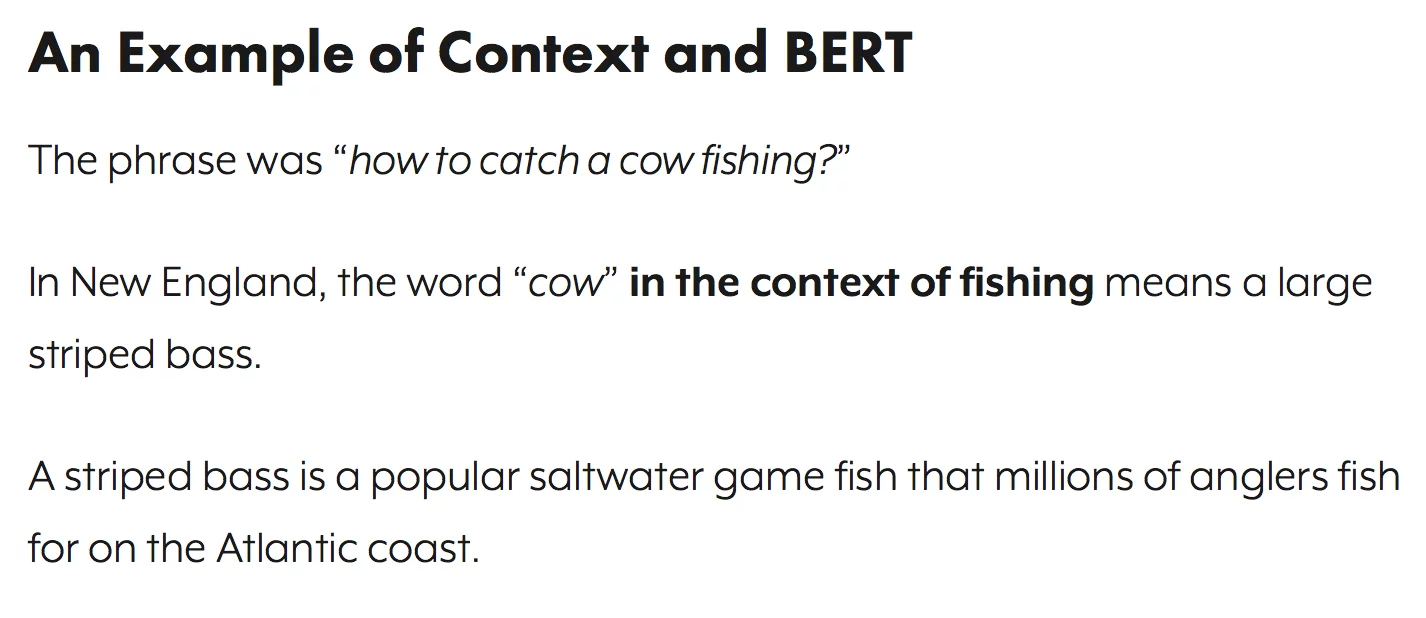

BERT meningkatkan pemahaman Google tentang kueri penelusuran menggunakan model konteks dua arah (yaitu B dalam BERT). Google sebenarnya berbicara sedikit tentang mekanisme BERT sekitar waktu ini tahun lalu ketika mereka mengumumkan BERT sebagai teknik baru untuk pra-pelatihan Pemrosesan Bahasa Alami (NLP).

Apa itu pra-pelatihan? Pra-pelatihan hanyalah mengajari mesin cara melakukan tugas, sebelum Anda benar-benar memberikannya pekerjaan. Dataset pra-pelatihan tradisional dimuat dengan beberapa ribu hingga beberapa ratus ribu contoh berlabel manusia.

Pra-pelatihan telah ada untuk sesaat, tetapi yang membuat BERT istimewa adalah keduanya kontekstual (makna setiap kata bergeser berdasarkan kata-kata di sekitarnya) dan dua arah - arti sebuah kata dipahami berdasarkan kata-kata baik Sebelum dan setelah itu.

Per Blog Google:

Dalam kalimat " Saya mengakses rekening bank ," model kontekstual searah akan mewakili " bank " berdasarkan " Saya mengakses " tetapi bukan " akun ." Namun, BERT merepresentasikan " bank " menggunakan konteks sebelumnya dan selanjutnya — " Saya mengakses ... akun " — mulai dari bagian paling bawah jaringan saraf yang dalam, menjadikannya sangat dua arah.

Pembaruan Google BERT dibuat berdasarkan kemajuan terkini dalam pembelajaran mesin dan pengenalan entitas. Pada dasarnya BERT membantu mengidentifikasi semua bagian ucapan dan konteks kata sebelum Google memproses pencarian.

Apa Arti BERT untuk Hasil Pencarian?

Menurut Google, ini berarti pengguna akan mulai melihat hasil yang lebih relevan, hasil yang lebih cocok dengan maksud pencarian pengguna. Peningkatan algoritme ini akan menjangkau hasil reguler dan hasil cuplikan kaya.

Google memberikan beberapa contoh bermanfaat dalam entri blog mereka yang mengumumkan BERT.

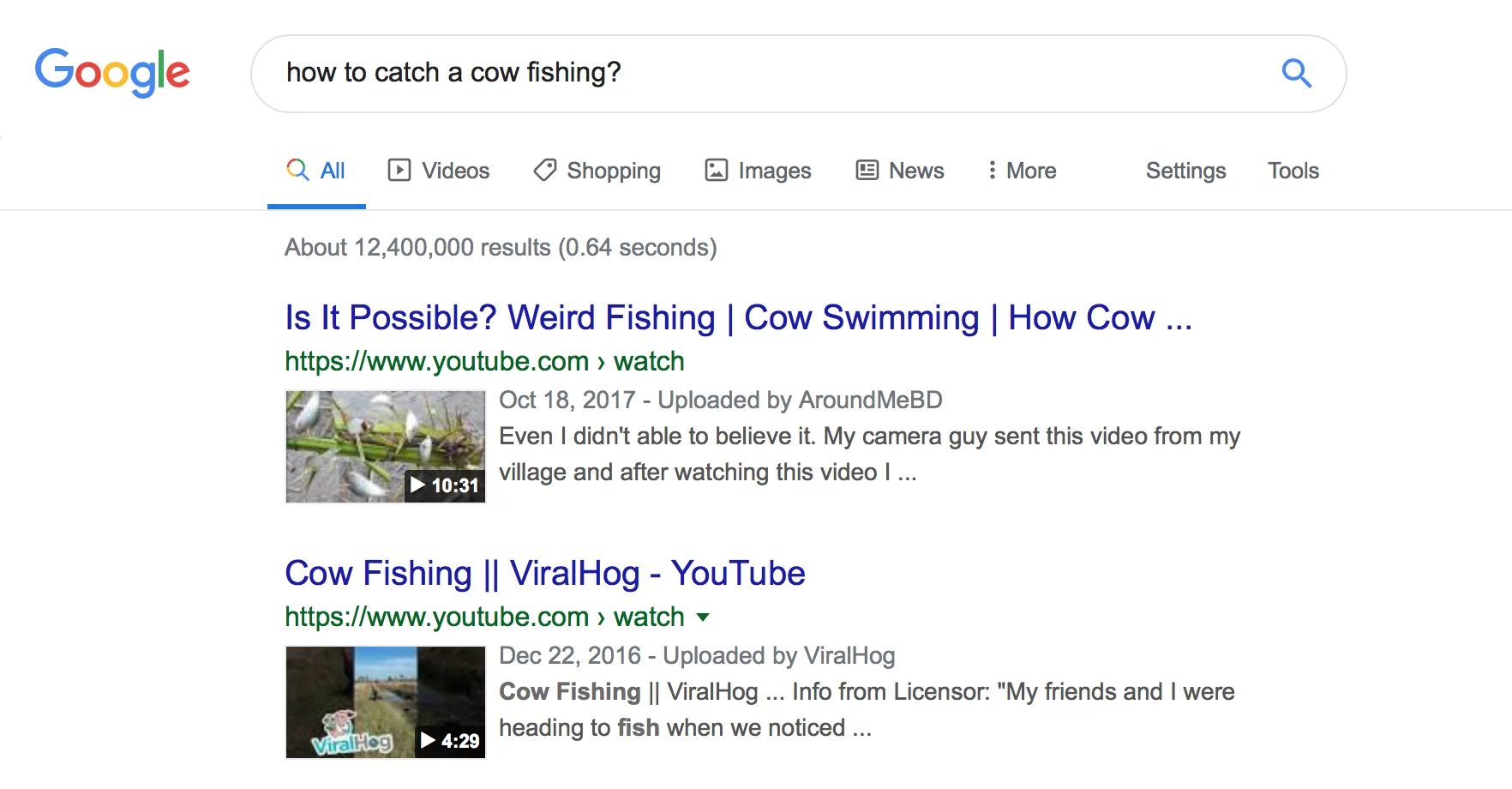

Contoh Estetika

Pertama, kami memiliki pengguna yang mencoba memahami jika Esthetician menghabiskan banyak waktu di kaki mereka sebagai bagian dari pekerjaan.

Anda dapat melihat di bawah bahwa sebelum BERT Google membaca kueri "apakah ahli kecantikan banyak bekerja" dan menghasilkan hasil yang membandingkan jenis lingkungan kerja untuk ahli kecantikan.

Setelah BERT, Google memunculkan artikel tentang tuntutan fisik untuk menjadi seorang ahli kecantikan, jauh lebih sejalan dengan informasi yang awalnya dicari oleh pencari.

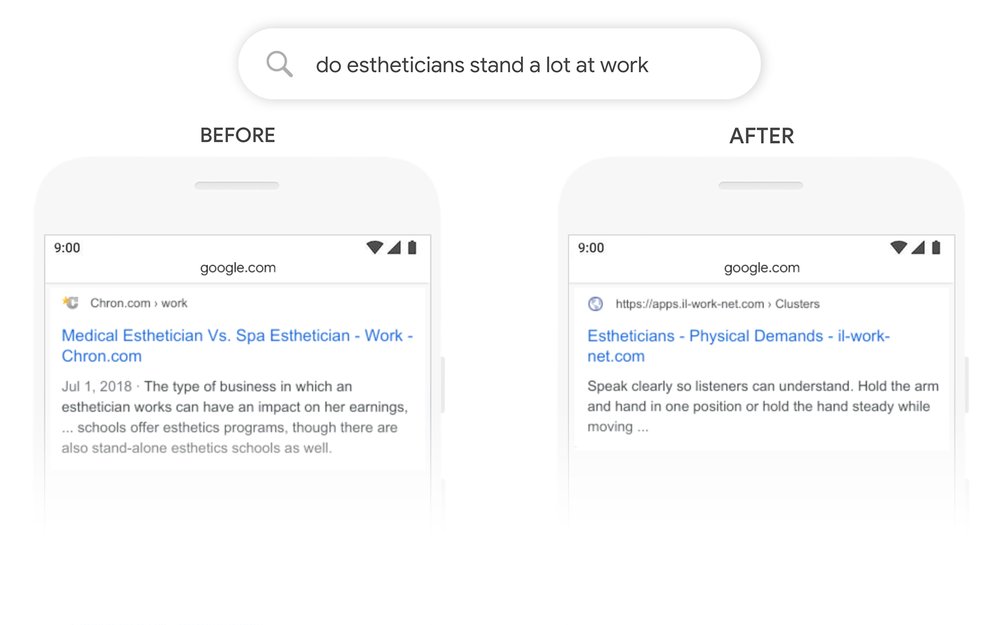

Contoh Buku Latihan Matematika

Dalam contoh ini, pengguna mencari buku latihan matematika untuk orang dewasa, tetapi menampilkan buku latihan matematika untuk anak-anak.

Setelah BERT, Google mengenali konteks kueri dengan benar, menghitung lebih baik untuk bagian kedua dari penelusuran "untuk orang dewasa".

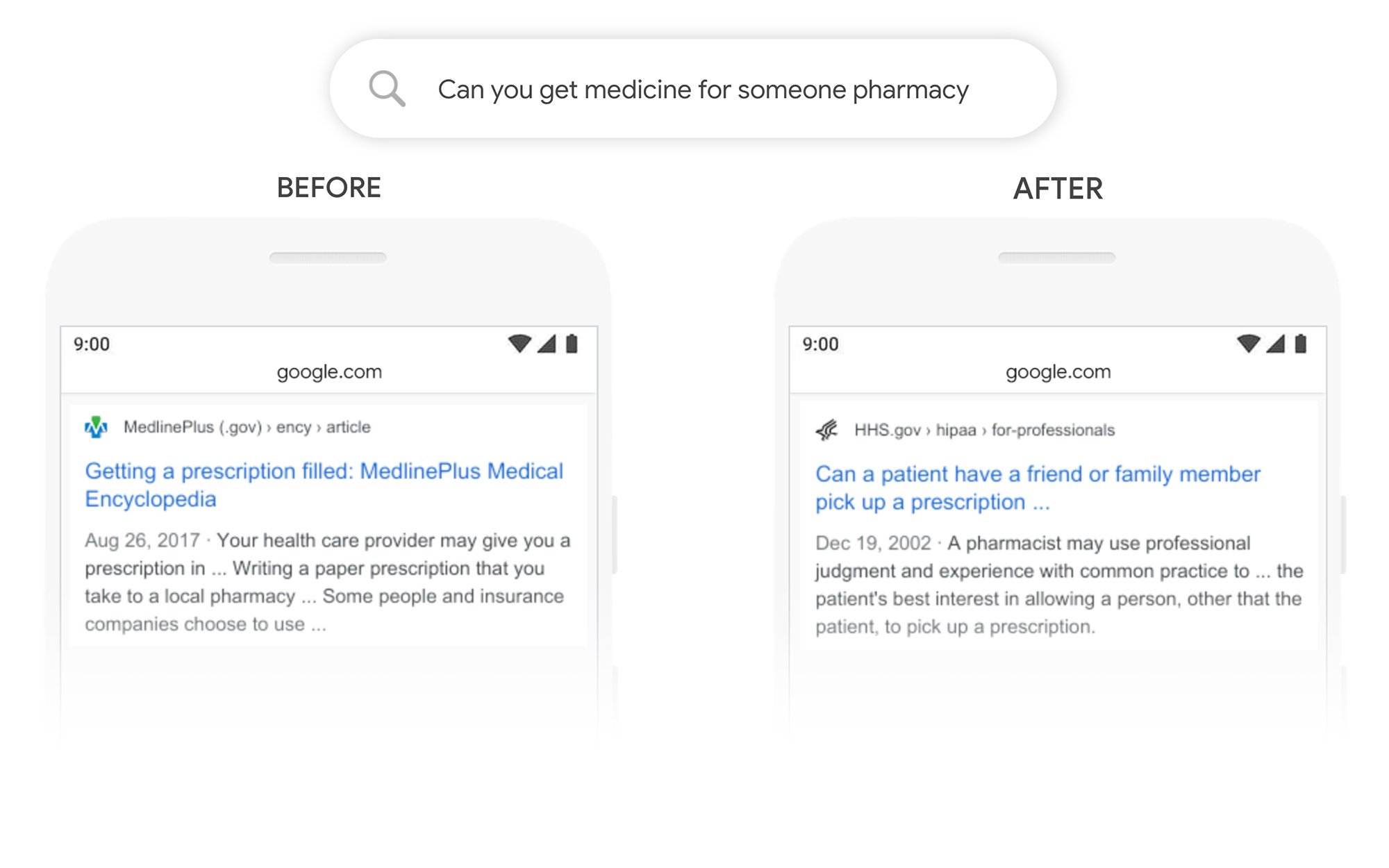

Contoh Dapatkah Anda Mengambil Obat Untuk Orang Lain

Dalam contoh ini kueri “bisakah Anda mendapatkan obat untuk apotek seseorang” menampilkan hasil tentang cara mengisi resep secara umum, bukan cara mengisinya untuk pihak ke-3. Setelah BERT, Google lebih memahami tujuan pengguna dan memunculkan artikel tentang apakah pasien dapat meminta teman atau anggota keluarga untuk mengambilkan resep untuk mereka atau tidak.

Apa yang Dapat Saya Lakukan untuk Memberi Peringkat Lebih Baik setelah BERT?

Untuk kata kunci apa pun di mana Anda kehilangan peringkat, Anda harus melihat halaman hasil pencarian yang direvisi untuk lebih memahami bagaimana Google melihat maksud pencarian dari istilah target Anda. Kemudian revisi konten Anda sesuai untuk memenuhi tujuan pengguna dengan lebih baik.

Jika Anda kehilangan peringkat di bawah BERT, kemungkinan besar itu adalah masalah yang terkait dengan seberapa cocok halaman Anda dengan maksud pencarian pengguna (membantu pengguna mencapai tujuan mereka) daripada menjadi masalah kualitas konten.

Mengingat bahwa BERT kemungkinan akan terus mendukung upaya pencarian suara dari waktu ke waktu, kami juga merekomendasikan situs web untuk menulis salinan yang jelas dan ringkas. Jangan gunakan bahasa pengisi, jangan kabur, langsung ke intinya.

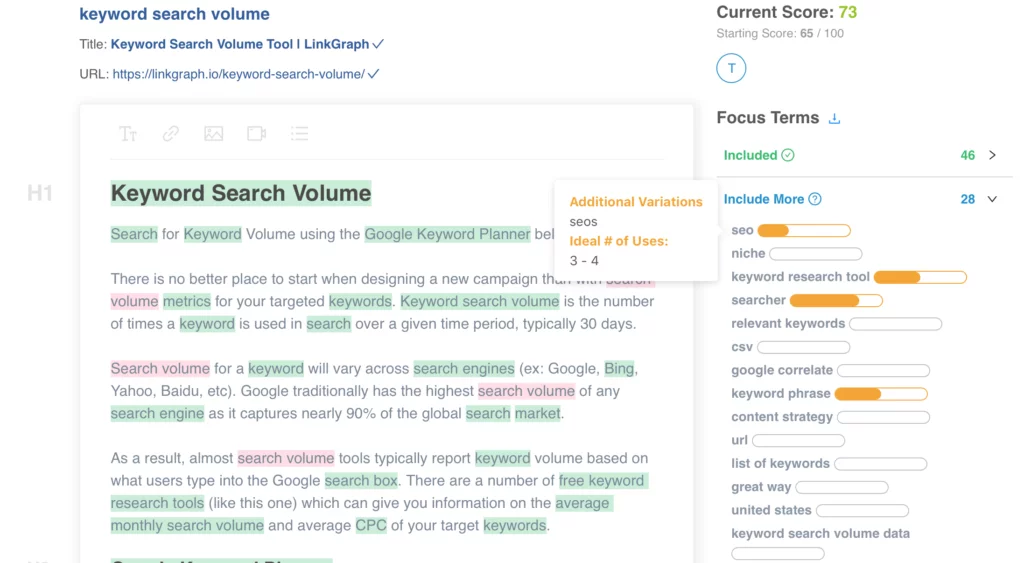

Butuh bantuan untuk mengoptimalkan konten Anda? Lihat Pengoptimal Konten Di Halaman LinkGraph, hubungi anggota tim kami di [email protected], atau jadwalkan rapat untuk menyiapkan hari ini.

Di Mana Saya Dapat Mempelajari Lebih Lanjut?

Dawn Anderson memberikan presentasi yang bagus awal bulan ini di Pubcon tentang “Google BERT and Family and the Natural Language Understanding Leaderboard Race,” dan Anda dapat melihat presentasinya.

Terima kasih telah memiliki #Pubcon saya. Ini dek saya <3 <3 https://t.co/aGYDI9pfdY

– Dawn Anderson (@dawnieando) 10 Oktober 2019

Jeff Dean juga baru-baru ini melakukan keynote di AI di Google termasuk BERT, yang bisa Anda tonton.