BERT: il più grande aggiornamento di Google da anni

Pubblicato: 2022-12-01Il BERT di Google è entrato in funzione alla fine del 2019 e ha avuto un impatto su quasi il 10% di tutte le ricerche. Probabilmente uno dei più grandi aggiornamenti dell'algoritmo del 2019, ecco tutto ciò che i SEO e i proprietari di siti dovrebbero sapere sul modello avanzato di elaborazione del linguaggio naturale di Google.

Cos'è il BERT di Google?

BERT è un algoritmo di deep learning e abbreviazione di Bidirectional Encoder Representations from Transformers. L'algoritmo ha aiutato a far emergere risultati più pertinenti per query di ricerca complicate.

Qual è stato l'effetto dell'aggiornamento dell'algoritmo BERT sulla ricerca di Google?

Questo è ciò che ha detto Google:

“Questi miglioramenti sono orientati a migliorare la comprensione della lingua, in particolare per query con linguaggio più naturale/conversazionale, poiché BERT è in grado di aiutare la ricerca a comprendere meglio la sfumatura e il contesto delle parole nelle ricerche e ad abbinare meglio tali query con risultati utili.

In particolare per query più lunghe e conversazionali o ricerche in cui preposizioni come "per" e "a" contano molto per il significato, Ricerca sarà in grado di comprendere il contesto delle parole nella tua query. Puoi cercare in un modo che ti sembra naturale.

Infatti, secondo Google, l'aggiornamento BERT avrà un impatto su 1 ricerca inglese su 10 negli Stati Uniti, ovvero il 10% delle query di ricerca. Questo è l'aggiornamento più significativo di Google negli ultimi 5 anni, almeno secondo loro:

Stiamo apportando un miglioramento significativo al modo in cui comprendiamo le query, rappresentando il più grande balzo in avanti degli ultimi cinque anni e uno dei più grandi balzi in avanti nella storia della Ricerca.

L'introduzione di BERT ha causato importanti fluttuazioni di classifica nella prima settimana di implementazione del nuovo algoritmo. I SEO di Webmaster World hanno commentato le fluttuazioni dall'inizio della settimana, notando la più grande fluttuazione delle classifiche che ha colpito il mondo SEO dai tempi di RankBrain.

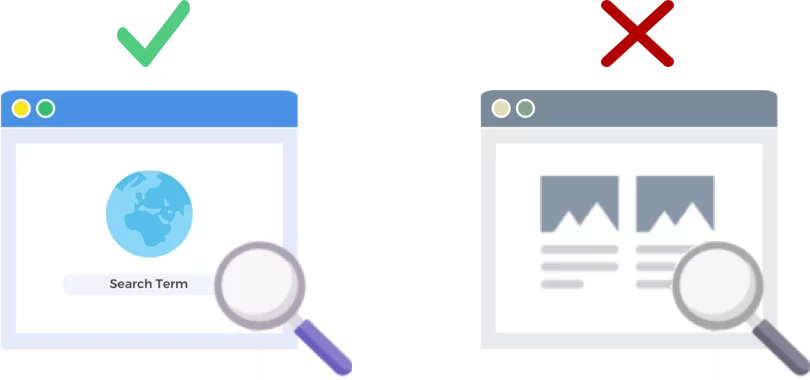

BERT analizza le query di ricerca NON le pagine web

La versione del 24 ottobre 2019 dell'algoritmo BERT migliora il modo in cui il gigante dei motori di ricerca analizza e comprende le query di ricerca (non le pagine web).

Come funziona BERT?

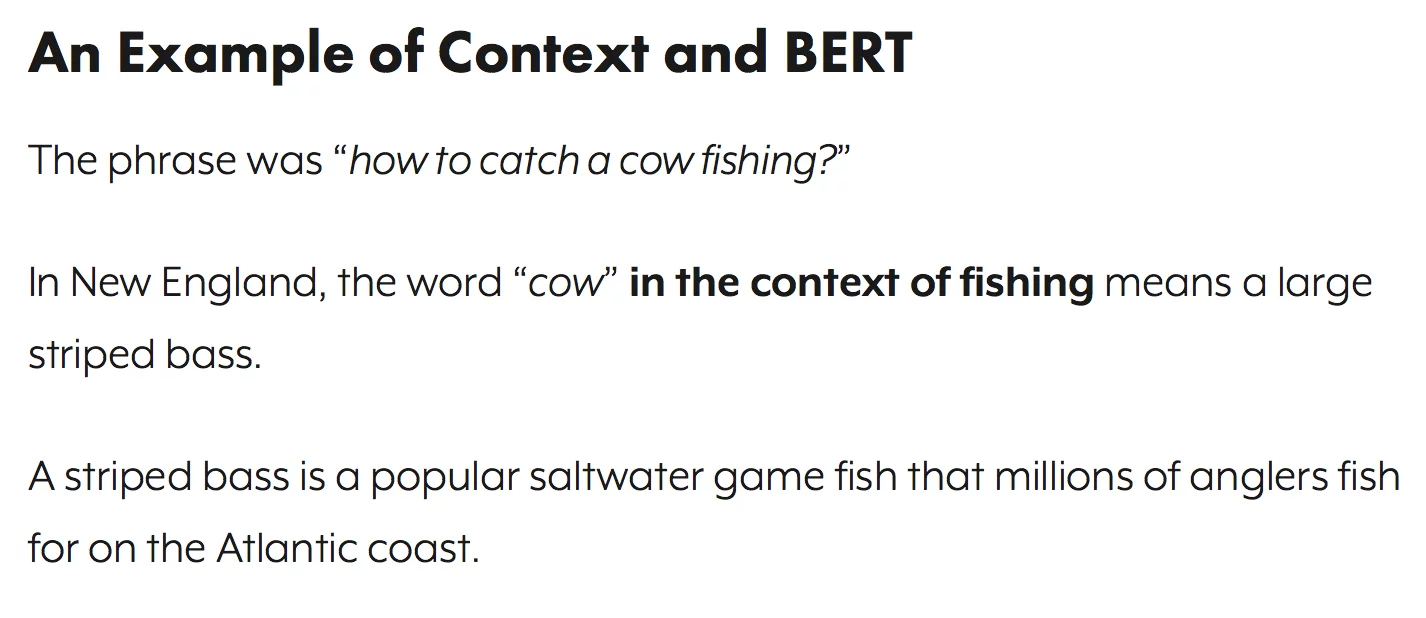

BERT migliora la comprensione da parte di Google delle query di ricerca utilizzando un modello di contesto bidirezionale (ovvero la B in BERT). Google in realtà ha parlato un po 'dei meccanismi di BERT in questo periodo l'anno scorso, quando hanno annunciato BERT come una nuova tecnica per la pre-formazione sull'elaborazione del linguaggio naturale (NLP).

Cos'è la pre-formazione? La pre-formazione è solo insegnare a una macchina come eseguire le attività, prima che tu le dia effettivamente il lavoro da fare. Tradizionalmente i set di dati di pre-addestramento vengono caricati da poche migliaia a poche centinaia di migliaia di esempi con etichetta umana.

Il pre-training esiste da tempo, ma ciò che rende BERT speciale è che è sia contestuale (il significato di ogni parola cambia in base alle parole che la circondano) sia bidirezionale: il significato di una parola viene compreso in base alle parole sia prima che dopo ciò.

Per blog di Google:

Nella frase " ho effettuato l'accesso al conto bancario ", un modello contestuale unidirezionale rappresenterebbe " banca " in base a " ho effettuato l'accesso al " ma non " conto ". Tuttavia, BERT rappresenta " banca " utilizzando sia il contesto precedente che quello successivo - " Ho effettuato l'accesso al ... conto " - a partire dal fondo di una rete neurale profonda, rendendola profondamente bidirezionale.

L'aggiornamento di Google BERT si basa sui recenti progressi nell'apprendimento automatico e nel riconoscimento delle entità. Fondamentalmente BERT aiuta a identificare tutte le parti del discorso e il contesto delle parole prima che Google elabori una ricerca.

Cosa significa BERT per i risultati di ricerca?

Secondo Google, significa che gli utenti inizieranno a vedere risultati più pertinenti, risultati che corrispondono meglio all'intento della ricerca di un utente. Questo miglioramento dell'algoritmo riguarderà i risultati regolari e i risultati dei rich snippet.

Google ha fornito alcuni esempi utili nel suo post sul blog che annunciava BERT.

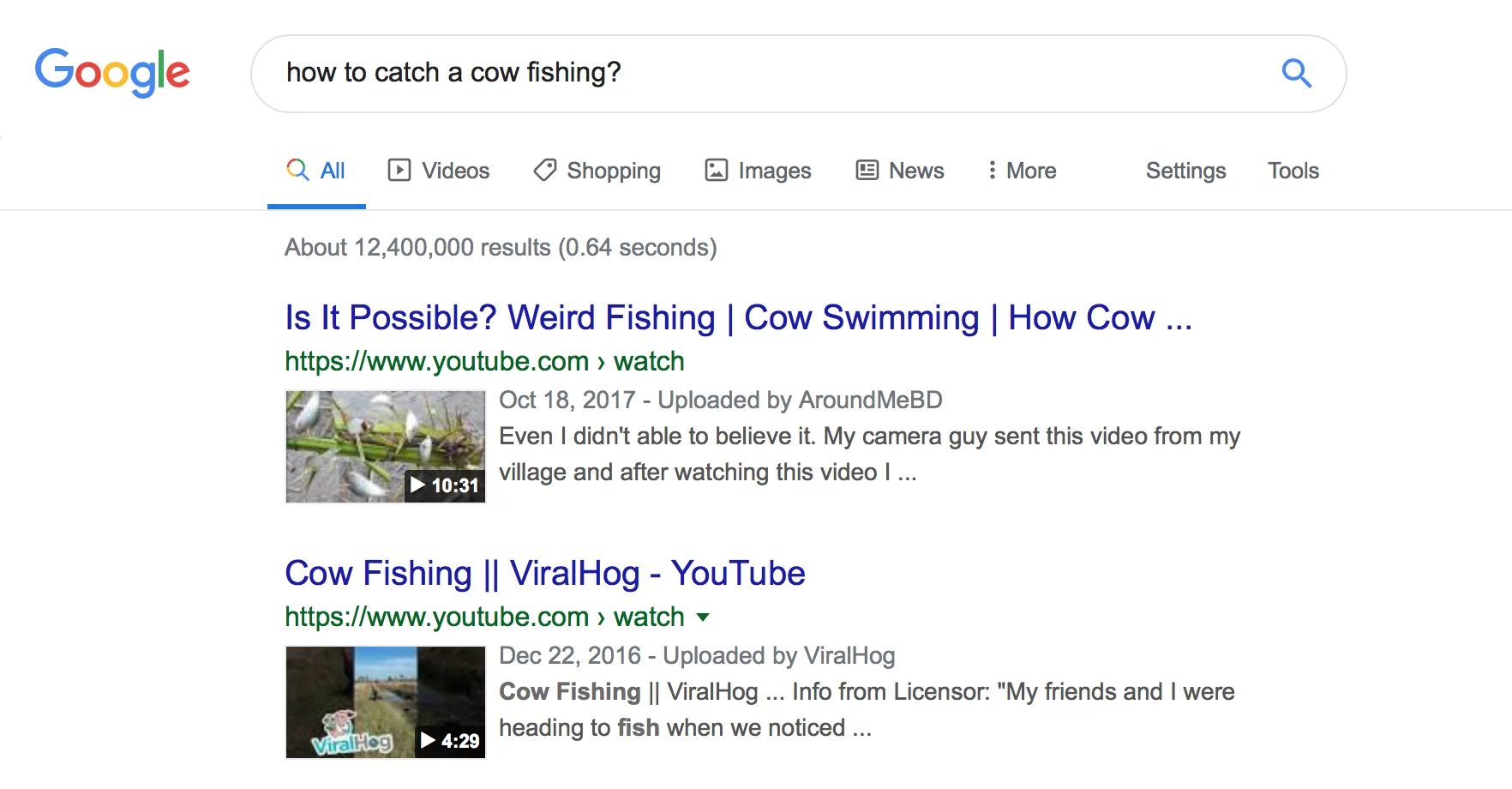

L'esempio dell'estetista

Innanzitutto, abbiamo un utente che cerca di capire se gli estetisti trascorrono molto tempo in piedi come parte del lavoro.

Di seguito puoi vedere che prima di BERT Google leggeva la domanda "gli estetisti stanno molto al lavoro" e produceva un risultato confrontando i tipi di ambienti di lavoro per gli estetisti.

Dopo BERT Google sta facendo emergere un articolo sulle esigenze fisiche di essere un estetista, molto più in linea con le informazioni che il ricercatore stava originariamente cercando di far emergere.

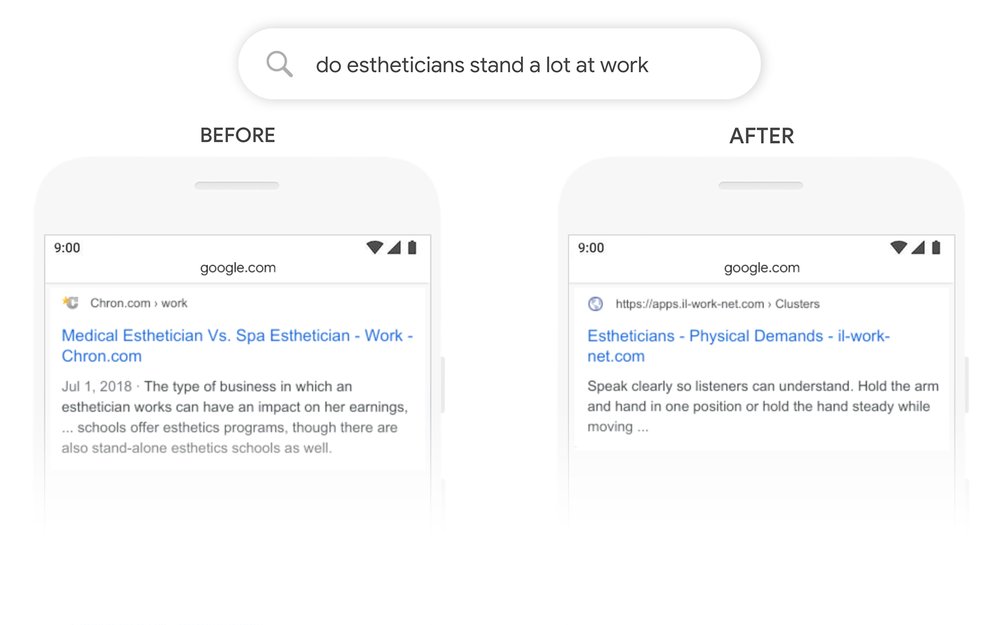

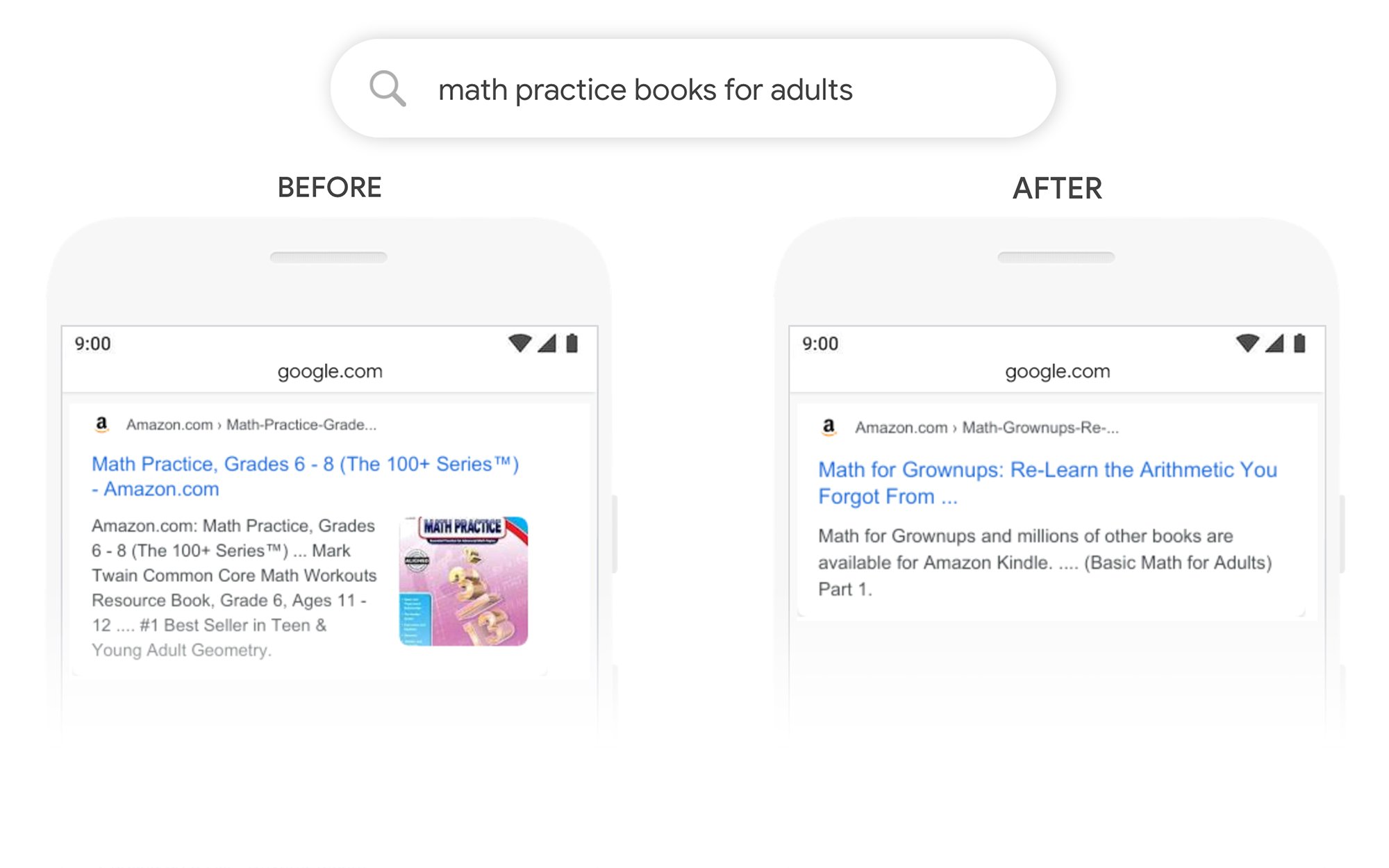

L'esempio dei libri di pratica di matematica

In questo esempio, un utente cerca libri di esercizi di matematica per adulti, ma visualizza libri di esercizi di matematica per bambini.

Dopo BERT, Google riconosce correttamente il contesto della query, rappresentando meglio la seconda parte della ricerca “per adulti”.

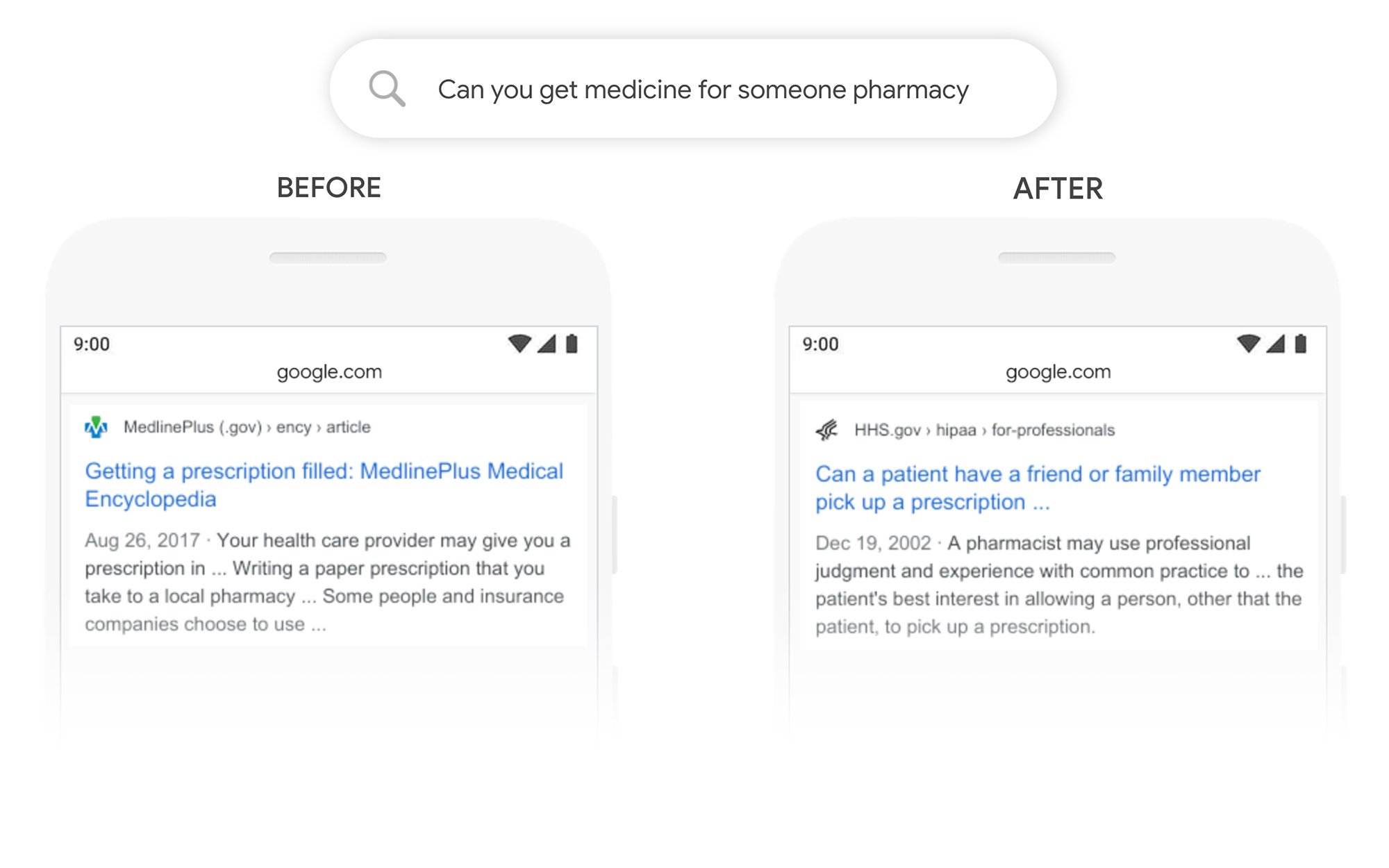

L'esempio Puoi prendere la medicina per qualcun altro

In questo esempio la query "puoi ottenere medicine per qualcuno in farmacia" restituisce un risultato su come compilare le prescrizioni in generale, piuttosto che su come compilarle per una terza parte. Dopo BERT, Google comprende meglio l'obiettivo dell'utente e fa emergere un pezzo sulla possibilità o meno che un paziente possa chiedere a un amico o un familiare di ritirare la prescrizione per loro.

Cosa posso fare per classificarmi meglio dopo BERT?

Per tutte le parole chiave in cui perdi posizioni, dovresti dare un'occhiata alla pagina dei risultati di ricerca rivista per capire meglio come Google sta visualizzando l'intento di ricerca dei tuoi termini target. Quindi rivedi i tuoi contenuti di conseguenza per soddisfare meglio gli obiettivi dell'utente.

Se hai perso le classifiche sotto BERT, è più probabile che si tratti di un problema relativo al modo in cui la tua pagina corrisponde all'intento di ricerca di un utente (aiuta un utente a raggiungere il suo obiettivo) piuttosto che a un problema di qualità del contenuto.

Dato che è probabile che BERT supporti ulteriormente gli sforzi di ricerca vocale nel tempo, consigliamo anche ai siti Web di scrivere testi chiari e concisi. Non usare un linguaggio di riempimento, non essere vago, vai dritto al punto.

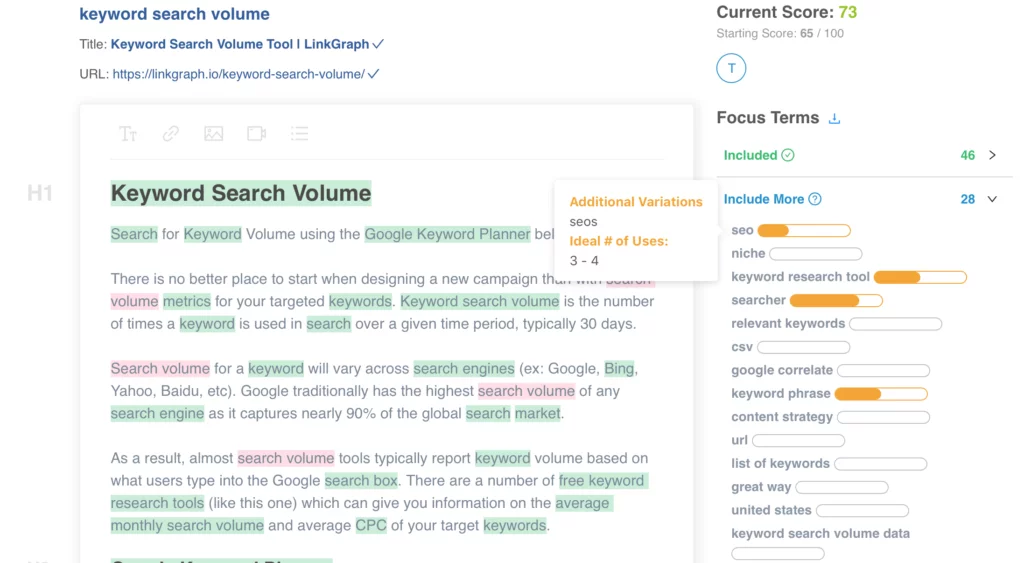

Hai bisogno di aiuto per ottimizzare i tuoi contenuti? Dai un'occhiata a On Page Content Optimizer di LinkGraph, contatta un membro del nostro team all'indirizzo sales@linkgraph.io o pianifica un incontro per ottenere la configurazione oggi.

Dove posso saperne di più?

Dawn Anderson ha tenuto un'ottima presentazione all'inizio di questo mese al Pubcon su "Google BERT and Family and the Natural Language Understanding Leaderboard Race", e puoi dare un'occhiata alla sua presentazione.

Grazie per avere il mio #Pubcon. Ecco il mio mazzo <3 <3 https://t.co/aGYDI9pfdY

— Dawn Anderson (@dawnieando) 10 ottobre 2019

Jeff Dean ha anche recentemente tenuto un discorso di apertura sull'intelligenza artificiale di Google, incluso BERT, che puoi guardare.