Stanco di ChatGPT che gratta i tuoi contenuti? Proteggi i tuoi contenuti ORA

Pubblicato: 2023-07-06

Nel panorama digitale odierno, la protezione dei contenuti, dei dati e del traffico web è della massima importanza. Con l'emergere di ChatGPT e di altri modelli di linguaggio AI, c'è una crescente preoccupazione per questi strumenti che raschiano i contenuti a proprio vantaggio. In qualità di editore, è essenziale capire come funzionano questi bot e i potenziali rischi che comportano.

In questo articolo, esploreremo il mondo dello scraping di ChatGPT e LLM e discuteremo le strategie per superare in astuzia e proteggere il traffico del tuo sito web.

Come faccio a sapere che ChatGPT sta effettuando lo scraping dei miei contenuti?

ChatGPT, vari plugin e altri modelli linguistici hanno guadagnato lo status di star grazie alla loro notevole capacità di generare testo simile a quello umano. Questi strumenti hanno rilevato e licenziato dipendenti di vari settori, tra cui la creazione di contenuti, il servizio clienti e persino la scrittura creativa. Sebbene possano essere utili in molti modi, è fondamentale capire che ci sono casi in cui possono essere utilizzati in modo improprio per lo scraping di contenuti.

Lo scraping, nel contesto di Internet, si riferisce al processo di estrazione di informazioni dai siti Web utilizzando robot automatizzati. Questi robot visitano diverse pagine Web, raccolgono dati e li utilizzano per addestrare ulteriormente i modelli di intelligenza artificiale. Quando ChatGPT o altri LLM estraggono contenuti, essenzialmente utilizzano i dati che raccolgono per migliorare le loro capacità di generazione di testo.

Tuttavia, il problema principale sorge quando questo processo di scraping viola i diritti di proprietà intellettuale e danneggia l'attività degli editori e delle organizzazioni dei media. È essenziale essere consapevoli di come i tuoi contenuti possono essere sottoposti a scraping e delle sue potenziali conseguenze sul tuo traffico web.

I problemi con lo scraping

Uno dei problemi principali con lo scraping è che può portare a perdere il controllo sui tuoi contenuti. Quando il contenuto del tuo sito web viene raschiato, può essere riutilizzato e distribuito altrove senza il tuo consenso. Ciò mina la tua autorità come creatore originale e pone sfide nel mantenere l'accuratezza e l'integrità dei tuoi contenuti.

Lo scraping può avere un impatto significativo sul posizionamento nei motori di ricerca del tuo sito web. I motori di ricerca danno la priorità ai contenuti originali e unici e, quando i contenuti di scraping vengono pubblicati altrove, possono ridurre la visibilità e la rilevanza del tuo sito Web nei risultati di ricerca. Ciò può comportare una diminuzione del traffico organico e una potenziale perdita di entrate.

Può anche portare a una rappresentazione distorta del tuo marchio o della tua organizzazione. Quando il contenuto di scraping viene utilizzato in modo inappropriato o fuori contesto, può travisare le tue intenzioni, creando confusione o addirittura danneggiando la tua reputazione. È fondamentale proteggere l'identità del tuo marchio e garantire che i tuoi contenuti vengano utilizzati in modo responsabile e con una corretta attribuzione.

Affrontare il problema dello scraping richiede un approccio multiforme. In qualità di creatore di contenuti o proprietario di un sito Web, puoi adottare diverse misure per proteggere i tuoi contenuti dallo scraping. L'implementazione di tecnologie come CAPTCHA, blocco IP o restrizioni di accesso ai contenuti può aiutare a dissuadere i bot automatizzati dall'accedere e fare scraping del tuo sito web.

Inoltre, il monitoraggio regolare del traffico del tuo sito Web e l'analisi del comportamento degli utenti possono aiutare a identificare attività sospette che potrebbero indicare lo scraping. Rimanendo vigile e proattivo, puoi intraprendere le azioni appropriate per mitigare l'impatto dello scraping sui tuoi contenuti e sulla tua attività.

È inoltre essenziale per gli sviluppatori e le organizzazioni di intelligenza artificiale che utilizzano LLM come ChatGPT dare la priorità alle considerazioni etiche . L'implementazione di linee guida e politiche rigorose che scoraggino l'uso improprio dello scraping può aiutare a prevenire la raccolta non autorizzata di contenuti. Lo sviluppo responsabile dell'IA mira a trovare un equilibrio tra innovazione e rispetto dei diritti di proprietà intellettuale.

In che modo ChatGPT esegue lo scraping dei tuoi contenuti?

Comprendere il processo di scraping utilizzato dai bot di ChatGPT è fondamentale per affrontare efficacemente questo problema. Questi robot utilizzano una tecnica nota come web crawling, in cui visitano pagine Web e seguono collegamenti per raccogliere informazioni. Queste informazioni vengono quindi utilizzate per addestrare il modello AI. Lo scraping dei contenuti può essere dannoso per gli editori e le aziende dei media per diversi motivi.

In primo luogo, può portare a una perdita di entrate se il contenuto di scraping viene ripubblicato senza autorizzazione. Ciò può compromettere la capacità degli editori originali di monetizzare i propri contenuti e comportare perdite finanziarie. Inoltre, può offuscare la reputazione degli editori, poiché il loro contenuto potrebbe essere travisato o estrapolato dal contesto quando ripubblicato dai bot di ChatGPT.

In secondo luogo, l'impatto sull'esperienza dell'utente è una preoccupazione significativa. Quando i bot di ChatGPT inondano un sito Web di richieste di scraping dei contenuti, possono sovraccaricare il server e rallentare la velocità di caricamento per gli utenti legittimi. Ciò può frustrare i visitatori e scoraggiarli dal tornare sul sito Web, portando a una diminuzione del traffico e alla potenziale perdita di coinvolgimento e entrate pubblicitarie.

Infine, il contenuto raschiato può anche influire sul posizionamento nei motori di ricerca di un sito Web. I motori di ricerca danno la priorità ai contenuti unici e originali , penalizzando i siti web con contenuti duplicati o raschiati. Se i robot di ChatGPT estraggono e ripubblicano i contenuti degli editori, possono avere un impatto negativo sugli sforzi di ottimizzazione dei motori di ricerca (SEO) dei creatori originali. Ciò può comportare una minore visibilità e una riduzione del traffico organico, danneggiando la presenza online degli editori.

Dati questi rischi, gli editori devono proteggere in modo proattivo i propri contenuti e il traffico web da ChatGPT e scraping LLM. L'implementazione di misure come CAPTCHA , il blocco degli IP e il rilevamento degli user agent può aiutare a identificare e bloccare i bot automatizzati che tentano di eseguire lo scraping dei contenuti. Inoltre, il monitoraggio regolare del traffico Web e l'analisi dei modelli possono aiutare a rilevare eventuali attività di scraping anomale e intraprendere le azioni appropriate.

Inoltre, gli editori possono esplorare vie legali per proteggere i propri contenuti. Le leggi sul copyright e i diritti di proprietà intellettuale possono essere applicati per impedire lo scraping e la ripubblicazione non autorizzati del loro lavoro. Chiedere consulenza legale e intraprendere le azioni legali necessarie contro le entità in violazione può inviare un messaggio forte e scoraggiare futuri tentativi di scraping.

Anche la collaborazione e la comunicazione tra editori, aziende dei media e sviluppatori di intelligenza artificiale sono fondamentali per affrontare questo problema. Stabilire partenariati e dialoghi aperti può portare allo sviluppo di pratiche e linee guida etiche per la formazione sull'IA, garantendo che i diritti dei creatori di contenuti siano rispettati mentre si fa progredire la tecnologia dell'IA.

Come anticipare ChatGPT e proteggere il traffico del tuo sito web?

Presentazione di Traffic Cop: il tuo scudo contro lo scraping non autorizzato

Traffic Cop di MonetizeMore è una soluzione all'avanguardia che funge da robusto scudo, salvaguardando efficacemente le tue risorse digitali da bot di scraping e accessi non autorizzati.

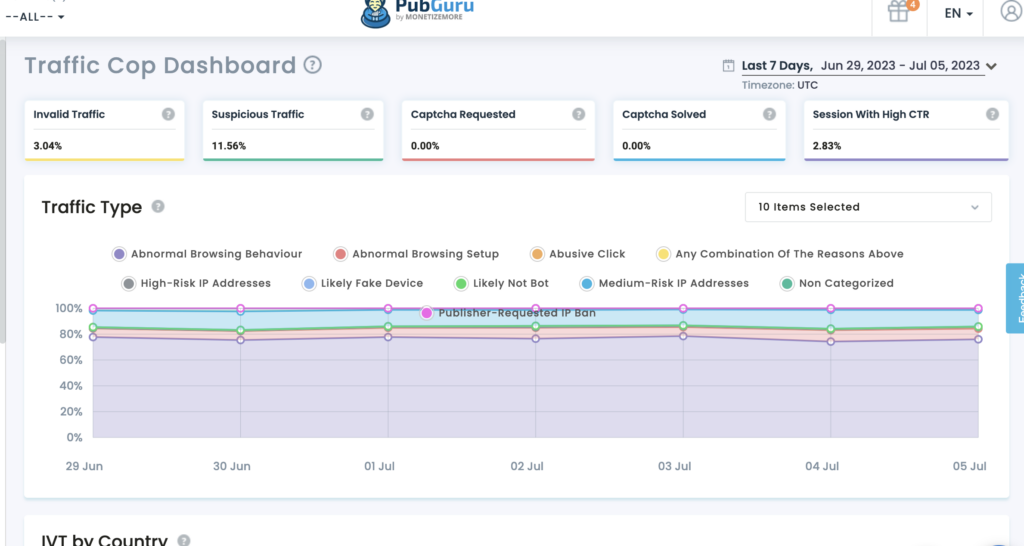

Protezione dei tuoi contenuti: con Traffic Cop, i tuoi preziosi contenuti rimangono al sicuro da scraping non autorizzati. I suoi avanzati algoritmi di apprendimento automatico gli consentono di identificare e distinguere tra traffico di utenti legittimi e bot dannosi. Traffic Cop blocca efficacemente i tentativi di scraping, assicurando che i tuoi contenuti rimangano esclusivi per il tuo sito web.

Protezione dei dati: i dati sono la linfa vitale delle attività online. Traffic Cop ti aiuta a mantenere l'integrità e la riservatezza dei tuoi dati. Il pluripremiato strumento utilizza algoritmi sofisticati per identificare e bloccare le attività di raccolta dei dati, garantendo la protezione dei tuoi dati.

Preservare il traffico web: il traffico web è essenziale per il successo di qualsiasi impresa online. Tuttavia, lo scraping non autorizzato può esaurire le tue risorse, influire sulle prestazioni del sito e minare i tuoi sforzi SEO. Traffic Cop è la tua sentinella vigile, che tiene a bada i bot dannosi e preserva il tuo traffico web. L'implementazione di meccanismi avanzati di rilevamento dei bot e misure proattive garantisce che gli utenti reali abbiano un accesso ininterrotto al tuo sito Web, migliorando l'esperienza dell'utente e massimizzando il tuo potenziale di conversione.

Perché scegliere il vigile urbano?

- Protezione completa: Traffic Cop offre uno scudo olistico contro i tentativi di scraping, salvaguardando contemporaneamente i tuoi contenuti, dati e traffico web.

- Rilevamento avanzato dei bot: distingue accuratamente tra utenti autentici e bot dannosi, impedendo l'accesso non autorizzato e le attività di scraping.

- Misure di sicurezza proattive: questa tecnologia utilizza algoritmi all'avanguardia per identificare e bloccare i tentativi di scraping in tempo reale, anticipando le potenziali minacce.

- Esperienza utente migliorata: preservando il traffico Web e tenendo a bada i bot dannosi, Traffic Cop garantisce un accesso ininterrotto per gli utenti reali, migliorando la loro esperienza e aumentando i tassi di conversione.

Oltre a quello:

Utilizza la limitazione della velocità: implementa misure di limitazione della velocità per limitare il numero di richieste per indirizzo IP o utente, impedendo ai bot di sovraccaricare il tuo sito Web con tentativi di scraping.

La limitazione della velocità è una tecnica efficace per prevenire gli attacchi di scraping limitando il numero di richieste che un utente o un indirizzo IP può effettuare entro un intervallo di tempo specifico. Impostando limiti ragionevoli, puoi garantire che gli utenti autentici possano accedere al tuo sito Web scoraggiando i bot dal tentare di eseguire lo scraping dei tuoi contenuti. L'implementazione della limitazione della velocità può aiutare a mantenere le prestazioni e la disponibilità del tuo sito web.

Proteggi i tuoi feed RSS: se fornisci feed RSS per il syndication, assicurati che siano protetti dallo scraping aggiungendo meccanismi di autenticazione o implementando chiavi API.

I feed RSS possono essere una preziosa fonte di syndication di contenuti, ma possono anche essere presi di mira dai bot di scraping. Per proteggere i tuoi feed RSS, è fondamentale implementare meccanismi di autenticazione o chiavi API. Richiedendo l'autenticazione, puoi assicurarti che solo gli utenti o le applicazioni autorizzati possano accedere e utilizzare i tuoi feed RSS. Inoltre, l'implementazione delle chiavi API può aiutarti a tracciare e controllare l'accesso ai tuoi feed, prevenendo tentativi di scraping non autorizzati.

Implementando queste strategie, puoi ridurre significativamente il rischio di scraping di ChatGPT e LLM, salvaguardando così i tuoi contenuti, dati e traffico web.

Fallo per tenere il passo con AI-Apocalypse.

Poiché ChatGPT e altri LLM continuano a progredire, gli editori devono considerare alcuni aspetti chiave per proteggere i loro contenuti e il traffico web:

- Rimani informato: tieniti aggiornato sugli ultimi progressi nell'intelligenza artificiale e nelle tecnologie di elaborazione del linguaggio naturale. Questo ti aiuterà a comprendere i potenziali rischi e le opportunità di questi strumenti.

- Rivedi i tuoi Termini di servizio: assicurati che i tuoi Termini di servizio vietino esplicitamente le attività di scraping e specifica le conseguenze per la violazione di questi termini.

- Esplora le opzioni legali: se sospetti una violazione dei tuoi diritti di proprietà intellettuale a causa dello scraping, consulta esperti legali per esplorare i rimedi legali disponibili.

- Impegnarsi con il settore: collaborare con le associazioni e le organizzazioni del settore per affrontare collettivamente le sfide poste dallo scraping e sostenere misure di protezione migliori.

Considerando in modo proattivo questi fattori, gli editori possono proteggere meglio i loro contenuti, dati e traffico web nell'era di ChatGPT e delle tecnologie LLM emergenti.

Oltre a queste considerazioni chiave, gli editori dovrebbero anche essere consapevoli del potenziale impatto di ChatGPT e LLM sul coinvolgimento del pubblico. Con l'aumento dei contenuti generati dall'intelligenza artificiale, esiste la possibilità che i lettori diventino più scettici sull'autenticità e l'affidabilità delle informazioni che consumano. Gli editori dovrebbero adottare misure per creare fiducia con il proprio pubblico etichettando chiaramente i contenuti generati dall'intelligenza artificiale e fornendo trasparenza sulla fonte delle informazioni.

Un'altra considerazione importante sono le potenziali implicazioni etiche dei contenuti generati dall'intelligenza artificiale. Man mano che gli LLM diventano più avanzati, è necessario garantire che il contenuto generato non perpetui pregiudizi o disinformazione. Gli editori dovrebbero stabilire linee guida e processi di revisione per garantire che i contenuti generati dall'intelligenza artificiale siano in linea con i loro standard e valori editoriali.

Inoltre, tieni presente l'evoluzione del panorama legale che circonda i contenuti generati dall'intelligenza artificiale. Man mano che queste tecnologie diventano più diffuse, potrebbero essere messe in atto nuove normative e quadri giuridici per disciplinarne l'uso. Rimanere al passo con questi sviluppi e consultare esperti legali può aiutare gli editori a destreggiarsi tra le complessità legali dei contenuti generati dall'intelligenza artificiale.

Conclusione

Salvaguardare i tuoi contenuti, dati e traffico web dallo scraping di ChatGPT è fondamentale per mantenere l'integrità della tua attività. Minaccia le loro entrate e l'esperienza utente e influisce sulla loro visibilità e reputazione online. Comprendendo il processo di scraping, implementando misure protettive, esplorando le opzioni legali e promuovendo la collaborazione, gli editori possono salvaguardare i propri contenuti e mitigare i rischi associati allo scraping guidato dall'intelligenza artificiale.

Traffic Cop di MonetizeMore offre una soluzione completa per proteggere i tuoi contenuti, dati e traffico web. Sfruttando il rilevamento avanzato dei bot e le misure di sicurezza proattive, Traffic Cop ti consente di concentrarti sulla tua attività principale salvaguardando efficacemente le tue risorse digitali.

Abbraccia Traffic Cop oggi e goditi la tranquillità sapendo che la tua presenza online è protetta da scraping non autorizzato.

Incontra Aleesha Jacob, un'esperta Content B2B e SEO Manager con oltre 7 anni di esperienza nella creazione di contenuti basati sui dati che alimentano le conversioni per le aziende SAAS. Avendo lavorato con aziende di tecnologia pubblicitaria e clienti come BMW e Heineken, Aleesha porta una vasta esperienza. Con le sue impareggiabili capacità nella creazione di contenuti accattivanti, aiuta le aziende di tutte le dimensioni a ottenere più lead, aumentare le entrate e far crescere la loro presenza online.