Cos'è il Crawl Budget e come ottimizzarlo

Pubblicato: 2022-11-25

Un crawl budget può sembrare un concetto estraneo quando impari per la prima volta come funzionano i robot dei motori di ricerca. Sebbene non siano il concetto SEO più semplice, sono meno complicati di quanto possa sembrare. Una volta che inizi a capire cos'è un crawl budget e come funziona il crawling dei motori di ricerca, puoi iniziare a ottimizzare il tuo sito web per ottimizzare la crawlability. Questo processo aiuterà il tuo sito a raggiungere il massimo potenziale per il posizionamento nei risultati di ricerca di Google.

Che cos'è un crawl budget?

Un crawl budget è il numero di URL di un sito Web che i bot dei motori di ricerca possono indicizzare in una sessione di indicizzazione. Il "budget" di una sessione di scansione varia da sito web a sito web in base alle dimensioni di ogni singolo sito, alle metriche sul traffico e alla velocità di caricamento della pagina.

Se sei arrivato fin qui e i termini SEO non ti sono familiari, utilizza il nostro glossario SEO per familiarizzare con le definizioni .

Quali fattori influenzano il crawl budget di un sito web?

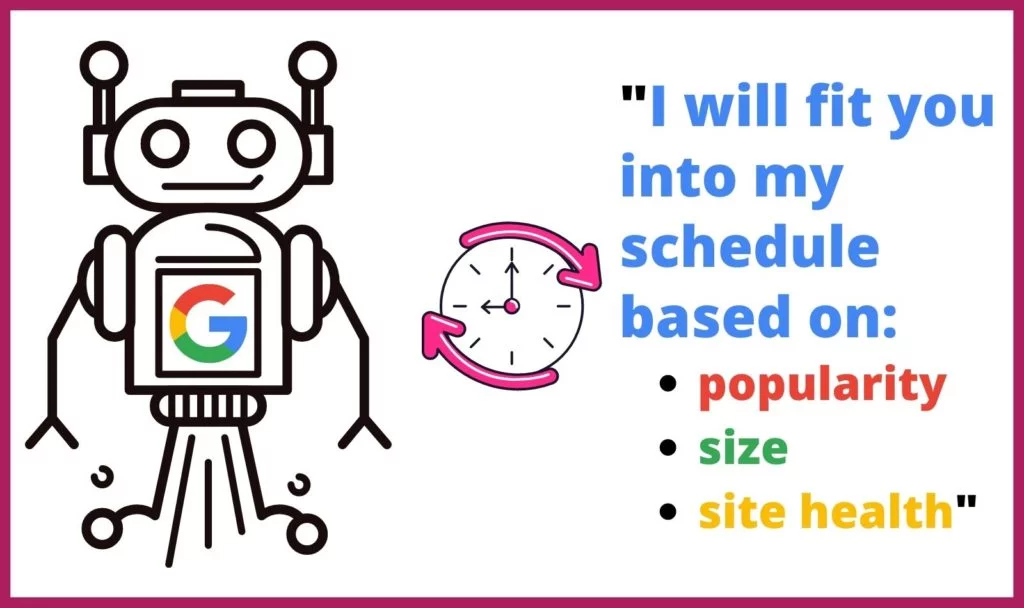

Google non dedica la stessa quantità di tempo o numero di scansioni a tutti i siti Web su Internet. I webcrawler determinano anche quali pagine scansionano e con quale frequenza in base a diversi fattori. Determinano la frequenza e la durata della scansione di ciascun sito in base a:

Google non dedica la stessa quantità di tempo o numero di scansioni a tutti i siti Web su Internet. I webcrawler determinano anche quali pagine scansionano e con quale frequenza in base a diversi fattori. Determinano la frequenza e la durata della scansione di ciascun sito in base a:

- Popolarità: più un sito o una pagina viene visitata, più spesso dovrebbe essere analizzata per gli aggiornamenti. Inoltre, le pagine più popolari accumuleranno più collegamenti in entrata più rapidamente.

- Dimensioni: i siti Web e le pagine di grandi dimensioni con elementi a più alta intensità di dati richiedono più tempo per la scansione.

- Salute/Problemi: quando un webcrawler raggiunge un vicolo cieco tramite collegamenti interni, ci vuole tempo prima che trovi un nuovo punto di partenza o abbandoni la scansione. Errori 404, reindirizzamenti e tempi di caricamento lenti rallentano e ostacolano i webcrawler.

In che modo il tuo crawl budget influisce sulla SEO?

Il processo di indicizzazione del webcrawler rende possibile la ricerca. Se i tuoi contenuti non possono essere trovati e quindi indicizzati dai webcrawler di Google, le tue pagine Web e il tuo sito Web non saranno rilevabili dagli utenti. Ciò porterebbe al tuo sito a perdere molto traffico di ricerca.

Perché Google esegue la scansione dei siti Web?

I Googlebot esaminano sistematicamente le pagine di un sito Web per determinare di cosa trattano la pagina e il sito Web in generale. I webcrawler elaborano, classificano e organizzano i dati da quel sito web pagina per pagina per creare una cache di URL insieme al loro contenuto, in modo che Google possa determinare quali risultati di ricerca dovrebbero apparire in risposta a una query di ricerca.

Inoltre, Google utilizza queste informazioni per determinare quali risultati di ricerca si adattano meglio alla query di ricerca al fine di determinare dove ciascun risultato di ricerca dovrebbe apparire nell'elenco gerarchico dei risultati di ricerca.

Cosa succede durante una scansione?

Google assegna un determinato periodo di tempo a un Googlebot per elaborare un sito web. A causa di questa limitazione, è probabile che il bot non esegua la scansione di un intero sito durante una sessione di scansione. Invece, funzionerà attraverso tutte le pagine del sito in base al file robots.txt e ad altri fattori (come la popolarità di una pagina).

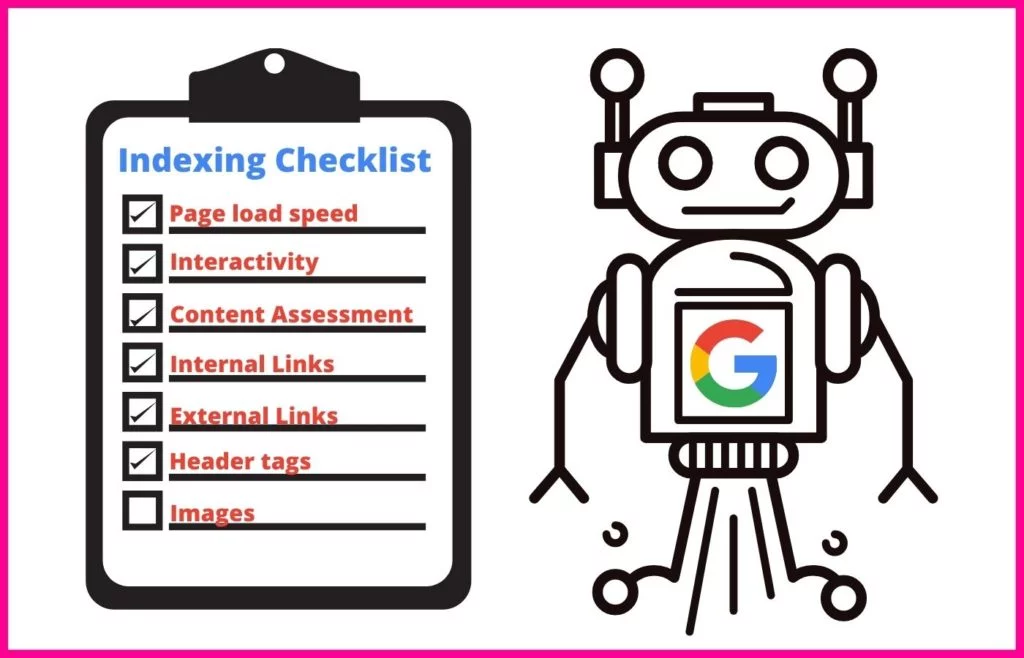

Durante la sessione di scansione, un Googlebot utilizzerà un approccio sistematico per comprendere il contenuto di ogni pagina che elabora.

Ciò include l'indicizzazione di attributi specifici, come:

- Meta tag e utilizzo della PNL per determinarne il significato

- Collegamenti e testo di ancoraggio

- File multimediali avanzati per ricerche di immagini e ricerche di video

- Marcatura dello schema

- Marcatura HTML

Il web crawler eseguirà anche un controllo per determinare se il contenuto della pagina è un duplicato di un canonico. In tal caso, Google sposterà l'URL a una scansione con priorità bassa, in modo da non perdere tempo a eseguire la scansione della pagina con la stessa frequenza.

Che cosa sono la velocità di scansione e la domanda di scansione?

I web crawler di Google assegnano un certo periodo di tempo a ogni scansione che eseguono. In qualità di proprietario di un sito Web, non hai alcun controllo su questo periodo di tempo. Tuttavia, puoi modificare la velocità con cui eseguono la scansione delle singole pagine del tuo sito mentre si trovano sul tuo sito. Questo numero si chiama velocità di scansione .

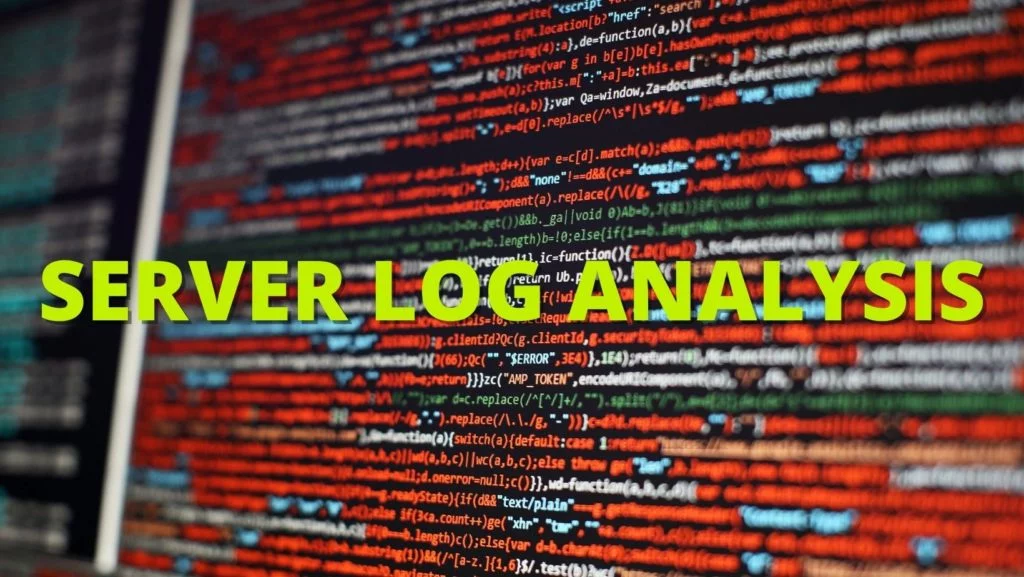

La domanda di scansione è la frequenza con cui Google esegue la scansione del tuo sito. Questa frequenza si basa sulla domanda del tuo sito da parte degli utenti di Internet e sulla frequenza con cui i contenuti del tuo sito devono essere aggiornati durante la ricerca. Puoi scoprire la frequenza con cui Google esegue la scansione del tuo sito utilizzando un'analisi del file di registro (vedi n. 2 di seguito).

Come posso determinare il Crawl Budget del mio sito?

Poiché Google limita il numero di volte in cui esegue la scansione del tuo sito e per quanto tempo, devi sapere qual è il tuo budget di scansione. Tuttavia, Google non fornisce ai proprietari dei siti questi dati, soprattutto se il tuo budget è così limitato che i nuovi contenuti non raggiungeranno le SERP in modo tempestivo. Questo può essere disastroso per contenuti importanti e nuove pagine come pagine di prodotti che potrebbero farti guadagnare denaro.

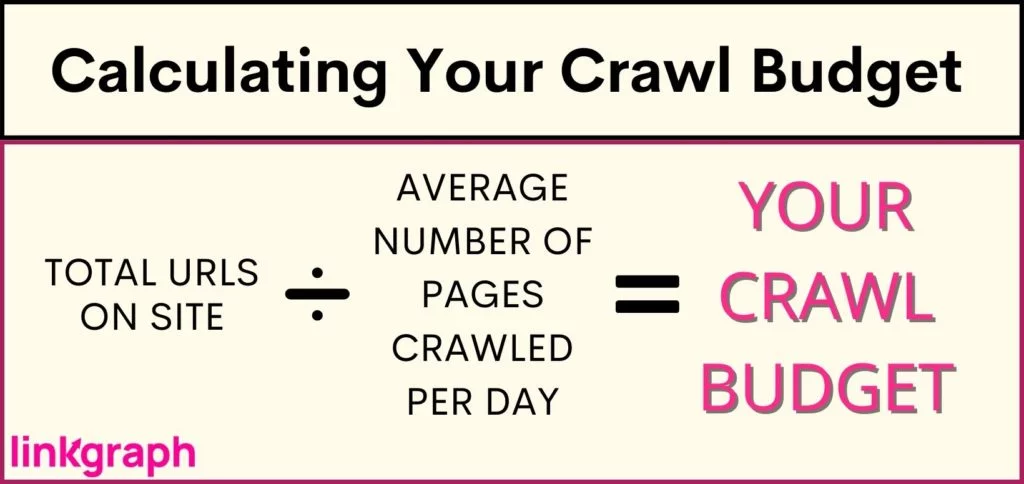

Per capire se il tuo sito sta affrontando limiti di crawl budget (o per confermare che il tuo sito è A-OK), ti consigliamo di: Ottieni un inventario di quanti URL ci sono sul tuo sito. Se utilizzi Yoast, il totale sarà elencato nella parte superiore dell'URL della tua sitemap .

Come puoi ottimizzare per il tuo crawl budget?

Quando arriva il momento in cui il tuo sito è diventato troppo grande per il suo crawl budget, dovrai tuffarti nell'ottimizzazione del crawl budget. Poiché non puoi dire a Google di eseguire la scansione del tuo sito più spesso o per un periodo di tempo più lungo, devi concentrarti su ciò che puoi controllare.

L'ottimizzazione del crawl budget richiede un approccio sfaccettato e una comprensione delle best practice di Google . Da dove dovresti iniziare quando si tratta di ottenere il massimo dalla tua velocità di scansione? Questo elenco completo è scritto in ordine gerarchico, quindi inizia dall'alto.

1. Prendi in considerazione l'aumento del limite di velocità di scansione del tuo sito

Google invia richieste contemporaneamente a più pagine del tuo sito. Tuttavia, Google cerca di essere cortese e di non impantanare il tuo server, con tempi di caricamento più lenti per i visitatori del tuo sito. Se noti che il tuo sito è in ritardo dal nulla, questo potrebbe essere il problema.

Per contrastare l'impatto sull'esperienza degli utenti, Google ti consente di ridurre la velocità di scansione. In questo modo limiterai il numero di pagine che Google può indicizzare contemporaneamente.

È interessante notare, tuttavia, che Google ti consente anche di aumentare il limite della velocità di scansione, con l'effetto che possono estrarre più pagine contemporaneamente, con conseguente scansione di più URL contemporaneamente. Tuttavia, tutti i rapporti suggeriscono che Google è lento nel rispondere a un aumento del limite della velocità di scansione e non garantisce che Google eseguirà la scansione di più siti contemporaneamente.

Come aumentare il limite della velocità di scansione:

- In Search Console, vai su "Impostazioni".

- Da lì, puoi vedere se la tua velocità di scansione è ottimale o meno.

- Quindi puoi aumentare il limite a una velocità di scansione più rapida per 90 giorni.

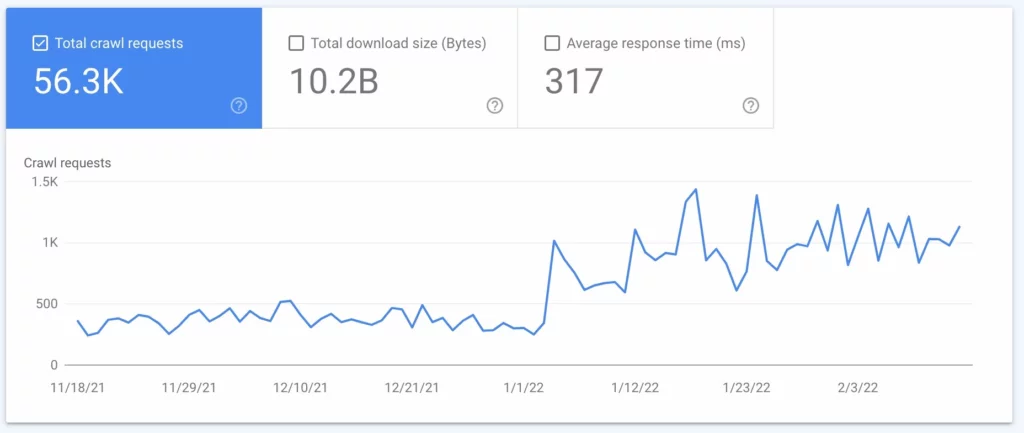

2. Eseguire un'analisi del file di registro

Un'analisi del file di registro è un report dal server che riflette ogni richiesta inviata al server. Questo rapporto ti dirà esattamente cosa fanno i Googlebot sul tuo sito. Sebbene questo processo venga spesso eseguito da SEO tecnici, puoi parlare con l'amministratore del tuo server per ottenerne uno.

Utilizzando l' analisi del file di registro o il file di registro del server, imparerai:

- Frequenza con cui Google esegue la scansione del tuo sito

- Quali pagine vengono scansionate di più

- Quali pagine hanno un codice server che non risponde o manca

Una volta che hai queste informazioni, puoi usarle per eseguire dal numero 3 al numero 7.

3. Mantieni aggiornati la tua Sitemap XML e Robots.txt

Se il tuo file di registro mostra che Google impiega troppo tempo a scansionare le pagine che non desideri vengano visualizzate nelle SERP, puoi richiedere che i crawler di Google saltino queste pagine. Ciò consente di liberare parte del budget di scansione per le pagine più importanti.

La tua mappa del sito (che puoi ottenere da Google Search Console o SearchAtlas ) fornisce a Googlebots un elenco di tutte le pagine del tuo sito che desideri che Google indicizzi in modo che possano apparire nei risultati di ricerca. Mantenere la tua mappa del sito aggiornata con tutte le pagine web che vuoi che i motori di ricerca trovino e omettere quelle che non vuoi che trovino può massimizzare il modo in cui i webcrawler trascorrono il loro tempo sul tuo sito.

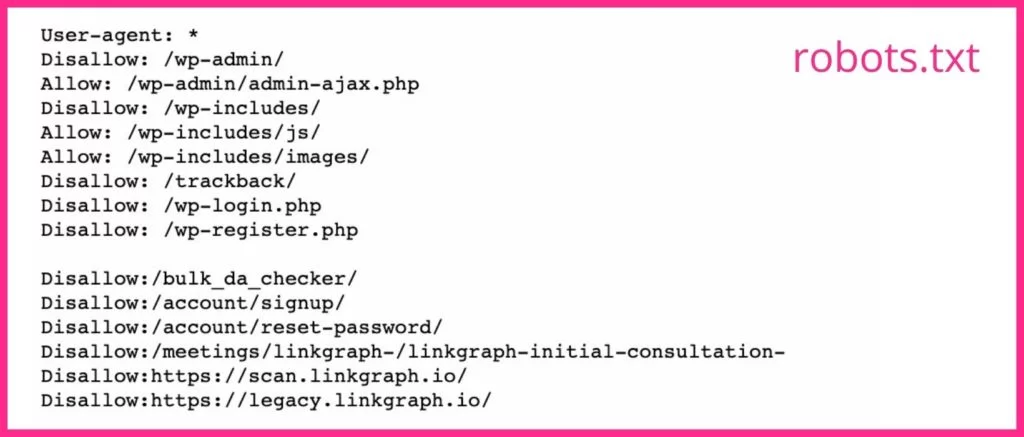

Il tuo file robots.txt indica ai crawler dei motori di ricerca quali pagine vuoi e quali non vuoi che eseguano la scansione. Se disponi di pagine che non costituiscono buone pagine di destinazione o pagine chiuse, dovresti utilizzare il tag noindex per i relativi URL nel file robots.txt. I Googlebot probabilmente salteranno qualsiasi pagina web con il tag noindex.

4. Ridurre i reindirizzamenti e le catene di reindirizzamento

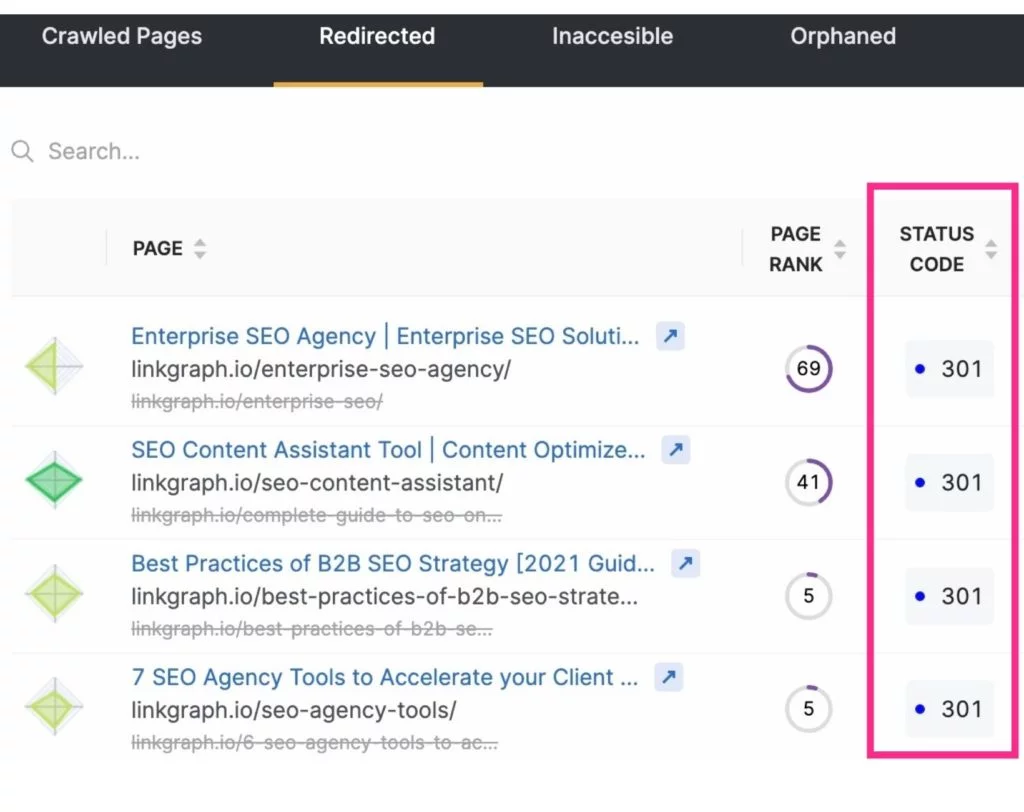

Oltre a liberare il crawl budget escludendo le pagine non necessarie dalle scansioni dei motori di ricerca, puoi anche massimizzare le scansioni riducendo o eliminando i reindirizzamenti. Questi saranno tutti gli URL che risultano in un codice di stato 3xx.

Gli URL reindirizzati richiedono più tempo per essere recuperati da Googlebot poiché il server deve rispondere con il reindirizzamento e quindi recuperare la nuova pagina. Sebbene un reindirizzamento richieda solo pochi millisecondi, possono sommarsi. E questo può rendere la scansione del tuo sito complessivamente più lunga. Questa quantità di tempo viene moltiplicata quando un Googlebot si imbatte in una catena di reindirizzamenti URL.

Per ridurre i reindirizzamenti e le catene di reindirizzamento, sii consapevole della tua strategia di creazione dei contenuti e seleziona attentamente il testo per i tuoi slug.

5. Correggi i collegamenti interrotti

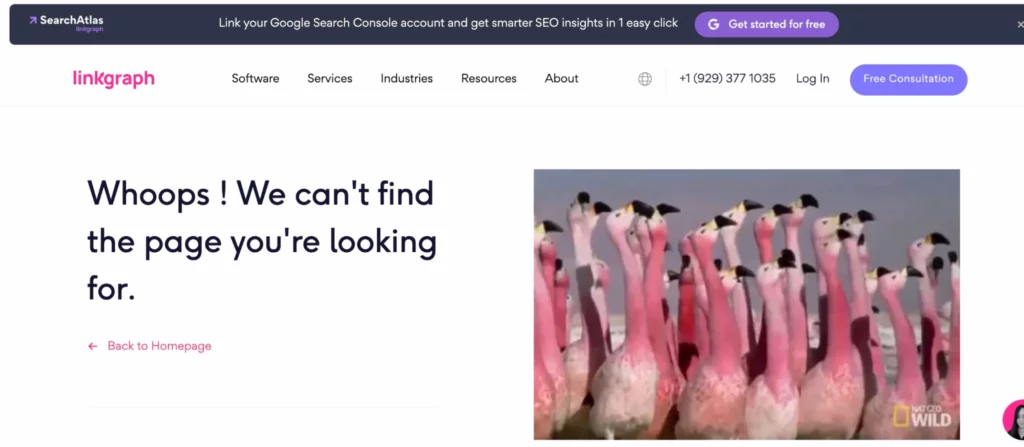

Il modo in cui Google esplora spesso un sito è navigando attraverso la tua struttura di link interna. Mentre si fa strada attraverso le tue pagine, noterà se un link porta a una pagina inesistente (questo è spesso indicato come un errore 404 soft). Quindi andrà avanti, non volendo perdere tempo a indicizzare detta pagina.

I collegamenti a queste pagine devono essere aggiornati per indirizzare l'utente o Googlebot a una pagina reale. O (anche se è difficile da credere) il Googlebot potrebbe aver identificato erroneamente una pagina come un errore 4xx o 404 quando la pagina esiste effettivamente. Quando ciò accade, verifica che l'URL non contenga errori di battitura, quindi invia una richiesta di scansione per tale URL tramite il tuo account Google Search Console.

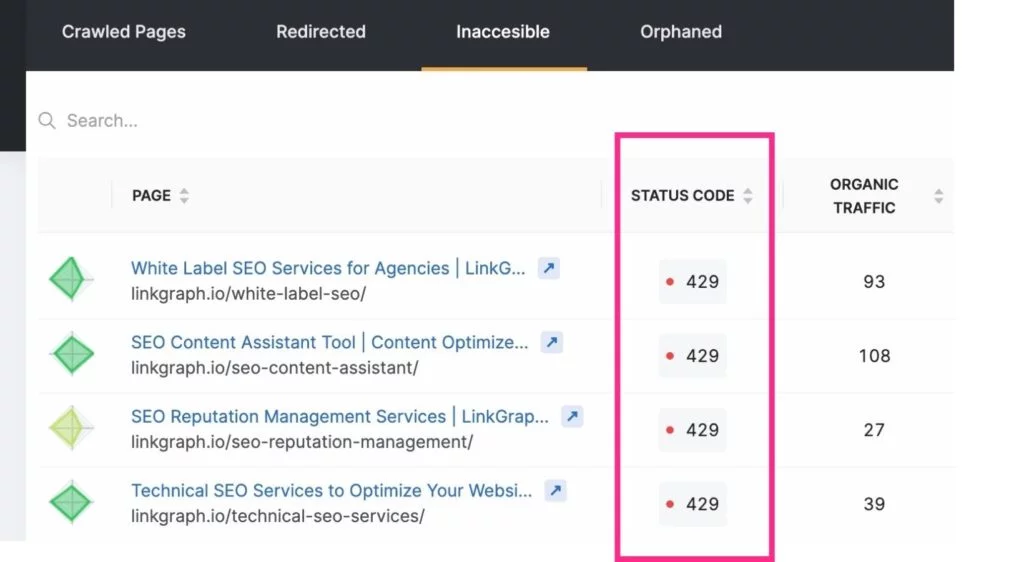

Per rimanere aggiornato su questi errori di scansione, puoi utilizzare il rapporto Indice > Copertura del tuo account Google Search Console. Oppure utilizza lo strumento Site Audit di SearchAtlas per trovare il rapporto sugli errori del tuo sito da trasmettere al tuo sviluppatore web.

Nota: i nuovi URL potrebbero non essere visualizzati immediatamente nell'analisi del file di registro. Concedi a Google un po' di tempo per trovarli prima di richiedere una scansione.

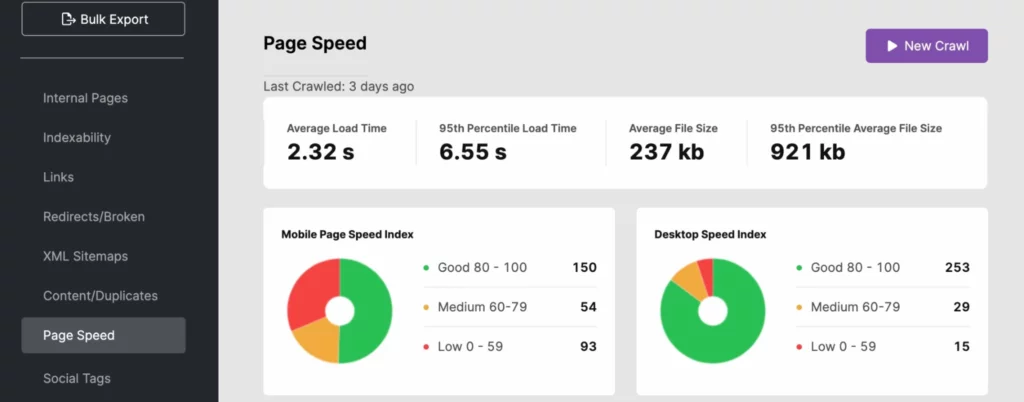

6. Lavorare per migliorare la velocità di caricamento della pagina

I robot dei motori di ricerca possono spostarsi in un sito a un ritmo rapido. Tuttavia, se la velocità del tuo sito non è all'altezza, può davvero incidere notevolmente sul tuo budget di scansione. Utilizza l'analisi del file di registro, SearchAtlas o PageSpeedInsights per determinare se il tempo di caricamento del tuo sito sta influenzando negativamente la tua visibilità nella ricerca.

Per migliorare i tempi di risposta del tuo sito, utilizza gli URL dinamici e segui le best practice Core Web Vitals di Google . Ciò può includere l'ottimizzazione delle immagini per i media above the fold.

Se il problema di velocità del sito è sul lato server, potresti voler investire in altre risorse del server come:

- Un server dedicato (soprattutto per siti di grandi dimensioni)

- Aggiornamento all'hardware del server più recente

- Aumento della RAM

Questi miglioramenti daranno anche una spinta alla tua esperienza utente, che può aiutare il tuo sito a funzionare meglio nella ricerca di Google poiché la velocità del sito è un segnale per il PageRank.

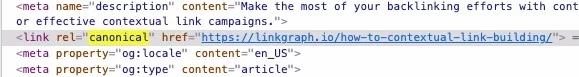

7. Non dimenticare di utilizzare i tag canonici

Il contenuto duplicato è disapprovato da Google, almeno quando non riconosci che il contenuto duplicato ha una pagina di origine. Come mai? Googlebot esegue la scansione di ogni pagina a meno che non sia inevitabile, a meno che non gli venga richiesto di fare diversamente. Tuttavia, quando incontra una pagina duplicata o una copia di qualcosa che conosce (sulla tua pagina o fuori dal sito), interromperà la scansione di quella pagina. E mentre questo fa risparmiare tempo, dovresti far risparmiare ancora più tempo al crawler utilizzando un tag canonico che identifica l'URL canonico.

I canonici dicono a Googlebot di non preoccuparsi di utilizzare il periodo di scansione per indicizzare quel contenuto. Questo dà al bot del motore di ricerca più tempo per esaminare le tue altre pagine.

8. Concentrati sulla tua struttura di collegamento interna

Avere una pratica di collegamento ben strutturata all'interno del tuo sito può aumentare l'efficienza di una scansione di Google. I link interni indicano a Google quali pagine del tuo sito sono le più importanti e questi link aiutano i crawler a trovare le pagine più facilmente.

Le migliori strutture di collegamento collegano utenti e Googlebot ai contenuti del tuo sito web. Usa sempre un testo di ancoraggio pertinente e posiziona i tuoi link in modo naturale in tutti i tuoi contenuti.

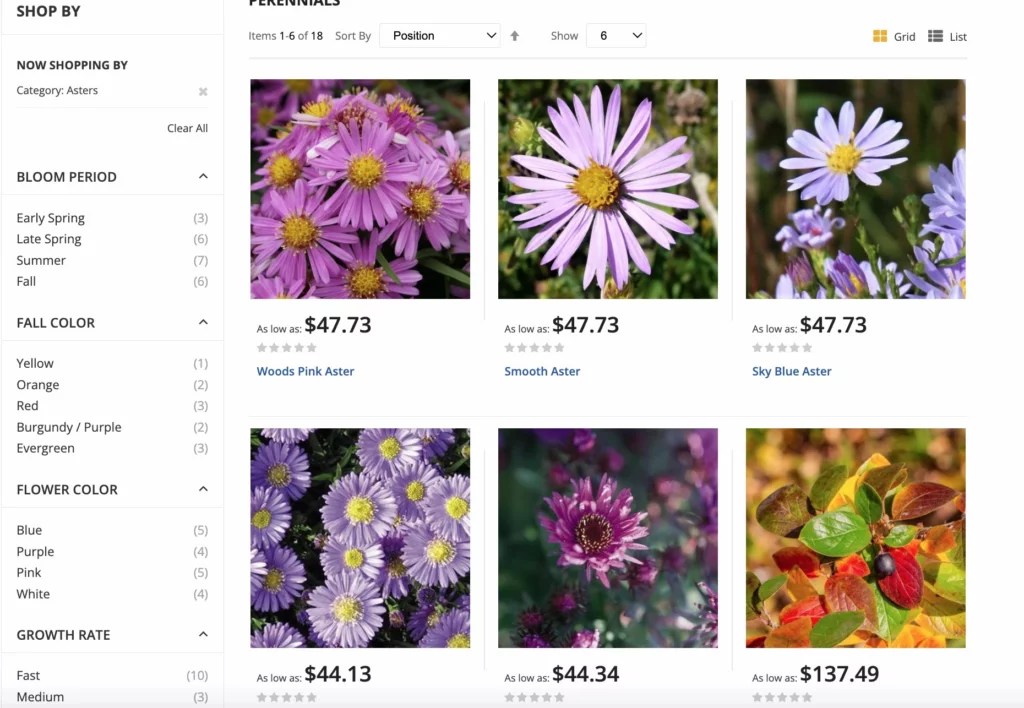

Per i siti di e-commerce, Google dispone di best practice per le opzioni di navigazione con facet per massimizzare le scansioni. La navigazione sfaccettata consente agli utenti del sito di filtrare i prodotti in base agli attributi, rendendo lo shopping un'esperienza migliore. Questo aggiornamento aiuta a evitare confusione canonica e problemi di duplicazione oltre a scansioni di URL in eccesso.

9. Elimina i contenuti non necessari

I Googlebot possono spostarsi così velocemente e indicizzare così tante pagine ogni volta che eseguono la scansione di un sito. Se hai un numero elevato di pagine che non ricevono traffico o hanno contenuti obsoleti o di bassa qualità, tagliale! Il processo di potatura ti consente di eliminare il bagaglio in eccesso del tuo sito che può appesantirlo.

Avere un numero eccessivo di pagine sul tuo sito può deviare i Googlebot su pagine non importanti ignorando le pagine.

Ricorda solo di reindirizzare tutti i link a queste pagine, in modo da non ritrovarti con errori di scansione.

10. Accumula più backlink

Proprio come i Googlebot arrivano sul tuo sito e iniziano a indicizzare le pagine in base a collegamenti interni, utilizzano anche collegamenti esterni nel processo di indicizzazione. Se altri siti si collegano al tuo, Googlebot raggiungerà il tuo sito e indicizzerà le pagine per comprendere meglio i contenuti collegati.

Inoltre, i backlink danno al tuo sito un po' più di popolarità e attualità, che Google utilizza per determinare la frequenza con cui il tuo sito deve essere indicizzato.

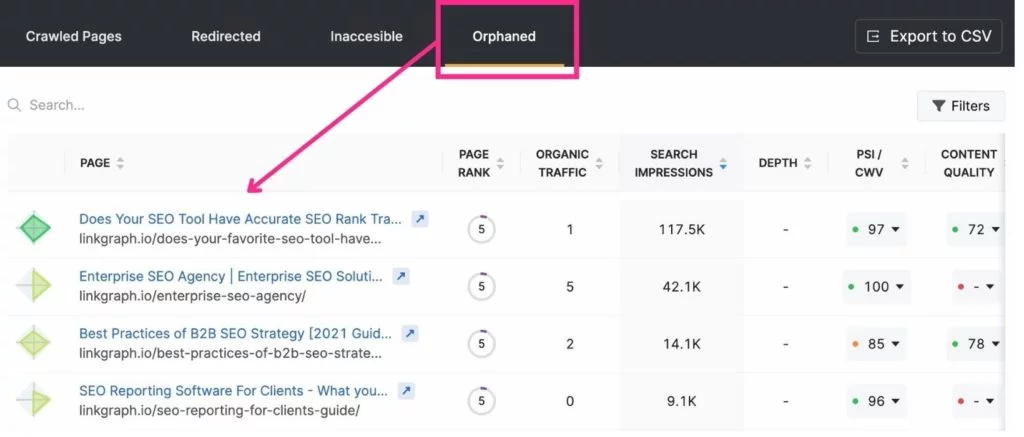

11. Elimina le pagine orfane

Poiché il crawler di Google passa da una pagina all'altra tramite collegamenti interni, può trovare facilmente le pagine a cui sono collegati. Tuttavia, le pagine che non sono collegate a un punto qualsiasi del tuo sito spesso passano inosservate a Google. Queste sono denominate "pagine orfane".

Quando è appropriata una pagina orfana? Se si tratta di una pagina di destinazione che ha uno scopo o un pubblico molto specifico. Ad esempio, se invii un'e-mail ai golfisti che vivono a Miami con una pagina di destinazione che si applica solo a loro, potresti non voler collegare alla pagina da un altro.

I migliori strumenti per l'ottimizzazione del crawl budget

Search Console e Google Analytics possono tornare molto utili quando si tratta di ottimizzare il budget di scansione. Search Console ti consente di richiedere a un crawler di indicizzare le pagine e tenere traccia delle tue statistiche di scansione. Google Analytics ti aiuta a monitorare il tuo percorso di collegamento interno.

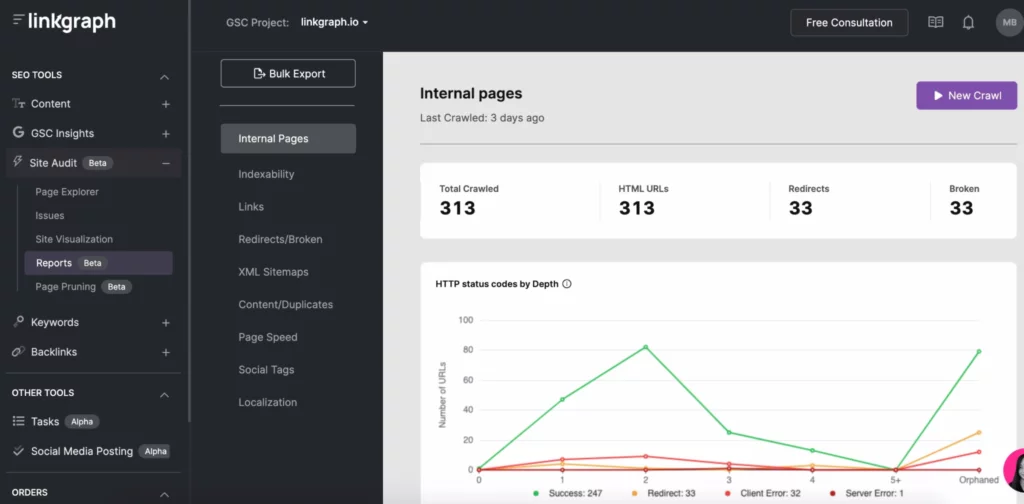

Altri strumenti SEO, come SearchAtlas, ti consentono di trovare facilmente i problemi di scansione tramite gli strumenti Site Audit. Con un rapporto, puoi vedere:

- Rapporto di scansione dell'indicizzabilità

- Profondità indice

- Velocità della pagina

- Contenuto duplicato

- Mappa del sito XML

- Collegamenti

Ottimizza il tuo crawl budget e diventa un motore di ricerca con le migliori prestazioni

Anche se non puoi controllare la frequenza con cui i motori di ricerca indicizzano il tuo sito o per quanto tempo, puoi ottimizzare il tuo sito per ottenere il massimo da ogni scansione del tuo motore di ricerca. Inizia con i log del tuo server e dai un'occhiata più da vicino al tuo rapporto di scansione su Search Console. Quindi tuffati nella correzione di eventuali errori di scansione, struttura dei link e problemi di velocità della pagina.

Mentre svolgi la tua attività di scansione GSC, concentrati sul resto della tua strategia SEO, inclusa la creazione di link e l'aggiunta di contenuti di qualità . Nel corso del tempo, le tue pagine di destinazione scalano le pagine dei risultati dei motori di ricerca.