Cos'è il Crawl Budget e come ottimizzarlo per la SEO?

Pubblicato: 2023-06-14In FATJOE, ci occupiamo di creare contenuti di qualità per le pagine Web e di garantire collegamenti potenti a tali pagine.

Ma come fanno i motori di ricerca come Google a trovare quelle pagine? La risposta è strisciare.

I crawler di Google accedono ai siti Web, seguono i collegamenti e analizzano il contenuto di ogni pagina per aggiungere l'URL al suo indice.

Il crawl budget è la risorsa che i motori di ricerca allocano per scansionare le pagine web entro un periodo di tempo specifico. Determina quante pagine del tuo sito eseguiranno la scansione dei bot e con quale frequenza torneranno.

La gestione del crawl budget è molto importante per i proprietari di siti Web e i team SEO,in particolare quelli con siti di grandi dimensioni .

Ottimizzando il crawl budget, puoi assicurarti che i motori di ricerca indicizzino le pagine importanti del tuo sito. Ciò può migliorare la tua visibilità nei risultati di ricerca e garantire che i motori di ricerca vedano i tuoi contenuti .

In questa guida tratteremo:

- Cos'è il crawl budget

- Come funziona

- Perché è importante per la SEO

- Come aumentare il crawl budget

Che cos'è il crawl budget?

Il crawl budget è la risorsa che i motori di ricerca danno a un sito web per la scansione e l'indicizzazione delle sue pagine web.

È un grosso problema nell'ottimizzazione per i motori di ricerca (SEO) in quanto determina l'efficacia con cui Google e altri motori di ricerca possono trovare e includere le tue pagine nei risultati di ricerca.

Perché i motori di ricerca assegnano i crawl budget?

Google ha il proprio crawler chiamato GoogleBot, che esplora e indicizza le pagine web.

Ma Internet è enorme.

Non c'è modo per Google di scansionare e indicizzareognipagina suognisito web.

Quindi, per assicurarsi che raggiunga le pagine più pertinenti per gli utenti della ricerca, Google assegna budget di scansione ai siti web.

Questo è lo stesso anche per i motori di ricerca non Google, ma ci concentreremo su Google dato, beh,è Google.

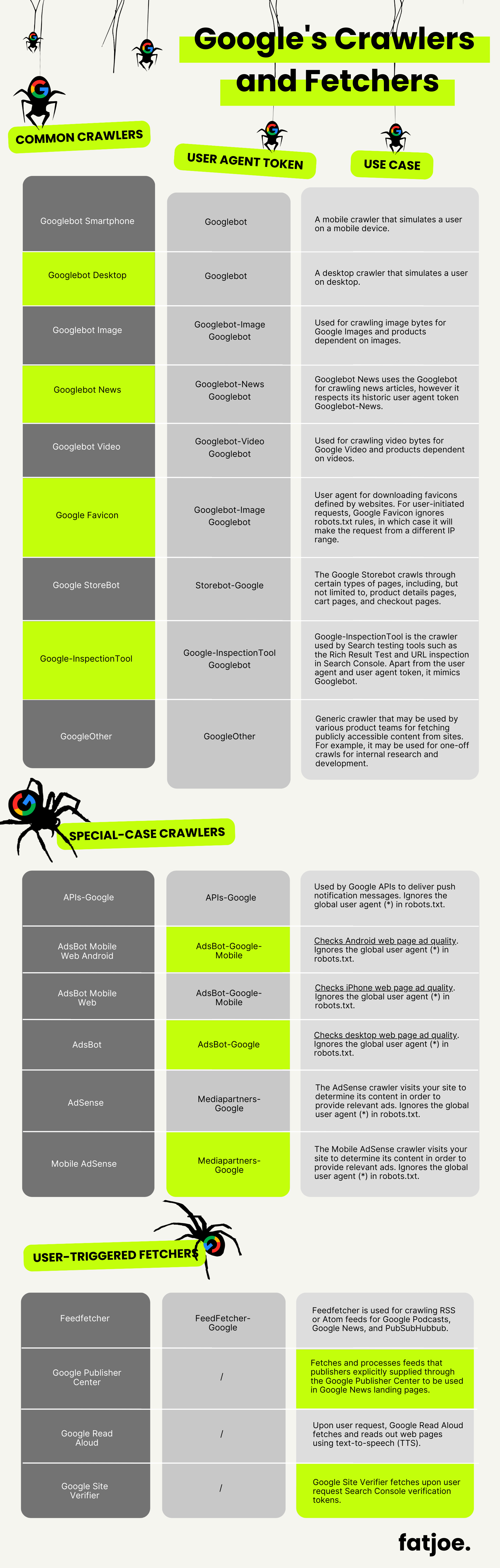

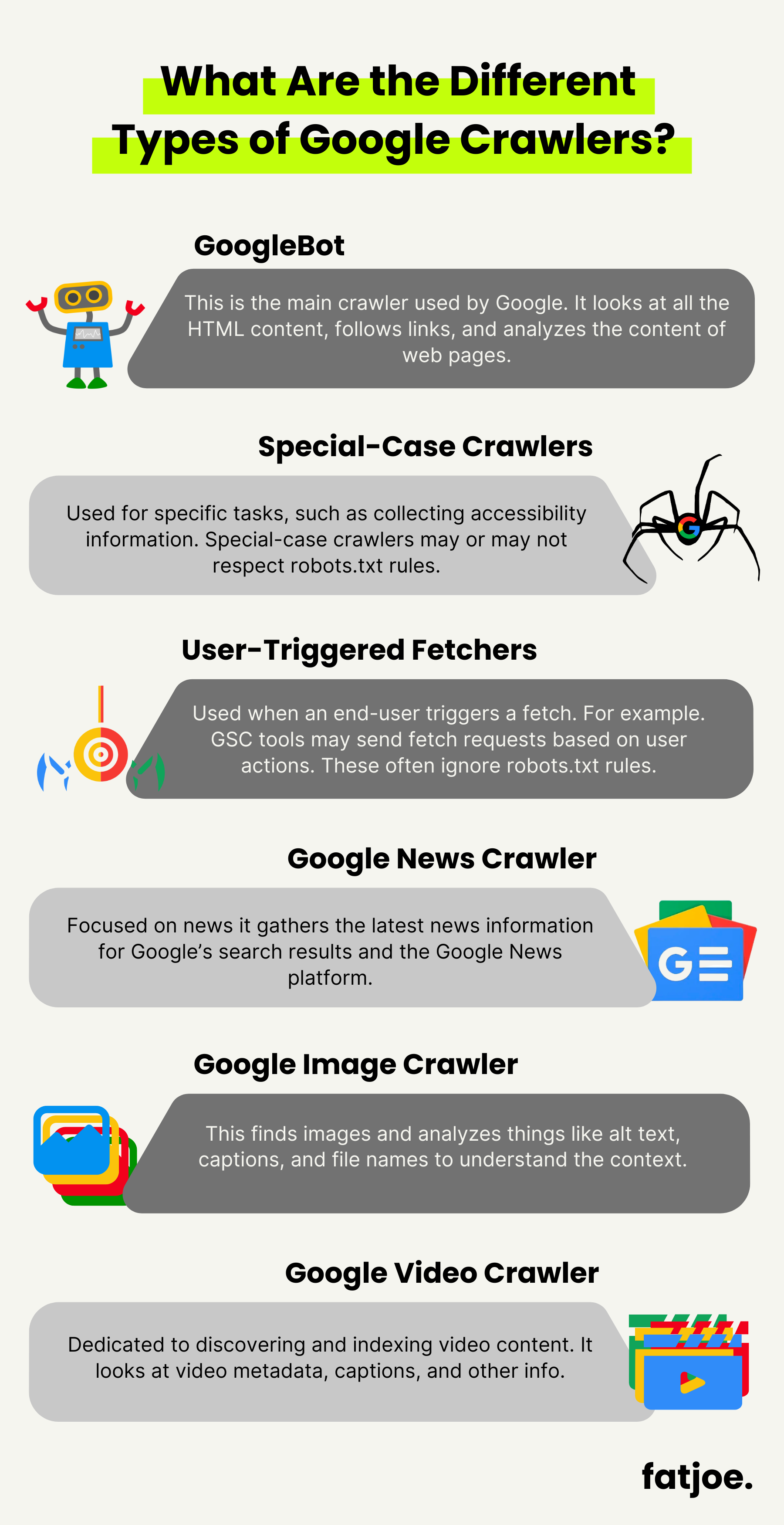

Quali sono i diversi tipi di crawler di Google?

I motori di ricerca hanno diversi tipi di crawler per raccogliere informazioni sulle pagine web. Abbiamo riassunto qui i principali tipi di crawler e fetcher:

Googlebot

Questo è il crawler principale utilizzato da Google per scoprire e indicizzare le pagine web. Guarda tutto il contenuto HTML, segue i link e analizza il contenuto delle pagine web.

Crawler per casi speciali

Questi crawler vengono utilizzati per attività specifiche, come la raccolta di informazioni sull'accessibilità. I crawler di casi speciali possono rispettare o meno le regole di robots.txt.

Fetcher attivati dall'utente

Questo tipo di crawler viene utilizzato quando un utente finale attiva un recupero. Ad esempio, alcuni strumenti di Google Search Console invieranno richieste di recupero in base alle azioni dell'utente. I fetcher attivati dall'utente generalmente ignorano le regole di robots.txt.

Crawler di Google News

Questo è incentrato sulla scansione dei contenuti relativi alle notizie. Raccoglie le informazioni sulle notizie più recenti e garantisce che appaiano nei risultati di ricerca di Google e nella piattaforma Google News.

Crawler di immagini di Google

Come suggerisce il nome, questo crawler è interamente dedicato alle immagini. Esamina il Web per trovare immagini e analizza cose come testo alternativo, didascalie e nomi di file per comprendere il contesto.

Crawler di Google Video

Simile al crawler di immagini, questo è dedicato alla scoperta e all'indicizzazione dei contenuti video. Esamina metadati video, didascalie e altre informazioni.

Per un riepilogo più completo di ogni crawler e fetcher di Google (inclusi il token dell'agente utente e il caso d'uso), vai alla fine della nostra utile tabella!

Scansione mobile-first

Poiché sempre più persone utilizzano dispositivi mobili per navigare in Internet, Google è passato all'indicizzazione mobile-first.

Google utilizza un agente per smartphone per eseguire la scansione e l'indicizzazione della versione mobile dei siti Web, prima della versione desktop. Garantire che il tuo sito web sia mobile-responsive è essenziale per la crawlability del tuo sito e per ottimizzare il tuo crawl budget.

Il motore di ricerca ha recentemente completato l'ultimo passaggio collettivo all'indicizzazione mobile-first nel maggio 2023:

Google esegue un altro lotto di indicizzazione in blocco per dispositivi mobili il 22 maggio 2023, finalizzando una transizione alla scansione della ricerca come se fosse un browser mobile, 6 anni di lavoro! https://t.co/9CxsrRFkcE

— Michael Stricker (@RadioMS) 22 maggio 2023

In che modo Google assegna il crawl budget?

Il crawl budget si basa su due fattori: il limite della capacità di scansione e la domanda di scansione.

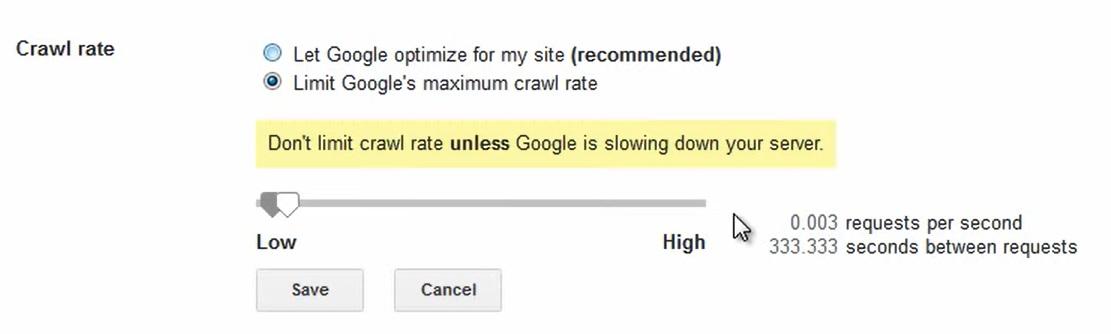

Limite di capacità di scansione

I motori di ricerca monitorano le prestazioni del server di un sito Web e la rapidità con cui risponde. Regolano il limite della capacità di scansione in base alle prestazioni del server.

Il limite è inoltre influenzato dalle risorse di scansione disponibili in qualsiasi momento e dalle preferenze del proprietario del sito web.

Puoi modificare manualmente il limite della velocità di scansione dalla pagina Impostazioni velocità di scansione in Google Search Console.

Se riscontri problemi di disponibilità, puoi ridurre la frequenza di scansione.

Ma aumentarlo manualmente non farà sì che Google venga a scansionare il tuo sito web più velocemente.Inoltre, non puoi influenzare qualipagine verranno sottoposte a scansione da Google.

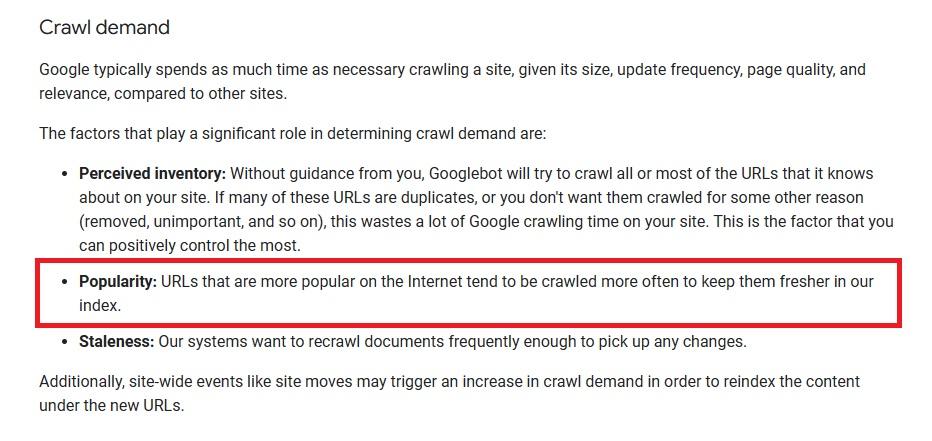

Domanda di scansione

La domanda di scansione aiuta i motori di ricerca a decidere quali pagine scansionare più spesso.

Considera cose come le dimensioni del sito, la frequenza con cui una pagina viene aggiornata e il valore percepito della pagina.

Anche i problemi tecnici SEO possono influire sulla domanda di scansione.

Il Crawl Budget include solo pagine Web?

No, il crawl budgetnon riguarda solo le pagine .

Stiamo davvero parlando di qualsiasi documento scansionato dai motori di ricerca e di tutti i vari elementi che esistono in una pagina. Ciò include cose come file JavaScript e CSS, varianti di pagine mobili, dati strutturati e file PDF.

Come funziona il limite di scansione?

Il limite di scansione riguarda il mantenimento di un equilibrio tra la scansione e le risorse del server.

Durante la scansione di un sito Web, i motori di ricerca monitorano la risposta del server. Se il server risponde rapidamente, la velocità di ricerca per indicizzazione potrebbe aumentare.

Se il server mostra segni di tensione, il motore di ricerca può ridurre la velocità di scansione per alleggerire il carico del server.

I proprietari di siti web possono anche implementare ritardi di scansione nel file robots.txt del sito. Questo indica ai crawler di mettere in pausa per una certa durata tra richieste consecutive al sito web.

Come funziona la domanda di scansione?

La domanda di scansione è una misura dell'importanza di una pagina per GoogleBot.

I motori di ricerca prestano attenzione alla struttura dei collegamenti interni, ai collegamenti esterni e ai segnali di coinvolgimento degli utenti per determinare quali pagine hanno una maggiore richiesta di scansione.

Ecco come viene descritto su Google Search Central:

I backlink sono un segnale che una pagina web è affidabile, popolare e vale la pena scansionarla.

Ai siti web con molti backlink di alta qualità provenienti da fonti autorevoli viene assegnato un crawl budget maggiore .

Google vuole anche fornire agli utenti risultati di ricerca aggiornati, quindi dà la priorità alla scansione e all'indicizzazione di nuovi contenuti.

Perché il Crawl Budget è importante per la SEO?

Il crawl budget influisce direttamente sul modo in cui i motori di ricerca scoprono e indicizzano le pagine del tuo sito web.

Ma vale la pena notare che il crawl budget da solo non è un fattore di ranking.

È anche qualcosa che in genere non influisce sui siti più piccoli.

In un recente video , Daniel Waisberg, sostenitore della ricerca di Google, ha rivelato:

“È più rilevante se lavori con un sito web di grandi dimensioni.Se hai un sito con meno di qualche migliaio di pagine, non devi preoccupartene.”

Devi davvero preoccuparti del crawl budget solo se hai un sito Web di grandi dimensioni o un negozio di e-commerce con un numero elevato di pagine.

Il crawl budget può influenzare o essere influenzato da quanto segue:

Visibilità nei risultati di ricerca

Quando il crawl budget è limitato, Google potrebbe impiegare più tempo a scansionare e classificare nuove pagine e contenuti. Se Google non trova una pagina a causa di problemi di crawl budget, non verrà visualizzata nei risultati di ricerca .

Struttura del sito

Se stai sprecando il crawl budget avendo una serie di pagine duplicate o di scarso valore, Google farà fatica a capire quali pagine sono importanti. GoogleBot impiegherà del tempo a scansionare parti del tuo sito che non ti aiuteranno a posizionarti per le tue parole chiave target.

Una buona struttura del sito aiuta i motori di ricerca a determinare le relazioni tra le tue pagine, che possono, a loro volta, costruire il tuo SEO semantico.

Autorità topica

Dare la priorità alla scansione di pagine importanti e concentrarsi su contenuti di alta qualità può aumentare la tua autorità di attualità.

Aumenta le tue possibilità di posizionarti più in alto per i termini di ricerca pertinenti.

Parole chiave Cannibalizzazione

La cannibalizzazione delle parole chiave si verifica quando due pagine di un sito Web competono per le stesse parole chiave nei risultati di ricerca.

L'ottimizzazione del crawl budget ti aiuta a evitarlo.

Organizzare la struttura del tuo sito ed evitare contenuti duplicati rende più facile per Google eseguire la scansione del tuo sito e comprenderne i contenuti, garantendo al contempo che le tue pagine siano uniche ed evitino di competere tra loro nei risultati di ricerca.

Come ottimizzare il crawl budget per la SEO?

Quindi, come puoi ottimizzare il crawl budget per ottenere migliori risultati SEO?

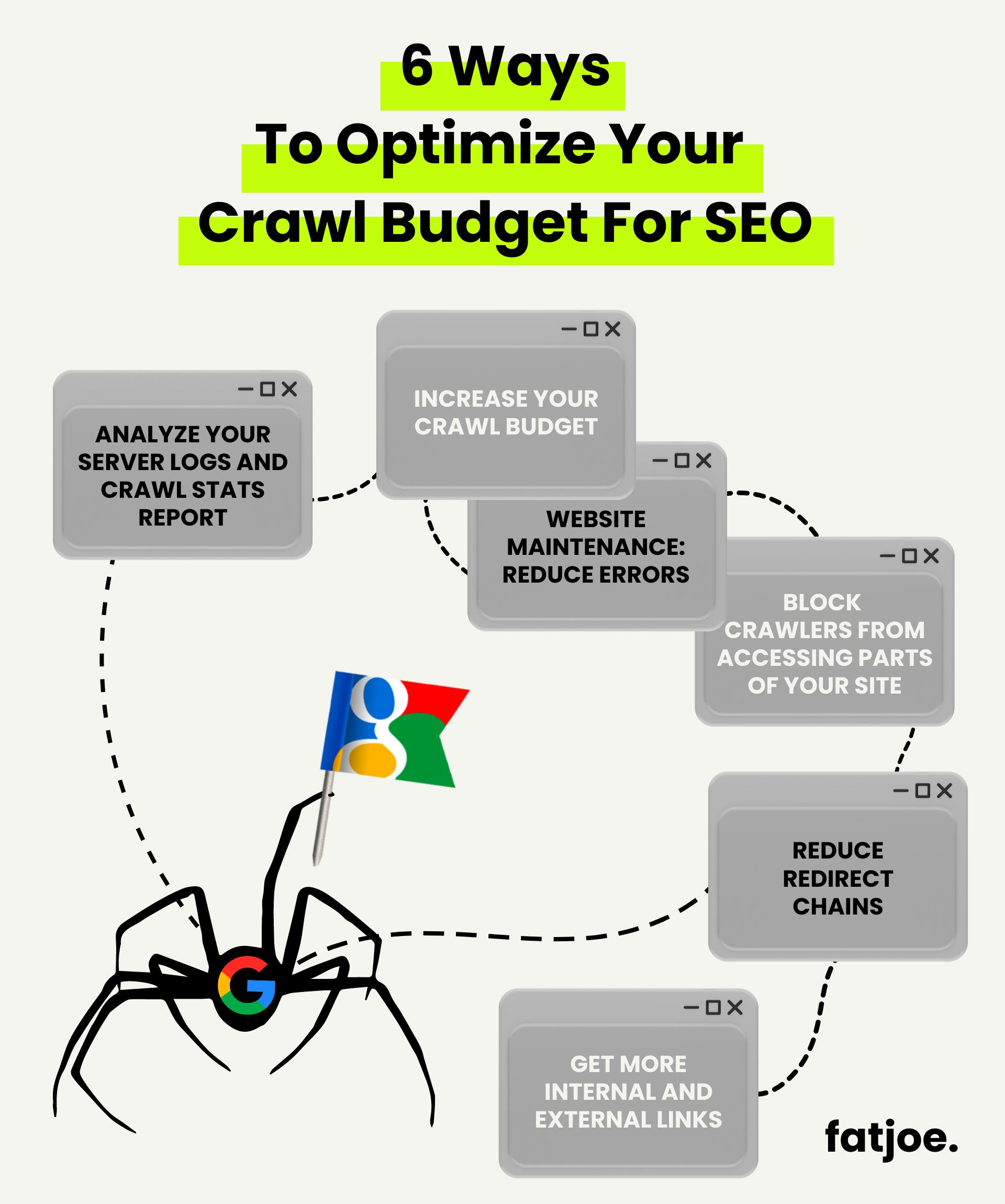

Ecco sei strategie che puoi implementare:

Strategia 1: dai un'occhiata ai registri del tuo server e al rapporto sulle statistiche di scansione

Inizia analizzando i file di log del tuo server.

Questi registri contengono informazioni preziose su come i crawler dei motori di ricerca interagiscono con il tuo sito web. Puoi sapere quali pagine vengono sottoposte a scansione, con quale frequenza vi si accede e se si verificano errori di scansione.

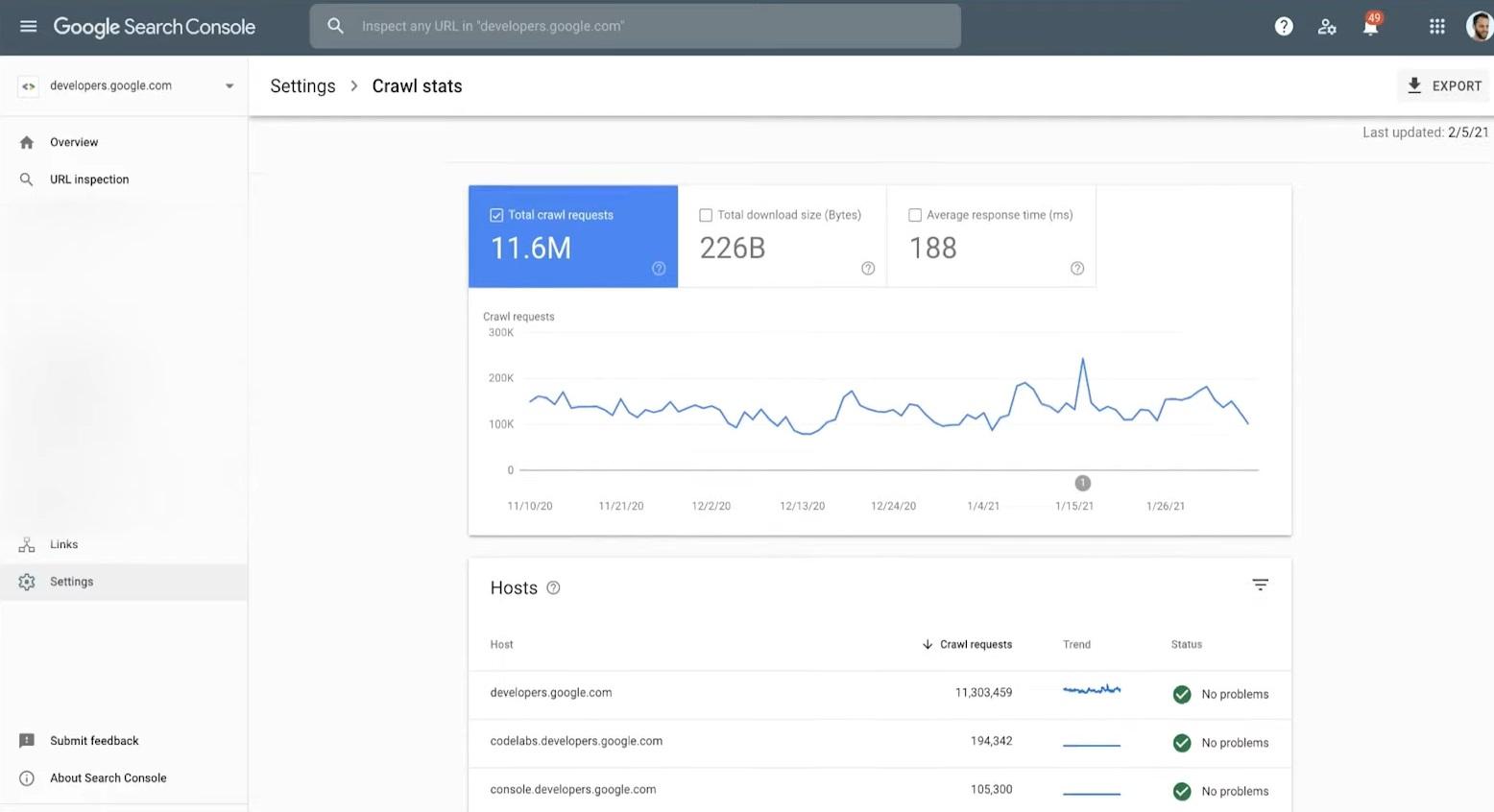

Anche il rapporto sulle statistiche di scansione in Google Search Console può fornire informazioni utili.

Puoi visualizzare il grafico delle tendenze di scansione, i dettagli sullo stato dell'host e un'analisi dettagliata delle richieste di scansione.

Strategia 2: Aumenta il tuo Crawl Budget

Anche se non puoi avere il controllo diretto sul crawl budget assegnato dai motori di ricerca, puoi comunque influenzarlo.

La chiave è migliorare la qualità complessiva e la pertinenza del tuo sito web.

Ecco una ripartizione di Peter Nikolow, CEO di Mobilo:

"Crawl budget" e il tuo sito:

– Crawl budget: crawl demand vs capacità vs necessità

Aumenta la domanda: crea un sito fantastico

Aumenta la capacità: crea un sito veloce

Riduci la necessità: meno URL sono migliori#WMCZRH— Peter Nikolow (@PeterNikolow) 11 dicembre 2019

Ecco come mettere in pratica questo consiglio:

Pubblica regolarmente contenuti freschi e di alta qualità

Mantenere il tuo sito web aggiornato con nuovi contenuti mostra ai motori di ricerca che il tuo sito è attivo.

Segnala ai motori di ricerca che i tuoi contenuti offrono informazioni preziose, aumentando potenzialmente il crawl budget del tuo sito web.

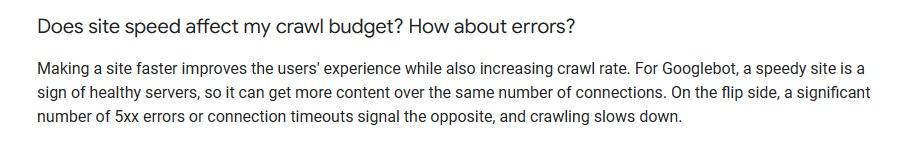

Migliora il tempo di caricamento della pagina

Le pagine a caricamento lento possono ostacolare il processo di scansione e indicizzazione.

Ecco come lo descrive Google:

Se le tue pagine si caricano rapidamente, Google può esplorare più parti del tuo sito e indicizzare più pagine.

Lavora sulla compressione delle immagini e sull'utilizzo di tecniche di memorizzazione nella cache per migliorare la velocità del sito.

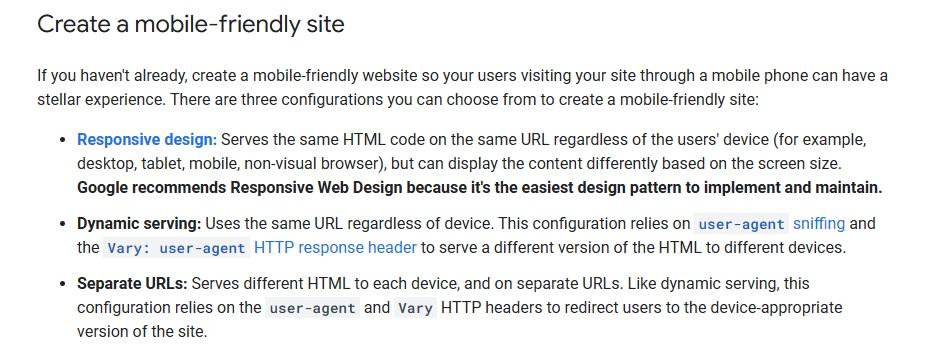

Garantire la compatibilità con i dispositivi mobili

Google utilizza la versione mobile del tuo sito per l'indicizzazione e il posizionamento.

Quindi avere un sito web ottimizzato per i dispositivi mobili è fondamentale.

Ecco alcuni suggerimenti dal blog di Google Search Central:

Strategia 3: Manutenzione del sito Web: ridurre gli errori

Collegamenti interrotti, pagine 404 ed errori del server possono rallentare i crawler dei motori di ricerca e consumare il tuo crawl budget.

Ciò potrebbe includere collegamenti interrotti che non portano a nulla, pagine che non possono essere trovate o problemi del server che causano interruzioni.

Condurre audit di routine del sito Web per identificare eventuali pagine che non vengono scansionate correttamente o che causano errori.

Strategia 4: Impedisci ai crawler di accedere a parti del tuo sito

A volte, potresti avere parti del tuo sito Web che non sono realmente rilevanti per la scansione o l'indicizzazione dei motori di ricerca.

Pensa alle pagine di amministrazione e ai contenuti duplicati.

Puoi utilizzare il file "robots.txt" per dire ai crawler dei motori di ricerca di evitare queste sezioni.

In questo modo, GoogleBot può concentrarsi sull'esplorazione e sull'indicizzazione delle pagine importanti del tuo sito web.

Strategia 5: ridurre le catene di reindirizzamento

Le catene di reindirizzamento possono esaurire il tuo crawl budget.

GoogleBot deve navigare su più reindirizzamenti consecutivi prima di arrivare finalmente all'URL di destinazione.

Tutti quei reindirizzamenti non necessari occupano il crawl budget senza dare alcun valore aggiunto.

Consiglio tecnico SEO: ogni reindirizzamento che aggiungi rallenta il tuo sito web.

L'aggiunta di troppi reindirizzamenti può avere un impatto negativo sul Time To First Byte del tuo sito: pic.twitter.com/hzW8ehgRMg

— Chris Long (@gofishchris) 1 giugno 2023

Ridurre al minimo le catene di reindirizzamento può aiutare i motori di ricerca a raggiungere le pagine di destinazione più velocemente. Rende il viaggio dal punto A al punto B più facile sia per i crawler che per gli utenti.

Strategia 6: ottenere più collegamenti interni ed esterni

Ottenere più backlink da siti Web affidabili può aumentare la visibilità e l'autorità del tuo sito.

Poiché i motori di ricerca ti riconoscono come fonte autorevole, è più probabile che allochino una parte maggiore del crawl budget sul tuo sito web.

Anche il collegamento interno è importante.

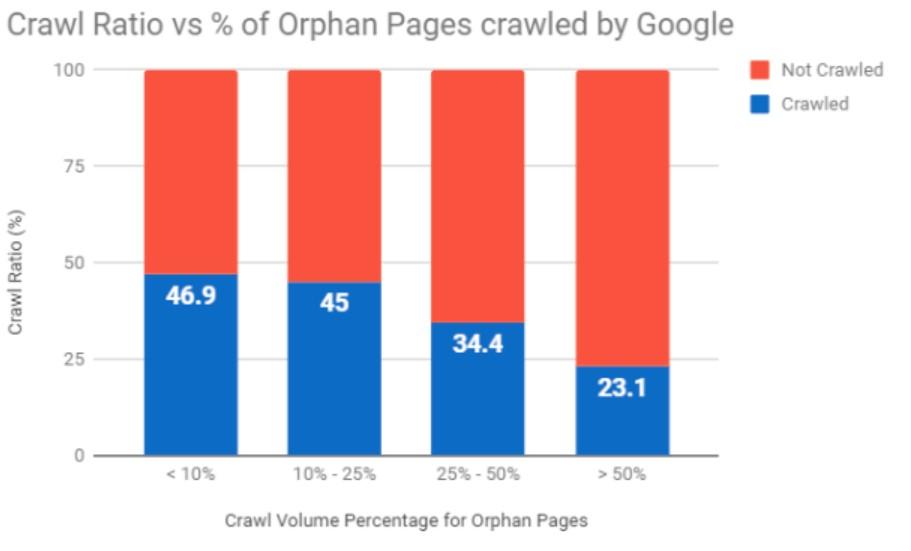

Uno dei maggiori sprechi del crawl budget sono le pagine orfane.

Si tratta di pagine Web che non hanno collegamenti interni o collegamenti esterni che puntano ad esse.

Secondo un recente studio di Botify, le pagine non linkate consumano il 26% del crawl budget di Google:

Fonte: Botify

I link interni contestuali aiutano GoogleBot a trovare e indicizzare tutte le pagine del tuo sito web.

Puoi fare un uso più efficiente del tuo crawl budget assicurandoti che ogni pagina che desideri indicizzare abbia almeno un link interno che punta ad essa.

Sfrutta al massimo il Crawl Budget del tuo sito

L'ottimizzazione del crawl budget è una parte importante di una strategia SEO di successo.

Si tratta di rendere il più semplice possibile GoogleBot. Comprendendo come funziona il crawl budget e come ottimizzarlo, puoi assicurarti che Google esegua la scansione e indicizzi le tue pagine il più spesso possibile.

Ciò migliorerà la tua visibilità nei risultati di ricerca e ti aiuterà ad attirare più traffico organico.

Dedichi tempo, impegno e denaro alla produzione di pagine Web di alta qualità con ottimi contenuti; assicurati che questo non sia lavoro sprecato assicurandoti che le tue pagine possano essere sottoposte a scansione e visualizzate dai motori di ricerca.

Infine, stai cercando un'analisi completa di tutti i crawler e i fetcher di Google , incluso il loro token agente utente e il loro caso d'uso? Dai un'occhiata alla nostra pratica infografica qui sotto!