In che modo ChatGPT influisce sul traffico bot automatizzato?

Pubblicato: 2023-06-28

L'emergere di ChatGPT e di tecnologie AI simili porta sia opportunità che sfide. In qualità di editore, è fondamentale esaminare il potenziale impatto di ChatGPT sul traffico automatizzato/bot e ideare strategie efficaci per mitigarne le conseguenze negative. Questo articolo esplora le implicazioni di ChatGPT sulla generazione di traffico bot, scraping di contenuti e violazione della proprietà intellettuale e fornisce iniziative attuabili per affrontare queste preoccupazioni.

1. Facilitazione della generazione di traffico bot attraverso la creazione di codice

La capacità di ChatGPT di generare codice è uno strumento prezioso per l'istruzione e la risoluzione dei problemi. Tuttavia, gli attori malintenzionati possono sfruttare questa capacità per produrre codice che prende di mira i siti Web con traffico bot automatizzato. I siti Web basati su pubblicità, che dipendono dall'autentico coinvolgimento degli utenti per la generazione di entrate, sono particolarmente vulnerabili.

Poiché in genere gli inserzionisti pagano per impressioni e clic in base alle interazioni degli utenti, il coinvolgimento generato dai bot può gonfiare artificialmente queste metriche. Di conseguenza, gli inserzionisti possono pagare per interazioni non avviate da utenti reali ma da bot.

Questa negligenza non solo porta a perdite finanziarie per gli inserzionisti, ma erode anche la fiducia nelle piattaforme pubblicitarie online. Gli inserzionisti si aspettano che i loro investimenti raggiungano e coinvolgano un vero pubblico umano. Quando invece i loro annunci vengono mostrati al traffico bot, ciò mina l'efficacia e il valore delle loro campagne pubblicitarie. Tali incidenti possono danneggiare la reputazione della piattaforma pubblicitaria e degli editori ad essa associati, poiché gli inserzionisti diventano cauti nell'allocare i propri budget a piattaforme suscettibili alle frodi dei bot.

Gli editori devono conoscere questo potenziale impatto e adottare le misure appropriate per mitigare i rischi. Ciò include l'implementazione di solidi meccanismi di rilevamento e prevenzione delle frodi, la collaborazione con reti pubblicitarie affidabili che utilizzano sofisticati algoritmi di rilevamento dei bot e il monitoraggio dei modelli di traffico per identificare anomalie che potrebbero indicare l'attività dei bot. Affrontando attivamente il problema del traffico bot, gli editori possono mantenere l'integrità delle loro metriche di coinvolgimento e creare fiducia con gli inserzionisti.

2. Intensificazione dello scraping dei contenuti

ChatGPT e sistemi simili possono eseguire varie attività, incluso il web scraping, che comporta l'estrazione di dati da siti Web per diversi obiettivi. Purtroppo, l'uso di sistemi simili a ChatGPT potrebbe portare a un aumento dello scraping dei contenuti. Questa attività può comportare la duplicazione autorizzata o non autorizzata di contenuti online, che vengono poi riutilizzati o monetizzati. Lo scraping dei contenuti può inoltre gravare eccessivamente sui server dei siti Web presi di mira, compromettendone le prestazioni e la disponibilità per gli utenti legittimi.

Quando i contenuti di scraping vengono monetizzati altrove, gli editori vengono privati del traffico e del coinvolgimento che i loro contenuti originali avrebbero generato. Inoltre, lo scraping dei contenuti può gravare eccessivamente sui server dei siti Web presi di mira. Quando vengono effettuate numerose richieste di scraping, può causare un aumento del carico del server e dell'utilizzo della larghezza di banda, portando potenzialmente a prestazioni ridotte o addirittura a tempi di inattività. Gli utenti legittimi potrebbero riscontrare tempi di caricamento della pagina più lenti o difficoltà di accesso al sito Web, influenzando la loro esperienza utente complessiva.

Da un punto di vista legale, lo scraping dei contenuti solleva preoccupazioni in merito alla violazione del copyright e dei diritti di proprietà intellettuale. Lo scraping e la riproduzione non autorizzati di contenuti senza un'attribuzione o un'autorizzazione adeguata possono violare le leggi sul copyright. Gli editori hanno il diritto di proteggere le loro opere originali e controllare come vengono utilizzate e distribuite.

Per affrontare l'intensificazione dello scraping dei contenuti, gli editori possono adottare varie misure. Questi possono includere l'implementazione di salvaguardie tecnologiche come algoritmi di rilevamento dei bot, sistemi CAPTCHA o meccanismi di limitazione della velocità per rilevare e mitigare i tentativi di scraping. Inoltre, gli editori possono sfruttare le vie legali per proteggere i propri contenuti, tra cui la registrazione del copyright, l'emissione di avvisi di rimozione alle parti in violazione e il perseguimento di azioni legali contro i trasgressori recidivi.

È essenziale che gli editori rimangano vigili e controllino attivamente i loro contenuti per la duplicazione non autorizzata. Adottando misure proattive per salvaguardare la loro proprietà intellettuale e mitigare l'impatto dello scraping dei contenuti, gli editori possono mantenere il controllo sui loro contenuti, proteggere i loro flussi di entrate e difendere i loro diritti legali.

3. Preoccupazioni per violazione della proprietà intellettuale e del copyright

Un aumento dello scraping dei contenuti, aiutato da ChatGPT e tecnologie simili, potrebbe comportare una diffusa violazione della proprietà intellettuale e del copyright. Questa tendenza crescente minaccia la capacità dei creatori di contenuti originali di trarre benefici adeguati dal loro lavoro.

Lo scraping dei contenuti comporta l'estrazione e la ripubblicazione non autorizzate di contenuti online, spesso senza fornire un'attribuzione adeguata o chiedere l'autorizzazione ai creatori originali. Questa pratica mina i principi fondamentali della proprietà intellettuale, in cui i creatori dovrebbero avere il diritto di controllare la distribuzione, l'utilizzo e la monetizzazione delle loro opere.

Quando il contenuto viene raschiato e ripubblicato senza consenso, diminuisce il potenziale di guadagno per i creatori originali. Perdono l'opportunità di monetizzare i loro contenuti attraverso canali legittimi, come pubblicità, abbonamenti o accordi di licenza. Inoltre, la mancanza di una corretta attribuzione li priva del riconoscimento e della credibilità che meritano per i loro sforzi creativi.

Inoltre, lo scraping dei contenuti può portare a un ambiente online diluito in cui i contenuti duplicati inondano varie piattaforme. Ciò non solo crea confusione per gli utenti che cercano fonti affidabili e autentiche, ma ostacola anche la crescita e la diversità dei contenuti originali. La prevalenza di contenuti scraped diminuisce l'incentivo per i creatori a investire tempo, risorse e talento nella produzione di opere originali e di alta qualità.

Da un punto di vista legale, lo scraping di contenuti senza autorizzazione spesso viola le leggi sul copyright. Queste leggi concedono diritti esclusivi ai creatori di contenuti, incluso il diritto di riprodurre, distribuire, visualizzare e adattare le loro opere. Lo scraping e la ripubblicazione non autorizzati di materiale protetto da copyright violano tali diritti, esponendo potenzialmente gli autori a conseguenze legali.

Per affrontare queste preoccupazioni, i creatori di contenuti e gli editori devono rimanere vigili nel monitorare e proteggere la loro proprietà intellettuale. Possono impiegare varie strategie per combattere lo scraping dei contenuti, inclusa l'implementazione di misure tecniche per rilevare e prevenire tentativi di scraping, filigrana o impronte digitali digitali dei loro contenuti e perseguire azioni legali contro i recidivi.

Misure attenuanti

Dati questi potenziali impatti, è imperativo sviluppare strategie per mitigare l'uso improprio di ChatGPT e tecnologie simili. Queste strategie includono l'implementazione di meccanismi di rilevamento dei bot più rigorosi, lo sviluppo di strumenti per valutare i livelli di protezione dei siti Web contro i content scraper, l'educazione degli editori sui potenziali rischi e la creazione di quadri legali che affrontino l'uso non autorizzato di tali tecnologie.

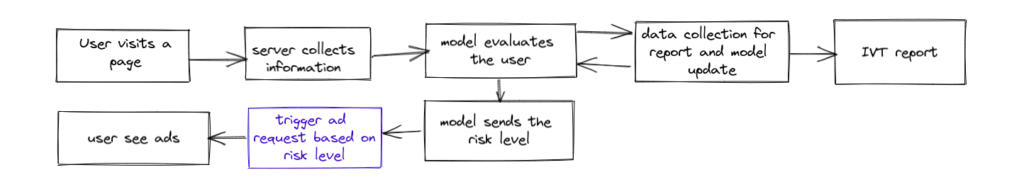

Per mitigare i potenziali impatti negativi di ChatGPT e tecnologie simili, gli editori possono trarre vantaggio dall'utilizzo di soluzioni avanzate di rilevamento dei bot comeTraffic Cop .Traffic Cop, una pluripremiata soluzione di blocco dei bot offerta da MonetizeMore, fornisce una difesa efficace contro il traffico generato dai bot, salvaguardando l'integrità delle metriche di coinvolgimento e proteggendo gli investimenti degli inserzionisti.

Con i suoi algoritmi avanzati e le sue capacità di apprendimento automatico, Traffic Cop è progettato per rilevare e bloccare bot dannosi, click farm e altre attività fraudolente. Integrando Traffic Cop nei loro siti web, gli editori possono garantire che le loro piattaforme basate su pubblicità siano protette dagli effetti negativi del traffico bot, come metriche di coinvolgimento gonfiate, metriche di performance imprecise e spesa pubblicitaria sprecata.

Questa soluzione completa per il blocco dei bot non solo migliora l'accuratezza e l'affidabilità delle metriche di coinvolgimento, ma aiuta anche a mantenere la fiducia degli inserzionisti nella piattaforma. Bloccando in modo proattivo i bot, Traffic Cop assicura che i budget degli inserzionisti siano allocati per un effettivo coinvolgimento degli utenti, con conseguente maggiore trasparenza e un maggiore ritorno sull'investimento.

Inoltre, Traffic Cop fornisce agli editori approfondimenti e rapporti dettagliati sul traffico dei bot, consentendo loro di analizzare i modelli, comprendere l'entità del problema dei bot e adottare le misure necessarie per ottimizzare ulteriormente le prestazioni degli annunci e l'esperienza dell'utente.

Sfruttando Traffic Cop, gli editori possono affrontare con sicurezza le sfide poste dalle attività bot dannose, garantendo un ambiente pubblicitario più sicuro e affidabile sia per gli editori che per gli inserzionisti. Consente agli editori di assumere il controllo dei propri siti Web, proteggere i propri flussi di entrate e rafforzare le proprie relazioni con gli inserzionisti.

Per saperne di più su questo bot killer e sulle sue capacità nel mitigare gli effetti negativi dei sistemi simili a GPT, puoi iniziare con Traffic Cop per una prova di 7 giorni qui!

Syed Tanveer Jishan è un esperto specialista di machine learning, specializzato nel rilevamento di anomalie con un decennio di esperienza nel mondo accademico e industriale, in particolare nella tecnologia pubblicitaria. Ha guidato con successo lo sviluppo di Traffic Cop, un innovativo strumento di rilevamento delle frodi per MonetizeMore, che ha consentito di ridurre di dieci volte il recupero delle entrate pubblicitarie. In qualità di ricercatore accademico, Syed ha pubblicato numerosi nuovi lavori di ricerca, unendo competenze pratiche e accademiche nel campo dell'apprendimento automatico. Le sue capacità ed esperienze lo equipaggiano in modo unico per aiutare le aziende a salvaguardare i ricavi dalle frodi e migliorare l'efficienza operativa utilizzando l'intelligenza artificiale.