Come ottimizzare il budget di scansione e aumentare le classifiche?

Pubblicato: 2017-01-14Sommario

- 1 Che cos'è il Crawl Budget?

- 2 Perché il budget di scansione è importante?

- 3 Quando è il Crawl Budget un problema?

- 4 Come ottimizzare il budget di scansione

- 5 1. Migliorare la struttura del sito

- 6 2.Risolvere i collegamenti interrotti

- 7 3.Utilizzare i contenuti Rich Media con attenzione

- 8 4.Ripulire la mappa del sito

- 9 5.Costruire collegamenti esterni

- 10 6.Organizzare i collegamenti interni

- 11 7.Utilizzare i feed

- 12 8.Rimuovi le catene di reindirizzamento

- 13 9.Assicurati che le tue pagine siano scansionabili

Tutti sanno cos'è l'ottimizzazione dei motori di ricerca e l'importanza di un sito ben strutturato, parole chiave pertinenti, contenuti di qualità, tag adeguati, mappa del sito pulita e altri standard tecnici. Ma ci sono possibilità che tu non abbia pensato all'ottimizzazione della scansione.

L'ottimizzazione del budget di scansione è qualcosa che va a un livello più profondo dell'ottimizzazione dei motori di ricerca. Mentre l'ottimizzazione dei motori di ricerca è più focalizzata sul processo di ottimizzazione per le query degli utenti, l'ottimizzazione della scansione si concentra sul modo in cui i bot dei motori di ricerca (web spider) accedono al tuo sito.

In questo articolo, illustreremo i meccanismi alla base del modo in cui i motori di ricerca assegnano i budget di scansione ai siti Web e i suggerimenti per aiutarti a ottenere il massimo dal tuo budget di scansione per massimizzare le classifiche, il traffico organico e, soprattutto, l'indicizzazione.

Che cos'è il budget di scansione?

Il budget di scansione è semplicemente la quantità di pagine che lo spider del motore di ricerca eseguirà la scansione del tuo sito Web in un determinato periodo di tempo. Il budget di scansione è generalmente determinato dalle dimensioni e dallo stato del tuo sito e dal numero di link che puntano al tuo sito.

Il budget di scansione è un fattore SEO importante a cui spesso non viene prestata sufficiente attenzione. I motori di ricerca utilizzano gli spider bot per eseguire la scansione delle pagine Web, raccogliere informazioni e aggiungerle al proprio indice. Inoltre, indicano anche i collegamenti alle pagine che visitano e tentano di eseguire la scansione anche di quelle nuove pagine.

Ad esempio, Googlebot è lo spider web che scopre nuove pagine e le aggiunge all'indice di Google. La maggior parte dei servizi web e degli strumenti SEO si affida a questi web spider per raccogliere informazioni utili.

Perché il budget di scansione è importante?

La scansione di un sito Web è un passaggio primario e cruciale per garantirne la ricerca. Se ti stai chiedendo se l'ottimizzazione del crawl budget sia importante per il tuo sito web, la risposta è ovviamente SÌ. I tuoi sforzi SEO e l'ottimizzazione della scansione probabilmente andranno di pari passo.

Per quanto semplice sia, è abbastanza logico che dovresti preoccuparti del crawl budget perché rende più facile per Google scoprire e indicizzare il tuo sito web. Se ci sono più scansioni sul tuo sito web, significa che avrai aggiornamenti più veloci quando pubblichi nuovi contenuti. Quindi, maggiore è il tuo crawl budget, più velocemente accadrà.

Ciò ti aiuterà anche a migliorare l'esperienza utente complessiva per il tuo sito Web, il che migliora la visibilità e, in definitiva, si traduce in un migliore posizionamento delle SERP. Il fatto è che le pagine che sono state scansionate di recente ottengono maggiore visibilità nelle SERP e se una pagina non viene scansionata da un po' non si classificherà bene.

Quando il budget di scansione è un problema?

Non è che il Crawl budget crei spesso un problema. Se hai allocato scansioni proporzionali per gli URL del tuo sito web, non è un problema. Ma supponiamo che il tuo sito web abbia 200.000 URL e Google esegue la scansione di solo 2.000 pagine al giorno del tuo sito, quindi potrebbero essere necessari 100 giorni prima che Google identifichi o aggiorni gli URL: ora questo è un problema.

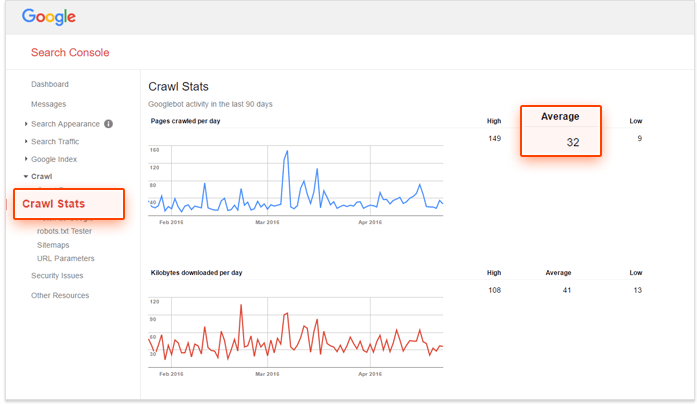

Se stai cercando una soluzione e vuoi verificare se il tuo budget di scansione necessita di ottimizzazione, utilizza Google Search Console e il numero di URL sul tuo sito per calcolare il "numero di scansione" del tuo sito web. Come fare questo?

– Per prima cosa devi valutare quante pagine ci sono sul tuo sito web, puoi farlo facendo un sito: cerca su Google,

– In secondo luogo, vai al tuo account Google Search Console e vai su Scansione, quindi Statistiche di scansione. Se il tuo account non è configurato correttamente, non otterrai questi dati.

– Il terzo passaggio consiste nel dividere il numero totale di pagine del tuo sito per il numero medio di pagine scansionate al giorno sul tuo sito web.

Se questo numero è maggiore di 10, devi cercare di ottimizzare il tuo crawl budget. Se è meno di 5, bravo! Non è necessario leggere oltre.

Come ottimizzare il budget di scansione

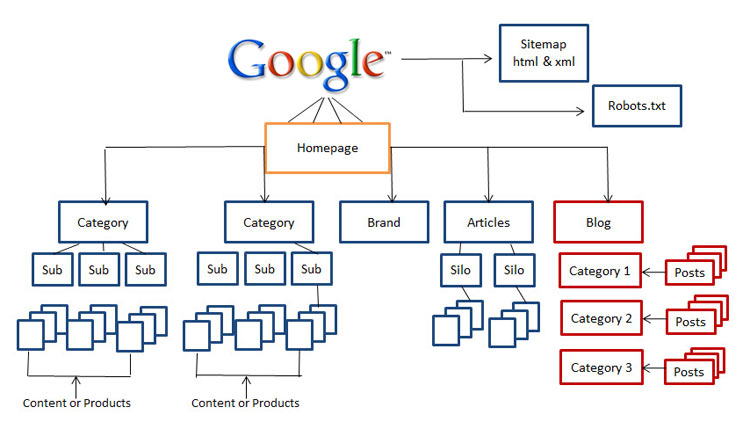

1. Migliora la struttura del sito

Oggi, l'importanza della struttura del sito è un fattore cruciale. I maestri SEO come Rand Fishkin consigliano di assicurarsi che gli utenti del tuo sito Web non siano a più di tre clic dalla home page durante la loro visita. È davvero un ottimo consiglio per i SEO in termini di usabilità poiché è improbabile che i tuoi visitatori scavino più a fondo nel tuo sito web.

Quindi, se non disponi di un sito Web pulito, facile da navigare e adatto ai motori di ricerca, ora è il momento di iniziare a ristrutturare il tuo sito Web.

2. Risolvi i collegamenti interrotti

Questa è una delle differenze fondamentali tra l'ottimizzazione dei motori di ricerca e l'ottimizzazione della scansione non solo i collegamenti interrotti svolgono un ruolo sostanziale nel far scendere le classifiche, ma ostacolano anche notevolmente la capacità di Googlebot di indicizzare e classificare il tuo sito web.

L'algoritmo di Google è notevolmente migliorato nel corso degli anni e qualsiasi cosa che influisca sull'esperienza dell'utente potrebbe avere un impatto sulle SERP. Google ha sempre cercato di copiare il comportamento dell'utente e di aggiornare gli algoritmi. Quindi dovremmo sempre considerare l'esperienza dell'utente quando ottimizziamo i siti Web per i motori di ricerca.

3.Utilizzare con attenzione i contenuti Rich Media

Oggi, Google fatica a eseguire la scansione di Silverlight e solo di alcuni altri file, ma ci sono stati momenti in cui Google non poteva eseguire la scansione di contenuti multimediali come flash, javascript e HTML.

Tuttavia, sebbene Google possa leggere la maggior parte dei tuoi file rich media, ci sono altri motori di ricerca che potrebbero non essere in grado di farlo. Ciò significa che dovresti usare questi file con saggezza e, a volte, potresti volerli evitare del tutto nelle pagine che vuoi classificare.

4. Pulisci la mappa del sito

Sforzati di ripulire la tua mappa del sito e mantenerla aggiornata al fine di salvaguardarti da ingombri che potrebbero danneggiare l'usabilità del tuo sito Web, comprese pagine bloccate, pagine non canoniche, reindirizzamenti non necessari e pagine di livello 400. L'uso delle mappe dei siti XML è il modo migliore per aiutare i tuoi utenti e gli spider bot.

Ci sono vari strumenti sul mercato per ripulire la tua mappa del sito. Puoi utilizzare il generatore di mappe del sito XML per creare una mappa del sito pulita che escluda tutte le pagine bloccate dall'indicizzazione, trova e correggi cose come reindirizzamenti 301 e 302 e pagine non canoniche.

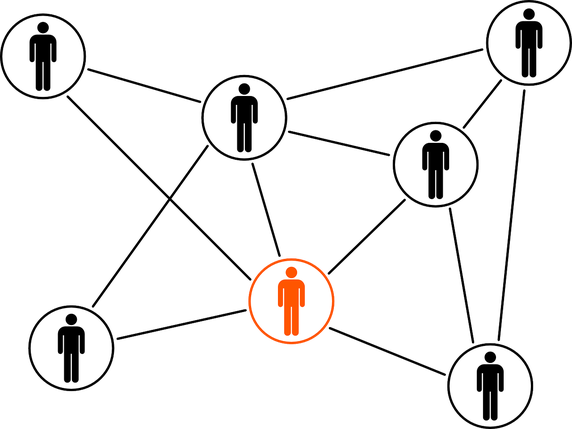

5.Crea collegamenti esterni

Il link building è un argomento caldo di tutti i tempi e non scomparirà nel prossimo futuro. Scoprire nuove comunità, stabilire relazioni online e creare valore del marchio sono alcuni dei vantaggi che dovresti già avere nel tuo processo di creazione di link.

Se eseguiti attraverso le migliori pratiche, i collegamenti esterni sono i collegamenti che puntano a un dominio esterno e la fonte più importante per ottenere classifiche più elevate. Sebbene i collegamenti esterni siano le metriche più difficili da manipolare, sono un ottimo modo per i motori di ricerca di conoscere la popolarità e la pertinenza di una pagina web.

6. Organizzare il collegamento interno

Sebbene la creazione di link interni non abbia molto a che fare con l'ottimizzazione del crawl budget, ciò non significa che puoi ignorarla. Una struttura del sito ben organizzata e mantenuta aiuta i tuoi contenuti a essere facilmente visibili agli utenti e agli spider bot senza spendere abbastanza budget per la scansione.

Un sistema di collegamento interno ben strutturato migliora anche l'esperienza dell'utente. Aiutare gli utenti a raggiungere qualsiasi area con pochi clic e rendere le cose facilmente accessibili generalmente farà sì che i visitatori rimangano più a lungo sul tuo sito web, il che migliorerà le tue classifiche SERP.

7.Utilizzare i feed

Vari feed come RSS, Atom e XML aiutano il tuo sito web a fornire contenuti agli utenti anche quando non stanno navigando nel tuo sito web. Questo è il modo migliore per gli utenti di iscriversi ai siti più favorevoli e ricevere aggiornamenti regolari ogni volta che vengono pubblicati nuovi contenuti.

Da molto tempo, i feed RSS hanno dimostrato di essere un buon modo per aumentare il numero di lettori e il coinvolgimento del tuo sito web. Inoltre, sono anche tra i siti più visitati dai web spider di Google. Quando il tuo sito web ha un aggiornamento, puoi inviarlo a Feed Burner di Google in modo da essere sicuro che sia indicizzato correttamente.

8.Rimuovi le catene di reindirizzamento

Ogni URL a cui stai reindirizzando sprecherà un po' del tuo budget di scansione. Quando il tuo sito web ha lunghe catene di reindirizzamento, il che significa avere un gran numero di reindirizzamenti 301 e 302 di fila, gli spider web potrebbero cadere prima che raggiungano la tua pagina di destinazione, alla fine la tua pagina non verrà indicizzata. Se stai cercando la migliore pratica con i reindirizzamenti, è meglio avere il minor numero di reindirizzamenti possibile sul tuo sito Web e non più di due di seguito.

9. Assicurati che le tue pagine siano scansionabili

Se gli spider dei motori di ricerca sono in grado di trovare le tue pagine web, trovare e seguire i link all'interno del tuo sito web, allora sono scansionabili. Quindi, devi configurare i tuoi file robots.txt e .htaccess in modo che non blocchino le pagine critiche del tuo sito web.

Potrebbe anche essere necessario fornire i file di testo delle pagine che si trovano su contenuti multimediali come flash, silverlight, ecc.

Solo disabilitando il file robots.txt, non puoi garantire di impedire la deindicizzazione di una pagina. Se sono presenti elementi esterni come i link in entrata che continuano a indirizzare il traffico alla pagina che non hai consentito, Google potrebbe ritenere che la pagina sia ancora pertinente. In questo caso, dovrai bloccare manualmente l'indicizzazione della pagina. Puoi farlo facilmente utilizzando l'intestazione HTTP X-Robots-Tag o il meta tag noindex robots.

Tieni presente che se utilizzi il meta tag noindex o X-Robots-Tag, non devi disattivare la pagina in robots.txt. La pagina deve essere scansionata prima che il tag venga visualizzato e rispettato.

Conclusione: l'ottimizzazione del crawl budget non è un compito facile e certamente non è una "vincita rapida". Se hai un sito web di piccole o medie dimensioni, ben mantenuto, probabilmente stai bene. Ma se hai una struttura del sito complessa e disorganizzata con migliaia di URL e i file di registro del server ti sovrastano, potrebbe essere il momento di chiamare professionisti o esperti per aiutarti.