Alto rischio, alta ricompensa: come i marchi possono utilizzare l'IA in modo etico

Pubblicato: 2023-07-18L'IA generativa ha già cambiato il mondo, ma non è tutto oro ciò che luccica. Mentre l'interesse dei consumatori per ChatGPT è alto, c'è una crescente preoccupazione sia tra gli esperti che tra i consumatori sui pericoli dell'intelligenza artificiale per la società. Le preoccupazioni per la perdita del lavoro, la sicurezza dei dati, la disinformazione e la discriminazione sono alcune delle principali aree che causano allarme.

L'intelligenza artificiale è la paura in più rapida crescita negli Stati Uniti, con un aumento del 26% rispetto a solo un trimestre fa.

L'intelligenza artificiale cambierà senza dubbio il modo in cui lavoriamo, ma le aziende devono essere consapevoli dei problemi che ne derivano. In questo blog, esploreremo le preoccupazioni dei consumatori in merito alla sicurezza del lavoro e dei dati, come i marchi possono alleviare le preoccupazioni e proteggere se stessi e i consumatori da potenziali rischi.

1. Salvaguardare l'IA generativa

I contenuti generati dall'intelligenza artificiale, come ChatGPT e il creatore di immagini DALL-E, stanno rapidamente diventando parte della vita quotidiana, con oltre la metà dei consumatori che vede i contenuti generati dall'intelligenza artificiale almeno una volta alla settimana. Poiché questi strumenti richiedono enormi quantità di dati per apprendere e generare risposte, le informazioni sensibili possono insinuarsi nel mix.

Con molte parti in movimento, le piattaforme di intelligenza artificiale generativa consentono agli utenti di contribuire al codice in vari modi nella speranza di migliorare i processi e le prestazioni. Lo svantaggio è che con molti contributi, le vulnerabilità spesso passano inosservate e le informazioni personali possono essere esposte. Questa situazione esatta è ciò che è accaduto a ChatGPT all'inizio di maggio 2023.

Con oltre la metà dei consumatori che afferma che le violazioni dei dati li indurrebbero a boicottare un marchio, la privacy dei dati deve avere la priorità. Mentre si stanno compiendo passi per scrivere leggi sull'intelligenza artificiale, nel frattempo i marchi devono autoimporre regole di trasparenza e linee guida sull'utilizzo e renderle note al pubblico.

2 consumatori su 3 vogliono che le aziende che creano strumenti di intelligenza artificiale siano trasparenti su come vengono sviluppati.

Ciò può creare fiducia nel marchio, una valuta particolarmente ambita in questo momento. Oltre alla qualità, la sicurezza dei dati è il fattore più importante quando si tratta di fidarsi dei marchi. Con la fedeltà al marchio sempre più fragile, i marchi devono rassicurare i consumatori che i loro dati sono in buone mani.

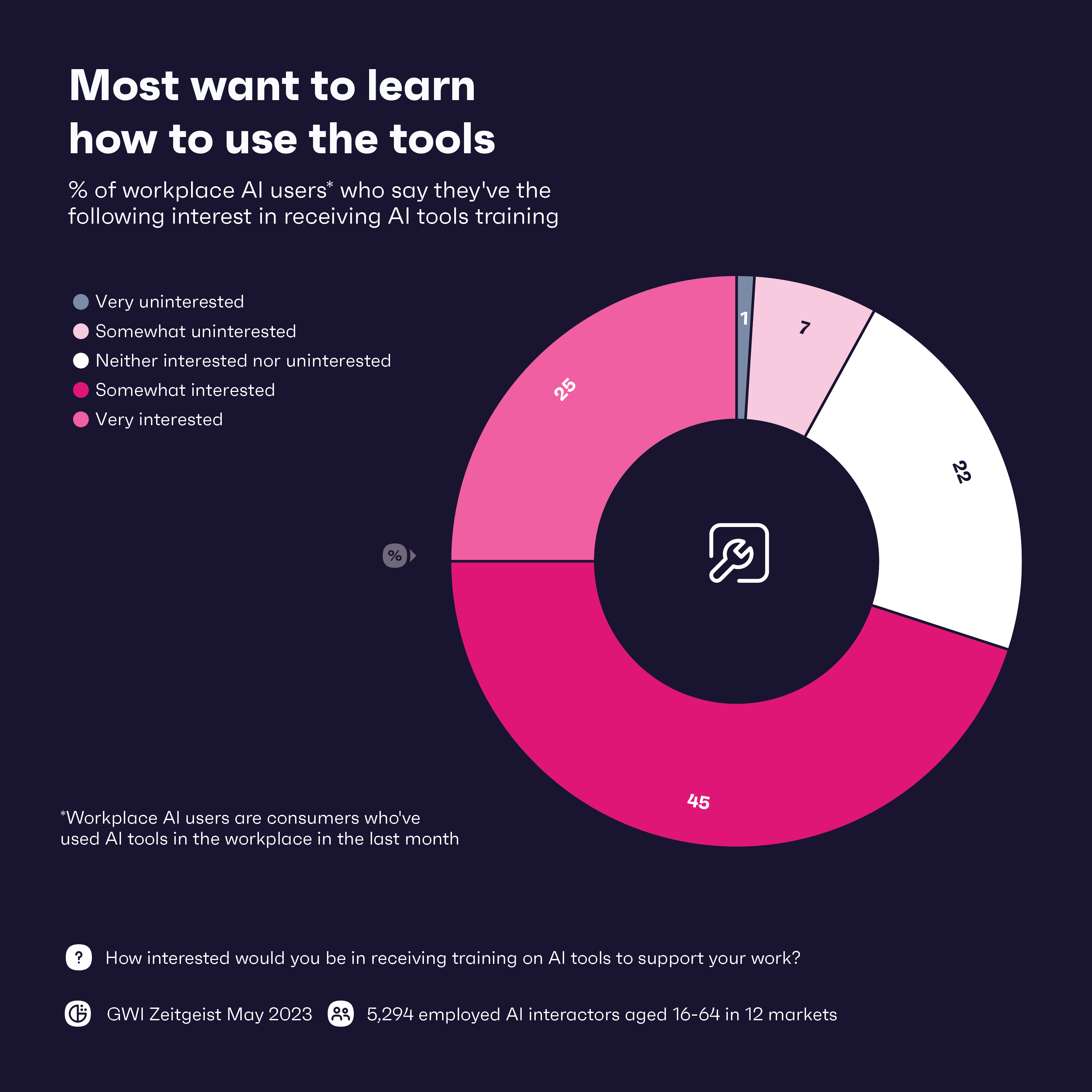

Allora qual è uno dei modi migliori per proteggere i dati nell'era dell'IA? La prima linea di difesa è la formazione del personale sugli strumenti di intelligenza artificiale, con il 71% dei lavoratori che afferma di essere interessato alla formazione. Combinare questo con la formazione sulla protezione dei dati è altrettanto importante. L'istruzione è davvero fondamentale qui: fornire ai lavoratori le conoscenze necessarie per garantire che la privacy dei dati sia in primo piano farà molto.

2. Mantenerlo reale in un mondo di notizie false

Facebook ha impiegato 4,5 anni per raggiungere 100 milioni di utenti. In confronto, ChatGPT ha impiegato poco più di due mesi per raggiungere quel traguardo.

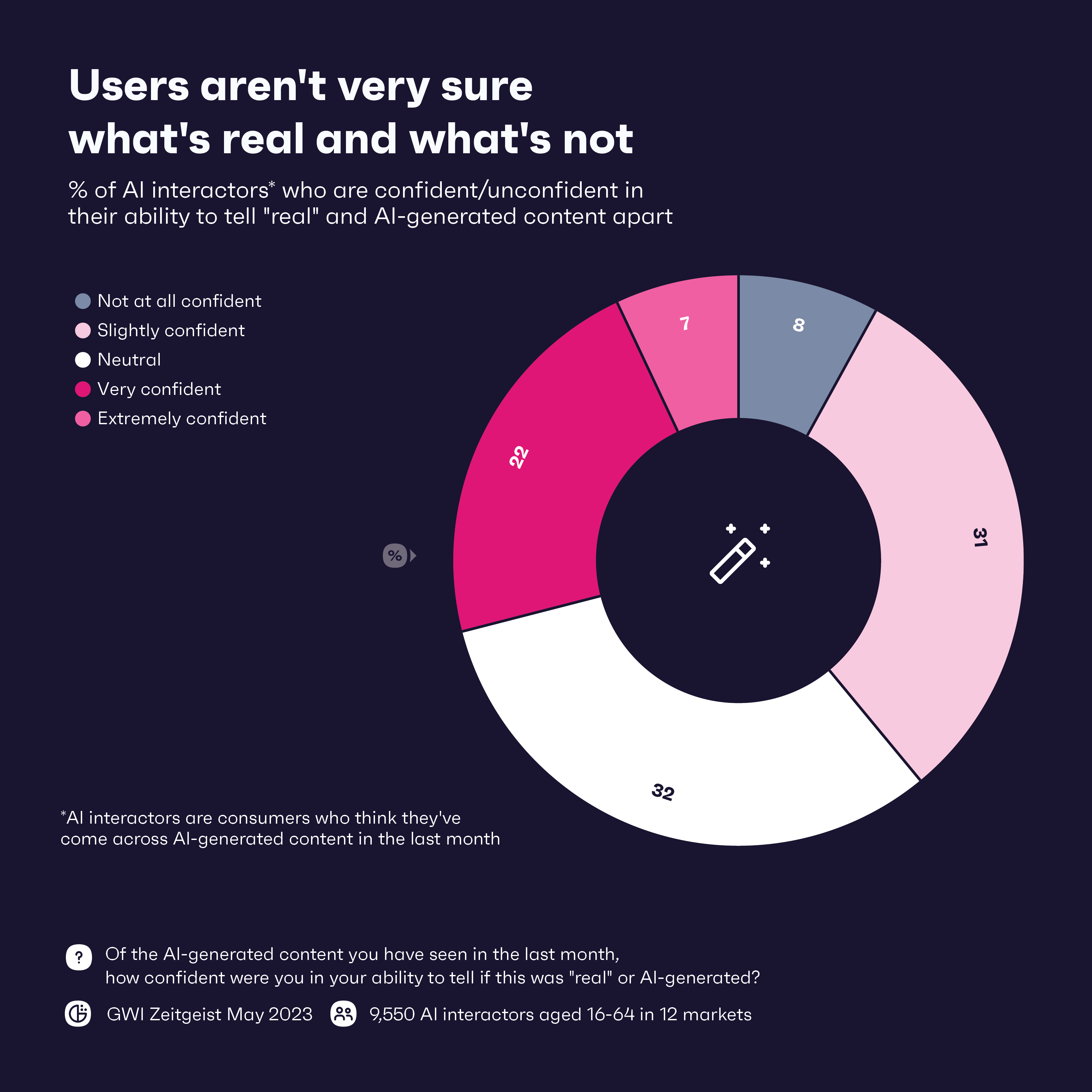

Per quanto impressionante sia l'ascesa dell'IA generativa, è stata una calamita per la creazione di notizie false sotto forma di audio e video, noti come deepfake. La tecnologia è già stata utilizzata per diffondere disinformazione in tutto il mondo. Solo il 29% dei consumatori è fiducioso nella propria capacità di distinguere i contenuti generati dall'intelligenza artificiale e i contenuti "reali", il che probabilmente peggiorerà man mano che i deepfake diventeranno più sofisticati.

Quasi due terzi degli utenti di ChatGPT affermano di interagire con lo strumento come farebbero con una persona reale, il che dimostra quanto potrebbe essere potenzialmente persuasivo lo strumento.

Ma i consumatori l'hanno visto arrivare; Il 64% afferma di essere preoccupato che gli strumenti di intelligenza artificiale possano essere utilizzati per scopi non etici. Con questa preoccupazione e la scarsa fiducia nel rilevare i deepfake, sono i marchi che possono fare la differenza nel proteggere i consumatori da quest'ultima ondata di notizie false e fornire istruzione su come identificare tali contenuti.

I marchi possono iniziare implementando la verifica della fonte e conducendo la due diligence su qualsiasi informazione che desiderano condividere o promuovere. Allo stesso modo, possono collaborare o utilizzare processi interni di verifica dei fatti su tutte le notizie che possono ricevere. Per la maggior parte dei marchi, queste misure saranno probabilmente già in atto, poiché notizie false e disinformazione sono dilaganti da anni.

Ma man mano che i deepfake diventano più intelligenti, i marchi dovranno tenerne conto. Per batterli, i marchi potrebbero dover ricorrere ancora una volta all'intelligenza artificiale sotto forma di strumenti di rilevamento basati sull'intelligenza artificiale in grado di identificare e contrassegnare i contenuti generati dall'intelligenza artificiale. Questi strumenti diventeranno una necessità nell'era dell'intelligenza artificiale, ma potrebbero non essere sufficienti poiché i cattivi attori di solito sono un passo avanti. Ma una combinazione di strumenti di rilevamento e supervisione umana per interpretare correttamente il contesto e la credibilità potrebbe ostacolare il peggio.

Anche la trasparenza è fondamentale. Far sapere ai consumatori che stai facendo qualcosa per affrontare le notizie false generate dall'intelligenza artificiale può ottenere punti di fiducia con loro e aiutare a stabilire standard di settore che possono aiutare tutti a rimanere al passo con i deepfake.

3. Combattere i pregiudizi intrinseci

Nessuno vuole un incubo di pubbliche relazioni, ma questa è una possibilità reale se i marchi non controllano due volte le informazioni che ottengono dai loro strumenti di intelligenza artificiale. Ricorda, gli strumenti di intelligenza artificiale imparano dai dati estratti da Internet, dati pieni di pregiudizi umani, errori e discriminazioni.

Per evitare ciò, i marchi dovrebbero utilizzare set di dati diversi e rappresentativi per addestrare i modelli di intelligenza artificiale. Sebbene eliminare completamente pregiudizi e discriminazioni sia quasi impossibile, l'utilizzo di un'ampia gamma di set di dati può aiutare a eliminarne alcuni. Più consumatori sono preoccupati di come vengono sviluppati gli strumenti di intelligenza artificiale, e una certa trasparenza sull'argomento potrebbe farli fidarsi un po' di più di questi strumenti.

Mentre tutti i marchi dovrebbero preoccuparsi di utilizzare dati imparziali, alcuni settori devono essere più attenti di altri. I marchi bancari e sanitari, in particolare, devono essere iper-consapevoli di come utilizzano l'intelligenza artificiale, poiché questi settori hanno una storia di discriminazione sistemica. Secondo i nostri dati, il comportamento che causa danni a comunità specifiche è il motivo principale per cui i consumatori boicotterebbero un marchio e all'interno dei terabyte di dati utilizzati per addestrare gli strumenti di intelligenza artificiale si trovano dati potenzialmente dannosi.

Oltre a una revisione dettagliata dei set di dati utilizzati, i marchi hanno anche bisogno di persone, preferibilmente con una formazione diversificata, di equità e inclusione (DE&I), per supervisionare l'intero processo. Secondo il nostro set di dati GWI USA Plus, DE&I è importante per il 70% degli americani ed è più probabile che acquistino da marchi che condividono i loro valori.

4. Trovare il giusto equilibrio con l'automazione sul posto di lavoro

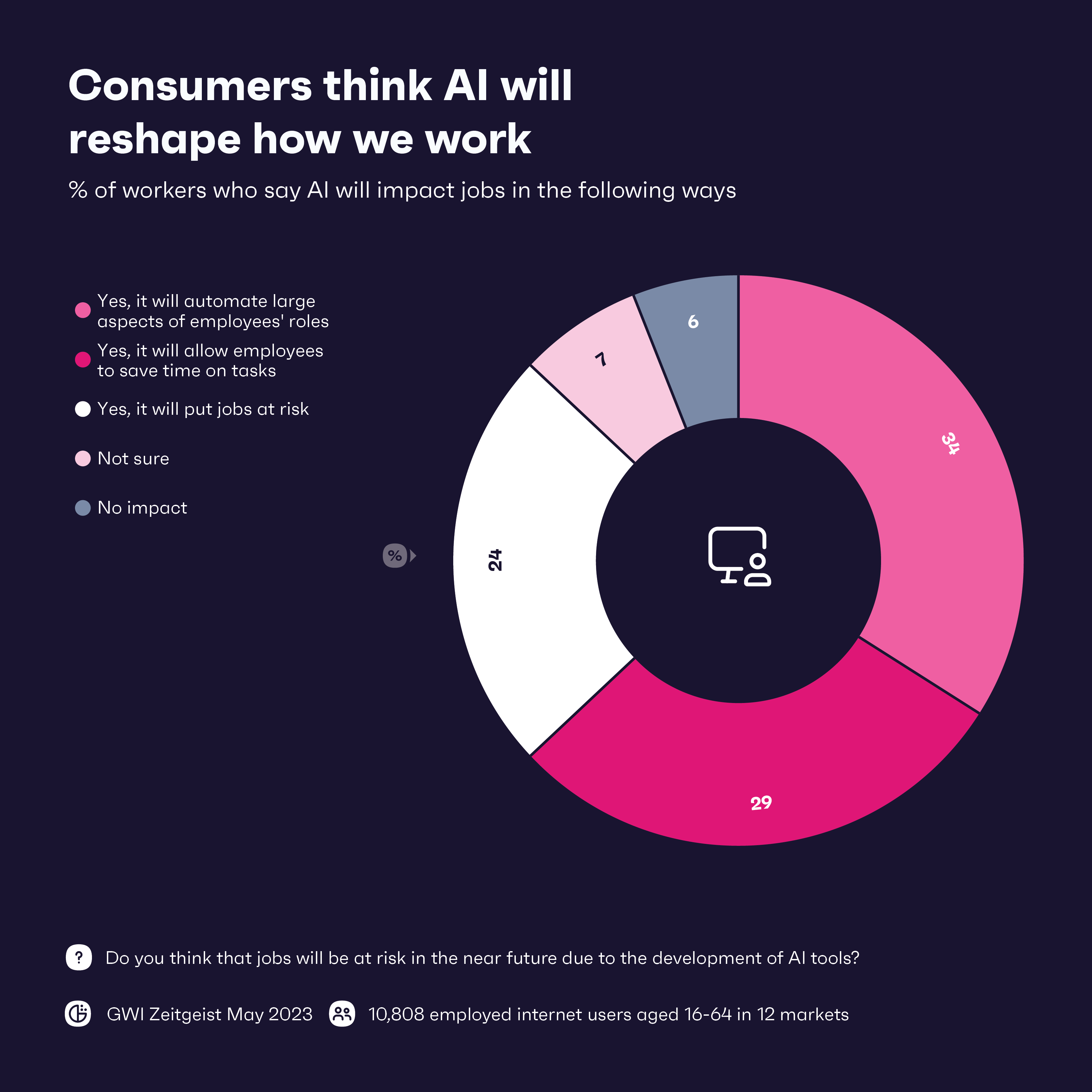

Rivolgiamoci all'elefante nella stanza. L'intelligenza artificiale sarà un amico o un nemico per i lavoratori? Non c'è dubbio che cambierà il lavoro così come lo conosciamo, ma quanto sarà grande l'impatto dell'IA sul posto di lavoro dipende da chi lo chiedi.

Quello che sappiamo è che la grande maggioranza dei lavoratori si aspetta che l'IA abbia una sorta di impatto sul proprio lavoro. È prevista l'automazione di ampi aspetti dei ruoli dei dipendenti, in particolare nei settori tecnologico e manifatturiero/logistico. Nel complesso, i lavoratori sembrano entusiasti dell'IA, con 8 settori su 12 che affermano che l'automazione avrà un impatto positivo.

Il rovescio della medaglia, quasi il 25% dei lavoratori vede l'IA come una minaccia per i posti di lavoro e coloro che lavorano nei settori dei viaggi e della salute e della bellezza sono particolarmente nervosi. L'IA generativa sembra migliorare in modo esponenziale ogni mese, quindi la domanda è: se l'IA può occuparsi di attività banali ora, cosa verrà dopo?

Anche se l'intelligenza artificiale occupa circa 80 milioni di posti di lavoro a livello globale, i lavoratori possono trovare modi per utilizzare l'intelligenza artificiale in modo efficace per migliorare le proprie competenze, anche nei settori vulnerabili. Il servizio clienti è destinato a subire importanti aggiornamenti con l'intelligenza artificiale, ma non può accadere senza gli umani. L'IA generativa può gestire la maggior parte delle richieste, ma gli esseri umani devono essere presenti per gestire le informazioni sensibili e fornire un tocco empatico. Gli esseri umani possono anche lavorare con l'intelligenza artificiale per fornire soluzioni e consigli più personalizzati, il che è particolarmente importante nei settori dei viaggi e della bellezza.

L'intelligenza artificiale che automatizza alcune attività può consentire ai lavoratori di contribuire in altri modi. Possono dedicare più tempo al pensiero strategico e alla ricerca di soluzioni innovative, che potrebbero portare a nuovi prodotti e servizi. Sarà diverso per ogni azienda e settore, ma coloro che sono in grado di trovare il giusto equilibrio tra intelligenza artificiale e lavoratori umani dovrebbero prosperare nell'era dell'IA.

Il prompt finale: cosa devi sapere

L'intelligenza artificiale può essere potente, ma i brand devono essere consapevoli dei rischi. Dovranno proteggere i dati dei consumatori ed essere consapevoli delle notizie false. La trasparenza sarà fondamentale. I consumatori sono nervosi per il futuro dell'intelligenza artificiale e i marchi che mostrano loro che si stanno comportando in modo etico e responsabile faranno molta strada.

La tecnologia è entusiasmante e probabilmente avrà un impatto positivo sul posto di lavoro in generale. Ma i marchi dovrebbero procedere con cautela e cercare di trovare il giusto equilibrio tra tecnologia e capitale umano. I dipendenti avranno bisogno di una formazione approfondita su etica, sicurezza e corretta applicazione, e così facendo aumenteranno le loro capacità. Integrando gli strumenti di intelligenza artificiale per lavorare a fianco delle persone, invece di sostituirli completamente, i marchi possono trovare un equilibrio che li preparerà per il futuro potenziato dall'intelligenza artificiale.