ChatGPT がコンテンツをスクレイピングすることにうんざりしていませんか? 今すぐコンテンツを保護してください

公開: 2023-07-06

今日のデジタル環境では、コンテンツ、データ、Web トラフィックを保護することが最も重要です。 ChatGPT やその他の AI 言語モデルの出現により、これらのツールが自らの利益のためにコンテンツをスクレイピングすることに対する懸念が高まっています。 パブリッシャーとしては、これらのボットがどのように動作するか、またボットがもたらす潜在的なリスクを理解することが不可欠です。

この記事では、ChatGPT と LLM スクレイピングの世界を探索し、Web サイトのトラフィックを出し抜いて保護する戦略について説明します。

ChatGPT がコンテンツをスクレイピングしていることをどうやって確認できますか?

ChatGPT、さまざまなプラグイン、およびその他の言語モデルは、人間のようなテキストを生成する優れた能力によりスターの地位を獲得しました。 これらのツールは、コンテンツ作成、顧客サービス、さらにはクリエイティブライティングを含むさまざまな業界の従業員を引き継ぎ、解雇しました。 これらはさまざまな方法で役立ちますが、コンテンツのスクレイピングに悪用される場合があることを理解することが重要です。

インターネットの文脈におけるスクレイピングは、自動ボットを使用して Web サイトから情報を抽出するプロセスを指します。 これらのボットはさまざまな Web ページにアクセスしてデータを収集し、それを使用して AI モデルをさらにトレーニングします。 ChatGPT または他の LLM がコンテンツをスクレイピングする場合、基本的には収集したデータを利用してテキスト生成機能を強化します。

しかし、主な問題は、このスクレイピングプロセスが知的財産権を侵害し、出版社やメディア組織のビジネスに損害を与える場合に発生します。 コンテンツがどのようにスクレイピングされるか、およびそれが Web トラフィックに与える可能性のある影響を認識することが重要です。

スクレイピングの問題点

スクレイピングに関する主な問題の 1 つは、コンテンツの制御が失われる可能性があることです。 Web サイトのコンテンツがスクレイピングされると、ユーザーの同意なしに再利用され、他の場所に配布される可能性があります。 これにより、オリジナルの作成者としての権威が損なわれ、コンテンツの正確性と完全性を維持することが困難になります。

スクレイピングは、Web サイトの検索エンジンのランキングに大きな影響を与える可能性があります。 検索エンジンはオリジナルでユニークなコンテンツを優先するため、スクレイピングされたコンテンツが他の場所で公開されると、検索結果における Web サイトの可視性と関連性が薄れる可能性があります。 これにより、オーガニック トラフィックが減少し、収益が減少する可能性があります。

また、ブランドや組織の歪んだ表現につながる可能性もあります。 スクレイピングされたコンテンツが不適切に使用されたり、文脈を無視して使用されたりすると、ユーザーの意図が誤って伝えられ、混乱が生じたり、評判が損なわれたりする可能性があります。 ブランド アイデンティティを保護し、コンテンツが責任を持って適切な帰属のもとに使用されるようにすることが重要です。

スクレイピングの問題に対処するには、多面的なアプローチが必要です。 コンテンツ作成者または Web サイト所有者は、コンテンツがスクレイピングされないようにいくつかの対策を講じることができます。 CAPTCHA、IP ブロック、コンテンツ アクセス制限などのテクノロジーを実装すると、自動化されたボットによる Web サイトへのアクセスやスクレイピングを阻止できます。

さらに、Web サイトのトラフィックを定期的に監視し、ユーザーの行動を分析すると、スクレイピングを示す可能性のある不審なアクティビティを特定するのに役立ちます。 常に警戒し、積極的に行動することで、コンテンツやビジネスに対するスクレイピングの影響を軽減するための適切な措置を講じることができます。

ChatGPT などの LLM を利用する AI 開発者や組織にとって、倫理的考慮事項を優先することも不可欠です。 スクレイピングの悪用を防止する厳格なガイドラインとポリシーを実装することは、コンテンツの不正収集を防ぐのに役立ちます。 責任ある AI 開発は、イノベーションと知的財産権の尊重とのバランスを取ることを目的としています。

ChatGPT はどのようにコンテンツをスクレイピングしますか?

この問題に効果的に対処するには、ChatGPT ボットが採用するスクレイピング プロセスを理解することが重要です。 これらのボットは、Web クローリングとして知られる技術を使用し、Web ページにアクセスし、リンクをたどって情報を収集します。 この情報は、AI モデルのトレーニングに利用されます。 コンテンツのスクレイピングは、いくつかの理由からパブリッシャーやメディア ビジネスに有害となる可能性があります。

まず、スクレイピングされたコンテンツが許可なく再公開されると、収益の損失につながる可能性があります。 これにより、元のパブリッシャーのコンテンツを収益化する能力が損なわれ、経済的損失が生じる可能性があります。 さらに、ChatGPT ボットによって再公開されると、コンテンツが誤って伝えられたり、文脈から切り離されたりする可能性があるため、公開者の評判を傷つける可能性があります。

次に、ユーザー エクスペリエンスへの影響が重大な懸念事項です。 ChatGPT ボットが Web サイトにコンテンツを収集するリクエストを大量に送信すると、サーバーに過負荷がかかり、正規ユーザーの読み込み速度が遅くなる可能性があります。 これにより、訪問者はイライラして Web サイトに戻る意欲がなくなり、トラフィックが減少し、エンゲージメントや広告収入が失われる可能性があります。

最後に、スクレイピングされたコンテンツは、Web サイトの検索エンジンのランキングに影響を与える可能性もあります。 検索エンジンは独自のオリジナル コンテンツを優先し、重複またはスクレイピングされたコンテンツのある Web サイトにペナルティを与えます。 ChatGPT ボットがパブリッシャーからコンテンツをスクレイピングして再公開すると、元のクリエイターの検索エンジン最適化 (SEO) の取り組みに悪影響を及ぼす可能性があります。 これにより、認知度が低下し、オーガニック トラフィックが減少し、パブリッシャーのオンライン プレゼンスが損なわれる可能性があります。

これらのリスクを考慮すると、パブリッシャーは自社のコンテンツと Web トラフィックを ChatGPT や LLM スクレイピングから積極的に保護する必要があります。 CAPTCHA 、IP ブロック、ユーザー エージェント検出などの対策を実装すると、コンテンツをスクレイピングしようとする自動ボットを特定してブロックするのに役立ちます。 さらに、Web トラフィックを定期的に監視し、パターンを分析することで、異常なスクレイピング アクティビティを検出し、適切な措置を講じることができます。

さらに、パブリッシャーはコンテンツを保護するための法的手段を模索できます。 作品の不正なスクレイピングや再公開を防ぐために、著作権法と知的財産権を施行することができます。 法的アドバイスを求め、侵害団体に対して必要な法的措置を講じることは、強力なメッセージとなり、今後のスクレイピングの試みを阻止することができます。

この問題に対処するには、パブリッシャー、メディア企業、AI 開発者間のコラボレーションとコミュニケーションも重要です。 パートナーシップとオープンな対話を確立することは、AI トレーニングの倫理慣行とガイドラインの開発につながり、AI テクノロジーを進歩させながらコンテンツ作成者の権利が確実に尊重されるようにすることができます。

ChatGPT の先を行き、Web サイトのトラフィックを保護するにはどうすればよいでしょうか?

Traffic Cop のご紹介: 不正なスクレイピングに対するシールド

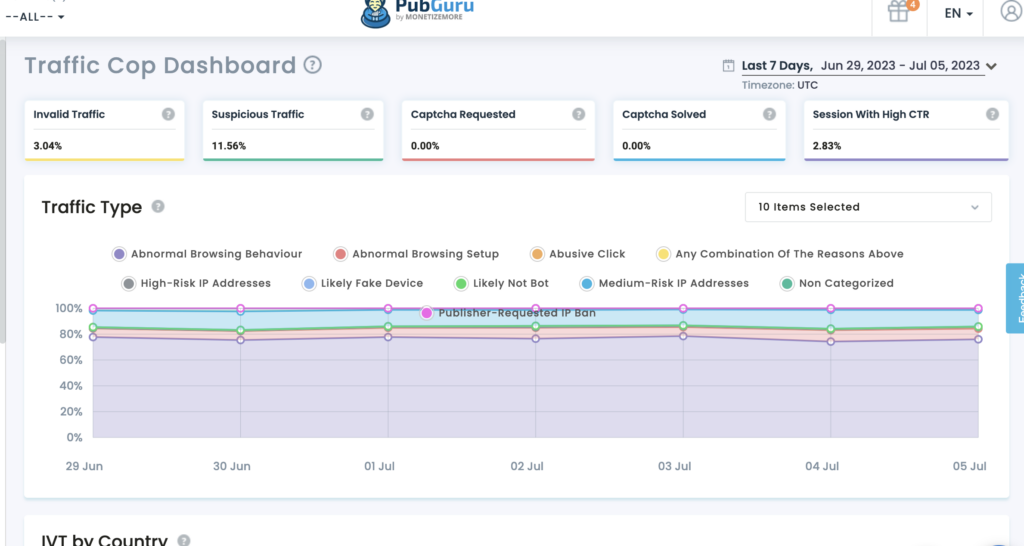

MonetizeMore の Traffic Cop は、堅牢なシールドとして機能し、スクレイピング ボットや不正アクセスからデジタル資産を効果的に保護する最先端のソリューションです。

コンテンツの保護: Traffic Cop を使用すると、貴重なコンテンツが不正なスクレイピングから保護されます。 高度な機械学習アルゴリズムにより、正規のユーザー トラフィックと悪意のあるボットを識別して区別できます。 Traffic Cop はスクレイピングの試みを効果的にブロックし、コンテンツを Web サイト専用に保ちます。

データの保護:データはオンライン ビジネスの生命線です。 Traffic Cop は、データの整合性と機密性を維持するのに役立ちます。 受賞歴のあるこのツールは、高度なアルゴリズムを採用してデータ収集アクティビティを特定してブロックし、データを確実に保護します。

Web トラフィックの保護: Web トラフィックは、あらゆるオンライン ベンチャーの成功に不可欠です。 ただし、不正なスクレイピングはリソースを枯渇させ、サイトのパフォーマンスに影響を与え、SEO の取り組みを損なう可能性があります。 Traffic Cop は、悪意のあるボットを寄せ付けず、Web トラフィックを保護する警戒心のある番兵です。 高度なボット検出メカニズムと事前対策の実装により、本物のユーザーが Web サイトに中断なくアクセスできるようになり、ユーザー エクスペリエンスが向上し、コンバージョンの可能性が最大化されます。

交通警察を選ぶ理由

- 包括的な保護: Traffic Cop はスクレイピングの試みに対して総合的なシールドを提供し、コンテンツ、データ、Web トラフィックを同時に保護します。

- 高度なボット検出:本物のユーザーと悪意のあるボットを正確に区別し、不正アクセスやスクレイピング活動を防ぎます。

- プロアクティブなセキュリティ対策:このテクノロジーは最先端のアルゴリズムを採用し、スクレイピングの試みをリアルタイムで特定してブロックし、潜在的な脅威の一歩先を進みます。

- ユーザー エクスペリエンスの強化: Traffic Cop は、Web トラフィックを保護し、悪意のあるボットを寄せ付けないようにすることで、本物のユーザーの中断のないアクセスを保証し、ユーザー エクスペリエンスを向上させ、コンバージョン率を高めます。

それ以外:

レート制限を利用する:レート制限措置を実装して、IP アドレスまたはユーザーごとのリクエスト数を制限し、ボットによるスクレイピング試行によって Web サイトが過負荷になるのを防ぎます。

レート制限は、ユーザーまたは IP アドレスが特定の時間枠内に実行できるリクエストの数を制限することにより、スクレイピング攻撃を防ぐ効果的な手法です。 適切な制限を設定することで、ボットがコンテンツをスクレイピングしようとするのを阻止しながら、本物のユーザーが確実に Web サイトにアクセスできるようにすることができます。 レート制限を実装すると、Web サイトのパフォーマンスと可用性を維持するのに役立ちます。

RSS フィードを保護する:シンジケーション用に RSS フィードを提供する場合は、認証メカニズムを追加するか API キーを実装することで、RSS フィードがスクレイピングから保護されていることを確認してください。

RSS フィードはコンテンツ シンジケーションの貴重なソースになる可能性がありますが、スクレイピング ボットのターゲットになる可能性もあります。 RSS フィードを保護するには、認証メカニズムまたは API キーを実装することが重要です。 認証を要求すると、許可されたユーザーまたはアプリケーションのみが RSS フィードにアクセスして使用できるようになります。 さらに、API キーを実装すると、フィードへのアクセスを追跡および制御し、不正なスクレイピングの試みを防ぐことができます。

これらの戦略を実装することで、ChatGPT と LLM スクレイピングのリスクを大幅に軽減し、コンテンツ、データ、Web トラフィックを保護できます。

AI 黙示録に遅れないようにするためにこれを実行してください。

ChatGPT やその他の LLM が進歩し続けるにつれて、パブリッシャーはコンテンツと Web トラフィックを保護するために、次のような重要な側面を考慮する必要があります。

- 最新情報を入手: AI および自然言語処理テクノロジーの最新の進歩について常に最新の情報を入手してください。 これは、これらのツールの潜在的なリスクと機会を理解するのに役立ちます。

- 利用規約を確認します。利用規約でスクレイピング活動が明示的に禁止されていることを確認し、これらの規約に違反した場合の結果を明記してください。

- 法的オプションを検討する:スクレイピングによる知的財産権の侵害が疑われる場合は、法律の専門家に相談して、利用可能な法的救済策を検討してください。

- 業界との連携:業界団体や組織と協力して、スクレイピングによってもたらされる課題に共同で対処し、より良い保護措置を提唱します。

これらの要素を積極的に考慮することで、パブリッシャーは、ChatGPT と新興 LLM テクノロジーの時代において、コンテンツ、データ、Web トラフィックをより適切に保護できます。

これらの重要な考慮事項に加えて、パブリッシャーは ChatGPT と LLM が視聴者のエンゲージメントに及ぼす潜在的な影響についても認識しておく必要があります。 AI によって生成されたコンテンツの台頭により、読者は自分が消費する情報の信頼性と信頼性についてより懐疑的になる可能性があります。 パブリッシャーは、AI が生成したコンテンツに明確なラベルを付け、情報源に関する透明性を提供することで、視聴者との信頼を築くための措置を講じる必要があります。

もう 1 つの重要な考慮事項は、AI によって生成されたコンテンツの潜在的な倫理的影響です。 LLM がより高度になるにつれて、生成されたコンテンツが偏見や誤った情報を永続させないようにする必要があります。 出版社はガイドラインを確立し、AI によって生成されたコンテンツが編集基準と価値観に沿っていることを確認するプロセスをレビューする必要があります。

さらに、AI によって生成されたコンテンツを取り巻く法的状況の進化にも留意してください。 これらのテクノロジーがさらに普及するにつれて、その使用を管理するための新しい規制や法的枠組みが導入される可能性があります。 こうした動向を常に把握し、法律の専門家に相談することは、パブリッシャーが AI 生成コンテンツの法的な複雑さに対処するのに役立ちます。

結論

ChatGPT スクレイピングからコンテンツ、データ、Web トラフィックを保護することは、ビジネスの整合性を維持する上で非常に重要です。 これは収益とユーザー エクスペリエンスを脅かし、オンラインでの知名度と評判に影響を与えます。 スクレイピングのプロセスを理解し、保護措置を導入し、法的選択肢を検討し、コラボレーションを促進することで、パブリッシャーはコンテンツを保護し、AI 主導のスクレイピングに関連するリスクを軽減できます。

MonetizeMore の Traffic Cop は、コンテンツ、データ、Web トラフィックを安全に保つための包括的なソリューションを提供します。 Traffic Cop は、高度なボット検出とプロアクティブなセキュリティ対策を活用することで、デジタル資産を効果的に保護しながら、コア ビジネスに集中できるようにします。

今すぐ Traffic Cop を利用し、あなたのオンライン プレゼンスが不正なスクレイピングから保護されていることを知って安心してください。

Aleesha Jacob は、SAAS ビジネスのコンバージョンを促進するデータ駆動型コンテンツの作成に 7 年以上の経験を持つ、経験豊富な B2B コンテンツおよび SEO マネージャーです。 BMW やハイネケンなどのアドテク企業やクライアントと協力してきたアリーシャは、豊富な専門知識をもたらします。 魅力的なコンテンツを作成する比類のないスキルにより、彼女はあらゆる規模の企業がより多くの見込み客を獲得し、収益を増やし、オンラインでの存在感を高めるのを支援しています。