クロール バジェットとは何か、最適化する方法

公開: 2022-11-25

検索エンジン ボットのしくみを初めて知ったとき、クロール バジェットはなじみのない概念のように思えるかもしれません。 最も簡単な SEO の概念ではありませんが、見た目ほど複雑ではありません。 クロール バジェットとは何か、検索エンジンのクロールがどのように機能するかを理解し始めたら、クロール可能性を最適化するために Web サイトの最適化を開始できます。 このプロセスは、サイトが Google の検索結果でランキングされる可能性を最大限に高めるのに役立ちます。

クロール バジェットとは

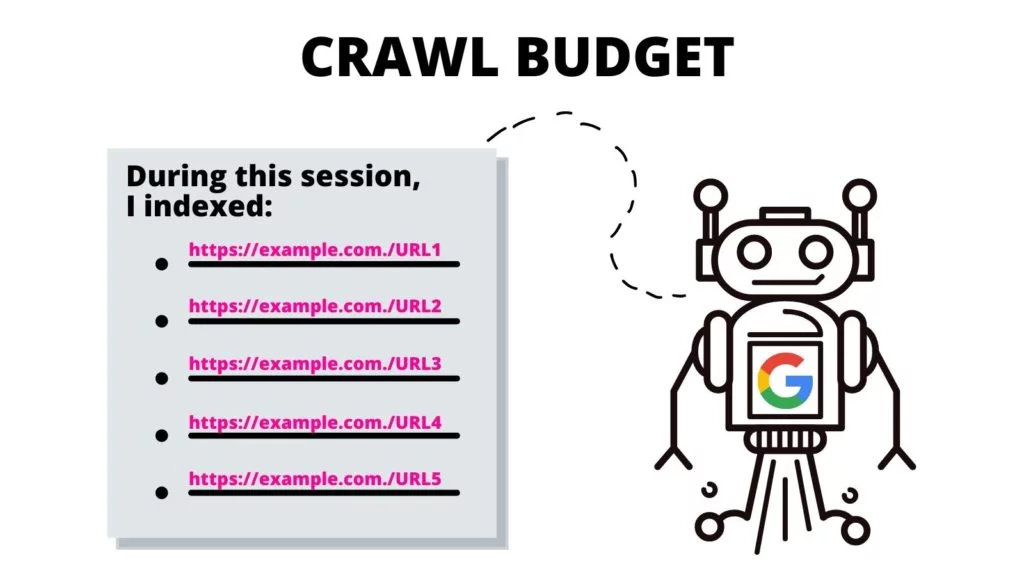

クロール バジェットとは、検索エンジン ボットが 1 回のインデックス作成セッション内でインデックス化できる 1 つの Web サイトの URL の数です。 クロール セッションの「予算」は、個々のサイトのサイズ、トラフィック メトリック、およびページの読み込み速度に基づいて、Web サイトごとに異なります。

ここまで読んで SEO 用語に慣れていない場合は、 SEO 用語集を使用して定義に慣れてください。

Web サイトのクロール バジェットに影響を与える要因は何ですか?

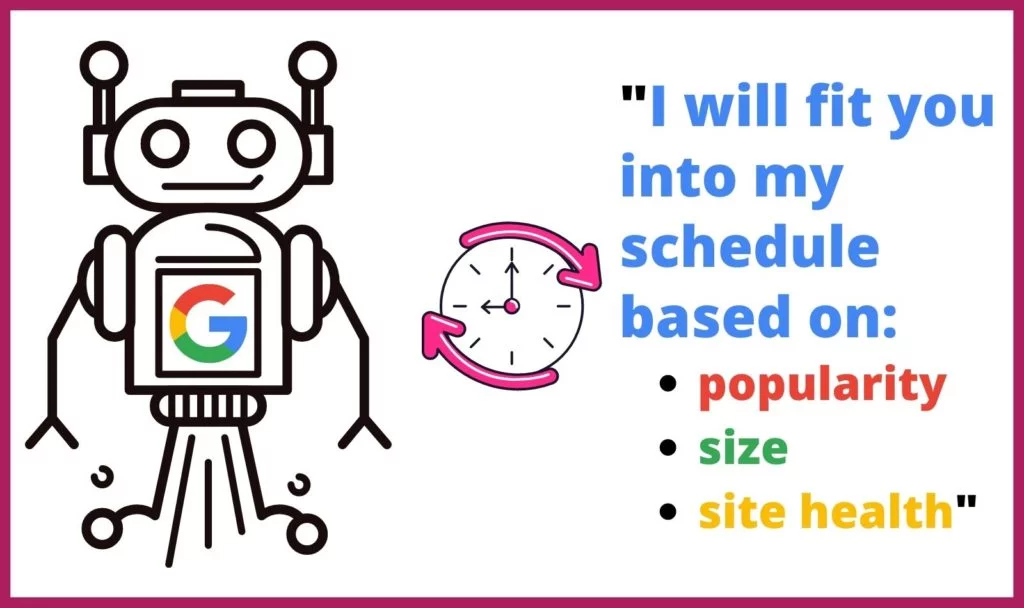

Google は、インターネット上のすべての Web サイトに対して同じ時間や回数のクロールを行っているわけではありません。 また、Web クローラーは、いくつかの要因に基づいて、クロールするページとその頻度を決定します。 以下に基づいて、各サイトをクロールする頻度と期間を決定します。

Google は、インターネット上のすべての Web サイトに対して同じ時間や回数のクロールを行っているわけではありません。 また、Web クローラーは、いくつかの要因に基づいて、クロールするページとその頻度を決定します。 以下に基づいて、各サイトをクロールする頻度と期間を決定します。

- 人気:サイトやページへのアクセスが多いほど、更新のために分析する頻度が高くなります。 さらに、より人気のあるページは、より多くのインバウンドリンクをより迅速に獲得します。

- サイズ:データ量の多い要素を含む大規模な Web サイトやページは、クロールに時間がかかります。

- 健全性/問題: Web クローラーが内部リンクを通じて行き止まりに達すると、新しい開始点を見つけるのに時間がかかるか、クロールを中止します。 404 エラー、リダイレクト、および読み込み時間の遅さは、Web クローラーの速度を低下させ、妨害します。

クロール バジェットは SEO にどのように影響しますか?

Webcrawlerのインデックス作成プロセスにより、検索が可能になります。 コンテンツが見つからず、Google の Web クローラーによってインデックスに登録されない場合、Web ページと Web サイトは検索者に発見されません。 これにより、サイトは多くの検索トラフィックを逃すことになります。

Google が Web サイトをクロールする理由

Googlebot は、ウェブサイトのページを体系的に調べて、そのページとウェブサイト全体の内容を判断します。 ウェブクローラーは、コンテンツとともに URL のキャッシュを作成するために、そのウェブサイトのデータをページごとに処理、分類、整理します。これにより、Google は検索クエリに応じてどの検索結果を表示するかを決定できます。

さらに、Google はこの情報を使用して、検索クエリに最も適した検索結果を決定し、各検索結果を階層検索結果リストのどこに表示するかを決定します。

クロール中に何が起こるか?

Google は、Googlebot がウェブサイトを処理するために一定の時間を割り当てます。 この制限により、ボットは 1 回のクロール セッションでサイト全体をクロールしない可能性があります。 代わりに、robots.txt ファイルやその他の要因 (ページの人気度など) に基づいて、サイトのすべてのページを処理します。

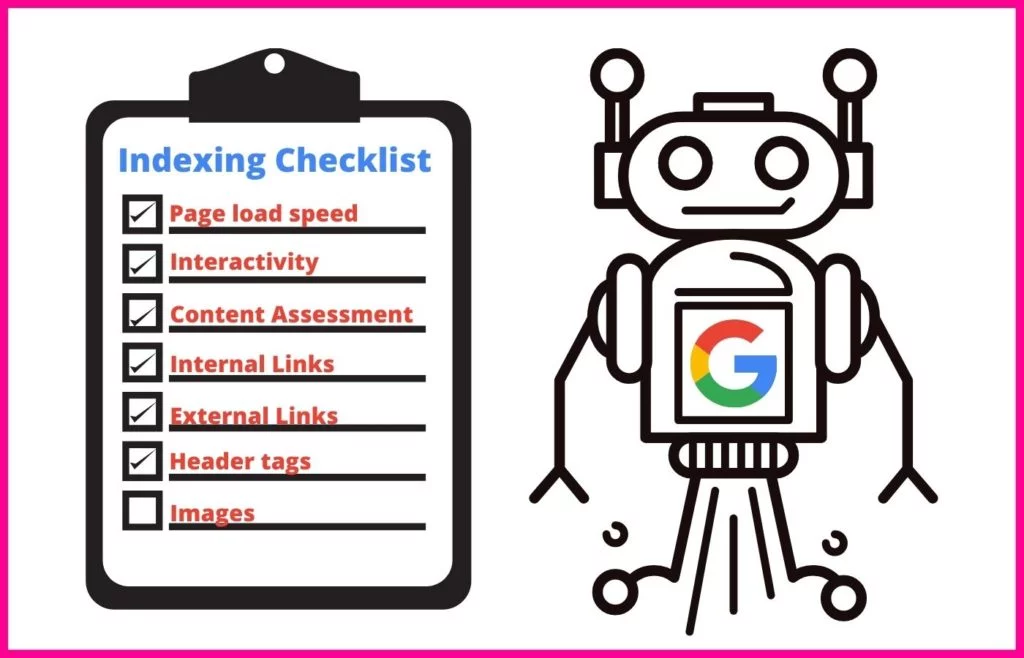

クロール セッション中、Googlebot は体系的なアプローチを使用して、処理する各ページのコンテンツを理解します。

これには、次のような特定の属性のインデックス作成が含まれます。

- メタタグとNLP を使用してその意味を判断する

- リンクとアンカー テキスト

- 画像検索および動画検索用のリッチ メディア ファイル

- スキーマ マークアップ

- HTML マークアップ

Web クローラーは、ページ上のコンテンツが正規のコンテンツと重複しているかどうかを判断するためのチェックも実行します。 その場合、Google はその URL を優先度の低いクロールに移動します。これにより、ページを頻繁にクロールして時間を無駄にすることがなくなります。

クロール レートとクロール デマンドとは何ですか?

Google の Web クローラーは、実行するすべてのクロールに一定の時間を割り当てます。 Web サイトの所有者として、この時間を制御することはできません。 ただし、サイト上での個々のページのクロール速度は変更できます。 この数値はクロール レートと呼ばれます。

クロール需要は、Google がサイトをクロールする頻度です。 この頻度は、インターネット ユーザーによるサイトの需要と、検索でサイトのコンテンツを更新する必要がある頻度に基づいています。 ログ ファイル分析を使用して、Google がサイトをクロールする頻度を確認できます (以下の #2 を参照)。

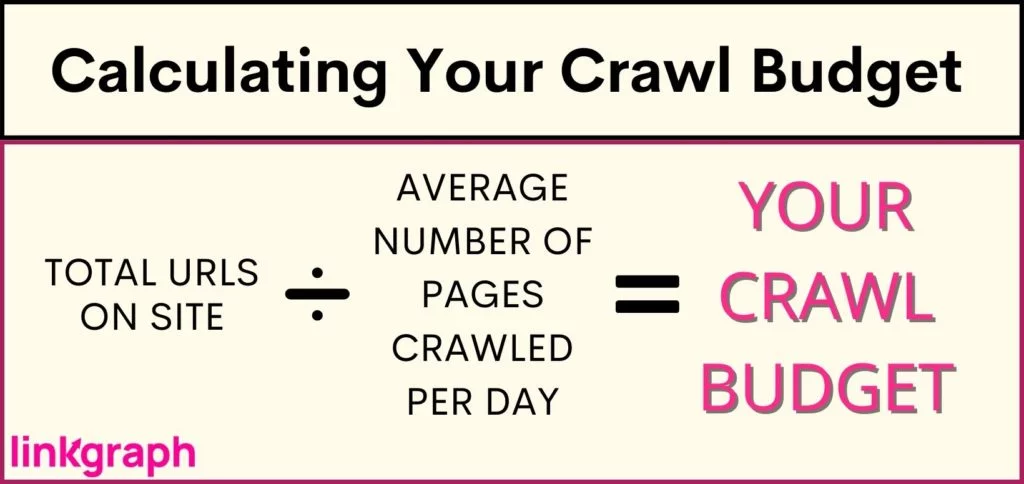

サイトのクロール バジェットを決定するにはどうすればよいですか?

Google はサイトをクロールする回数と期間を制限しているため、クロール バジェットを把握しておく必要があります。 ただし、Google はサイト所有者にこのデータを提供しません。予算が非常に限られているため、新しいコンテンツがタイムリーに SERP に表示されない場合は特にそうです。 これは、重要なコンテンツや、収益を上げられる製品ページなどの新しいページにとって悲惨な結果になる可能性があります。

サイトがクロール バジェットの制限に直面しているかどうかを理解する (またはサイトが A-OK であることを確認する) には、次のことを行う必要があります。 サイトにある URL の数のインベントリを取得します。 Yoast を使用している場合、合計はサイトマップ URLの上部に表示されます。

クロール バジェットを最適化するにはどうすればよいですか?

サイトがクロール バジェットに対して大きくなりすぎた場合、クロール バジェットの最適化に飛び込む必要があります。 サイトをより頻繁に、またはより長時間クロールするように Google に指示することはできないため、制御できることに集中する必要があります。

クロール バジェットの最適化には、多面的なアプローチとGoogle のベスト プラクティスの理解が必要です。 クロール レートを最大限に活用するには、どこから始めればよいでしょうか。 この包括的なリストは階層順に書かれているので、一番上から始めてください。

1. サイトのクロール レート制限を引き上げることを検討する

Google はサイトの複数のページに同時にリクエストを送信します。 ただし、Google は礼儀正しく、サーバーを停止させないように努めているため、サイト訪問者の読み込み時間が遅くなります。 サイトがどこからともなく遅れていることに気付いた場合は、これが問題である可能性があります。

ユーザー エクスペリエンスへの影響に対処するために、Google ではクロール レートを下げることを許可しています。 これにより、Google が同時にインデックスに登録できるページ数が制限されます。

興味深いことに、Google ではクロール レートの上限を上げることもできます。つまり、一度により多くのページをプルできるため、一度にクロールされる URL が増えます。 ただし、すべてのレポートは、クロール レート制限の引き上げに対する Google の対応が遅いことを示唆しており、Google がより多くのサイトを同時にクロールすることを保証するものではありません。

クロール レート制限を引き上げる方法:

- Search Console で [設定] に移動します。

- そこから、クロール レートが最適かどうかを確認できます。

- その後、制限を 90 日間、より高速なクロール レートに引き上げることができます。

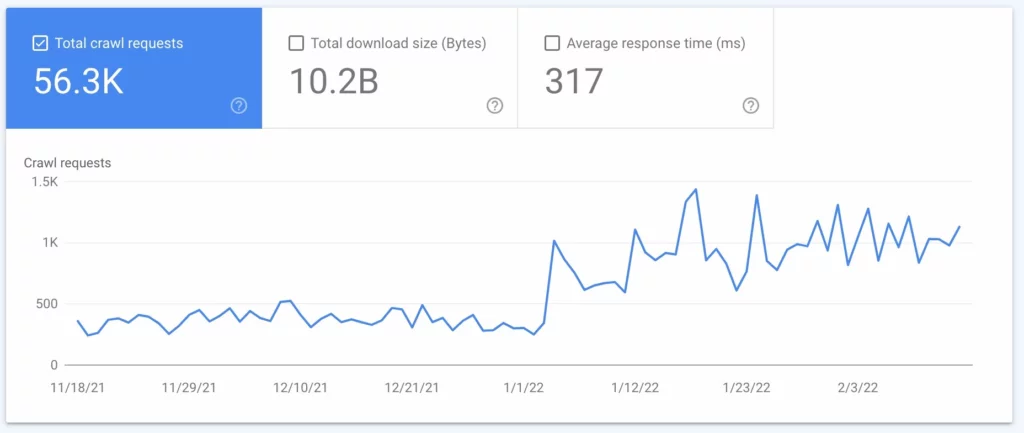

2. ログ ファイル分析の実行

ログ ファイル分析は、サーバーに送信されたすべての要求を反映するサーバーからのレポートです。 このレポートでは、Googlebot がサイトで何を行っているかを正確に知ることができます。 多くの場合、このプロセスはテクニカル SEO によって実行されますが、サーバー管理者に相談して取得することができます。

ログ ファイル分析またはサーバー ログ ファイルを使用すると、次のことがわかります。

- Google がサイトをクロールする頻度

- 最もクロールされるページ

- サーバーコードが応答しない、または欠落しているページ

この情報を取得したら、それを使用して #3 から #7 を実行できます。

3. XML サイトマップと Robots.txt を最新の状態に保つ

Google が SERP に表示したくないページのクロールに多くの時間を費やしていることがログ ファイルに示されている場合は、Google のクローラーにこれらのページをスキップするようリクエストできます。 これにより、より重要なページのためにクロール バジェットの一部が解放されます。

サイトマップ(Google Search Console またはSearchAtlasから取得できます) は、検索結果に表示されるように、Google にインデックスしてもらいたいサイト上のすべてのページのリストを Googlebot に提供します。 検索エンジンに見つけてもらいたいすべての Web ページでサイトマップを最新の状態に保ち、検索エンジンに見つけてほしくないページを除外することで、Web クローラーがサイトで費やす時間を最大限に増やすことができます。

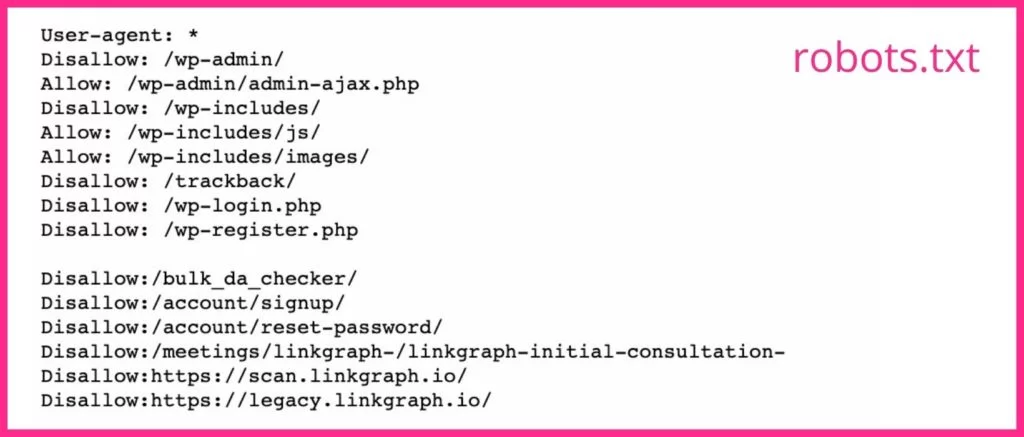

robots.txt ファイルは、クロールするページとクロールしないページを検索エンジンのクローラーに伝えます。 適切なランディング ページにならないページやゲートされたページがある場合は、robots.txt ファイル内の URL にnoindex タグを使用する必要があります。 Googlebot は、noindex タグを含むウェブページをスキップする可能性があります。

4. リダイレクトとリダイレクト チェーンを減らす

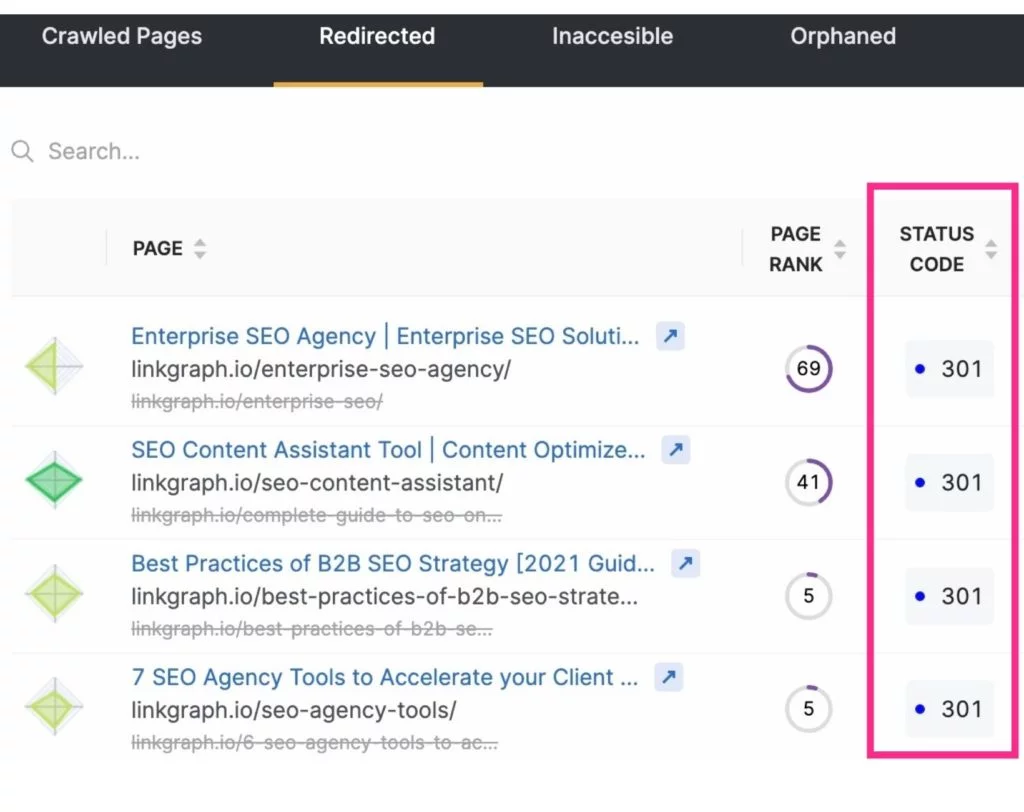

検索エンジンのクロールから不要なページを除外してクロール バジェットを解放することに加えて、リダイレクトを削減または排除することでクロールを最大化することもできます。 これらは、3xx ステータス コードになる任意の URL です。

サーバーはリダイレクトに応答してから新しいページを取得する必要があるため、リダイレクトされた URL を Googlebot が取得するのに時間がかかります。 1 回のリダイレクトにかかる時間はわずか数ミリ秒ですが、合計すると数ミリ秒かかります。 また、これにより、サイトのクロールに全体的に時間がかかる可能性があります. Googlebot が一連の URL リダイレクトに遭遇すると、この時間は倍増します。

リダイレクトとリダイレクト チェーンを減らすには、コンテンツ作成戦略に注意し、スラッグのテキストを慎重に選択してください。

5.壊れたリンクを修正する

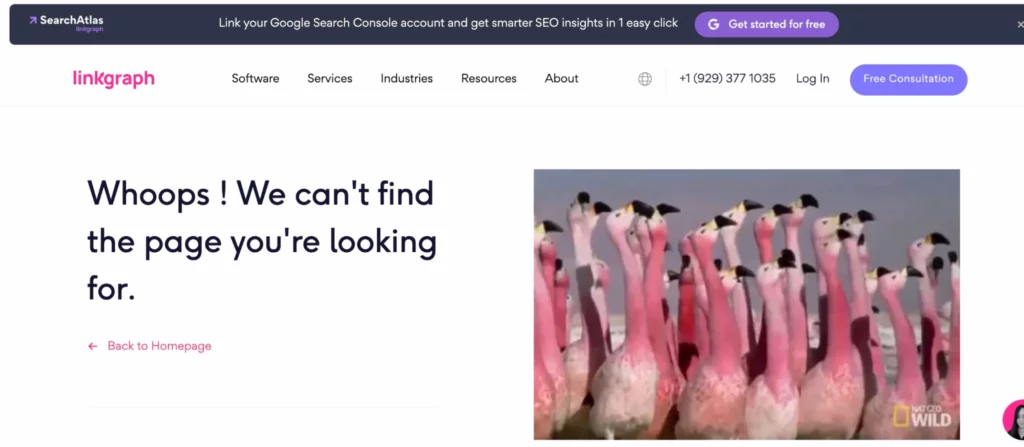

Google がよくサイトを探索する方法は、内部リンク構造を介して移動することです。 ページを処理する際に、リンクが存在しないページにつながるかどうかを通知します (これは、多くの場合、ソフト 404 エラーと呼ばれます)。 次に、そのページのインデックス作成に時間を無駄にしたくないので、先に進みます。

ユーザーまたは Googlebot を実際のページに移動するには、これらのページへのリンクを更新する必要があります。 または (信じがたいことですが)、ページが実際に存在するにもかかわらず、Googlebot がそのページを 4xx または 404 エラーと誤認した可能性があります。 このような場合は、URL にタイプミスがないことを確認してから、Google Search Console アカウントからその URL のクロール リクエストを送信してください。

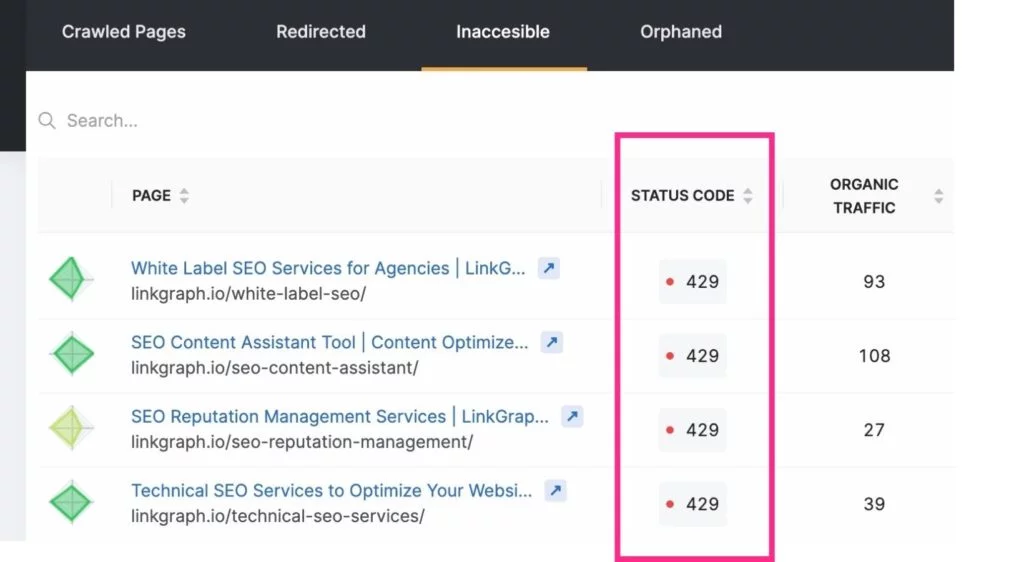

これらのクロール エラーを最新の状態に保つには、Google Search Console アカウントの [インデックス] > [カバレッジ レポート] を使用できます。 または、 SearchAtlasのサイト監査ツールを使用してサイト エラー レポートを見つけ、Web 開発者に渡します。

注:新しい URL はすぐにログ ファイル分析に表示されない場合があります。 クロールをリクエストする前に、Google がそれらを見つけるまでしばらく待ちます。

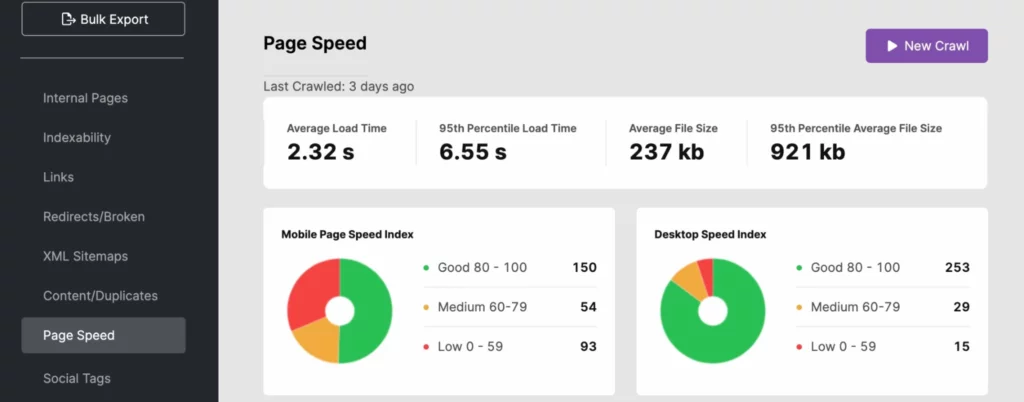

6. ページ読み込み速度の改善に取り組む

検索エンジン ボットは、サイト内を高速で移動できます。 ただし、サイトの速度が標準に達していない場合、クロールの予算に大きな負担がかかる可能性があります. ログ ファイル分析、 SearchAtlas 、または PageSpeedInsights を使用して、サイトの読み込み時間が検索の可視性に悪影響を及ぼしているかどうかを判断します。

サイトの応答時間を改善するには、動的 URL を使用し、 Google の Core Web Vitals のベスト プラクティスに従ってください。 これには、フォールド上のメディアの画像最適化が含まれる場合があります。

サイトの速度の問題がサーバー側にある場合は、次のような他のサーバー リソースに投資することをお勧めします。

- 専用サーバー (特に大規模サイトの場合)

- 新しいサーバー ハードウェアへのアップグレード

- RAM の増加

サイトの速度は PageRank のシグナルであるため、これらの改善によりユーザー エクスペリエンスが向上し、Google 検索でのサイトのパフォーマンスが向上します。

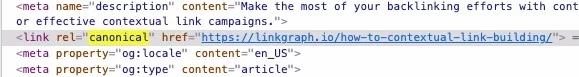

7. Canonical タグの使用を忘れないでください

重複したコンテンツは、少なくとも重複したコンテンツにソース ページがあることを認めていない場合は、Google に嫌われます。 なんで? Googlebot は、特に指示がない限り、やむを得ない場合を除き、すべてのページをクロールします。 ただし、重複したページや使い慣れたもののコピー (ページ上またはオフサイト) に遭遇すると、そのページのクロールを停止します。 これにより時間が節約されますが、正規 URL を識別する正規タグを使用することで、クローラーの時間をさらに節約する必要があります。

Canonicalsは、クロール期間を使用してそのコンテンツをインデックスに登録しないように Googlebot に指示します。 これにより、検索エンジン ボットが他のページを調べる時間が増えます。

8. 内部リンク構造に注目する

サイト内で適切に構造化されたリンクを実践することで、Google クロールの効率を高めることができます。 内部リンクは、サイトのどのページが最も重要であるかを Google に伝え、これらのリンクはクローラーがページを見つけやすくするのに役立ちます。

最適なリンク構造は、ユーザーと Googlebot をウェブサイト全体のコンテンツに結び付けます。 常に関連するアンカー テキストを使用し、コンテンツ全体に自然なリンクを配置してください。

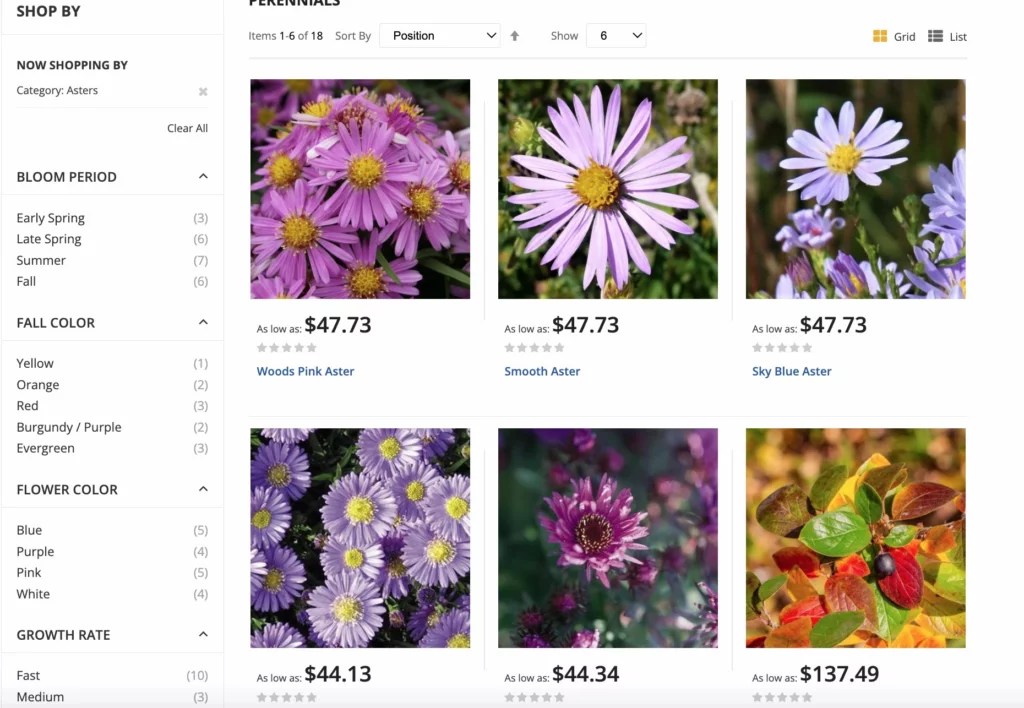

e コマース サイトの場合、Googleには、クロールを最大化するためのファセット ナビゲーション オプションのベスト プラクティスがあります。 ファセット ナビゲーションにより、サイト ユーザーは属性で商品をフィルタリングできるため、ショッピングがより快適になります。 この更新により、過剰な URL クロールに加えて、正規の混乱や重複の問題を回避できます。

9. 不要なコンテンツを削除する

Googlebot は、サイトをクロールするたびに非常に高速に移動し、非常に多くのページをインデックスに登録できます。 トラフィックを受け取らないページや、古いコンテンツや低品質のコンテンツを含むページが多数ある場合は、それらをカットしてください。 剪定プロセスにより、サイトの重荷になる可能性のある余分な荷物を切り取ることができます。

サイトに過剰なページがあると、Googlebot が重要でないページに誘導され、ページが無視される可能性があります。

クロール エラーが発生しないように、すべてのリンクをこれらのページにリダイレクトすることを忘れないでください。

10. バックリンクを増やす

Googlebot がサイトに到着すると、内部リンクに基づいてページのインデックス作成を開始するのと同じように、インデックス作成プロセスで外部リンクも使用します。 他のサイトがあなたのサイトにリンクしている場合、Googlebot はリンク元のコンテンツをよりよく理解するために、あなたのサイトに移動してページをインデックスに登録します。

さらに、被リンクはサイトの人気と最新性を高めます。Google はこれを使用して、サイトをインデックスに登録する必要がある頻度を決定します。

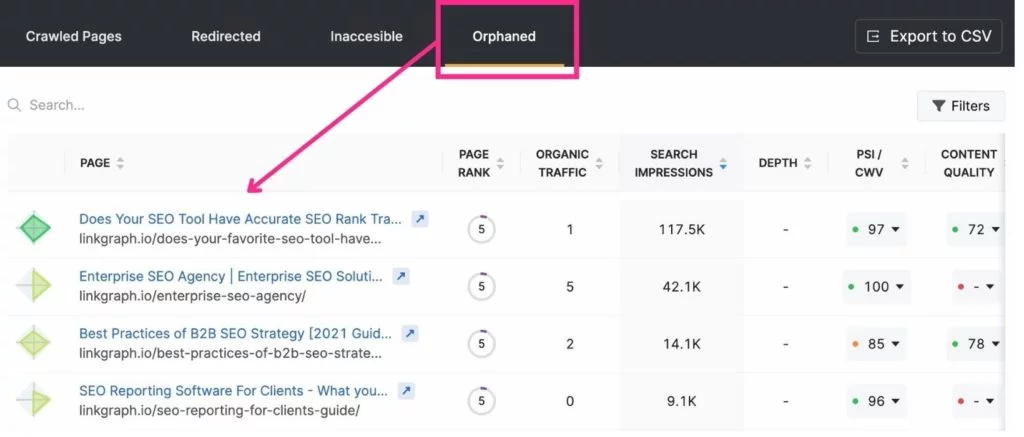

11.孤立したページを排除する

Google のクローラーは内部リンクを介してページ間を移動するため、リンク先のページを簡単に見つけることができます。 ただし、サイトのどこかにリンクされていないページは、Google に気付かれないことがよくあります。 これらは「孤立したページ」と呼ばれます。

孤立したページが適切な場合は? 非常に具体的な目的またはオーディエンスを持つランディング ページの場合。 たとえば、マイアミに住むゴルファーにのみ適用されるランディング ページを含む電子メールを送信する場合、別のページからのリンクを希望しない場合があります。

クロール バジェットの最適化に最適なツール

クロール バジェットの最適化に関しては、Search Console と Google アナリティクスが非常に役立ちます。 Search Console では、クローラーにページのインデックス登録とクロール統計の追跡をリクエストできます。 Google アナリティクスは、内部リンクの旅を追跡するのに役立ちます。

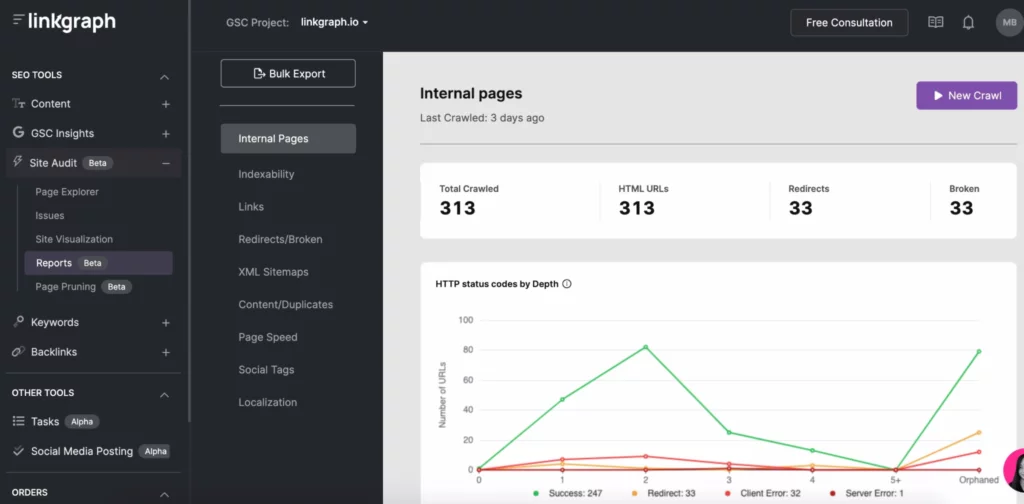

SearchAtlas などの他の SEO ツールを使用すると、Site Audit ツールを使用してクロールの問題を簡単に見つけることができます。 1 つのレポートで、サイトの次の情報を確認できます。

- インデクサビリティ クロール レポート

- 索引の深さ

- ページ速度

- 重複コンテンツ

- XML サイトマップ

- リンク

クロール バジェットを最適化し、検索エンジンのトップ パフォーマーになる

検索エンジンがサイトをインデックスする頻度や期間を制御することはできませんが、サイトを最適化して、検索エンジンの各クロールを最大限に活用することはできます。 サーバー ログから始めて、Search Console のクロール レポートを詳しく見てみましょう。 次に、クロール エラー、リンク構造、ページ速度の問題を修正します。

GSC のクロール アクティビティを進めている間は、リンクの構築や質の高いコンテンツの追加など、残りの SEO 戦略に集中してください。 時間が経つにつれて、ランディング ページが検索エンジンの結果ページを上っていくのがわかります。