SEOチェックリストの主な構成要素は何ですか

公開: 2022-05-22効果的なページ上のSEO要因に関しては、これらの7つのポイントは技術的なSEOチェックリストに不可欠です。 SEOは単にキーワードの研究やコンテンツに関するものではありません。 それはさらに進んでおり、SEOマーケターは、最大のオーガニックトラフィックを獲得し、検索エンジンで上位にランク付けするために、SEOマーケティングのためのある程度の技術的なSEOノウハウを持っている必要があります。

これが2020年のSEOページで最高の7ポイントの技術的なSEOチェックリストです。ここではSEOチェックリストの主要なコンポーネントは何ですか-

リッチスニペット

リッチスニペットは「リッチリザルト」とも呼ばれます。 これらは、追加データとともに表示される検索結果です。 検索エンジンにキャプションを付けて強調表示するデータは、最初にスキーママークアップツールを使用して生成する必要があるため、このためのHTMLのノウハウが少し必要です。 生成されたスクリプトは、Webページの頭と体の領域の間にアップロードする必要があります。 これにより、検索エンジンがページのコンテンツを簡単に読み取って理解できるようになります。 一般的なリッチスニペットの種類には、レビュー、レシピ、イベントが含まれます。 これは、2020年のSEOマーケティングのトレンドのページ上のSEO要因です。

正規化

ウェブサイトの異なるリンクに同じコンテンツがある場合...正規タグは、検索エンジンにそれらを1つとして表示するように指示する方法です。 正規タグを付けることにより、検索エンジンがコンテンツを重複または繰り返しと見なさないことが保証されます。正規タグは、特定のURLがページのマスターコピーを表すことを検索エンジンに伝える方法です。 「relcanonical」で示されます。canonicalタグを使用すると、検索結果に表示するURLのバージョンを検索エンジンに指示できます。 正規化も重要なページ上のSEO要因であり、SEOマーケティングの技術的なSEOチェックリストに含まれている必要があります。

サイトマップ

サイトマップは、検索エンジンがWebサイトのすべてのコンテンツを検索、クロール、およびインデックス作成するのに役立つWebサイトの青写真です。 サイトマップは、サイトのどのページが最も重要かを検索エンジンに伝えます。 サイトマップは、特定のページにインデックスを付けるように検索エンジンを管理または義務付けていませんが、インデックスを作成したいWebサイトに関連性のあるコンテンツがあることを検索エンジンに通知する方法です。

サイトマップには、主に4つのタイプがあります。

- 通常のXMLサイトマップ

- ビデオサイトマップ

- ニュースサイトマップ

- 画像サイトマップ。

サイトマップは、技術的なページ上のSEOチェックリストに含まれている必要があります

301リダイレクト

301リダイレクトは、特定のリンクが他のURLに永続的に移動されたことを検索エンジンに通知する永続的なリダイレクトです。 ほとんどの場合、301リダイレクトは、Webサイトにリダイレクトを実装するための最良の方法です。 301を提供すると、ブラウザと検索エンジンボットの両方に、ページが永続的に移動したことが示されます。 検索エンジンはこれを、ページの場所が変更されただけでなく、コンテンツ(またはその更新バージョン)が新しいURLで見つかることを意味すると解釈します。

404エラー

404 Page Not Foundエラーをよく知っている必要があります。これは、アクセスしようとしているWebページが移動または削除されたことを示しています。 ほとんどのページはこのエラーのままになりますが、効果的なSEOの観点から、可能な限り最も創造的な方法で、Webサイトの冗長なページを利用することをお勧めします。 提案のいくつかは、面白い404 not foundメッセージを作成し、連絡先情報を表示し、アクティブなWebサイトのリンクを含めるなどです。

ジオタグ

ジオタグは、地元のお店やサービスをオンラインで見つけたい場合に非常に役立ちます。 ジオタグは、特定の場所でWebサイト、コンテンツ、RSSフィードなどにタグを付けることができる手法です。 緯度と経度を使用して、視聴者に自分がどこにいるか、何かがどこにあるかを正確に知らせることができます。 経度と緯度以外の要素を使用して、説明、タイトル、名前などを追加するなど、よりパーソナライズすることができます。

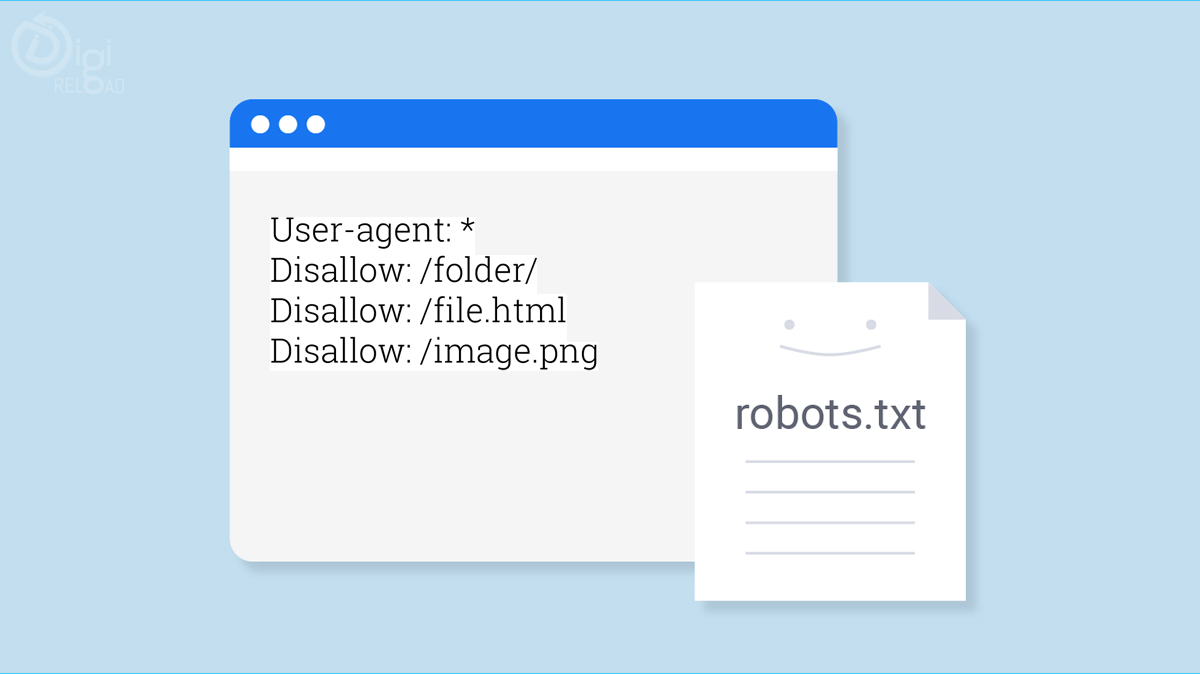

Robots.txt

簡単に言うと、Robots.txtは、Webサイトのページをクロールする方法に関するWebロボットへの指示です。 robots.txtを使用して、クロールするページとスキップするページをWebクローラーに指示します。 これらのクロール命令は、すべてのユーザーエージェントの動作を「禁止」または「許可」することで指定されます。