BERT: 몇 년 만에 Google의 최대 업데이트

게시 됨: 2022-12-01Google의 BERT는 2019년 말에 가동되었으며 모든 검색의 거의 10%에 영향을 미쳤습니다. 아마도 2019년 가장 큰 알고리즘 업데이트 중 하나일 것입니다. 여기 SEO와 사이트 소유자가 Google의 고급 자연어 처리 모델에 대해 알아야 할 모든 것이 있습니다.

구글의 BERT란?

BERT는 딥 러닝 알고리즘 이며 Bidirectional Encoder Representations from Transformers의 줄임말입니다. 이 알고리즘은 복잡한 검색 쿼리에 대해 보다 관련성 높은 결과를 표시하는 데 도움이 되었습니다.

BERT 알고리즘 업데이트가 Google 검색에 미친 영향은 무엇입니까?

구글은 이렇게 말했습니다.

“BERT는 검색에서 단어의 뉘앙스와 맥락을 더 잘 이해하고 이러한 쿼리를 유용한 결과와 더 잘 일치시키는 데 도움이 될 수 있기 때문에 이러한 개선 사항은 특히 자연어/대화 쿼리에 대한 언어 이해 향상에 중점을 둡니다.

특히 더 길고 더 많은 대화형 쿼리 또는 "for" 및 "to"와 같은 전치사가 의미에 매우 중요한 검색의 경우 검색에서 검색어의 컨텍스트를 이해할 수 있습니다. 자연스럽게 느껴지는 방식으로 검색할 수 있습니다.”

실제로 Google에 따르면 BERT 업데이트는 미국 내 영어 검색 10건 중 1건, 즉 검색어의 10%에 영향을 미칠 것입니다. 적어도 그들에 따르면 이것은 지난 5년 동안 Google의 가장 중요한 업데이트입니다.

우리는 검색어를 이해하는 방법을 크게 개선하고 있으며, 지난 5년 동안 가장 큰 도약이자 검색 역사상 가장 큰 도약 중 하나입니다.

BERT의 도입으로 새로운 알고리즘을 배포한 첫 주에 큰 순위 변동이 발생했습니다. Webmaster World의 SEO는 RankBrain 이후 SEO 세계를 강타한 가장 큰 순위 변동에 주목하면서 이번 주 초부터 변동에 대해 논평했습니다.

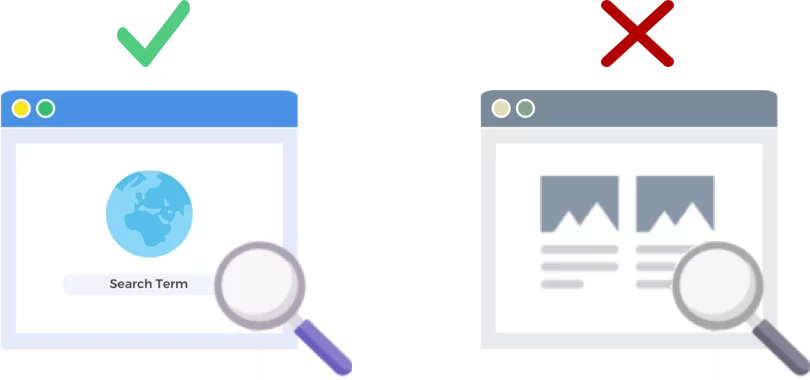

BERT는 웹페이지가 아닌 검색 쿼리를 분석합니다.

BERT 알고리즘의 2019년 10월 24일 릴리스는 거대 검색 엔진이 검색 쿼리(웹 페이지가 아님)를 분석하고 이해하는 방법을 개선합니다.

BERT는 어떻게 작동합니까?

BERT는 양방향(BERT의 B) 컨텍스트 모델을 사용하여 검색 쿼리에 대한 Google의 이해를 향상시킵니다. Google은 실제로 작년 이맘때 BERT를 자연어 처리(NLP) 사전 교육을 위한 새로운 기술로 발표했을 때 BERT의 메커니즘에 대해 약간 이야기했습니다.

사전 교육이란 무엇입니까? 사전 훈련은 실제로 작업을 맡기기 전에 기계에 작업 수행 방법을 가르치는 것입니다. 전통적으로 사전 교육 데이터 세트에는 사람이 레이블을 지정한 수천에서 수십만 개의 예제가 로드됩니다.

Pre-training은 비트를 위해 주변에 있었지만 BERT를 특별하게 만드는 것은 문맥(각 단어의 의미가 주변 단어에 따라 변경됨)과 양방향(단어의 의미는 단어의 의미가 Before it과 두 단어를 기반으로 이해됨)이라는 것입니다. 그 후에.

Google 블로그에 따르면:

“ I access the bank account ” 문장에서 단방향 컨텍스트 모델은 “ I access the ”를 기반으로 “ bank ”를 나타내지만 “ account ”는 나타내지 않습니다. 그러나 BERT는 이전 컨텍스트와 다음 컨텍스트를 모두 사용하여 " 은행 "을 나타냅니다. 즉, 심층 신경망의 맨 아래에서 시작하여 깊이 양방향으로 만드는 "... 계정 에 액세스했습니다 "입니다.

Google BERT 업데이트는 기계 학습 및 엔터티 인식의 최근 발전을 기반으로 합니다. 기본적으로 BERT는 Google이 검색을 처리하기 전에 품사와 단어의 맥락을 모두 식별하는 데 도움이 됩니다.

검색 결과에서 BERT는 무엇을 의미합니까?

Google에 따르면 이는 사용자가 사용자의 검색 의도와 더 잘 일치하는 더 관련성 높은 결과를 보기 시작한다는 것을 의미합니다. 이 알고리즘 개선은 일반 결과와 리치 스니펫 결과에 걸쳐 있습니다.

Google은 BERT를 알리는 블로그 항목에서 몇 가지 유용한 예를 제공했습니다.

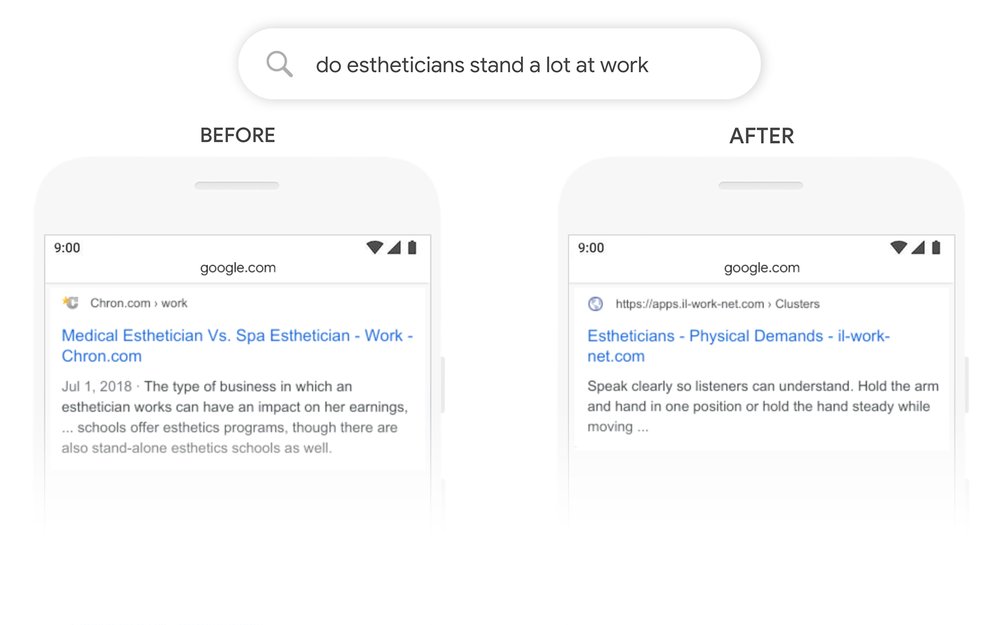

미용사의 예

먼저 미용사가 작업의 일부로 서서 많은 시간을 보내는지 이해하려는 사용자가 있습니다.

아래에서 BERT Google이 "미용사는 일을 많이 하는가"라는 쿼리를 읽고 미용사의 작업 환경 유형을 비교한 결과를 생성한 것을 볼 수 있습니다.

BERT 이후 Google은 검색자가 원래 표시하려고 했던 정보와 훨씬 더 일치하는 미용사가 되기 위한 신체적 요구 사항에 대한 기사를 표시합니다.

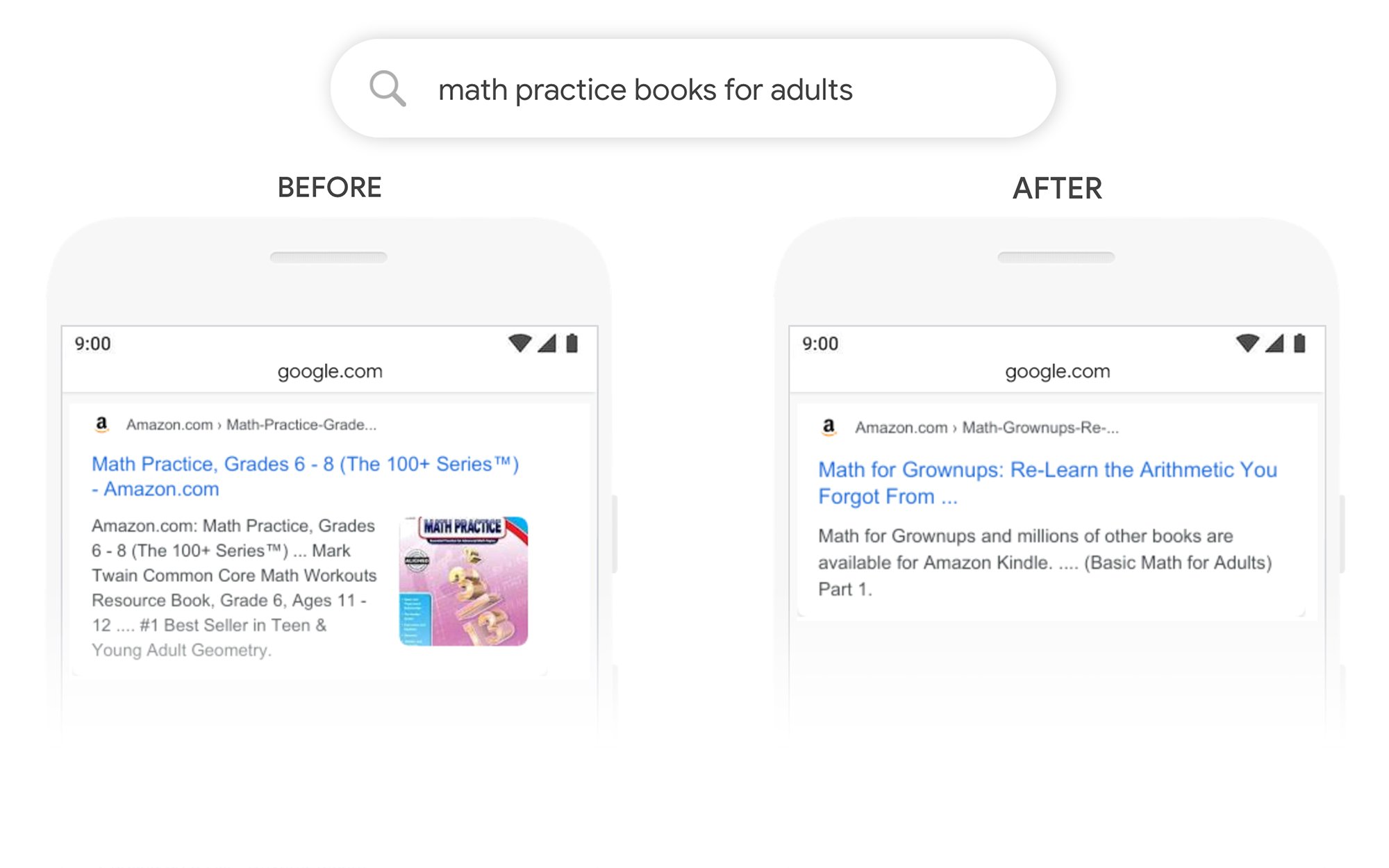

수학 연습 책 예

이 예에서 사용자는 성인을 위한 수학 연습 책을 찾고 있지만 어린이를 위한 수학 연습 책을 표시합니다.

BERT 이후 Google은 검색어의 컨텍스트를 올바르게 인식하여 "성인용" 검색의 두 번째 부분을 더 잘 설명합니다.

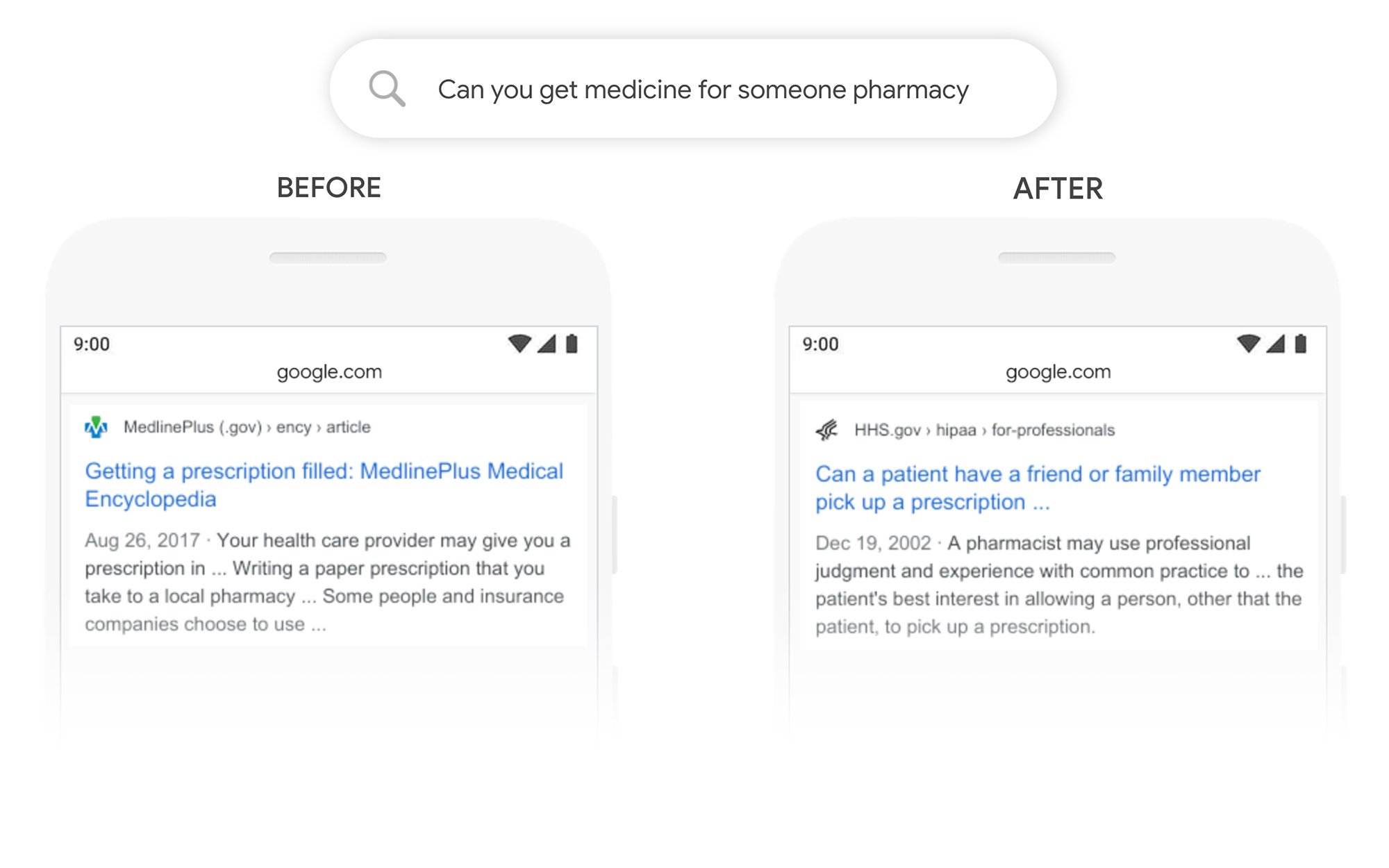

다른 사람을 위해 약을 주울 수 있습니까? 예

이 예에서 "약국을 위해 약을 받을 수 있습니까?"라는 쿼리는 타사를 위해 처방전을 조제하는 방법이 아니라 일반적으로 처방전을 조제하는 방법에 대한 결과를 반환합니다. BERT 이후 Google은 사용자의 목표를 더 잘 이해하고 환자가 친구나 가족에게 처방전을 받도록 할 수 있는지 여부에 대한 정보를 표시합니다.

BERT 이후 순위를 높이려면 어떻게 해야 하나요?

순위를 잃은 키워드의 경우 수정된 검색 결과 페이지를 살펴보고 Google이 타겟 용어의 검색 의도를 어떻게 보고 있는지 더 잘 이해해야 합니다. 그런 다음 사용자의 목표를 더 잘 충족하도록 콘텐츠를 수정합니다.

BERT에서 순위를 잃었다면 콘텐츠 품질 문제보다 페이지가 사용자의 검색 의도와 얼마나 잘 일치하는지(사용자가 목표를 달성하는 데 도움이 됨)와 관련된 문제일 가능성이 더 큽니다.

BERT가 시간이 지남에 따라 음성 검색 노력을 추가로 지원할 가능성이 있다는 점을 감안할 때 웹 사이트에서 명확하고 간결한 문구를 작성할 것을 권장합니다. 필러 언어를 사용하지 말고 애매하게 말하지 말고 바로 요점을 말하십시오.

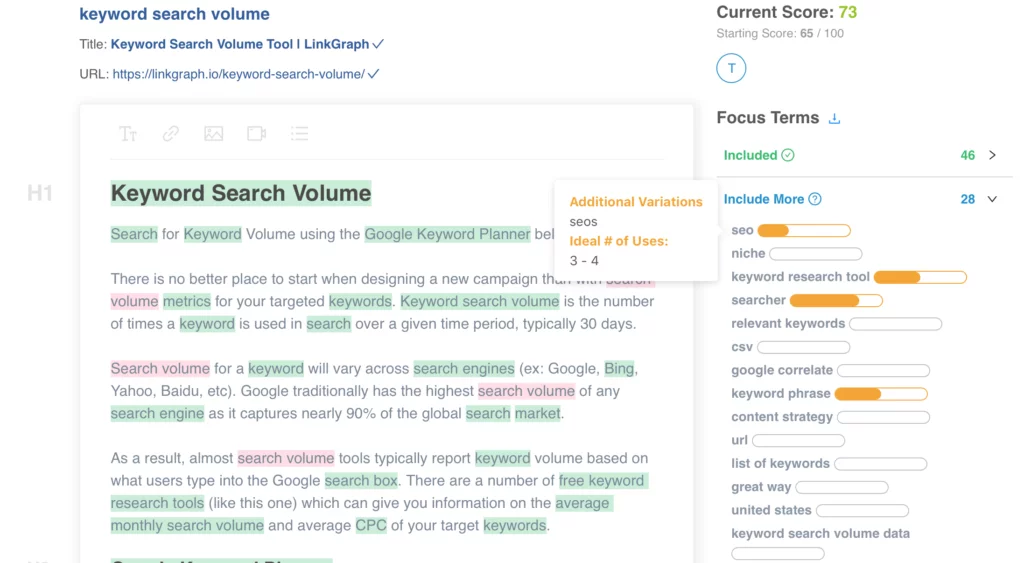

콘텐츠를 최적화하는 데 도움이 필요하십니까? LinkGraph의 On Page Content Optimizer를 확인하거나, [email protected]로 당사 팀원에게 연락하거나, 오늘 회의를 예약하여 설정하십시오.

어디에서 자세히 알아볼 수 있습니까?

Dawn Anderson은 이번 달 초 Pubcon에서 "Google BERT와 가족 및 자연어 이해 리더보드 레이스"에 대해 멋진 프레젠테이션을 했습니다. 그녀의 프레젠테이션을 볼 수 있습니다.

제 #Pubcon을 이용해 주셔서 감사합니다. 여기 내 덱이 있습니다. <3 <3 https://t.co/aGYDI9pfdY

— 던 앤더슨(@dawnieando) 2019년 10월 10일

Jeff Dean은 또한 최근 BERT를 포함한 Google의 AI에서 기조연설을 했습니다.