SEO 체크리스트의 주요 구성 요소는 무엇입니까?

게시 됨: 2022-05-22효과적인 페이지 SEO 요소와 관련하여 이 7가지 사항은 기술적 SEO 체크리스트에 필수적입니다. SEO는 단순히 키워드 연구 및 콘텐츠에 관한 것이 아닙니다. 더 나아가서 SEO 마케터는 최대의 유기적 트래픽을 얻고 검색 엔진에서 높은 순위를 차지하기 위해 SEO 마케팅에 대한 어느 정도의 기술적 SEO 노하우를 보유해야 합니다.

다음은 SEO 체크리스트의 주요 구성요소가 무엇인지 논의하는 2020년 최고의 페이지 SEO를 위한 7가지 기술 SEO 체크리스트입니다.

리치 스니펫

리치 스니펫은 '리치 결과'라고도 합니다. 추가 데이터와 함께 표시되는 검색 결과입니다. 검색 엔진이 캡션 및 강조 표시할 데이터를 스키마 마크업 도구를 사용하여 먼저 생성해야 하므로 이를 위해 약간의 HTML 노하우가 필요합니다. 생성된 스크립트는 웹 페이지의 헤드와 바디 영역 사이에 업로드되어야 합니다. 이렇게 하면 검색 엔진이 페이지의 콘텐츠를 쉽게 읽고 이해할 수 있습니다. 일반적인 리치 스니펫 유형에는 리뷰, 레시피 및 이벤트가 포함됩니다. 이것은 2020년 SEO 마케팅을 위한 트렌드 온페이지 SEO 요소입니다.

정규화

웹사이트의 다른 링크에 동일한 콘텐츠가 있는 경우...표준 태그는 검색 엔진이 해당 링크를 하나로 볼 수 있도록 하는 방법입니다. 표준 태그를 추가하면 검색 엔진이 귀하의 콘텐츠를 중복으로 간주하거나 표준 태그로 반복하지 않을 것임을 확신할 수 있습니다. 특정 URL이 페이지의 마스터 사본을 나타낸다는 것을 검색 엔진에 알리는 방법입니다. "rel canonical"로 표시됩니다. 표준 태그를 사용하면 검색 결과에 표시할 URL 버전을 검색 엔진에 명령하게 됩니다. 정규화는 다시 중요한 페이지 SEO 요소이며 SEO 마케팅을 위한 기술 SEO 체크리스트에 있어야 합니다.

사이트맵

사이트맵은 검색 엔진이 웹사이트의 모든 콘텐츠를 찾고, 크롤링하고, 색인을 생성하는 데 도움이 되는 웹사이트의 청사진입니다. Sitemap은 또한 검색 엔진에 귀하의 사이트에서 가장 중요한 페이지를 알려줍니다. 사이트맵은 검색 엔진이 특정 페이지의 색인을 생성하도록 제어하거나 명령하지 않지만… 오히려 색인을 생성하려는 웹사이트에 관련 콘텐츠가 있음을 검색 엔진에 알리는 방법입니다.

사이트맵에는 4가지 주요 유형이 있습니다.

- 일반 XML 사이트맵

- 동영상 사이트맵

- 뉴스 사이트맵

- 이미지 사이트맵.

사이트맵은 기술 페이지 SEO 체크리스트에 있어야 합니다.

301 리디렉션

301 리디렉션은 특정 링크가 다른 URL로 영구적으로 이동되었음을 검색 엔진에 알리는 영구 리디렉션입니다. 대부분의 경우 301 리디렉션은 웹사이트에서 리디렉션을 구현하는 가장 좋은 방법입니다. 301을 제공하면 페이지가 영구적으로 이동했음을 브라우저와 검색 엔진 봇 모두에 나타냅니다. 검색 엔진은 이를 페이지의 위치가 변경되었을 뿐만 아니라 콘텐츠 또는 업데이트된 버전의 콘텐츠를 새 URL에서 찾을 수 있다는 의미로 해석합니다.

404 오류

404 페이지를 찾을 수 없음 오류에 대해 잘 알고 있어야 합니다. 이는 액세스를 시도하는 웹 페이지가 이동 또는 삭제되었음을 나타냅니다. 대부분의 페이지는 이 오류와 함께 그대로 남아 있지만 효과적인 SEO 관점에서 웹사이트의 중복 페이지가 있는 경우 최대한 창의적인 방법으로 사용하는 것이 좋습니다. 제안 사항 중 일부는 재미있는 404 찾을 수 없음 메시지 만들기, 연락처 정보 표시, 활성 웹 사이트 링크 포함 등이 있습니다.

지오태그

위치정보 태그는 지역 비즈니스가 온라인에서 검색되기를 원할 때 큰 도움이 됩니다. 지리적 태그 지정은 웹사이트, 콘텐츠, RSS 피드 및 기타 특정 위치에 태그를 지정할 수 있는 기술입니다. 위도와 경도를 사용하여 시청자에게 현재 위치 또는 무언가가 있는 위치를 정확히 알릴 수 있습니다. 경도 및 위도 이외의 다른 요소를 사용하여 설명, 제목, 이름 등을 추가하는 등 개인화할 수 있습니다.

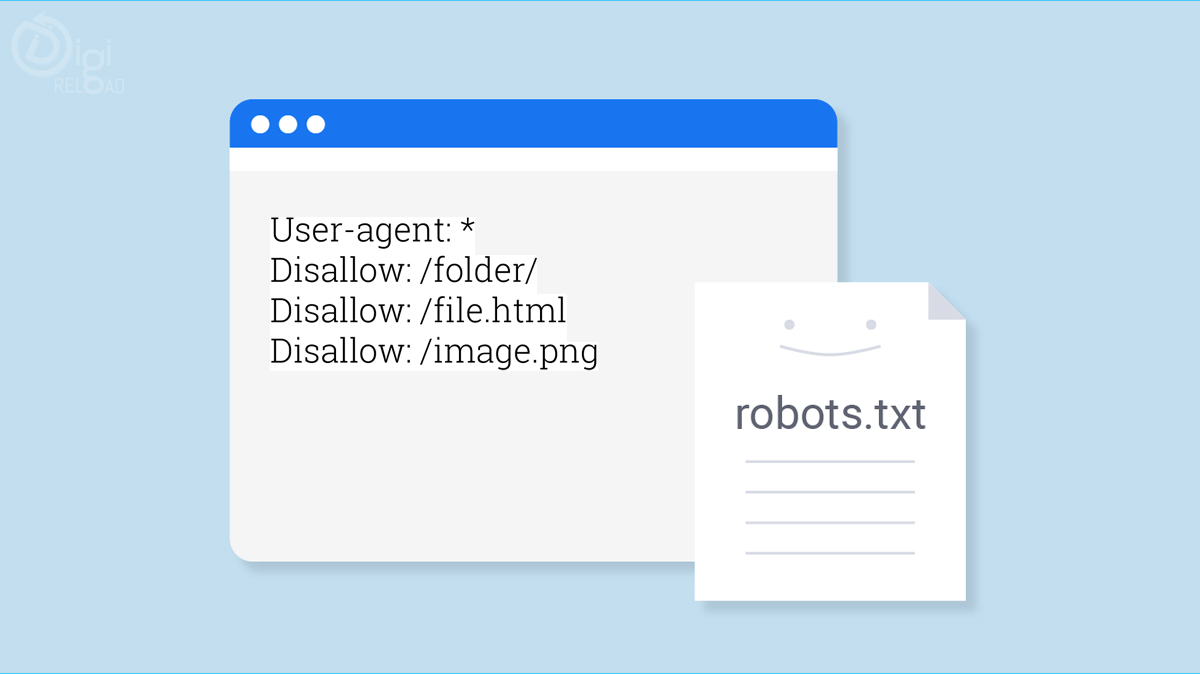

로봇.txt

간단한 의미에서 Robots.txt는 웹 사이트에서 페이지를 크롤링하는 방법에 대한 웹 로봇에 대한 지침입니다. robots.txt를 사용하여 크롤링할 페이지와 건너뛸 페이지를 웹 크롤러에 지시합니다. 이러한 크롤링 지침은 모든 사용자 에이전트의 동작을 "허용하지 않음" 또는 "허용"으로 지정합니다.