BERT: największa aktualizacja Google od lat

Opublikowany: 2022-12-01BERT Google został uruchomiony pod koniec 2019 roku i wpłynął na prawie 10% wszystkich wyszukiwań. Prawdopodobnie jedna z największych aktualizacji algorytmu w 2019 roku. Oto wszystko, co specjaliści SEO i właściciele witryn powinni wiedzieć o zaawansowanym modelu przetwarzania języka naturalnego Google.

Co to jest BERT Google?

BERT to algorytm głębokiego uczenia się i skrót od Bidirectional Encoder Representations from Transformers. Algorytm pomógł uzyskać trafniejsze wyniki dla skomplikowanych zapytań.

Jaki był wpływ aktualizacji algorytmu BERT na wyszukiwarkę Google?

Oto co powiedział Google:

„Te ulepszenia mają na celu poprawę rozumienia języka, szczególnie w przypadku zapytań bardziej naturalnych/konwersacyjnych, ponieważ BERT jest w stanie pomóc wyszukiwarce lepiej zrozumieć niuanse i kontekst słów w wyszukiwaniu oraz lepiej dopasować te zapytania do pomocnych wyników.

Szczególnie w przypadku dłuższych, bardziej konwersacyjnych zapytań lub wyszukiwań, w których przyimki takie jak „za” i „do” mają duże znaczenie dla znaczenia, wyszukiwarka będzie w stanie zrozumieć kontekst słów w zapytaniu. Możesz wyszukiwać w sposób, który wydaje Ci się naturalny”.

W rzeczywistości, według Google, aktualizacja BERT wpłynie na 1 na 10 wyszukiwań w języku angielskim w USA, czyli 10% zapytań. To najważniejsza aktualizacja Google w ciągu ostatnich 5 lat, przynajmniej według nich:

Dokonujemy znacznych ulepszeń w sposobie rozumienia zapytań, co stanowi największy skok naprzód w ciągu ostatnich pięciu lat i jeden z największych skoków naprzód w historii wyszukiwania.

Wprowadzenie BERT spowodowało duże wahania w rankingu w pierwszym tygodniu wdrożenia nowego algorytmu. Specjaliści ds. SEO w Webmaster World komentują wahania od początku tygodnia, odnotowując największe wahania w rankingach, jakie dotknęły świat SEO od czasu RankBrain.

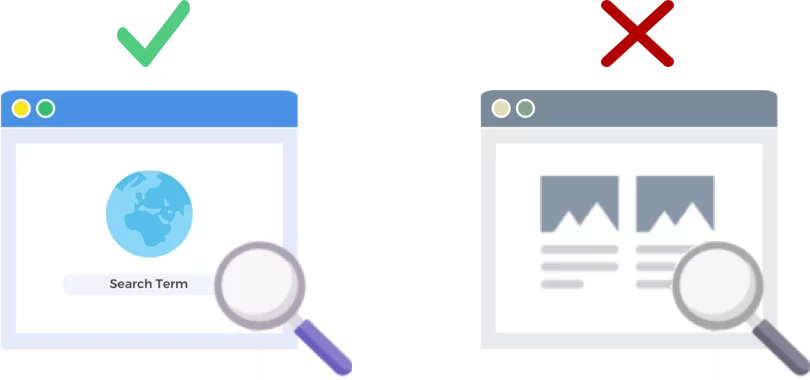

BERT analizuje zapytania wyszukiwania NIE strony internetowe

Wydanie 24 października 2019 r. algorytmu BERT poprawia sposób, w jaki gigant wyszukiwarek analizuje i rozumie zapytania wyszukiwania (nie strony internetowe).

Jak działa BERT?

BERT poprawia zrozumienie zapytań przez Google przy użyciu dwukierunkowego modelu kontekstu (to jest B w BERT). Google faktycznie mówił trochę o mechanice BERT w tym czasie w zeszłym roku, kiedy ogłosili BERT jako nową technikę wstępnego szkolenia w zakresie przetwarzania języka naturalnego (NLP).

Co to jest przedtreningówka? Trening wstępny to po prostu uczenie maszyny wykonywania zadań, zanim faktycznie dasz jej pracę do wykonania. Tradycyjnie przedtreningowe zestawy danych zawierają od kilku do kilkuset tysięcy przykładów oznaczonych przez człowieka.

Wstępne szkolenie istnieje już od jakiegoś czasu, ale to, co wyróżnia BERT, to to, że jest zarówno kontekstowe (znaczenie każdego słowa zmienia się w zależności od słów wokół niego), jak i dwukierunkowe – znaczenie słowa jest rozumiane na podstawie słów zarówno Przed nim, jak i po tym.

Według bloga Google:

W zdaniu „ Uzyskałem dostęp do konta bankowego ” jednokierunkowy model kontekstowy reprezentowałby „ bank ” w oparciu o „ uzyskałem dostęp do konta”, ale nie „ konto ”. Jednak BERT reprezentuje „ bank ” przy użyciu zarówno poprzedniego, jak i następnego kontekstu — „ Uzyskałem dostęp do … konta ” — zaczynając od samego dołu głębokiej sieci neuronowej, co czyni ją głęboko dwukierunkową.

Aktualizacja Google BERT opiera się na najnowszych postępach w uczeniu maszynowym i rozpoznawaniu jednostek. Zasadniczo BERT pomaga zidentyfikować wszystkie części mowy i kontekst słów przed przetworzeniem wyszukiwania przez Google.

Co BERT oznacza dla wyników wyszukiwania?

Według Google oznacza to, że użytkownicy zaczną widzieć bardziej trafne wyniki, które lepiej pasują do intencji wyszukiwania użytkownika. To ulepszenie algorytmu obejmie wyniki zwykłe i fragmenty rozszerzone.

Google dostarczyło kilka pomocnych przykładów we wpisie na blogu zapowiadającym BERT.

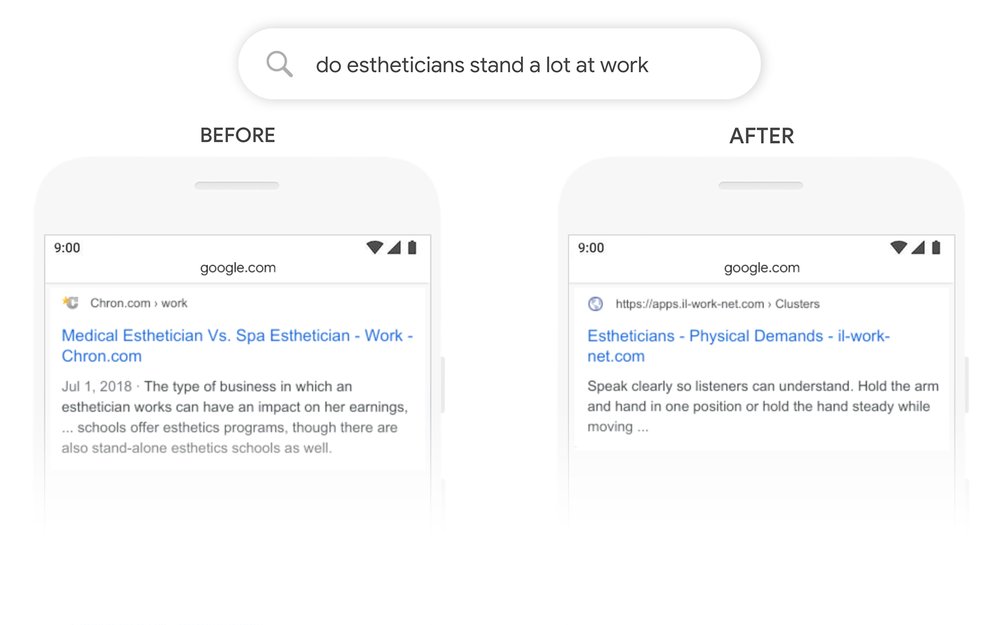

Przykład estetyka

Po pierwsze, mamy użytkownika, który próbuje zrozumieć, czy estetycy spędzają dużo czasu na nogach w ramach swojej pracy.

Możesz zobaczyć poniżej, że zanim BERT Google odczytał zapytanie „czy estetycy dużo stoją w pracy” i wygenerował wynik porównujący rodzaje środowisk pracy dla estetyków.

Po BERT Google wyświetla artykuł na temat fizycznych wymagań bycia estetykiem, znacznie bardziej zgodny z informacjami, które wyszukiwarka pierwotnie próbowała ujawnić.

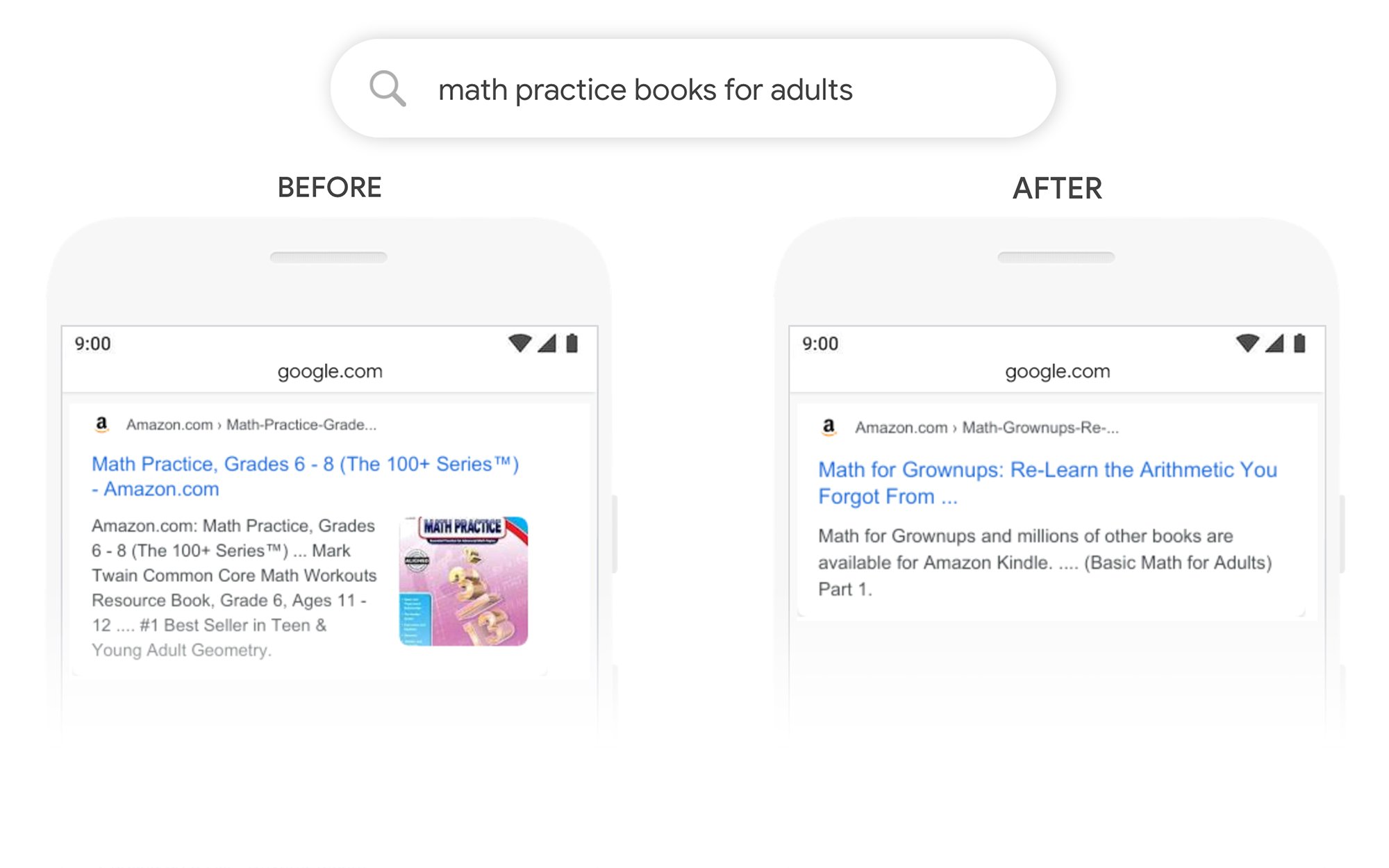

Przykład podręczników do ćwiczeń z matematyki

W tym przykładzie użytkownik szuka podręczników do matematyki dla dorosłych, ale wyświetla podręczniki do matematyki dla dzieci.

Po BERT Google poprawnie rozpoznaje kontekst zapytania, lepiej uwzględniając drugą część wyszukiwania „dla dorosłych”.

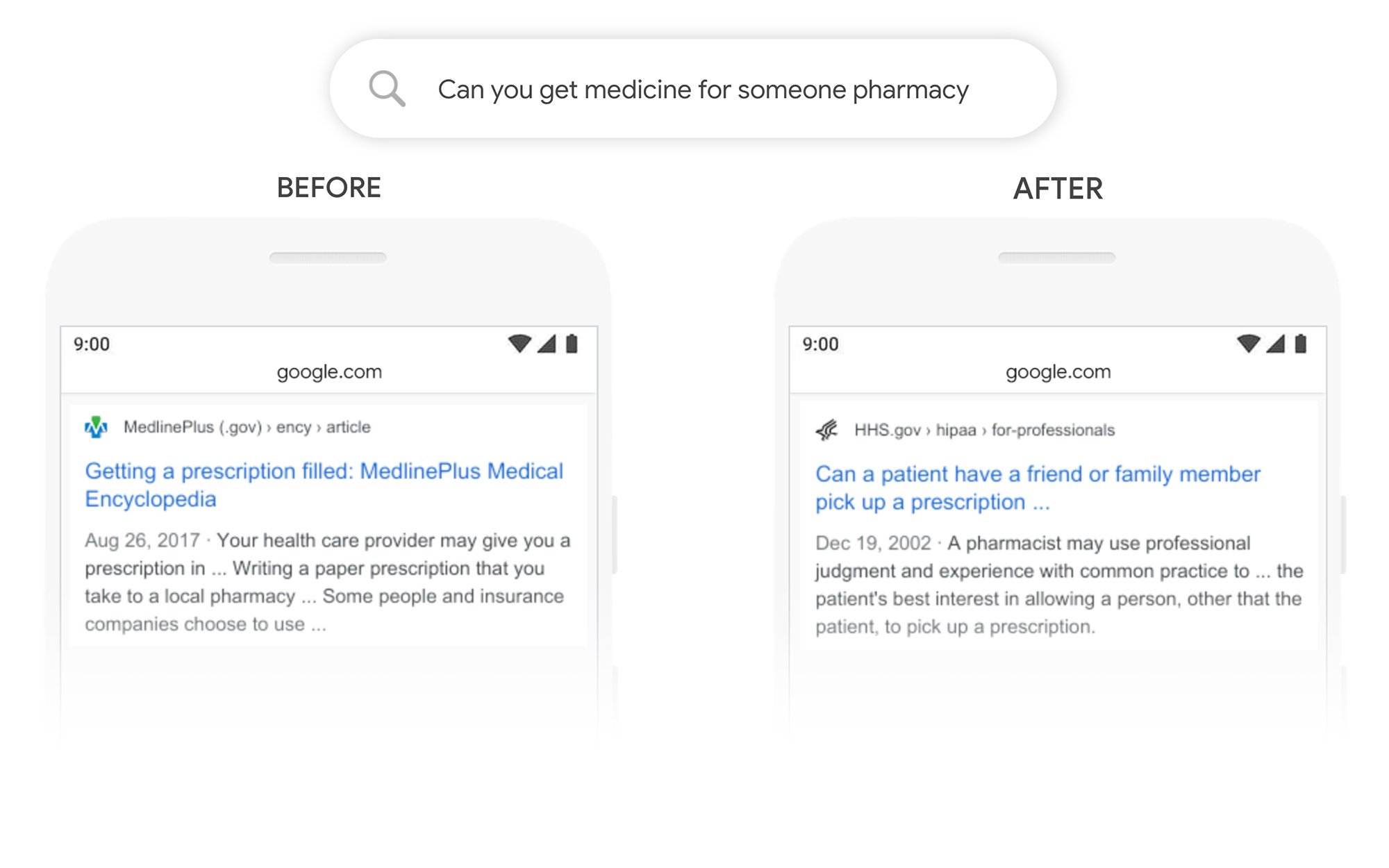

Przykład, czy możesz odebrać lekarstwo dla kogoś innego

W tym przykładzie zapytanie „czy możesz zdobyć lekarstwo dla kogoś w aptece” zwraca wynik dotyczący ogólnego sposobu realizacji recept, a nie sposobu realizacji ich dla osoby trzeciej. Po BERT Google lepiej rozumie cel użytkownika i pokazuje, czy pacjent może poprosić znajomego lub członka rodziny o odbiór recepty.

Co mogę zrobić, aby poprawić ranking po BERT?

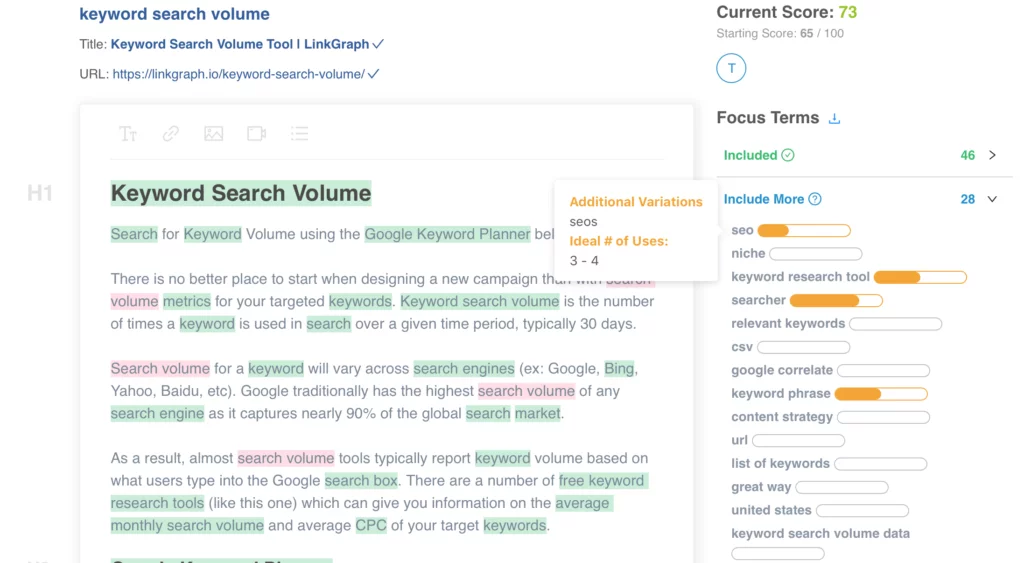

W przypadku słów kluczowych, w przypadku których tracisz pozycję w rankingu, powinieneś rzucić okiem na poprawioną stronę wyników wyszukiwania, aby lepiej zrozumieć, w jaki sposób Google postrzega intencje wyszukiwania Twoich docelowych haseł. Następnie odpowiednio zmień treść, aby lepiej spełniała cele użytkownika.

Jeśli straciłeś pozycję w rankingu w ramach BERT, bardziej prawdopodobne jest, że jest to problem związany z dopasowaniem strony do intencji wyszukiwania użytkownika (pomaga użytkownikowi osiągnąć cel), niż z jakością treści.

Biorąc pod uwagę, że BERT prawdopodobnie z czasem będzie dalej wspierać wyszukiwanie głosowe, zalecamy również stronom internetowym pisanie jasnej i zwięzłej kopii. Nie używaj języka wypełniającego, nie mów niejasno, przejdź od razu do rzeczy.

Potrzebujesz pomocy w optymalizacji treści? Sprawdź Optymalizator treści na stronie LinkGraph, skontaktuj się z członkiem naszego zespołu pod adresem [email protected] lub umów się na spotkanie, aby skonfigurować już dziś.

Gdzie mogę dowiedzieć się więcej?

Dawn Anderson przedstawiła świetną prezentację na początku tego miesiąca w Pubcon na temat „Google BERT and Family and the Natural Language Understanding Leaderboard Race”. Możesz rzucić okiem na jej prezentację.

Dzięki za udział w #Pubcon. Oto moja talia <3 <3 https://t.co/aGYDI9pfdY

— Dawn Anderson (@dawnieando) 10 października 2019 r

Jeff Dean również niedawno wygłosił przemówienie na temat sztucznej inteligencji w Google, w tym BERT, które możesz obejrzeć.