7 najlepszych narzędzi do skrobania sieci w Internecie w 2023 r

Opublikowany: 2023-11-17Podsumowanie: Narzędzia do skrobania sieci usprawniają procedurę wyodrębniania danych ze stron internetowych w celu podejmowania decyzji opartych na danych. Przyjrzyjmy się niektórym z najlepszych narzędzi do skrobania, których możesz użyć w tym celu.

Narzędzia do skrobania witryn internetowych odgrywają zasadniczą rolę w wydobywaniu danych ze stron internetowych. Umożliwiają użytkownikom gromadzenie, analizowanie i organizowanie informacji do różnych celów, w tym do badań, analiz i spostrzeżeń dotyczących konkurencji. Mogą zautomatyzować cały proces wydobywania danych i znacząco przyczynić się do podejmowania decyzji w oparciu o dane w różnych dziedzinach.

W tym artykule dowiemy się o najlepszych narzędziach do ekstrakcji danych z Internetu, które mogą się przydać podczas eksportowania danych. Ale najpierw dowiedzmy się, czym dokładnie jest skrobanie sieci.

Spis treści

Co to jest skrobanie sieci?

Skrobanie sieci to zautomatyzowany sposób gromadzenia danych zbiorczych z różnych witryn internetowych. Wyodrębnione dane to nieustrukturyzowane dane w formacie HTML, które są konwertowane na dane strukturalne, takie jak arkusze kalkulacyjne i bazy danych.

Istnieje wiele sposobów usuwania danych ze stron internetowych, na przykład przy użyciu interfejsów API, oprogramowania i tworzenia własnego, unikalnego kodu. Wiele przykładów oprogramowania oferuje wbudowane boty skrobające lub umożliwia tworzenie własnych botów skrobających do skrobania w Internecie.

Lista 7 narzędzi do skrobania sieci w Indiach w roku 2023 dla początkujących

- Oktopara

- ParseHub

- Skrobanie bota

- Skrobanie Pszczoły

- Apify

- Zenscrape'a

- Skrobak sieciowy

Oto szczegółowe wyliczenie najlepszych narzędzi do skrobania stron internetowych w oparciu o ich funkcje, ceny, zalety i wady itp., które pomogą Ci wybrać najlepsze oprogramowanie.

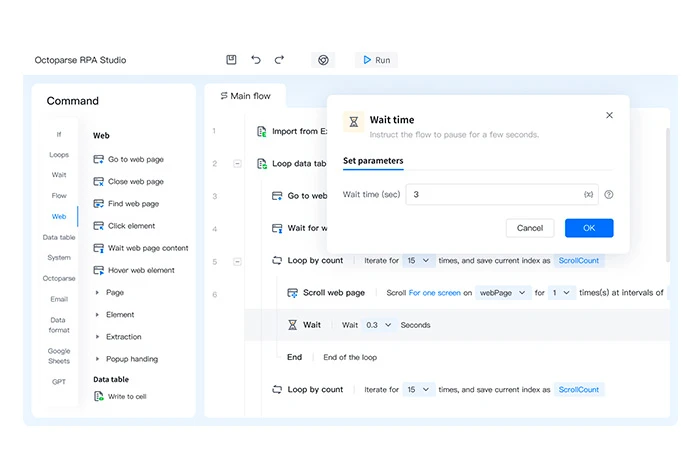

Oktopara

Octoparse to narzędzie do usuwania stron internetowych, które pozwala w ciągu kilku sekund zamienić strony internetowe w uporządkowane dane. Jest to oprogramowanie niewymagające kodu, które może wyodrębnić odpowiednie informacje z różnych typów witryn internetowych lub stron internetowych.

Nieustrukturyzowane dane wyodrębniane z dowolnej witryny internetowej są zapisywane w uporządkowanych formatach plików, takich jak HTML, zwykły tekst, Excel i tak dalej.

Funkcje Octoparse

- Eksportuje dane do wielu formatów, takich jak Excel, CSV i JSON

- Planuje eksport danych do baz danych

- Zapewnia wiele szablonów do skrobania danych

- Nie tworzy skrobaków sieciowych kodu

- Tworzy 750 zadań do skrobania stron internetowych

Plusy i minusy Octoparse

- Obsługuje automatyczną rotację adresów IP podczas wydobywania danych ze strony internetowej, aby zmniejszyć ryzyko ich śledzenia.

- Możesz także wyodrębniać dane z wielu chmur za pośrednictwem serwerów chmurowych.

- Dostępne są ograniczone opcje dostosowywania oprogramowania.

Ceny Octoparse: Dostępny bezpłatny plan | Płatny plan zaczyna się od 6241,54 INR/miesiąc

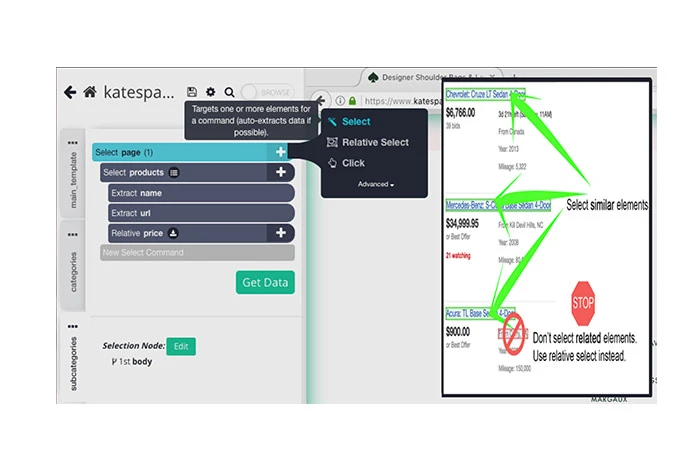

ParseHub

Bezpłatne narzędzie do złomowania ParseHub może być używane do usuwania danych z różnych stron internetowych. Wszystko, co musisz zrobić, to wybrać witrynę internetową do złomowania, wybrać dane do złomowania i wyeksportować zeskrobane dane do różnych formatów.

Można go używać do przechowywania danych z różnych serwerów, renderowania JavaScript, rozwiązywania CAPTCHA itp. Dzięki funkcji planowania możesz także planować ekstrakcję danych na różnych stronach internetowych.

Funkcje ParseHuba

- Automatycznie zmienia adresy IP w celu indeksowania witryn internetowych

- Importuje zeskrobane dane do wielu formatów, takich jak JSON i Excel

- Pobiera leady sprzedażowe z katalogów, społeczności, mediów społecznościowych itp.

- Oferuje wiele interfejsów API do agregowania danych z różnych źródeł

- Wyodrębnia dane z tabel, map i wykresów

Plusy i minusy ParseHub

- Oferuje integrację z Dropbox w celu zapisywania wyodrębnionych danych.

- Możesz go używać do wyodrębniania obrazów, tekstu, atrybutów itp. ze stron internetowych.

- Użytkownicy z niewielką wiedzą techniczną mogą mieć trudności w korzystaniu z oprogramowania.

Ceny ParseHub: Dostępny bezpłatny plan | Płatny plan zaczyna się od 15 736,69 INR/miesiąc

Skrobanie bota

Scraping Bot zapewnia interfejs API do skrobania sieci, umożliwiający wyodrębnianie danych HTML z różnych źródeł bez blokowania. Oferuje wiele interfejsów API dostosowanych do konkretnego sektora w celu wyodrębnienia najbardziej odpowiednich danych. Po przeanalizowaniu danych automatycznie importuje je w formacie JSON w celu integracji z istniejącym przepływem pracy.

Funkcje bota skrobania

- Obsługuje równoczesne żądania serwera

- Automatyzuje procedurę zbierania danych

- Wyodrębnia dane klientów, aby znaleźć potencjalnych klientów

- Oferuje analizę sentymentalną

- Wybiera treści z różnych źródeł, aby ulepszyć strategię dotyczącą treści

Plusy i minusy skrobania bota

- Obsługuje także renderowanie JavaScript.

- Zapewnia kierowanie geograficzne w celu filtrowania witryn internetowych na podstawie Twojej lokalizacji geograficznej

- Zajmuje dużo pamięci systemowej i RAM.

Ceny botów Scraping: Dostępny plan bezpłatny | Płatny plan zaczyna się od 3476,21 INR/miesiąc

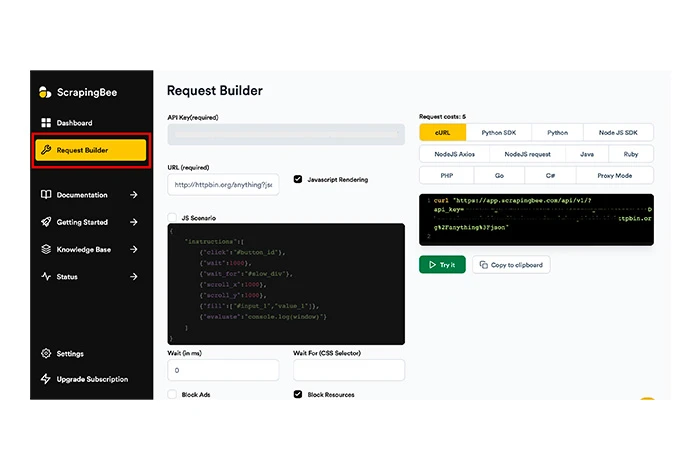

Skrobanie Pszczoły

Scrapingbee to kolejne narzędzie do skrobania witryn, które może pomóc w ogólnym skrobaniu sieci, skrobaniu na podstawie strony wyników wyszukiwania (SERP) i hakowaniu wzrostu.

Narzędzie może wykonywać JavaScript na stronach i obracać wszystkie proxy dla każdego żądania, aby udostępnić Ci surową stronę HTML bez ryzyka zablokowania. ScrapingBee zarządza CAPTCHA, serwerami proxy i przeglądarkami, dzięki czemu możesz łatwo wyodrębnić dane z wybranej witryny.

Funkcje Scrapingbee

- Obsługuje rotację adresów IP w celu skrobania sieci

- Zapewnia automatyczną rotację serwerów proxy

- Oferuje ogólne skrobanie sieci

- Wyodrębnia strony HTML, JSON itp.

- Nie tworzy żadnych niestandardowych silników do skrobania stron internetowych

Plusy i minusy Scrapingbee

- Obsługuje skrobanie danych ukierunkowanych geograficznie.

- Zapewnia oddzielny interfejs API do skrobania wyników wyszukiwania Google.

- Wewnętrzne błędy serwera występują bardzo często.

Ceny Scrapingbee: Brak dostępnego bezpłatnego planu | Płatny plan zaczyna się od 4077,57 INR/miesiąc

Apify

Apify to oprogramowanie do skrobania sieci, za pomocą którego można tworzyć, wdrażać i nadzorować różne narzędzia do skrobania sieci. Umożliwia tworzenie różnych interfejsów API do przeglądania stron internetowych i optymalizuje serwery proxy w centrach danych w celu wyodrębniania danych.

Apify ma również sklep, w którym oferuje gotowe narzędzia do skrobania stron internetowych, takich jak Instagram, Twitter, Mapy Google itp. Zawiera kilka funkcji do skrobania stron internetowych, automatyzacji przepływu pracy i ekstrakcji danych.

Funkcje Apify

- Uruchamia nieograniczoną liczbę zadań jednocześnie

- Zarządza serwerami proxy dla centrów danych i SERP

- Wyodrębnia dane z Amazon, schema.org, stron internetowych itp.

- Obsługuje rotację adresów IP podczas skrobania danych

- Oferuje rozwiązywanie CAPTCHA i renderowanie JavaScript

- Eksportuje dane w formatach takich jak CSV, JSON, Excel itp.

Plusy i minusy Apify

- Oferuje rotację serwerów proxy jako wbudowaną funkcję.

- Dostęp do danych można uzyskać w wielu formatach za pośrednictwem interfejsów API.

- Mogą wystąpić problemy ze zgodnością oprogramowania.

Ceny Apify: Dostępny plan bezpłatny | Płatny plan zaczyna się od 4077,64 INR/miesiąc

Zenscrape'a

Zenscrape to interfejs API, który zarządza wszystkimi problemami związanymi ze skrobaniem stron internetowych i obsługuje wysokiej jakości ekstrakcję danych HTML. Narzędzie renderuje żądania za pośrednictwem nowoczesnej, bezobsługowej przeglądarki Chrome w celu precyzyjnej i dokładnej agregacji danych.

Dane pobrane ze stron internetowych są eksportowane do wielu formatów, takich jak Excel i JSON. Co więcej, dzięki funkcji geolokalizacji możesz wybrać lokalizację proxy, aby wyświetlić treść witryny kierowanej geograficznie.

Funkcje Zenscrape'a

- Obsługuje indeksowanie sieci

- Wykonuje skrobanie danych cenowych

- Automatycznie usuwa informacje o kontaktach ze stron internetowych

- Zarządza standardowymi i premium serwerami proxy witryn internetowych

- Obsługa rotacji IP i rozwiązywania CAPTCHA

Plusy i minusy Zenscrape’a

- Obsługuje także ekstrakcję danych HTML ze stron internetowych.

- Czas reakcji stron internetowych w Zenscrape jest bardzo szybki.

- Aby przekonwertować pobrane dane na różne formaty plików, musisz użyć narzędzia innej firmy.

Ceny Zenscrape: Dostępny bezpłatny plan | Płatny plan zaczyna się od 2496,26 INR/miesiąc

Skrobak sieciowy

Web Scraper to narzędzie do skrobania online, którego można używać do regularnej i zaplanowanej ekstrakcji danych. Można go zintegrować z innymi systemami w celu wykorzystania wyodrębnionych danych. Za pomocą tego narzędzia do skrobania możesz zbiorczo wyodrębniać dane i jednocześnie uruchamiać zadania skrobania wielu witryn internetowych.

Funkcje skrobaka sieciowego

- Szybko automatyzuje procedurę ekstrakcji danych

- Konfiguruje skrobaki bez kodowania

- Wyodrębnia dane witryny za pomocą wielopoziomowej nawigacji

- Wykorzystuje mapy witryn do dostosowywania danych witryn internetowych

- Eksportuje dane w formatach CSV, XLSX, JSON i innych.

Plusy i minusy skrobaka sieciowego

- Możesz także zaplanować usuwanie witryn na podstawie tygodni, dni, godzin itp.

- Może obracać adres IP z wieloma adresami IP.

- Konfiguracja zajmuje dużo czasu.

- Pobrane dane są przechowywane tylko do 60 dni.

Ceny Web Scraper: Dostępny plan bezpłatny | Płatny plan zaczyna się od 4162,90 INR/miesiąc

Jak wybrać skrobak sieciowy?

Aby wybrać odpowiedni skrobak wstęgowy, należy wziąć pod uwagę następujące czynniki:

- Obsługiwany system operacyjny: Skrobak sieciowy, który planujesz kupić, musi obsługiwać system operacyjny, którego używasz.

- Wsparcie w chmurze: dzięki temu wsparciu będziesz mógł zapisywać uporządkowane dane w chmurze.

- Integracja: Integracja z innymi platformami umożliwia łatwe przesyłanie pobranych danych na inne platformy.

- Szkolenie: Ponieważ korzystanie z narzędzia do scrapowania stron internetowych wymaga wiedzy programistycznej, musisz wybrać narzędzie oferujące obszerne materiały szkoleniowe.

- Ceny: Weź pod uwagę cenę oprogramowania i upewnij się, że mieści się ona w Twoim budżecie.

Jak działa skrobanie sieci?

Zgarnianie wstęgi odbywa się w trzech prostych krokach. Po pierwsze, bot skrobający symuluje przeglądanie przez człowieka i usuwa witrynę, a po drugie, analizuje dane z węzła danych. Na koniec pobiera i konwertuje przeanalizowane dane. Oto szczegółowe wyliczenie każdego kroku.

Krok 1: Bot przeglądający strony internetowe symuluje dowolnego człowieka przeglądającego daną witrynę. Następnie wprowadza docelowy adres URL i wysyła żądania do serwera. Po zakończeniu serwer dostarcza informacje z powrotem do pliku HTML.

Krok 2: Za pomocą kodu HTML bot dociera do węzła danych i analizuje dane zgodnie z poleceniem kodu skrobającego.

Krok 3: Na podstawie konfiguracji bota zeskrobane dane są czyszczone i konwertowane na format danych strukturalnych, taki jak JSON. Następnie dane są gotowe do importu lub transportu do różnych baz danych.

Porównanie najlepszych narzędzi do ekstrakcji stron internetowych

Oto porównanie najlepszych narzędzi do skrobania stron internetowych na podstawie obsługiwanych systemów operacyjnych, dostępności bezpłatnej wersji próbnej i ogólnej oceny użytkowników.

| Oprogramowanie | Obsługiwany system operacyjny | Bezpłatny okres próbny | Ocena |

| Oktopara | Windows, Mac | Dostępny | 4 |

| ParseHub | Windows, macOS, Linux | Niedostępne | 4,5 |

| Skrobanie bota | Windows, Mac | Dostępny | 3.5 |

| Skrobanie Pszczoły | Oparte na sieci | Dostępne przez 14 dni | 4.1 |

| Apify | Oparte na sieci | Bezpłatne | 4.9 |

| Zenscrape'a | Oparte na sieci | Bezpłatne narzędzie do analizy danych | 3.8 |

| Skrobak sieciowy | Windows, Mac | Dostępne przez 7 dni | 4.1 |

Wniosek

Po przeczytaniu artykułu być może zrozumiałeś narzędzia do skrobania stron internetowych i to, w jaki sposób mogą one pomóc w ekstrakcji danych. W tym artykule wymieniliśmy najlepsze programy do wyodrębniania i importowania danych ze stron internetowych.

Bazując na funkcjach takich jak ekstrakcja danych, rotacja adresów IP, zarządzanie proxy itp., ParseHub i Scraping Bot okazały się najlepszymi narzędziami do skrobania sieci. Jednak przed wybraniem dowolnego narzędzia do skrobania stron internetowych należy wziąć pod uwagę wymagania dotyczące cen i funkcji.

Często zadawane pytania dotyczące narzędzi Web Scraper

Czym są narzędzia do ekstrakcji stron internetowych?

Narzędzia do skrobania stron internetowych to programy zaprojektowane w celu usprawnienia funkcji wyodrębniania danych ze stron internetowych. Dzięki tym narzędziom możesz stworzyć własnego bota, który będzie w stanie pobrać potrzebne dane z wybranych stron internetowych.

Do czego służy skrobanie sieci?

Skrobanie sieci może być wykorzystywane do wielu celów, takich jak wyodrębnianie danych z mediów społecznościowych, informacji kontaktowych, danych o nieruchomościach, informacji o cenach akcji i wielu innych.

Jak wyciągnąć dane ze strony internetowej?

Aby wyodrębnić dane ze swojej witryny, możesz użyć różnych narzędzi do skrobania danych. Niektóre z najlepszych narzędzi, jakie możesz rozważyć do skrobania stron internetowych, to Zenscrape, Apify, Scrapingbee, Smartproxy, Agenty itp.

Jakie są korzyści z używania narzędzi do skrobania stron internetowych dla firm?

Korzystając z narzędzi do skrobania sieci, firmy mogą zautomatyzować proces ekstrakcji danych, zaoszczędzić cenny czas i wykorzystać dane do uzyskania cennych informacji. Co więcej, firmy mogą jednocześnie usuwać dane z wielu witryn internetowych za pomocą tych narzędzi do analizowania sieci, aby zaoszczędzić czas i zasoby.

Czy do korzystania z narzędzi do skrobania stron internetowych konieczna jest znajomość kodowania?

Do korzystania z narzędzia do skrobania stron internetowych wymagana jest podstawowa znajomość kodowania. Nie jest to jednak konieczne, ponieważ wiele narzędzi ma przyjazne interfejsy i można z nich korzystać przy niewielkiej wiedzy technicznej lub bez niej.

Jak mogę bezpłatnie zdrapać dane?

Aby bezpłatnie zeskrobać dane ze strony internetowej, możesz wybrać bezpłatne narzędzia do skrobania danych. Narzędzia te oferują bezpłatne plany lub są całkowicie bezpłatne. Niektóre z tych narzędzi obejmują Apify, Zenscrape, Octoparse itp.