Masz dość ChatGPT zgarniających Twoje treści? Chroń swoje treści TERAZ

Opublikowany: 2023-07-06

W dzisiejszym krajobrazie cyfrowym ochrona treści, danych i ruchu internetowego ma ogromne znaczenie. Wraz z pojawieniem się ChatGPT i innych modeli językowych sztucznej inteligencji rośnie obawa, że te narzędzia będą zbierać treści dla własnych korzyści. Jako wydawca musisz zrozumieć, jak działają te boty i jakie stwarzają potencjalne zagrożenia.

W tym artykule poznamy świat skrobania ChatGPT i LLM oraz omówimy strategie przechytrzenia i ochrony ruchu w witrynie.

Skąd mam wiedzieć, że ChatGPT pobiera moje treści?

ChatGPT, różne wtyczki i inne modele językowe zyskały status gwiazd ze względu na ich niezwykłą zdolność do generowania tekstu przypominającego ludzki. Narzędzia te przejęły i zwolniły pracowników z różnych branż, w tym tworzenia treści, obsługi klienta, a nawet kreatywnego pisania. Chociaż mogą być pomocne na wiele sposobów, ważne jest, aby zrozumieć, że istnieją przypadki, w których można je niewłaściwie wykorzystać do skrobania treści.

Scraping w kontekście Internetu odnosi się do procesu wydobywania informacji ze stron internetowych za pomocą zautomatyzowanych botów. Te boty odwiedzają różne strony internetowe, zbierają dane i wykorzystują je do dalszego szkolenia modeli AI. Kiedy ChatGPT lub inne LLM zgarniają zawartość, zasadniczo wykorzystują zebrane dane do zwiększenia możliwości generowania tekstu.

Jednak główny problem pojawia się, gdy ten proces skrobania narusza prawa własności intelektualnej i szkodzi działalności wydawców i organizacji medialnych. Istotne jest, aby mieć świadomość, w jaki sposób Twoje treści mogą zostać zeskrobane i jaki może to mieć wpływ na ruch w sieci.

Problemy ze skrobaniem

Jednym z głównych problemów związanych ze skrobaniem jest to, że może to prowadzić do utraty kontroli nad treścią. Gdy zawartość Twojej witryny zostanie zeskrobana, można ją zmienić i rozpowszechnić w innym miejscu bez Twojej zgody. Podważa to Twój autorytet jako oryginalnego twórcy i utrudnia zachowanie dokładności i integralności Twoich treści.

Skrobanie może mieć znaczący wpływ na rankingi Twojej witryny w wyszukiwarkach. Wyszukiwarki traktują priorytetowo treść oryginalną i niepowtarzalną, a kiedy pobrane treści są publikowane w innym miejscu, może to osłabić widoczność i trafność Twojej witryny w wynikach wyszukiwania. Może to skutkować spadkiem ruchu organicznego i potencjalną utratą przychodów.

Może to również prowadzić do zniekształconej reprezentacji Twojej marki lub organizacji. Gdy zeskrobana treść jest używana niewłaściwie lub wyrwana z kontekstu, może fałszywie przedstawiać Twoje intencje, prowadząc do zamieszania, a nawet nadszarpnięcia Twojej reputacji. Ochrona tożsamości Twojej marki i zapewnienie, że Twoje treści są wykorzystywane w sposób odpowiedzialny i z odpowiednią atrybucją, ma kluczowe znaczenie.

Rozwiązanie problemu skrobania wymaga wieloaspektowego podejścia. Jako twórca treści lub właściciel witryny możesz podjąć kilka działań, aby chronić swoje treści przed zeskrobaniem. Wdrażanie technologii, takich jak CAPTCHA, blokowanie adresów IP lub ograniczenia dostępu do treści, może pomóc zniechęcić automatyczne boty do uzyskiwania dostępu do Twojej witryny i jej skrobania.

Ponadto regularne monitorowanie ruchu w Twojej witrynie i analizowanie zachowań użytkowników może pomóc zidentyfikować podejrzane działania, które mogą wskazywać na scraping. Zachowując czujność i proaktywność, możesz podjąć odpowiednie działania, aby złagodzić wpływ scrapingu na Twoje treści i działalność.

Istotne jest również, aby programiści AI i organizacje korzystające z LLM, takie jak ChatGPT, priorytetowo traktowały kwestie etyczne . Wdrażanie surowych wytycznych i zasad, które zniechęcają do niewłaściwego korzystania ze skrobania, może pomóc w zapobieganiu nieautoryzowanemu gromadzeniu treści. Odpowiedzialny rozwój sztucznej inteligencji ma na celu znalezienie równowagi między innowacjami a poszanowaniem praw własności intelektualnej.

W jaki sposób ChatGPT zbiera Twoje treści?

Zrozumienie procesu scrapingu stosowanego przez boty ChatGPT ma kluczowe znaczenie dla skutecznego radzenia sobie z tym problemem. Boty te wykorzystują technikę zwaną indeksowaniem sieci, podczas której odwiedzają strony internetowe i podążają za odsyłaczami w celu zebrania informacji. Informacje te są następnie wykorzystywane do trenowania modelu AI. Skrobanie treści może być szkodliwe dla wydawców i firm medialnych z kilku powodów.

Po pierwsze, może to prowadzić do utraty przychodów, jeśli pobrane treści zostaną ponownie opublikowane bez pozwolenia. Może to osłabić zdolność pierwotnych wydawców do zarabiania na swoich treściach i spowodować straty finansowe. Ponadto może to nadszarpnąć reputację wydawców, ponieważ ich treść może zostać fałszywie przedstawiona lub wyrwana z kontekstu po ponownym opublikowaniu przez boty ChatGPT.

Po drugie, istotnym problemem jest wpływ na wrażenia użytkownika. Gdy boty ChatGPT zalewają witrynę żądaniami pobrania treści, może to przeciążyć serwer i spowolnić ładowanie legalnych użytkowników. Może to frustrować odwiedzających i zniechęcać ich do powrotu do witryny, prowadząc do zmniejszenia ruchu i potencjalnej utraty zaangażowania i przychodów z reklam.

Wreszcie, zeskrobana treść może również wpływać na rankingi witryny w wyszukiwarkach. Wyszukiwarki traktują priorytetowo unikalne i oryginalne treści , karząc witryny z powielonymi lub zeskrobanymi treściami. Jeśli boty ChatGPT zgarną i ponownie opublikują treści od wydawców, może to negatywnie wpłynąć na wysiłki oryginalnych twórców w zakresie optymalizacji pod kątem wyszukiwarek (SEO). Może to skutkować niższą widocznością i ograniczeniem ruchu organicznego, co szkodzi obecności wydawców w Internecie.

Biorąc pod uwagę te zagrożenia, wydawcy muszą proaktywnie chronić swoje treści i ruch internetowy przed skrobaniem ChatGPT i LLM. Wdrażanie środków, takich jak CAPTCHA , blokowanie adresów IP i wykrywanie agenta użytkownika, może pomóc w identyfikacji i blokowaniu automatycznych botów próbujących pobierać treści. Ponadto regularne monitorowanie ruchu w sieci i analizowanie wzorców może pomóc w wykryciu wszelkich nietypowych działań typu scraping i podjęciu odpowiednich działań.

Ponadto wydawcy mogą badać prawne możliwości ochrony swoich treści. Prawa autorskie i prawa własności intelektualnej mogą być egzekwowane, aby zapobiec nieautoryzowanemu kopiowaniu i ponownemu publikowaniu ich pracy. Zasięgnięcie porady prawnej i podjęcie niezbędnych działań prawnych przeciwko podmiotom naruszającym prawo może wysłać mocny sygnał i powstrzymać przyszłe próby złomowania.

Współpraca i komunikacja między wydawcami, firmami medialnymi i programistami AI również mają kluczowe znaczenie w rozwiązaniu tego problemu. Nawiązywanie partnerstw i otwarty dialog może prowadzić do opracowania etycznych praktyk i wytycznych dotyczących szkoleń w zakresie sztucznej inteligencji, zapewniając poszanowanie praw twórców treści przy jednoczesnym rozwijaniu technologii sztucznej inteligencji.

Jak wyprzedzić ChatGPT i chronić ruch w witrynie?

Przedstawiamy Traffic Cop: Twoja tarcza przed nieautoryzowanym skrobaniem

MonetizeMore's Traffic Cop to najnowocześniejsze rozwiązanie, które działa jak solidna tarcza, skutecznie chroniąc Twoje zasoby cyfrowe przed skrobaniem botów i nieautoryzowanym dostępem.

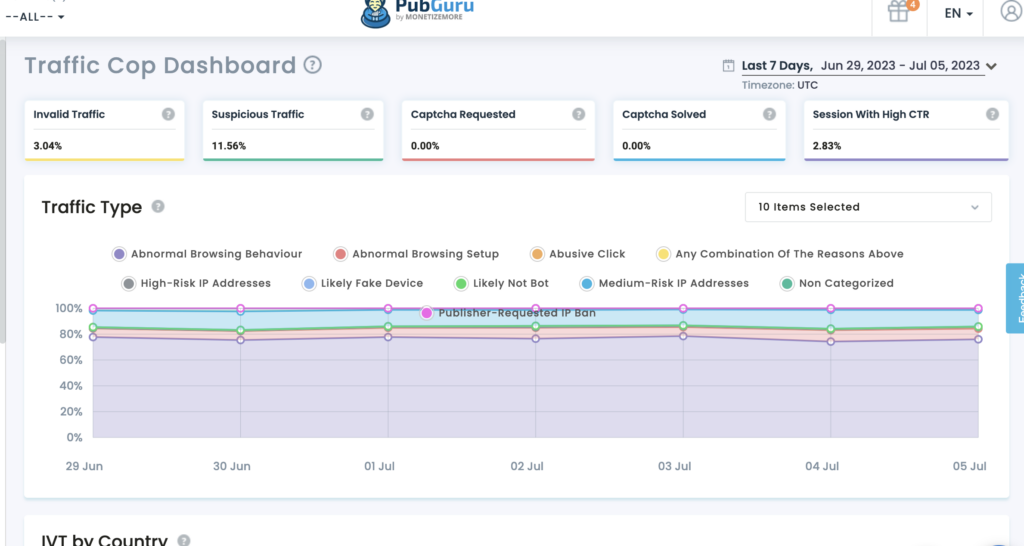

Ochrona Twoich treści: Dzięki Traffic Cop Twoje cenne treści są chronione przed nieautoryzowanym dostępem. Zaawansowane algorytmy uczenia maszynowego umożliwiają identyfikację i rozróżnienie między legalnym ruchem użytkowników a złośliwymi botami. Traffic Cop skutecznie blokuje próby skrobania, zapewniając, że Twoje treści pozostają wyłączne dla Twojej witryny.

Zabezpieczanie danych: Dane są siłą napędową firm internetowych. Traffic Cop pomaga zachować integralność i poufność danych. Wielokrotnie nagradzane narzędzie wykorzystuje zaawansowane algorytmy do identyfikowania i blokowania działań związanych z gromadzeniem danych, zapewniając ochronę danych.

Zachowanie ruchu w sieci: Ruch w sieci jest niezbędny dla powodzenia każdego przedsięwzięcia online. Jednak nieautoryzowane pobieranie danych może wyczerpać zasoby, wpłynąć na wydajność witryny i osłabić wysiłki SEO. Traffic Cop to Twój czujny strażnik, trzymający złośliwe boty na dystans i chroniący ruch w sieci. Wdrożenie zaawansowanych mechanizmów wykrywania botów i proaktywnych środków gwarantuje, że prawdziwi użytkownicy mają nieprzerwany dostęp do Twojej witryny, poprawiając komfort użytkowania i maksymalizując potencjał konwersji.

Dlaczego warto wybrać policję drogową?

- Kompleksowa ochrona: Traffic Cop zapewnia holistyczną ochronę przed próbami skrobania, chroniąc jednocześnie zawartość, dane i ruch internetowy.

- Zaawansowane wykrywanie botów: Dokładnie rozróżnia prawdziwych użytkowników od złośliwych botów, zapobiegając nieautoryzowanemu dostępowi i czynnościom typu scraping.

- Proaktywne środki bezpieczeństwa: ta technologia wykorzystuje najnowocześniejsze algorytmy do identyfikowania i blokowania prób scrapingu w czasie rzeczywistym, będąc o krok przed potencjalnymi zagrożeniami.

- Ulepszone wrażenia użytkownika: Zachowując ruch sieciowy i powstrzymując złośliwe boty, Traffic Cop zapewnia nieprzerwany dostęp dla prawdziwych użytkowników, poprawiając ich wrażenia i zwiększając współczynniki konwersji.

Inne niż to:

Wykorzystaj ograniczenie szybkości: zastosuj środki ograniczające szybkość, aby ograniczyć liczbę żądań przypadających na adres IP lub użytkownika, zapobiegając przeciążeniu witryny przez boty próbami skrobania.

Ograniczanie szybkości to skuteczna technika zapobiegania atakom typu scraping poprzez ograniczenie liczby żądań, które użytkownik lub adres IP może wykonać w określonym przedziale czasowym. Ustanawiając rozsądne limity, możesz zapewnić, że prawdziwi użytkownicy będą mieli dostęp do Twojej witryny, jednocześnie zniechęcając boty do prób zeskrobywania treści. Wdrożenie ograniczenia szybkości może pomóc w utrzymaniu wydajności i dostępności Twojej witryny.

Chroń swoje kanały RSS: jeśli dostarczasz kanały RSS do dystrybucji, upewnij się, że są one chronione przed skrobaniem, dodając mechanizmy uwierzytelniania lub implementując klucze API.

Kanały RSS mogą być cennym źródłem syndykacji treści, ale mogą być również celem botów skrobających. Aby chronić swoje kanały RSS, kluczowe jest wdrożenie mechanizmów uwierzytelniania lub kluczy API. Wymagając uwierzytelnienia, możesz zapewnić, że tylko autoryzowani użytkownicy lub aplikacje będą mieli dostęp do Twoich kanałów RSS i będą z nich korzystać. Ponadto wdrożenie kluczy API może pomóc w śledzeniu i kontrolowaniu dostępu do Twoich kanałów, zapobiegając nieautoryzowanym próbom skrobania.

Wdrażając te strategie, możesz znacznie zmniejszyć ryzyko skrobania ChatGPT i LLM, chroniąc w ten sposób swoje treści, dane i ruch w sieci.

Zrób to, aby nadążyć za apokalipsą AI.

Ponieważ ChatGPT i inne LLM wciąż się rozwijają, wydawcy muszą rozważyć pewne kluczowe aspekty, aby chronić swoje treści i ruch w sieci:

- Bądź na bieżąco: Bądź na bieżąco z najnowszymi osiągnięciami w technologii sztucznej inteligencji i przetwarzania języka naturalnego. Pomoże Ci to zrozumieć potencjalne zagrożenia i możliwości związane z tymi narzędziami.

- Przejrzyj warunki korzystania z usługi: Upewnij się, że Twoje warunki korzystania z usługi wyraźnie zabraniają zbierania danych i określają konsekwencje naruszenia tych warunków.

- Poznaj możliwości prawne: jeśli podejrzewasz naruszenie swoich praw własności intelektualnej w wyniku scrapingu, skonsultuj się z ekspertami prawnymi, aby poznać dostępne środki prawne.

- Zaangażuj się w branżę: Współpracuj ze stowarzyszeniami i organizacjami branżowymi, aby wspólnie stawić czoła wyzwaniom związanym ze skrobaniem i opowiadać się za lepszymi środkami ochrony.

Aktywnie rozważając te czynniki, wydawcy mogą lepiej chronić swoje treści, dane i ruch w sieci w dobie ChatGPT i powstających technologii LLM.

Oprócz tych kluczowych kwestii, wydawcy powinni również zdawać sobie sprawę z potencjalnego wpływu ChatGPT i LLM na zaangażowanie odbiorców. Wraz z rozwojem treści generowanych przez sztuczną inteligencję istnieje możliwość, że czytelnicy staną się bardziej sceptyczni co do autentyczności i wiarygodności informacji, które konsumują. Wydawcy powinni podjąć kroki w celu zbudowania zaufania wśród swoich odbiorców, wyraźnie oznaczając treści generowane przez sztuczną inteligencję i zapewniając przejrzystość źródła informacji.

Inną ważną kwestią są potencjalne implikacje etyczne treści generowanych przez sztuczną inteligencję. Ponieważ LLM stają się coraz bardziej zaawansowane, istnieje potrzeba zapewnienia, że generowane treści nie utrwalają uprzedzeń ani dezinformacji. Wydawcy powinni ustanowić wytyczne i procesy przeglądu, aby zapewnić zgodność treści generowanych przez sztuczną inteligencję z ich standardami redakcyjnymi i wartościami.

Ponadto należy pamiętać o zmieniającym się otoczeniu prawnym dotyczącym treści generowanych przez sztuczną inteligencję. Ponieważ technologie te stają się coraz bardziej rozpowszechnione, mogą zostać wprowadzone nowe przepisy i ramy prawne regulujące ich wykorzystanie. Bycie na bieżąco z tymi wydarzeniami i konsultowanie się z ekspertami prawnymi może pomóc wydawcom w radzeniu sobie z zawiłościami prawnymi treści generowanych przez sztuczną inteligencję.

Wniosek

Ochrona treści, danych i ruchu internetowego przed skrobaniem ChatGPT ma kluczowe znaczenie dla utrzymania integralności Twojej firmy. Zagraża to ich przychodom i wygodzie użytkownika oraz wpływa na ich widoczność i reputację online. Rozumiejąc proces scrapingu, wdrażając środki ochronne, badając opcje prawne i wspierając współpracę, wydawcy mogą chronić swoje treści i ograniczać ryzyko związane ze scrapingiem opartym na sztucznej inteligencji.

MonetizeMore's Traffic Cop oferuje kompleksowe rozwiązanie zapewniające bezpieczeństwo treści, danych i ruchu internetowego. Wykorzystując zaawansowane wykrywanie botów i proaktywne środki bezpieczeństwa, Traffic Cop pozwala skupić się na podstawowej działalności, jednocześnie skutecznie chroniąc zasoby cyfrowe.

Skorzystaj z usługi Traffic Cop już dziś i ciesz się spokojem, wiedząc, że Twoja obecność w Internecie jest chroniona przed nieautoryzowanym dostępem.

Poznaj Aleeshę Jacob, doświadczoną menedżerkę ds. treści B2B i SEO z ponad 7-letnim doświadczeniem w tworzeniu treści opartych na danych, które napędzają konwersje dla firm SAAS. Pracując z firmami zajmującymi się technologią reklamową i klientami, takimi jak BMW i Heineken, Aleesha wnosi bogate doświadczenie. Dzięki niezrównanym umiejętnościom tworzenia atrakcyjnych treści pomaga firmom różnej wielkości zdobywać więcej potencjalnych klientów, zwiększać przychody i zwiększać swoją obecność w Internecie.