Edge AI: jak przetwarzanie brzegowe wzmacnia nową falę sztucznej inteligencji

Opublikowany: 2022-11-22Ostatnie badania sugerują, że liczba urządzeń Internetu rzeczy używanych na całym świecie przekroczy 38 miliardów do 2025 roku. Gwałtowny wzrost nieuchronnie wpłynie na stan przyjęcia sztucznej inteligencji, ponieważ obie koncepcje — Internet rzeczy i sztuczna inteligencja — zawsze szły ręka w rękę.

Wraz z powoli wychodzącym z mody złotym standardem tworzenia systemów IoT, podejściem zorientowanym na chmurę, sztuczna inteligencja również zacznie zbliżać się do krawędzi. Powody przejścia na urządzenia brzegowe są różne, ale najbardziej zauważalne to duże opóźnienia i wysokie koszty przetwarzania w chmurze. Są one szczególnie dotkliwe w przypadku wielkoskalowych systemów IoT.

Mimo to, podczas gdy dostawcy oprogramowania do sztucznej inteligencji poszerzają swoją ofertę, opracowując systemy Edge AI, firmy zastanawiają się: czym dokładnie jest Edge AI, jak działa pod maską i jakie są typowe przypadki użycia AI Edge, na podstawie których można je rozwijać? Jeśli zadajesz sobie takie pytania, czytaj dalej. W poniższym artykule zwracamy uwagę na wnętrzności, przypadki użycia, korzyści i ograniczenia sztucznej inteligencji na krawędzi.

Czym jest Edge AI i czym różni się od sztucznej inteligencji w chmurze?

Standardową architekturę IoT można z grubsza podzielić na trzy komponenty: rzeczy, bramy i chmurę. Rzeczy oznaczają wszelkiego rodzaju narzędzia, gadżety i sprzęt wzbogacony o czujniki generujące dane. Bramy to scentralizowane urządzenia, na przykład routery, które łączą rzeczy z chmurą. Urządzenia końcowe i bramy tworzą razem warstwę brzegową.

Z kolei Edge AI oznacza wdrażanie algorytmów AI bliżej krawędzi sieci, czyli albo podłączonych urządzeń (węzły końcowe), albo bramek (węzły brzegowe).

W przeciwieństwie do podejścia opartego na chmurze, w którym algorytmy sztucznej inteligencji są opracowywane i wdrażane w chmurze, systemy sztucznej inteligencji skoncentrowane na krawędzi podejmują decyzje w ciągu milisekund i działają po niższych kosztach.

Inne zalety Edge AI w porównaniu z rozwiązaniami AI w chmurze obejmują:

- Krótszy czas przetwarzania: ponieważ dane są analizowane lokalnie, nie ma potrzeby wysyłania żądań do chmury i oczekiwania na odpowiedzi, co ma ogromne znaczenie w przypadku aplikacji o krytycznym znaczeniu czasowym, takich jak urządzenia medyczne czy systemy wspomagające kierowcę

- Zmniejszona przepustowość i koszty: bez konieczności przesyłania dużych ilości danych z czujników do chmury, systemy Edge AI wymagają mniejszej przepustowości (używanej głównie do przesyłania metadanych), co wiąże się z niższymi kosztami operacyjnymi

- Zwiększone bezpieczeństwo: lokalne przetwarzanie danych pomaga zmniejszyć ryzyko naruszenia poufnych informacji w chmurze lub podczas przesyłania

- Większa niezawodność: Edge AI działa nawet w przypadku zakłóceń sieci lub tymczasowej niedostępności usług w chmurze

- Zoptymalizowane zużycie energii: lokalne przetwarzanie danych zwykle zużywa mniej energii niż przesyłanie wygenerowanych danych do chmury, co pomaga wydłużyć żywotność baterii urządzeń końcowych

Według Markets and Markets, globalny rynek oprogramowania Edge AI ma osiągnąć 1,8 miliarda dolarów do 2026 roku, rosnąc przy CAGR na poziomie 20,8%. Oczekuje się, że różne czynniki, takie jak rosnące obciążenia przedsiębiorstw w chmurze i szybki wzrost liczby inteligentnych aplikacji, będą napędzać wdrażanie rozwiązań Edge AI.

Jak Edge AI działa pod maską

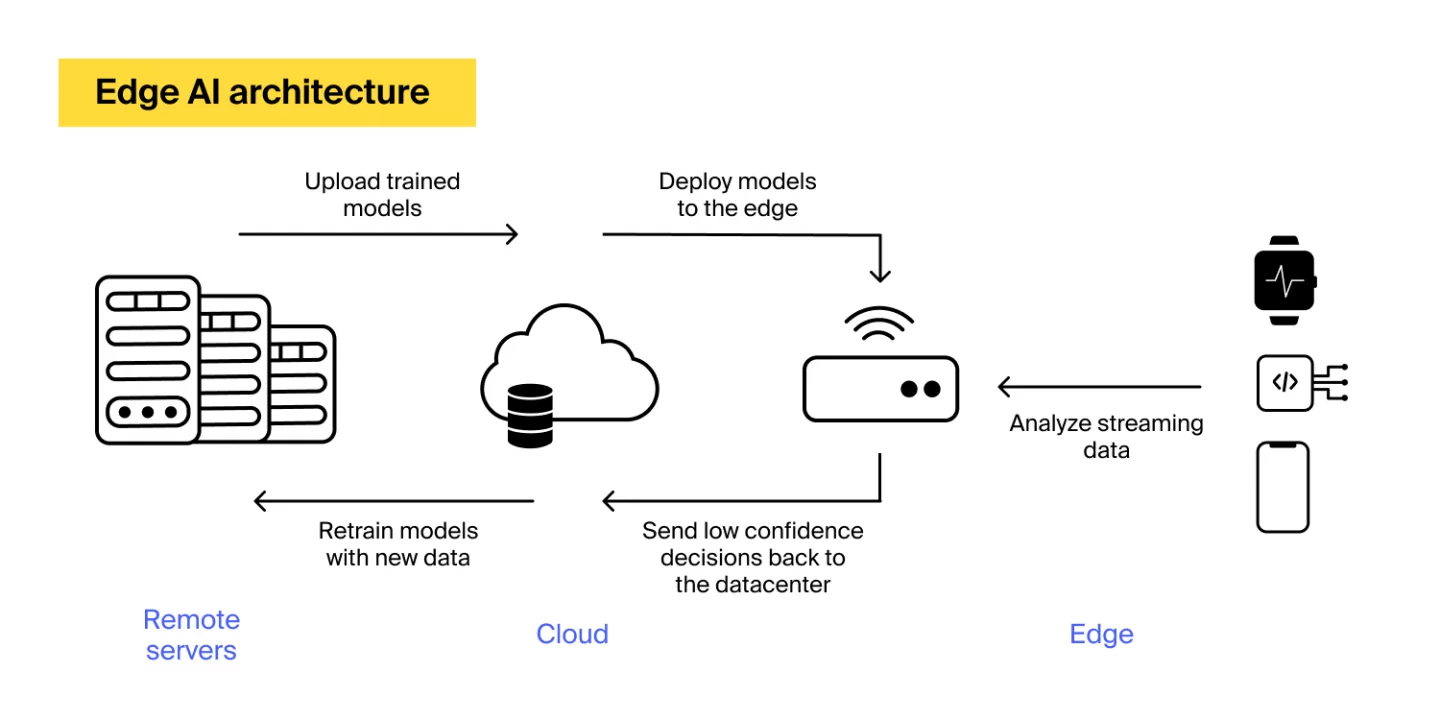

Pomimo powszechnego błędnego przekonania, standardowe rozwiązanie sztucznej inteligencji skoncentrowane na krawędzi jest zwykle wdrażane w sposób hybrydowy — z urządzeniami brzegowymi podejmującymi decyzje na podstawie danych przesyłanych strumieniowo i centrum danych (zwykle w chmurze) używanym do przeglądu i ponownego szkolenia wdrożonych modeli sztucznej inteligencji.

Tak więc podstawowa architektura Edge AI zazwyczaj wygląda tak:

Aby systemy Edge AI mogły rozumieć ludzką mowę, prowadzić pojazdy i wykonywać inne nietrywialne zadania, potrzebują inteligencji podobnej do ludzkiej. W tych systemach ludzkie poznanie jest replikowane za pomocą algorytmów głębokiego uczenia się, podzbioru sztucznej inteligencji.

Proces uczenia modeli głębokiego uczenia się często odbywa się w chmurze, ponieważ osiągnięcie większej dokładności wymaga ogromnych ilości danych i dużej mocy obliczeniowej. Po przeszkoleniu modele głębokiego uczenia są wdrażane na urządzeniu końcowym lub na urządzeniu brzegowym, gdzie działają teraz autonomicznie.

Jeśli model napotka problem, informacja zwrotna jest przesyłana do chmury, gdzie rozpoczyna się ponowne uczenie, aż do zastąpienia modelu na krawędzi nowym, dokładniejszym. Ta pętla sprzężenia zwrotnego pozwala zachować precyzję i skuteczność rozwiązania Edge AI.

Przegląd technologii sprzętowych i programowych umożliwiających sztuczną inteligencję brzegową

Standardowa implementacja sztucznej inteligencji na krawędzi wymaga komponentów sprzętowych i programowych.

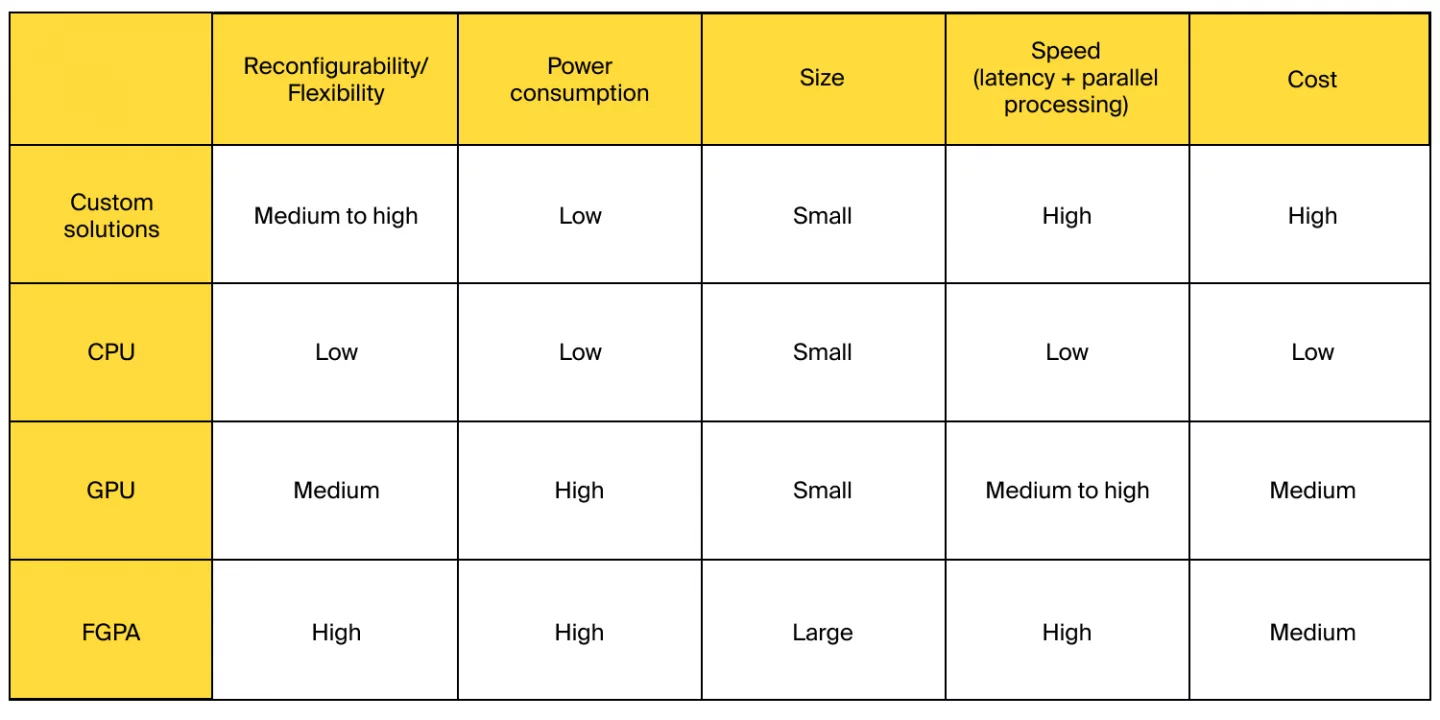

W zależności od konkretnej aplikacji Edge AI może istnieć kilka opcji sprzętowych do wykonywania przetwarzania Edge AI. Najpopularniejsze obejmują procesory, procesory graficzne, układy scalone specyficzne dla aplikacji (ASIC) i programowalne macierze bramek (FPGA).

Układy ASIC zapewniają wysokie możliwości przetwarzania, a jednocześnie są energooszczędne, co sprawia, że dobrze pasują do szerokiej gamy aplikacji Edge AI.

Procesory graficzne z kolei mogą być dość kosztowne, zwłaszcza jeśli chodzi o obsługę rozwiązań brzegowych na dużą skalę. Mimo to są one preferowaną opcją w przypadkach krytycznych dla opóźnień, które wymagają błyskawicznego przetwarzania danych, takich jak samochody bez kierowcy lub zaawansowane systemy wspomagające kierowcę.

Układy FPGA zapewniają jeszcze lepszą moc obliczeniową, efektywność energetyczną i elastyczność. Kluczową zaletą układów FPGA jest to, że są programowalne, czyli sprzęt „postępuje” zgodnie z instrukcjami oprogramowania. Pozwala to na większą oszczędność energii i rekonfigurację, ponieważ można po prostu zmienić charakter przepływu danych w sprzęcie, w przeciwieństwie do zakodowanych na stałe układów ASIC, procesorów i procesorów graficznych.

Podsumowując, wybierając optymalną opcję sprzętową dla rozwiązania Edge AI, należy wziąć pod uwagę kombinację czynników, w tym możliwość rekonfiguracji, zużycie energii, rozmiar, szybkość przetwarzania i koszty. Oto porównanie popularnych opcji sprzętowych według podanych kryteriów:

Źródło

Z kolei oprogramowanie Edge AI zawiera pełen stos technologii umożliwiających proces głębokiego uczenia i pozwalający algorytmom AI działać na urządzeniach brzegowych. Infrastruktura oprogramowania Edge AI obejmuje pamięć masową, zarządzanie danymi, analizę danych/wnioskowanie AI oraz komponenty sieciowe.

Przypadki użycia Edge AI

Firmy z różnych sektorów już korzystają z brzegowej sztucznej inteligencji. Oto zestawienie najbardziej znanych przypadków użycia Edge AI z różnych branż.

Handel detaliczny: poprawa jakości zakupów

Pozytywne doświadczenia zakupowe są głównym problemem sprzedawców detalicznych, ponieważ jest to czynnik decydujący o utrzymaniu klientów. Korzystając z analiz opartych na sztucznej inteligencji, sprzedawcy detaliczni mogą dbać o zadowolenie konsumentów, upewniając się, że staną się oni stałymi klientami.

Jedną z wielu aplikacji Edge AI, które pomagają pracownikom handlu detalicznego w ich codziennych operacjach i zapewniają lepszą obsługę klienta, jest wykorzystywanie Edge AI do określania, kiedy produkty wymagają uzupełnienia i wymiany.

Kolejna aplikacja wykorzystująca sztuczną inteligencję wykorzystuje komputerowe rozwiązania wizyjne w inteligentnych systemach kasowych, które mogą ostatecznie uwolnić klientów od konieczności skanowania towarów przy kasie.

Detaliści używają również inteligentnej analizy wideo, aby zagłębić się w preferencje klientów i odpowiednio ulepszyć układ sklepu.

Produkcja: wprowadzenie inteligentnej fabryki

Przedsiębiorstwa produkcyjne, zwłaszcza zajmujące się produkcją precyzyjną, muszą zapewnić dokładność i bezpieczeństwo procesu produkcyjnego. Wzbogacając zakłady produkcyjne o sztuczną inteligencję, producenci mogą zapewnić bezpieczeństwo i wydajność hali produkcyjnej. W tym celu przyjmują aplikacje AI, które przeprowadzają inspekcje w halach produkcyjnych, podobnie jak te używane przez Procter & Gamble i BMW.

Firma Procter & Gamble korzysta z zaawansowanego rozwiązania AI, które wykorzystuje materiał z kamer inspekcyjnych do kontroli zbiorników z mieszanką chemiczną. Aby produkty z wadami nie trafiały do linii produkcyjnej, rozwiązanie Edge AI wdrożone bezpośrednio w kamerach wskazuje niedoskonałości i powiadamia kierowników hali produkcyjnej o wykrytych odchyleniach jakościowych.

BMW wykorzystuje połączenie przetwarzania brzegowego i sztucznej inteligencji, aby uzyskać wgląd w fabrykę w czasie rzeczywistym. Przedsiębiorstwo otrzymuje wyraźny obraz swojej linii montażowej dzięki inteligentnym kamerom zainstalowanym w całym zakładzie produkcyjnym.

Motoryzacja: umożliwienie autonomicznych samochodów

Autonomiczne samochody i zaawansowane systemy wspomagające kierowcę polegają na sztucznej inteligencji w celu poprawy bezpieczeństwa, wydajności i zmniejszenia ryzyka wypadków.

Autonomiczne samochody są wyposażone w różne czujniki, które zbierają informacje o warunkach drogowych, lokalizacji pieszych, poziomie oświetlenia, warunkach jazdy, obiektach wokół pojazdu i innych czynnikach. Ze względów bezpieczeństwa te duże ilości danych muszą być przetwarzane szybko. Edge AI zajmuje się zadaniami monitorowania wrażliwymi na opóźnienia, takimi jak wykrywanie obiektów, śledzenie obiektów i rozpoznawanie lokalizacji.

Bezpieczeństwo: wspomaganie rozpoznawania twarzy

Jednym z obszarów, które coraz częściej przechodzą na krawędź, jest rozpoznawanie twarzy.

W przypadku aplikacji zabezpieczających z funkcją rozpoznawania twarzy, na przykład systemu bezpieczeństwa inteligentnego domu, czas reakcji ma kluczowe znaczenie. W tradycyjnych systemach opartych na chmurze materiał z kamery jest stale przemieszczany po sieci, co wpływa na szybkość przetwarzania rozwiązania i koszty operacyjne.

Bardziej efektywnym podejściem jest przetwarzanie danych wideo bezpośrednio w kamerach bezpieczeństwa. Ponieważ przeniesienie danych do chmury nie wymaga czasu, aplikacja może być bardziej niezawodna i responsywna.

Elektronika użytkowa: udostępnianie nowych funkcji w urządzeniach mobilnych

Urządzenia mobilne generują mnóstwo danych. Przetwarzanie tych danych w chmurze wiąże się z pewnymi wyzwaniami, takimi jak duże opóźnienia i wykorzystanie przepustowości. Aby przezwyciężyć te problemy, programiści mobilni zaczęli dostosowywać sztuczną inteligencję brzegową do przetwarzania generowanych danych z większą szybkością i niższymi kosztami.

Mobilne przypadki użycia obsługiwane przez Edge AI obejmują rozpoznawanie mowy i twarzy, wykrywanie ruchu i upadków i nie tylko.

Powszechne podejście jest jednak nadal hybrydowe. Dane, które wymagają większej pamięci lub wysokich możliwości obliczeniowych, są przesyłane do chmury lub warstwy mgły, podczas gdy dane, które można interpretować lokalnie, pozostają na krawędzi.

Bariery w adopcji sztucznej inteligencji na krawędzi

Ograniczona moc obliczeniowa

Trenowanie algorytmów AI wymaga wystarczających mocy obliczeniowych, które są w dużej mierze nieosiągalne na krawędzi. Tak więc większość aplikacji skoncentrowanych na krawędzi nadal zawiera część chmurową, w której algorytmy sztucznej inteligencji są szkolone i aktualizowane.

Jeśli skłaniasz się ku zbudowaniu aplikacji skoncentrowanej na krawędzi, która w mniejszym stopniu opiera się na chmurze, musisz przemyśleć sposoby optymalizacji przechowywania danych na urządzeniu (na przykład przechowywanie tylko ramek zawierających twarz w aplikacjach do rozpoznawania twarzy) oraz Proces szkolenia AI.

Luki w zabezpieczeniach

Chociaż zdecentralizowany charakter aplikacji brzegowych i brak potrzeby przesyłania danych przez sieć zwiększa funkcje bezpieczeństwa aplikacji skoncentrowanych na brzegu sieci, węzły końcowe są nadal podatne na cyberataki. Dlatego potrzebne są dodatkowe środki bezpieczeństwa, aby przeciwdziałać zagrożeniom bezpieczeństwa. Modele uczenia maszynowego, które napędzają rozwiązania brzegowe, również mogą być dostępne i modyfikowane przez przestępców. Blokowanie ich i traktowanie ich jako kluczowych zasobów może pomóc w zapobieganiu problemom związanym z bezpieczeństwem brzegowym.

Utrata danych

Sama natura krawędzi oznacza, że dane mogą nie dotrzeć do chmury w celu przechowywania. Urządzenia końcowe można skonfigurować tak, aby odrzucały wygenerowane dane w celu obniżenia kosztów operacyjnych lub poprawy wydajności systemu. Chociaż ustawienia chmury mają sporo ograniczeń, ich główną zaletą jest fakt, że wszystkie — lub prawie wszystkie — wygenerowane dane są przechowywane, dzięki czemu można je wykorzystać do zebrania wglądu.

Jeśli przechowywanie danych jest konieczne w konkretnym przypadku użycia, zalecamy przejście na hybrydę i wykorzystanie chmury do przechowywania i analizowania użytkowania oraz innych danych statystycznych, tak jak zrobiliśmy to, opracowując inteligentne lustro fitness dla naszych klientów.

Jeśli nadal masz pytania bez odpowiedzi dotyczące Edge AI lub szukasz zaufanego partnera do wdrożenia aplikacji Edge AI, napisz do ITRex. Nasi eksperci chętnie Ci pomogą.

Pierwotnie opublikowane na stronie https://itrexgroup.com 1 listopada 2022 r.