Pięć technologii kognitywnych w kształtowaniu przyszłości

Opublikowany: 2019-12-04Technologia Cognitive to zaawansowane systemy wspomagania kierowcy oparte na sztucznej inteligencji. Badanie sugerowane przez Hackett Group sugeruje, że 85 procent liderów zakupów jest zaangażowanych w badania nad technologiami kognitywnymi, które rozwiną program operacyjny w ciągu najbliższych trzech-pięciu lat. Tylko 32 proc. wszystkich posiada strategię wdrożenia technologii, a spośród nich 25 proc. ma wystarczający kapitał i spryt, by je wdrożyć. Proponuję Ci najbardziej potencjalne technologie kognitywne, które mogą kształtować Twoją przyszłość.

Ponieważ sztuczna inteligencja staje się podstawą rozwoju naszego codziennego życia. Organizacje IT muszą przyjąć tę nowo powstałą technologię, aby utrzymać swoją pozycję na rynku. W zarządzaniu usługami, aby eskalować całościowy system, ważna jest integracja technologii kognitywnych. Takie podejście oferuje ogromne potencjalne korzyści w kształtowaniu przyszłości zarówno użytkowników, jak i zarządzania usługami. Integrując technologie kognitywne, możesz oferować swoim użytkownikom spersonalizowane, zaawansowane i konwersacyjne doświadczenia, które przyniosły lepsze i szybsze wyniki. Tak jak użytkownicy smartfonów nakazują swojemu asystentowi pomaganie w różnych codziennych zadaniach, tak samo uzyskasz dokładne wrażenia dzięki obsłudze, która prosi chatboty o pomoc w różnych czynnościach bez ingerencji człowieka. W ten sposób możesz uzyskać wysoką satysfakcję klientów.

Analiza Big Data

Big Data Analytics to proces zarządzania ogromną ilością danych w celu rysowania wzorców, trendów i praktycznych spostrzeżeń za pomocą zaawansowanych technologii i funkcji obliczeniowych. Jest to forma zaawansowanej analityki obejmującej skomplikowane aplikacje z modelami predykcyjnymi i algorytmami statystycznymi, zadania te wykonują wysokowydajne systemy analityczne. Te wyspecjalizowane systemy i oprogramowanie analityczne oferują wiele korzyści, w tym większe możliwości uzyskania przychodów, bazę marketingową, zaawansowaną obsługę klienta, efektywność operacyjną, lepszą przewagę konkurencyjną. Aplikacje oparte na aplikacjach analitycznych Big Data dają przestrzeń analitykom danych, modelarzom predykcyjnym, statystykom, innym specjalistom w tej dziedzinie do analizy rosnących wolumenów ustrukturyzowanych danych transakcyjnych i innych form danych, które nie są praktykowane przez tradycyjne programy BI i analityczne. Otacza połączenie danych ustrukturyzowanych i nieustrukturyzowanych. Dzięki połączeniu czujnika dane te są gromadzone i łączone z Internetem Rzeczy (Internet of Things). Wykorzystywanych jest wiele narzędzi i technologii:

- Bazy danych NoSQL

- Hadoop

- PRZĘDZA

- MapaReduce

- Iskra

- Hbase

- Ul

- Świnia

Aplikacje do analizy Big Data zawierają dane z systemów wewnętrznych i źródeł zewnętrznych, takich jak dane pogodowe dotyczące konsumentów, zebrane przez zewnętrznych dostawców usług informacyjnych. Aplikacja do analizy strumieniowej stała się powszechna w środowiskach Big Data do przeprowadzania analiz w czasie rzeczywistym danych wprowadzanych do systemów Hadoop za pomocą silników przetwarzania strumieniowego, takich jak Spark, Flink i Storm. Z tą technologią zintegrowane są skomplikowane systemy analityczne, które umożliwiają zarządzanie i analizowanie dużej ilości danych. Big Data stało się niezwykle korzystne w analityce łańcucha dostaw. Do 2011 roku analityka big data zaczęła zajmować silną pozycję w organizacjach i oczach opinii publicznej. Wraz z Big Data Hadoop i innymi powiązanymi technologiami Big Data zaczęły się wokół niego pojawiać. Przede wszystkim ekosystem Hadoop zaczął nabierać kształtu i dojrzewać z czasem. Big Data były przede wszystkim platformą dużych firm zajmujących się systemami internetowymi i handlem elektronicznym. Obecnie został przyjęty przez sprzedawców detalicznych, firmy świadczące usługi finansowe, ubezpieczycieli, organizacje opieki zdrowotnej, produkcję i inne potencjalne przedsiębiorstwa. W niektórych przypadkach klastry Hadoop i systemy NoSQL są używane na poziomie wstępnym jako lądowiska i obszary pomostowe dla danych. Cała akcja jest wykonywana, zanim zostanie załadowana do analitycznej bazy danych, aby przeprowadzić ogólną analizę w złożonej formie. Gdy dane są gotowe, można je analizować za pomocą oprogramowania służącego do zaawansowanych procesów analitycznych. Eksploracja danych, analityka predykcyjna, uczenie maszynowe, głębokie uczenie to typowe narzędzia do zakończenia całej akcji. W tym spektrum bardzo ważne jest, aby wspomnieć, że oprogramowanie do eksploracji tekstu i analizy statystycznej odgrywa kluczową rolę w procesie analizy big data. W przypadku aplikacji ETL i analitycznych zapytania są skryptowane w MapReduce za pomocą różnych języków programowania, takich jak R, Python, Scala i SQL.

Nauczanie maszynowe:

Uczenie maszynowe to zaawansowany, ciągły proces, w którym maszyny są opracowywane w taki sposób, aby mogły wykonywać swoje zadania jako człowiek. Maszyny te są opracowywane przy użyciu zaawansowanych technologicznie danych, aby wykonywać swoje zadania bez interwencji człowieka. Uczenie maszynowe to aplikacja sztucznej inteligencji, która daje maszynie możliwość uczenia się i ulepszania programu bez żadnych bezpośrednich i wyraźnych działań. Zasadniczo koncentruje się na opracowaniu programu komputerowego, który może uzyskać dostęp do danych i wykorzystać je do samodzielnej nauki. Jego głównym celem jest umożliwienie maszynom automatycznego uczenia się bez pomocy człowieka. Uczenie maszynowe jest ściśle związane ze statystyką obliczeniową, w związku z czym badanie optymalizacji matematycznej jest zadaniem uczenia maszynowego. Zadanie uczenia maszynowego można podzielić na kilka szerokich kategorii.

- Nadzorowana nauka.

- Nauka częściowo nadzorowana.

- Nienadzorowane uczenie maszynowe.

- Wzmocnienie uczenia maszynowego.

Wszystkie te sklasyfikowane kategorie uczenia maszynowego oferują inny odcień zadania w analizie danych i informacji oraz podejmowaniu istotnych decyzji:

- Algorytm uczenia tworzy przypuszczalną funkcję do przewidywania wartości wyjściowej. Algorytmy uczenia można porównać jego wyniki z obliczonymi wynikami i znaleźć błędy modyfikacji modelu zgodnie z wymaganiami.

- Nienadzorowane algorytmy uczenia maszynowego nie mogą skorygować właściwych wyników, a raczej mogą eksplorować dane i wyciągać wnioski z zestawu danych w celu opisania ukrytej struktury z danych nieoznaczonych.

- Częściowo nadzorowany algorytm uczenia maszynowego jest używany zarówno w przypadku danych oznaczonych, jak i nieoznaczonych.

- Wzmacniające algorytmy uczenia maszynowego wchodzą w interakcję ze środowiskiem, aby wywoływać działania i odkrywać nagrody i błędy. Proces prób i błędów okazał się być najważniejszą cechą tej nauki. Aby umożliwić ten proces, prosta informacja zwrotna o nagrodzie jest niezbędna do nauczenia się, które działanie jest najlepsze, co jest ogólnie określane jako sygnał wzmacniający.

Podobnie jak analiza Big Data, uczenie maszynowe umożliwia również analizę ogromnej ilości danych. Ma tendencję do dostarczania szybkich i najdokładniejszych wyników w celu identyfikacji korzystnych możliwości lub zarządzania systemem zarządzania ryzykiem. Jednak prawidłowe wykonanie całego programu może również wymagać dodatkowego czasu i zasobów. Jest to bardzo skuteczny proces zarządzania i monitorowania ogromnej ilości danych i informacji.

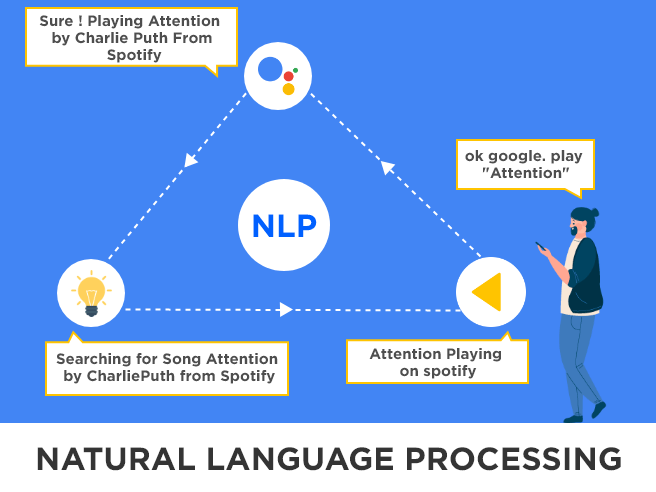

Przetwarzanie języka naturalnego (NLP)

Przetwarzanie języka naturalnego polega na trenowaniu maszyn z ludzką inteligencją, aby powodowały zmiany w ich języku i odpowiedzi, aby uczynić je bardziej ludzkimi. W rzeczywistości odnosi się do tego, jak się ze sobą komunikujemy. NLP definiuje się jako automatyczne manipulowanie językiem naturalnym poprzez użycie oprogramowania. Badania nad przetwarzaniem języka natury rozpoczęto ponad 50 lat temu. Różni się od innych typów danych. Niemniej jednak, po tylu latach pracy, wyzwanie związane z procesem języka naturalnego nie zostało rozwiązane w czasopiśmie Mathematical Linguistic, opublikowanym przez zapalonego naukowca: „jest to trudne z punktu widzenia dziecka, które musi spędzić wiele lat na nauce języka … trudno jest dorosłemu uczącemu się języka, trudno jest naukowcowi, który próbuje modelować odpowiednie zjawiska, a także inżynierowi, który próbuje budować systemy, które zajmują się wejściem i wyjściem języka naturalnego. Te zadania są trudne, że Turing mógł słusznie uczynić płynną rozmowę w języku naturalnym centralnym elementem jego testu na inteligencję”.

Ponieważ uczenie maszynowe naukowcy i badacze są zainteresowani pracą z danymi, a językoznawcy mogą pracować w procesie NLP. Współcześni twórcy sugerowali, że: „celem językoznawstwa jest umiejętność scharakteryzowania i wyjaśnienia wielości spostrzeżeń językowych krążących wokół nas, w rozmowach, piśmie i innych mediach. Częściowo ma to związek z poznawczym rozmiarem tego, jak ludzie przyswajają, wytwarzają i rozumieją język, częściowo ze zrozumieniem relacji między wypowiedzią językową a światem, a częściowo ze zrozumieniem struktur językowych przez w jakim języku się komunikuje”

Sztuczna inteligencja

Sztuczna inteligencja napędza automatyzację podstawowych zadań za pomocą komputerów, które służą jako zaawansowani asystenci cyfrowi. Inteligencja ludzka opiera się na wyczuwaniu otoczenia, uczeniu się od otoczenia i przetwarzaniu informacji ze środowiska. Oznacza to, że sztuczna inteligencja obejmuje:

- Oszukiwanie ludzkiego zmysłu, takiego jak dotyk, smak, wzrok, węch i słuch.

- Oszukiwanie ludzkich reakcji: Robotyka.

- Oszustwo uczenia się i przetwarzania: Uczenie maszynowe i głębokie uczenie.

Cognitive Computing generalnie koncentruje się na naśladowaniu ludzkich zachowań i rozwiązywaniu problemów, które można rozwiązać potencjalnie nawet lepiej niż ludzka inteligencja. Cognitive Computing po prostu uzupełnia informacje, aby podejmować decyzje łatwiejsze niż kiedykolwiek. Natomiast sztuczna inteligencja odpowiada za samodzielne podejmowanie decyzji i minimalizowanie roli człowieka. Technologie, które działają za Cognitive Computing są podobne do technologii stojących za sztuczną inteligencją, które obejmują głębokie uczenie, uczenie maszynowe, sieci neuronowe, NLP itp. Chociaż przetwarzanie kognitywne jest ściśle związane ze sztuczną inteligencją, kiedy ich praktyczne zastosowanie wyszło na jaw, są zupełnie inne. AI definiuje się jako „symulację procesów ludzkiej inteligencji przez maszyny, zwłaszcza systemy komputerowe. Procesy te obejmują uczenie się (pozyskiwanie informacji i zasad korzystania z informacji), rozumowanie (wykorzystywanie reguł do przybliżonego lub ostatecznego wniosku) oraz autokorektę”. Sztuczna inteligencja to ogólny termin, w ramach którego wiele technologii, algorytmów, teorii i metod umożliwia komputerowi lub dowolnemu inteligentnemu urządzeniu działanie z zaawansowanymi technologiami z ludzką inteligencją. Uczenie maszynowe i robotyka są objęte sztuczną inteligencją, która pozwala maszynom oferować rozszerzoną inteligencję i może przewyższyć ludzki wgląd i dokładność. Narzędzie AI oferuje szereg nowych funkcjonalności w Twojej firmie. Algorytmy głębokiego uczenia zintegrowane z najbardziej zaawansowanymi narzędziami AI. Badacze i marketerzy uważają, że wprowadzenie rozszerzonej inteligencji ma bardziej neutralny wydźwięk, który pozwoli nam zrozumieć, że sztuczna inteligencja jest wykorzystywana w celu ulepszania produktów i usług. AI można podzielić na cztery kategorie:

Reaktywne maszyny: Komputer do gry w szachy Deep Blue firmy IBM jest w stanie zidentyfikować figury na szachownicy i odpowiednio przewidzieć, chociaż nie może uzyskać dostępu do przeszłych doświadczeń, aby poinformować przyszłe. Potrafi zarządzać i analizować możliwe ruchy. AlphaGO firmy Google to kolejny przykład, który został zaprojektowany do pracy w wąskich celach i nie można go zastosować w innej sytuacji.

Teoria umysłu: Chociaż tego typu sztuczna inteligencja jest rozwijana w taki sposób, aby maszyny mogły podejmować indywidualne decyzje. Chociaż ta technologia AI została opracowana dość dawno temu. Obecnie nie ma praktycznego zastosowania.

Ograniczona pamięć: Ta technologia sztucznej inteligencji została opracowana w celu wykonywania zadań w przyszłości w odniesieniu do przeszłych doświadczeń. Ma możliwość podejmowania i udzielania zaawansowanych wskazówek dotyczących każdej ważnej decyzji dotyczącej Twoich zadań. Na przykład: jeśli prowadzisz samochód, zaprojektowany przez sztuczną inteligencję system nawigacyjny może zapewnić Ci bezpośrednią zmianę pasa, aby dotrzeć do celu.

Samoświadomość: Opracowano sztuczną inteligencję, która może naprawdę mieć zmysł i świadomość taką, jaką ma ludzkie ciało. Maszyny zintegrowane z samoświadomością potrafią zrozumieć obecny stan, wykorzystując informacje do odczytania tego, co czuje osoba trzecia.

Automatyzacja procesów

Automatyzacja procesów umożliwia łączenie różnych funkcji, automatyzację procesów i minimalizację błędów. Automatyzacja procesów to wykorzystanie technologii do automatyzacji biznesu. Pierwszym krokiem jest rozpoczęcie od rozpoznania procesów wymagających automatyzacji. Kiedy doskonale rozumiesz proces automatyzacji, powinieneś zaplanować cele dla automatyzacji. Zanim uruchomisz automatyzację, musisz sprawdzić luki i błędy w procesie. Oto lista, na której możesz rozszyfrować, dlaczego potrzebujesz procesu automatyzacji w swojej firmie:

- Standaryzacja i usprawnienie procesów.

- Aby sprawnie rozwiązać proces, zmniejszając koszty.

- Aby opracować lepszą alokację zasobów.

- Dla poprawy obsługi klienta.

- Aby poprawić zgodność w celu uregulowania i standaryzacji procesów biznesowych.

- Aby zapewnić wysoką satysfakcję pracowników.

- Aby poprawić widoczność wydajności przetwarzania.

Grupa działów może przyjąć proces biznesowy, aby zautomatyzować swój proces i ułatwić cykl o skomplikowanym charakterze.

Źródło obrazu nagłówka: https://bit.ly/2PfdWWm