Jak ChatGPT wpływa na zautomatyzowany ruch botów?

Opublikowany: 2023-06-28

Pojawienie się ChatGPT i podobnych technologii sztucznej inteligencji niesie ze sobą zarówno możliwości, jak i wyzwania. Jako wydawca kluczowe jest zbadanie potencjalnego wpływu ChatGPT na ruch zautomatyzowany/botów i opracowanie skutecznych strategii łagodzenia jego negatywnych konsekwencji. W tym artykule omówiono wpływ ChatGPT na generowanie ruchu przez boty, pobieranie treści i naruszenie praw własności intelektualnej oraz przedstawiono możliwe do podjęcia inicjatywy w celu rozwiązania tych problemów.

1. Ułatwienie generowania ruchu przez boty poprzez tworzenie kodu

Zdolność ChatGPT do generowania kodu jest nieocenionym narzędziem do edukacji i rozwiązywania problemów. Złośliwi aktorzy mogą jednak wykorzystać tę możliwość do stworzenia kodu, którego celem są strony internetowe ze zautomatyzowanym ruchem botów. Strony internetowe oparte na reklamach, których generowanie przychodów zależy od autentycznego zaangażowania użytkowników, są szczególnie narażone.

Ponieważ reklamodawcy zazwyczaj płacą za wyświetlenia i kliknięcia na podstawie interakcji użytkowników, zaangażowanie generowane przez boty może sztucznie zawyżać te wskaźniki. W rezultacie reklamodawcy mogą płacić za interakcje inicjowane nie przez rzeczywistych użytkowników, ale przez boty.

Ten błąd w sztuce nie tylko prowadzi do strat finansowych reklamodawców, ale także podkopuje zaufanie do internetowych platform reklamowych. Reklamodawcy oczekują, że ich inwestycje dotrą i zaangażują prawdziwych odbiorców. Kiedy zamiast tego ich reklamy są wyświetlane ruchowi botów, podważa to skuteczność i wartość ich kampanii reklamowych. Takie incydenty mogą zaszkodzić reputacji platformy reklamowej i powiązanych z nią wydawców, ponieważ reklamodawcy obawiają się przeznaczać swoje budżety na platformy podatne na oszustwa związane z botami.

Wydawcy muszą znać ten potencjalny wpływ i podejmować odpowiednie działania w celu ograniczenia ryzyka. Obejmuje to wdrażanie niezawodnych mechanizmów wykrywania oszustw i zapobiegania im, współpracę z renomowanymi sieciami reklamowymi, które wykorzystują zaawansowane algorytmy wykrywania botów, oraz monitorowanie wzorców ruchu w celu zidentyfikowania anomalii, które mogą wskazywać na aktywność botów. Aktywnie zajmując się problemem ruchu botów, wydawcy mogą zachować integralność wskaźników zaangażowania i budować zaufanie reklamodawców.

2. Intensyfikacja scrapingu treści

ChatGPT i podobne systemy mogą wykonywać różne zadania, w tym skrobanie stron internetowych, które pociąga za sobą wydobywanie danych ze stron internetowych w różnych celach. Niestety, korzystanie z systemów podobnych do ChatGPT może doprowadzić do gwałtownego wzrostu zbierania treści. Ta czynność może obejmować autoryzowane lub nieautoryzowane powielanie treści online, które są następnie wykorzystywane do innych celów lub zarabiania. Zgarnianie treści może również nadmiernie obciążać serwery docelowych witryn, wpływając na ich wydajność i dostępność dla uprawnionych użytkowników.

Kiedy zeskrobane treści są zarabiane gdzie indziej, wydawcy są pozbawieni ruchu i zaangażowania, które wygenerowaliby ich oryginalne treści. Ponadto skrobanie treści może nadmiernie obciążać serwery docelowych witryn. Gdy wysyłanych jest wiele żądań skrobania, może to spowodować zwiększone obciążenie serwera i wykorzystanie przepustowości, potencjalnie prowadząc do pogorszenia wydajności, a nawet przestojów. Legalni użytkownicy mogą doświadczać wolniejszego ładowania strony lub trudności z dostępem do witryny, co wpływa na ich ogólne wrażenia z użytkowania.

Z prawnego punktu widzenia skrobanie treści budzi obawy dotyczące naruszenia praw autorskich i praw własności intelektualnej. Nieautoryzowane kopiowanie i powielanie treści bez odpowiedniego przypisania lub pozwolenia może naruszać prawa autorskie. Wydawcy mają prawo do ochrony swoich oryginalnych dzieł i kontrolowania sposobu ich wykorzystywania i rozpowszechniania.

Aby zaradzić intensyfikacji zbierania treści, wydawcy mogą zastosować różne środki. Mogą one obejmować wdrażanie zabezpieczeń technologicznych, takich jak algorytmy wykrywania botów, systemy CAPTCHA lub mechanizmy ograniczania szybkości w celu wykrywania i łagodzenia prób skrobania. Ponadto wydawcy mogą wykorzystywać prawne możliwości ochrony swoich treści, w tym rejestrację praw autorskich, wysyłanie żądań usunięcia stronom naruszającym prawa i podejmowanie działań prawnych przeciwko osobom wielokrotnie naruszającym prawa.

Wydawcy muszą zachować czujność i aktywnie monitorować swoje treści pod kątem nieautoryzowanego powielania. Podejmując proaktywne kroki w celu ochrony swojej własności intelektualnej i złagodzenia skutków scrapingu treści, wydawcy mogą zachować kontrolę nad swoimi treściami, chronić swoje źródła przychodów i przestrzegać swoich praw.

3. Własność intelektualna i naruszenia praw autorskich

Wzrost zbierania treści, wspomagany przez ChatGPT i podobne technologie, może skutkować powszechnym naruszeniem własności intelektualnej i praw autorskich. Ta eskalująca tendencja zagraża zdolności twórców oryginalnych treści do czerpania odpowiednich korzyści ze swojej pracy.

Skrobanie treści obejmuje nieautoryzowane pobieranie i ponowne publikowanie treści online, często bez podania odpowiedniego źródła lub uzyskania pozwolenia od oryginalnych twórców. Taka praktyka podważa fundamentalne zasady własności intelektualnej, zgodnie z którymi twórcy powinni mieć prawo do kontrolowania dystrybucji, użytkowania i monetyzacji swoich dzieł.

Gdy treść jest pobierana i ponownie publikowana bez zgody, zmniejsza to potencjalne przychody pierwotnych twórców. Tracą możliwości zarabiania na swoich treściach za pośrednictwem legalnych kanałów, takich jak reklamy, subskrypcje lub umowy licencyjne. Dodatkowo brak odpowiedniej atrybucji pozbawia ich uznania i wiarygodności, na jakie zasługują za swój twórczy wysiłek.

Ponadto skrobanie treści może prowadzić do osłabienia środowiska online, w którym zduplikowane treści zalewają różne platformy. Powoduje to nie tylko zamieszanie wśród użytkowników poszukujących wiarygodnych i autentycznych źródeł, ale także hamuje rozwój i różnorodność oryginalnych treści. Rozpowszechnienie scrapowanych treści zmniejsza motywację twórców do inwestowania czasu, zasobów i talentu w tworzenie wysokiej jakości, oryginalnych prac.

Z prawnego punktu widzenia zbieranie treści bez pozwolenia często narusza prawa autorskie. Przepisy te przyznają twórcom treści wyłączne prawa, w tym prawo do powielania, rozpowszechniania, wyświetlania i dostosowywania ich dzieł. Nieautoryzowane pobieranie i ponowne publikowanie materiałów chronionych prawem autorskim narusza te prawa, potencjalnie narażając sprawców na konsekwencje prawne.

Aby rozwiać te obawy, twórcy treści i wydawcy muszą zachować czujność w monitorowaniu i ochronie swojej własności intelektualnej. Mogą stosować różne strategie zwalczania scrapingu treści, w tym wdrażać środki techniczne w celu wykrywania prób scrapingu i zapobiegania im, znakowania wodnego lub cyfrowego odcisku palca treści oraz podejmować kroki prawne przeciwko recydywistom.

Środki łagodzące

Biorąc pod uwagę te potencjalne skutki, konieczne jest opracowanie strategii ograniczających niewłaściwe użycie ChatGPT i podobnych technologii. Strategie te obejmują wdrażanie bardziej rygorystycznych mechanizmów wykrywania botów, opracowywanie narzędzi do oceny poziomu ochrony stron internetowych przed skrobakami treści, edukowanie wydawców na temat potencjalnych zagrożeń oraz ustanawianie ram prawnych dotyczących nieautoryzowanego korzystania z takich technologii.

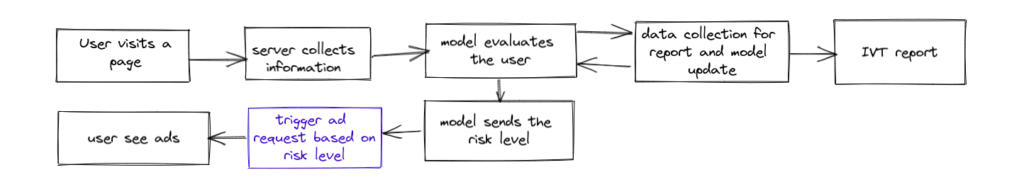

Aby złagodzić potencjalny negatywny wpływ ChatGPT i podobnych technologii, wydawcy mogą korzystać z zaawansowanych rozwiązań do wykrywania botów, takich jakTraffic Cop .Traffic Cop, wielokrotnie nagradzane rozwiązanie do blokowania botów oferowane przez MonetizeMore, zapewnia skuteczną ochronę przed ruchem generowanym przez boty, chroniąc integralność wskaźników zaangażowania i chroniąc inwestycje reklamodawców.

Dzięki zaawansowanym algorytmom i funkcjom uczenia maszynowego Traffic Cop jest przeznaczony do wykrywania i blokowania złośliwych botów, farm kliknięć i innych oszukańczych działań. Integrując Traffic Cop ze swoimi witrynami internetowymi, wydawcy mogą zapewnić, że ich platformy reklamowe są chronione przed niekorzystnymi skutkami ruchu botów, takimi jak zawyżone wskaźniki zaangażowania, niedokładne wskaźniki wydajności i zmarnowane wydatki na reklamę.

To kompleksowe rozwiązanie do blokowania botów nie tylko zwiększa dokładność i niezawodność wskaźników zaangażowania, ale także pomaga utrzymać zaufanie reklamodawców do platformy. Proaktywnie blokując boty, Traffic Cop zapewnia, że budżety reklamodawców są przeznaczane na rzeczywiste zaangażowanie użytkowników, co skutkuje większą przejrzystością i wyższym zwrotem z inwestycji.

Co więcej, Traffic Cop zapewnia wydawcom szczegółowe informacje i raporty na temat ruchu botów, umożliwiając im analizowanie wzorców, zrozumienie skali problemu botów i podejmowanie niezbędnych działań w celu dalszej optymalizacji wydajności reklam i wygody użytkowników.

Wykorzystując Traffic Cop, wydawcy mogą pewnie stawić czoła wyzwaniom związanym ze złośliwymi działaniami botów, zapewniając bezpieczniejsze i godne zaufania środowisko reklamowe zarówno dla wydawców, jak i reklamodawców. Pozwala wydawcom przejąć kontrolę nad ich witrynami, chronić swoje źródła przychodów i wzmacniać relacje z reklamodawcami.

Aby dowiedzieć się więcej o tym zabójcy botów i jego możliwościach łagodzenia negatywnych skutków systemów podobnych do GPT, możesz rozpocząć 7-dniowy okres próbny z Traffic Cop tutaj!

Syed Tanveer Jishan jest doświadczonym specjalistą od uczenia maszynowego, specjalizującym się w wykrywaniu anomalii z dziesięcioletnim doświadczeniem w środowisku akademickim i przemysłowym, zwłaszcza w technologii reklamowej. Z powodzeniem kierował rozwojem Traffic Cop, przełomowego narzędzia do wykrywania oszustw dla MonetizeMore, które przyniosło dziesięciokrotny spadek zwrotu przychodów z reklam. Jako naukowiec akademicki Syed opublikował wiele nowatorskich prac badawczych, łącząc praktyczną i akademicką wiedzę w dziedzinie uczenia maszynowego. Jego umiejętności i doświadczenie w wyjątkowy sposób wyposażają go w pomoc firmom w zabezpieczaniu przychodów przed oszustwami i zwiększaniu wydajności operacyjnej przy użyciu sztucznej inteligencji.