LLMOps, czyli jak skutecznie zarządzać modelami językowymi w organizacji | Sztuczna inteligencja w biznesie #125

Opublikowany: 2024-05-27Aby w pełni wykorzystać potencjał modeli wielkojęzycznych (LLM), firmy muszą wdrożyć skuteczne podejście do zarządzania tymi zaawansowanymi systemami. Potrafią generować naturalnie brzmiący tekst, tworzyć kod i znajdować kluczowe informacje w ogromnych zbiorach danych. LLM mają ogromny potencjał usprawnienia realizacji zadań korporacyjnych, ale wymagają także specjalistycznego zarządzania całym ich cyklem życia – od szkoleń, przez techniki podpowiedzi, po wdrożenie produkcyjne. Rozwiązaniem jest LLMOps, zestaw najlepszych praktyk operacyjnych dla dużych modeli językowych. Czytaj.

LLMOps – spis treści

- Jak działają LLM i do czego służą w firmach?

- Co to jest LLMOps?

- MLOps vs. LLMOps — podobieństwa i różnice

- Kluczowe zasady LLMOps

- Streszczenie

Jak działają LLM i do czego służą w firmach?

Zanim omówimy LLMOps, wyjaśnijmy najpierw, czym są duże modele językowe. Są to systemy uczenia maszynowego, które zostały przeszkolone na ogromnych zbiorach tekstu – od książek, przez artykuły internetowe po kod źródłowy, ale także obrazy, a nawet wideo. W rezultacie uczą się rozumieć gramatykę, semantykę i kontekst ludzkiego języka. Wykorzystują architekturę transformatora opisaną po raz pierwszy przez badaczy Google w 2017 roku w artykule „Attention Is All You Need” (https://arxiv.org/pdf/1706.03762v5.pdf). Dzięki temu potrafią przewidzieć kolejne słowa w zdaniu, tworząc płynny i naturalny język.

Jako wszechstronne narzędzia, LLM w firmach są szeroko stosowane między innymi do:

- budowanie wewnętrznych wektorowych baz danych w celu skutecznego wyszukiwania odpowiednich informacji w oparciu o zrozumienie zapytania, a nie tylko słów kluczowych — przykładem może być kancelaria prawna, która wykorzystuje LLM do tworzenia wektorowej bazy danych wszystkich odpowiednich przepisów i orzeczeń sądowych. Pozwala to na szybkie odnalezienie klucza informacyjnego do konkretnej sprawy,

- automatyzacja procesów CI/CD (Continious Integration/Continious Deployment) poprzez generowanie skryptów i dokumentacji – duże firmy technologiczne mogą wykorzystać LLM do automatycznego generowania kodu, testów jednostkowych i dokumentowania nowych funkcji oprogramowania, przyspieszając cykle wydawnicze,

- gromadzenie, przygotowywanie i etykietowanie danych — LLM może pomóc w przetwarzaniu i kategoryzowaniu ogromnych ilości danych tekstowych, obrazowych lub dźwiękowych, co jest niezbędne do szkolenia innych modeli uczenia maszynowego.

Firmy mogą również dopasować wstępnie przeszkolonych specjalistów LLM do swoich branż, ucząc ich specjalistycznego języka i kontekstu biznesowego (dostrajanie).

Jednak tworzenie treści, tłumaczenie języków i opracowywanie kodu to najczęstsze zastosowania LLM w przedsiębiorstwie. W rzeczywistości LLM mogą tworzyć spójne opisy produktów, raporty biznesowe, a nawet pomagać programistom w pisaniu kodu źródłowego w różnych językach programowania.

Pomimo ogromnego potencjału LLM, organizacje muszą być świadome związanych z nim wyzwań i ograniczeń. Należą do nich koszty obliczeniowe, ryzyko błędu systematycznego w danych szkoleniowych, potrzeba regularnego monitorowania i dostrajania modeli oraz wyzwania związane z bezpieczeństwem i prywatnością. Należy także pamiętać, że wyniki generowane przez modele na obecnym etapie rozwoju wymagają nadzoru człowieka ze względu na występujące w nich błędy (halucynacje).

Źródło: DALL·E 3, podpowiedź: Marta M. Kania (https://www.linkedin.com/in/martamatyldakania/)

Co to jest LLMOps?

LLMOps, czyli Large Language Model Operations, to zestaw praktyk służących do skutecznego wdrażania i zarządzania dużymi modelami językowymi (LLM) w środowiskach produkcyjnych. Dzięki LLMOps modele AI mogą szybko i skutecznie odpowiadać na pytania, dostarczać podsumowania i wykonywać złożone instrukcje, co zapewnia lepsze doświadczenie użytkownika i większą wartość biznesową. LLMOps odnosi się do zestawu praktyk, procedur i przepływów pracy, które ułatwiają opracowywanie, wdrażanie i zarządzanie dużymi modelami językowymi przez cały ich cykl życia.

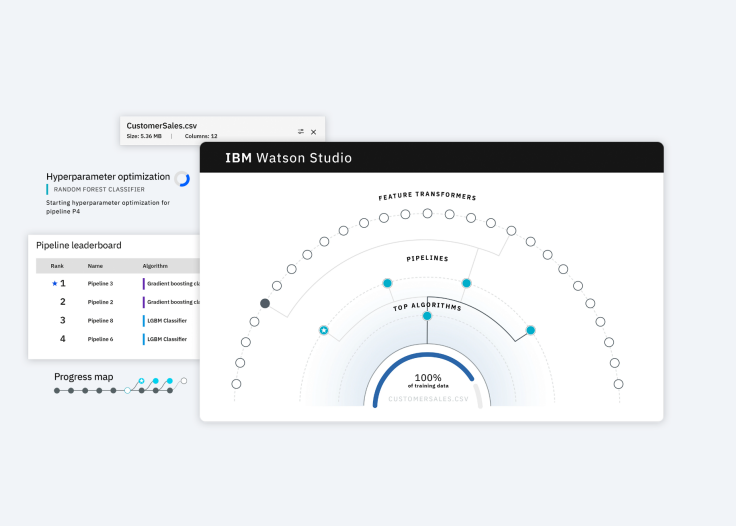

Można je postrzegać jako rozwinięcie koncepcji MLOps (Machine Learning Operations) dostosowanej do specyficznych wymagań LLM. Platformy LLMOps, takie jak Vertex AI od Google (https://cloud.google.com/vertex-ai), Databricks Data Intelligence Platform (https://www.databricks.com/product/data-intelligence-platform) lub IBM Watson Studio (https://www.ibm.com/products/watson-studio) umożliwiają bardziej efektywne zarządzanie bibliotekami modeli, redukując koszty operacyjne i umożliwiając mniej personelu technicznego wykonywanie zadań związanych z LLM.

W przeciwieństwie do tradycyjnych operacji programowych, LLMOps muszą stawić czoła złożonym wyzwaniom, takim jak:

- przetwarzanie ogromnych ilości danych,

- uczenie wymagających obliczeniowo modeli,

- wdrażanie LLM w firmie,

- ich monitorowanie i dostrajanie,

- zapewnienie bezpieczeństwa i prywatności wrażliwych informacji.

LLMOps nabierają szczególnego znaczenia w obecnym krajobrazie biznesowym, w którym firmy w coraz większym stopniu polegają na zaawansowanych i szybko rozwijających się rozwiązaniach AI. Standaryzacja i automatyzacja procesów z nimi związanych  Dzięki tym modelom organizacje mogą efektywniej wdrażać innowacje oparte na przetwarzaniu języka naturalnego.

Dzięki tym modelom organizacje mogą efektywniej wdrażać innowacje oparte na przetwarzaniu języka naturalnego.

Źródło: IBM Watson Studio (https://www.ibm.com/products/watson-studio)

MLOps vs. LLMOps — podobieństwa i różnice

Chociaż LLMOps wyewoluowały z dobrych praktyk MLOps, wymagają one innego podejścia ze względu na naturę dużych modeli językowych. Zrozumienie tych różnic jest kluczowe dla firm, które chcą skutecznie wdrażać LLM.

Podobnie jak MLOps, LLMOps opiera się na współpracy badaczy danych zajmujących się danymi, inżynierów DevOps i specjalistów IT. Jednak w przypadku LLMOps większy nacisk kładzie się na:

- wskaźniki oceny wydajności, takie jak BLEU (mierzący jakość tłumaczeń) i ROUGE (mierzący streszczenia tekstów), zamiast klasycznych wskaźników uczenia maszynowego,

- jakość szybkiej inżynierii – czyli opracowanie odpowiednich zapytań i kontekstów, aby uzyskać pożądane rezultaty z LLM,

- ciągły feedback od użytkowników – wykorzystanie ocen do iteracyjnego ulepszania modeli,

- większy nacisk na testowanie jakości przez ludzi podczas ciągłego wdrożenia,

- obsługa baz danych wektorowych.

Pomimo tych różnic MLOps i LLMOps mają wspólny cel – automatyzację powtarzalnych zadań oraz promowanie ciągłej integracji i wdrażania w celu zwiększenia wydajności. Dlatego niezwykle istotne jest zrozumienie wyjątkowych wyzwań stojących przed LLMOps i dostosowanie strategii do specyfiki dużych modeli językowych.

Kluczowe zasady LLMOps

Skuteczne wdrożenie LLMOps wymaga przestrzegania kilku kluczowych zasad. Ich zastosowanie zapewni skuteczną i bezpieczną realizację potencjału LLM w organizacji. Poniższych 11 zasad LLMOps dotyczy zarówno tworzenia, optymalizacji działania, jak i monitorowania wydajności LLM w organizacji.

- Zarządzanie zasobami obliczeniowymi. Procesy LLM takie jak szkolenia wymagają dużej mocy obliczeniowej, dlatego zastosowanie wyspecjalizowanych procesorów takich jak Neural Network Processing Unit (NPU) czy Tensor Processing Unit (TPU) może znacznie przyspieszyć te operacje i obniżyć koszty. Należy monitorować i optymalizować wykorzystanie zasobów w celu uzyskania maksymalnej wydajności.

- Stały monitoring i konserwacja modeli . Narzędzia monitorujące mogą wykrywać spadki wydajności modelu w czasie rzeczywistym, umożliwiając szybką reakcję. Zbieranie informacji zwrotnych od użytkowników i ekspertów umożliwia iteracyjne udoskonalanie modelu, aby zapewnić jego długoterminową skuteczność.

- Właściwe zarządzanie danymi . Kluczowy jest wybór oprogramowania, które pozwala na wydajne przechowywanie i odzyskiwanie dużych ilości danych w całym cyklu życia LLM. Automatyzacja procesów gromadzenia, czyszczenia i przetwarzania danych zapewni stały dopływ wysokiej jakości informacji do uczenia modeli.

- Przygotowywanie danych. Regularne przekształcanie, agregacja i separacja danych jest niezbędna do zapewnienia jakości. Dane powinny być widoczne i możliwe do udostępniania między zespołami, aby ułatwić współpracę i zwiększyć wydajność.

- Szybka inżynieria . Szybka inżynieria polega na wydawaniu LLM jasnych poleceń wyrażonych w języku naturalnym. Dokładność i powtarzalność odpowiedzi udzielanych przez modele językowe, a także prawidłowe i spójne wykorzystanie kontekstu zależą w dużej mierze od precyzji podpowiedzi.

- Realizacja . Aby zoptymalizować koszty, wstępnie wyszkolone modele muszą być dostosowane do konkretnych zadań i środowisk. Platformy takie jak NVIDIA TensorRT (https://developer.nvidia.com/tensorrt) i ONNX Runtime (https://onnxruntime.ai/) oferują narzędzia do optymalizacji głębokiego uczenia się, aby zmniejszyć rozmiar modeli i przyspieszyć ich wydajność.

- Odzyskiwanie po awarii . Regularne kopie zapasowe modeli, danych i konfiguracji zapewniają ciągłość działania w przypadku awarii systemu. Wdrożenie mechanizmów redundancji, takich jak replikacja danych i równoważenie obciążenia, zwiększa niezawodność całego rozwiązania.

- Rozwój modelu etycznego. Należy przewidzieć, wykryć i skorygować wszelkie błędy systematyczne w danych szkoleniowych i wynikach modeli, które mogą zniekształcić wyniki i prowadzić do nieuczciwych lub szkodliwych decyzji. Firmy powinny wdrożyć procesy zapewniające odpowiedzialny i etyczny rozwój systemów LLM.

- Informacje zwrotne od ludzi . Wzmocnienie modelu poprzez opinie użytkowników (RLHF – Reinforcement Learning from Human Feedback) może znacznie poprawić jego wydajność, ponieważ zadania LLM są często otwarte. Ludzki osąd pozwala na dostosowanie modelu do preferowanych zachowań.

- Łańcuchy i rurociągi LLM . Narzędzia takie jak LangChain (https://python.langchain.com/) i LlamaIndex (https://www.llamaindex.ai/) umożliwiają łączenie wielu wywołań LLM i interakcję z systemami zewnętrznymi w celu realizacji złożonych zadań. Pozwala to na budowanie kompleksowych aplikacji w oparciu o LLM.

- Strojenie modelu Biblioteki open source, takie jak Hugging Face Transformers (https://huggingface.co/docs/transformers/index), PyTorch (https://pytorch.org/) lub TensorFlow (https:////www.tensorflow.org /), pomagają poprawić wydajność modelu poprzez optymalizację algorytmów szkoleniowych i wykorzystania zasobów. Kluczowe jest również zmniejszenie opóźnień modelu, aby zapewnić responsywność aplikacji.

Źródło: Tensor Flow (https://blog.tensorflow.org/2024/03/whats-new-in-tensorflow-216.html?hl=pl)

Streszczenie

LLMOps umożliwiają firmom bezpieczne i niezawodne wdrażanie zaawansowanych modeli językowych oraz definiowanie, w jaki sposób organizacje wykorzystują technologie przetwarzania języka naturalnego. Automatyzując procesy, ciągłe monitorowanie i dostosowując się do konkretnych potrzeb biznesowych, organizacje mogą w pełni wykorzystać ogromny potencjał LLM w generowaniu treści, automatyzacji zadań, analizie danych i wielu innych obszarach.

Chociaż LLMOps ewoluowały od najlepszych praktyk MLOps, wymagają różnych narzędzi i strategii dostosowanych do wyzwań związanych z zarządzaniem dużymi modelami językowymi. Tylko przy przemyślanym i konsekwentnym podejściu firmy będą mogły efektywnie wykorzystać tę przełomową technologię, zapewniając jednocześnie bezpieczeństwo, skalowalność i zgodność z przepisami.

W miarę jak LLM stają się coraz bardziej zaawansowane, rośnie rola LLMOps, dając organizacjom solidną podstawę do wdrażania potężnych systemów sztucznej inteligencji w kontrolowany i zrównoważony sposób. Firmy, które inwestują w rozwój kompetencji LLMOps, zyskają strategiczną przewagę w zakresie wykorzystania innowacji opartych na przetwarzaniu języka naturalnego, co pozwoli im pozostać w czołówce transformacji cyfrowej.

Jeśli podobają Ci się nasze treści, dołącz do naszej społeczności pracowitych pszczół na Facebooku, Twitterze, LinkedIn, Instagramie, YouTube, Pinterest i TikTok.

Autor: Robert Whitney

Ekspert JavaScriptu i instruktor, który szkoli działy IT. Jego głównym celem jest podniesienie produktywności zespołu poprzez uczenie innych, jak efektywnie współpracować podczas kodowania.

Sztuczna inteligencja w biznesie:

- Zagrożenia i szanse AI w biznesie (część 1)

- Zagrożenia i szanse AI w biznesie (część 2)

- Zastosowania AI w biznesie – przegląd

- Chatboty tekstowe wspomagane sztuczną inteligencją

- Biznesowe NLP dziś i jutro

- Rola AI w podejmowaniu decyzji biznesowych

- Planowanie postów w mediach społecznościowych. Jak sztuczna inteligencja może pomóc?

- Zautomatyzowane posty w mediach społecznościowych

- Nowe usługi i produkty współpracujące z AI

- Jakie są słabe strony mojego pomysłu na biznes? Sesja burzy mózgów z ChatGPT

- Korzystanie z ChatGPT w biznesie

- Aktorzy syntetyczni. 3 najlepsze generatory wideo AI

- 3 przydatne narzędzia do projektowania graficznego AI. Generatywna sztuczna inteligencja w biznesie

- 3 niesamowitych autorów AI, których musisz dziś wypróbować

- Odkrywanie mocy sztucznej inteligencji w tworzeniu muzyki

- Poruszanie się po nowych możliwościach biznesowych dzięki ChatGPT-4

- Narzędzia AI dla menedżera

- 6 niesamowitych wtyczek ChatGTP, które ułatwią Ci życie

- 3 grafików AI. Generatywna sztuczna inteligencja dla biznesu

- Jaka przyszłość czeka sztuczną inteligencję według McKinsey Global Institute?

- Sztuczna inteligencja w biznesie - Wprowadzenie

- Czym jest NLP, czyli przetwarzanie języka naturalnego w biznesie

- Automatyczne przetwarzanie dokumentów

- Tłumacz Google kontra DeepL. 5 zastosowań tłumaczenia maszynowego w biznesie

- Działanie i zastosowania biznesowe robotów głosowych

- Technologia wirtualnego asystenta, czyli jak rozmawiać z AI?

- Czym jest inteligencja biznesowa?

- Czy sztuczna inteligencja zastąpi analityków biznesowych?

- Jak sztuczna inteligencja może pomóc w BPM?

- AI i media społecznościowe – co o nas mówią?

- Sztuczna inteligencja w zarządzaniu treścią

- Kreatywna sztuczna inteligencja dziś i jutro

- Multimodalna sztuczna inteligencja i jej zastosowania w biznesie

- Nowe interakcje. Jak sztuczna inteligencja zmienia sposób, w jaki obsługujemy urządzenia?

- RPA i API w cyfrowej firmie

- Przyszły rynek pracy i nadchodzące zawody

- Sztuczna inteligencja w EdTech. 3 przykłady firm, które wykorzystały potencjał sztucznej inteligencji

- Sztuczna inteligencja i środowisko. 3 rozwiązania AI, które pomogą Ci zbudować zrównoważony biznes

- Detektory treści AI. Czy są tego warte?

- ChatGPT kontra Bard kontra Bing. Który chatbot AI prowadzi w wyścigu?

- Czy sztuczna inteligencja chatbota jest konkurencją dla wyszukiwarki Google?

- Skuteczne podpowiedzi ChatGPT dla HR i rekrutacji

- Szybka inżynieria. Co robi szybki inżynier?

- Generator makiet AI. 4 najlepsze narzędzia

- AI i co jeszcze? Najważniejsze trendy technologiczne dla biznesu w 2024 roku

- Sztuczna inteligencja i etyka biznesu. Dlaczego warto inwestować w etyczne rozwiązania

- Metasztuczna sztuczna inteligencja. Co warto wiedzieć o funkcjach Facebooka i Instagrama wspieranych przez sztuczną inteligencję?

- Regulacja AI. Co musisz wiedzieć jako przedsiębiorca?

- 5 nowych zastosowań AI w biznesie

- Produkty i projekty AI – czym różnią się od innych?

- Automatyzacja procesów wspomagana sztuczną inteligencją. Gdzie zacząć?

- Jak dopasować rozwiązanie AI do problemu biznesowego?

- AI jako ekspert w Twoim zespole

- Zespół AI a podział ról

- Jak wybrać kierunek kariery w AI?

- Czy zawsze warto dodawać sztuczną inteligencję do procesu rozwoju produktu?

- AI w HR: Jak automatyzacja rekrutacji wpływa na rozwój HR i zespołu

- 6 najciekawszych narzędzi AI w 2023 roku

- 6 największych wpadek biznesowych spowodowanych przez sztuczną inteligencję

- Jaka jest analiza dojrzałości AI firmy?

- AI do personalizacji B2B

- Przypadki użycia ChatGPT. 18 przykładów tego, jak ulepszyć swój biznes dzięki ChatGPT w 2024 r

- Mikrouczenie się. Szybki sposób na zdobycie nowych umiejętności

- Najciekawsze wdrożenia AI w firmach w 2024 roku

- Czym zajmują się specjaliści od sztucznej inteligencji?

- Jakie wyzwania niesie ze sobą projekt AI?

- 8 najlepszych narzędzi AI dla biznesu w 2024 roku

- Sztuczna inteligencja w CRM. Co AI zmienia w narzędziach CRM?

- Ustawa UE o sztucznej inteligencji. W jaki sposób Europa reguluje wykorzystanie sztucznej inteligencji

- Sora. Jak realistyczne filmy z OpenAI zmienią biznes?

- 7 najlepszych twórców stron AI

- Narzędzia niewymagające kodu i innowacje AI

- Jak bardzo wykorzystanie AI zwiększa produktywność Twojego zespołu?

- Jak wykorzystać ChatGTP do badań rynku?

- Jak poszerzyć zasięg swojej kampanii marketingowej AI?

- „Wszyscy jesteśmy programistami”. W jaki sposób programiści obywatelscy mogą pomóc Twojej firmie?

- AI w transporcie i logistyce

- Jakie problemy biznesowe może naprawić sztuczna inteligencja?

- Sztuczna inteligencja w mediach

- AI w bankowości i finansach. Stripe, Monzo i Grab

- AI w branży turystycznej

- Jak sztuczna inteligencja sprzyja narodzinom nowych technologii

- Rewolucja AI w mediach społecznościowych

- Sztuczna inteligencja w handlu elektronicznym. Przegląd światowych liderów

- 4 najlepsze narzędzia do tworzenia obrazów AI

- 5 najlepszych narzędzi AI do analizy danych

- Strategia AI w Twojej firmie – jak ją zbudować?

- Najlepsze kursy AI – 6 niesamowitych rekomendacji

- Optymalizacja słuchania mediów społecznościowych za pomocą narzędzi AI

- IoT + AI, czyli jak obniżyć koszty energii w firmie

- AI w logistyce. 5 najlepszych narzędzi

- Sklep GPT – przegląd najciekawszych GPT dla biznesu

- LLM, GPT, RAG... Co oznaczają akronimy AI?

- Roboty AI – przyszłość czy teraźniejszość biznesu?

- Jaki jest koszt wdrożenia AI w firmie?

- Jak sztuczna inteligencja może pomóc w karierze freelancera?

- Automatyzacja pracy i zwiększenie produktywności. Przewodnik po sztucznej inteligencji dla freelancerów

- AI dla startupów – najlepsze narzędzia

- Budowa strony internetowej z AI

- OpenAI, Midjourney, Antropiczny, Przytulająca Twarz. Kto jest kim w świecie AI?

- Jedenaście laboratoriów i co jeszcze? Najbardziej obiecujące startupy AI

- Dane syntetyczne i ich znaczenie dla rozwoju Twojego biznesu

- Najlepsze wyszukiwarki AI. Gdzie szukać narzędzi AI?

- Wideo AI. Najnowsze generatory wideo AI

- AI dla menedżerów. Jak sztuczna inteligencja może ułatwić Ci pracę

- Co nowego w Google Gemini? Wszystko co musisz wiedzieć

- AI w Polsce. Firmy, spotkania i konferencje

- Kalendarz AI. Jak zoptymalizować swój czas w firmie?

- AI i przyszłość pracy. Jak przygotować firmę na zmiany?

- Klonowanie głosu AI dla biznesu. Jak tworzyć spersonalizowane wiadomości głosowe za pomocą AI?

- Sprawdzanie faktów i halucynacje AI

- AI w rekrutacji – opracowywanie materiałów rekrutacyjnych krok po kroku

- Podróż w połowie v6. Innowacje w generowaniu obrazu AI

- Sztuczna inteligencja w MŚP. Jak MŚP mogą konkurować z gigantami wykorzystującymi sztuczną inteligencję?

- Jak AI zmienia influencer marketing?

- Czy sztuczna inteligencja naprawdę stanowi zagrożenie dla programistów? Devina i Microsoft AutoDev

- Chatboty AI dla e-commerce. Studium przypadku

- Najlepsze chatboty AI dla e-commerce. Platformy

- Jak być na bieżąco z tym, co dzieje się w świecie AI?

- Oswajanie sztucznej inteligencji. Jak zrobić pierwsze kroki, aby zastosować AI w swoim biznesie?

- Zakłopotanie, Bing Copilot czy You.com? Porównanie wyszukiwarek AI

- Królestwo. Przełomowy model językowy od Apple?

- Eksperci AI w Polsce

- Google Genie — generatywny model sztucznej inteligencji, który tworzy w pełni interaktywne światy z obrazów

- Automatyzacja czy udoskonalenie? Dwa podejścia do AI w firmie

- LLMOps, czyli jak skutecznie zarządzać modelami językowymi w organizacji